ChatGPT等不會很快接管人類工作,易出錯,AI也不會免費打工

ChatGPT 等大模型的相繼發布,讓很多人倍感壓力,害怕 AI 會很快接管他們的工作。對此,OpenAI 也曾發表過一項研究,表明 ChatGPT 的影響涵蓋所有收入階層,且高收入工作可能面臨更大的風險。事實到底如何呢?

我們應該將所有的工作,即使是那些令人滿意的工作都實現自動智能化嗎?

這是未來生命研究所 (Future of Life Institute) 最近提出的幾個問題之一,該研究所呼吁暫停大型人工智能實驗,目前埃隆?馬斯克 (Elon Musk) 、Steve Wozniak 和 Andrew Yang 等 1 萬多人均已簽署了該倡議。盡管可能有一些炒作的意味,但它聽起來仍十分嚴重 —— 然而,人工智能究竟如何被用于實現所有工作的自動智能化呢?先不考慮這是否可取 —— 試想,它真的可能嗎?

麻省理工學院連接科學研究所研究員 Douglas Kim 表示:我認為真正的障礙是,我們從 OpenAI 和谷歌 Bard 看到的通用人工智能功能的涌現,與早期互聯網普遍可用或云基礎設施服務可用的情況類似。它還沒有像提到的那樣,為數億工作者的普遍使用做好準備。

即使研究人員也無法跟上 AI 創新的步伐

Douglas Kim 指出,雖然革命性的技術可以迅速傳播,但在被證明為有用、易于使用的應用程序之前,它們通常無法得到廣泛運用。他指出,生成式 AI 將需要特定的商業應用,才能超越早期采用者的核心受眾。

Augment 公司 AI 負責人 Matthew Kirk 也持相似觀點:「我認為 AI 行業正在發生的事情與互聯網早期發生的事情類似。當時的互聯網各種觀點非常混亂,沒有標準。人類需要時間和合作來確定人們遵循的標準。即使是像測量時間這樣平凡的事情也非常復雜。」

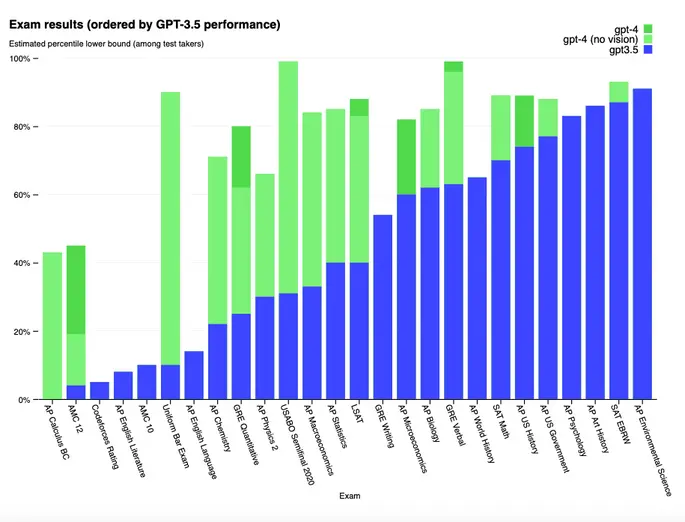

標準化是人工智能發展的痛點。用于訓練模型和微調結果的方法是保密的,這使得有關它們是如何運作這一基本問題難以解答。OpenAI 一直在吹捧 GPT-4 通過眾多標準化測試的能力 —— 但模型是真正理解了測試,還是僅僅只是訓練重現正確答案呢?對于它能夠處理新奇任務的能力,這又意味著什么呢?研究人員似乎無法就此答案達成一致,也無法就可能用于得出結論的方法達成一致。

對比 GPT 3.5 和 GPT 4 的標準化測試成績圖表

OpenAI 的 GPT-4 可以在很多標準化測試中取得好成績。它是真正理解了它們,還是接受了正確答案的訓練?

即使可以就標準達成一致,設計和生產廣泛使用在基于 GPT -4 等大語言模型 (LLMs) 或其他生成式 AI 系統的 AI-powered 工具所需的物理硬件也可能是一個挑戰。Optiver 全球研究基礎設施負責人 Lucas A. Wilson 認為,AI 行業正在進行一場軍備競賽,以生產出盡可能復雜的大型語言模型(LLM)。這反過來又迅速增加了訓練模型所需的計算資源。

和人類一樣,AI 也不會免費工作

與此同時,開發人員必須找到應對限制的方法。從零開始訓練一個強大的大型語言模型(LLM)可以帶來獨特的機會,但這只適用于資金充足的大型組織。實現一項可以運用現有模型的服務要便宜得多 (例如,Open AI 的 ChatGPT-3.5 Turbo 對 API 訪問的定價約為每 1000 個英語單詞 0.0027 美元)。但當人工智能驅動的服務變得流行時,成本仍然會增加。無論哪種情況,推出可無限制使用的 AI 都是不現實的,這將迫使開發者做出艱難的選擇。

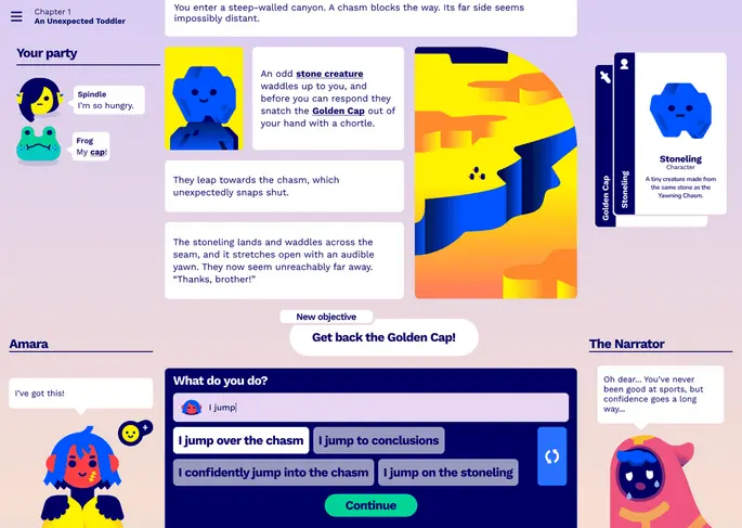

Hidden Door,一家通過構建 AI 平臺來制作敘事型游戲的初創公司,其首席執行官兼聯合創始人 Hilary Mason 表示:「一般來說,依靠 AI 創立的初創公司應該對所有特定供應商應用程序編程接口(API)的依賴都持非常謹慎的態度。我們也可以構建不必讓 GPU 成為核心的架構,但這需要相當多的經驗。」

Hidden Door 正在開發用于幫助用戶運用人工智能來制作獨特敘事體驗的軟件。這是一個用于生成敘事游戲的 AI-powered 屏幕截圖工具。它包括用戶可以選擇的多個 character 和 prompt。

大多數基于生成式 AI 構建的服務都會對每月生成的內容量設有一個固定的上限。這些專業服務費用對于企業來說可能會增加成本,從而拖慢人們工作任務智能自動化的步伐。即使是擁有大量資源的 OpenAI,也會根據當前的負載限制 ChatGPT 的付費用戶:截至本文撰寫時,它所設置的上限是每 3 小時 25 次 GPT-4 查詢。因而,對于任何想要依賴 ChatGPT 工作的人來說,這都是一個巨大問題。

AI-powered 工具的開發人員還面臨著一個和計算機本身一樣古老的挑戰 —— 設計一個好的用戶界面。一個能夠完成許多任務的強大 LLM(大型語言模型)應該是一個無與倫比的工具,但是如果使用它的人無從下手,那么它完成任務的能力就無關緊要了。Kirk 指出,雖然 ChatGPT 是易于使用的,但當用戶需要專注于特定的任務時,通過聊天與 AI 交互的開放性可能被證明會令人無所適從。

Kirk 說:「我從過往經歷中了解到,讓工具完全開放往往會給用戶帶去困惑,而非幫助。你可以把它想象成一個有著無窮無盡門廊的大廳。大多數人都會困惑重重,手足無措,呆在原地。我們仍有諸多工作要做,來確定為用戶展示最優的那扇門「。Mason 也有類似的觀察,他補充說:「就像 ChatGPT 主要是對 GPT-3 的 UX 優化一樣,我認為我們僅僅只是剛開始創造出 UI 設計中的隱喻,我們還需要在產品中有效地運用 AI 模型。」

訓練使用 AI 本身就是一項工作

幻覺(hallucination),作為 LLM 一個特殊的問題,早已引發了爭議,它還嚴重阻礙到了為敏感且重要的工作構建 AI 工具的進程。LLM 有一種令人難以置信的能力,它可以生成獨特的文本,講述笑話,編造關于虛構人物的事跡。然而,當精確性和準確性成為任務的關鍵時,這個技能卻變成了一種障礙,因為 LLM 經常會將不存在的虛假消息來源或不正確的陳述當作事實。

Kim 表示:在某些受到嚴格監管的行業 (銀行、保險、醫療保健),公司的特定職能部門都很難調和好非常嚴格的數據隱私和防止歧視的其他監管要求之間的關系。在這些受監管的行業,你不能讓 AI 犯那種在寫課程論文時還可以看得過去的錯誤。

企業可能會爭先雇傭那些具備 AI 工具專業知識的員工。人工智能安全和研究公司 Anthropic 最近因為一則招聘廣告上了頭條,他們在招聘一名 prompt 工程師和圖書管理員時,注明需要應聘者在完成其它本職工作以外,可負責建立 “一個具備高質量 prompt 或 prompt 鏈的圖書館,以完成各種任務”。薪水 17.5 萬到 33.5 萬美元。

然而,Wilson 看到了有效使用 AI 工具所需的專業知識與 AI 承諾提供的效率之間的矛盾。

「如何招聘人才來從事為 LLMs 提供培訓的全新工作,以解放那些早已專注于更復雜或更抽象工作任務的員工呢?」Wilson 問道。「我還沒有看到一個明確的答案。」

盡管存在這些問題,但利用人工智能增強工作仍可能是值得的。計算機革命顯然就是如此:盡管許多人需要訓練才能使用 Word 和 Excel 工具,但很少有人會提出打字機或圖表紙可以作為更好的替代。正如未來生命研究所的信中所擔憂的那樣,「我們用自動化取代所有工作,包括令人滿意的工作」。雖然這樣的未來至少還需要半年多的時間,但人工智能革命現在正在拉開帷幕,而且從今天起的十年里,人工智能革命的畫卷將會不斷展開。