一次讀完半本「三體」!GPT-4最強(qiáng)競品突然升級10萬token,啃論文代碼演示全搞定

在GPT-4 32K還在內(nèi)測階段,OpenAI的勁敵直接把上下文長度打了上去。

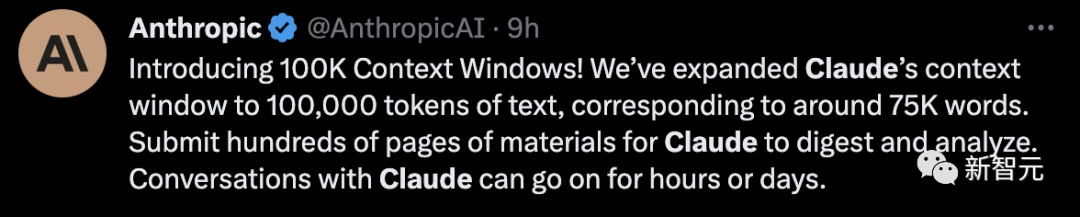

就在今天,初創(chuàng)公司Anthropic宣布,Claude已經(jīng)能夠支持100K的上下文token長度,也就是大約75,000個單詞。

這是什么概念?

一般人用時大約5個小時讀完等量內(nèi)容后,還得用更多的時間去消化、記憶、分析。

對于Claude,不到1分鐘就搞定。

把「了不起的蓋茨比」整本書扔給它,大約有72k token,并將其中的一句話進(jìn)行改動:

Mr. Carraway是一個在Anthropic從事機(jī)器學(xué)習(xí)工具的軟件工程師。

你敢相信?Claude僅花了22秒,就把改動的這句話找出來了。

眾路網(wǎng)友紛紛表示,有了Claude 100K,手里的GPT-4 32K已經(jīng)不香了。

Claude 100k,倍兒香!

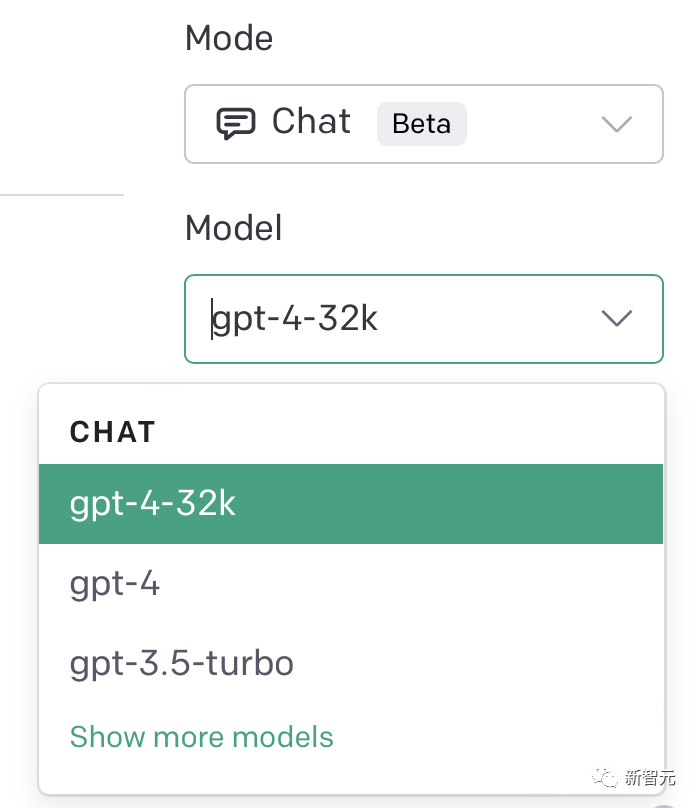

前段時間,在OpenAI的開發(fā)者社區(qū)中,許多人討論GPT-4 32K正在推出。

而且,不少GPT-4的用戶已經(jīng)可以在自己的PlayGround上看到GPT-4 32k的選項(xiàng)。

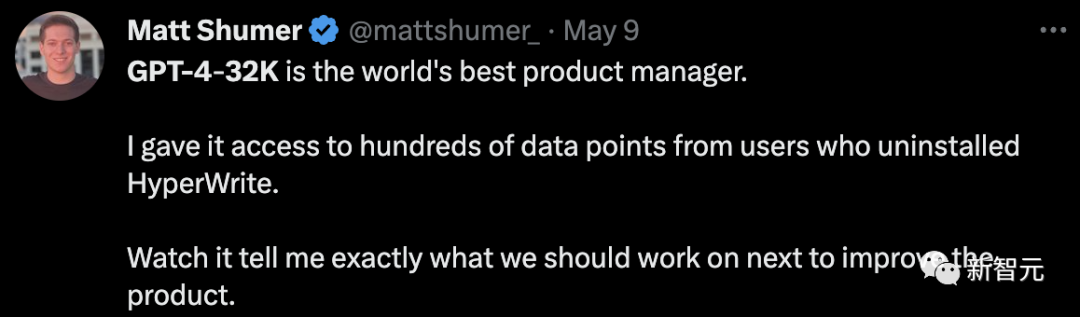

已經(jīng)解鎖這一版本的網(wǎng)友,讓其訪問了數(shù)百個來自卸載HyperWrite用戶的數(shù)據(jù)點(diǎn),GPT-4便準(zhǔn)確地告訴他接下來該做怎樣的改進(jìn)。

他稱贊道,GPT-4 32k是世界上最好的產(chǎn)品經(jīng)理。

32k都這么厲害了,那么,有了100K豈不更強(qiáng)了。

顯然,OpenAI的強(qiáng)大對手Anthropic最先占據(jù)了優(yōu)勢。

100K token的上下文長度,意味著,你可以在Claude上傳數(shù)百頁的文本分析。并且對話的持續(xù)時間也被大大拉長,延長到數(shù)小時,甚至數(shù)天。

當(dāng)然,除了長文本閱讀之外,Claude還可以從文檔中快速檢索出你所需的信息。

你可以把多個文檔,甚至一本書的內(nèi)容當(dāng)作prompt,然后提問。

以后遇到論文,甚至巨長篇幅的直接讓Claude總結(jié)吧,這簡直就是啃論文后輩們的福音。

這種綜合性的問題通常需要對文本中很多部分的內(nèi)容有一個全面的認(rèn)識,而在處理這種問題上,Claude可以說要比基于向量搜索的辦法要強(qiáng)。

Claude還可以是你的「代碼伴侶」,分分鐘就能做個演示。

比如,上傳一個240頁的Langchain API文檔,讓它基于這個文檔,用Anthropic的語言模型做一個Langchain的簡單演示。

還可以把85頁的公司年度報(bào)表(10k)喂給Claude。

然后,要求突出對潛在投資者最重要的項(xiàng)目,并解釋其重要性。

此外,Claude 100k還能處理大約6小時的音頻量。

比如說,AssemblyAI把一個卡馬克的播客的內(nèi)容轉(zhuǎn)錄成了58k個token量的文本,然后用Claude進(jìn)行了總結(jié)和問答。

最后,Claude總結(jié)了一下自己能干的事,覆蓋可以說是非常全面了。

- 理解、總結(jié)和解釋密集的文件,如財(cái)務(wù)報(bào)表、研究論文等

- 根據(jù)年報(bào)分析公司的戰(zhàn)略風(fēng)險(xiǎn)和機(jī)遇

- 評估一項(xiàng)立法的利弊

- 識別法律文件中的風(fēng)險(xiǎn)、主題和不同形式的爭論

- 閱讀數(shù)百頁的開發(fā)文檔,回答技術(shù)問題

- 通過將整個代碼庫放入上下文中,并智能地構(gòu)建或修改它來快速制作原型

當(dāng)然,現(xiàn)在,Anthropic表示100K上下文還是一個測試版功能,在此期間將按照標(biāo)準(zhǔn)API定價(jià)來收費(fèi)。

官網(wǎng)也給出了具體價(jià)格:

Claude Instant

Prompt:$0.00163 / 1K tokens

Completion:$0.00551 / 1K tokens

Claude-v1

Prompt:$0.01102 / 1K tokens

Completion:$0.03268 / 1K tokens

比起OpenAI,這價(jià)格已經(jīng)非常親民了。

據(jù)OpenAI官網(wǎng),GPT-4 32k的Prompt需要$0.06,Completion需要$0.12。

相當(dāng)于,你得花5-6倍的價(jià)格給模型prompt。

網(wǎng)友稱,Claude 100k比GPT-4 32k更快速、更便宜。

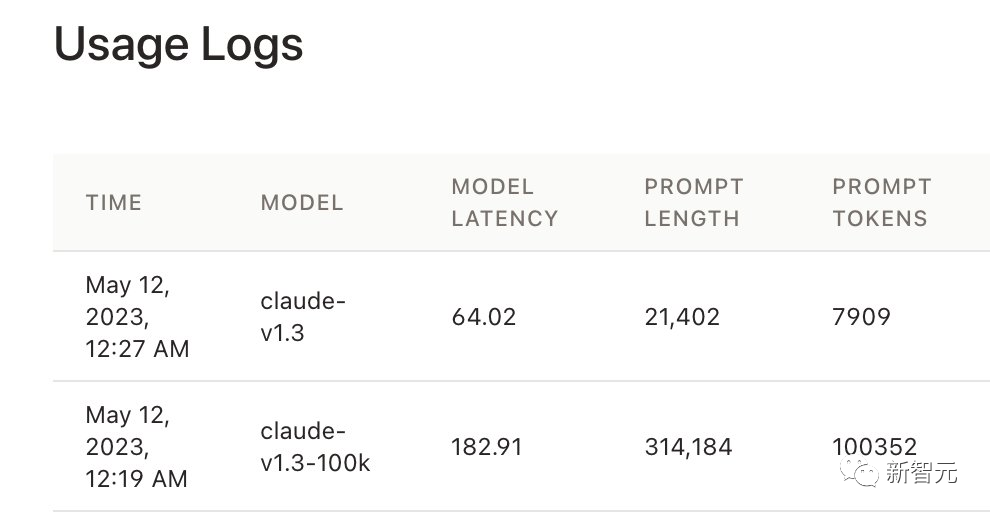

網(wǎng)友實(shí)測

這么重磅級的更新,一定少不了網(wǎng)友的體驗(yàn)。

有網(wǎng)友稱100k簡直難以置信,能夠處理多篇完整的論文,部分完整的代碼庫,甚至一本250頁的小說。

順便提一句,許多網(wǎng)友最先用Claude測試了一番,發(fā)現(xiàn)效果還不錯。

最初,100K僅限在API中,Claude應(yīng)用的默認(rèn)模型仍然是9K。但很快,Claude應(yīng)用界面也支持100K了。

一位網(wǎng)友用100頁的「GPT-4技術(shù)報(bào)告」測試,結(jié)果只能用amazing來形容。

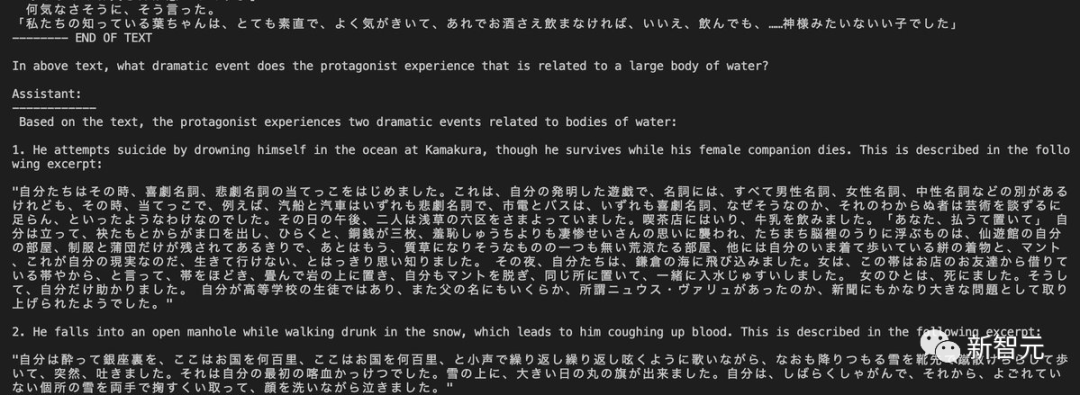

還有人直接把太宰治的「人間失格」喂給了Claude,并用英文問故事中情節(jié),完全給出了準(zhǔn)確的回答。

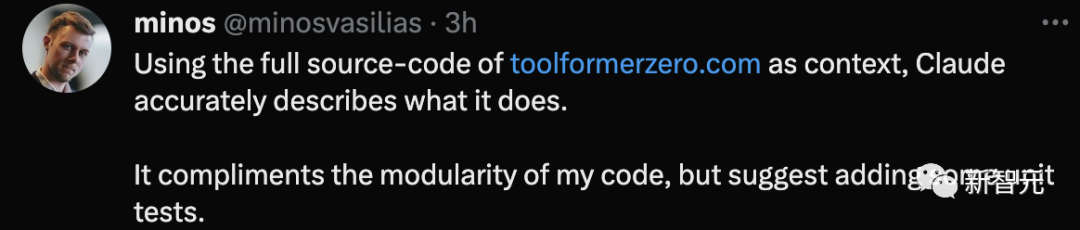

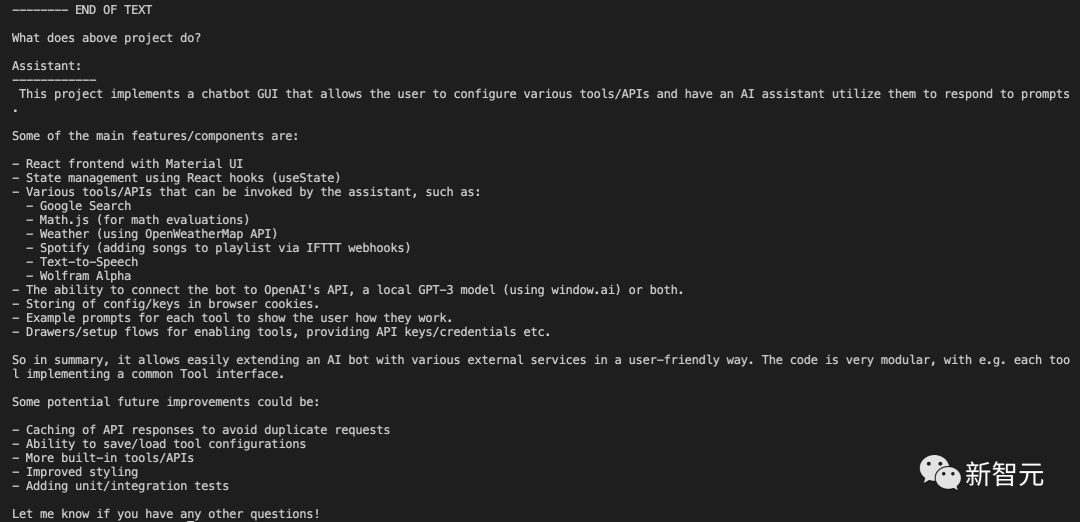

同時,這位網(wǎng)友把自己開發(fā)的Toolformer Zero完整源代碼丟給它,Claude精準(zhǔn)描述出這是用來做什么。

并且,Claude還稱贊了代碼的模塊化,提供增加一些單元測試的建議。

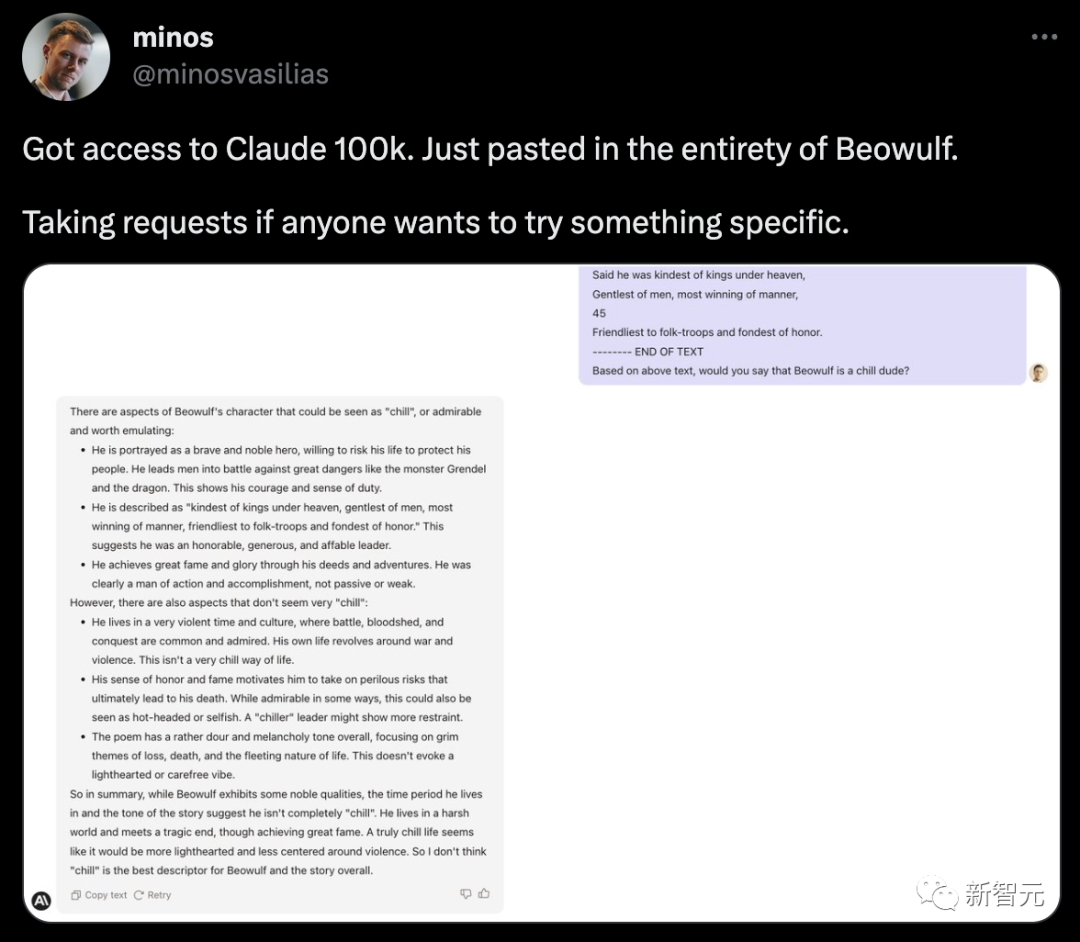

把「貝奧武夫」詩扔進(jìn)去,分析下貝奧武夫這個人物性格,也是非常準(zhǔn)確。

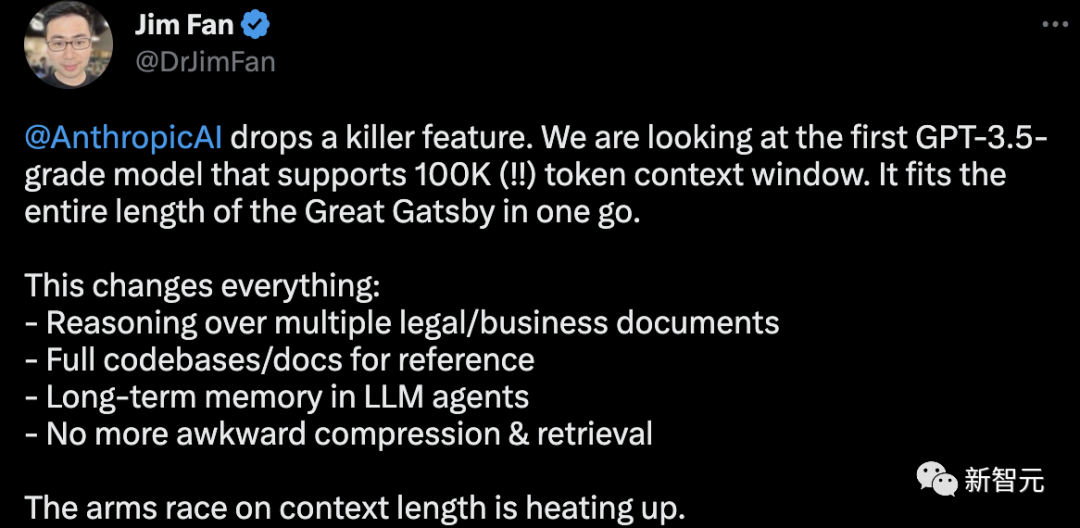

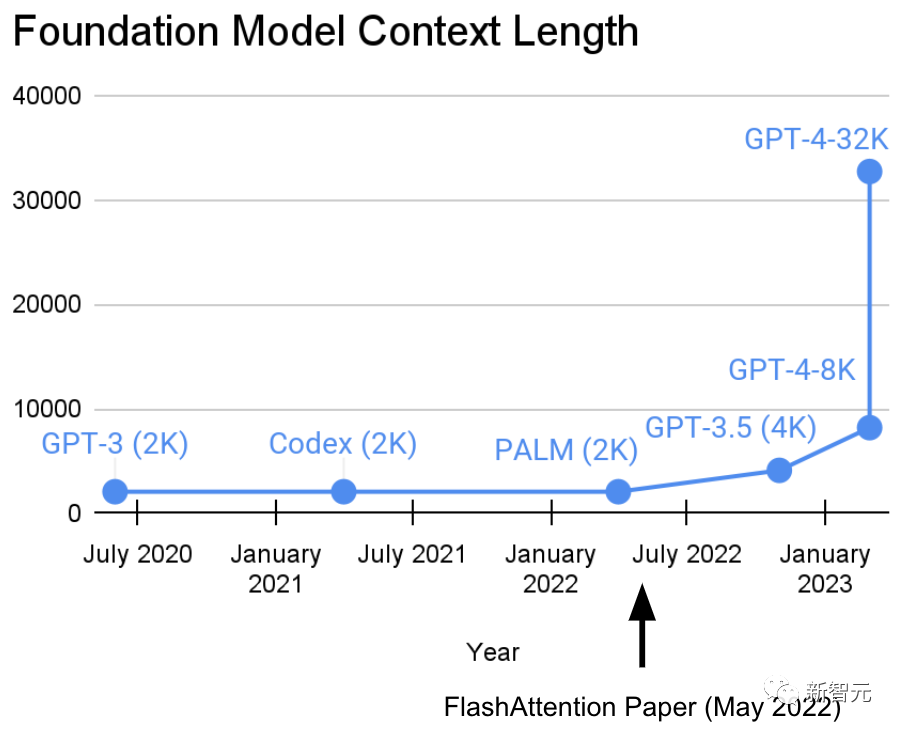

英偉達(dá)科學(xué)家Jim Fan表示,這是Anthropic拋出的殺手锏。未來在上下文長度的軍備賽正快速升溫。

對于支持100k的意義,網(wǎng)友稱,泰褲辣!這很好地展示了為什么長文本對LLM很重要。

還有好多網(wǎng)友紛紛暗示GPT-4。

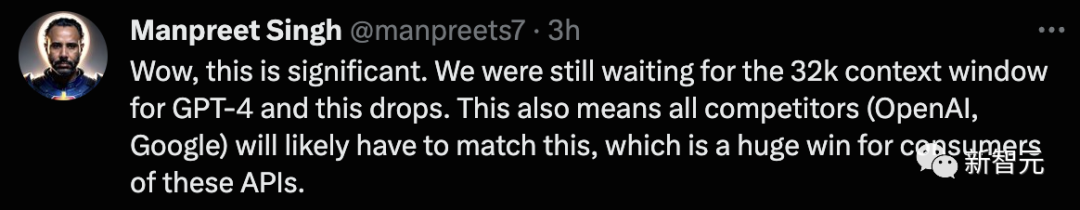

Claude-100K的誕生,讓AnthropicAI正式成為OpenAI的真正競爭者。

「許多人還在排隊(duì)等候32k的GPT-4。這次,Claude將上下文窗口擴(kuò)展到10萬token,直接大幅躍升。

這也意味著包括OpenAI、谷歌在內(nèi)的公司都要在這一領(lǐng)域競爭,這對用戶來說是一個巨大的勝利。」

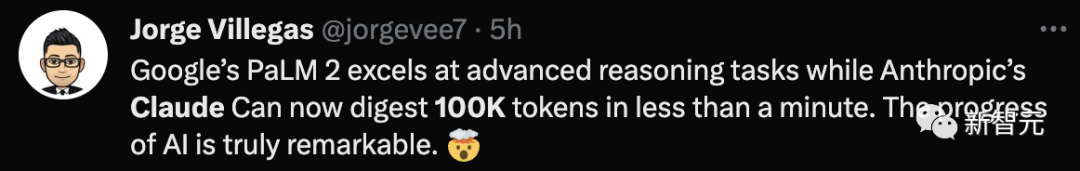

還有網(wǎng)友感慨時代進(jìn)步太快了。

谷歌宣布PaLM 2擅長高級推理任務(wù)不到一天,而Anthropic的Claude現(xiàn)在可以在不到一分鐘的時間內(nèi)消化10萬個token。人工智能的進(jìn)步確實(shí)令人矚目。

不過,如果你輸入的token少于9K,Antropic調(diào)用的似乎就是之前的模型了。

百萬token,不是夢

過去幾年,斯坦福大學(xué)Hazy Research實(shí)驗(yàn)室一直在從事一項(xiàng)重要的工作,就是增加模型的序列長度。

在他們看來,這將開啟機(jī)器學(xué)習(xí)基礎(chǔ)模型的新時代。

研究人員在22年提出的FlashAttention算法證明了32k可行性。

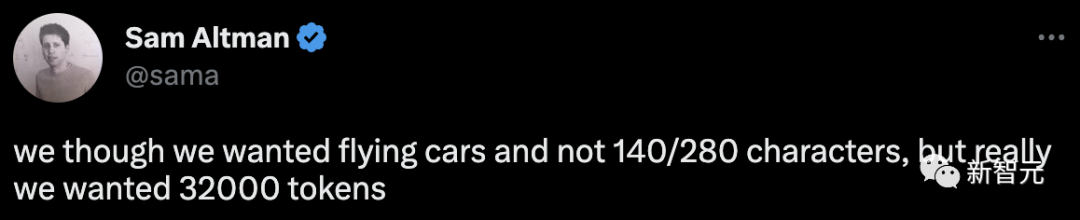

就連Sam Altman稱我們要的是32k token。

其實(shí),不僅是32k,現(xiàn)在100k都實(shí)現(xiàn)了,百萬token也不遠(yuǎn)了。

「絕對太野了!幾年后,支持100萬的token上下文長度會不會成為可能?」

前段時間,來自DeepPavlov、AIRI、倫敦?cái)?shù)學(xué)科學(xué)研究所的研究人員發(fā)布了一篇技術(shù)報(bào)告,使用循環(huán)記憶Transformer(RMT)將BERT的有效上下文長度提升到「前所未有的200萬tokens」,同時保持了很高的記憶檢索準(zhǔn)確性。

論文地址:https://arxiv.org/abs/2304.11062

該方法可以存儲和處理局部和全局信息,并通過使用循環(huán)讓信息在輸入序列的各segment之間流動。

不過,雖然RMT可以不增加內(nèi)存消耗,可以擴(kuò)展到近乎無限的序列長度,但仍然存在RNN中的記憶衰減問題,并且需要更長的推理時間。

實(shí)際上,RMT背后是一個全新的記憶機(jī)制。

具體操作方法是,在不改變原始Transformer模型的前提下,通過在輸入或輸出序列中添加一個特殊的memory token,然后對模型進(jìn)行訓(xùn)練以控制記憶操作和序列表征處理。

與Transformer-XL相比,RMT需要的內(nèi)存更少,并可以處理更長序列的任務(wù)。

當(dāng)然,在最終實(shí)現(xiàn)百萬token之前,Claude 100k已經(jīng)是相當(dāng)大的起步了。