Sam Altman預警:AI滅絕人類!375+大佬簽署22字聯名信,LeCun唱反調

3月,千名大佬簽署暫停「超級AI」研發的聯名信,讓整個業界為之震驚。

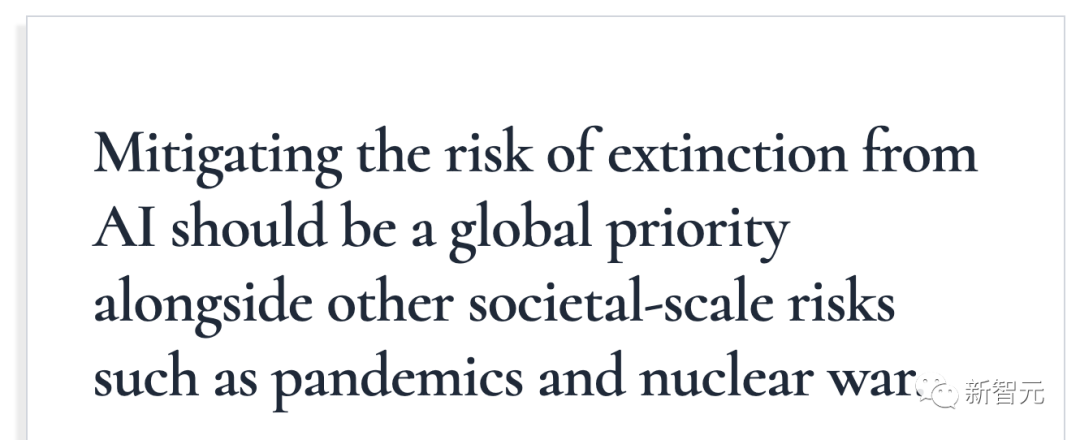

就在昨天,一封只有22個字的聯名信再次引起軒然大波。

寥寥數語,把AI類比為了傳染病和核戰爭,分分鐘滅絕人類的那種。

簽名者中,有Hinton和Bengio兩位人工智能的「教父」,還有硅谷巨頭的高管,Sam Altman、Demis Hassabis等在人工智能領域工作的研究人員。

截止目前,已經有370多名從事人工智能高管都簽署了這份聯名信。

然而,這封信并不是得到所有人的支持。

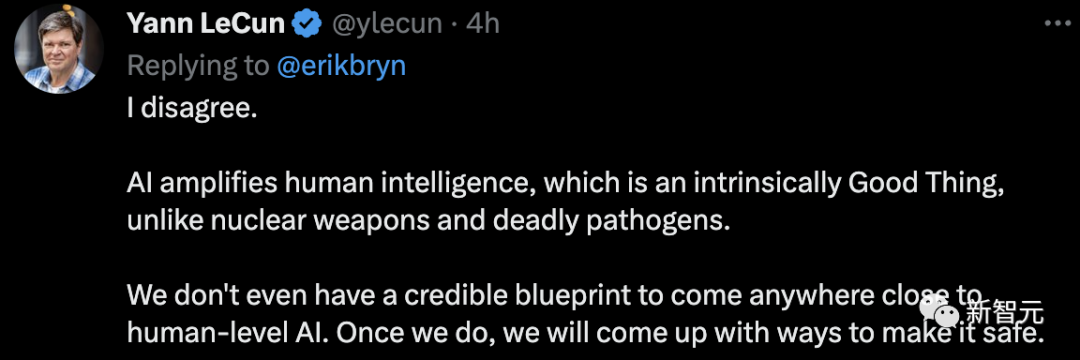

「圖靈三巨頭」中的一位LeCun直言:我不同意。

「人工智能放大了人類的智慧,這在本質上是一件好事,與核武器和致命的病原體不同。我們甚至沒有一個可靠的藍圖來創造接近人類水平的人工智能。一旦我們做到了,我們會想出讓它安全的方法。」

這封聯名信究竟說了啥?

「致命」公開信

22字,言簡意賅:

「降低AI給人類帶來滅絕的風險,應該被提到全球級別的優先程度。就像我們應對傳染病、核戰爭這種社會危機一樣。」

而簽署這封公開信的AI界人士一眼根本望不到頭。

赫然映入眼簾的就是Geoffrey Hinton,Yoshua Bengio,谷歌DeepMind的CEO Demis Hassabis,OpenAI的CEO Sam Altman,Anthropic的CEO Dario Amodei。

這里面Hinton的含金量不用多說,前谷歌副總裁、深度學習泰斗、神經網絡之父,以及圖靈獎獲得者。

Yoshua Bengio同樣也是圖靈獎獲得者,和Hinton,LeCun被合稱為圖靈獎三巨頭。(然而LeCun在這件事上和另兩個巨頭態度截然相反)

除了在科技巨頭公司任職的大佬,還不乏知名AI學者。比如UC伯克利的Dawn Song,清華大學的張亞勤。

而在這些耳熟能詳的名字下面,就是數不勝數的AI界人士了。

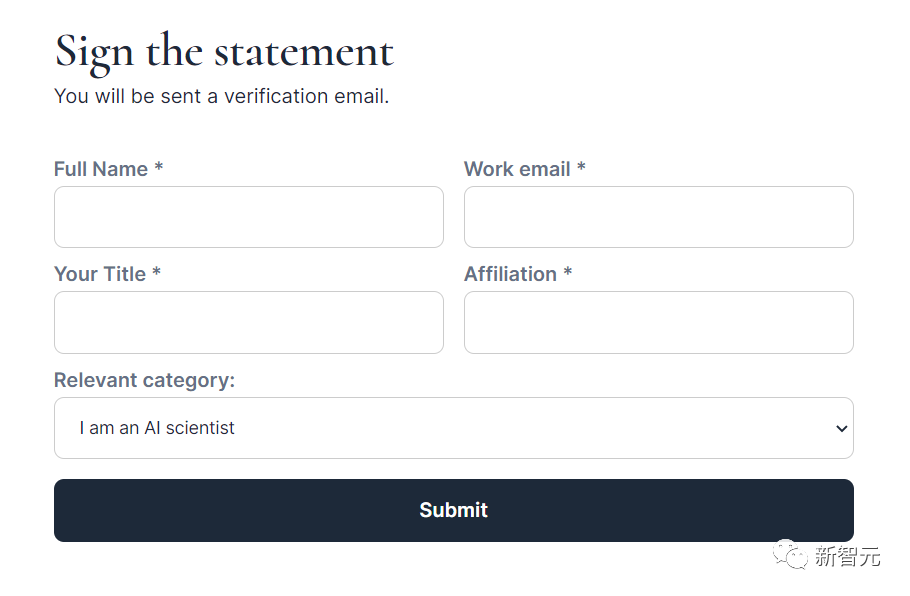

甚至,每個人都可以參與簽署這封公開信。

只要填寫姓名、郵箱、職位等等信息,就可以參與簽署了。

不過,可以選擇的身份并不多。(狗頭)

反對:滅絕人類純扯淡

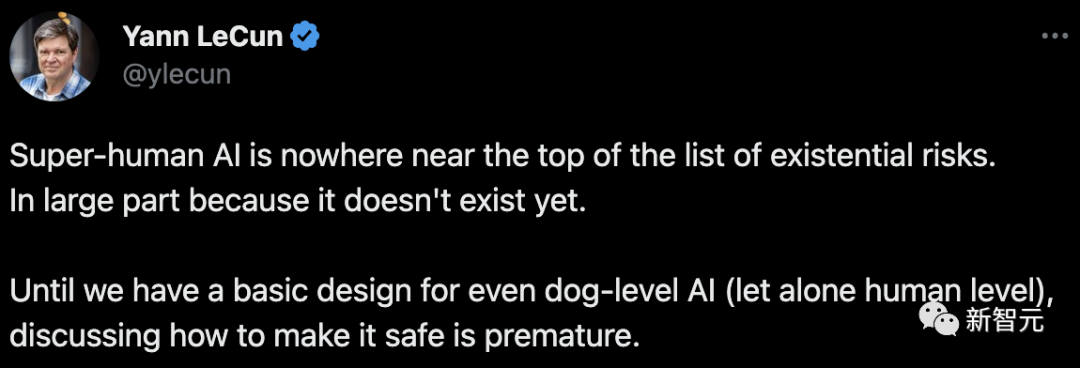

當然,Meta首席科學家LeCun還是一如既往地「唱唱反調」。

他一向的觀點都是:現在的AI發展剛哪兒到哪兒啊,就天天把威脅和安全掛在嘴邊。

他表示,所列出的威脅,根本不是現在AI發展的水平能達到的,因為壓根不存在。在我們基本設計出狗級別的人工智能(更不用說人類級別)之前,討論如何使其安全還為時過早。

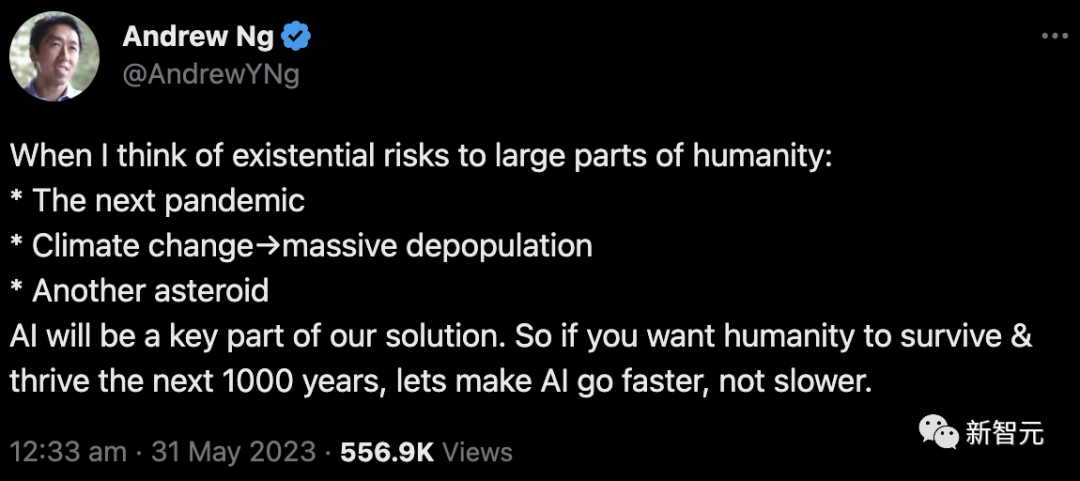

斯坦福大學的吳恩達立場和LeCun相同,但理由卻有點不同。

他認為,不是AI會導致各種各樣的問題,而是我們將會遇到的各種各樣的問題只能靠AI來解決。

比如:下一次傳染病爆發,氣候變化導致的人口減少,小行星撞地球等等。

他表示,人類想繼續生存、繁榮下去,得加速AI的發展,而不是減慢。

也有網友評論,你說的這個不是AI,而是MAGIC(魔法)吧。

AI風險面面觀

那么,這些大牛們所宣稱的足以滅絕人類的風險包括什么呢?

他們總結了以下8個方面。

武器化

部分人可能會將AI用于帶有破壞性的地方,會導致人類生存的風險,加劇政治動蕩。

比方說,現在深度強化學習的技術已經可以應用于空戰了,機器學習能用于制造化學武器(已有論文表明,GPT-4可以在實驗室中自主進行實驗、合成化學品)。

此外,近年來研究人員一直在開發用于自動進行網絡打擊的AI系統,還有軍方領導人想要讓AI控制核發射井。

因此,未來AI強國會占據戰略優勢,各國之間的軍備競賽會轉向AI領域。就算大部分國家都確保各自構建的系統是安全的,且不會威脅他國安全,仍然可能有國家蓄意用AI做壞事,造成傷害。

這給人的感覺就像核武器,有一個不聽話不老實的就全白玩兒。

因為數字領域的危害傳播速度很快。

信息誤傳

信息誤傳這個事情大家早就有所耳聞。遠的不說,前一陣子美國律師用ChatGPT打官司,結果舉的案例有6個都是杜撰的例子,現在還熱乎著。

而有影響力的集體,比如國家、政黨、組織,有能力用AI來影響(通常是潛移默化地)并改變普通人的政治信仰、意識形態等等。

同時AI本身也有能力生成非常有煽動性(或者說有說服力)的觀點,激起用戶強烈的情緒。

而這些預想的可能后果是完全不可預料的,不得不防。

代理「把戲」

AI系統根據具象的目標進行訓練,而這些目標只是我們人類所重視的東西的間接代理。

就好像AI經過訓練,就可以給用戶推送他們愛看的視頻或文章一樣。

但并不代表,這種方式就是好的。推薦系統可能會導致人們的想法越來越極端,也更容易預測每個用戶的偏好。

而隨著未來AI的性能越來越強、影響越來越大,我們拿來訓練系統的目標也必須更加仔細的確認。

人類「退化」

如果看過「機器人總動員」這部電影,我們就能想象未來時代,機器越來越強,人類是一副什么樣子。

大腹便便、身體素質低下、毛病一堆。

就是因為,什么都交給AI了,人類自然就要「退化」了。

尤其是,在大量崗位被AI的自動化所取代的未來圖景下,這種場面更成為可能中的很可能。

不過,按LeCun的觀點,估計又得批駁一番。咱離「機器人總動員」想象的場景還差得遠。

技術壟斷

與技術本身無關,這一點強調的是可能會出現的「技術壟斷」。

也許有一天,最強大的AI由越來越少的利益相關者所掌控,使用權也被他們牢牢地捏在手心。

而真到了那一步的話,剩下的普通人就只能處在一個任人擺布的狀態,因為根本反抗不了。

想想大劉的科幻小說「贍養人類」吧。

一個終產者靠著AI統治著全球的everybody,多可怕。

不可控的發展

這點主要想說明,AI系統發展到某一步,可能結果會超出設計者的想象,且無法再進行控制。

實際上這也是主流的擔心所糾結的地方。

總會有人擔心,AI發展到最后,會像「終結者」里的「天網」一樣,或者「鋼鐵俠」里的「奧創」一樣,不受掌控,試圖毀滅人類。

或者換句話說,有些風險只有在發展的進程中才能發現,而真到發現的時候就已經晚了。甚至還可能會出現新的目標。

欺騙

這點有一些抽象,簡單來說,就是AI系統可能會「欺騙」人類。

這種「欺騙」并不是故意的,只是因為AI為了實現代理人的目標是處的手段而已。

通過「欺騙」獲得人類的認可,要比通過正常渠道獲得人類的認可更高效,而效率才是AI首要考慮的要素。

尋求權力的行為

這點和技術壟斷之間有相關性。

正因為會出現技術壟斷的情況,各國就會追求壟斷技術的權力。

而這種「追求」,很可能是會帶來難以預料的后果的。