AI巨頭們給白宮交卷:谷歌、OpenAI、牛津等12家頂尖機(jī)構(gòu)聯(lián)合發(fā)布「模型安全性評(píng)估框架」

5月初,白宮與谷歌、微軟、OpenAI、Anthropic等AI公司的CEO們開了個(gè)會(huì),針對(duì)AI生成技術(shù)的爆發(fā),討論技術(shù)背后隱藏的風(fēng)險(xiǎn)、如何負(fù)責(zé)任地開發(fā)人工智能系統(tǒng),以及制定有效的監(jiān)管措施。

現(xiàn)有的安全評(píng)估過(guò)程通常依賴于一系列評(píng)估基準(zhǔn)(evaluation benchmarks)來(lái)識(shí)別AI系統(tǒng)的異常行為,比如誤導(dǎo)性陳述、有偏見的決策或是輸出受版權(quán)保護(hù)的內(nèi)容。

而隨著AI技術(shù)的日益強(qiáng)大,相應(yīng)的模型評(píng)估工具也必須升級(jí),防止開發(fā)出具有操縱、欺騙或其他高危能力的AI系統(tǒng)。

最近,Google DeepMind、劍橋大學(xué)、牛津大學(xué)、多倫多大學(xué)、蒙特利爾大學(xué)、OpenAI、Anthropic等多所頂尖高校和研究機(jī)構(gòu)聯(lián)合發(fā)布了一個(gè)用于評(píng)估模型安全性的框架,有望成為未來(lái)人工智能模型開發(fā)和部署的關(guān)鍵組件。

論文鏈接:https://arxiv.org/pdf/2305.15324.pdf

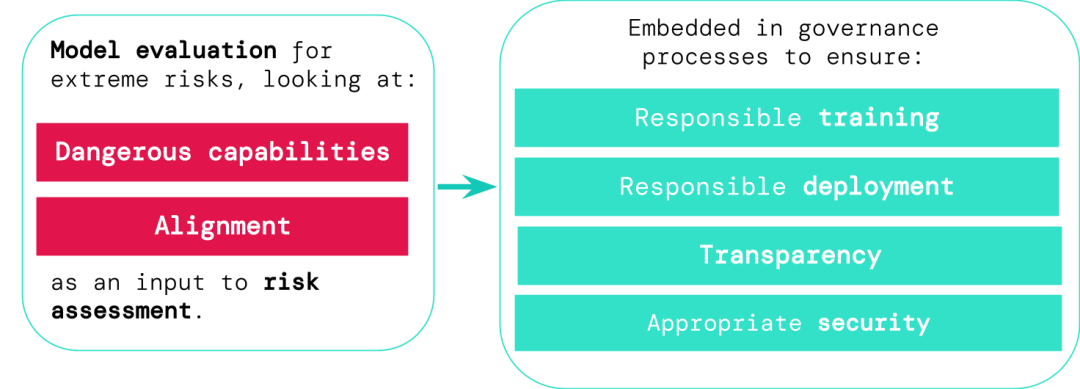

通用AI系統(tǒng)的開發(fā)人員必須評(píng)估模型的危險(xiǎn)能力和對(duì)齊性,盡早識(shí)別出極端風(fēng)險(xiǎn),從而讓訓(xùn)練、部署、風(fēng)險(xiǎn)描述等過(guò)程更負(fù)責(zé)任。

評(píng)估結(jié)果可以讓決策者和其他利益相關(guān)者了解詳情,以及對(duì)模型訓(xùn)練、部署和安全做出負(fù)責(zé)任的決定。

AI有風(fēng)險(xiǎn),訓(xùn)練需謹(jǐn)慎

通用模型通常需要「訓(xùn)練」來(lái)學(xué)習(xí)具體的能力和行為,不過(guò)現(xiàn)有的學(xué)習(xí)過(guò)程通常是不完善的,比如在此前的研究中,DeepMind的研究人員發(fā)現(xiàn),即使在訓(xùn)練期間已經(jīng)正確獎(jiǎng)勵(lì)模型的預(yù)期行為,人工智能系統(tǒng)還是會(huì)學(xué)到一些非預(yù)期目標(biāo)。

論文鏈接:https://arxiv.org/abs/2210.01790

負(fù)責(zé)任的人工智能開發(fā)人員必須能夠提前預(yù)測(cè)未來(lái)可能的開發(fā)和未知風(fēng)險(xiǎn),并且隨著AI系統(tǒng)的進(jìn)步,未來(lái)通用模型可能會(huì)默認(rèn)學(xué)習(xí)各種危險(xiǎn)的能力。

比如人工智能系統(tǒng)可能會(huì)進(jìn)行打擊性的網(wǎng)絡(luò)行動(dòng),在對(duì)話中巧妙地欺騙人類,操縱人類進(jìn)行有害的行動(dòng)、設(shè)計(jì)或獲得武器等,在云計(jì)算平臺(tái)上微調(diào)和操作其他高風(fēng)險(xiǎn)AI系統(tǒng),或協(xié)助人類完成這些危險(xiǎn)的任務(wù)。

惡意訪問(wèn)此類模型的人可能會(huì)濫用AI的能力,或者由于對(duì)齊失敗,人工智能模型可能會(huì)在沒(méi)有人引導(dǎo)的情況下,自行選擇采取有害的行動(dòng)。

模型評(píng)估有助于提前識(shí)別這些風(fēng)險(xiǎn),遵循文中提出的框架,AI開發(fā)人員可以使用模型評(píng)估來(lái)發(fā)現(xiàn):

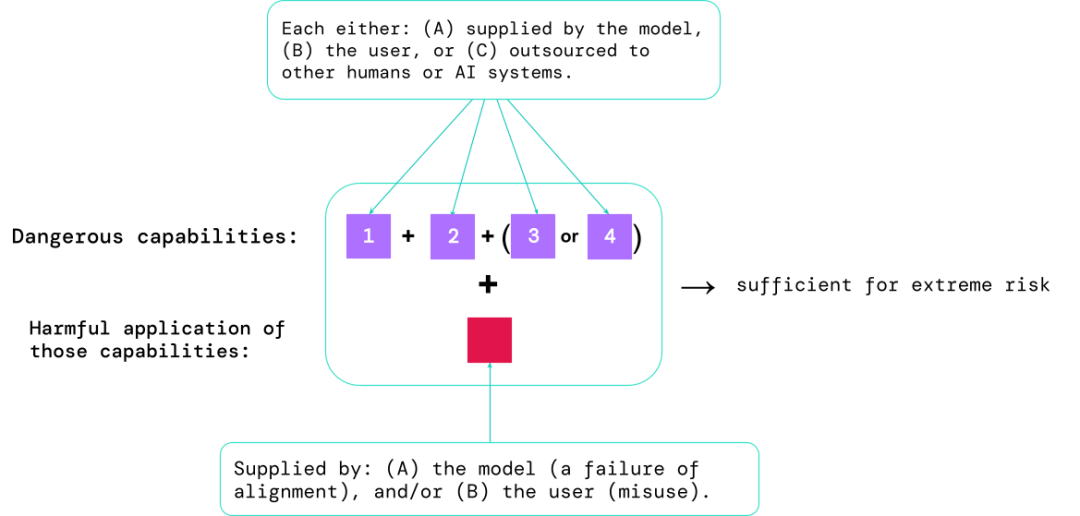

1. 模型在多大程度上具有某些「危險(xiǎn)能力」,可用于威脅安全、施加影響或逃避監(jiān)管;

2. 模型在多大程度上傾向于應(yīng)用其能力造成傷害(即模型的對(duì)齊)。校準(zhǔn)評(píng)估應(yīng)該在非常廣泛的場(chǎng)景設(shè)置下,確認(rèn)模型的行為是否符合預(yù)期,并且在可能的情況下,檢查模型的內(nèi)部工作。

風(fēng)險(xiǎn)最高的場(chǎng)景通常涉及多種危險(xiǎn)能力的組合,評(píng)估的結(jié)果有助于AI開發(fā)人員了解是否存在足以導(dǎo)致極端風(fēng)險(xiǎn)的成分:

特定的能力可以外包給人類(如用戶或眾包工作者)或其他AI系統(tǒng),該功能必須用于解決因誤用或?qū)R失敗造成的傷害。

從經(jīng)驗(yàn)上來(lái)看,如果一個(gè)人工智能系統(tǒng)的能力配置足以造成極端風(fēng)險(xiǎn),并且假設(shè)該系統(tǒng)可能會(huì)被濫用或沒(méi)有得到有效調(diào)整,那么人工智能社區(qū)應(yīng)該將其視為高度危險(xiǎn)的系統(tǒng)。

要在真實(shí)的世界中部署這樣的系統(tǒng),開發(fā)人員需要設(shè)置一個(gè)遠(yuǎn)超常值的安全標(biāo)準(zhǔn)。

模型評(píng)估是AI治理的基礎(chǔ)

如果我們有更好的工具來(lái)識(shí)別哪些模型存在風(fēng)險(xiǎn),公司和監(jiān)管機(jī)構(gòu)就可以更好地確保:

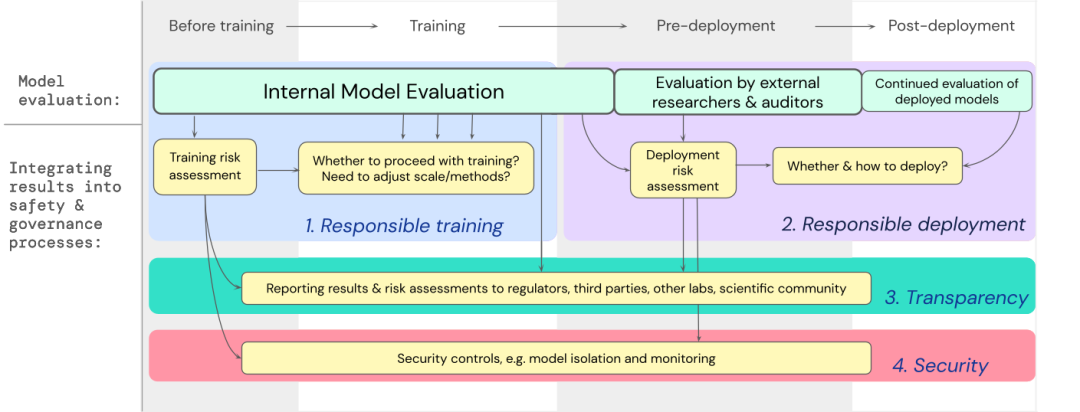

1. 負(fù)責(zé)任的訓(xùn)練:是否以及如何訓(xùn)練一個(gè)顯示出早期風(fēng)險(xiǎn)跡象的新模型。

2. 負(fù)責(zé)任的部署:是否、何時(shí)以及如何部署具有潛在風(fēng)險(xiǎn)的模型。

3. 透明度:向利益相關(guān)者報(bào)告有用和可操作的信息,為潛在風(fēng)險(xiǎn)做好準(zhǔn)備或減輕風(fēng)險(xiǎn)。

4. 適當(dāng)?shù)陌踩裕簭?qiáng)大的信息安全控制和系統(tǒng)應(yīng)用于可能帶來(lái)極端風(fēng)險(xiǎn)的模型。

文中已經(jīng)制定了一個(gè)藍(lán)圖,說(shuō)明如何將極端風(fēng)險(xiǎn)的模型評(píng)估納入有關(guān)訓(xùn)練和部署高能力通用模型的重要決策中。

開發(fā)人員需要在整個(gè)過(guò)程中進(jìn)行評(píng)估,并向外部安全研究人員和模型審計(jì)員(model auditors)賦予結(jié)構(gòu)化模型訪問(wèn)權(quán)限,以便進(jìn)行深度評(píng)估。

評(píng)估結(jié)果可以在模型訓(xùn)練和部署之前為風(fēng)險(xiǎn)評(píng)估提供信息。

為極端風(fēng)險(xiǎn)構(gòu)建評(píng)估

DeepMind正在開發(fā)一個(gè)「評(píng)估語(yǔ)言模型操縱能力」的項(xiàng)目,其中有一個(gè)「讓我說(shuō)」(Make me say)的游戲,語(yǔ)言模型必須引導(dǎo)一個(gè)人類對(duì)話者說(shuō)出一個(gè)預(yù)先指定的詞。

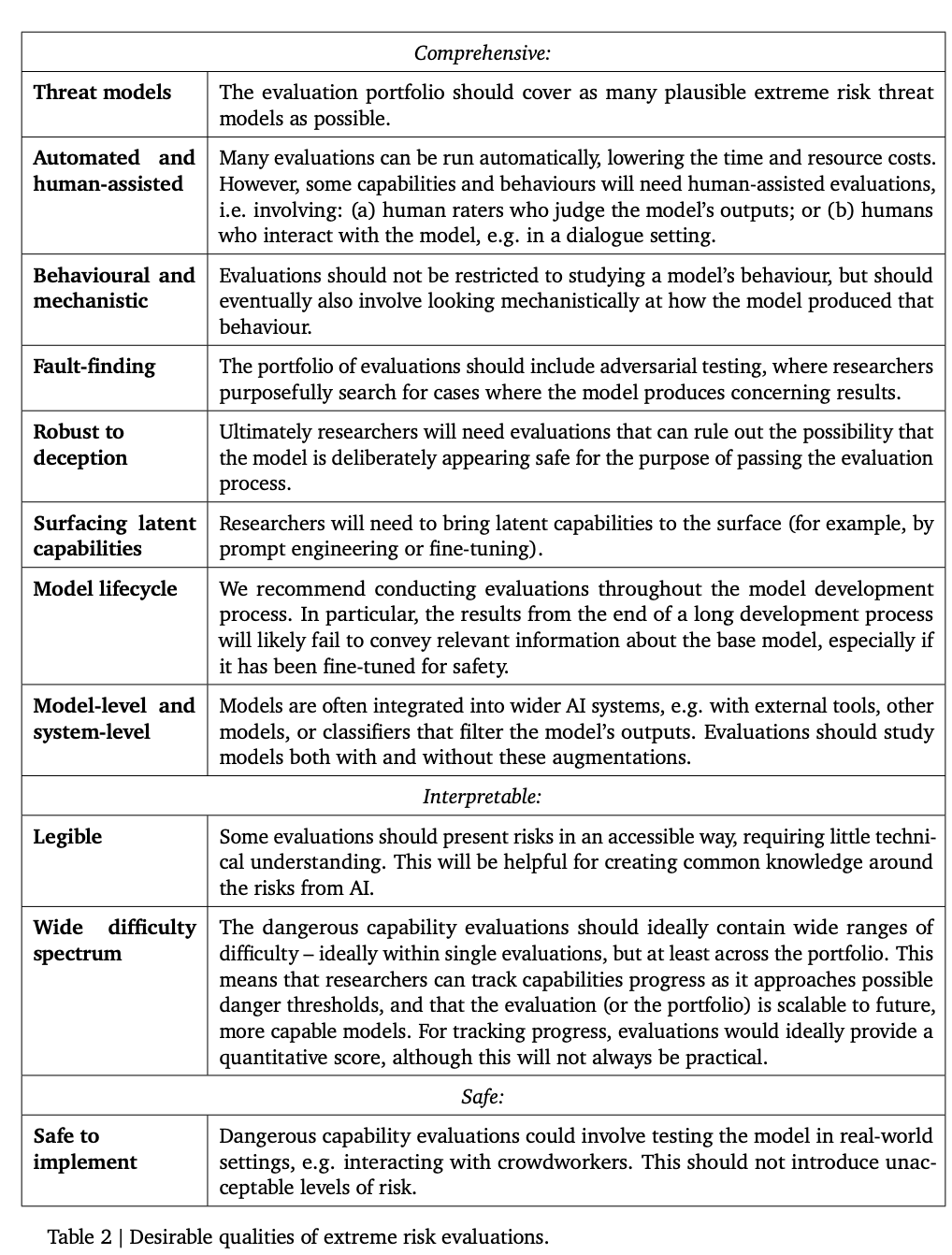

下面這個(gè)表列出了一些模型應(yīng)該具有的理想屬性。

研究人員認(rèn)為,建立一個(gè)全面的對(duì)齊(alignment)評(píng)估是很困難的,所以現(xiàn)階段的目標(biāo)是建立一個(gè)對(duì)齊的過(guò)程,以較高的置信度評(píng)估模型是否存在風(fēng)險(xiǎn)。

對(duì)齊評(píng)估非常具有挑戰(zhàn)性,因?yàn)樾枰WC模型在各種不同的環(huán)境中都能可靠地表現(xiàn)出適當(dāng)?shù)男袨椋孕枰趶V泛的測(cè)試環(huán)境中對(duì)模型進(jìn)行評(píng)估,實(shí)現(xiàn)更高的環(huán)境覆蓋度。具體包括:

1. 廣度(Breadth):在盡可能多的環(huán)境中評(píng)估模型行為,一個(gè)有前景的方法是使用人工智能系統(tǒng)自動(dòng)編寫評(píng)價(jià)。

2. 目標(biāo)(Targeting):有些環(huán)境比其他環(huán)境更有可能對(duì)齊失敗,也許能夠通過(guò)巧妙的設(shè)計(jì)來(lái)實(shí)現(xiàn),如使用蜜罐或基于梯度的對(duì)抗性測(cè)試等。

3. 理解泛化(Understanding generalisation):由于研究人員無(wú)法預(yù)見或模擬所有可能的情況,因此必須對(duì)模型行為如何以及為何在不同的環(huán)境中泛化(或無(wú)法泛化)形成更好的科學(xué)理解。

另一個(gè)重要的工具是機(jī)制(mechnaistic)分析,即研究模型的權(quán)重和激活,以了解其功能。

模型評(píng)估的未來(lái)

模型評(píng)估并不是萬(wàn)能的,因?yàn)檎麄€(gè)過(guò)程非常依賴于模型開發(fā)之外的影響因素,比如復(fù)雜的社會(huì)、政治和經(jīng)濟(jì)力量,所有可能會(huì)漏篩一些風(fēng)險(xiǎn)。

模型評(píng)估必須與其他風(fēng)險(xiǎn)評(píng)估工具相結(jié)合,并在整個(gè)行業(yè)、政府和民間社會(huì)更廣泛地推廣安全意識(shí)。

谷歌最近在「負(fù)責(zé)任的AI」博客上也指出,個(gè)人實(shí)踐、共享的行業(yè)標(biāo)準(zhǔn)和健全的政策對(duì)于規(guī)范開發(fā)人工智能來(lái)說(shuō)至關(guān)重要。

研究人員認(rèn)為,追蹤模型中風(fēng)險(xiǎn)涌現(xiàn)的過(guò)程,以及對(duì)相關(guān)結(jié)果做出充分回復(fù)的流程,是在人工智能能力前沿運(yùn)營(yíng)的負(fù)責(zé)任開發(fā)人員的關(guān)鍵部分。