利用大模型打造文本摘要訓練新范式

1、文本任務

這篇文章主要討論的是生成式文本摘要的方法,如何利用對比學習和大模型實現最新的生成式文本摘要訓練范式。主要涉及兩篇文章,一篇是BRIO: Bringing Order to Abstractive Summarization(2022),利用對比學習在生成模型中引入ranking任務;另一篇是On Learning to Summarize with Large Language Models as References(2023),在BRIO基礎上進一步引入大模型生成高質量訓練數據。

2、生成式文本摘要訓練方法和問題

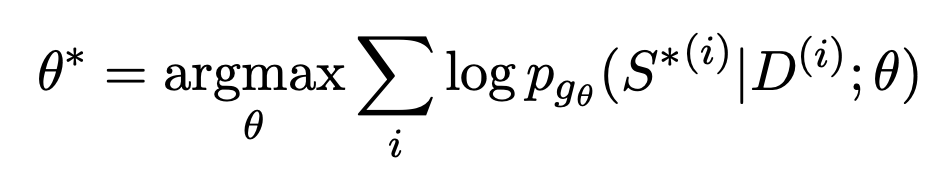

生成式文本摘要的訓練一般采用極大似估計的方式。首先用一個Encoder對document進行編碼,然后用一個Decoder遞歸的預測摘要中的每個文本,擬合的目標是一個人工構造的摘要標準答案。整個優化函數可以表示為如下形式,讓每個位置生成文本的概率和標準答案最接近:

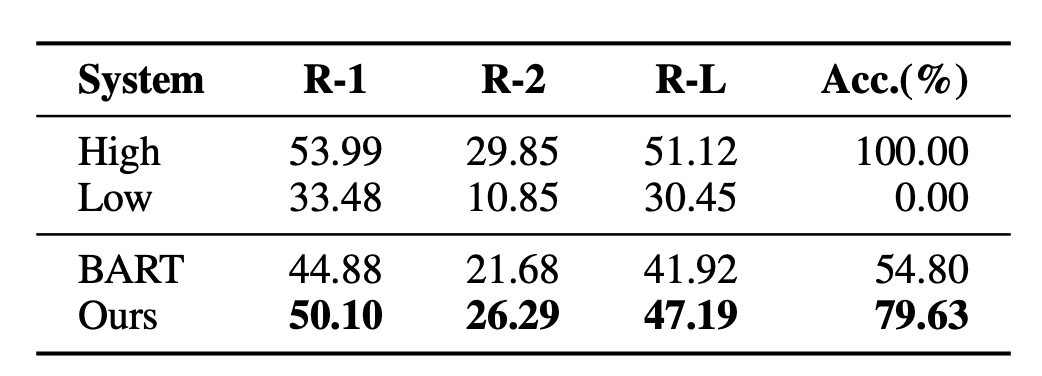

這種方式的問題在于,訓練和下游實際任務并不一致。對于一個document,可以產生很多摘要,這些摘要的質量有好有壞。而MLE要求擬合的目標必須是唯一一個標準答案。這種gap也導致文本摘要模型無法比較好的評估兩個質量不同摘要的好壞程度。例如在BRIO這篇論文中做了一個實驗,一般的文本摘要模型在判斷質量不同的兩個摘要的相對順序時,效果非常差。

3、生成模型引入排序對比學習

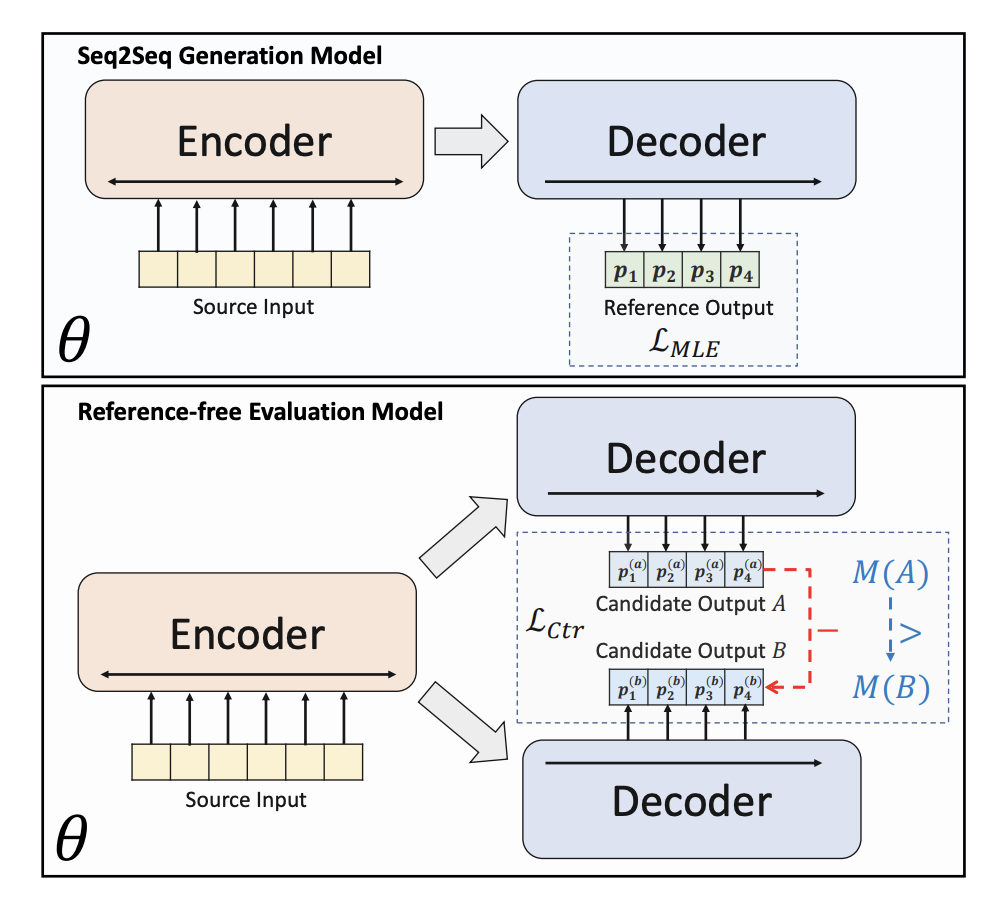

為了解決傳統生成式文本摘要模型存在的問題,BRIO: Bringing Order to Abstractive Summarization(2022)提出在生成模型中進一步引入對比學習任務,提升模型對不同質量摘要的排序能力。

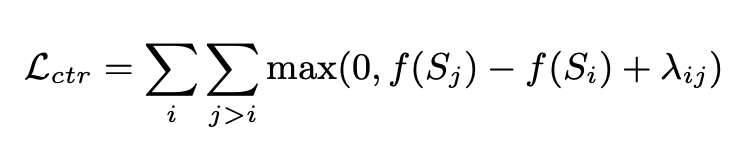

BRIO采用多任務的形式進行訓練。第一個任務和傳統生成式模型相同,也是MLE的方式擬合標準答案。第二個任務是一個對比學習任務,讓一個預訓練的文本摘要模型使用beam search生成不同的兩個結果,使用ROUGE評估這兩個生成結果和標準答案之間哪個更好,以確定這兩個摘要的排序。這兩個摘要結果輸入到Decoder中,得到兩個摘要的概率,通過對比學習loss讓模型給高質量摘要更高的打分。這部分對比學習loss的計算方式如下:

4、大模型優化文本摘要

隨著GPT等大模型的興起,人們發現用大模型生成的摘要甚至比人工生成的質量還要好。這種情況下,使用人工生成的標準答案就限制了模型效果的天花板。因此On Learning to Summarize with Large Language Models as References(2023)提出使用GPT這種大模型生成訓練數據,指導摘要模型學習。

這篇文章提出了3種利用大模型生成訓練樣本的方式。

第一種是直接使用大模型生成的摘要,替代人工生成的摘要,相當于直接用下游模型擬合大模型的摘要生成能力,訓練方式仍然是MLE。

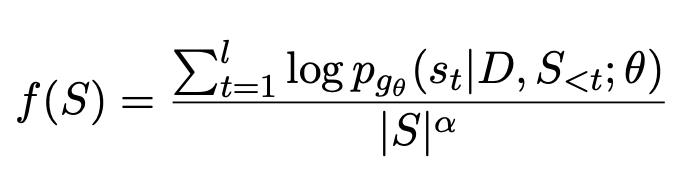

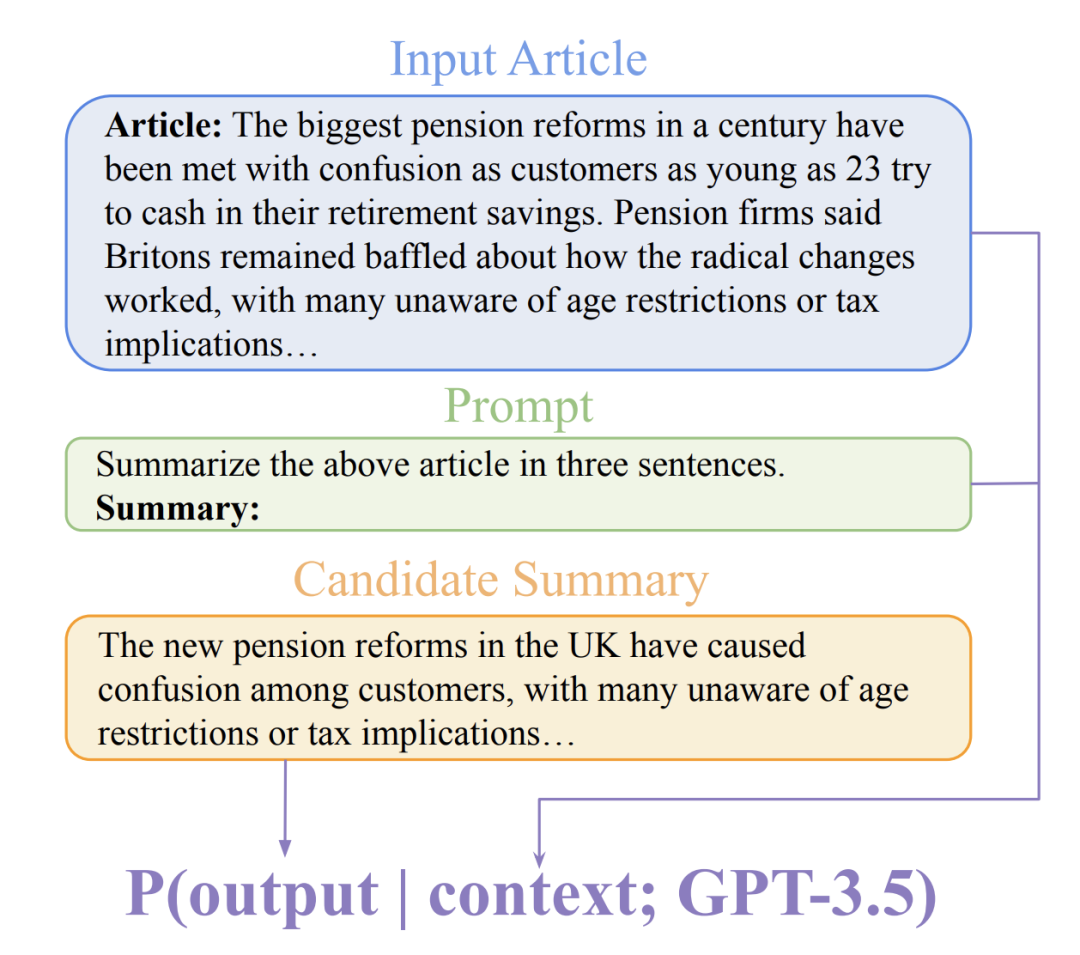

第二種方式為GPTScore,主要是利用預訓練大模型對生成的摘要進行打分,以這個打分作為評估摘要質量的依據,然后使用類似BRIO中的方式進行對比學習訓練。GPTScore是Gptscore: Evaluate as you desire(2023)中提出的一種基于大模型評估生成文本質量的方法。

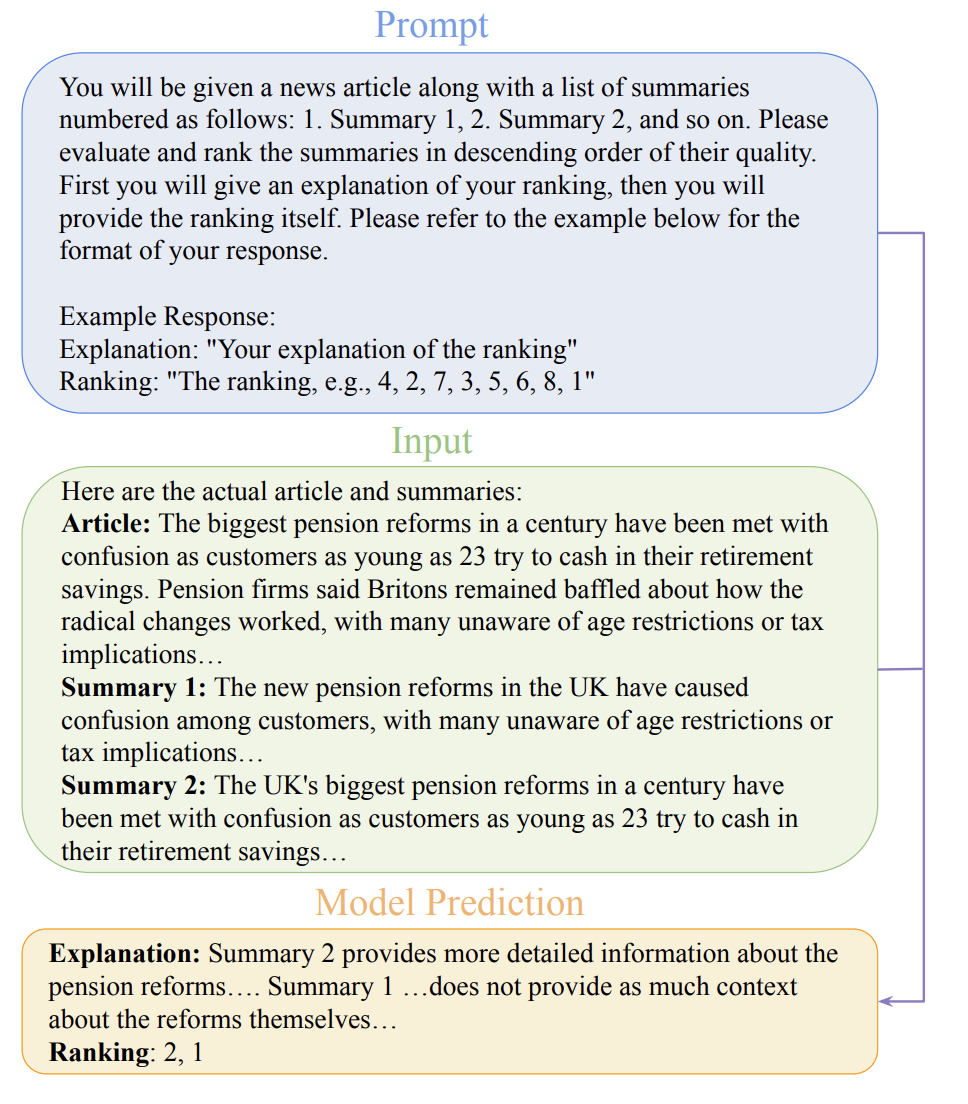

第三種方式為GPTRank,這種方法讓大模型對各個摘要進行排序而非直接打分,并讓大模型對排序邏輯做出解釋,以此獲取更合理的排序結果。

5、總結

大模型在摘要生成上的能力得到越來越廣泛的認可,因此利用大模型作為摘要模型擬合目標的生成器,取代人工標注結果,將成為未來的發展趨勢。同時,利用排序對比學習進行摘要生成的訓練,讓摘要模型感知摘要質量,超越原本的點擬合,對于提升摘要模型效果也至關重要。