LeCun再爆金句:ChatGPT?連條狗都比不上!語言模型喂出來的而已

圖靈三巨頭之一的LeCun昨日又爆金句。

「論聰明程度,ChatGPT可能連條狗都不如。」

這句話來自本周四LeCun在Vivatech上和Jacques Attalie的一場辯論,可謂精彩紛呈。

CNBC甚至直接把這句話放到了標題里,而LeCun也在之后火速轉推。

“ChatGPT和狗:比不了一點”

LeCun表示,當前的AI系統,哪怕是ChatGPT,根本就不具備人類的智能水平,甚至還沒有狗聰明。

要知道,在AI爆炸發展的今天,無數人已經為ChatGPT的強大性能所折服。在這種情況下,LeCun的這句話可謂驚世駭俗。

不過,LeCun一貫的觀點都是——不必太過緊張,如今的AI智能水平遠遠沒到我們該擔憂的地步。

而其他的科技巨頭則基本和LeCun持截然相反的意見。

比如同為圖靈三巨頭的Hinton和Bengio,以及AI屆人士由Sam Altman挑頭簽的公開信,馬斯克的危機言論等等。

在這種大環境下,LeCun一直「不忘初心」,堅定認為現在真沒啥可擔心的。

LeCun表示,目前的生成式AI模型都是在LLM上訓練的,而這種只接受語言訓練的模型聰明不到哪去。

「這些模型的性能非常有限,他們對現實世界沒有任何理解。因為他們純粹是在大量文本上訓練的。」

而又因為大部分人類所擁有的知識其實和語言無關,所以這部分內容AI是捕捉不到的。

LeCun打了個比方,AI現在可以通過律師考試,因為考試內容都停留在文字上。但AI絕對沒可能安裝一個洗碗機,而一個10歲的小孩兒10分鐘就能學會怎么裝。

這就是為什么LeCun強調,Meta正嘗試用視頻訓練AI。視頻可不僅僅是語言了,因此用視頻來訓練在實現上會更加艱巨。

LeCun又舉了個例子,試圖說明什么叫智能上的差別。

一個五個月大的嬰兒看到一個漂浮的東西,并不會想太多。但是一個九個月大的嬰兒再看到一個漂浮的物體就會感到非常驚訝。

因為在九個月大的嬰兒的認知里,一個物體不該是漂浮著的。

LeCun表示,如今我們是不知道如何讓AI實現這種認知能力的。在能做到這一點之前,AI根本就不可能擁有人類智能,連貓貓狗狗的都不可能。

Attali:我也要簽公開信

在這場討論中,法國經濟和社會理論家Jaques Attali表示,AI的好壞取決于人們如何進行利用。

然而他卻對未來持悲觀態度。他和那些簽公開信的AI大牛一樣,認為人類會在未來三四十年內面臨很多危險。

他指出,氣候災難和戰爭是他最為關注的問題,同時擔心AI機器人會「阻撓」我們。

Attali認為,需要為AI技術的發展設置邊界,但由誰來設定、設定怎么樣的邊界仍是未知的。

這和前一陣子簽的兩封公開信所主張的內容相同。

當然,公開信LeCun也是壓根沒搭理,發推高調表示哥們兒沒簽。

LeCun炮轟ChatGPT——沒停過

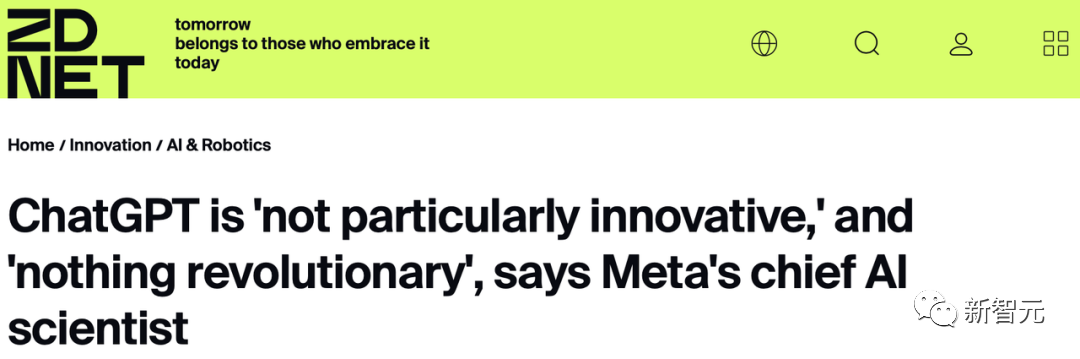

而在此之前,LeCun針對ChatGPT不止講過過一次類似的話。

就在今年的1月27日,Zoom的媒體和高管小型聚會上,LeCun對ChatGPT給出了一段令人驚訝的評價——

「就底層技術而言,ChatGPT并不是多么了不得的創新。雖然在公眾眼中,它是革命性的,但是我們知道,它就是一個組合得很好的產品,僅此而已。」

「除了谷歌和Meta之外,還有六家初創公司,基本上都擁有非常相似的技術。」

此外,他還表示,ChatGPT用的Transformer架構是谷歌提出的,而它用的自監督方式,正是他自己提倡的,那時OpenAI還沒誕生呢。

當時鬧得更大,Sam Altman直接在推上給LeCun取關了。

1月28日,LeCun梅開二度,繼續炮轟ChatGPT。

他表示,「大型語言模型并沒有物理直覺,它們是基于文本訓練的。如果它們能從龐大的聯想記憶中檢索到類似問題的答案,他們可能會答對物理直覺問題。但它們的回答,也可能是完全錯誤的。」

而LeCun對LLM的看法一以貫之,從未改變。從昨天的辯論就可以看出,他覺得語言訓練出來的東西毫無智能可言。

今年2月4日,LeCun直白地表示,「在通往人類級別AI的道路上,大型語言模型就是一條歪路」。

「依靠自動回歸和響應預測下一個單詞的LLM是條歪路,因為它們既不能計劃也不能推理。」

當然,LeCun是有充分的理由相信這一點的。

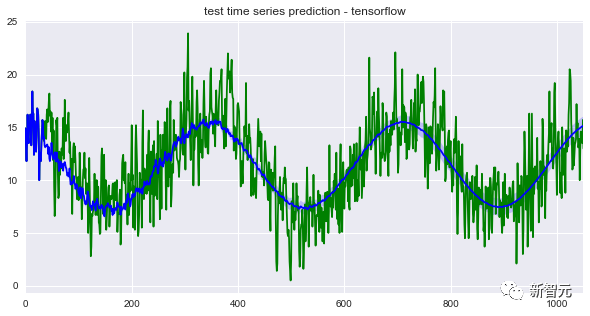

ChatGPT這種大語言模型是「自回歸」。AI接受訓練,從一個包含多達14000億個單詞的語料庫中提取單詞,預測給定句子序列中的最后一個單詞,也就是下一個必須出現的單詞。

Claude Shannon在上個世紀50年代開展的相關研究就是基于這一原則。

原則沒變,變得是語料庫的規模,以及模型本身的計算能力。

LeCun表示,「目前,我們無法靠這類模型生成長而連貫的文本,這些系統不是可控的。比如說,我們不能直接要求ChatGPT生成一段目標人群是13歲兒童的文本。

其次,ChatGPT生成的文本作為信息來源并不是100%可靠的。GPT的功能更像是一種輔助工具。就好比現有的駕駛輔助系統一樣,開著自動駕駛功能,也得把著方向盤。

而且,我們今天所熟知的自回歸語言模型的壽命都非常短,五年算是一個周期,五年以后,過去的模型就沒有人再會用了。

而我們的研究重點,就應該集中在找到一種是這些模型可控的辦法上。換句話說,我們要研究的AI,是能根據給定目標進行推理和計劃的AI,并且得能保證其安全性和可靠性的標準是一致的。這種AI能感受到情緒。」

要知道,人類情緒的很大一部分和目標的實現與否有關,也就是和某種形式的預期有關。

而有了這樣的可控模型,我們就能生成出長而連貫的文本。

LeCun的想法是,未來設計出能混合來自不同工具的數據的增強版模型,比如計算器或者搜索引擎。

像ChatGPT這樣的模型只接受文本訓練,因此ChatGPT對現實世界的認識并不完整。而想要在此基礎上進一步發展,就需要學習一些和整個世界的感官知覺、世界結構有關的內容。

然而好玩兒的是,Meta自己的模型galactica.ai上線三天就被網友噴的查無此人了。

原因是胡話連篇。