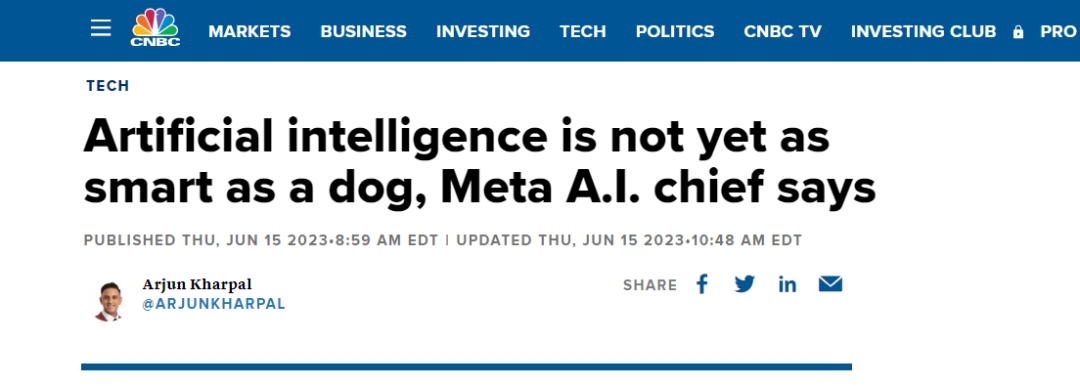

“CNN之父” Yann LeCun:人工智能沒腦子,智商不如一條狗

大數據文摘出品

被譽為深度學習三巨頭之一的Yann LeCun一直是樂天派,他不止在一個場合表達他對人工智能(AI)發展的樂觀預期。例如:“AI是人類智慧的放大器,AI越強大,人類就越聰明,更快樂和更有經濟效率。”

今日,CNBC有篇文章披露出了Yann LeCun對AI能力現狀的定義:它還不如一條狗聰明。至于原因,LeCun談到:

那些系統只在文本上訓練,它們對現實世界的基本現實沒有任何理解,然而大部分人類知識與語言無關……所以大部分人類經驗AI是學不會的。”

為了論證 LeCun的觀點,他舉了個例子,現在的AI系統可以通過美國的律師資格考試,然而,AI不會用/裝(load)洗碗機,一個10歲的小孩卻10分鐘就能搞定。

更深層次的原因,是AI無法復制人類能力,例如五月大的嬰兒看到水上漂浮物體可能無感,但九月大的嬰兒可能會表現出震驚,因為他會意識到物體不應該漂浮。

“不知道如何用機器復制這種能力。在我們能做到這一點之前,AI不會擁有人類水平的智能,也不會擁有狗或貓水平的智能。”LeCun如此解釋。

CNN之父的人工智能觀點

在去年的十月份,Yann LeCun在接采訪中提到,“今天的人工智能方法永遠不會帶來真正的智能。所有人工智能都面臨某些基本問題,特別是如何衡量信息。”

而最近公開的演講中,更是強烈批判GPT大模型所使用的方法,即根據概率生成自回歸的大模型,根本無法破除幻覺難題。

此前, LeCun提出目前AI研究面臨的三大挑戰,而這些挑戰也是GPT所使用方法無法解決的。

- AI如何學會表征世界,學習預測,并學習主要通過觀察來行動?

- AI如何才能以與基于梯度的學習相兼容的方式進行推理和計劃?

- AI如何學習在多個抽象層次和多個時間尺度上以層次化的方式表示感知和行動規劃?

針對上述問題,LeCun提出了兩個解決方向。一是運用自監督學習方法,減少系統學習所需的數據量,這本質上是通過預訓練來獲得更好的性能。二是進行端到端的訓練,設計一些能夠處理邊緣情況的系統,通過強化控制來解決問題。

圖源:北京智源大會

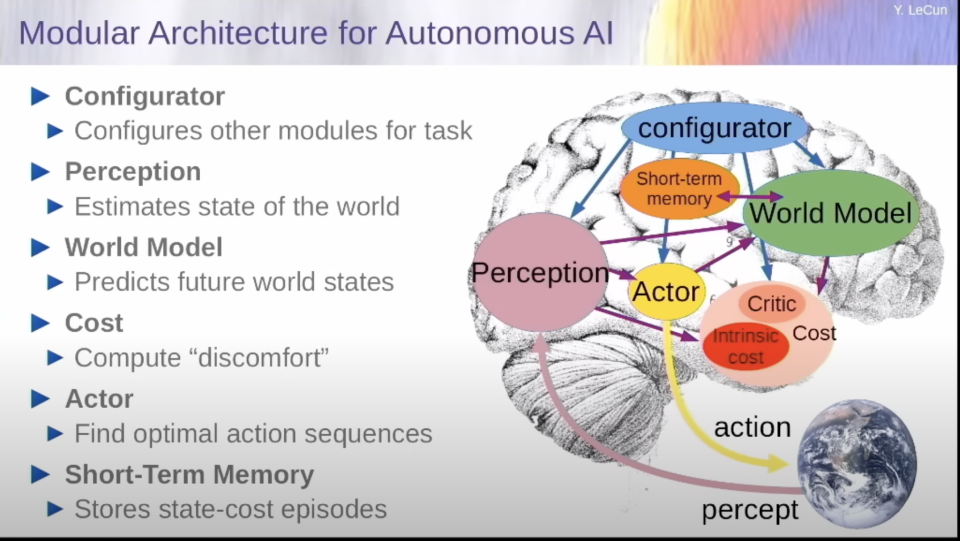

更為具體,他提出世界模型,給人工智能的下一步,提供解決方案。在他的設想中,世界模型為一個不光是在神經水平上模仿人腦的模型,而是在認知模塊上也完全貼合人腦分區的模型。它與大語言模型最大的差別在于可以有規劃和預測能力(世界模型),成本核算能力(成本模塊)。

通過世界模型,它可以真正的理解這個世界,并預測和規劃未來。通過成本核算模塊,結合一個簡單的需求(一定按照最節約行動成本的邏輯去規劃未來),它就可以杜絕一切潛在的毒害和不可靠性。

至于如何實現世界模型,LeCun認為可以采用自監督模型去訓練,比如一定要建立多層級的思維模式........

安全or危險?AI發展的兩種預見

和LeCun同年“摘取”圖靈獎得主盛譽的Geoffrey Hinton卻有著不一樣的觀點:

“這些超級智能出現的時間可能比我過去認為的要早得多......超級智能顯然會學得非常擅長欺騙人,可以讓人們實際執行它喜歡的任何動作。這非常可怕!””

從最近一些領域大咖的表態來看,似乎站臺Hinton,認為AI危險的人數更多一些。例如特斯拉的頭頭馬斯克表示,人工智能是未來文明面臨的最大危險之一。

而在今年五月份,大量學者、專家簽名公開信《AI 風險聲明》,信中警告稱如果對先進人工智能的發展監管不當,可能會對人類構成生存威脅。

這封公開信與以往不同,因為其中許多重要簽署者在 AI 實驗室、大型科技公司擔任要職。其中包括圖靈獎得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席執行官 Sam Altman,Google DeepMind 聯合創始人兼 CEO Demis Hassabis,微軟首席技術官 Kevin Scott,谷歌副總裁 James Manyika,OpenAI 首席科學家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已簽名。

而Hinton更是離職谷歌,表達畢生的后悔。他對造就了如今AI技術繁榮的神經網絡,表示抱歉。

參考鏈接:

https://new.qq.com/rain/a/20230612A08QO700

https://www.cnbc.com/2023/06/15/ai-is-not-even-at-dog-level-intelligence-yet-meta-ai-chief.html

https://mp.weixin.qq.com/s/LDTpMoDaIf3tTATxWeaSgg

https://mp.weixin.qq.com/s/GxEfoD06P1UPIIbFTbTgEg