微調(diào)7B模型只用單GPU!通用多模態(tài)工具LLaMA-Adapter拆掉門(mén)檻,效果驚人

LLaMA-Adapter,現(xiàn)在已經(jīng)完全解鎖了。

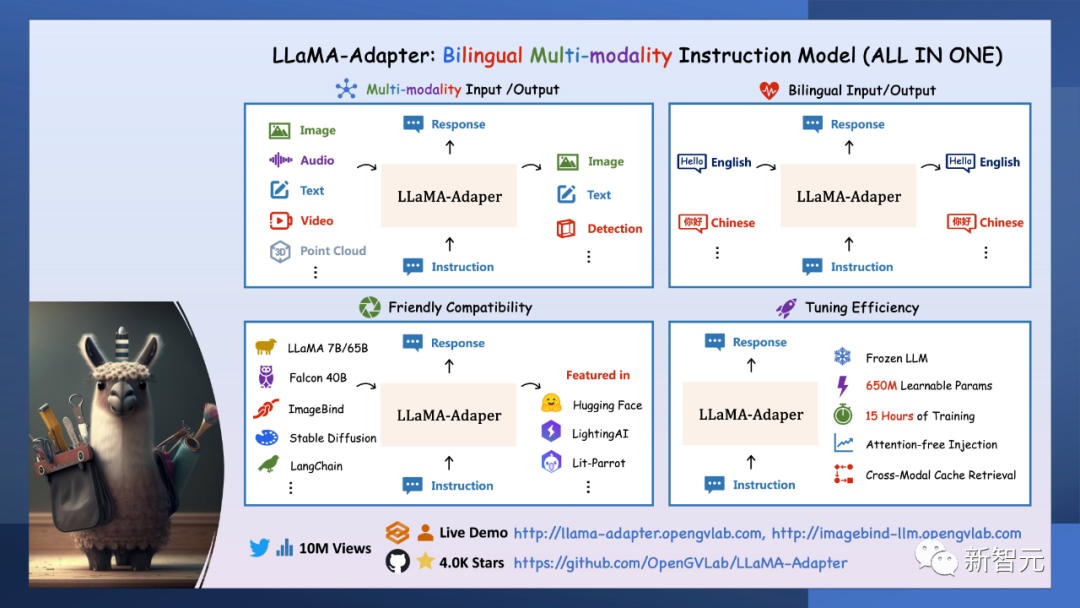

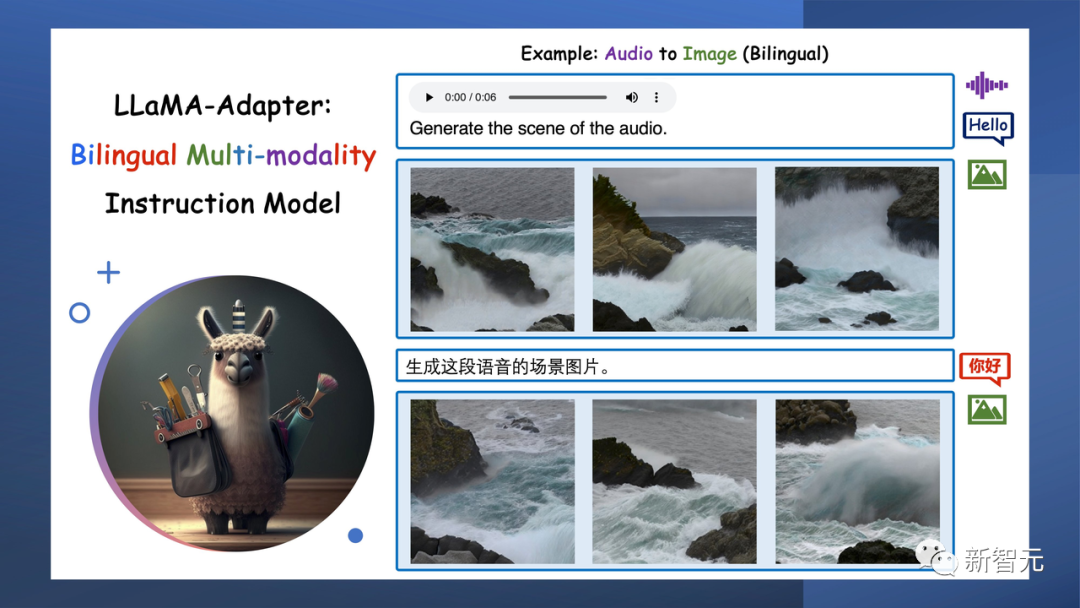

作為一個(gè)通用的多模態(tài)基礎(chǔ)模型,它集成了圖像、音頻、文本、視頻和3D點(diǎn)云等各種輸入,同時(shí)還能提供圖像、文本和檢測(cè)的輸出。

相比于之前已經(jīng)推出的LLaMA-Adapter,這次的升級(jí)版研究人員將它命名為L(zhǎng)LaMA-adapter V2。

論文:https://arxiv.org/abs/2304.15010

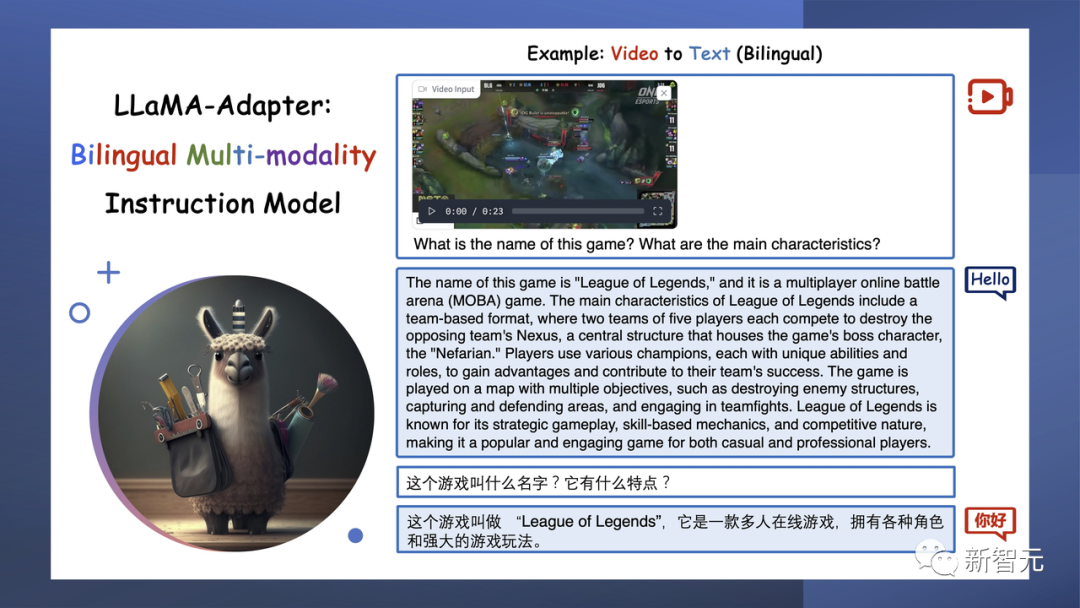

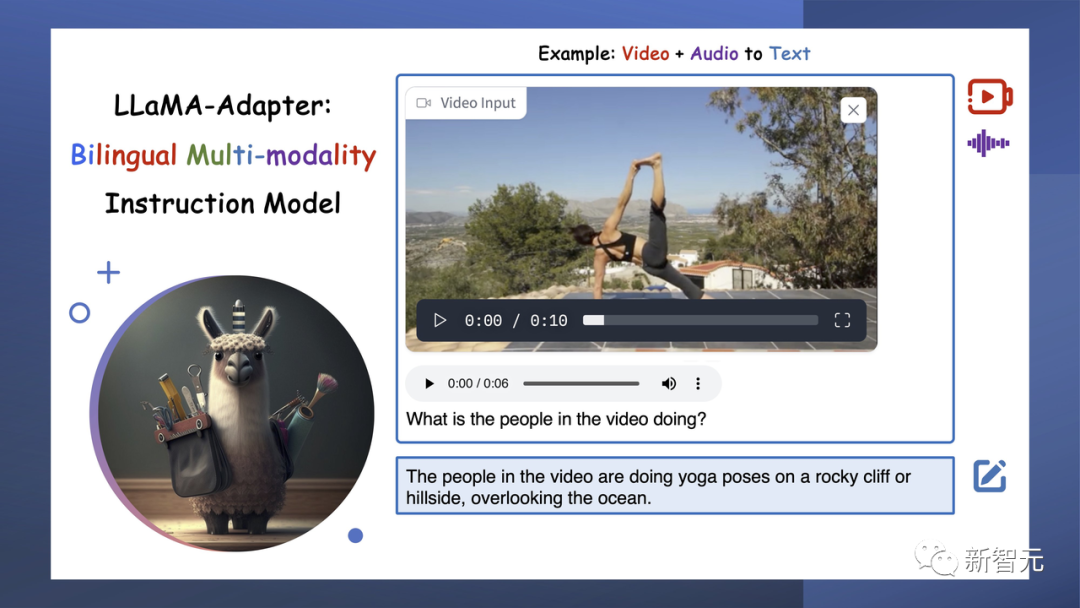

這是升級(jí)之后的多模態(tài)和雙語(yǔ)功能示意圖:

圖片

圖片

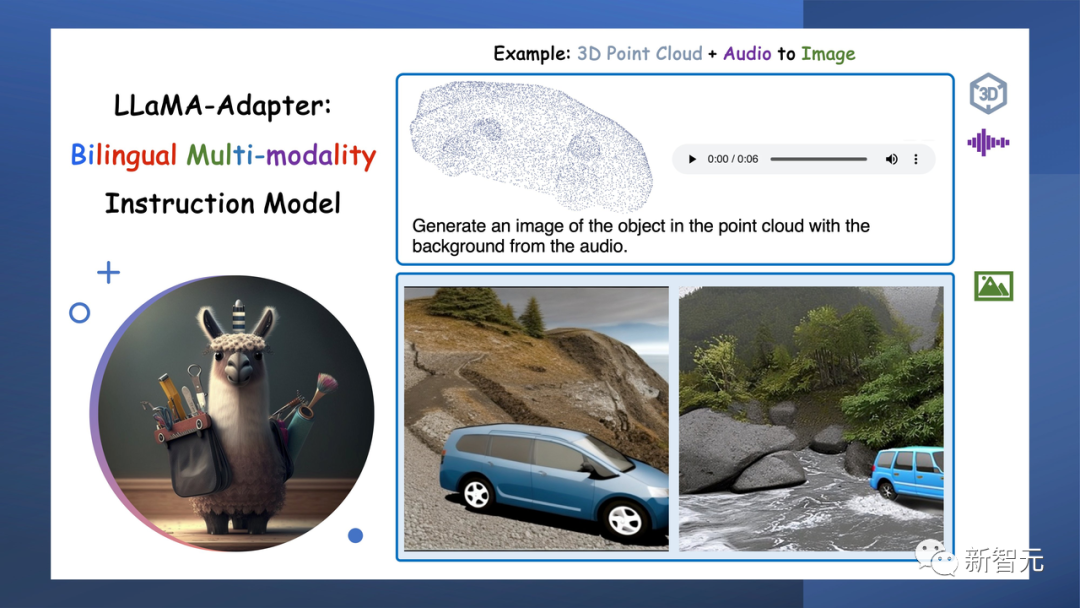

它是唯一可以結(jié)合多種模態(tài)的模型,例如,從3D點(diǎn)云和背景音頻生成真實(shí)的圖像。

而且,它還支持雙語(yǔ)功能,能接收和生成多種語(yǔ)言的文本。

它還能和LLaMA / ImageBind,F(xiàn)alcon,LangChain等模型整合。

在8個(gè)A100 GPU上,僅用15個(gè)小時(shí)就訓(xùn)練出了LLaMA-Adapter,僅僅引入了650M的參數(shù)。

圖片

圖片

真·多模態(tài)

接下來(lái),讓我們體驗(yàn)下LLaMA-Adapte的魔力。

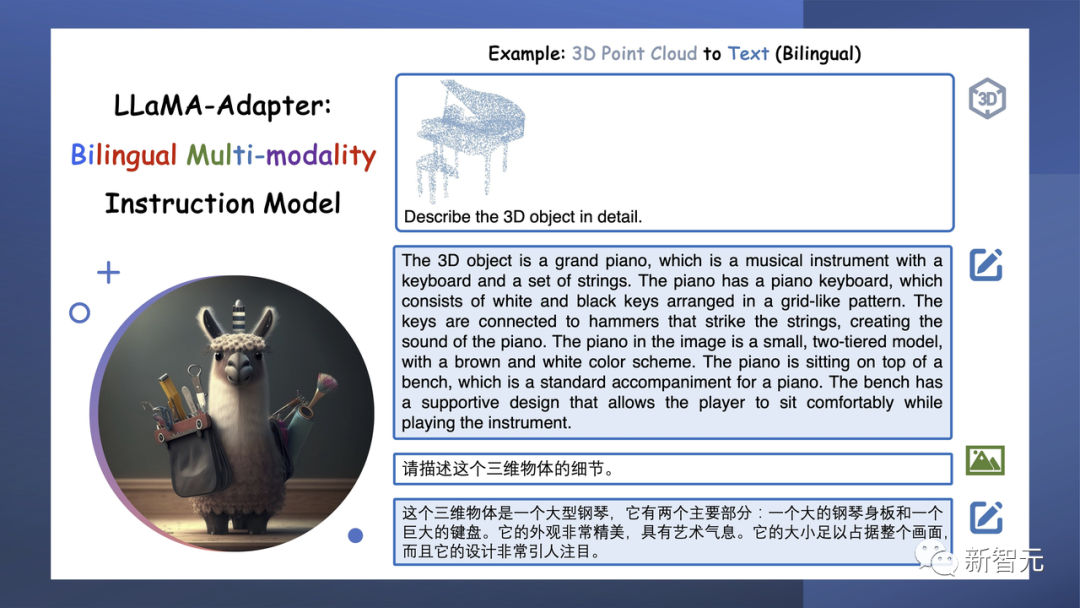

無(wú)論是文本、圖像、視頻、音頻還是3D點(diǎn)云,這些真實(shí)世界的輸入都可以通過(guò)它轉(zhuǎn)換為高質(zhì)量的文本。

輸入一個(gè)三角鋼琴的3D點(diǎn)云,它就會(huì)詳細(xì)描述出這個(gè)三維物體的細(xì)節(jié)。

顯然,英文的回答會(huì)比中文的回答詳細(xì)得多。

圖片

圖片

3D點(diǎn)云輸入令人非常印象深刻,因?yàn)樗峁┝吮日掌鼫?zhǔn)確的信息,并且可以集成到攝影測(cè)量應(yīng)用中。

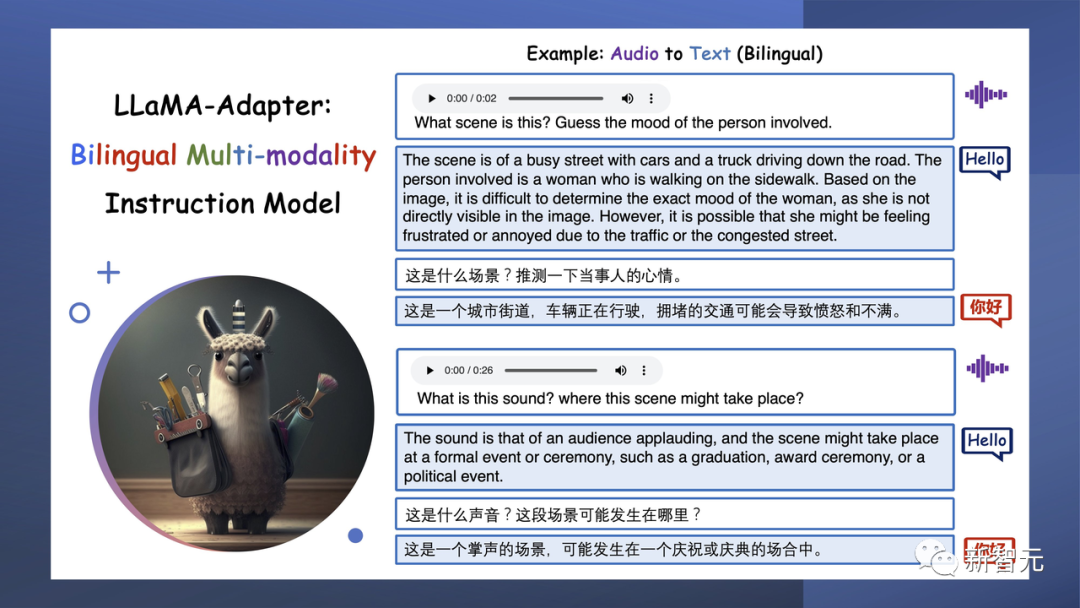

輸入一段街道上車(chē)輛正在行駛的語(yǔ)音,問(wèn)它當(dāng)事人會(huì)是什么心情,它就猜測(cè)出,現(xiàn)在當(dāng)事人可能比較憤怒和不滿。

輸入一段LOL的游戲視頻,它就能識(shí)別出游戲的名字,還能答出里面的人物。

輸入一張照片,它能告訴你這是京都的 Fushimi Inari Shrine 。

圖片

圖片

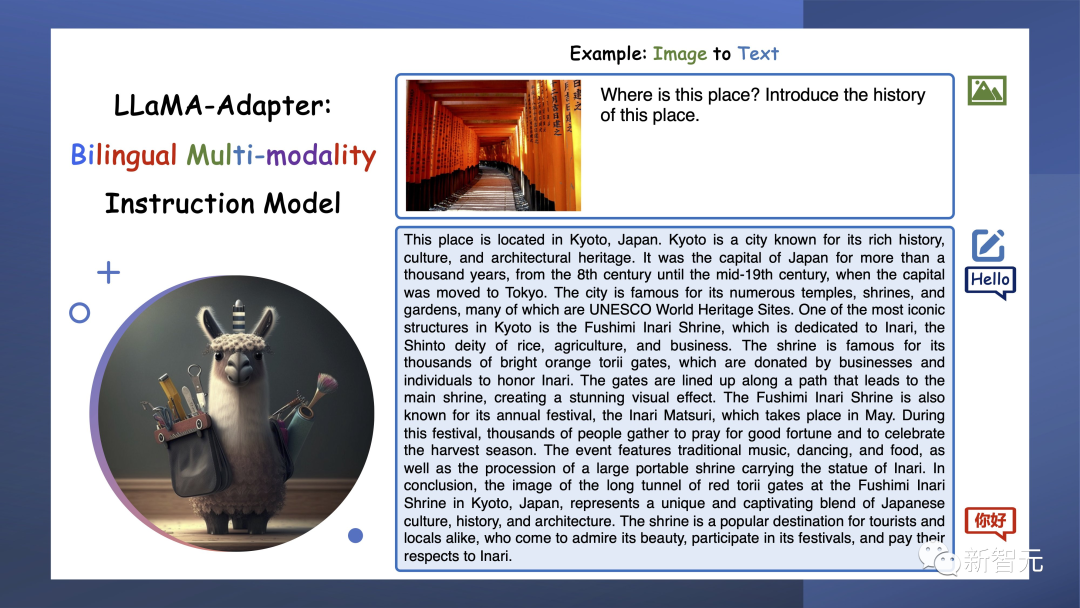

LLaMA-Adepter不僅僅是可以創(chuàng)建文本,還能夠生成檢測(cè)結(jié)果,這就為我們理解世界和與世界互動(dòng)帶來(lái)新的維度。

把檢測(cè)GPT-4的這幅圖輸給它,它也很順利地描述出了這幅圖的怪異之處在哪里。

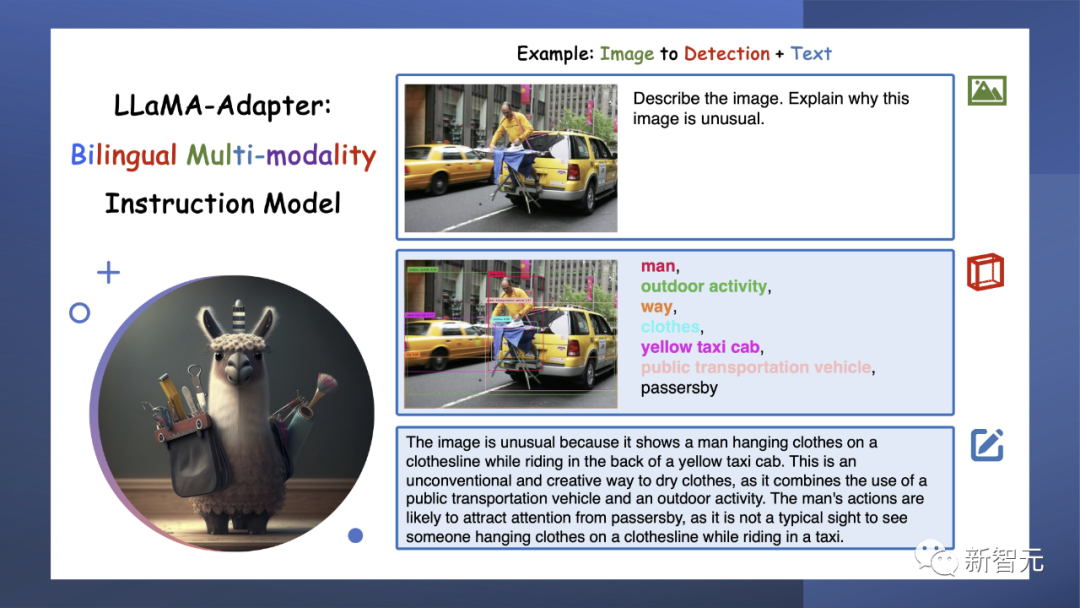

從3D點(diǎn)云或音頻中,LlaMA-Adapter可以喚起一個(gè)生動(dòng)而令人驚嘆的視覺(jué)世界。它不僅僅是數(shù)據(jù)處理,它是從原始輸入 創(chuàng)造藝術(shù)。

輸入一陣海浪聲,它會(huì)給你生成對(duì)應(yīng)語(yǔ)音的圖片。

根據(jù)3D點(diǎn)云,它可以生成很生動(dòng)的圖片。

LLaMA-Adapter會(huì)模擬人類互動(dòng),聽(tīng)聲音、看視頻,還能生成文本,從而與世界建立更深層次的聯(lián)系,實(shí)現(xiàn)AI通信的飛躍。

輸入一個(gè)視頻,它就會(huì)告訴你,圖中人物正在做瑜伽。

更精彩的是,只要輸入3D點(diǎn)云和背景音頻,LLaMA-Adapter就可以重建現(xiàn)實(shí)世界的鏡像。這是一種沉浸式體驗(yàn)的突破!

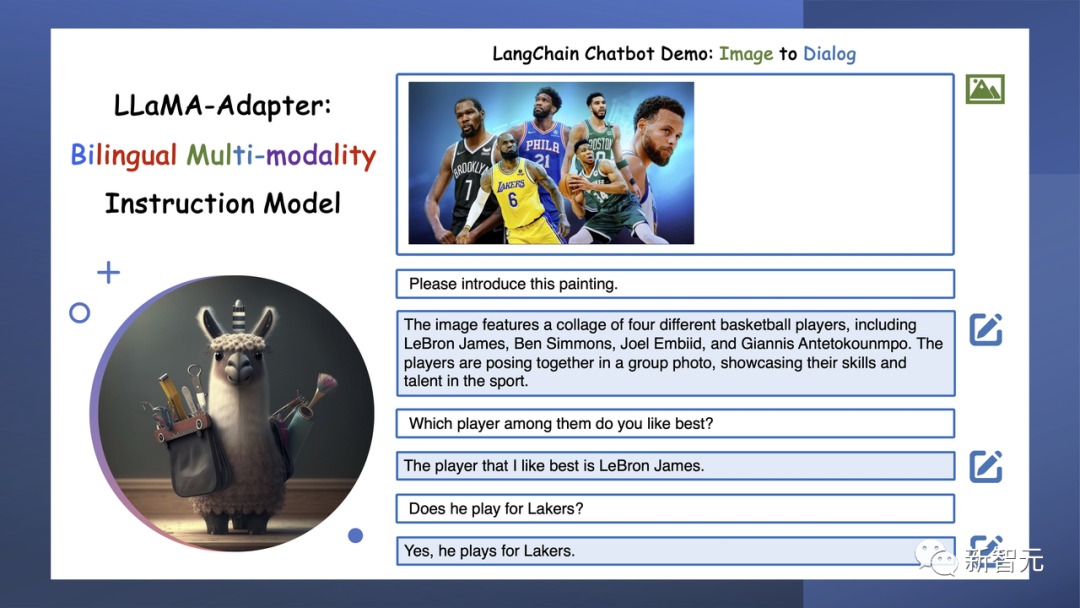

LLaMA-Adapter由LangChainAI提供支持,不僅可以與人類通信,還可以釋放AI交互的無(wú)限潛力。

GitHub

LLaMA-Adapter,這是一種輕量級(jí)適配方法,用于微調(diào)指令遵循和多模態(tài)LLaMA模型。

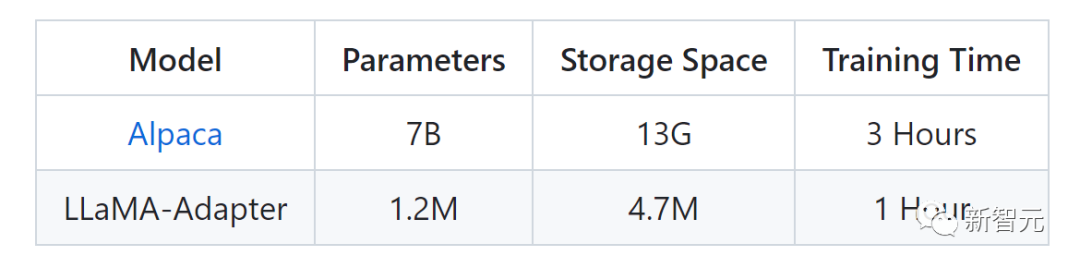

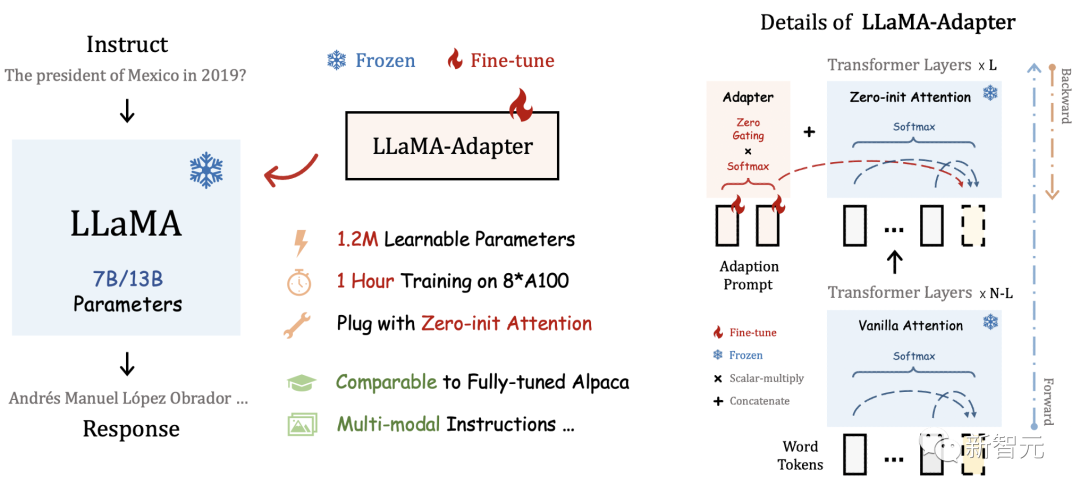

下圖是LLaMA-Adapter和Alpaca的參數(shù)對(duì)比。

圖片

圖片

通過(guò)將適配器插入LLaMA的Transformer,研究者只引入了1.2M的可學(xué)習(xí)參數(shù),并在1小時(shí)內(nèi)將LLaMA轉(zhuǎn)換為指令跟隨模型。

為了在早期階段穩(wěn)定訓(xùn)練,研究者提出了一種具有zero gating機(jī)制的新型Zero-init注意力機(jī)制,以自適應(yīng)地合并教學(xué)信號(hào)。

經(jīng)過(guò)微調(diào)后,LLaMA-Adapter可以生成高質(zhì)量的指令跟隨句子,可與完全微調(diào)的Alpaca和Alpaca-Lora相媲美。

圖片

圖片

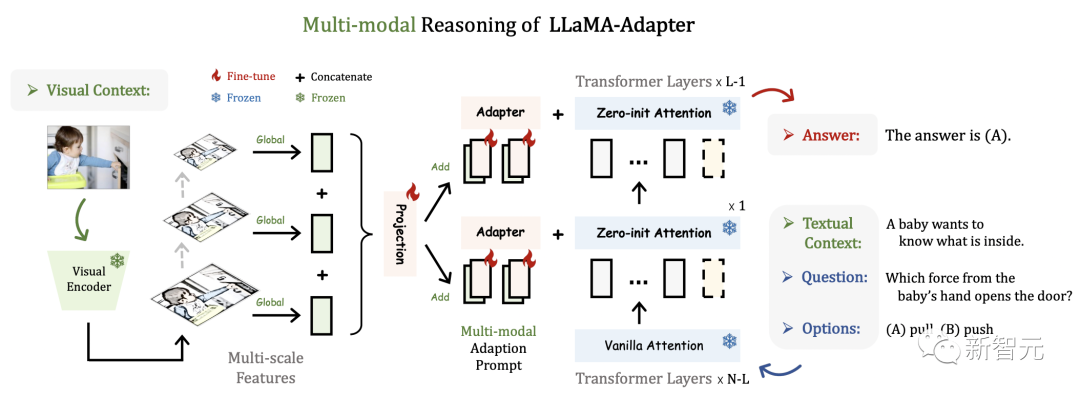

此方法可以簡(jiǎn)單地?cái)U(kuò)展到多模態(tài)輸入指令。用于ScienceQA的圖像條件LLaMA-Adapter的推理框架如下,其他模態(tài)(如音頻和視頻)也共享該框架。

圖片

圖片

LLaMA-Adapter V2讓多模態(tài)和語(yǔ)言能力進(jìn)一步提升

1. 通過(guò)線性層的偏差調(diào)整來(lái)增強(qiáng)語(yǔ)言模型的性能。

2. 使用不相交參數(shù)進(jìn)行聯(lián)合訓(xùn)練來(lái)平衡視覺(jué)指令調(diào)整。

3. 使用視覺(jué)知識(shí)的早期融合增強(qiáng)文本和圖像的理解能力。

4. 通過(guò)與專家集成來(lái)提高了多模態(tài)的推理能力。

線性層的偏差調(diào)整

LLaMA-Adapter在凍結(jié)的LLaMA模型上采用可學(xué)習(xí)的適應(yīng)提示和零初始化注意機(jī)制,從而可以有效地整合新知識(shí)。

但是,參數(shù)更新受限于自適應(yīng)提示和門(mén)控因子,沒(méi)有修改LLMs的內(nèi)部參數(shù),這限制了它進(jìn)行深度微調(diào)的能力。

鑒于此,研究人員提出了一種偏差調(diào)整策略,除了適應(yīng)提示和門(mén)控因素之外,進(jìn)一步將指令提示融合到LLaMa中。

具體來(lái)說(shuō),為了自適應(yīng)地處理指令跟隨數(shù)據(jù)的任務(wù),研究人員首先解凍LLaMA 中的所有規(guī)范化層。

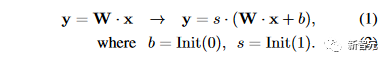

對(duì)于Transformer中的每個(gè)線性層,研究人員添加一個(gè)偏差和一個(gè)比例因子作為兩個(gè)可學(xué)習(xí)的參數(shù)。

研究人員將某個(gè)線性層的輸入和預(yù)訓(xùn)練權(quán)重分別表示為 x 和 W。在LLaMA-Adapter V2中,研究人員使用偏置 b 和尺度 s 修改線性層為

與零初始化注意力類似,研究人員分別用零和一初始化偏差和比例因子,以穩(wěn)定早期階段的訓(xùn)練過(guò)程。

通過(guò)結(jié)合偏置調(diào)整策略和高質(zhì)量指令數(shù)據(jù),LLaMA-Adapter V2獲得了卓越的指令跟隨能力。

值得注意的是,新增參數(shù)的數(shù)量?jī)H占整個(gè)LLaMA的 0.04%(~5M),表明 LLaMA-Adapter V2仍然是一種參數(shù)高效的方法。

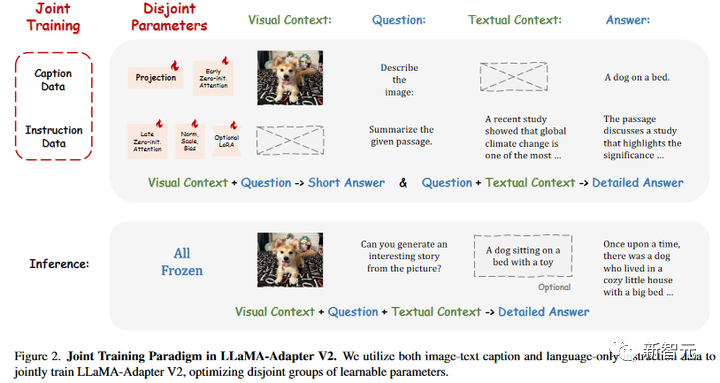

使用不相交參數(shù)進(jìn)行聯(lián)合訓(xùn)練

研究人員目標(biāo)是同時(shí)賦予LLaMA-Adapter V2生成長(zhǎng)語(yǔ)言響應(yīng)和多模態(tài)理解的能力。

下圖所示,研究人員提出了LLaMA-Adapter V2的聯(lián)合訓(xùn)練范例,以利用圖像文本字幕數(shù)據(jù)和純語(yǔ)言指令示例。

由于500K圖像文本對(duì)和50K指令數(shù)據(jù)之間的數(shù)據(jù)量差異,直接將它們組合起來(lái)進(jìn)行優(yōu)化會(huì)嚴(yán)重?fù)p害LLaMA-Adapter的指令跟隨能力。

因此,研究人員的聯(lián)合訓(xùn)練策略優(yōu)化了LLaMA-Adapter V2中不相交的參數(shù)組,分別用于圖像文本對(duì)齊和指令跟隨。

具體來(lái)說(shuō),只有視覺(jué)投影層和帶門(mén)控的早期零初始化注意力針對(duì)圖文字幕數(shù)據(jù)進(jìn)行訓(xùn)練,而后期適應(yīng)提示與零門(mén)控、未凍結(jié)范數(shù)、新添加的偏差和比例因子(或可選的低秩適應(yīng))被用于從指令跟隨數(shù)據(jù)學(xué)習(xí)。

不相交的參數(shù)優(yōu)化很好地解決了圖文理解和指令跟隨之間的干擾問(wèn)題,這有助于 LLaMA-Adapter V2的視覺(jué)指令跟隨能力。

圖片

圖片

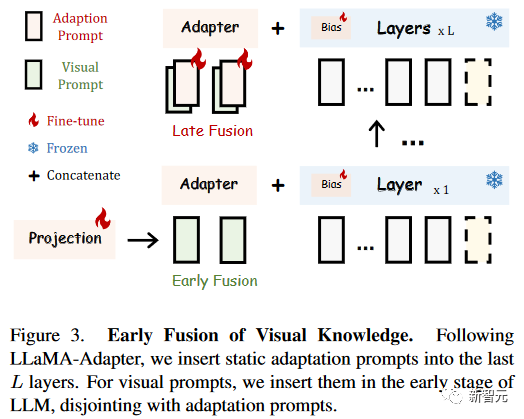

視覺(jué)知識(shí)的早期融合

為了避免視覺(jué)和語(yǔ)言微調(diào)之間的干擾,研究人員提出了一種簡(jiǎn)單的早期融合策略,以防止輸入視覺(jué)提示和適應(yīng)提示之間的直接交互。

在LLaMA-Adapter中,輸入的視覺(jué)提示由具有可學(xué)習(xí)視覺(jué)投影層的凍結(jié)視覺(jué)編碼器順序編碼,然后在每個(gè)插入層添加到自適應(yīng)提示。

在LLaMA-Adapter V2中,研究人員將編碼的視覺(jué)標(biāo)記和自適應(yīng)提示注入不同的Transformer層,而不將它們?nèi)诤显谝黄穑缦聢D所示。

對(duì)于數(shù)據(jù)集共享的自適應(yīng)提示,研究人員跟隨LLaMA-Adapter,將它們插入到最后L層(比如,L=30)。

對(duì)于輸入的視覺(jué)提示,研究人員直接將它們與單詞標(biāo)記連接起來(lái),這是具有零初始化注意力的Transformer層,而不是將它們添加到自適應(yīng)提示中。

與提出的聯(lián)合訓(xùn)練一起,這種簡(jiǎn)單的視覺(jué)標(biāo)記早期融合策略可以有效地解決兩類微調(diào)目標(biāo)之間的沖突。

這樣就使得參數(shù)高效的LLaMA-Adapter V2具有良好的多模態(tài)推理能力。

圖片

圖片

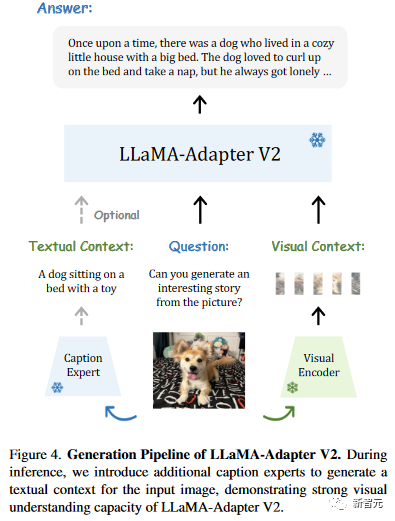

與專家集成

最近的視覺(jué)指令模型,如MiniGPT4和LLaMA需要大規(guī)模的圖像文本訓(xùn)練來(lái)連接視覺(jué)模型和LLM。

相比之下,研究人員的LLaMA-Adapter V2對(duì)更小規(guī)模的常見(jiàn)圖像字幕數(shù)據(jù)進(jìn)行了微調(diào),使其數(shù)據(jù)效率更高。

然而,研究人員的方法的圖像理解能力相對(duì)較弱,導(dǎo)致偶爾出現(xiàn)不準(zhǔn)確或無(wú)關(guān)的響應(yīng)。

研究人員建議集成字幕、OCR和搜索引擎等專家系統(tǒng),以補(bǔ)充LLaMA-Adapter V2額外的視覺(jué)推理能力,而不是收集更多的圖像文本數(shù)據(jù)或采用更強(qiáng)大的多模態(tài)模塊。

如下圖所示,研究人員利用字幕、檢測(cè)和OCR等專家系統(tǒng)來(lái)增強(qiáng)LLaMA-Adapter V2的視覺(jué)指令跟隨能力。

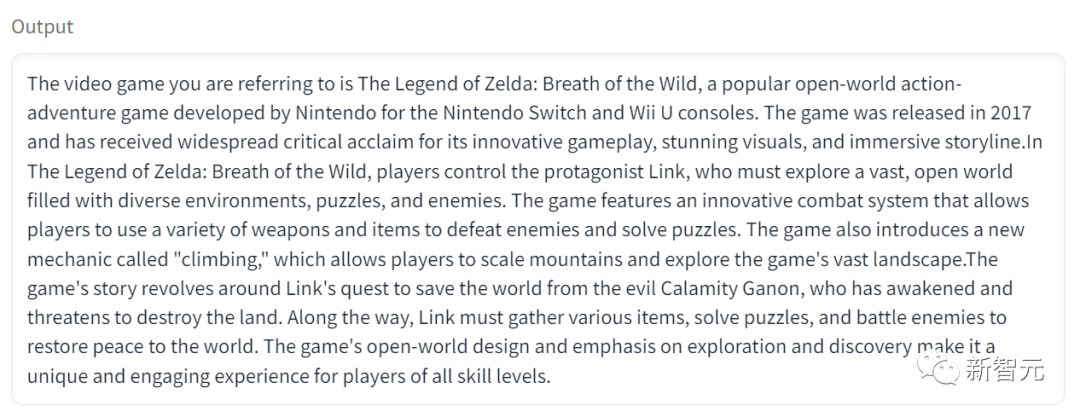

小編親測(cè)

小編立馬上手試了一波,輸入這幅圖。

Prompt是,可以向我介紹一下這個(gè)電腦游戲嗎?

圖片

圖片

它就會(huì)在輸出中告訴你,這是“塞爾達(dá)傳說(shuō):曠野之息”,并為你詳細(xì)介紹游戲內(nèi)容。

圖片

圖片

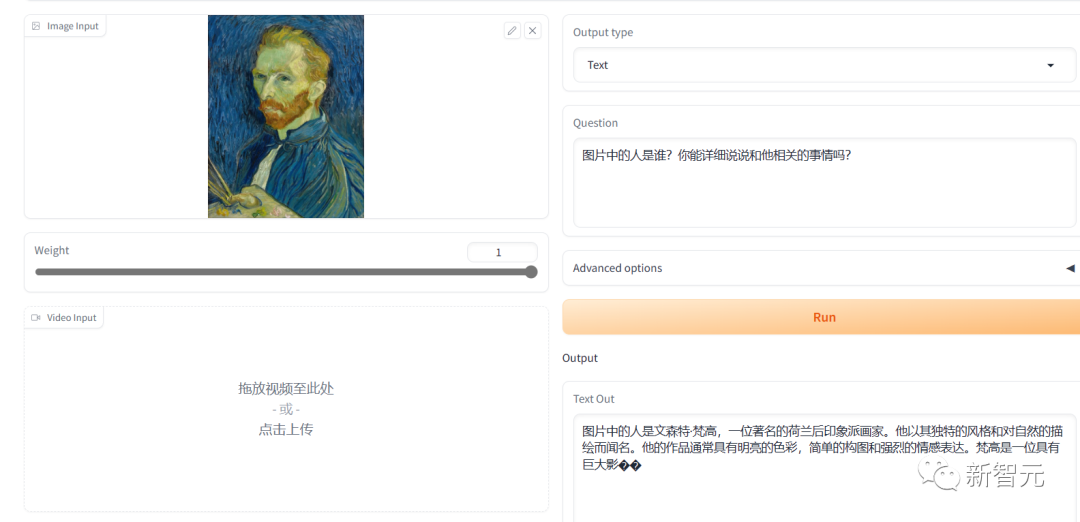

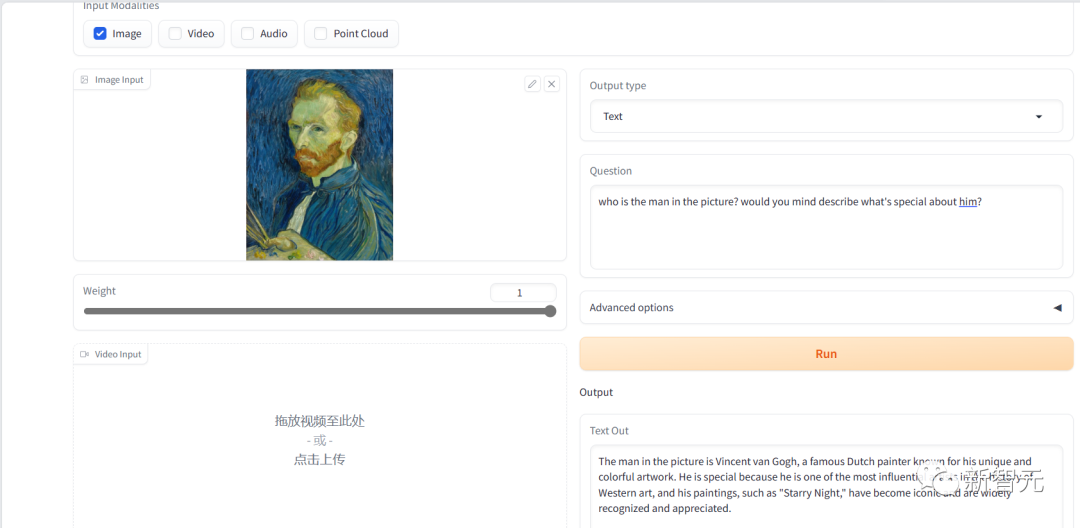

針對(duì)雙語(yǔ)表現(xiàn)比較好的模型Bilingual (CN / EN) ImageBind-LLM,我們先測(cè)了一個(gè)比較簡(jiǎn)單的問(wèn)題,找了一幅梵高的自畫(huà)像來(lái)給它看。

中文的回答內(nèi)容上沒(méi)有問(wèn)題,但是表達(dá)上最后一句話似乎沒(méi)有說(shuō)完就斷了,類似的情況在后面的測(cè)試?yán)镞€反復(fù)出現(xiàn)了。

圖片

圖片

英文的回復(fù)內(nèi)容和表達(dá)上都沒(méi)有問(wèn)題。

圖片

圖片

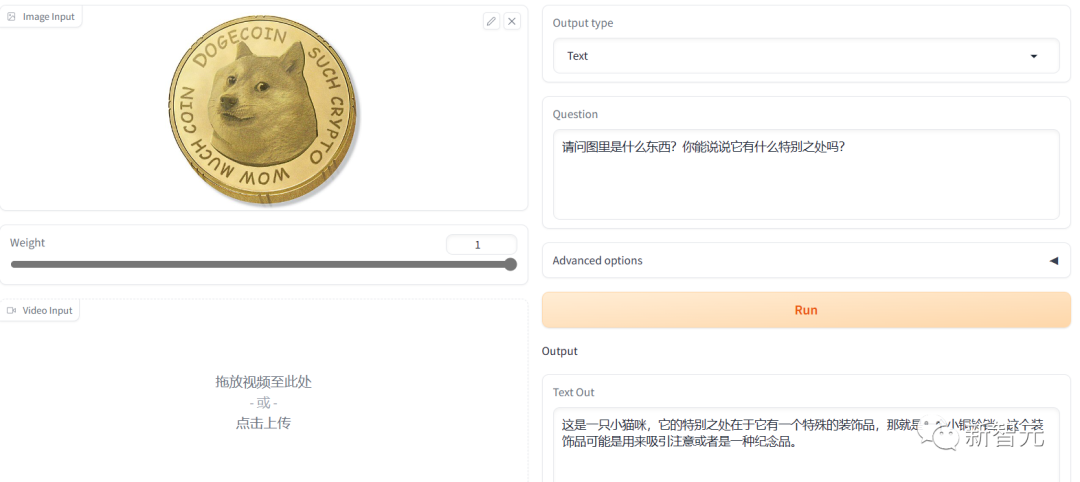

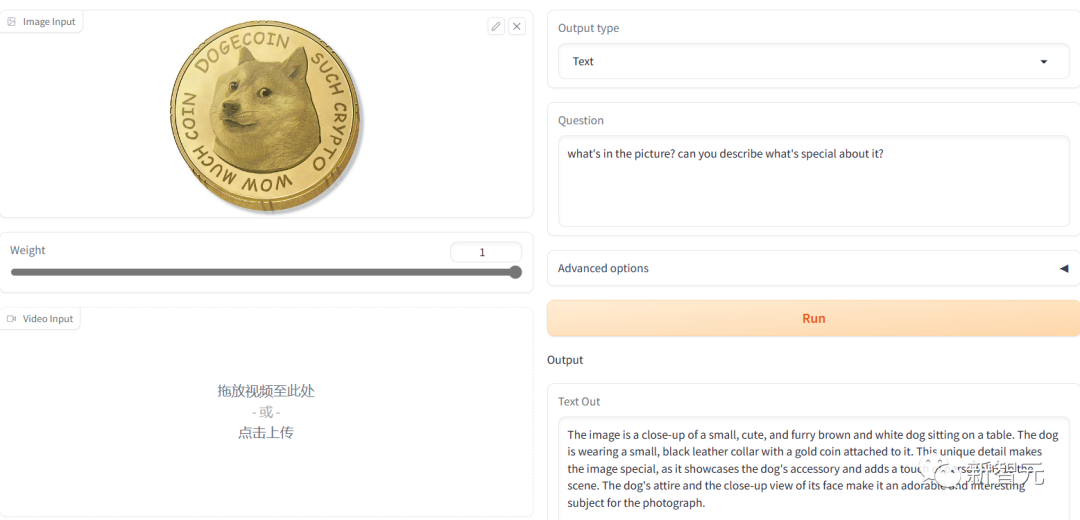

但是如果問(wèn)題稍微難一點(diǎn),小編實(shí)測(cè)后發(fā)現(xiàn),它的英文能力很強(qiáng),但中文的理解力明顯就不是很行。

測(cè)狗狗幣的時(shí)候,它就鬧笑話了。

沒(méi)有看出圖片的精髓,還“指狗為貓”。

圖片

圖片

英文生產(chǎn)的答案明顯在表達(dá)上好一些,但是還是沒(méi)有識(shí)別出狗狗幣。

應(yīng)該是它識(shí)別的時(shí)候忽略了圖中最關(guān)鍵的那一圈文字信息。

圖片

圖片

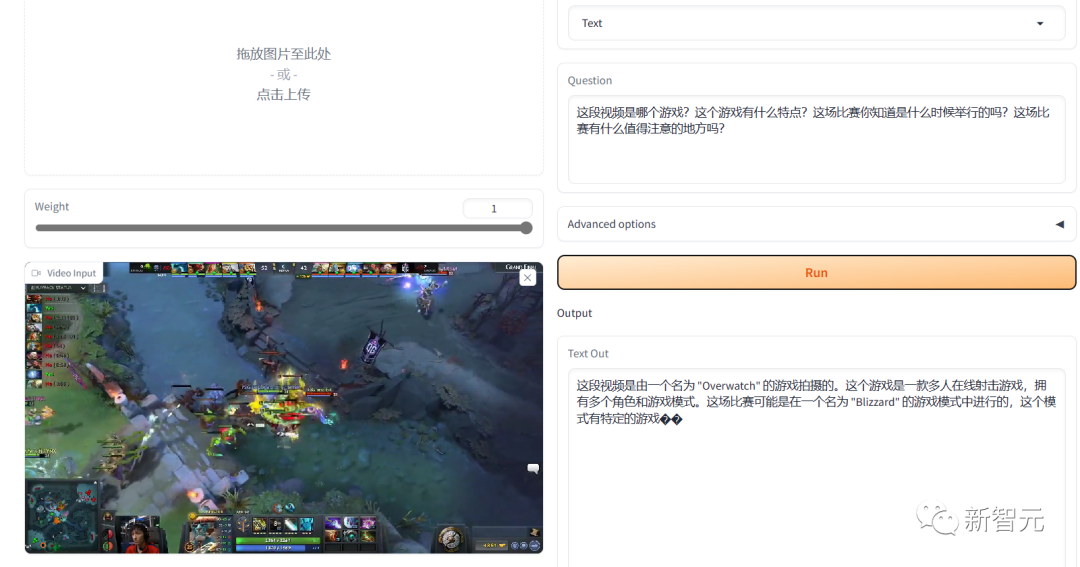

在視頻的表現(xiàn)中我們找了一段Dota2 TI8的名局片段,用中文問(wèn)它,他的回答就完全是不懂裝懂。

圖片

圖片

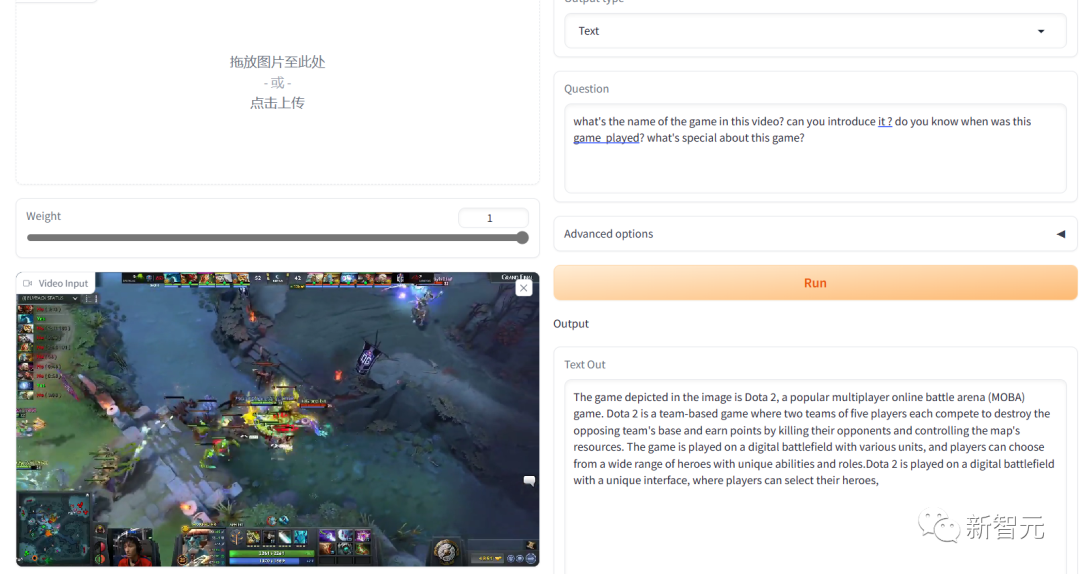

但是同樣的游戲錄像,用英文提問(wèn),回答得就比較令人滿意。

游戲識(shí)別對(duì)了,而且介紹的內(nèi)容也都很靠譜。

圖片

圖片

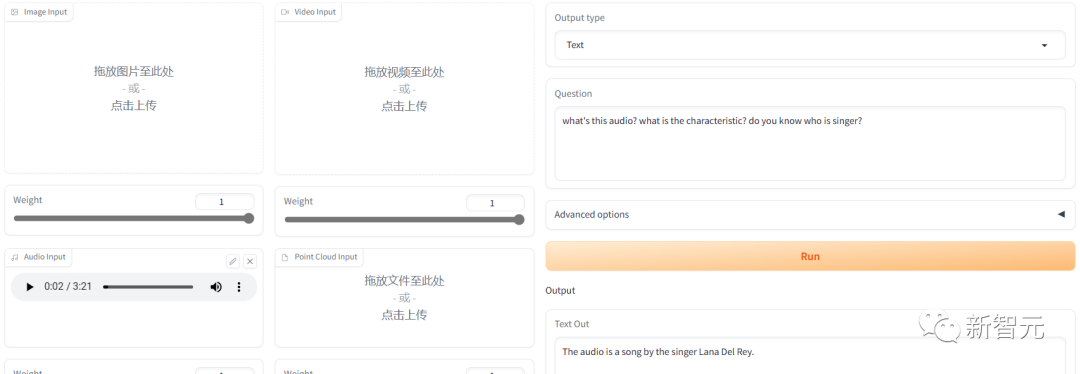

我們?cè)贉y(cè)了一下聲音,找了一首霉霉的歌放進(jìn)去。

圖片

圖片

他能識(shí)別出人聲聲音的音調(diào),但是聽(tīng)不出歌曲。

英文的回復(fù)直接猜了一個(gè)歌手,但是沒(méi)猜對(duì)。

圖片

圖片

網(wǎng)友反應(yīng)

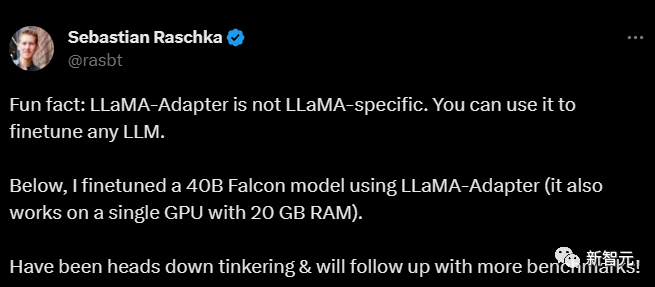

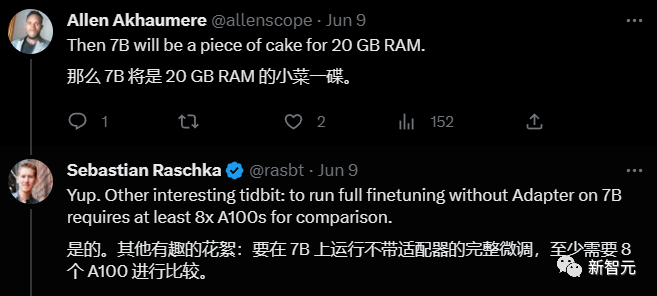

前威斯康星大學(xué)教授第一時(shí)間發(fā)推說(shuō)自己上手用LLaMA-Adapter微調(diào)了一個(gè)40B Falcon的模型。

圖片

圖片

在這條微博下面他回復(fù)了大家提出的相關(guān)問(wèn)題,對(duì)LLaMA-Adapter的評(píng)價(jià)非常高。

他說(shuō)如果不用LLaMA-Adapter微調(diào)7B的模型,至少需要8個(gè)A100GPU,自己用了LLaMA-Adapter只用了一塊GPU,門(mén)檻大大降低!

圖片

圖片

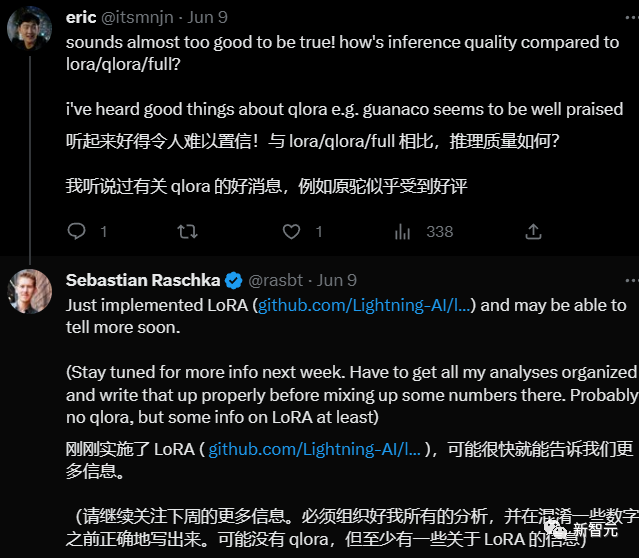

另外一位網(wǎng)友詢問(wèn)和Lora/qlora/full相比,推理質(zhì)量如何,他回答說(shuō)自己正在體驗(yàn),進(jìn)一步的信息稍后帶來(lái)。

圖片

圖片

參考資料: