Falcon Mamba 7B:非 Transformer 架構先鋒,超越 Llama 3.1 創輝煌

在人工智能領域的不斷演進中,新的模型和架構不斷涌現,為各種應用場景帶來了更強大的能力和可能性。其中,Falcon Mamba 7B 作為全球首個通用大型 Mamba 架構模型,備受關注。本文將深入探討 Falcon Mamba 7B 的相關特性、技術架構、性能表現以及其在實際應用中的潛力。

一、Falcon Mamba 7B 簡介

Falcon Mamba 7B 是由阿布扎比支持的技術創新研究所(TI I)開源的模型。它是繼 Falcon 180B、Falcon 40B 和 Falcon 2 之后 TII 的第四個開放模型。與 Falcon 系列之前的型號不同,Falcon Mamba 7B 完全采用 SSLM(State Space Language Model)架構,而非傳統的 Transformer 架構,這一架構的轉變為其帶來了獨特的優勢和性能特點。

二、Mamba 架構的特點

Mamba 架構,即狀態空間模型(SSM,State Space Model),具有以下顯著特點:

- 高效處理長序列:結合了 RNN 和 CNN 的特點,通過引入選擇機制,允許模型根據當前輸入有選擇地傳播或忘記信息,從而提高了處理文本信息的效率。與 Transformer 架構中自注意力機制需要關注輸入序列中的所有位置不同,Mamba 架構在處理長序列時無需過多的計算能力和內存來處理不斷增長的上下文窗口,能夠更好地應對長距離依賴關系,并且在處理較長文本時不會遇到像 Transformer 那樣的困難。

- 硬件感知的并行算法:以遞歸模式運行,避免了 GPU 內存層級之間 I/O 訪問,極大地提高了計算效率,使其能夠在有限的硬件資源下實現更高效的計算。

- 簡化的架構設計:將 SSM 架構和 Transformer 中的 MLP 塊結合為單一的塊,進一步優化了模型的結構,減少了計算復雜度,同時也為模型的訓練和推理帶來了更高的效率。

三、Falcon Mamba 7B 的性能優勢

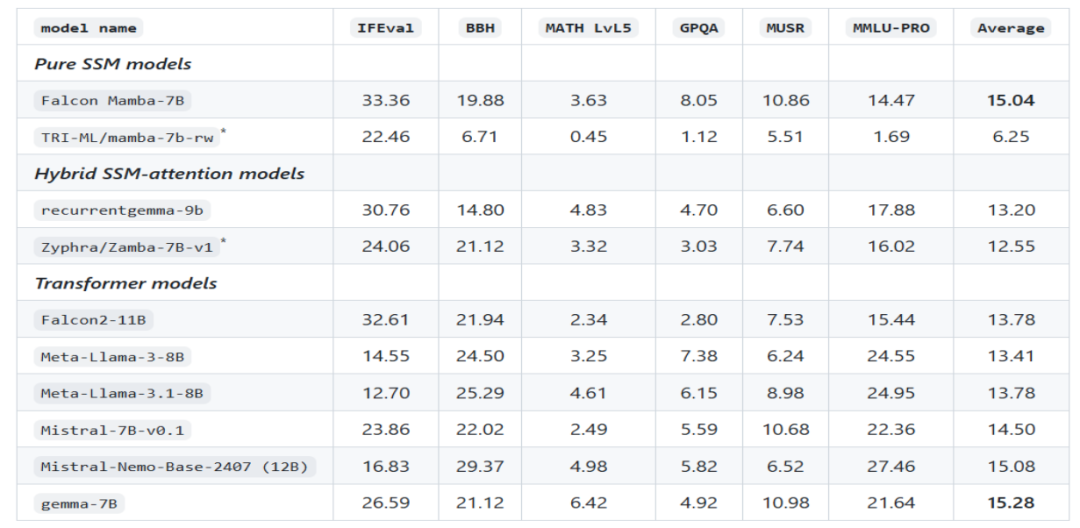

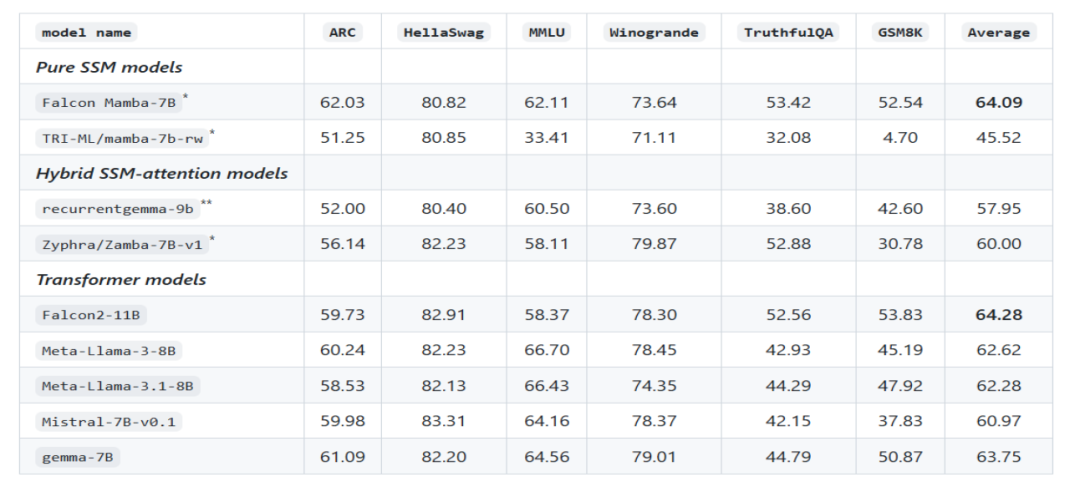

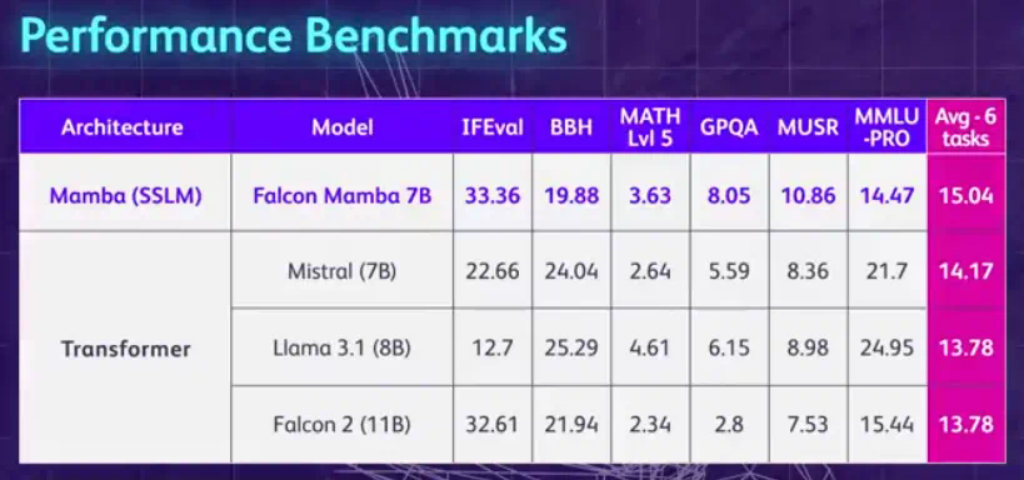

在多個基準測試中,Falcon Mamba 7B 的均分超過了如 Llama 3.1 8B 和 Mistral 7B 等同尺寸級別的領先模型。例如,在使用 lm-evaluation-harness 包進行的模型評估中,Falcon Mamba 7B 獲得了較高的均分,展示出了其在各種文本生成任務上的出色表現。

圖片

圖片

官方根據 LLM 排行榜第一版的基準評估我們Falcon Mamba 7B模型

圖片

圖片

四、模型訓練與數據

Falcon Mamba 7B 使用了約 5500GT(相當于 5.5B token)的數據進行訓練。這些數據主要由 RefinedWeb 數據組成,并添加了公共來源的高質量技術數據和代碼數據。在訓練過程中,大部分時間使用了恒定的學習率,隨后進行了一個較短的學習率衰減階段。在最后階段,還加入了一小部分高質量的精選數據,以進一步提升模型性能。這種精心設計的訓練策略和多樣化的數據來源,使得 Falcon Mamba 7B 能夠充分學習到不同領域和類型的知識,從而具備更廣泛的知識覆蓋和更強的泛化能力。

五、實際應用場景與潛力

由于 Falcon Mamba 7B 具備處理任意長度序列、高效的計算能力和出色的內存效率等優勢,它在眾多實際應用場景中具有巨大的潛力。

- 企業級機器翻譯:能夠準確地處理大規模的文本翻譯任務,無論是長篇文檔還是實時的多語言交互翻譯,都可以提供高質量的翻譯結果,提高翻譯效率和準確性。

- 文本摘要生成:可以快速地從大量文本中提取關鍵信息,生成簡潔而準確的摘要,幫助用戶快速了解文本的核心內容,節省閱讀時間和精力。

- 算機視覺任務中的文本處理:例如在圖像描述生成、視頻字幕生成等方面,能夠根據圖像或視頻內容生成準確的文本描述,為計算機視覺與自然語言處理的結合提供有力支持。

- 音頻處理:對于音頻文件中的語音內容進行識別和理解,實現語音轉文本、語音指令處理等功能,為音頻相關的應用場景提供智能解決方案。

- 估計和預測任務:憑借其對數據的深入理解和強大的計算能力,可以在金融、氣象、物流等領域進行數據的分析和預測,為決策提供參考依據。

六、與其他模型的比較

與傳統的 Transformer 架構模型相比,Falcon Mamba 7B 在處理長序列和內存使用方面具有明顯優勢。而與其他采用 Mamba 架構的模型,如 Mistral 發布的首個基于 Mamba 架構的開源大模型 CodeStral 7B 相比,Falcon Mamba 7B 在性能和通用性上表現更為突出,能夠處理各種文本生成任務,而不僅僅局限于特定領域。

圖片

圖片

七、模型本地部署推理

Falcon Mamba 架構將在 Hugging Face transformers 庫的新版本 (>4.45.0) 中提供。要使用該模型,請確保安裝最新版本的 Hugging Face transformers 或從源安裝庫。

pip install transformers >4.45.0模型下載,要下載模型到本地進行推理,可參考下面指令:

git clone https://huggingface.co/tiiuae/falcon-mamba-7bFalcon Mamba 與您熟悉的 Hugging Face 提供的大多數 API 兼容,例如 或 :AutoModelForCausalLMpipeline

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "tiiuae/falcon-mamba-7b"

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(model_id, torch_dtype="auto", device_map="auto")

inputs = tokenizer("Hello world, today", return_tensors="pt").to(0)

output = model.generate(**inputs, max_new_tokens=100, do_sample=True)

print(tokenizer.decode(Output[0], skip_special_tokens=True))由于模型很大,它還支持量化等功能,以便在較小的 GPU 內存約束上運行模型,例如:bitsandbytes

from transformers import AutoModelForCausalLM, AutoTokenizer, BitsAndBytesConfig

model_id = "tiiuae/falcon-mamba-7b"

tokenizer = AutoTokenizer.from_pretrained(model_id)

quantization_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_id, quantization_cnotallow=quantization_config)

inputs = tokenizer("Hello world, today", return_tensors="pt").to(0)

output = model.generate(**inputs, max_new_tokens=100, do_sample=True)

print(tokenizer.decode(output[0], skip_special_tokens=True))結語

盡管 Falcon Mamba 7B 取得了顯著的成績,但在實際應用中仍然面臨一些挑戰。例如,在處理某些復雜語言結構或特定領域的專業知識時,可能需要進一步優化和改進。此外,隨著人工智能技術的不斷發展,如何進一步提高模型的性能、拓展其應用領域、增強其可解釋性以及應對數據隱私和安全等問題,都是未來需要探索和解決的方向。

總之,Falcon Mamba 7B 作為全球首個通用大型 Mamba 架構模型,以其獨特的架構、出色的性能和廣泛的應用潛力,為人工智能領域帶來了新的活力和機遇。隨著對其研究和應用的不斷深入,相信它將在未來的各種場景中發揮更加重要的作用,為推動人工智能技術的發展和應用做出更大的貢獻。我們也期待著在未來看到更多基于 Falcon Mamba 7B 進行改進和創新的模型和應用,共同推動人工智能領域邁向新的高度。

相關資料

Hugging Face 地址:https://huggingface.co/tiiuae/falcon-mamba-7b

博文介紹:https://huggingface.co/blog/falconmamba

github地址:https://github.com/huggingface/blog/blob/main/falconmamba.md