你大腦中的畫面,現在可以高清還原了

近幾年,圖像生成領域取得了巨大的進步,尤其是文本到圖像生成方面取得了重大突破:只要我們用文本描述自己的想法,AI 就能生成新奇又逼真的圖像。

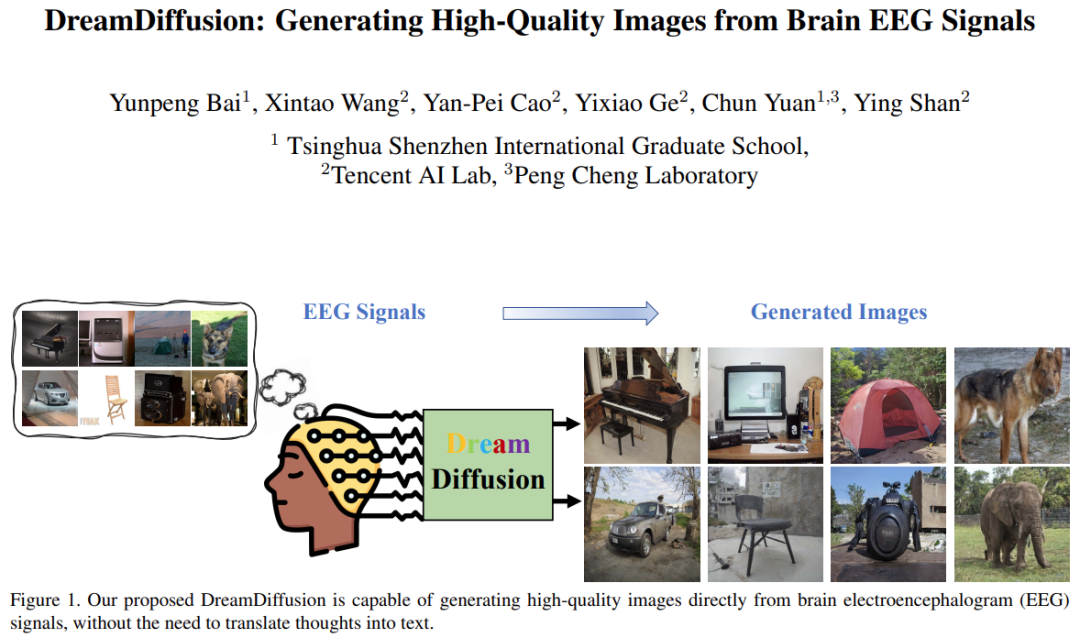

但其實我們可以更進一步 —— 將頭腦中的想法轉化為文本這一步可以省去,直接通過腦活動(如 EEG(腦電圖)記錄)來控制圖像的生成創作。

這種「思維到圖像」的生成方式有著廣闊的應用前景。例如,它能極大提高藝術創作的效率,并幫助人們捕捉稍縱即逝的靈感;它也有可能將人們夜晚的夢境進行可視化;它甚至可能用于心理治療,幫助自閉癥兒童和語言障礙患者。

最近,來自清華大學深圳國際研究生院、騰訊 AI Lab 和鵬城實驗室的研究者們聯合發表了一篇「思維到圖像」的研究論文,利用預訓練的文本到圖像模型(比如 Stable Diffusion)強大的生成能力,直接從腦電圖信號生成了高質量的圖像。

圖片

圖片

論文地址:https://arxiv.org/pdf/2306.16934.pdf

項目地址:https://github.com/bbaaii/DreamDiffusion

方法概述

近期一些相關研究(例如 MinD-Vis)嘗試基于 fMRI(功能性磁共振成像信號)來重建視覺信息。他們已經證明了利用腦活動重建高質量結果的可行性。然而,這些方法與理想中使用腦信號進行快捷、高效的創作還差得太遠,這主要有兩點原因:

首先,fMRI 設備不便攜,并且需要專業人員操作,因此捕捉 fMRI 信號很困難;

其次,fMRI 數據采集的成本較高,這在實際的藝術創作中會很大程度地阻礙該方法的使用。

相比之下,EEG 是一種無創、低成本的腦電活動記錄方法,并且現在市面上已經有獲得 EEG 信號的便攜商用產品。

但實現「思維到圖像」的生成還面臨兩個主要挑戰:

1)EEG 信號通過非侵入式的方法來捕捉,因此它本質上是有噪聲的。此外,EEG 數據有限,個體差異不容忽視。那么,如何從如此多的約束條件下的腦電信號中獲得有效且穩健的語義表征呢?

2)由于使用了 CLIP 并在大量文本 - 圖像對上進行訓練,Stable Diffusion 中的文本和圖像空間對齊良好。然而,EEG 信號具有其自身的特點,其空間與文本和圖像大不相同。如何在有限且帶有噪聲的 EEG - 圖像對上對齊 EEG、文本和圖像空間?

為了解決第一個挑戰,該研究提出,使用大量的 EEG 數據來訓練 EEG 表征,而不是僅用罕見的 EEG 圖像對。該研究采用掩碼信號建模的方法,根據上下文線索預測缺失的 token。

不同于將輸入視為二維圖像并屏蔽空間信息的 MAE 和 MinD-Vis,該研究考慮了 EEG 信號的時間特性,并深入挖掘人類大腦時序變化背后的語義。該研究隨機屏蔽了一部分 token,然后在時間域內重建這些被屏蔽的 token。通過這種方式,預訓練的編碼器能夠對不同個體和不同腦活動的 EEG 數據進行深入理解。

對于第二個挑戰,先前的解決方法通常直接對 Stable Diffusion 模型進行微調,使用少量噪聲數據對進行訓練。然而,僅通過最終的圖像重構損失對 SD 進行端到端微調,很難學習到腦信號(例如 EEG 和 fMRI)與文本空間之間的準確對齊。因此,研究團隊提出采用額外的 CLIP 監督,幫助實現 EEG、文本和圖像空間的對齊。

具體而言,SD 本身使用 CLIP 的文本編碼器來生成文本嵌入,這與之前階段的掩碼預訓練 EEG 嵌入非常不同。利用 CLIP 的圖像編碼器提取豐富的圖像嵌入,這些嵌入與 CLIP 的文本嵌入很好地對齊。然后,這些 CLIP 圖像嵌入被用于進一步優化 EEG 嵌入表征。因此,經過改進的 EEG 特征嵌入可以與 CLIP 的圖像和文本嵌入很好地對齊,并更適合于 SD 圖像生成,從而提高生成圖像的質量。

基于以上兩個精心設計的方案,該研究提出了新方法 DreamDiffusion。DreamDiffusion 能夠從腦電圖(EEG)信號中生成高質量且逼真的圖像。

圖片

圖片

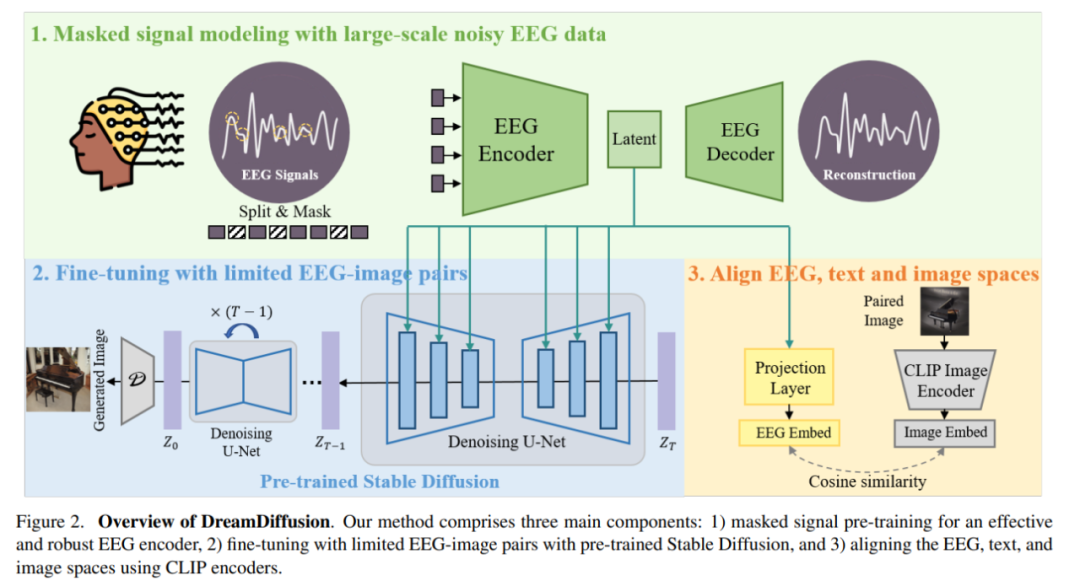

具體來說,DreamDiffusion 主要由三個部分組成:

1)掩碼信號預訓練,以實現有效和穩健的 EEG 編碼器;

2)使用預訓練的 Stable Diffusion 和有限的 EEG 圖像對進行微調;

3)使用 CLIP 編碼器,對齊 EEG、文本和圖像空間。

首先,研究人員利用帶有大量噪聲的 EEG 數據,采用掩碼信號建模,訓練 EEG 編碼器,提取上下文知識。然后,得到的 EEG 編碼器通過交叉注意力機制被用來為 Stable Diffusion 提供條件特征。

圖片

圖片

為了增強 EEG 特征與 Stable Diffusion 的兼容性,研究人員進一步通過在微調過程中減少 EEG 嵌入與 CLIP 圖像嵌入之間的距離,進一步對齊了 EEG、文本和圖像的嵌入空間。

實驗與分析

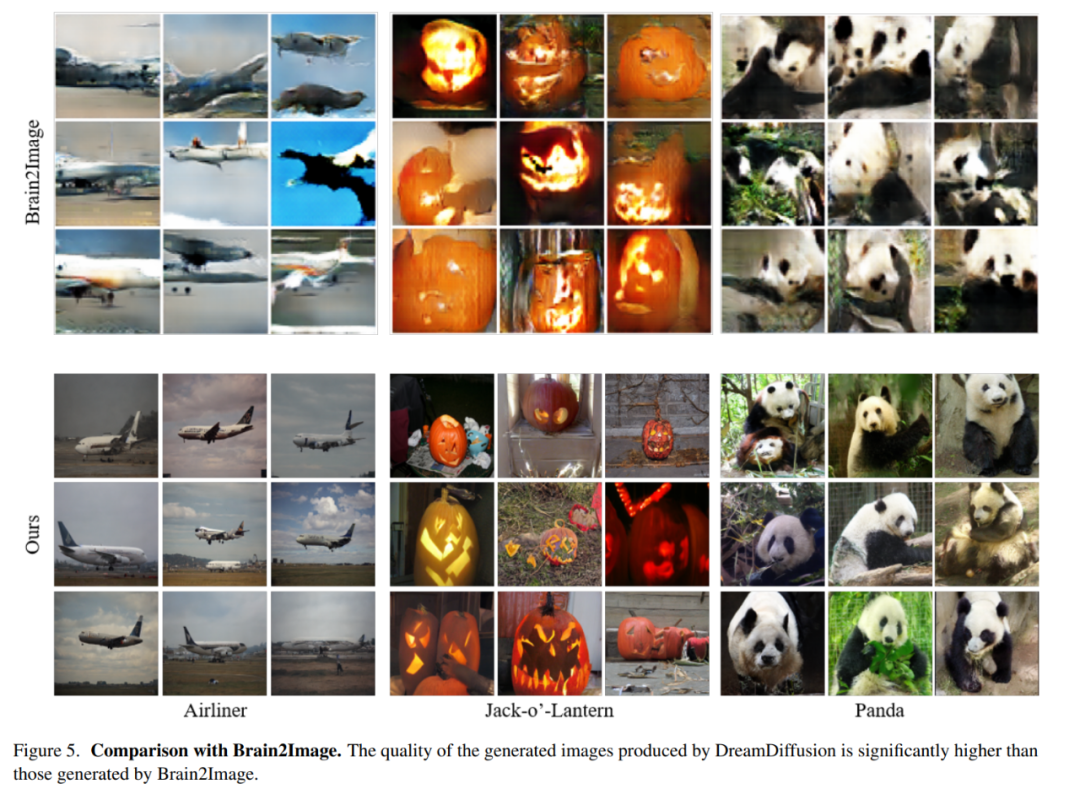

與 Brain2Image 對比

研究人員將本文方法與 Brain2Image 進行比較。Brain2Image 采用傳統的生成模型,即變分自編碼器(VAE)和生成對抗網絡(GAN),用于實現從 EEG 到圖像的轉換。然而,Brain2Image 僅提供了少數類別的結果,并沒有提供參考實現。

鑒于此,該研究對 Brain2Image 論文中展示的幾個類別(即飛機、南瓜燈和熊貓)進行了定性比較。為確保比較公平,研究人員采用了與 Brain2Image 論文中所述相同的評估策略,并在下圖 5 中展示了不同方法生成的結果。

下圖第一行展示了 Brain2Image 生成的結果,最后一行是研究人員提出的方法 DreamDiffusion 生成的。可以看到 DreamDiffusion 生成的圖像質量明顯高于 Brain2Image 生成的圖像,這也驗證了本文方法的有效性。

圖片

圖片

消融實驗

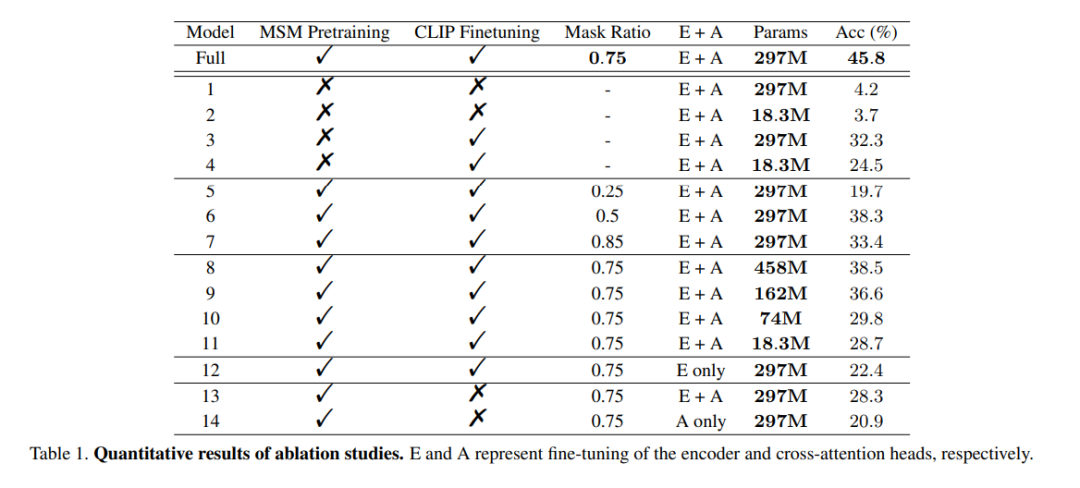

預訓練的作用:為了證明大規模 EEG 數據預訓練的有效性,該研究使用未經訓練的編碼器來訓練多個模型進行驗證。其中一個模型與完整模型相同,而另一個模型只有兩層的 EEG 編碼層,以避免數據過擬合。在訓練過程中,這兩個模型分別進行了有 / 無 CLIP 監督的訓練,結果如表 1 中 Model 列的 1 到 4 所示。可以看到,沒有經過預訓練的模型準確性有所降低。

mask ratio:本文還研究了用 EEG 數據確定 MSM 預訓練的最佳掩碼比。如表 1 中的 Model 列的 5 到 7 所示,過高或過低的掩碼比會對模型性能都會產生不利影響。當掩碼比為 0.75 達到最高的整體準確率。這一發現至關重要,因為這表明,與通常使用低掩碼比的自然語言處理不同,在對 EEG 進行 MSM 時,高掩碼比是一個較好的選擇。

CLIP 對齊:該方法的關鍵之一是通過 CLIP 編碼器將 EEG 表征與圖像對齊。該研究進行實驗驗證了這種方法的有效性,結果如表 1 所示。可以觀察到,當沒有使用 CLIP 監督時,模型的性能明顯下降。實際上,如圖 6 右下角所示,即使在沒有預訓練的情況下,使用 CLIP 對齊 EEG 特征仍然可以得到合理的結果,這凸顯了 CLIP 監督在該方法中的重要性。

圖片

圖片