小紅書多模態(tài)團(tuán)隊(duì)建立新「擴(kuò)散模型」:解碼腦電波,高清還原人眼所見

近些年,研究人員們對探索大腦如何解讀視覺信息,并試圖還原出原始圖像一直孜孜不倦。去年一篇被 CVPR 錄用的論文,通過擴(kuò)散模型重建視覺影像,給出了非常炸裂的效果—— AI 不光通過腦電波知道你看到了什么,并且?guī)湍惝嬃顺鰜怼?/span>

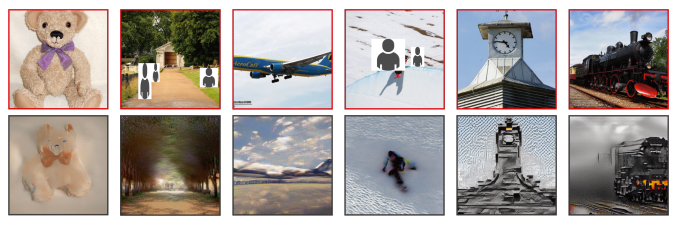

第一行:人眼所見畫面,第二行:AI 重現(xiàn)的畫面

簡而言之,AI 利用 fMRI 信號(全稱為功能性核磁共振成像)+ Diffusion Model,就能一定程度上實(shí)現(xiàn)「讀腦術(shù)」。

不過,如何有效提取并利用 fMRI 信號中隱含的語義和輪廓信息,仍然是業(yè)界的一個關(guān)鍵挑戰(zhàn)。

在上月揭曉的 AAAI 2024 上,小紅書多模態(tài)團(tuán)隊(duì)提出了一種新方法——可控腦視覺擴(kuò)散模型(Controllable Mind Visual Diffusion Model,CMVDM)。該模型能很好地將 fMRI 信號還原為與原始視覺刺激語義屬性一致,空間結(jié)構(gòu)對齊的高質(zhì)量圖片,可以使得生成的圖像清晰度更高、也更接近人眼所見的原始圖像。

具體來說,CMVDM 首先使用屬性對齊和輔助網(wǎng)絡(luò),從 fMRI 數(shù)據(jù)中提取語義和輪廓信息。其次,引入一個控制模型并結(jié)合殘差塊,充分利用提取的信息進(jìn)行圖像合成,生成與原始視覺刺激在語義內(nèi)容和輪廓特征上高度相似的高質(zhì)量圖像。

通過大量實(shí)驗(yàn),小紅書多模態(tài)團(tuán)隊(duì)證明了 CMVDM 在可視化質(zhì)量和技術(shù)指標(biāo)上都優(yōu)于現(xiàn)有的最先進(jìn)的方法(SOTA)。此外,團(tuán)隊(duì)還發(fā)現(xiàn)大腦的高級視覺皮層(HVC) 主要關(guān)注視覺刺激的語義信息,而低級視覺皮層(LVC)則主要關(guān)注視覺刺激的結(jié)構(gòu)信息。

一、背景

理解人類大腦在觀察視覺刺激(例如自然圖像)時發(fā)生的認(rèn)知過程,一直是神經(jīng)科學(xué)家的主要關(guān)注點(diǎn)。客觀的視覺刺激和主觀的認(rèn)知活動,都能在大腦的視覺皮層中引發(fā)復(fù)雜的神經(jīng)信號傳遞,從而為更高層次的認(rèn)知認(rèn)知和決策過程奠定基礎(chǔ)。隨著功能性磁共振成像(fMRI)等技術(shù)的進(jìn)步,人們已經(jīng)能夠以更高的精度和更細(xì)的粒度捕獲實(shí)時的大腦活動信號,從而加速了神經(jīng)科學(xué)研究的進(jìn)程。然而,對于認(rèn)知神經(jīng)科學(xué)和下游應(yīng)用(如腦機(jī)接口 BCI)來說,解讀和重構(gòu)這些復(fù)雜的信號仍然是一個巨大的挑戰(zhàn)。

早期嘗試在分析視覺任務(wù)的大腦活動時,主要關(guān)注將在人類受試者的大腦活動與觀察到的自然圖像相匹配,或者重構(gòu)簡單幾何形狀的視覺模式。這些探索證明了從大腦信號中獲取感知圖像的語義信息的可行性,然而它們對未見過的語義類別或復(fù)雜的重構(gòu)任務(wù)的泛化能力較差。

近期研究在從大腦信號重構(gòu)視覺刺激方面取得了重要進(jìn)展。Roman Beliy、Guy Gaziv 等工作能夠生成與原始視覺刺激形狀相似的圖像,但這些圖像存在嚴(yán)重的扭曲和模糊問題。文獻(xiàn) IC-GAN, Mind-Vis 等研究采用了常用的生成模型,如生成對抗網(wǎng)絡(luò)(GAN)或擴(kuò)散模型,生成的高質(zhì)量 RGB 圖像在語義上與原始視覺刺激保持一致,條件是對應(yīng)的 fMRI 信號。然而,如圖所示,這些方法在位置一致性上存在問題。 總的來說,現(xiàn)有方法未能有效地利用 fMRI 信號中固有的語義和空間特征。

為了解決上述問題,我們提出了一種可控腦視覺擴(kuò)散模型(CMVDM),該模型通過控制網(wǎng)絡(luò)使擴(kuò)散模型能夠利用提取出可信的語義和輪廓信息,從而完成高度逼真的人類視覺重構(gòu)。我們在兩個數(shù)據(jù)集上進(jìn)行了全面的實(shí)驗(yàn)來評估 CMVDM 的性能。與現(xiàn)有的方法相比,它在定性和定量結(jié)果上都達(dá)到了最先進(jìn)的水平(SOTA),證明了 CMVDM 從 fMRI 信號中解碼高質(zhì)量和可控圖像的有效性。

二、方法

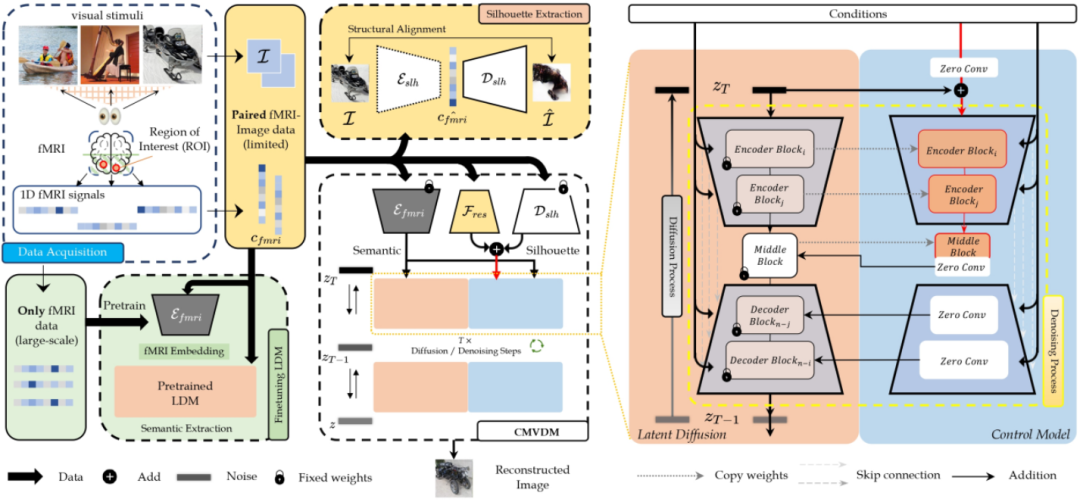

CMVDM 框架示意圖

具體來說,我們的方法可以被拆解為:

● 我們首先對一個預(yù)訓(xùn)練的潛在擴(kuò)散模型(Latent Diffusion Model,LDM)進(jìn)行微調(diào),使用語義對齊損失來提高性能,并預(yù)訓(xùn)練一個輪廓提取器來估計 fMRI 數(shù)據(jù)的準(zhǔn)確語義和輪廓信息。

● 受 ControlNet 的啟發(fā),我們引入一個控制網(wǎng)絡(luò),該網(wǎng)絡(luò)將輪廓信息作為條件輸入到預(yù)訓(xùn)練的 LDM 中,以指導(dǎo)擴(kuò)散過程生成所需的圖像,這些圖像在語義和輪廓信息方面都與原始視覺刺激相匹配。

● 此外,我們構(gòu)建了一個殘差模塊來提供超出語義和輪廓的信息。

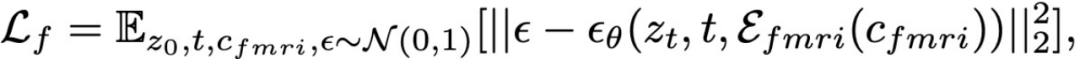

2.1 預(yù)訓(xùn)練 LDM 調(diào)整以及語義信息提取

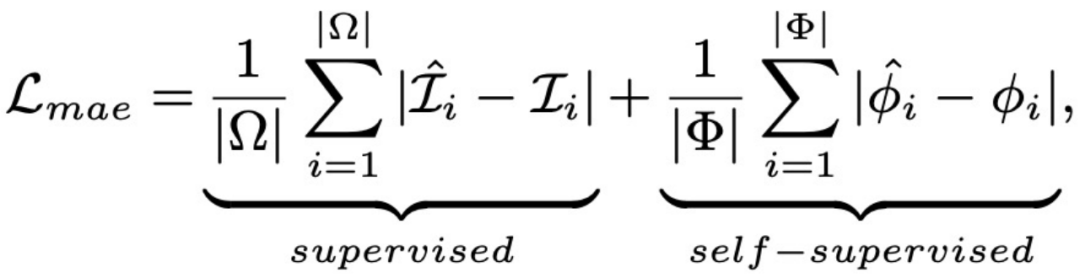

我們引入在 HCP 數(shù)據(jù)集上預(yù)訓(xùn)練的 fMRI 信號特征提取器以及預(yù)訓(xùn)練的 LDM 網(wǎng)絡(luò),通過下述監(jiān)督損失優(yōu)化 fMRI 信號特征提取器以及 LDM 網(wǎng)絡(luò)中的 cross attention 層,從而基本實(shí)現(xiàn)將腦電信號還原為視覺刺激。

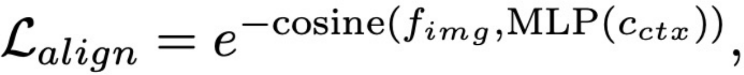

我們將上文從 fMRI 信號提取器中得到的特征定義為從 fMRI 信號中提取的語義信息。由于缺乏直接的語義監(jiān)督,只憑上文提到的監(jiān)督函數(shù)可能無法提供足夠的語義信息。因此,我們設(shè)計了一個語義對齊損失來進(jìn)一步增強(qiáng)語義信息和余弦相似度,如下所示。

核心思路是將從 fMRI 信號中提取出的語義信息與 CLIP 處理圖片得到的特征進(jìn)行對齊。可以參考「CMVDM 框架示意圖」中的“Finetuning LDM”部分。

2.2 輪廓信息提取

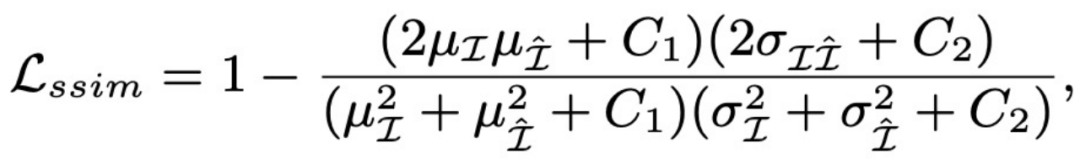

由于缺乏明確的位置條件指導(dǎo),Latent Diffusion Model 生成與輪廓匹配的結(jié)果仍然是一個挑戰(zhàn)。因此,我們提出了輪廓估計網(wǎng)絡(luò)來提取輪廓信息。我們的輪廓估計網(wǎng)絡(luò)由兩個對稱的部分組成:一個編碼器 ε 和一個解碼器 。編碼器將輸入圖像投影到 fMRI 信號空間,而解碼器則正相反。我們采用結(jié)構(gòu)相似性(SSIM)損失和平均絕對誤差(MAE)損失來優(yōu)化圖像和 Ground Truth 圖像之間的空間距離,具體公示如下。我們采用解碼器從 fMRI 信號中提取輪廓信息。

可以參考「CMVDM 框架示意圖」中的 “Silhouette Extraction” 部分。

2.3 控制網(wǎng)絡(luò)訓(xùn)練

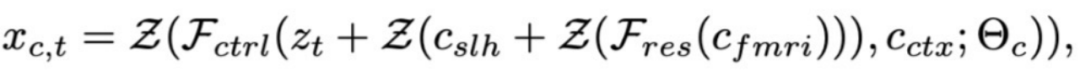

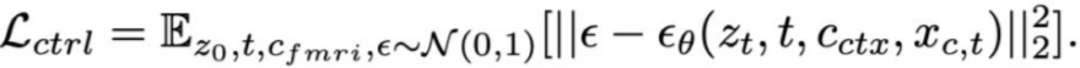

在從 fMRI 信號中獲取增強(qiáng)的語義信息和可靠的輪廓信息后,我們使用它們來控制生成的結(jié)果。受 ControlNet 的啟發(fā),我們設(shè)計了一個控制模型來控制生成圖像的整體構(gòu)成。具體來說,我們固定了 LDM 中去噪網(wǎng)絡(luò)中的所有參數(shù),并將去噪網(wǎng)絡(luò)的 U-Net 編碼器克隆到可訓(xùn)練的控制模塊中。控制模塊的輸入包括噪聲潛在代碼、語義信息和輪廓信息。此外,為了彌補(bǔ)在屬性提取中丟失的 fMRI 信息,我們采用了一個可訓(xùn)練的殘差塊來添加超出語義和輪廓的信息。推理過程和監(jiān)督控制模型的訓(xùn)練損失表示為:

可以參考「CMVDM 框架示意圖」中的 “Control Model” 以及 部分。

三、實(shí)驗(yàn)

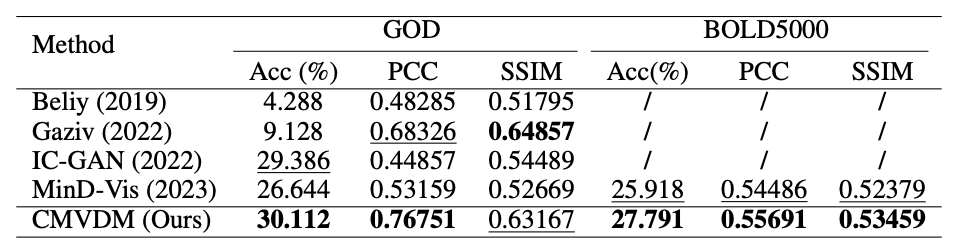

我們考慮在不同復(fù)雜度數(shù)據(jù)集上進(jìn)行視覺信號重建測試,考慮的數(shù)據(jù)集有兩個:Generic Objects Dataset (GOD)、BOLD5000 (Brain, Object, Landscape Dataset)。前者多為受試者對簡單圖片物體的腦電信號-圖片對,后者則增加了場景復(fù)雜度和數(shù)據(jù)量。我們將 CMVDM 與四種 SOTA 方法進(jìn)行比較:Beliy、Gaziv、IC-GAN、MinD-Vis。為評估模型的性能,在評價指標(biāo)上我們考慮 N-way 分類準(zhǔn)確度(Acc),皮爾森相關(guān)系數(shù)(PCC),結(jié)構(gòu)相似性度量(SSIM)來評價生成圖像的語義準(zhǔn)確度和結(jié)構(gòu)相似性。

3.1 指標(biāo)對比結(jié)果

如圖所示,實(shí)驗(yàn)結(jié)果揭示了 CMVDM 總體上顯著優(yōu)于其他方法。與 IC-GAN、MinD-Vis 相比,盡管兩者都產(chǎn)生了良好的結(jié)果,但 CMVDM 在 SSIM 方面顯著優(yōu)于它們。這表明 CMVDM 生成的圖像在物體輪廓和圖像結(jié)構(gòu)方面與視覺刺激的相似度更高。Gaziv 在 SSIM 方面取得了顯著的結(jié)果,但視覺結(jié)果表明,Gaziv 方法無法生成高保真度的圖像。

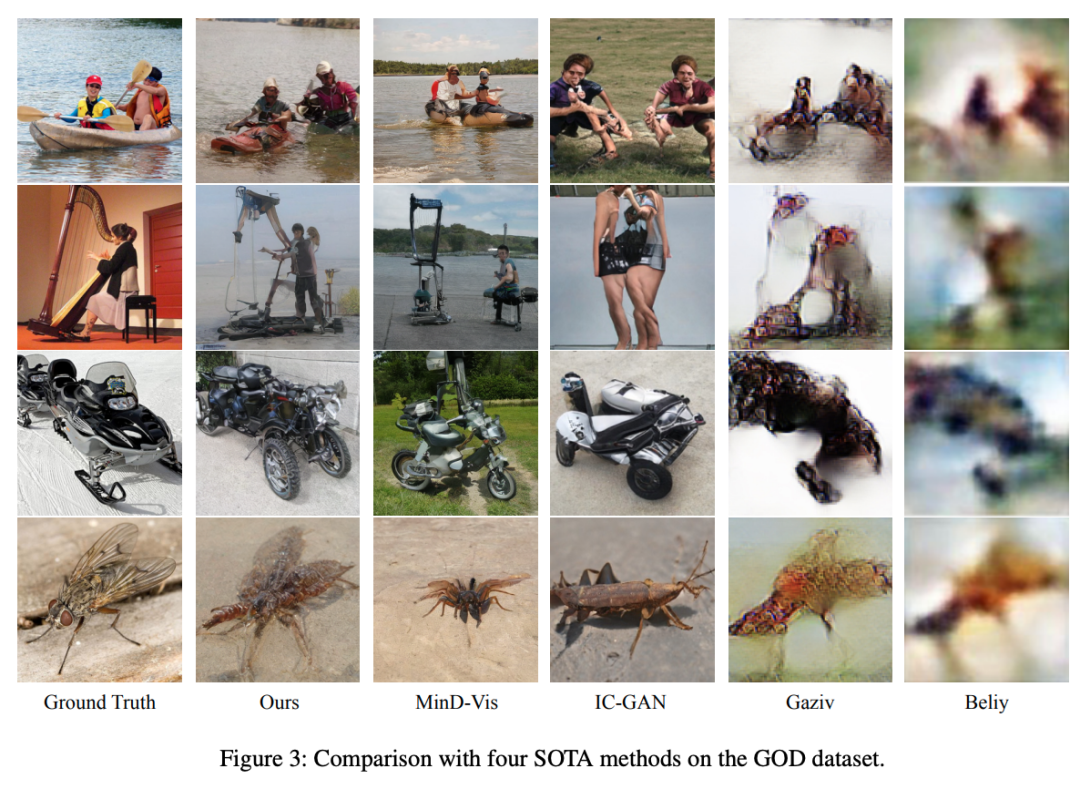

3.2 可視化對比結(jié)果

● GOD 上的可視化對比

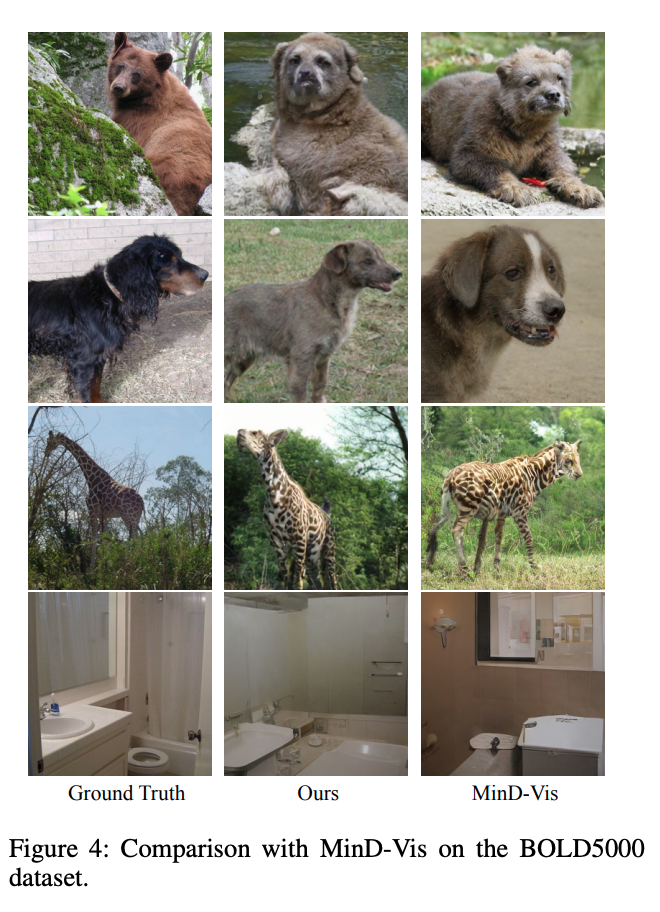

● BOLD5000 對比結(jié)果

3.3 實(shí)驗(yàn)分析

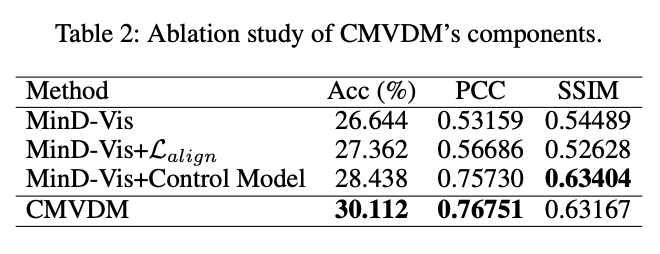

本工作對提出的損失函數(shù)與引入的模塊進(jìn)行了消融實(shí)驗(yàn),并結(jié)合不同視覺皮層的腦電信號進(jìn)行實(shí)驗(yàn)對比與可視化驗(yàn)證,證明了所提出方法的有效性。

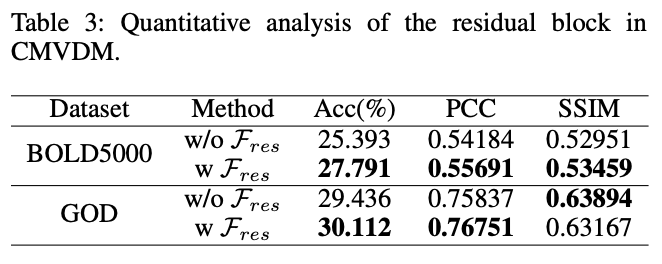

● 消融實(shí)驗(yàn)指標(biāo)分析

消融實(shí)驗(yàn)表明,CMVDM 在引入了新的對齊損失與結(jié)構(gòu)控制模塊后實(shí)現(xiàn)了對原始刺激更高的語義準(zhǔn)確度和結(jié)構(gòu)相似性。

引入的殘差模塊 有效提高了模型的表現(xiàn):

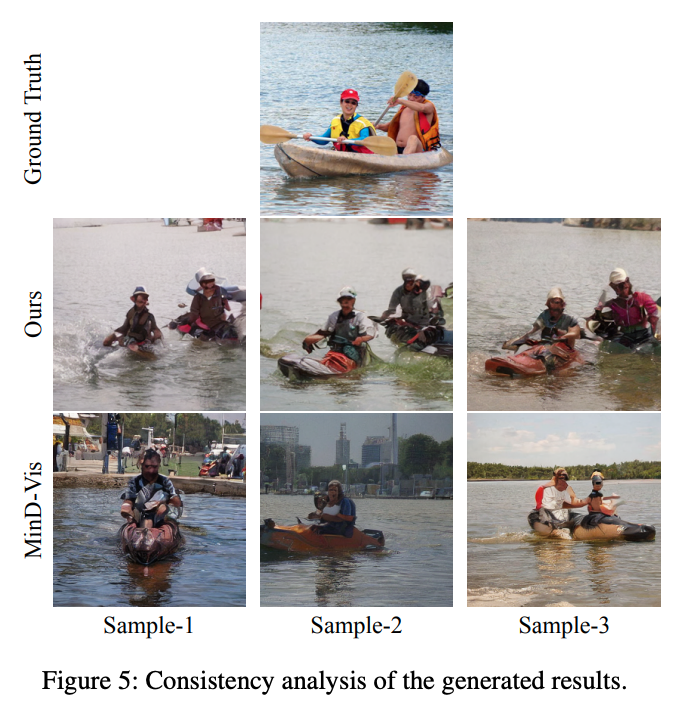

● 重建結(jié)果一致性可視化分析

我們的方法相比于 MinD-Vis 在生成一致性上更佳,表現(xiàn)出了對生成圖片結(jié)構(gòu)的有效控制。

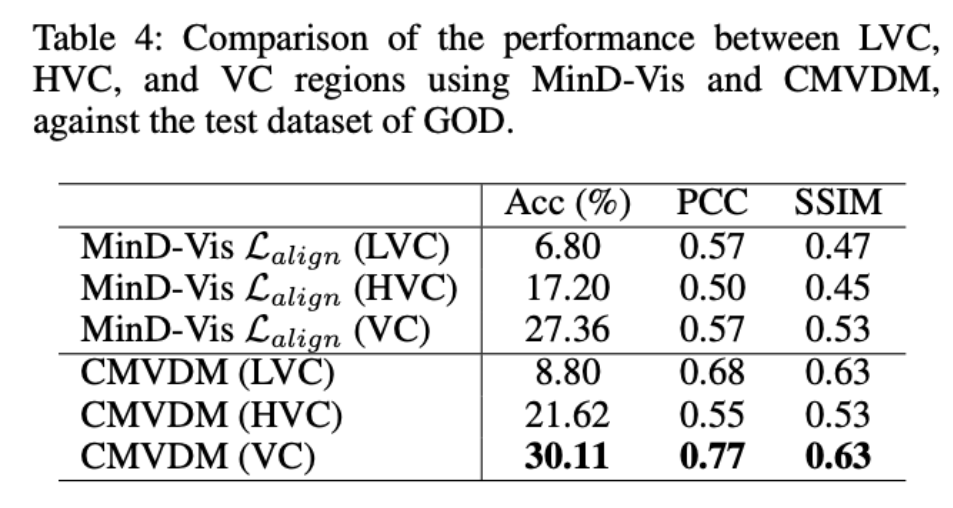

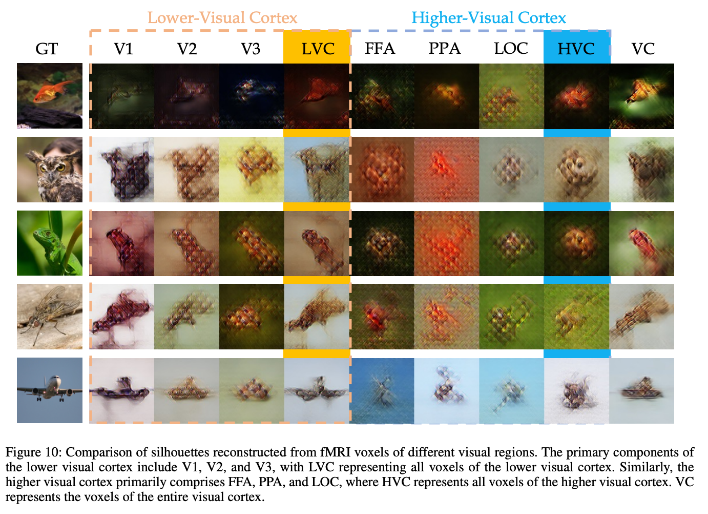

● 不同視覺皮層區(qū)域信號的重建分析

V1,V2, V3 均屬于低級視覺皮層 LVC 的主要組成區(qū)域,F(xiàn)FA,PPA,LOC則屬于高級視覺皮層 HVC 的主要組成區(qū)域,VC 代表全視覺皮層

實(shí)驗(yàn)結(jié)果與可視化表明:LVC 在結(jié)構(gòu)指標(biāo)上(如 SSIM )表現(xiàn)優(yōu)于 HVC,表明低級視覺皮層捕獲視覺信息的結(jié)構(gòu)等低級特征;HVC 在語義指標(biāo)上(如 Acc )表現(xiàn)明顯優(yōu)于 LVC,表明高級視覺皮層用于處理更抽象的語義特征;借助全視覺皮層 VC 的信號,我們的方法可以有效重建出語義、結(jié)構(gòu)與原始視覺刺激相近的高質(zhì)量圖像。

四、結(jié)束

我們提出了可控腦視覺擴(kuò)散模型(CMVDM)。這項(xiàng)工作將腦電信號重建問題分解為特征提取和圖像重建兩個子任務(wù)。通過采取自監(jiān)督與半監(jiān)督方法,我們分別提取信號的語義和結(jié)構(gòu)特征,并利用預(yù)訓(xùn)練擴(kuò)散模型的豐富知識進(jìn)行多條件視覺信號重建,實(shí)現(xiàn)了與原始視覺刺激語義匹配且結(jié)構(gòu)相似的高質(zhì)量圖像生成。

更進(jìn)一步,CMVDM 在腦電信號重建相關(guān)的數(shù)據(jù)集上取得了最先進(jìn)成果(SOTA),展現(xiàn)了其在復(fù)雜場景視覺信號可控重建方面的良好泛化性,突出其在神經(jīng)科學(xué)和計算機(jī)視覺交叉領(lǐng)域的創(chuàng)新性和實(shí)用性。本文提出的 Diffusion-based 生成方案可拓展至泛化的條件可控生成領(lǐng)域,為小紅書發(fā)布端文生圖新玩法提供更多方案。

論文地址:https://arxiv.org/pdf/2305.10135.pdf

五、作者簡介

- 曾博涵

現(xiàn)為北京航空航天大學(xué)碩士研究生,小紅書創(chuàng)作發(fā)布團(tuán)隊(duì)實(shí)習(xí)生,曾在 ECCV、CVPR、NeurIPS 等發(fā)表論文。主要研究方向?yàn)橛嬎銠C(jī)視覺生成。 - 李尚霖

現(xiàn)為北京航空航天大學(xué)碩士研究生,小紅書創(chuàng)作發(fā)布團(tuán)隊(duì)實(shí)習(xí)生,曾在 AAAI 發(fā)表多篇論文。主要研究方向?yàn)橛嬎銠C(jī)視覺生成、聯(lián)邦學(xué)習(xí)等。 - 萊戈(賈一亮)

小紅書生態(tài)算法團(tuán)隊(duì)負(fù)責(zé)人。曾在 CVPR、ICCV、ECCV、TNNLS、TGRS 等會刊發(fā)表 10 余篇論文,曾獲 YouTube-VOS 視頻分割競賽 Top-3 排名,曾獲天池視覺分割大獎賽復(fù)賽第 1 名。主要研究方向:目標(biāo)跟蹤、視頻分割、多模態(tài)分類/檢索等。 - 湯神(田不易)

小紅書創(chuàng)作發(fā)布團(tuán)隊(duì)負(fù)責(zé)人。曾在 CVPR、ECCV、ICCV、TIFS、ACMMM 等會議與期刊發(fā)表近 20 篇論文。多次刷新 WiderFace 和 FDDB 國際榜單世界記錄,ICCV Wider Challenge 人臉檢測國際競賽冠軍,ICCV VOT 單目標(biāo)跟蹤冠軍,CVPR UG2+ 亞軍。