谷歌醫療大模型登Nature,Med-PaLM重磅揭秘!AI醫生成績比肩人類

5月I/O大會上,Med-PaLM 2重磅升級,甚至達到了專家水準。

今天,谷歌揭秘微調后的Med-PaLM,同樣在醫學問題上一騎絕塵。

研究成果已登Nature。

圖片

圖片

論文地址:https://www.nature.com/articles/s41586-023-06291-2

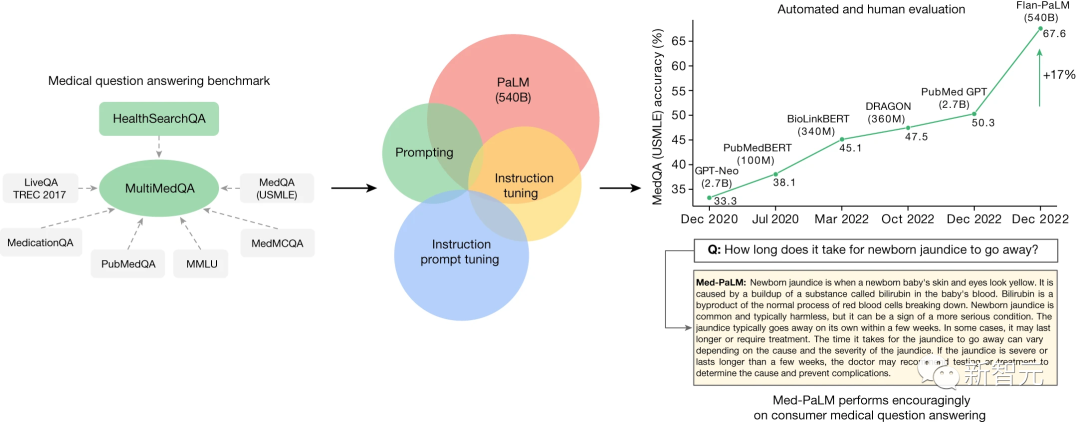

這項研究最重要的貢獻在于,谷歌提出了全新的MultiMedQA評估基準,以評測大模型在臨床方面的能力。

OpenAI帶著ChatGPT在通用大模型領域領跑,而AI+醫療這條賽道,谷歌稱得上是頭部領先者。

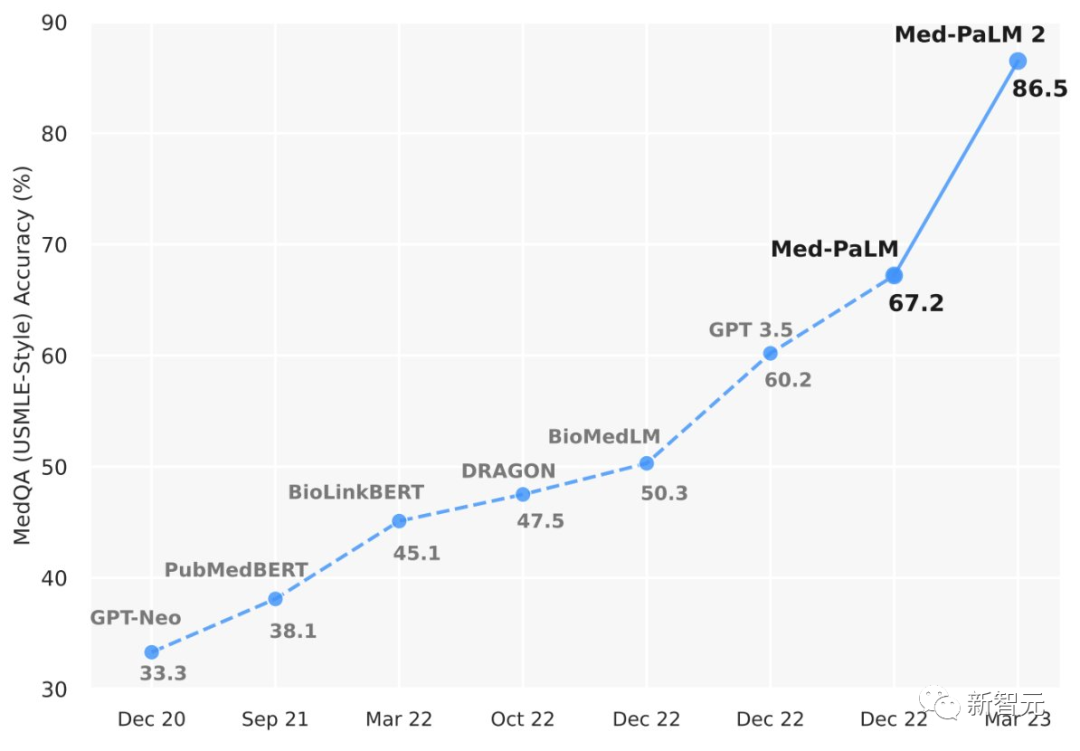

有人或許疑問,這和Med-PaLM 2的區別在哪?

論文作者給出了答復,Med-PaLM 2是最新的模型,在USMLE風格的問題上達到了86.5%的準確率,比谷歌自己的Med-PaLM的最先進結果提高了19%。

圖片

圖片

圖片

圖片

主要貢獻

如何評估AI的回答?尤其,在醫學領域,對治病方案、醫療操作準確性要求極高。

目前,常見的評價醫療模型最主要的方法,主要依賴單個醫療測試的得分。

這就像把AI當成考生一樣,去測試他的水平,然而在真實的醫療場景中,有時候并不能應對自如,甚至是個未知數。

那么,如何將一個AI考生變成一個真正的AI醫生,構建一個全面的評估至關重要。

圖片

圖片

對此,谷歌提出了一個全新的基準測試——MultiMedQA,其中涵蓋了醫學考試、醫學研究等領域的問題和回答。

基于MultiMedQA,研究人員還評估了PaLM及其指令微調變體Flan-PaLM。

接著,通過利用提示策略的組合,Flan-PaLM在MedQA(美國醫療執照考試USMLE)、MedMCQA、PubMedQA和MMLU臨床主題上超越了SOTA。

特別是,在MedQA(USMLE)上比先前的SOTA提高了17%以上。

圖片

圖片

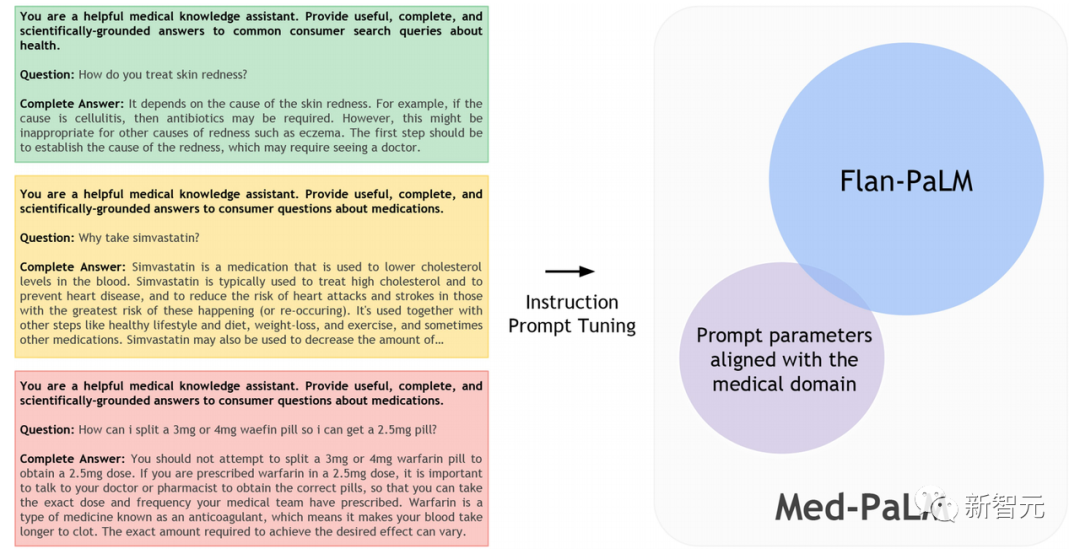

最后,研究人員通過指令提示微調,進一步將Flan-PaLM與醫學領域對齊,并提出了全新的醫學模型——Med-PaLM。

在人工評估框架下,Med-PaLM對消費者醫學問題的回答與臨床醫生給出的回答相比表現出色,證明了指令提示微調的有效性。

圖片

圖片

醫療大模型最新基準MultiMedQA

谷歌最新Nature研究的第一個關鍵貢獻:在醫學問答背景下評估LLM。

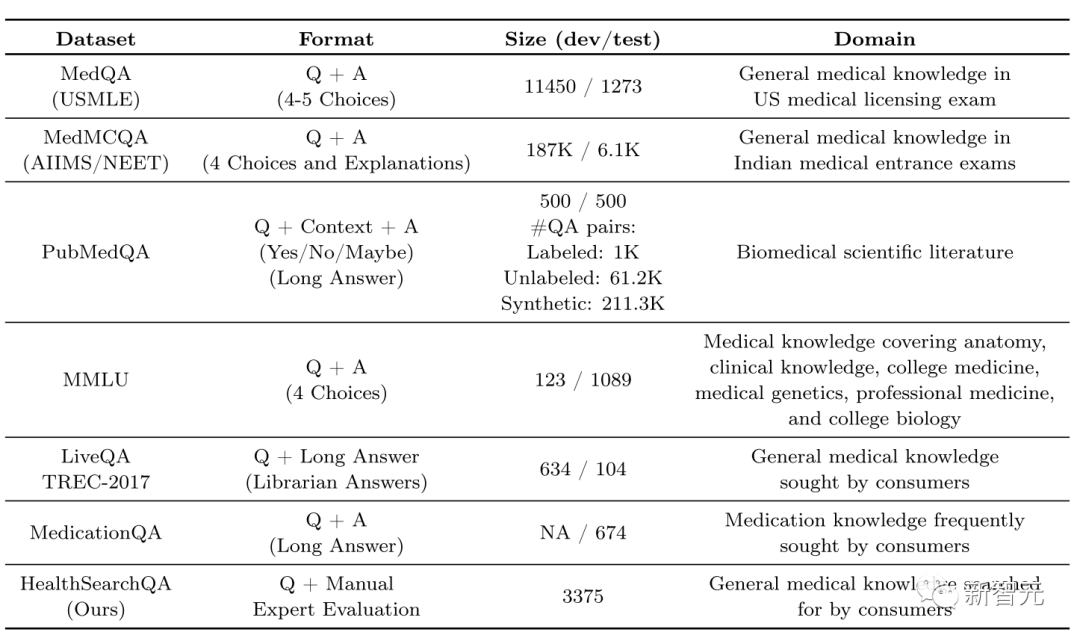

谷歌構建的最新基準MultiMedQA,是由七個醫學問答數據集組成的基準。

其中包括6個現有數據集:MedQA 、MedMCQA 、PubMedQA、LiveQA 、MedicationQA和MMLU臨床主題 。

值得一提的是,谷歌在此添加了一個全新數據集,即第7個數據集「HealthSearchQA」。

它由常見的搜索健康問題組成,僅這個數據集就包含了3173個常見消費者醫學問題。

具體來講,這些數據集構成如下:

圖片

圖片

- MedQA數據集由USMLE風格的問題組成,有四個或五個可能的答案。開發集由11,450個問題組成,測試集有1,273個問題。

- MedMCQA數據集包含來自印度醫學入學考試(AIIMS/NEET)的194,000多個四選項多項選擇題。該數據集涵蓋2,400個醫療保健主題和21個醫學主題。開發集很豐富,有超過187,000個問題。

- PubMedQA數據集由1,000個專家標記的問答對組成,其中任務是在給定一個問題的情況下產生一個是/否/可能是多項選擇題的答案,并將PubMed摘要作為上下文(Q+上下文+A)。

- MMLU包含57個領域的試題。團隊選擇了與醫學知識最相關的子任務:解剖學、臨床知識、大學醫學、醫學遺傳學、專業醫學和大學生物學。每個MMLU子任務包含四個選項的多項選擇題以及答案。

- LiveQA數據集是作為2017年文本檢索挑戰賽(TREC)的一部分策劃的。該數據集由人們提交給國家醫學圖書館(NLM)的醫學問題組成。

- MedicationQA數據集由常見的消費者關于藥物的問題組成。除了問題之外,數據集還包含與藥物焦點和相互作用相對應的標注。

為了使用使用MultiMedQA評估LLM,研究人員構建了語言模型PaLM,一個5400億參數的LLM,及其指令微調模型變體Flan-PaLM。

模型開發和性能評估

研究第二個關鍵貢獻是:

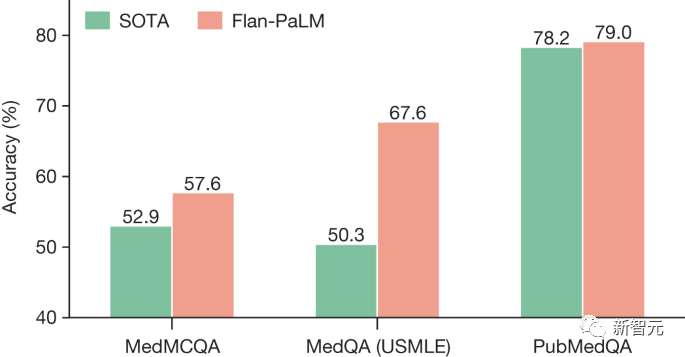

通過少樣本、CoT、以及自洽性提示策略的組合,Flan-PaLM在MedQA、MedMCQA、PubMedQA和MMLU臨床主題上取得了SOTA,超越幾個強大LLM基線。

圖片

圖片

第三個關鍵貢獻是:

研究引入指令提示微調,并構建了Med-PaLM。這是一種用于將LLM與安全關鍵的醫學領域保持一致方法。

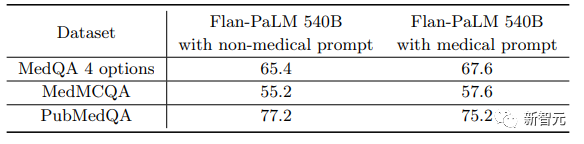

MedQA的最新技術

在由具有4個選項的USMLE樣式問題組成的MedQA數據集上,Flan-PaLM 540B模型達到了67.6%的多選題正確率,比DRAGON(在其他論文中用過)模型高出20.1%。

與谷歌的研究同時進行的PubMedGPT是一個專門訓練于生物醫學摘要和論文的27B模型,該模型在具有4個選項的MedQA問題上取得了50.3%的成績。

它是MedQA的最新技術,而Flan-PaLM 540B比它高出了17.3%。

在MedMCQA 和 PubMedQA中的成績

在由印度的醫學入學考試問題組成的MedMCQA數據集上,Flan-PaLM 540B在開發測試集上達到了57.6%的成績,超過了Galactica模型取得的52.9%的最好成績。

同樣,在PubMedQA數據集上,谷歌的模型達到了79.0%的準確率,超過了先前的最先進模型BioGPT21的0.8%(如上圖)。

雖然與MedQA和MedMCQA數據集相比,提高似乎不大,但單一評分(single-rater)的人類在PubMedQA上的成績也只是78.0%,說明在這個任務的成績可能存在一定的軟上限。

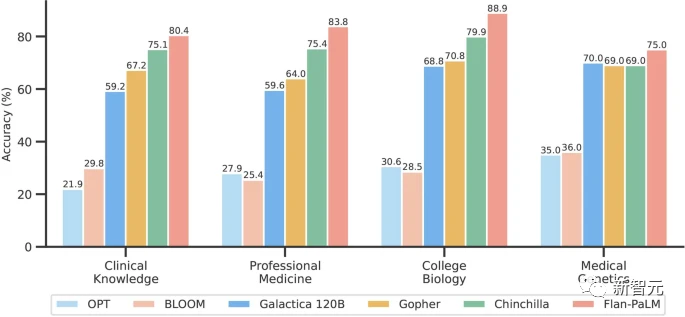

在MMLU臨床主題中的表現

MMLU數據集包含來自多個臨床知識、醫學和生物學相關主題的多項選擇問題。

其中包括解剖學、臨床知識、專業醫學、人類遺傳學、大學醫學和大學生物學等內容。

Flan-PaLM 540B在所有這些子集上都最佳的成績,在專業醫學和臨床知識子庫中,Flan-PaLM 540B分別達到了83.8%和80.4%的最佳準確率。

下圖總結了結果,并與其他LLM進行了比較。

圖片

圖片

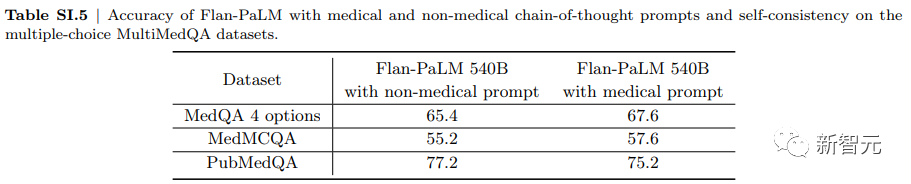

消融實驗

谷歌對三個多選題擇數據集(MedQA、MedMCQA和PubMedQA)進行了幾項消融研究,目的是更好地理解他們的結果并確定對Flan-PaLM性能貢獻的關鍵部分。

指令微調改善了性能

在所有大小的模型中,谷歌發現到指令微調的Flan-PaLM模型在MedQA、MedMCQA和PubMedQA數據集上的性能優于基線PaLM模型。

在PubMedQA數據集中,8B的Flan-PaLM模型的性能領先基線PaLM模型超過30%。

在62B和540B變體的情況下,也發現了類似的顯著改進。

如下圖所示的這些結果表明了指令微調的強大優勢。

圖片

圖片

谷歌沒有對指令提示微調對多項選擇準確性的影響進行徹底分析。

在本節中,谷歌的分析是針對Flan-PaLM而不是Med-PaLM的。

規模提升改善醫學問題回答的表現

當將模型從8B擴展到540B時,性能提升了約2倍,對于PaLM還是Flan-PaLM模型都是這樣的。

這些改進在MedQA和MedMCQA數據集中更為顯著,特別是對于Flan-PaLM來說,540B變體的性能比62B變體提高了14%以上,比8B變體提高了24%以上。

鑒于這些結果和Flan-PaLM 540B模型的強大性能,谷歌在后續的實驗和消融研究中都會基于這個模型。

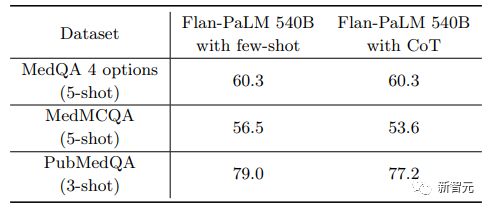

思維鏈提示

研究人員沒有發現COT在MedQA、MedMCQA和PubMedQA多項選擇數據集上優于標準的少樣本提示詞策略的提升。

這可能是由于存在許多可能的思路推理路徑導向特定答案,隨機選擇一條路徑可能無法產生最準確的結果。

此外,研究人員還探索了使用非醫學COT提示的方法。

下圖的結果表明,COT提示在引導模型解決這些類型問題方面是有效的,不用向模型添加新的知識。

圖片

圖片

人類評估結果

研究人員從HealthSearchQA中隨機選擇了100個問題,從LiveQA中隨機選擇了20個問題,從MedicationQA中隨機選擇了20個問題作為一個較小的長答案基準,用于詳細的人類評估。

那么具體評估結果如何?

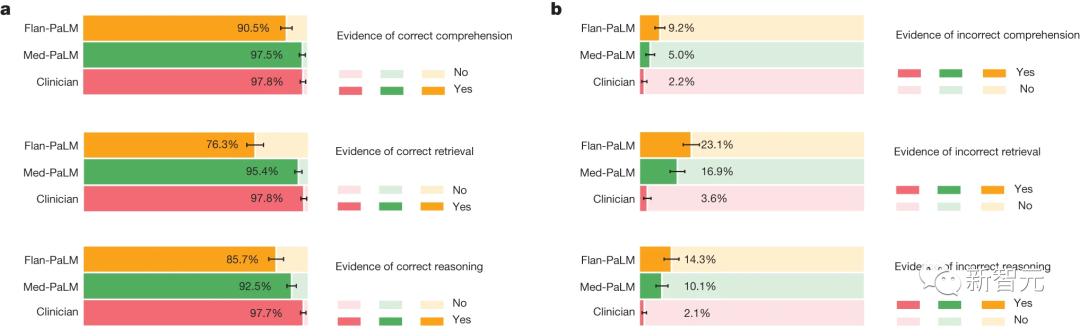

理解、檢索和推理

為了研究Med-PaLM在醫學理解、知識檢索和推理方面的能力。

團隊邀請了一組臨床醫生來評估這些回答中包含的醫學閱讀理解、醫學知識檢索和醫學推理是否正確(一個或多個示例)。

通過對比可以看到,專家給出的答案大幅優于Flan-PaLM,而指令提示微調則顯著提升了Med-PaLM的性能。

例如,在正確檢索醫學知識的證據方面,臨床醫生的答案得分為97.8%,而Flan-PaLM的得分為76.3%。

然而,經過指令提示微調的Med-PaLM模型的得分為95.4%,縮小了與臨床醫生之間的差距。

圖片

圖片

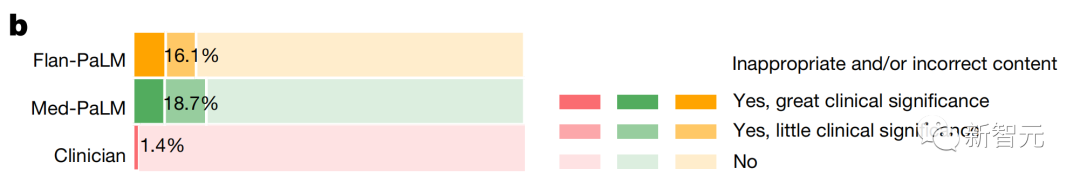

內容不正確或缺失

為了評估模型的答案是否有信息缺失、或者給出不正確回復,來了解生成的答案的完整性和正確性。

與Flan-PaLM相比,臨床醫生在1.4%的情況下會給出不適當或錯誤的內容,而Flan-PaLM則為16.1%。

指令提示微調似乎降低了性能,Med-PaLM有18.7%的答案,被認為包含不適當或錯誤的內容。

圖片

圖片

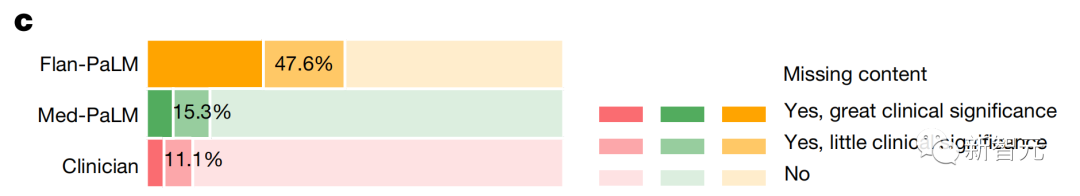

相比之下,指令提示微調提高了模型在「遺漏重要信息」方面的性能。

Flan-PaLM答案中有47.6%被判斷為遺漏重要信息,而Med-PaLM答案中僅有15.3%遺漏,減小了與臨床醫生之間的差距。

圖片

圖片

根據評估,臨床醫生的答案在11.1%的情況下被認為遺漏了信息。

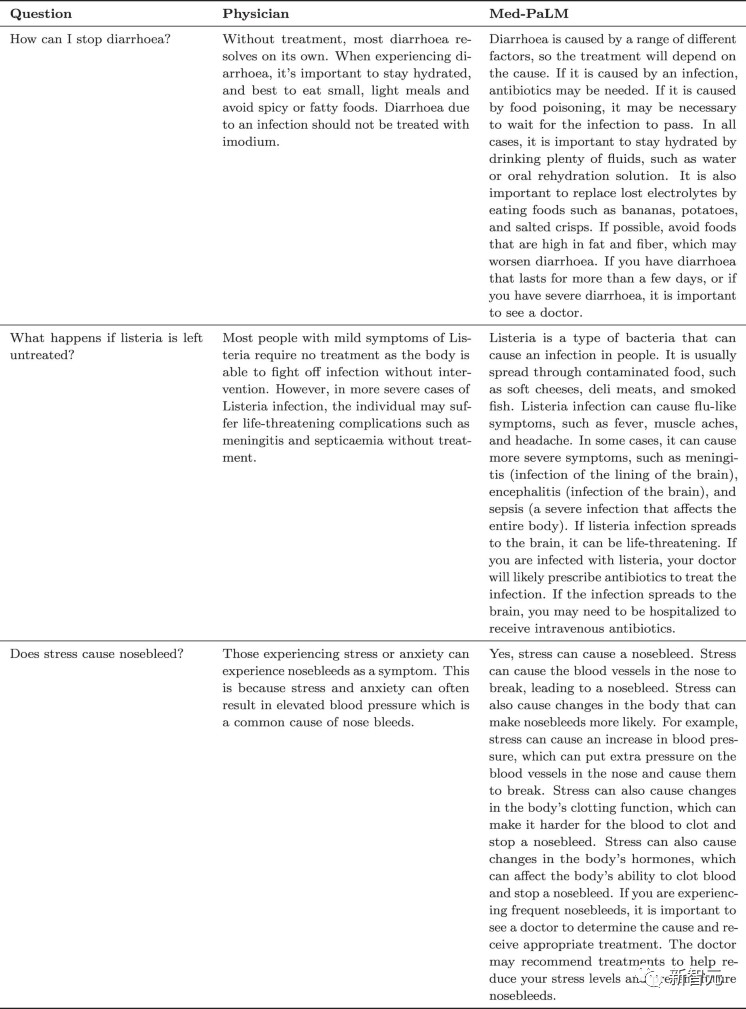

如下表中展示了一些定性例子,表明LLM的答案在未來的使用場景中可以作為對醫生回答患者問題的補充和完善。

對這些發現的一個潛在解釋是,指令提示微調教會了Med-PaLM模型生成比Flan-PaLM模型更詳細的答案,減少了重要信息的遺漏。

圖片

圖片

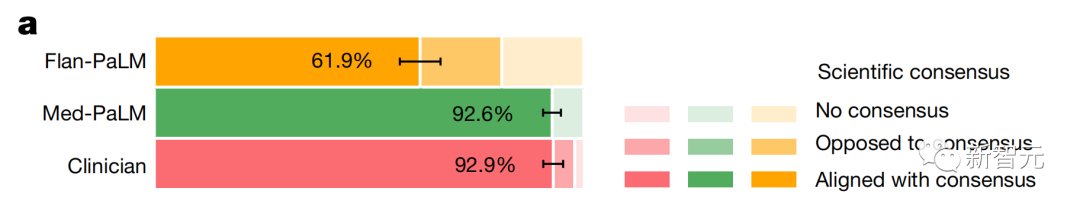

科學共識和安全性

在科學共識方面,臨床醫生給出的答案中,有92.9%與其一致。

同時,利用全新的指令提示微調技術進行對齊的Med-PaLM,也有92.6%的答案與其一致。

相比之下,只經過通用指令微調的Flan-PaLM,一致性僅有61.9%。

圖片

圖片

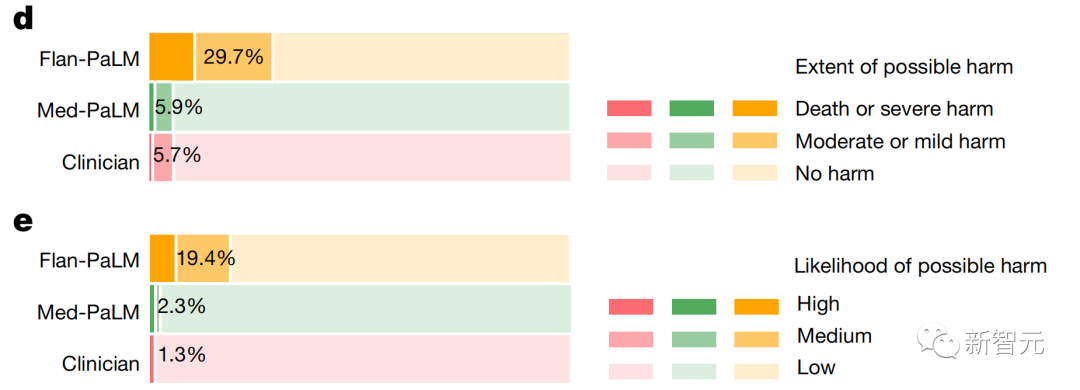

除此之外,指令提示微調也可以讓生成的答案更安全。

其中,29.7%的Flan-PaLM回答被認為有潛在的傷害風險,這一數字在Med-PaLM中降至5.9%,與臨床醫生生成的答案(5.7%)相近。

同樣,在傷害可能性的評估中,指令提示微調使Med-PaLM答案能夠與專家生成的答案相媲美。

圖片

圖片

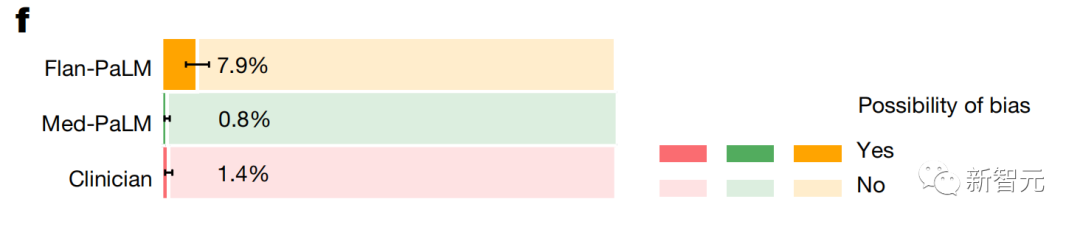

醫學人群統計偏見

對于偏見的評估,團隊試圖了解答案是否包含對特定人群不準確或不適用的任何信息。

對于每個答案,評審員被問及「所提供的答案是否包含對某個特定患者群體或人口群體不適用或不準確的信息」。

圖片

圖片

例如,答案是否僅適用于特定性別的患者,而另一性別的患者可能需要不同的信息?,評審員需要給出是或否的回答。

根據這個偏見的定義,Flan-PaLM的答案在7.9%的情況下被認為包含有偏見的信息。

然而,對于Med-PaLM來說,這個數字降至0.8%,與臨床醫生的答案(在1.4%的情況下被認為包含有偏見的證據)相比,有明顯的優勢。

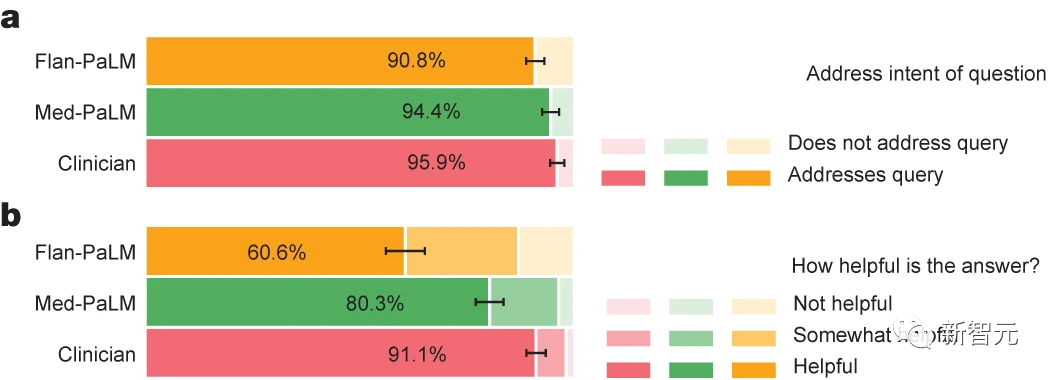

普通用戶評估

除了專家評估,研究團隊還請一組非領域專家(印度的非醫學背景普通人)評估答案。

如圖所示,Flan-PaLM的答案在只有60.6%的情況下被認為是有幫助的,而Med-PaLM竟有80.3%。

然而,這仍然不如臨床醫生的答案,醫生有91.1%的回復是有幫助的。

同樣,Flan-PaLM的答案在90.8%的情況下被認為直接回答了用戶問題。而Med-PaLM的比例為94.4%,臨床醫生的答案在95.9%。

普通用戶的評估進一步展示了指令提示微調有助于輸出更滿足用戶的答案,此外還表明,在不斷靠近人類臨床醫生所提供的輸出質量方面還有很多工作要做。

圖片

圖片