AIGC算力全景與趨勢報告發布!一文解讀AIGC算力構成、產業鏈條,還有五新趨勢判斷

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

AI算力從沒有任何一個時刻,比現在更受矚目。

大模型趨勢發生以來,大模型的數量、規模,在短短幾月內突增。

百億千億級別大模型飆升至數十個,萬億參數大模型已正式誕生。

在這樣的量級變化下,算力需求呈現出劇烈變化。

模型層公司幾乎在不計一切代價搶購算力服務,英偉達市值一度突破萬億美元,云計算市場被加速重塑……

毫無疑問,算力之于AIGC產業發展,是如同水電、石油一樣的基礎能源。

在AIGC時代序幕拉起后,該如何理解算力產業,就顯得尤為重要。

企業需要怎樣的算力?算力產業會因AIGC興起發生哪些變革?當下算力市場構成究竟如何?

《AIGC算力全景與趨勢報告》為此而來,幫助大家理解這些問題。

在報告中,量子位智庫系統性解析了AIGC算力構成、產業鏈條,還進一步指出了AIGC算力的五新趨勢及三大階段發展預測。

核心觀點包括:

- AIGC驅動下,芯片競逐高性能大算力,引入新計算架構;

- AI服務器異軍突起,紅利曲線先訓練后推理;

- MaaS重塑云服務范式,AIGC商業模式閉環;

- AI模型一體機呼之欲出,傳統產業“開箱即用”;

- 智算中心護航AIGC運營,算力租賃模式成新解;

……

具體細節,我們逐一來看。

國產服務器廠商業務增量超30%

分析當下產業現狀來看,產業主體主要包括:

- 芯片

- AI服務器(集群)

- 云計算

芯片層:AIGC兩大路線提供算力

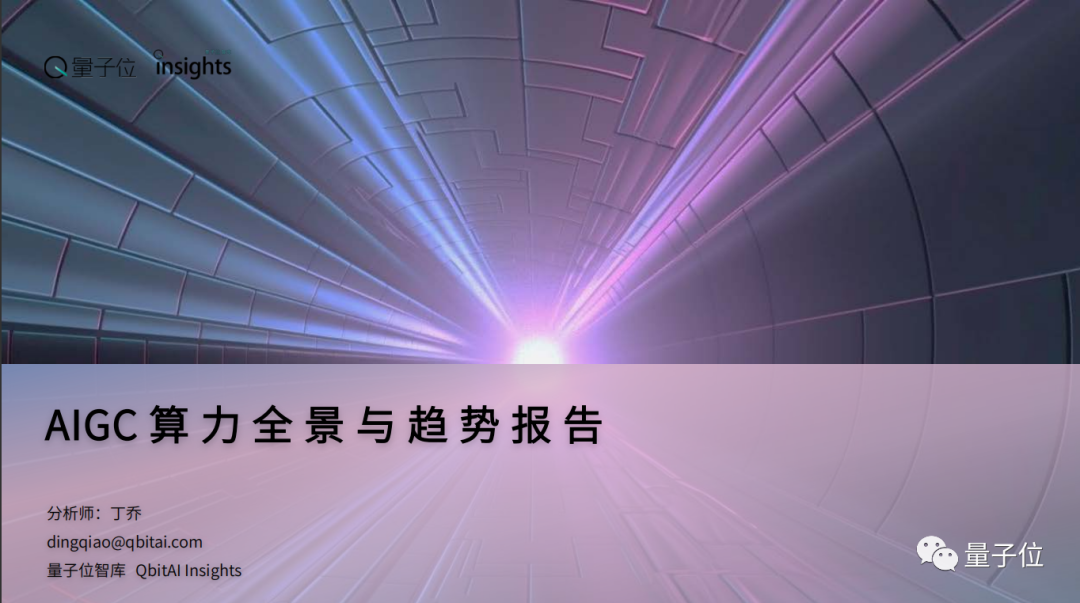

在計算類芯片中,目前業內有兩種主流路線來滿足AIGC產業的算力需求。

一種是以英偉達為代表的GPU路線,稱為通用芯片。

另一種是以華為、寒武紀為代表的ASIC路線,稱為專用芯片路線。

目前,這兩種路線上匯集了不同類型的玩家,它們承擔的計算任務也有區別。

通用芯片路線下,能夠完成多樣化計算任務,并且適合大規模并行計算。

即通用芯片(GPU)更適合AIGC目前所需算力。

專用路線的優勢體現在特定場景中的更優能效比。由于專用芯片設計被用來執行專門或定制化任務,其在特定場景中能夠達到相較于通用芯片更優的能效比和計算效率。

正因為專用芯片在特定場景中能夠釋放出更大的計算效率,其也成為互聯網等云廠商自研芯片時選擇的技術路線。

通常,互聯網云廠商的自研芯片主要服務于自家產品,強調在自身生態中將芯片性能最大化釋放。

圖片

圖片

服務器層:業務增量明顯,以互聯網客戶為主

AIGC對于高性能計算的需求,使得AI服務器成為服務器領域業務增長最快的細分種類。

大模型訓練,例如GPT-3,需要大量的計算資源和內存,通常涉及使用數千甚至數萬塊GPU來加快訓練速度。

由于這些計算對芯片性能要求非常高,需要使用專門的硬件和軟件來支持大規模并行計算和高速數據傳輸。

AI服務器是專門為處理人工智能工作負載而設計的服務器,使用專門硬件加速器(如GPU、TPU等),以及高速網絡連接和存儲,以提供高性能計算能力。

相比之下,CPU(通用服務器)通常不能滿足AIGC對極大算力的需求,其計算能力、內存和存儲容量通常較低。另外,CPU通常不具備專門的硬件加速器,無法提供高速計算。

因此,大型模型訓練需要依靠AI服務器集群來提供算力服務。

根據量子位智庫的調研顯示,今年AIGC爆發后,國產服務器廠商普遍業務增量在30%以上。

近日,TrendForce也將2022-2026年AI服務器出貨量年復合增長率上調至22%。在AI服務器業務量激增的背后,最大的買家依然是互聯網公司。

2022年,AI服務器采購占比中,字節跳動、騰訊、阿里巴巴、百度等大廠成為主要采購方。今年,大模型研發的火熱更是帶動下游互聯網大廠購買需求,使其依舊是AI服務器最大的買方。

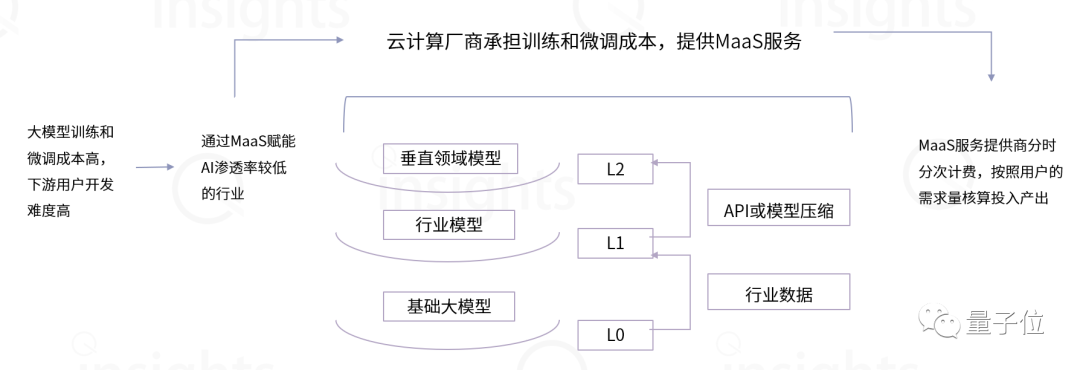

云計算:MaaS重塑服務模式,新老玩家重構競爭力

MaaS模式最早由阿里提出,隨后互聯網大廠、人工智能企業(如商湯)均已引入MaaS模式。

此外,互聯網大廠、華為等企業已經將自研芯片用于MaaS底座構建中。

2023年,國內頭部云廠商相繼推出自己的MaaS平臺,基于大模型基座,為計算資源有限、缺乏專業經驗的企業提供一站式MaaS服務。

對于云廠商來講,MaaS服務的主要目的在于幫助客戶快速構建行業專屬大模型。基于此,云廠商之間的競爭維度轉變為算力基礎設施、通用大模型能力、AI平臺/工具能力。

圖片

圖片

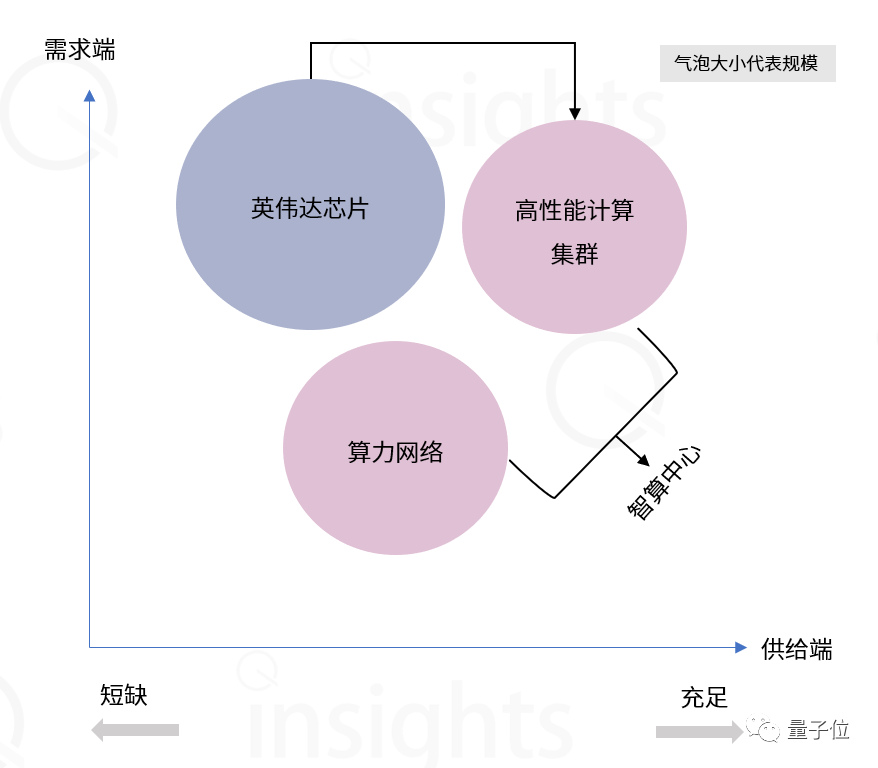

智算中心現狀:基建級AI算力供應,打造地區經濟增長新引擎

從計算設備分布來看,在服務器和AI服務器市場中,北京、廣東、浙江、上海、江蘇位居前五,(服務器和AI服務器)市場份額總計分別達到75%和90%(2021年數據)。

從供給角度看,目前智算中心多分布在東部和中部省份,而AIGC業務需要處理海量數據導致東部算力資源成本過高。

將大模型訓練等對計算要求高的任務移至西部地區,形成“東數西訓”,能夠有效降低成本,實現算網資源綜合成本最優。

具體來講,針對算力需求供需不平衡等問題,需要通過算力調度將東部的算力和數據處理任務轉移至成本較低的西部地區。其中,優化東西部之間互聯網絡和樞紐節點間直連網絡是提升算力調度水平的關鍵。

從需求角度看,AIGC算力需求主要來自于研發AIGC大模型的廠商,主要分布在京津冀地區、長三角及大灣區。

芯片服務器變革初現

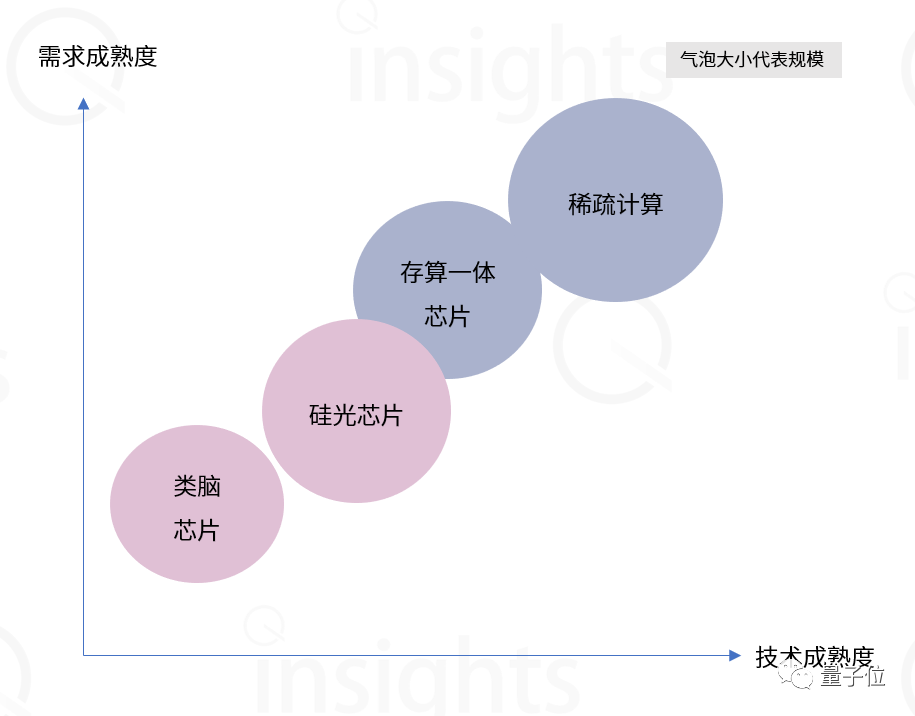

大模型趨勢給算力提出新要求,催生底層硬件新轉變。我們從芯片和服務器兩個層面看起:

芯片層面

目前在高性能芯片中,英偉達A100占據絕對優勢,而A100在中國只有存量沒有增量,市場將給予國產GPU廠商更多機會。

此外,在芯片代工層面,目前7nm及以上制程沒有對應的國產代工廠可以承接,GPU廠商多數選擇成熟制程+先進封裝的方案來實現較高的性能指標。

在服務器集群層面,通過多卡多機并行計算、高性能網絡實現高性能計算。

由于英偉達構建的硬件產品+CUDA生態在10年內很難突破,未來在高性能GPU受限的情況下,分析師預計硬件層將會有兩種主要解決方案,一種是發展GPU+片間互聯技術,實現大規模并行計算。

另一種是跳出馮·諾依曼架構,發展存算一體架構,將計算單元與存儲單元融合,實現數量級的計算能效提升。

軟件層面,稀疏計算和構建高性能網絡是目前兩種解決方案。

稀疏化計算的創新體現在算法層面,通過刪除無效或冗余的數據(此類數據通常數量龐大),大幅減少數據的計算量,從而加快計算速度。

構建高性能網絡的目的在于減少大模型訓練時長。通過構建高性能網絡,為每個計算節點超高通信帶寬,帶來數倍通行性能的提升,從而縮短大模型訓練時長。

服務器層面

AI大模型對算力需求呈指數級增長,使得具有更高配置的AI服務器成為AIGC算力的主要載體。

相比于傳統服務器,AI服務器的計算、存儲以及網絡傳輸能力能達到更高的水平。

例如,NVIDIA DGX A100服務器 8 個 GPU+2 個 CPU 的配置遠高于傳統服務器 1~2 個 CPU 的配置。

在我國,智算中心是為人工智能(大模型)提供算力資源的公共基礎設施平臺,其算力機組以AI訓練服務器和AI推理服務器為主。

隨著大模型趨勢演進,未來AI服務器的主要需求將從訓練側向推理側傾斜。根據IDC的預測,到2026年,AIGC的算力62.2%將作用于模型推理。

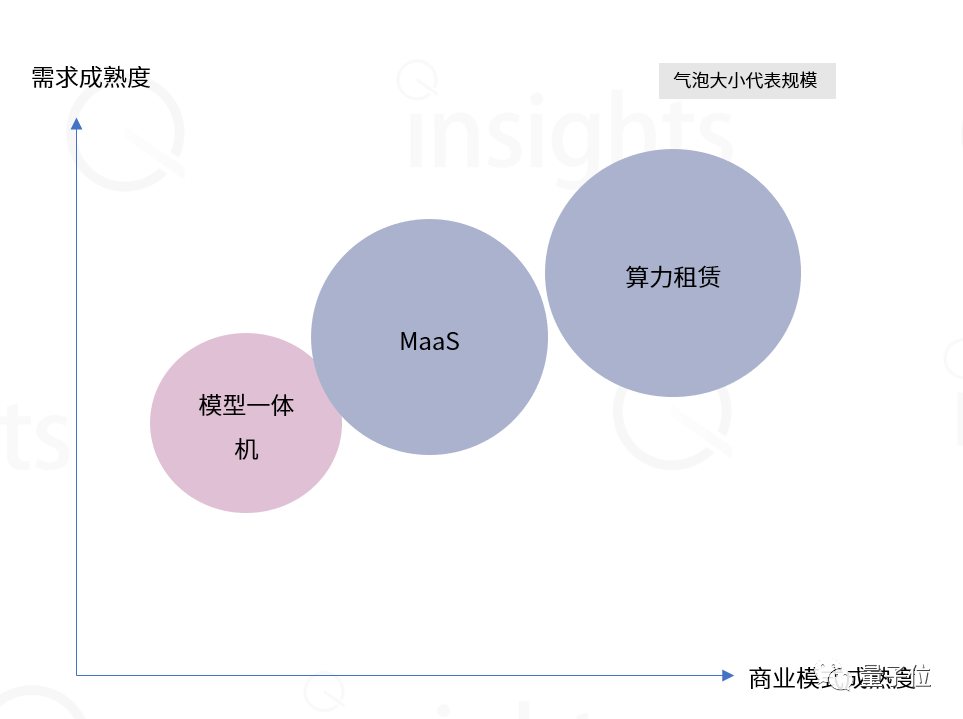

行業變革催生新商業機遇

更進一步,AI大模型趨勢給算力行業帶來全新機遇,新范式、新產品、新基建正在涌現。

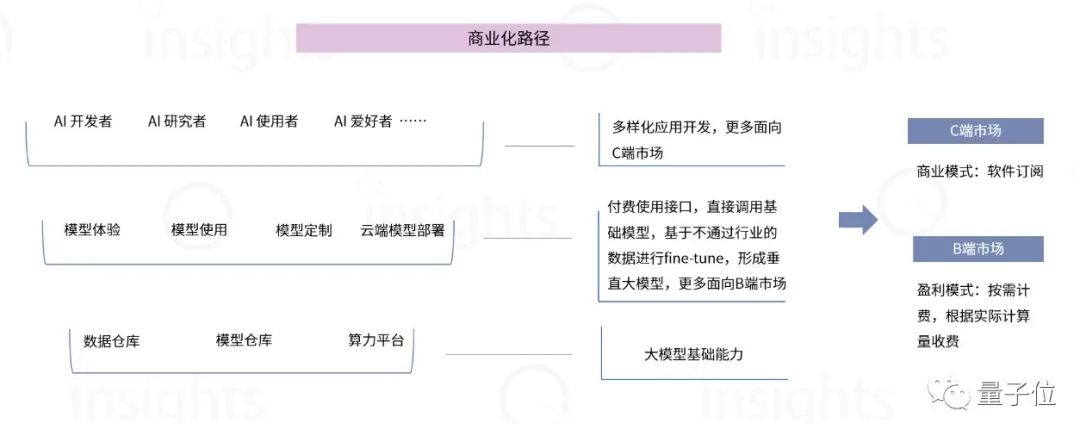

新游戲規則:MaaS重塑云服務范式,AIGC商業模式閉環

MaaS(模型即服務)在算力、算法和應用層中嵌入大模型,以智能底座集成應用并統一對外輸出。

MaaS的本質是將行業內通用的基礎技術提煉整合成服務,滿足各類應用場景需求。

在商業化過程中,大模型能力以及配套的中間件工具,會成為企業對于云計算廠商的新考量維度。

云計算服務能力的判別式從算力水平轉向「云智一體」能力,在算力基礎設施之外,核心競爭力轉變為把算力、模型和場景應用打造成標準化產品的能力。

圖片

圖片

新物種:AI模型一體機呼之欲出,傳統產業「開箱即用」

AI模型一體機將軟硬件深度融合,根據企業不同需求,將對應的產品或解決方案提前部署在AI服務器上,打包形成一整套解決方案。

AI模型一體機的成本優勢主要體現在以下三點:

- 1)整體采購價格低于軟件+硬件分開采購的價格;

- 2)企業單獨采購服務器再交由AI企業部署軟件耗費時間周期長,AI模型一體機能夠開箱即用,降低交付成本;

- 3)所需服務器數量大幅降低,為客戶節省空間成本。

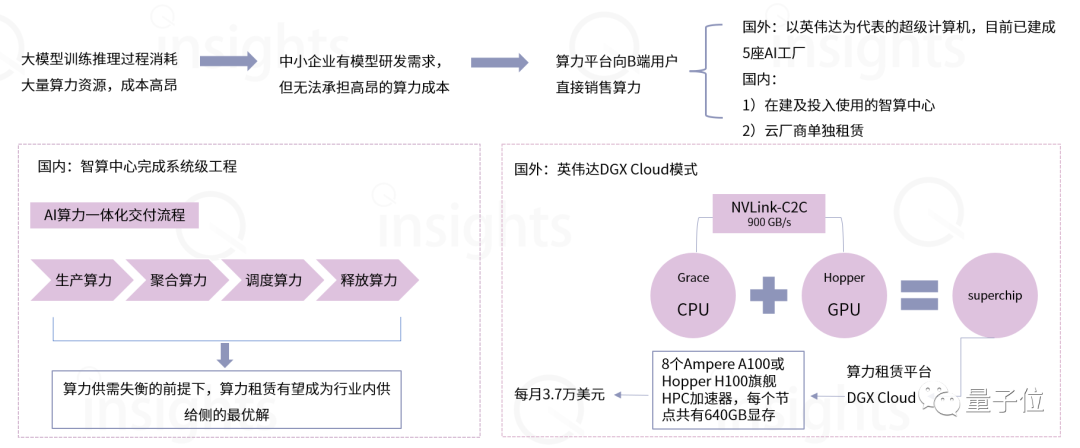

新基建:智算中心護航AIGC運營,算力租賃模式成新解

算力租賃模式可以有效降低大模型研發門檻,對于研發垂類行業的小模型企業來說,沒有購買足夠AI服務器的實力,公共算力基礎平臺將幫助中小型企業搭建其自身所需模型。

企業無需購買服務器,通過瀏覽器便可訪問算力中心,使用算力服務。

對于中小企業來講,無需依賴云廠商所構建的大模型底座進行二次開發,而是通過租用公有算力平臺的算力資源,研發垂類行業小模型。

圖片

圖片

行業發展預測

綜上,量子位智庫對AIGC未來發展進行預測,可分為三個階段:

- AIGC基建期

- AIGC開發期

- AIGC商業期

AIGC基建期

目前AIGC模型層的企業多數處在預訓練階段,對于芯片的需求來源主要為GPU。

在初期階段,高性能GPU廠商將成為最大收益方。

然而目前國產GPU廠商距離英偉達有較大差距,率先受益方為存量市場中的優勢方。

因此,國產AI服務器廠商是此階段的強勢供給方。目前,國內在AI服務器領域已經出現供不應求的局面。

AIGC開發期

中期階段(5年內),在算力層是一個由訓練向推理傾斜的過程。

在此階段,推理芯片將成為主要需求方。相比于GPU的高算力高功耗以及對應的算力浪費,推理芯片更注重芯片的算效比,對于功耗和成本有更優的把控。此外,這個階段也會是創新型芯片的機會。

分析師預計存算一體芯片、類腦芯片、硅光芯片將有更多市場機會。

在推理階段,相較于訓練階段的云計算,邊緣計算將有更多機會。

首先,推理階段對應的應用趨于多樣化,多樣化的需求使云計算會產生更多的算力浪費且計算效率不高。

其次,邊緣計算能夠為大模型推理提供足夠算力。

在此階段,AI服務器廠商的紅利期逐漸見頂,需求將轉向成本更低的通用服務器;芯片也從GPU轉向NPU/ASIC/FPGA/CPU等多種形式并存。國產創新型芯片路線中,看好存算一體架構的發展。

AIGC商業期

芯片的底層創新優勢開始顯現,存算一體、光子芯片、類腦芯片等具備真正革新技術的芯片廠商在市場中的作用增強。

AIGC算力所需的芯片種類更加多元。

這個階段的企業對算力的考量更加綜合,不僅考慮算力大小,功耗和成本可能超過算力大小成為各模型層公司關心的指標。

圖片

圖片

報告獲取

復制下方鏈接至瀏覽器打開:

https://jkhbjkhb.feishu.cn/wiki/W5D7wuDcbiPXDLkaRLQcAJpOn8f