陳怡然教授論文獲2024 IEEE優(yōu)秀論文獎(jiǎng)!STN-iCNN:端到端的人臉解析框架

陳怡然教授論文獲獎(jiǎng)!

這篇有關(guān)人臉識(shí)別/分析的論文拿下了2024 IEEE CIS TETCI優(yōu)秀論文獎(jiǎng)。

陳怡然教授在微博上表示,「四年前發(fā)表的文章居然得了2024年的杰出論文獎(jiǎng)。」

圖片

圖片

論文題目:通過(guò)互聯(lián)卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行端對(duì)端的人臉解析

圖片

圖片

人臉解析是一項(xiàng)重要的計(jì)算機(jī)視覺(jué)任務(wù),需要對(duì)人臉部位(如眼睛、鼻子、嘴巴等)進(jìn)行精確的像素分割,為進(jìn)一步的人臉?lè)治觥⑿薷暮推渌麘?yīng)用提供基礎(chǔ)。

互聯(lián)卷積神經(jīng)網(wǎng)絡(luò)(iCNN)被證明是一種有效的人臉解析模型。然而,最初的iCNN是在兩個(gè)階段分別訓(xùn)練的,這就限制了它的性能。

為了解決這個(gè)問(wèn)題,本篇論文引入了一個(gè)簡(jiǎn)單的端到端人臉解析框架——STN輔助的iCNN(即:STN-iCNN),通過(guò)在兩個(gè)孤立階段之間添加空間變換器網(wǎng)絡(luò)(STN)來(lái)擴(kuò)展iCNN。

STN-iCNN利用STN為原始的兩階段iCNN管道提供可訓(xùn)練的連接,使端到端的聯(lián)合訓(xùn)練成為可能。

此外,作為副產(chǎn)品,STN還能提供比原始裁剪器更精確的裁剪部分。

由于這兩個(gè)優(yōu)勢(shì),研究人員的方法顯著提高了原始模型的精度。研究人員的模型在標(biāo)準(zhǔn)人臉解析數(shù)據(jù)集Helen數(shù)據(jù)集上取得了具有競(jìng)爭(zhēng)力的性能。

它還在CelebAMask-HQ數(shù)據(jù)集上取得了優(yōu)異的性能,證明了其良好的泛化能力。

STN-iCNN

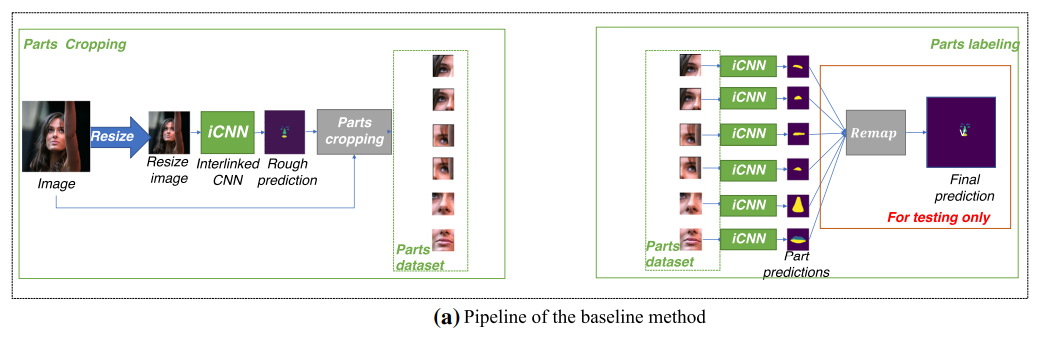

下面兩張圖片比較了STN-iCNN和傳統(tǒng)的基線法的對(duì)比。

在圖a中,我們可以看到基線法分為兩步。

第一步是檢測(cè)和裁剪人臉部分,第二步是分別標(biāo)注裁剪的部分。由于在此過(guò)程中使用的裁剪方法不可區(qū)分,因此這兩個(gè)階段無(wú)法進(jìn)行聯(lián)合訓(xùn)練。

如開(kāi)頭所說(shuō),這限制了系統(tǒng)的性能。

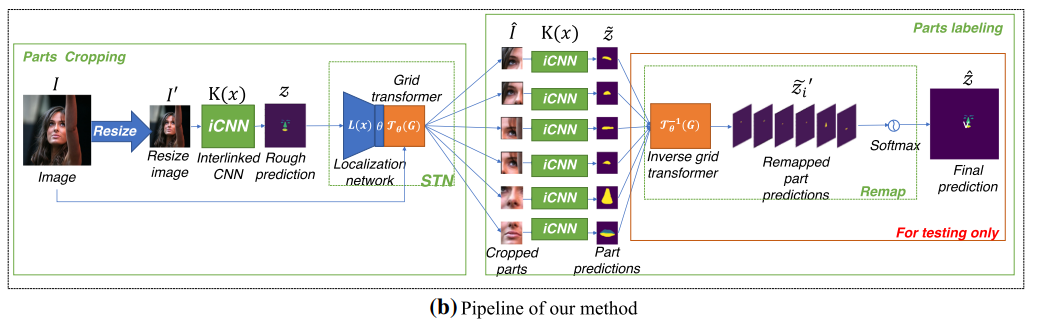

研究人員提出的方法通過(guò)在基線方法的兩個(gè)步驟之間添加空間變換器網(wǎng)絡(luò)(STN),就可解決了這一問(wèn)題。STN用一個(gè)可微分的空間變換器取代了原來(lái)的裁剪器,使模型能夠端到端地訓(xùn)練。

圖片

圖片

而像圖b中的STN-iCNN方法,對(duì)于每幅輸入的圖像,首先會(huì)調(diào)整圖像大小并傳遞給iCNN模型,由iCNN模型進(jìn)行粗分割。

然后,將粗分割版本發(fā)送給STN,STN的定位網(wǎng)絡(luò)預(yù)測(cè)變換器參數(shù)矩陣θ。然后,以θ為參數(shù),網(wǎng)格變換器對(duì)原始圖像中的相應(yīng)部分進(jìn)行裁剪。

最后,逆網(wǎng)格變換器將所有部分預(yù)測(cè)結(jié)果重映射為最終的整體預(yù)測(cè)結(jié)果。

圖片

圖片

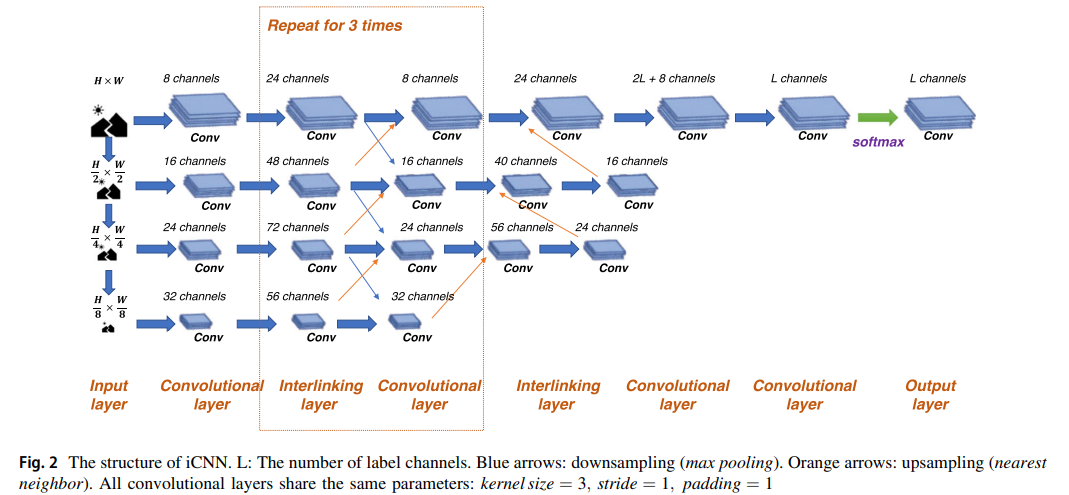

下圖是iCNN的結(jié)構(gòu)示意圖。

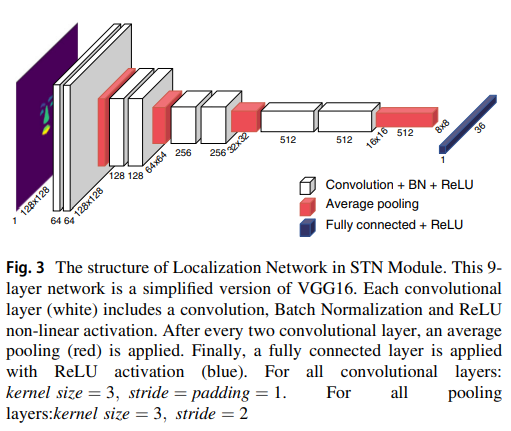

圖3則是STN模塊中的定位網(wǎng)絡(luò)結(jié)構(gòu)。

圖3則是STN模塊中的定位網(wǎng)絡(luò)結(jié)構(gòu)。

這個(gè)9層網(wǎng)絡(luò)是VGG16的簡(jiǎn)化版本。每個(gè)卷積層(白色)包括卷積、批量歸一化和ReLU非線性激活。

在每?jī)蓚€(gè)卷積層之后,應(yīng)用平均池化(紅色)。

最后,應(yīng)用ReLU激活的全連接層(藍(lán)色)。

圖片

圖片

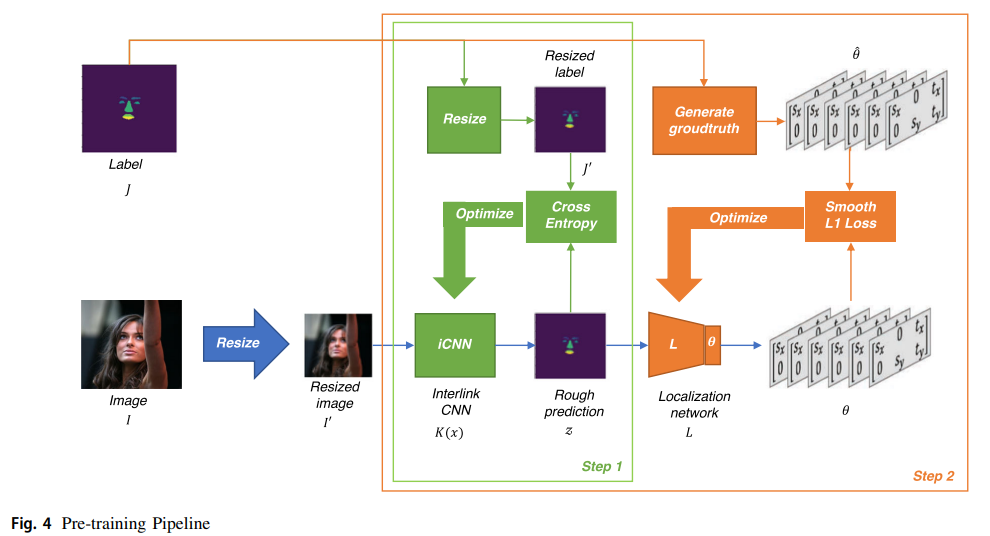

研究人員將整個(gè)系統(tǒng)的訓(xùn)練過(guò)程分為預(yù)訓(xùn)練和端到端訓(xùn)練。

首先,為了達(dá)到更好的效果,先對(duì)系統(tǒng)進(jìn)行了預(yù)訓(xùn)練。其中,有兩個(gè)模塊需要進(jìn)行預(yù)訓(xùn)練,一個(gè)是用于粗分割的iCNN K,另一個(gè)是用于部件定位的定位網(wǎng)絡(luò)L。

如下圖所示,K的輸入為調(diào)整后的圖像I0,輸出為粗略預(yù)測(cè)值z(mì)。

圖片

圖片

其優(yōu)化目標(biāo)是z和調(diào)整后的標(biāo)簽J'之間的交叉熵?fù)p失LR。

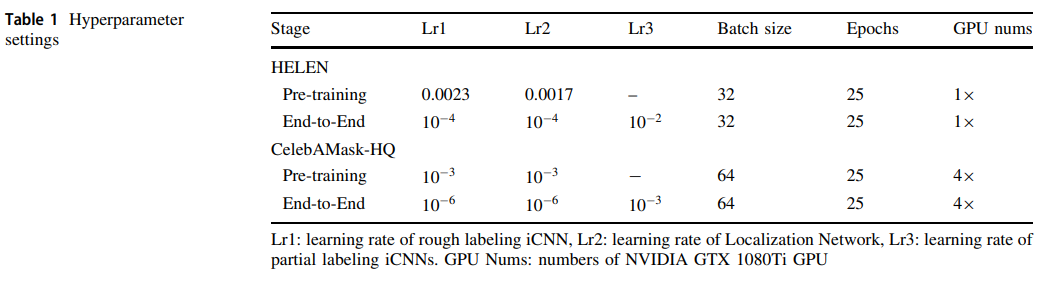

表1顯示了詳細(xì)的超參數(shù)。

研究人員分兩個(gè)階段對(duì)提出的模型進(jìn)行訓(xùn)練:預(yù)訓(xùn)練和端到端訓(xùn)練。其中,在端到端訓(xùn)練之前加載了前一階段獲得的預(yù)訓(xùn)練參數(shù)。

對(duì)于HELEN數(shù)據(jù)集,訓(xùn)練和推理在單個(gè)英偉達(dá)GTX1080Ti GPU上執(zhí)行,而對(duì)于CelebMaskA數(shù)據(jù)集,這些操作在4個(gè)英偉達(dá)GTX1080Ti GPU上執(zhí)行,每個(gè)GPU的批量大小為16。

所提出的模型具有良好的效率。在推理效率方面,基線模型每張臉的運(yùn)行時(shí)間為86毫秒,而提出的模型每張臉的運(yùn)行時(shí)間為80毫秒。

對(duì)于HELEN的訓(xùn)練效率,預(yù)訓(xùn)練階段需要0.5h,端到端階段需要2.2h;對(duì)于CelebMaskA的訓(xùn)練效率,預(yù)訓(xùn)練階段和端到端階段分別需要1.6h和10.2h。

在CelebMaskA上的混合訓(xùn)練策略:在HELEN上訓(xùn)練,在CelebMaskAD上微調(diào)由于CelebMaskA的數(shù)據(jù)量較大,直接訓(xùn)練需要更多的計(jì)算資源和更長(zhǎng)的訓(xùn)練時(shí)間。

在實(shí)踐中,研究人員發(fā)現(xiàn)使用CelebMaskA中的2000張圖像對(duì)已經(jīng)在Helen數(shù)據(jù)集上訓(xùn)練過(guò)的模型進(jìn)行微調(diào),兩者的性能相近。

這種方法在單個(gè)GPU上僅需2.1小時(shí),節(jié)省了大量的訓(xùn)練時(shí)間。這證明了研究人員模型的通用性。

圖片

圖片

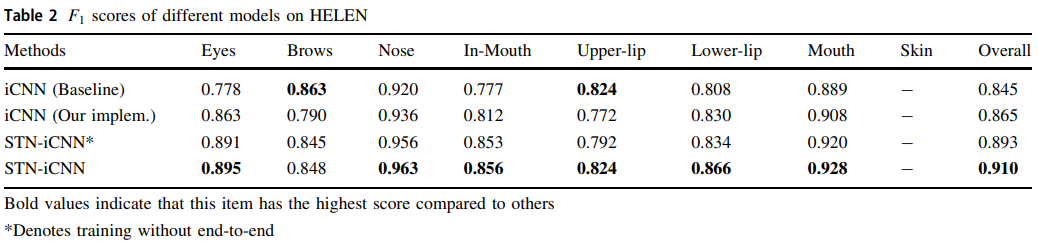

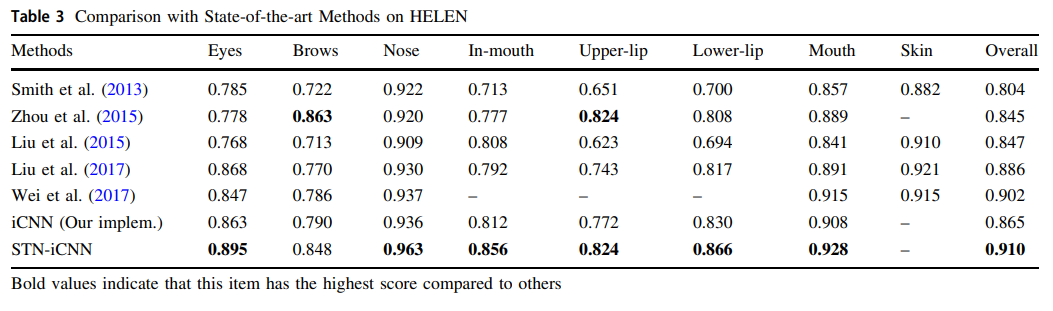

研究人員以之前一些研究者的結(jié)果為基線,將其與重新實(shí)現(xiàn)的iCNN和所提出的STN-iCNN在HELEN數(shù)據(jù)集上的結(jié)果進(jìn)行了比較。

比較結(jié)果如表2所示,其中STNiCNN*表示STN-iCNN在端到端訓(xùn)練前的結(jié)果。

我們能看到,即使在端到端訓(xùn)練之前,模型的結(jié)果也有明顯改善。

這是因?yàn)镾TN中的定位網(wǎng)絡(luò)具有深度CNN層,因此可以從粗糙掩膜中學(xué)習(xí)語(yǔ)義部分的上下文關(guān)系。在粗略掩碼不完整的情況下,仍然可以預(yù)測(cè)準(zhǔn)確的變換矩陣。

因此,STN能夠比原始裁剪器更精確地裁剪,從而提高了整體性能。

圖片

圖片

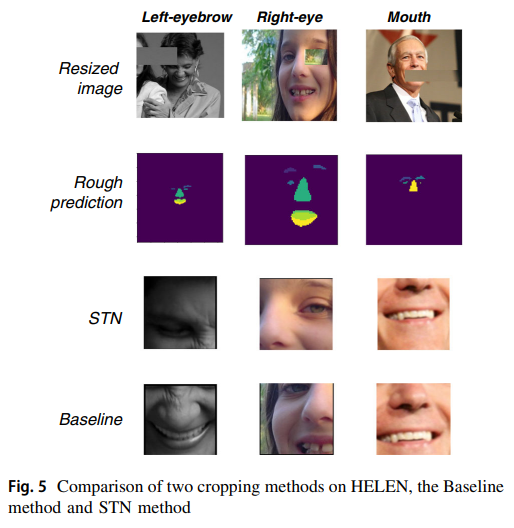

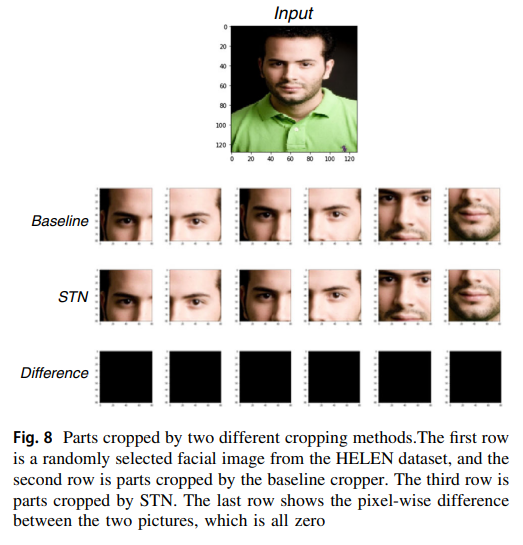

如圖5所示,研究人員在HELEN數(shù)據(jù)集上對(duì)兩種不同的裁剪方法進(jìn)行了對(duì)比實(shí)驗(yàn)。在該實(shí)驗(yàn)中,研究人員選取了一些圖像,并隨機(jī)地將其面部部分(如左眉、右眼、嘴等)與背景信息覆蓋在一起。然后研究人員將圖像發(fā)送給粗略標(biāo)注模型,得到不完整的粗略分割結(jié)果,見(jiàn)圖5中的第2行。在粗略結(jié)果的基礎(chǔ)上,研究人員使用基線方法和STN方法對(duì)未裁剪圖像進(jìn)行裁剪,并比較它們的裁剪結(jié)果。實(shí)驗(yàn)結(jié)果如圖5最后兩行所示。結(jié)果表明,STN方法即使在粗糙掩膜部分缺失的情況下也能正常工作。

圖片

圖片

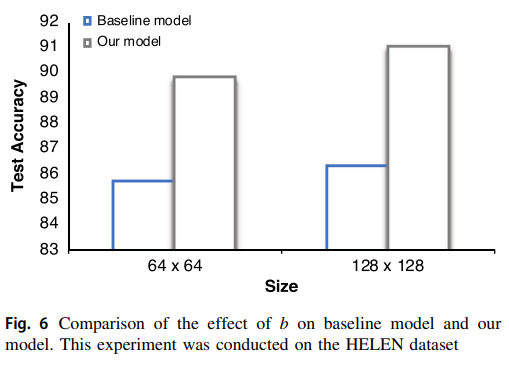

模型K的基線輸入大小為64×64,考慮到眼睛和眉毛特征較小,研究人員的模型將輸入大小改為128×128。

這一改變對(duì)基線方法的影響有限,但對(duì)研究人員的方法有明顯改善,如圖6所示。

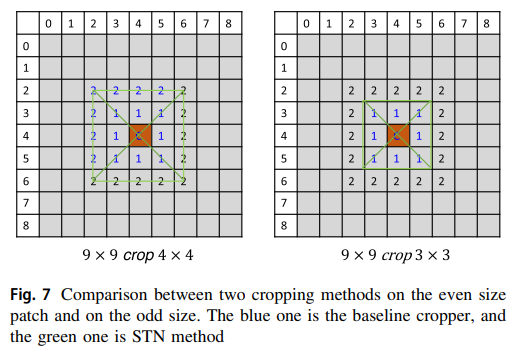

裁剪補(bǔ)丁的大小應(yīng)該是奇數(shù)而不是偶數(shù)。這是為了保證,在網(wǎng)格采樣過(guò)程中網(wǎng)格坐標(biāo)為整數(shù),從而使網(wǎng)格變換器等于基線方法在裁剪操作中的裁剪器。

圖片

圖片

如圖7所示,可以看出當(dāng)無(wú)法找到整數(shù)網(wǎng)格時(shí),STN進(jìn)行雙線性插值,而基線裁剪器進(jìn)行一像素偏移,從而導(dǎo)致結(jié)果不相等。

圖片

圖片

對(duì)于HELEN數(shù)據(jù)集,研究人員設(shè)置H ? W ? 81,對(duì)于CelebMaskA數(shù)據(jù)集,研究人員設(shè)置H ? W ? 127。兩種裁剪方法在HELEN數(shù)據(jù)集上的比較結(jié)果如圖8所示。

圖片

圖片

在選擇了合適的超參數(shù)后,研究人員完成了本文提出的STN-iCNN的端到端訓(xùn)練,并在HELEN數(shù)據(jù)集上將其測(cè)試結(jié)果與最先進(jìn)方法進(jìn)行了比較。

從表3可以看出,本文提出的STN-iCNN大大提高了原始iCNN模型的性能。

值得一提的是,由于研究人員的模型無(wú)法處理毛發(fā),也無(wú)法確定毛發(fā)對(duì)模型總體得分的影響,因此研究人員沒(méi)有將其與Lin等人(2019)的結(jié)果進(jìn)行比較。

圖片

圖片

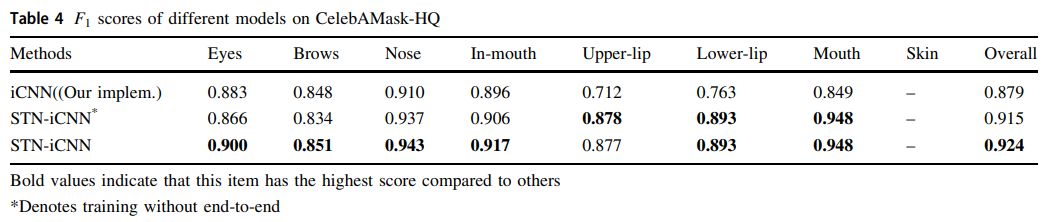

表4顯示了基線模型和研究人員提出的模型在F1得分上的比較。

在CelebAMask-HQ上的結(jié)果再次證明了所提方法和端到端訓(xùn)練的有效性,表明研究人員的模型具有一定的泛化能力。

更多論文內(nèi)容盡在參考鏈接中。