北大字節(jié)VAR獲最佳論文、廈大清華獲亞軍,NeurIPS 2024最佳論文出爐

剛剛,人工智能頂會(huì) NeurIPS 公布了今年的最佳論文(包括 Best Paper 和 Best Paper Runner-up,大會(huì)注冊者可以看到)。

一共有兩篇論文獲得最佳論文獎(jiǎng):

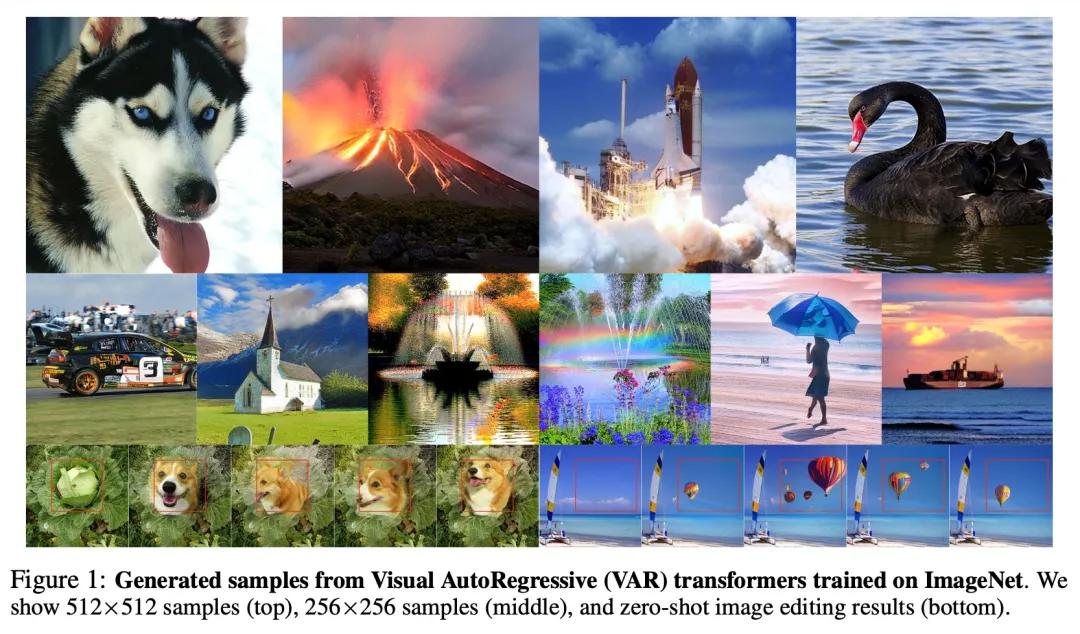

一是由北京大學(xué)、字節(jié)跳動(dòng)研究者共同完成的《Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction》(視覺自回歸建模:通過 Next-Scale 預(yù)測生成可擴(kuò)展圖像),論文一作為田柯宇(此前因涉攻擊內(nèi)部大模型,被字節(jié)起訴)。

機(jī)器之心獲悉,從 2023 年開始,字節(jié)商業(yè)化技術(shù)團(tuán)隊(duì)就在研究圖像生成的自回歸模型,一直將 VAR 作為高優(yōu)項(xiàng)目推進(jìn),不僅安排多名研究人員重點(diǎn)攻關(guān)此技術(shù)方向,還投入大量算力資源支持模型訓(xùn)練和實(shí)驗(yàn)。該團(tuán)隊(duì)近期將發(fā)布新的 VAR T2I 模型研究成果,并將對模型開源。

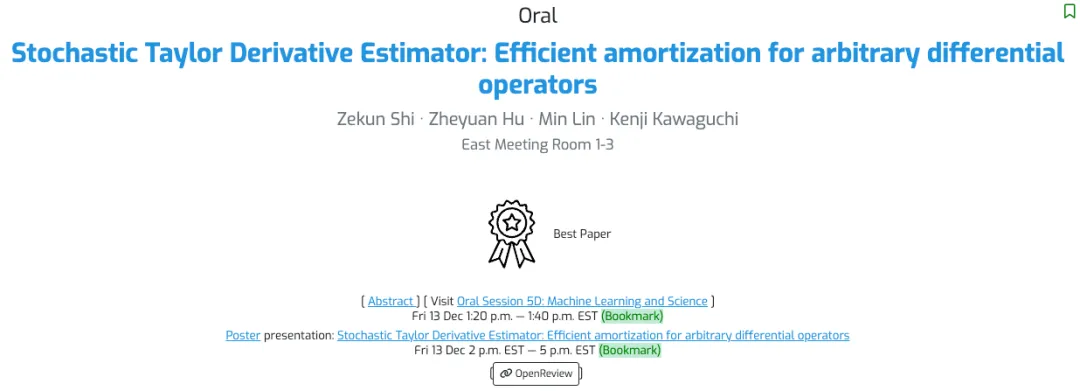

二是由新加坡國立大學(xué)、 Sea AI Lab 研究者共同完成的《Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators》(隨機(jī)泰勒導(dǎo)數(shù)估計(jì)器:任意微分算子的有效攤銷),論文一作為 Zekun Shi。

此外,還有兩篇論文獲得了最佳論文亞軍(Best Paper Runner-up):

由廈門大學(xué)、清華大學(xué)、微軟研究者共同完成的《Not All Tokens Are What You Need for Pretraining》(并非所有 token 都是預(yù)訓(xùn)練所需的), Zhenghao Lin 和 Zhibin Gou(茍志斌)為共同一作。

由英偉達(dá)和阿爾托大學(xué)共同完成的《Guiding a Diffusion Model with a Bad Version of Itself》(使用擴(kuò)散模型的一個(gè)糟糕版本引導(dǎo)其自身),論文一作為 Tero Karras。

NeurIPS 2024 將于 12 月 10 日星期二至 12 月 15 日星期日在溫哥華舉辦。本屆共收到 15671 篇有效論文投稿,比去年又增長了 27%,但最終接收率低于 2023 年,僅有 25.8%。最佳論文的公布提前引爆了有關(guān)此次大會(huì)的討論。

以下是獲獎(jiǎng)?wù)撐牡脑敿?xì)信息:

最佳論文

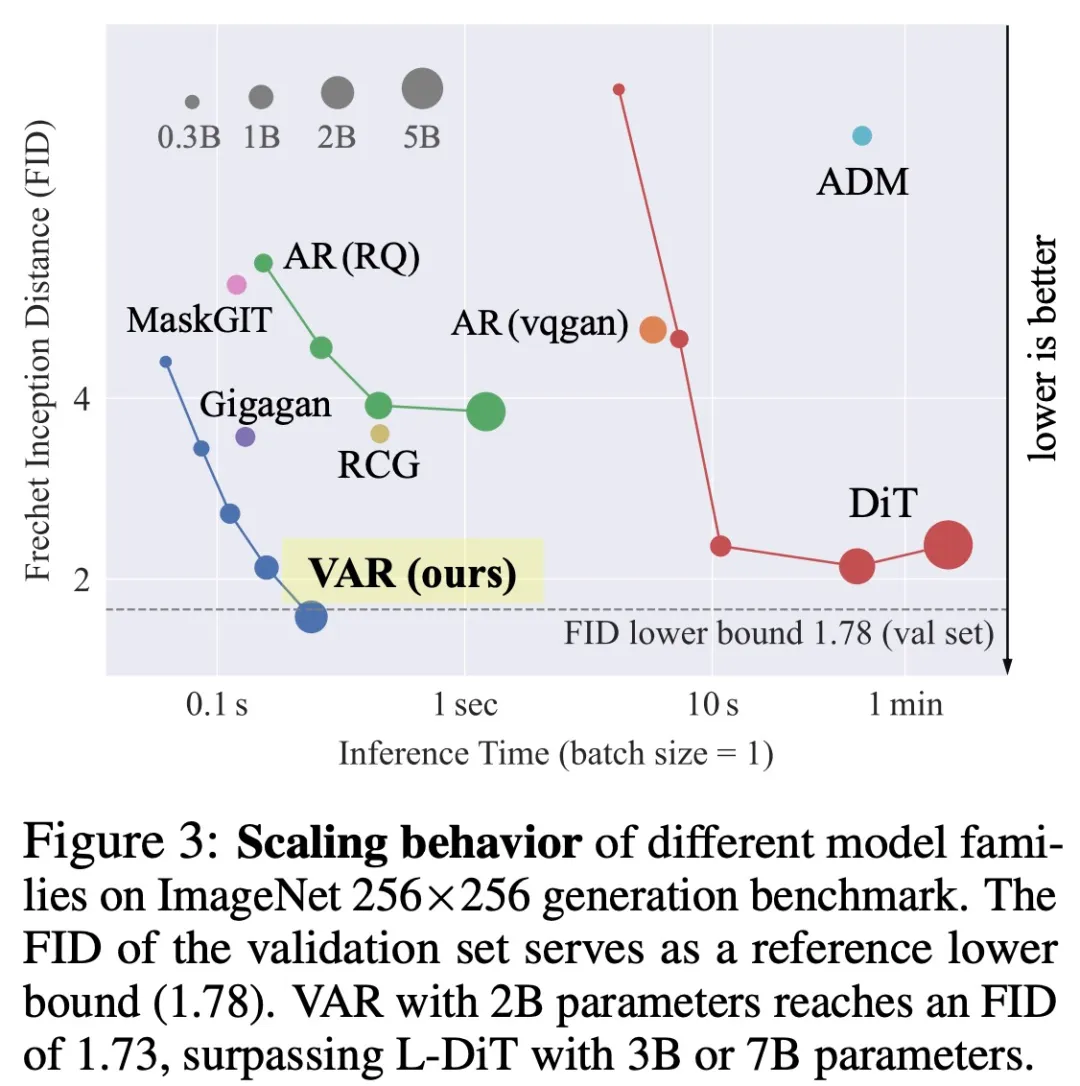

論文 1:Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction

- 作者:Keyu Tian, Yi Jiang, Zehuan Yuan, Bingyue Peng, Liwei Wang

- 機(jī)構(gòu):北京大學(xué)、字節(jié)跳動(dòng)

- 論文地址:https://arxiv.org/pdf/2404.02905

- 項(xiàng)目地址:https://github.com/FoundationVision/VAR

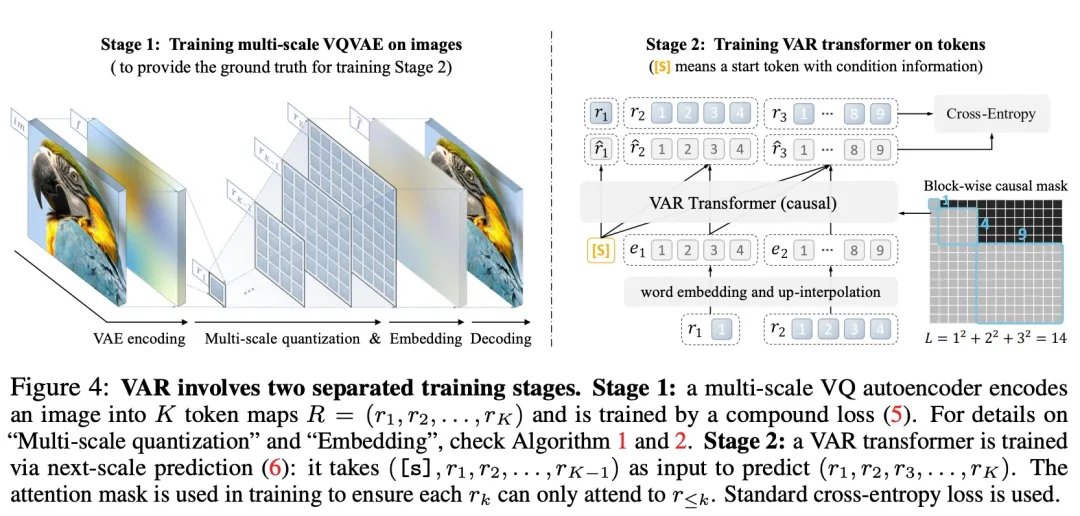

論文簡介:在自然語言處理中,以 GPT、LLaMa 系列等大語言模型為例的 Autoregressive(自回歸模型已經(jīng)取得了較大的成功,尤其擴(kuò)展定律(Scaling Law)和零樣本任務(wù)泛化能力(Zero-shot Task Generalizability)十分亮眼,初步展示出通往「通用人工智能 AGI」的潛力。

然而在圖像生成領(lǐng)域中,自回歸模型卻廣泛落后于擴(kuò)散(Diffusion)模型:DALL-E、Stable Diffusion、Sora 等模型均屬于 Diffusion 家族。

為了「解鎖」自回歸模型的能力和 Scaling Laws,研究團(tuán)隊(duì)從圖像模態(tài)內(nèi)在本質(zhì)出發(fā),模仿人類處理圖像的邏輯順序,提出一套全新的「視覺自回歸」生成范式:VAR, Visual AutoRegressive Modeling,首次使得 GPT 風(fēng)格的自回歸視覺生成,在效果、速度、Scaling 能力多方面超越 Diffusion,迎來了視覺生成領(lǐng)域的 Scaling Laws。

VAR 為如何定義圖像的自回歸順序提供了一個(gè)全新的視角,即由粗到細(xì)、由全局輪廓到局部精調(diào)的順序。在符合直覺的同時(shí),這樣的自回歸算法帶來了很好的效果:VAR 顯著提升了自回歸模型的速度和生成質(zhì)量,在多方面使得自回歸模型首次超越擴(kuò)散模型。同時(shí) VAR 展現(xiàn)出類似 LLM 的 Scaling Laws 和零樣本任務(wù)泛化能力。

論文 2:Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators

- 作者:Zekun Shi, Zheyuan Hu, Min Lin, Kenji Kawaguchi

- 機(jī)構(gòu):新加坡國立大學(xué)、 Sea AI Lab

- 論文地址:https://arxiv.org/abs/2412.00088

- 項(xiàng)目地址:https://github.com/sail-sg/stde

論文簡介:使用包含高維和高階微分算子的損失函數(shù)來優(yōu)化神經(jīng)網(wǎng)絡(luò)是非常昂貴的,因?yàn)榉聪騻鞑ブ袑?dǎo)數(shù)張量的大小按 縮放,計(jì)算圖中的計(jì)算按

縮放,計(jì)算圖中的計(jì)算按 縮放,其中,d 是域的維度,L 是前向計(jì)算圖中操作的數(shù)量,k 是導(dǎo)數(shù)的階數(shù)。

縮放,其中,d 是域的維度,L 是前向計(jì)算圖中操作的數(shù)量,k 是導(dǎo)數(shù)的階數(shù)。

在之前的研究中,d 中多項(xiàng)式縮放是通過隨機(jī)化在優(yōu)化過程中平攤計(jì)算來解決的。另外,單變量函數(shù)(d = 1)中 k 的指數(shù)縮放通過高階自動(dòng)微分(AD)解決。

本研究展示了如何通過正確構(gòu)造單變量高階 AD 輸入切線(input tangent),有效地對多元函數(shù)的任意階導(dǎo)數(shù)張量進(jìn)行任意收縮,這可用于有效地隨機(jī)化任何微分算子。

當(dāng)應(yīng)用于 PINN( Physics-Informed Neural Networks )時(shí),與使用一階 AD 進(jìn)行隨機(jī)化相比,本文方法提供了 1000 倍以上的速度提升和 30 倍以上的內(nèi)存減少,而且現(xiàn)在可以在單個(gè) NVIDIA A100 GPU 上在 8 分鐘內(nèi)解決 100 萬維 PDE。這項(xiàng)工作開啟了在大規(guī)模問題中使用高階微分算子的可能性。

最佳論文亞軍(Best Paper Runner-up)

論文 1:Not All Tokens Are What You Need for Pretraining

- 作者:Zhenghao Lin, Zhibin Gou, Yeyun Gong, Xiao Liu, yelong shen, Ruochen Xu, Chen Lin, Yujiu Yang, Jian Jiao, Nan Duan, Weizhu Chen

- 機(jī)構(gòu):廈門大學(xué)、清華大學(xué)、微軟

- 論文地址:https://openreview.net/pdf?id=0NMzBwqaAJ

- 項(xiàng)目地址:https://github.com/microsoft/rho

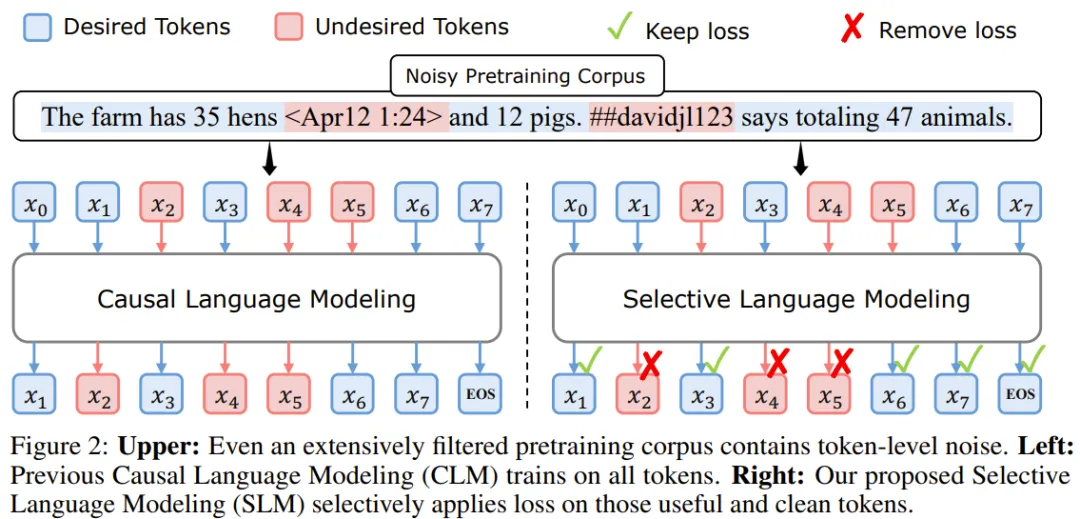

論文簡介:以前的語言模型預(yù)訓(xùn)練方法會(huì)統(tǒng)一對所有訓(xùn)練 token 應(yīng)用下一個(gè) token 預(yù)測損失。

但這一范式并非不可挑戰(zhàn)。這篇論文的作者首先做出了一個(gè)假設(shè):「對于語言模型訓(xùn)練,并非語料庫中的所有 token 都同等重要」。

然后,他們分析了語言模型的 token 級訓(xùn)練動(dòng)態(tài),結(jié)果發(fā)現(xiàn)不同 token 有著不同的損失模式。

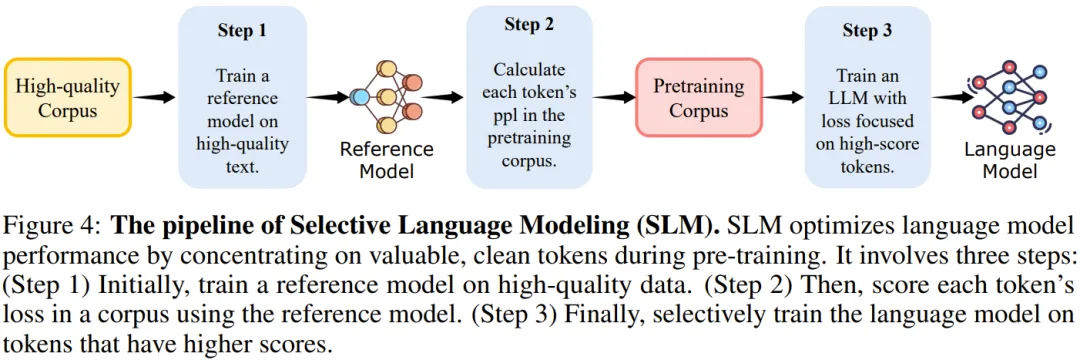

基于這些見解,他們開發(fā)了一種新模型 RHO-1。不同于傳統(tǒng)語言模型(會(huì)學(xué)習(xí)預(yù)測語料庫中的每一下個(gè) token),RHO-1 采用了選擇性語言建模(SLM),它會(huì)選擇性地使用與所需分布對齊的有用 token 進(jìn)行訓(xùn)練。

該方法需要使用一個(gè)參考模型來給 token 評分,然后再在分?jǐn)?shù)更高的 token 上使用一個(gè)重點(diǎn)關(guān)注損失(focused loss)來訓(xùn)練模型。

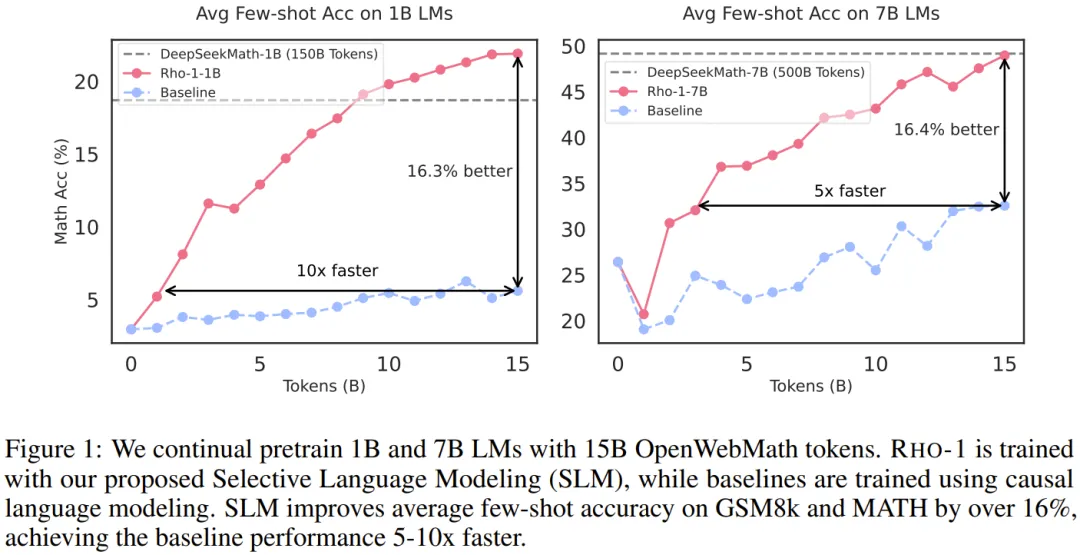

在 15B OpenWebMath 語料庫上進(jìn)行持續(xù)預(yù)訓(xùn)練時(shí),RHO-1 在 9 個(gè)數(shù)學(xué)任務(wù)上的少樣本準(zhǔn)確率實(shí)現(xiàn)了 30% 的絕對提升。經(jīng)過微調(diào)后,RHO-1-1B 和 7B 在 MATH 數(shù)據(jù)集上分別取得了 40.6% 和 51.8% 的 SOTA 結(jié)果 —— 僅用 3% 的預(yù)訓(xùn)練 token 就達(dá)到了 DeepSeekMath 相當(dāng)?shù)乃健4送猓趯?80B 個(gè)通用 token 進(jìn)行持續(xù)預(yù)訓(xùn)練時(shí),RHO-1 在 15 個(gè)不同任務(wù)上實(shí)現(xiàn)了 6.8% 的平均提升,數(shù)據(jù)效率和語言模型預(yù)訓(xùn)練的性能都得到了提升。

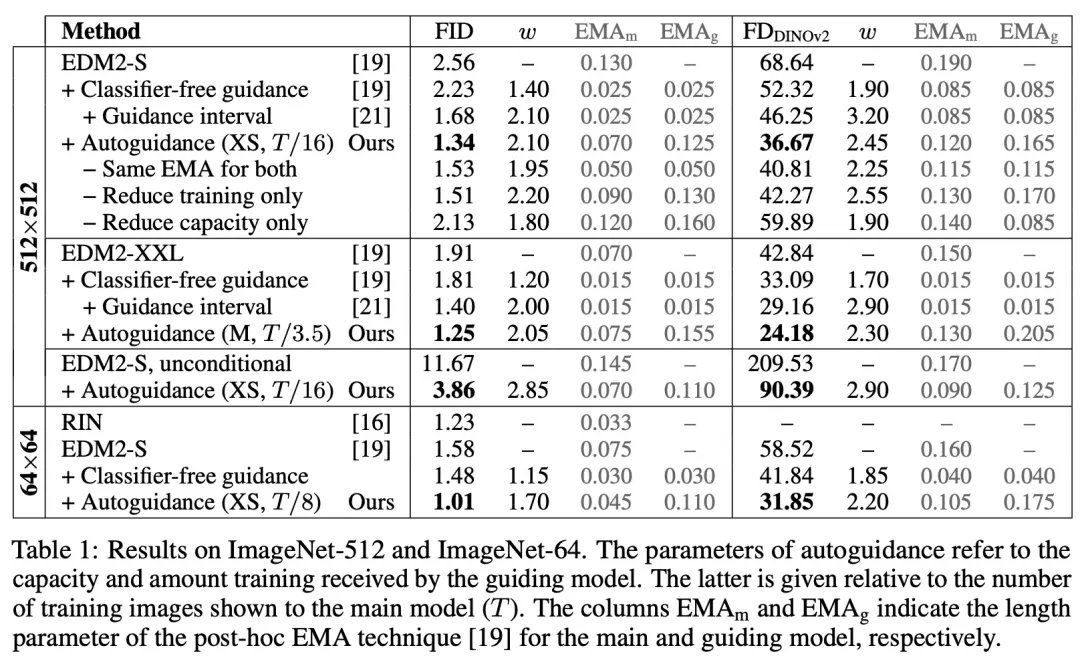

論文 2:Guiding a Diffusion Model with a Bad Version of Itself

- 作者:Tero Karras, Miika Aittala, Tuomas Kynk??nniemi, Jaakko Lehtinen, Timo Aila, Samuli Laine

- 機(jī)構(gòu):英偉達(dá)、阿爾托大學(xué)

- 論文地址:https://arxiv.org/pdf/2406.02507

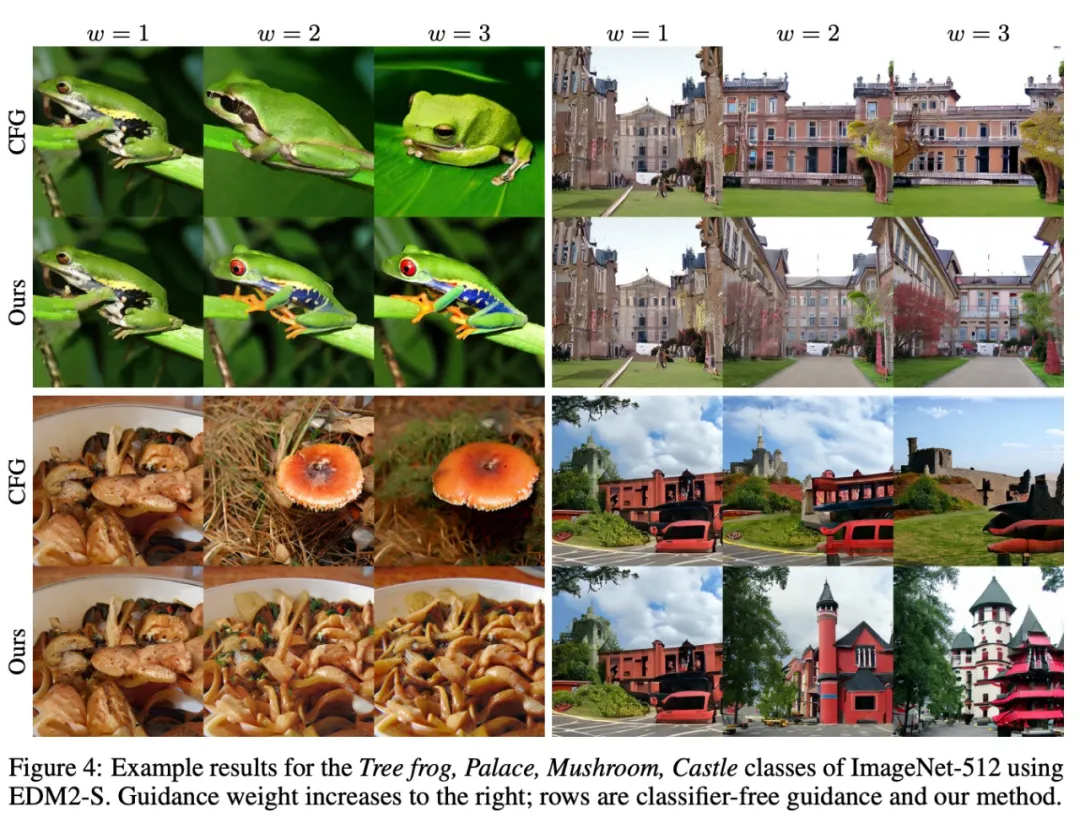

論文簡介:圖像生成擴(kuò)散模型關(guān)注的核心是圖像質(zhì)量、結(jié)果的多變程度以及結(jié)果與給定條件(例如類標(biāo)簽或文本提示)的對齊程度。

常見的無分類器引導(dǎo)方法是使用無條件模型來引導(dǎo)條件模型,這樣既能實(shí)現(xiàn)更好的提示詞對齊,也能得到更高質(zhì)量的圖像,但代價(jià)是多變程度下降。

這些效果似乎本質(zhì)上是糾纏在一起的,因此很難控制。

基于此,該團(tuán)隊(duì)得出了一個(gè)令人驚訝的觀察結(jié)果:通過使用較小、訓(xùn)練較少的模型版本(而不是無條件模型)來引導(dǎo)生成,就可以在不影響多變程度的情況下獲得對圖像質(zhì)量的控制。由此,圖像質(zhì)量與多變程度就分離了。

實(shí)驗(yàn)表明,這能顯著提升 ImageNet 生成效果。他們使用公開可用的網(wǎng)絡(luò),為 64×64 分辨率下的生成創(chuàng)造了 1.01 的 FID 記錄,為 512×512 創(chuàng)造了 1.25 的 FID 記錄。此外,該方法也適用于無條件擴(kuò)散模型,可極大提高其質(zhì)量。