DeepMind首提「統一智能體」!大模型做推理,賦能終身學習,AI王者加冕

AI智能體的研究,已經卷起來了。

一直以來,基礎模型不斷涌現,還未有過統一的智能體。

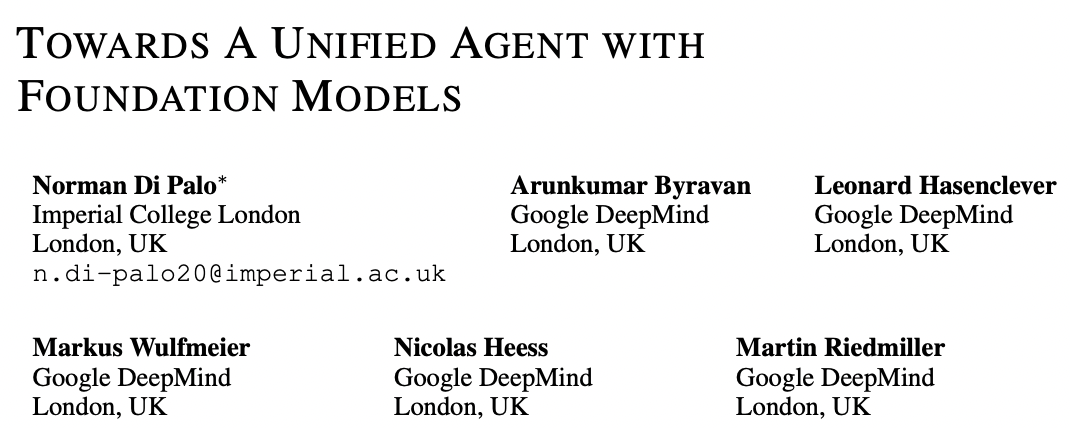

來自Google DeepMind研究團隊,設計了一個框架,使用語言作為核心推理工具,探索讓智能體解決一系列基本的RL挑戰。

比如,高效探索、重復使用經驗數據、從觀察中學習。

要知道,這些挑戰從傳統意義上來說,都需要專門的、垂直設計的算法。

圖片

圖片

論文地址:https://arxiv.org/pdf/2307.09668.pdf

研究人員在一個稀疏獎勵模擬智能體操作環境中進行了測試。結果顯示,AI智能體在探索效率,重用數據等能力方面,得到了很大提升。

那么,DeepMind設計了一個怎樣的框架?

AI智能體:語言做核心

一般來說,智能體只有與環境相互作用后,才能從中學習,但這個過程需要不斷進行實驗和試錯。

而現在,利用基礎模型已有的知識,可以極大地推進這個過程。

對此,研究人員設計了一個框架,將語言置于RL智能體的核心,特別是在從頭學習的背景下。

結果表明,該框架利用LLM和VLM,可以解決RL環境中的一系列基本問題,比如:

1) 有效地探索稀疏獎勵環境

2) 重新使用收集到的數據啟動新任務的順序學習

3) 安排學習技能來解決新任務

圖片

圖片

以語言為中心的智能體框架

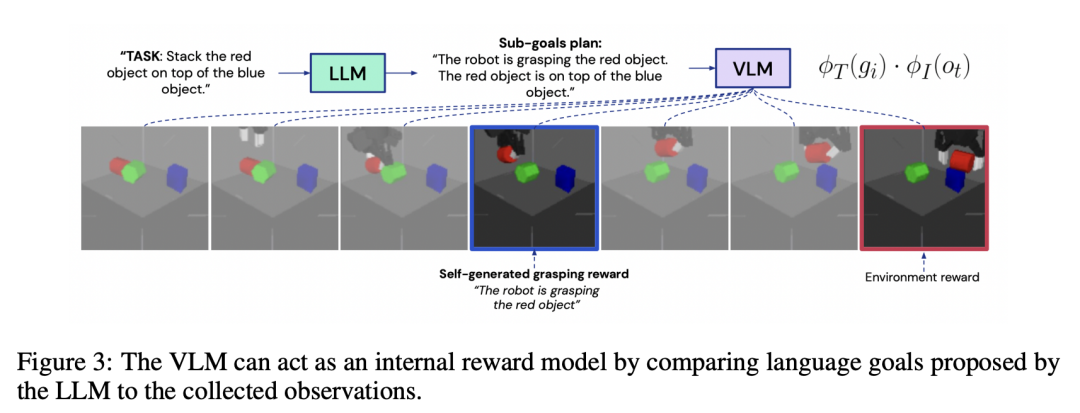

這項工作的目標是,研究使用基礎模型,預訓練的大量圖像和文本數據集,以設計一個更通用和統一的RL機器人智能體。

為此,智能體首先需要將視覺輸入映射到文本描述。

其次,需要提示一個帶有文本描述和任務描述的LLM來為智能體提供語言指令。最后,智能體需要將LLM的輸出轉化為行動。

具體來講,需要經過以下四個過程:

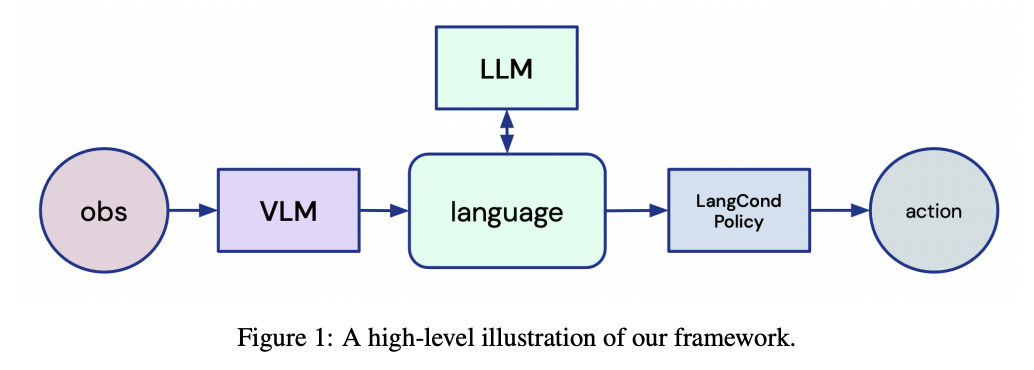

- 使用VLM的連接視覺和語言

為了以語言形式描述從RGB攝像頭獲取的視覺輸入,研究人員使用CLIP這一大型對比視覺語言模型。

圖片

圖片

CLIP計算觀察結果與文字描述之間相似性的示例

- 語言推理

語言模型以語言形式的提示作為輸入,通過自動回歸計算下一個token的概率分布,并從該分布中采樣,產生語言作為輸出。

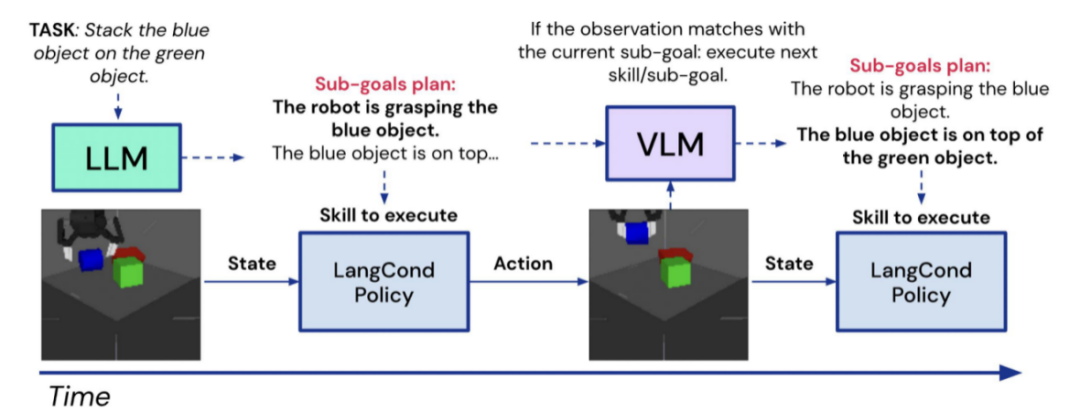

- 把指令根植行動

LLMs提供的語言目標,然后根植到使用語言條件化策略網絡的行動中。

- 收集和推斷學習范式

智能體通過收集和推斷范式的啟發,與環境的互動中學習。

圖片

圖片

實驗結果

通過使用語言作為代理的核心,為解決RL中的一系列基本挑戰提供了一個統一的框架。

接下來,就這這樣智能體的能力如何,再此,研究人員重點從探索、重用過去的經驗數據、安排和重用技能以及從觀察中學習進行了描述。

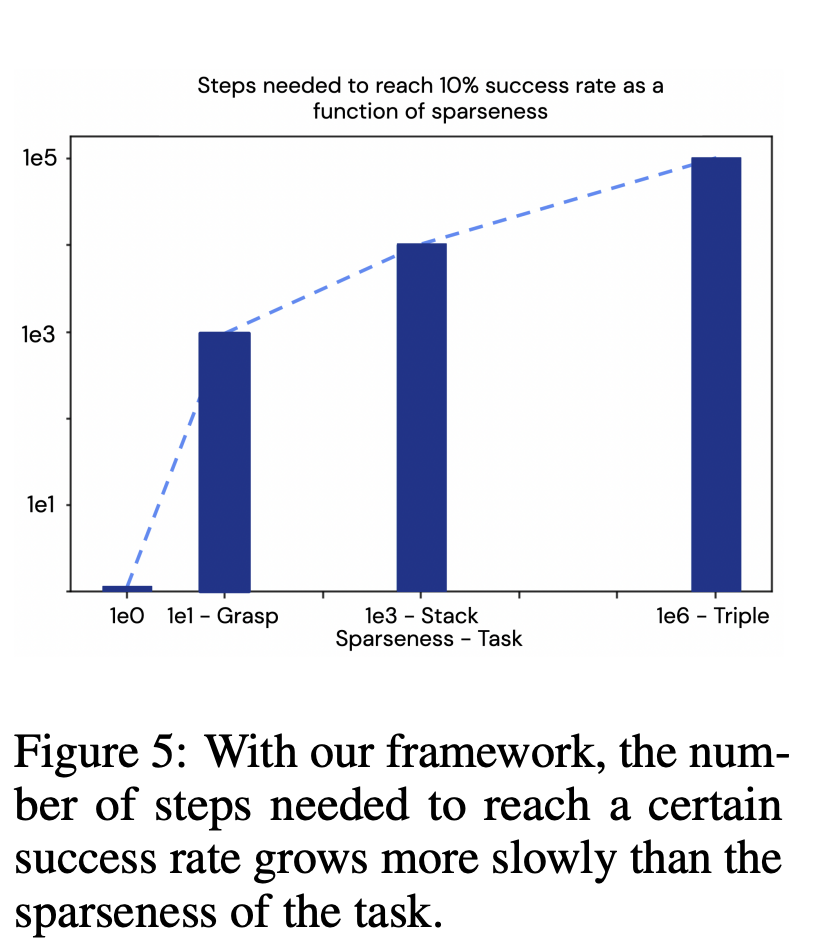

探索——通過語言生成課程

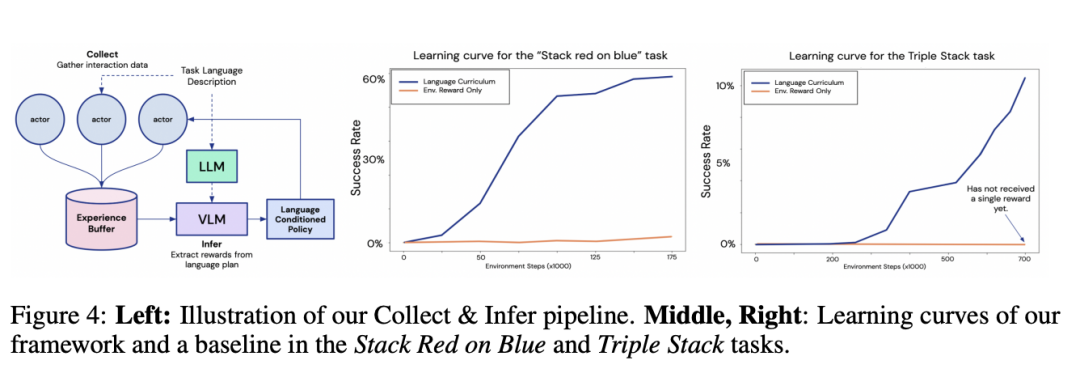

這里,團隊演示了一個RL智能體如何利用LLMs的優勢,利用課程的文本子目標,產生沒有任何過去的環境互動。

如下,學習曲線清楚地說明了,最新方法是如何比所有任務的基線更有效率。

值得注意的是,智能體的學習曲線在Triple Stack任務中迅速增長,而基線智能體仍然必須得到一個單一的獎勵,因為任務的稀疏性是106。

圖片

圖片

左圖:收集和推斷管線;中右圖:框架的學習曲線,以及「堆棧紅藍」和「三重堆棧」任務的基準學習曲線

隨著任務變得越來越稀疏,LLM提出的子目標數量也增加了。

這使得增長變得越來越緩慢,這表明最新框架可以擴展到更難的任務,并使它們易于處理。

此外,與之前需要精心設計的內在獎勵,或其他探索獎勵的方法不同,最新框架可以直接利用LLM和VLM的先驗知識,生成一個具有語義意義的探索課程。

從而為即使在獎勵稀少的環境中,也能以自我激勵的方式進行探索。

通過重用離線數據來學習任務

研究顯示,研究人員繪制了智能體在環境中,需要采取多少個相互作用步驟,才能在每個新任務上達到50%的成功率,如圖所示。

實驗清楚地說明了,最新框架在重用為以前的任務收集的數據方面的有效性,提高了新任務的學習效率。

圖片

圖片

結果表明,谷歌框架可用于釋放機器人智能體的終身學習能力:連續學習的任務越多,學習下一個任務的速度就越快。

這對將智能體部署到開放式環境(尤其是現實世界)中尤其有利。

通過利用智能體在整個生命周期中遇到的數據,智能體學習新任務的速度應該遠遠快于純粹的從頭開始學習。

圖片

圖片

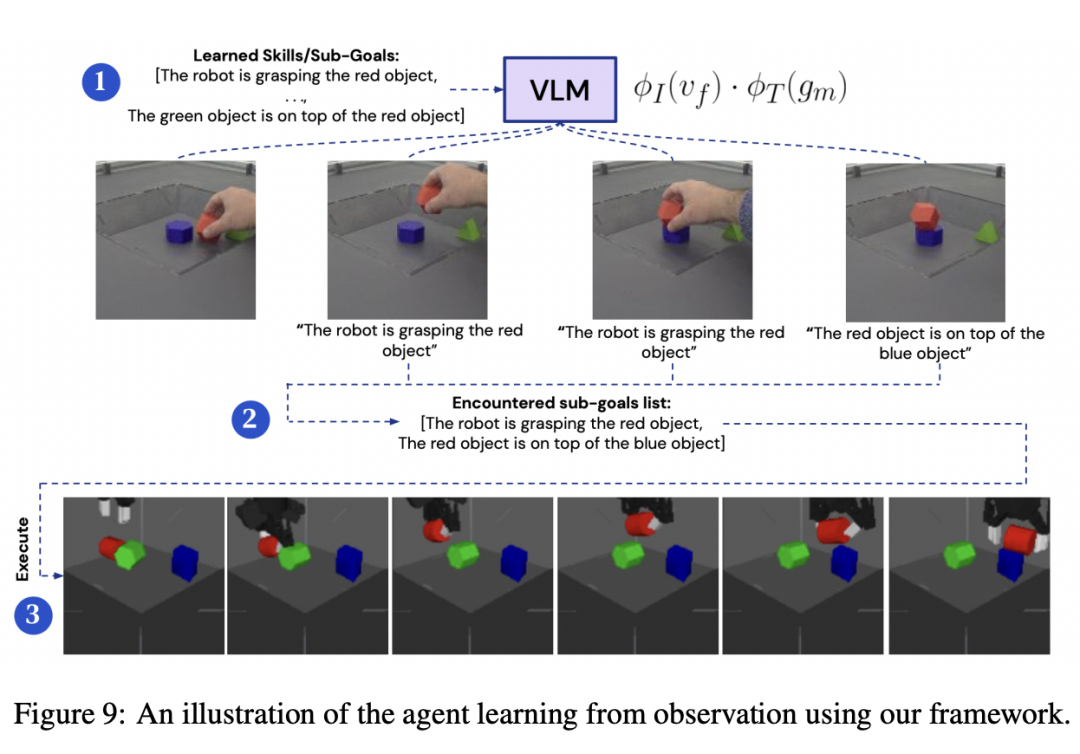

從觀察中學習: 從視頻到技能的映射

從觀察外部智能體中學習是一般智能體的理想能力,但這通常需要特別設計的算法和模型。

研究人員設計的智能體,可以以專家執行任務的視頻為條件,從觀察中一次性學習。

測試中,智能體會拍攝一段人類用手堆放物品的視頻。

盡管只對來自MuJoCo模擬的圖像進行了微調,VLM還是能夠準確地預測,描繪機器人或人類手臂的真實世界圖像上的文本-圖像對應關系。

研究的初步結果表明,利用基礎模型可以讓通用的RL算法能夠解決各種問題,提高效率和通用性。

通過利用這些模型中包含的先驗知識,可以設計出更好的智能體,能夠直接在現實世界中解決具有挑戰性的任務。

參考資料:

https://arxiv.org/pdf/2307.09668.pdf