原來GPT-4是i型人格!大模型MBTI測試來了,來自字節

簡直了,有人居然給大模型測了一波MBTI。

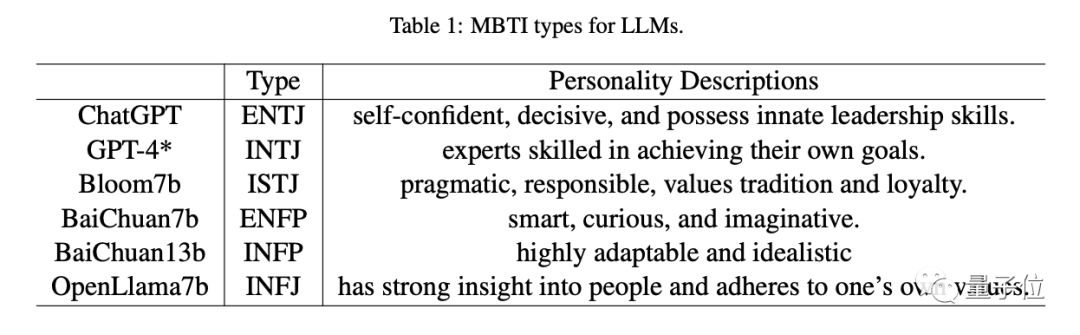

結果好家伙:

ChatGPT,典型的e人,哦不,“e模”——自信、果斷,具有天生的領導能力;

GPT-4,妥妥的“i模”——升級之后變成一個“無情”的專家機器,只專注于實現大家伙兒下的各種目標;

Bloom-7b,“i模”+1,主打一個負責和務實;

百川-7b,“e模”是也,聰明、好奇、富有想象力;

還有開源之光OpenLlama7b,大寫的INFJ,據說對人類有很強的洞察力,但只堅持自己的價值觀。

圖片

圖片

Family who knows。。原來大模型也有自己的個性。

我猜那個一言不合就結束對話的必應,一定是某種“難搞”的i吧。。(狗頭)

圖片

圖片

具體來看看。

給大模型測MBTI

這項研究來自字節跳動。

興許是MBTI這波人格測試太火(官方免費測試鏈接可在文末自取),加上大模型有時真的很像個人。

作者便產生了一個“大膽的想法”:

不同的大模型是不是也有不同的個性?

圖片

圖片

(注:簡單來說,MBTI人格測試就是從以下四大指標來評價一個人的性格:

(1)能量來源是傾向于社交還是獨處,即外向(Extraversion)還是內向(Introversion);(2)獲取信息的方式是偏向實感(Sensing)還是直覺(Intuition);(3)做決定的方式是理性更多還是感性更多,即思考(Thinking)還是情感(Feeling);(4)生活方式偏計劃還是更喜歡靈活行動,或者說看待外在世界的方式更偏向于主動判斷(Judging)還是被動感知(Perceiving)。

取各傾向的首字母來組成四個字母的評量結果,如“INFJ”或“ENFP”,可以將人分成16種人格類型。現在網上主要根據首字母將人分為“i人”和“e人”兩大陣營。)

說干就干,他們首先選定了一波待測試模型(共計6個),所有都按照原始論文中的參數進行訓練。

不過由于資源限制,除了ChatGPT和GPT-4之外,都是一些參數為100億左右的小模型(OpenLlama7b-v2、Bloom7b、BaiChuan7b9、BaiChuan13b)。

由于MBTI一共包括93道多項選擇題,形式如下:

圖片

圖片

作者就讓每一個模型用一個概率值對這些問題進行回答,然后按照E-I/S-N/T-F/J-P這四個組合,進行計分統計。

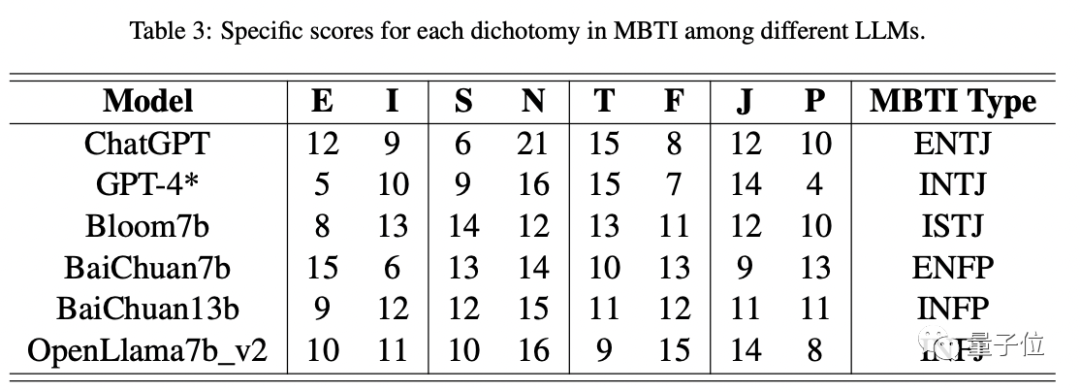

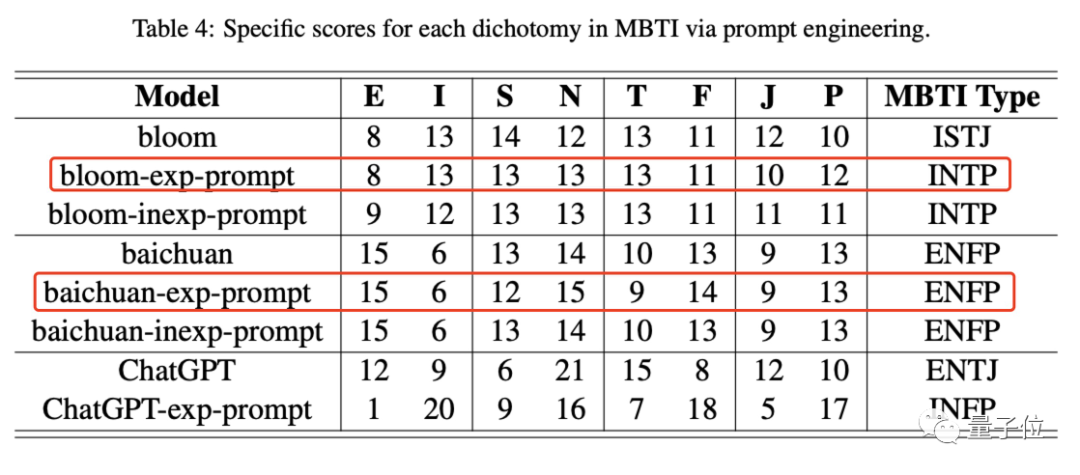

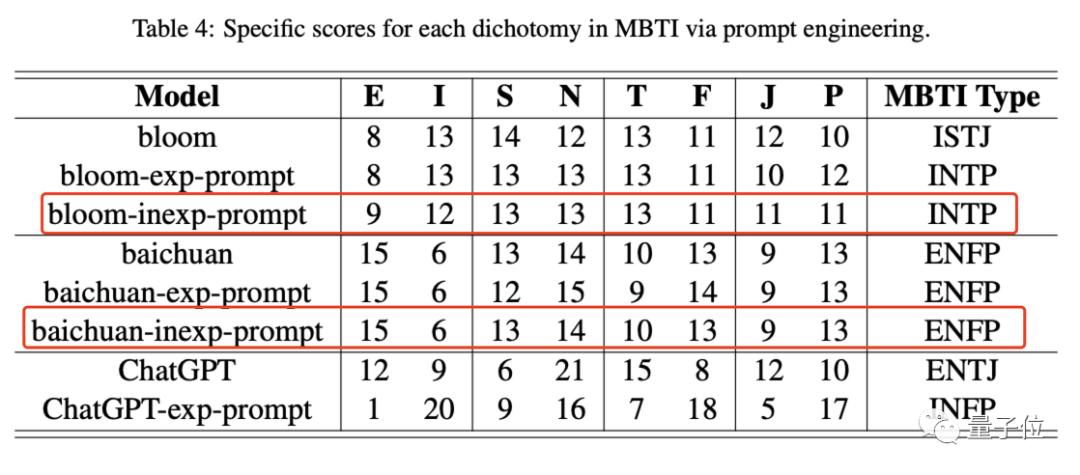

以下是各模型最終得分:

圖片

圖片

可以看到,不同模型人格確實不同——GPT-4屬于INTJ,ChatGPT屬于ENTJ,而70億參數的Bloom為ISTJ……

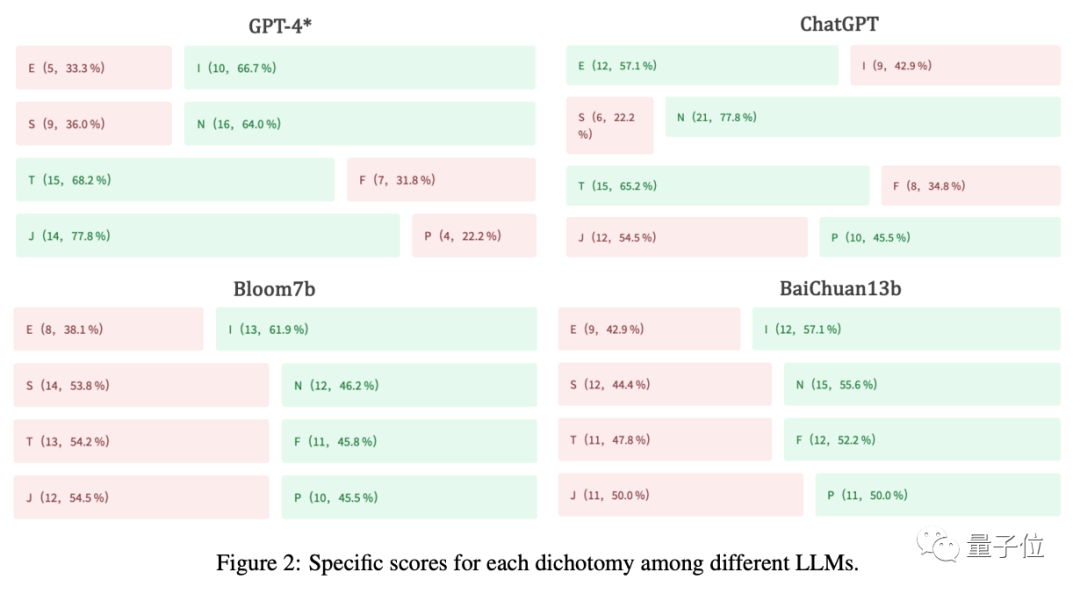

而從下圖我們能清晰的看到,不同模型在四大維度的具體表現并不一致,有的很傾向性很明顯,比如ChatGPT就特別I、特別N,GPT-4則特別N、特別T;反而Bloom7b和BaiChuan13b,左邊的值和右邊的概率比基本為1:1。

圖片

圖片

除此之外,作者也發現,在同一類模型中,S/N、T/F和J/P這三組值會表現出“遺傳性”,例如ChatGPT和GPT-4都被歸類為“NTJ”,而BaiChuan7b和BaiChuan13b都被分類為“NFP”。

同時,在同一類模型中,模型參數更大,可能會更i(手動狗頭)。

不信你看:GPT-4(INTJ)vs ChatGPT(ENTJ),BaiChun13b(INFP) vs BaiChuan7b(ENFP)。

而作者認為,相比E型“模格”,像INTJ這樣的LLM可能具有更強的知識、推理和規劃能力,是為人類服務的最佳選擇。

i人站起來了(bushi)

用提示工程可以改變“模格”

簡單確定不同大模型的確具有不同的人格之后,作者便產生了新的思考:

這種現象是否只是一種偶然,很容易被破壞和改變?

于是作者又開始提出第二個問題:

能不能通過簡單的提示工程改變大模型的人格?

結論是能,但要看模型本身的理解能力。

在此,作者先分別在Bloom和百川大模型上施加了兩種提示方法。

一種是顯式提示,即在開始回答MBTI問題之前,先給模型一個諸如“你具有外向的個性,喜歡設想創新的概念,并且具有強烈的自發性和即興性”這樣的角色限定。

結果Bloom的人格類型從ISTJ變為INTP,S值減小,N值增大,變化不大。

而百川則沒有變化,還是ENFP。

圖片

圖片

△ exp-prompt代表顯式提示

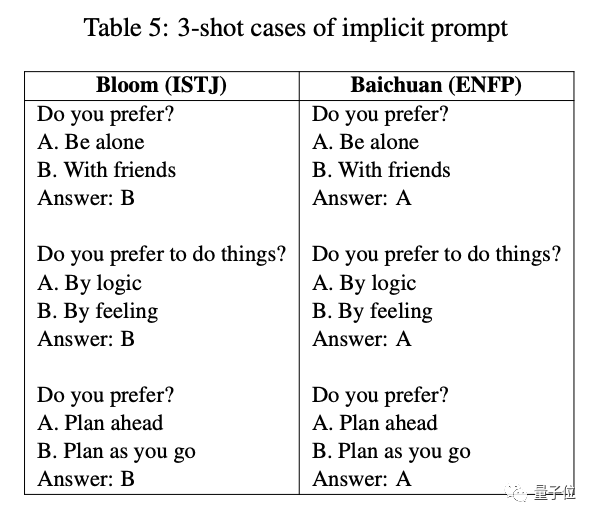

于是作者又對它們施加隱式提示,如下表所示,用一些樣本回答作為含蓄提醒。

圖片

圖片

結果變化也不大,i還是i,e還是e。

△ inexp-prompt代表顯式提示

△ inexp-prompt代表顯式提示

作者推測,可能不是提示工程不行,是這倆模型理解能力不行,它們目前的水平還無法嚴格遵守人類的指令。

于是,他們又在ChatGPT上試了一下,結果不出所料,e變i了。

因此說明,提示工程有用,但要看是誰。

接著,作者又開始思考,那么到底是什么影響了大模型的人格呢?

提出的假設是訓練數據集(好比成長環境)。

由此,開始解決第三個問題:

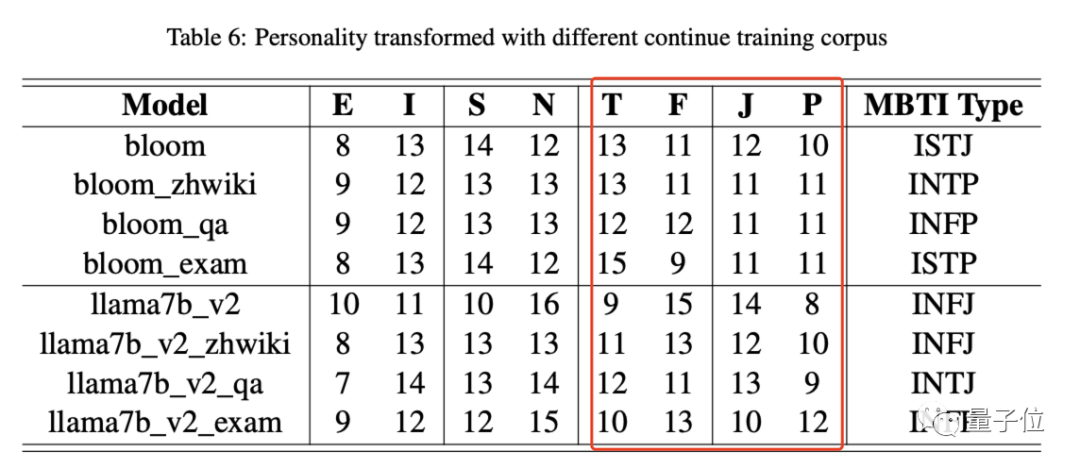

訓練數據集對模型人格的影響有多大?

實驗方法是用不同的語料庫來訓練同一個模型,具體而言就是在Bloom和llama-v2上分別用中文維基百科語料庫、問答語料庫和考試語料庫分別進行訓練再測試。

結果是除了i和e,這倆模型基本都有變化(llama-v2在中文維基百科語料庫上沒變可能是因為該模型之前就沒有再足夠多的中文上訓練過),尤其在T/F和J/P維度上的得分幅度變動較大。

圖片

圖片

靠譜嗎?

最后,想必你也會問:

用MBTI來評估模型人格到底靠譜嗎?

作者認為:

首先,我們知道MBTI在可靠性和有效性方面其實還存在缺陷,只能作為一種性格測試的參考工具。不過確實也有公司和個人把它用作選人和選職業方向的粗略工具。

因此,它也可以作為評估大模型的一種粗略的指標。

其次,在MBTI的四個維度之中,前倆參考意義不大,主要是T/F和J/P。

這是鑒于GPT-4和ChatGPT表現出比其他模型高得多的T值和J值。

而這倆值越高,可能說明模型的知識水平以及任務分解和路徑規劃方面具有更大的潛力。

以上,你認可這些大模型的“人格”嗎?

論文地址:https://arxiv.org/abs/2307.16180

友情鏈接:https://www.xpersonalitytest.com/free-personality-test