直接壓縮一切!OpenAI首席科學(xué)家Ilya Sutskever這么看無(wú)監(jiān)督學(xué)習(xí)

近日,OpenAI 首席科學(xué)家 Ilya Sutskever 在專(zhuān)注于計(jì)算理論研究的 Simons Institute 作了一次講座,一句話總結(jié)就是我們可以通過(guò)壓縮的視角來(lái)看待無(wú)監(jiān)督學(xué)習(xí)。此外他還分享了不少其它有趣的見(jiàn)解。機(jī)器之心整理了該演講的大體內(nèi)容,希望借此幫助讀者更深入地理解無(wú)監(jiān)督學(xué)習(xí)。

Sutskever 首先談到了自己的研究方向的變化,他說(shuō):「不久前,我將全部的研究重心都轉(zhuǎn)移到了 AI 對(duì)齊研究上。」這說(shuō)的是 OpenAI 前段時(shí)間成立的「Superalignment(超級(jí)對(duì)齊)」團(tuán)隊(duì),由他與 Jan Leike 共同領(lǐng)導(dǎo)。Sutskever 表示他們已經(jīng)在 AI 對(duì)齊方面取得了一些研究成果,但這并非這次演講關(guān)注的話題。對(duì)此感興趣的讀者可參閱《用 AI 對(duì)齊 AI?超級(jí)對(duì)齊團(tuán)隊(duì)領(lǐng)導(dǎo)人詳解 OpenAI 對(duì)齊超級(jí)智能四年計(jì)劃》。

這次演講的主題為「An observation on Generalization(對(duì)泛化的一種觀察)」,而 Ilya Sutskever 具體談?wù)摰闹攸c(diǎn)是一種解釋無(wú)監(jiān)督學(xué)習(xí)的理論。

首先,Ilya Sutskever 提出了一連串有關(guān)「學(xué)習(xí)」的廣義問(wèn)題:學(xué)習(xí)究竟是什么?為什么學(xué)習(xí)有用?為什么學(xué)習(xí)應(yīng)該有用?計(jì)算機(jī)為什么應(yīng)該具備學(xué)習(xí)能力?為什么神經(jīng)網(wǎng)絡(luò)可以學(xué)習(xí)?為什么機(jī)器學(xué)習(xí)模型可以學(xué)習(xí)到數(shù)據(jù)的規(guī)律?我們能否用數(shù)學(xué)形式來(lái)描述學(xué)習(xí)?

監(jiān)督學(xué)習(xí)

Sutskever 先從監(jiān)督學(xué)習(xí)談起。他表示,監(jiān)督學(xué)習(xí)方面已經(jīng)有了重要的形式化工作,這是多位研究者在多年前得到的成果;這些成果通常被稱(chēng)為統(tǒng)計(jì)學(xué)習(xí)理論。

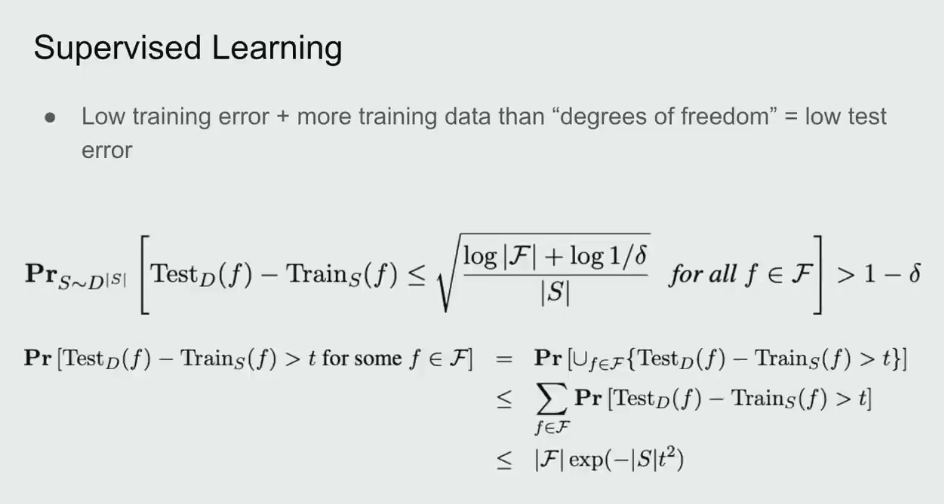

監(jiān)督學(xué)習(xí)的優(yōu)勢(shì)在于能提供一個(gè)學(xué)習(xí)必定成功的精確數(shù)學(xué)條件。也就是說(shuō),如果你有一些來(lái)自某數(shù)據(jù)分布的數(shù)據(jù),然后你能成功實(shí)現(xiàn)較低的訓(xùn)練損失并且你的訓(xùn)練數(shù)據(jù)足夠多(多于數(shù)據(jù)分布的自由度),那么你的測(cè)試誤差必定很低。

從數(shù)學(xué)上講,如果能在一類(lèi)函數(shù)中找到能實(shí)現(xiàn)較低訓(xùn)練損失的函數(shù),那么學(xué)習(xí)就必定成功。也因此,監(jiān)督學(xué)習(xí)非常簡(jiǎn)單。

研究者在相關(guān)研究中已經(jīng)發(fā)現(xiàn)了一些定理,如下便是一例。Sutskever 表示解釋這個(gè)定理大概需要五分鐘,但很顯然他的演講時(shí)間有限。

總而言之,這個(gè)定理很「優(yōu)雅」,只用三行數(shù)學(xué)推導(dǎo)便能證明監(jiān)督學(xué)習(xí)過(guò)程。

所以相對(duì)而言,監(jiān)督學(xué)習(xí)已經(jīng)得到很好的理解。我們知道其必定會(huì)成功的原因 —— 只要我們能收集到大規(guī)模的監(jiān)督學(xué)習(xí)數(shù)據(jù)集,那么就完全可以相信模型必定越來(lái)越好。當(dāng)然另一點(diǎn)也很重要,也就是保證測(cè)試分布和訓(xùn)練分布一致;只有這樣,監(jiān)督學(xué)習(xí)理論才是有效的。

所以監(jiān)督學(xué)習(xí)的概念是很簡(jiǎn)單的。我們也已經(jīng)有了監(jiān)督學(xué)習(xí)為什么有效的答案 —— 我們知道語(yǔ)音識(shí)別和圖像分類(lèi)為什么可以實(shí)現(xiàn),因?yàn)樗鼈兌蓟谟行矣袛?shù)學(xué)保證的監(jiān)督學(xué)習(xí)。

這里 Ilya Sutskever 順帶提了提 VC 維度。他提到很多統(tǒng)計(jì)學(xué)習(xí)理論的研究者都認(rèn)為 VC 維度是一大關(guān)鍵組件,但 VC 維度被發(fā)明出來(lái)的目的是為了讓模型有能力處理有無(wú)限精度的參數(shù)。

舉個(gè)例子,如果你的線性分類(lèi)器的每個(gè)參數(shù)都有無(wú)限精度,而現(xiàn)實(shí)中的浮點(diǎn)數(shù)的精度都是有限的,而且精度會(huì)收縮,那么你可以通過(guò) VC 維度實(shí)現(xiàn)一些函數(shù),將這個(gè)線性分類(lèi)器歸約成前面公式描述的監(jiān)督學(xué)習(xí)形式。

無(wú)監(jiān)督學(xué)習(xí)是什么?

接下來(lái)看無(wú)監(jiān)督學(xué)習(xí)。首先什么是無(wú)監(jiān)督學(xué)習(xí)?Ilya Sutskever 表示他目前還沒(méi)看到令人滿意的對(duì)無(wú)監(jiān)督學(xué)習(xí)的闡釋?zhuān)覀円膊恢廊绾螐臄?shù)學(xué)上推理它 —— 最多只能在直覺(jué)上做點(diǎn)推斷。

無(wú)監(jiān)督學(xué)習(xí)是機(jī)器學(xué)習(xí)領(lǐng)域長(zhǎng)久以來(lái)的夢(mèng)想。Sutskever 認(rèn)為這個(gè)目標(biāo)已經(jīng)在實(shí)驗(yàn)研究中達(dá)成,即模型在不被告知數(shù)據(jù)內(nèi)容的前提下觀察數(shù)據(jù)并發(fā)現(xiàn)其中存在的真實(shí)有用的隱藏結(jié)構(gòu)。

這是怎么發(fā)生的?我們能確保這一定會(huì)發(fā)生嗎?Sutskever 表示我們不能,畢竟我們?cè)跓o(wú)監(jiān)督學(xué)習(xí)方面沒(méi)有在監(jiān)督學(xué)習(xí)方面那樣的理論保證。

人們?cè)缭谏鲜兰o(jì) 80 年代就在探究無(wú)監(jiān)督學(xué)習(xí)了,當(dāng)時(shí)使用的術(shù)語(yǔ)也是類(lèi)似。在實(shí)驗(yàn)中,人們觀察到,當(dāng)數(shù)據(jù)量較小時(shí),不會(huì)出現(xiàn)無(wú)監(jiān)督學(xué)習(xí)現(xiàn)象,但是一些現(xiàn)在流行的開(kāi)發(fā)思路已經(jīng)出現(xiàn)了,比如 BERT、擴(kuò)散模型、老式的語(yǔ)言模型等。當(dāng)時(shí)的無(wú)監(jiān)督學(xué)習(xí)也能生成一些很酷的樣本,但當(dāng)然是比不上現(xiàn)在的技術(shù)。

但因?yàn)槲覀儾恢罒o(wú)監(jiān)督學(xué)習(xí)的工作方式,所以它一直都讓人困惑。

比如當(dāng)你針對(duì)某個(gè)目標(biāo)(比如圖像重建或預(yù)測(cè)下一個(gè)詞)進(jìn)行優(yōu)化時(shí),你可能也在意另一個(gè)目標(biāo)(比如圖像分類(lèi)或文檔分類(lèi)),而模型可能在這個(gè)未經(jīng)優(yōu)化的目標(biāo)上也能取得不錯(cuò)的表現(xiàn)。但為什么會(huì)這樣呢?不知道,實(shí)驗(yàn)結(jié)果就是如此。Sutskever 說(shuō)這就像是魔法。

難道我們就要放棄理論,在實(shí)證主義上一路走下去嗎?

我們知道無(wú)監(jiān)督學(xué)習(xí)是學(xué)習(xí)輸入分布中的結(jié)構(gòu),然后從中獲得有助于實(shí)現(xiàn)目標(biāo)的東西。但如果輸入分布是均勻分布(uniform distribution)呢?這時(shí)候各種無(wú)監(jiān)督學(xué)習(xí)算法都會(huì)失效。我們應(yīng)該怎么看待這種現(xiàn)象呢?Sutskever 表示我們需要做些假設(shè)。

一種無(wú)監(jiān)督學(xué)習(xí)方法:分布匹配

接下來(lái),Sutskever 展示了一種思考無(wú)監(jiān)督學(xué)習(xí)的潛在方式。他說(shuō)這種無(wú)監(jiān)督學(xué)習(xí)方式一直沒(méi)有成為主流,但卻非常有趣。它有與監(jiān)督學(xué)習(xí)類(lèi)似的特征,也就是必然有效。為什么會(huì)這樣?這涉及到一種名為分布匹配(distribution matching)的無(wú)監(jiān)督學(xué)習(xí)流程。

接下來(lái)簡(jiǎn)單說(shuō)明一下。假設(shè)有兩個(gè)數(shù)據(jù)源 X 和 Y,它們之間并無(wú)對(duì)應(yīng)關(guān)系;模型的目標(biāo)是找到函數(shù) F,使得 F (X) 的分布與 Y 的分布近似 —— 這是對(duì) F 的約束(constraint)。

對(duì)于機(jī)器翻譯和語(yǔ)音識(shí)別等許多應(yīng)用場(chǎng)景,這個(gè)約束可能是有意義的。舉個(gè)例子,如果有一個(gè)英語(yǔ)句子的分布,使用函數(shù) F 后,可以得到接近法語(yǔ)句子分布的分布,那么就可以說(shuō)我們得到了 F 的真實(shí)約束。

如果 X 和 Y 的維度都足夠高,那么 F 可能就有大量約束。事實(shí)上,你甚至有可能從那些約束中恢復(fù)完整的 F。這是無(wú)監(jiān)督學(xué)習(xí)的監(jiān)督學(xué)習(xí)(supervised learning of unsupervised learning)的一個(gè)示例,它必定有效,就像監(jiān)督學(xué)習(xí)必定有效一樣。

此外,替代密碼(subsitution cipher)也符合這一框架。

Sutskever 表示自己在 2015 年時(shí)獨(dú)立發(fā)現(xiàn)了這一現(xiàn)象。這讓他不禁思考:也許我們能用某種有意義的數(shù)學(xué)形式來(lái)描述無(wú)監(jiān)督學(xué)習(xí)。

當(dāng)然,上面描述的機(jī)器翻譯場(chǎng)景是簡(jiǎn)化過(guò)的人工場(chǎng)景,并不符合真實(shí)的應(yīng)用情況,對(duì)應(yīng)的無(wú)監(jiān)督學(xué)習(xí)場(chǎng)景自然也是如此。

接下來(lái),Sutskever 將闡述他提出的方法 —— 其能從數(shù)學(xué)上為無(wú)監(jiān)督學(xué)習(xí)提供說(shuō)明以及確保無(wú)監(jiān)督學(xué)習(xí)的結(jié)果優(yōu)良。

眾所周知,壓縮就是一種預(yù)測(cè),每個(gè)壓縮器都可以轉(zhuǎn)換為一個(gè)預(yù)測(cè)器,反之亦然。全體壓縮器與全體預(yù)測(cè)器之間存在一一對(duì)應(yīng)關(guān)系。

Sutskever 指出,為了能更清晰地說(shuō)明對(duì)無(wú)監(jiān)督學(xué)習(xí)的思考,使用壓縮方面的論述方式更具優(yōu)勢(shì)。

基于此,他給出了一個(gè)思想實(shí)驗(yàn)。

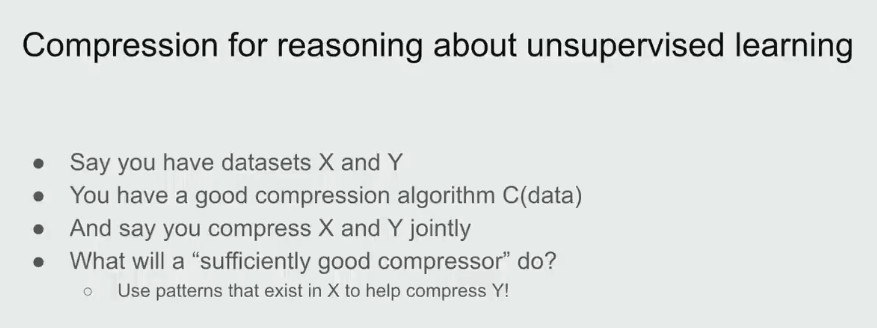

假設(shè)你有兩個(gè)數(shù)據(jù)集 X 和 Y,它們是你的硬盤(pán)上的兩個(gè)文件;然后你有一個(gè)很棒的壓縮算法 C。再假設(shè)你對(duì) X 和 Y 進(jìn)行聯(lián)合壓縮,也就是先將它們連接起來(lái),然后將其饋送給壓縮器。

現(xiàn)在的重要問(wèn)題是:一個(gè)足夠好的壓縮器會(huì)做什么?

Sutskever 給出了一個(gè)非常直覺(jué)式的答案:壓縮器會(huì)使用 X 中存在的模式來(lái)幫助壓縮 Y;反之亦然。

他表示,預(yù)測(cè)任務(wù)場(chǎng)景其實(shí)也存在類(lèi)似的現(xiàn)象,但在壓縮語(yǔ)境中說(shuō)起來(lái)似乎就更直觀一點(diǎn)。

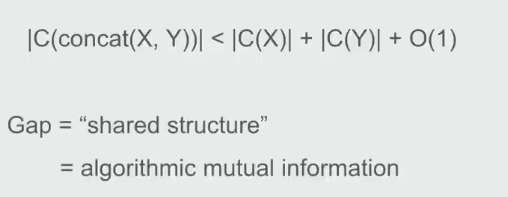

如果你的壓縮器足夠好,那么對(duì)連接后文件的壓縮結(jié)果應(yīng)該不會(huì)差于分開(kāi)壓縮的結(jié)果。

因此,通過(guò)連接所獲得的進(jìn)一步壓縮效果是你的壓縮器注意到的某種共有的結(jié)構(gòu)。壓縮器越好,其能提取出的共有結(jié)構(gòu)就越多。

兩種壓縮結(jié)果之間的差就是共有結(jié)構(gòu),即算法互信息(algorithmic mutual information)。

對(duì)應(yīng)地,可以把 Y 視為監(jiān)督任務(wù)的數(shù)據(jù),X 視為無(wú)監(jiān)督任務(wù)的數(shù)據(jù),而你對(duì)這些信息有某種形式的數(shù)學(xué)推理 —— 可以使用 X 中的模式來(lái)幫助 Y 任務(wù)。

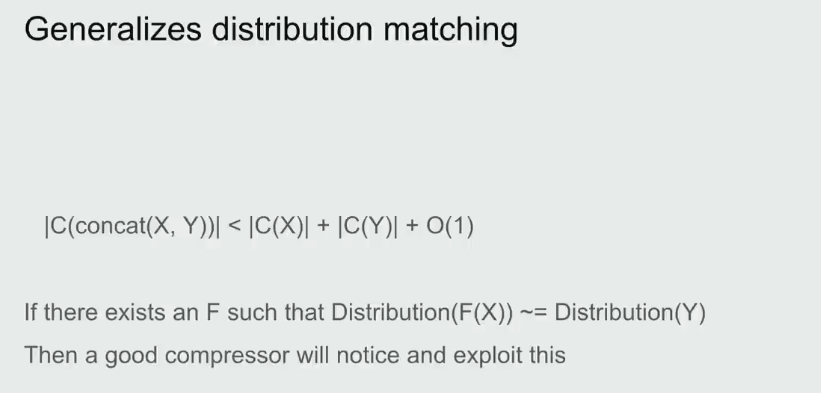

也要注意其如何實(shí)現(xiàn)了對(duì)分布匹配的泛化。如果是在分布匹配情況下,假如 X 是語(yǔ)言 1,Y 是語(yǔ)言 2,并且存在某個(gè)簡(jiǎn)單函數(shù) F 可從一個(gè)分布轉(zhuǎn)換到另一個(gè)分布;那么優(yōu)良的壓縮器也能注意到這一點(diǎn)并將其利用起來(lái),甚至可能在內(nèi)部恢復(fù)出該函數(shù)。

這樣一來(lái),閉環(huán)就形成了。那么我們?nèi)绾斡脭?shù)學(xué)形式描述無(wú)監(jiān)督學(xué)習(xí)呢?

無(wú)監(jiān)督學(xué)習(xí)的數(shù)學(xué)形式化

注意這一部分的描述會(huì)交替使用壓縮場(chǎng)景和預(yù)測(cè)場(chǎng)景的描述。

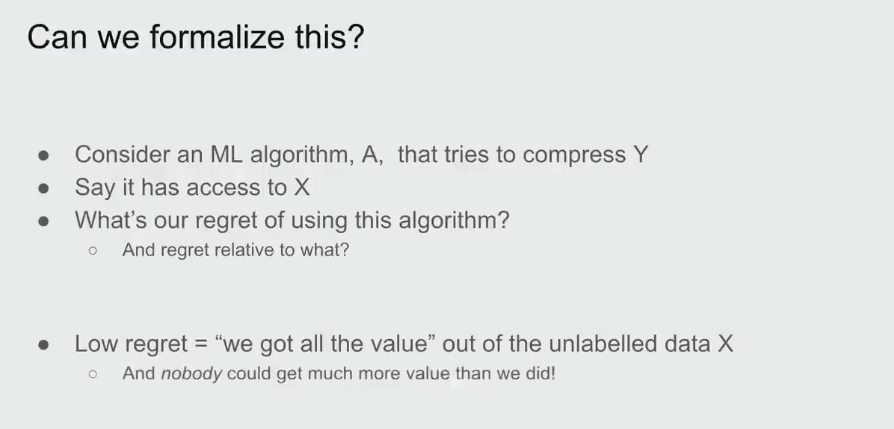

首先假設(shè)我們有一個(gè)機(jī)器學(xué)習(xí)算法 A,其作用是壓縮 Y。算法 A 能夠訪問(wèn) X。令 X 為 1 號(hào)文件,Y 為 2 號(hào)文件。我們希望我們的機(jī)器學(xué)習(xí)算法 / 壓縮器能對(duì) Y 進(jìn)行壓縮并且其能在合適的時(shí)候使用 X。目標(biāo)是盡可能地壓縮 Y。

那么我們要問(wèn)自己:使用這個(gè)算法最大的遺憾(regret)是什么?

Sutskever 解釋說(shuō):「如果我很好地完成了工作并且我的遺憾很低,就意味著我已經(jīng)從這未標(biāo)注的數(shù)據(jù)中獲得了所有盡可能的幫助。這些未標(biāo)注數(shù)據(jù)已經(jīng)盡可能地幫助了我。我對(duì)此毫無(wú)遺憾。」也就是說(shuō)已經(jīng)沒(méi)有更好的預(yù)測(cè)值可供更好的壓縮算法使用了。「我已經(jīng)從我的未標(biāo)注數(shù)據(jù)中獲得了最大收益。」

Sutskever 認(rèn)為這是向思考無(wú)監(jiān)督學(xué)習(xí)所邁出的重要一步。你不知道你的無(wú)監(jiān)督數(shù)據(jù)集是否真的有用,但如果你在監(jiān)督學(xué)習(xí)算法上的遺憾很低,那么不管有沒(méi)有用,你都已經(jīng)得到了最佳結(jié)果,不可能會(huì)有更好的結(jié)果了。

現(xiàn)在進(jìn)入有些晦澀難懂的理論領(lǐng)域。

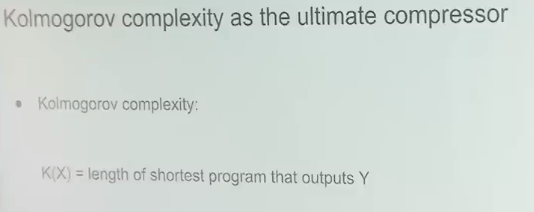

將 Kolmogorov 復(fù)雜度用作終極壓縮器能為我們提供超低遺憾的算法,但這其實(shí)并不是算法,因?yàn)樗豢捎?jì)算。

先簡(jiǎn)單解釋一下 Kolmogorov 復(fù)雜度:就好比你給我一些數(shù)據(jù),為了壓縮它,我給你提供一個(gè)可能存在的最短的程序。Kolmogorov 復(fù)雜度就等于這個(gè)最短程序的長(zhǎng)度。

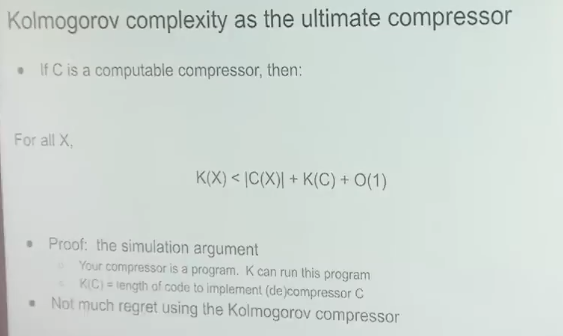

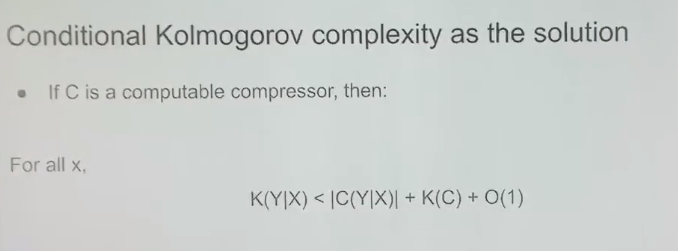

令 C 是一個(gè)可計(jì)算的壓縮器,那么對(duì)于所有 X,Kolmogorov 壓縮器的復(fù)雜度小于壓縮器 C 的任意輸出加上實(shí)現(xiàn)該壓縮器所需的代碼字符數(shù)。

我們可以使用模擬論證(simulation argument)來(lái)證明這一點(diǎn)。假設(shè)有一個(gè)非常棒的壓縮器 C,那么它可能是一個(gè)計(jì)算機(jī)程序,如果將這個(gè)計(jì)算機(jī)程序交給 K 來(lái)運(yùn)行,那么 K 所需的成本就是這個(gè)程序的長(zhǎng)度。Kolmogorov 壓縮器可以模擬其它計(jì)算機(jī)程序和其它壓縮器,也因此它是不可計(jì)算的。它就像是一個(gè)能夠模擬所有計(jì)算機(jī)程序的自由程序,但它也是有可能存在的最好的壓縮器。

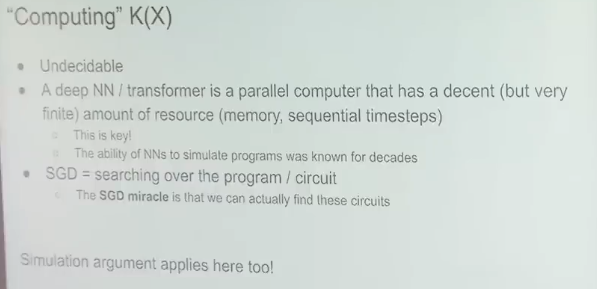

現(xiàn)在我們泛化 Kolmogorov 壓縮器,使其可以使用其它信息。我們知道 Kolmogorov 壓縮器是不可計(jì)算的,不可判定的,而像是搜索所有程序。這就像是使用神經(jīng)網(wǎng)絡(luò)通過(guò) SGD(隨機(jī)梯度下降)調(diào)整參數(shù)來(lái)搜索程序。這個(gè)過(guò)程運(yùn)行在有一定資源(內(nèi)存、 步驟數(shù))的計(jì)算機(jī)上,這就像是非常微小的 Kolmogorov 壓縮器。這兩者存在相似之處。

神經(jīng)網(wǎng)絡(luò)可以模擬小程序,它們是小小的計(jì)算機(jī),有回路 / 電路。我們可以使用 SGD 訓(xùn)練這些計(jì)算機(jī),從數(shù)據(jù)中找到它的「電路」。

模擬論證在這里也適用。如果你想設(shè)計(jì)一個(gè)更好的神經(jīng)網(wǎng)絡(luò)架構(gòu),你會(huì)發(fā)現(xiàn)這很困難,因?yàn)樵鎏砘蛐薷倪B接這些操作雖然可以被其它神經(jīng)網(wǎng)絡(luò)架構(gòu)模擬,但實(shí)際卻難以做到。因?yàn)檫@些是能帶來(lái)巨大提升的罕見(jiàn)情況。正如從 RNN 到 Transformer 轉(zhuǎn)變。RNN 有一個(gè)瓶頸:隱藏狀態(tài)。但如果我們能找到一種方法,讓 RNN 可以擁有非常大的隱藏狀態(tài),那么它的性能表現(xiàn)可能會(huì)重新趕上 Transformer。

所以我們可以把條件 Kolmogorov 復(fù)雜度作為無(wú)監(jiān)督學(xué)習(xí)的解,如下所示:

其中 C 是一個(gè)可計(jì)算的壓縮器,K (Y|X) 是如果能使用 X,能輸出 Y 的最短程序的長(zhǎng)度。

這是無(wú)監(jiān)督學(xué)習(xí)的超低遺憾的解,只不過(guò)它是不可計(jì)算的,但卻能提供一個(gè)有用的框架。

直接壓縮一切!

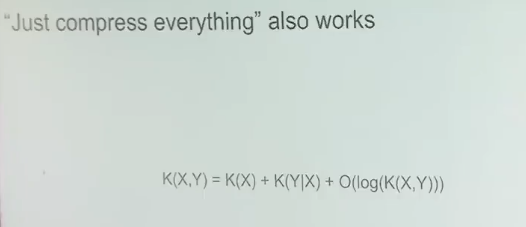

Sutskever 又進(jìn)一步提到「直接壓縮一切」也是可行的。

條件 Kolmogorov 復(fù)雜度 K (Y|X) 在機(jī)器學(xué)習(xí)語(yǔ)境中是不自然的,因?yàn)樗腔?X 來(lái)壓縮 Y,而至少就目前而言,以大型數(shù)據(jù)集為條件還是基本無(wú)法辦到的。我們可以擬合大型數(shù)據(jù)集,但很難以其為條件。

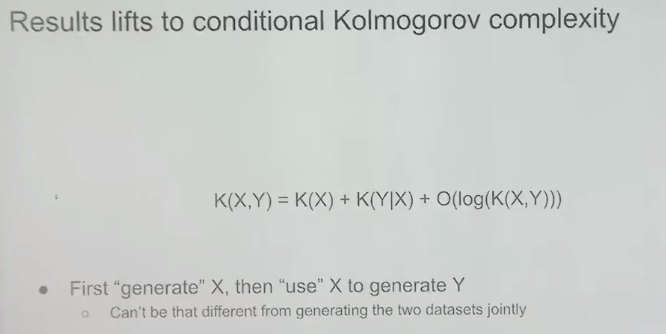

而上式是表示:如果你想要對(duì)你監(jiān)督的東西 Y 進(jìn)行預(yù)測(cè),使用壓縮 X 和 Y 連接數(shù)據(jù)的常規(guī) Kolmogorov 壓縮器的表現(xiàn)與條件壓縮器一樣好。當(dāng)然實(shí)際細(xì)節(jié)還有更多微妙之處,但這其實(shí)就是表示我們可以使用常規(guī) Kolmogorov 壓縮器來(lái)求解無(wú)監(jiān)督學(xué)習(xí) —— 就是將你的所有數(shù)據(jù)連接起來(lái),然后執(zhí)行壓縮,這樣就能在你關(guān)心的監(jiān)督任務(wù)上得到很好的結(jié)果。

對(duì)此的證明要更復(fù)雜一些,這里就不再繼續(xù)深入了。

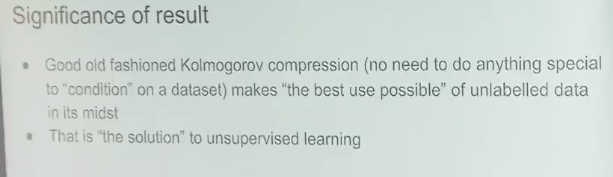

重點(diǎn)的結(jié)論是常規(guī) Kolmogorov 壓縮(無(wú)需以某個(gè)數(shù)據(jù)集為條件)是「以最好的可能方式使用」無(wú)標(biāo)注數(shù)據(jù)。這就是無(wú)監(jiān)督學(xué)習(xí)的解。

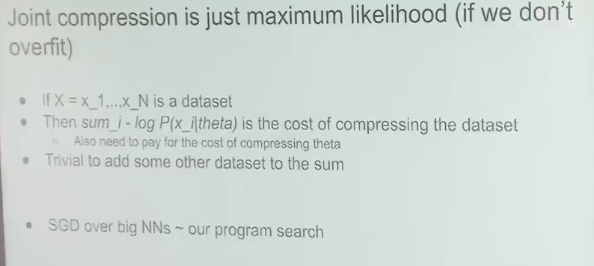

聯(lián)合壓縮就是最大似然

Sutskever 在演講中談到的最后一點(diǎn)是:這種聯(lián)合壓縮就是最大似然,只要沒(méi)有過(guò)擬合。

如果你有一個(gè)數(shù)據(jù)集,那么給定參數(shù)的似然之和就是壓縮該數(shù)據(jù)集的成本。你還需要支付壓縮參數(shù)的成本。而如果你想壓縮兩個(gè)數(shù)據(jù)集,也沒(méi)有問(wèn)題,只需向你的數(shù)據(jù)集添加數(shù)據(jù)點(diǎn)即可,也就是向上面的求和運(yùn)算 sum 添加更多項(xiàng)。

所以通過(guò)連接數(shù)據(jù)來(lái)進(jìn)行聯(lián)合壓縮在機(jī)器學(xué)習(xí)語(yǔ)境中是非常自然的做法。相比而言,通過(guò)條件 Kolmogorov 復(fù)雜度就麻煩多了。

我們甚至可以將其用于解釋神經(jīng)網(wǎng)絡(luò)的工作方式。我們可以將用于大型神經(jīng)網(wǎng)絡(luò)的 SGD 用作我們的大型程序搜索器。神經(jīng)網(wǎng)絡(luò)越大,就能更好地近似常規(guī) Kolmogorov 壓縮器。Sutskever 評(píng)價(jià)說(shuō):「也許這就是我們喜歡大型神經(jīng)網(wǎng)絡(luò)的原因,因?yàn)槲覀兛梢砸源私撇豢蓪?shí)現(xiàn)的無(wú)遺憾常規(guī) Kolmogorov 壓縮器思想。隨著我們訓(xùn)練的神經(jīng)網(wǎng)絡(luò)越來(lái)越大,遺憾會(huì)越來(lái)越低。」

此理論也適用于 GPT 模型嗎?

Sutskever 對(duì)此的答案是肯定的,不過(guò)解釋 GPT 模型的行為時(shí),無(wú)需引述有關(guān)壓縮或監(jiān)督學(xué)習(xí)的說(shuō)明,你可以說(shuō) GPT 的「理論」可以通過(guò)對(duì)文本的條件分布進(jìn)行推理而得到。

那么,我們能找到其它的直接驗(yàn)證方法來(lái)驗(yàn)證這一理論嗎?我們能用視覺(jué)等其它領(lǐng)域來(lái)解釋嗎?如果我們?cè)谙袼財(cái)?shù)據(jù)上這樣操作,我們能得到優(yōu)良的無(wú)監(jiān)督學(xué)習(xí)嗎?

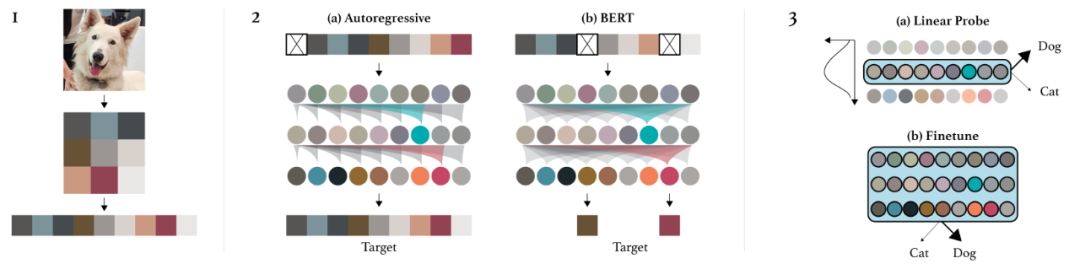

Sutskever 表示他們已經(jīng)在 2020 年做過(guò)這樣的研究,即 iGPT。當(dāng)然,這主要是一個(gè)驗(yàn)證概念的研究,離實(shí)踐應(yīng)用還有很大距離,詳見(jiàn)論文《Generative Pretraining from Pixels》。

該論文表明:如果你能做出很棒的下一步預(yù)測(cè)器,那么就能收獲很棒的無(wú)監(jiān)督學(xué)習(xí)效果。這篇論文在圖像領(lǐng)域證明了該論斷。

簡(jiǎn)單來(lái)說(shuō),先將圖片轉(zhuǎn)換成像素序列,每個(gè)像素都有一個(gè)離散的密度值。要做的就是使用同樣的 Transformer 來(lái)預(yù)測(cè)下一個(gè)像素。這不同于 BERT,就是預(yù)測(cè)下一個(gè) token,因?yàn)檫@是最大化壓縮的似然。

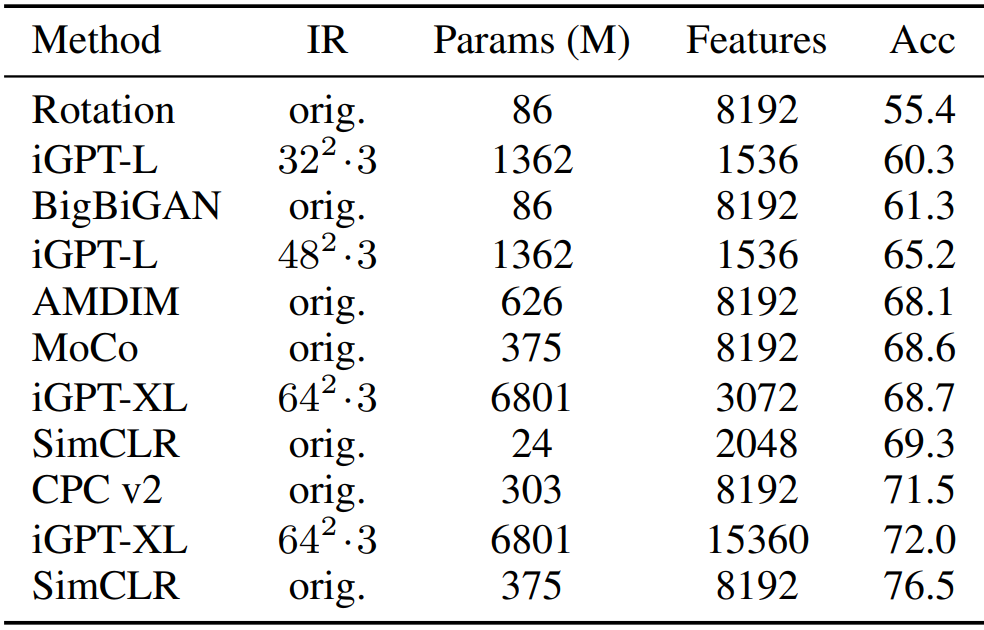

下面來(lái)看看結(jié)果:

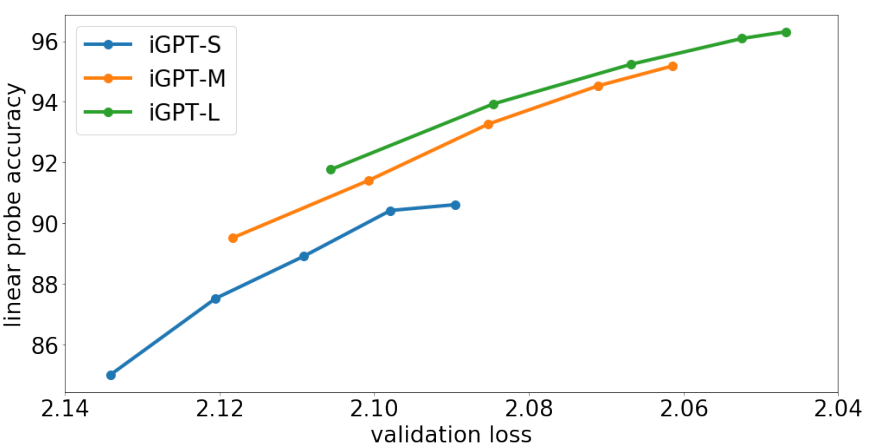

如圖所示,這是不同大小的 iGPT 模型在 CIFAR-10 上的線性探查準(zhǔn)確度,也就是在無(wú)監(jiān)督學(xué)習(xí)的像素預(yù)測(cè)任務(wù)上的下一步預(yù)測(cè)準(zhǔn)確度。可以看出,預(yù)測(cè)下一個(gè)像素就和預(yù)測(cè)下一個(gè)詞一樣有效。當(dāng)模型規(guī)模更大時(shí),無(wú)監(jiān)督學(xué)習(xí)的效果也更好。

他們進(jìn)行了實(shí)驗(yàn)研究,結(jié)果發(fā)現(xiàn)在 ImageNet 上,經(jīng)過(guò)多方面擴(kuò)展的 iGPT 的表現(xiàn)可以接近當(dāng)今最佳的監(jiān)督學(xué)習(xí),但依然還有些差距。

不過(guò) Sutskever 認(rèn)為這就是個(gè)計(jì)算問(wèn)題,因?yàn)?SimCLR 等監(jiān)督學(xué)習(xí)方式使用的是高分辨率的大圖,他們?yōu)榫扌?Transformer(68 億參數(shù))提供的是 64×64 的小圖。這就像是基于一個(gè)大型數(shù)據(jù)集以無(wú)監(jiān)督的方式預(yù)測(cè)下一個(gè)像素,然后在 ImageNet 上擬合線性探針,得到很好的結(jié)果。

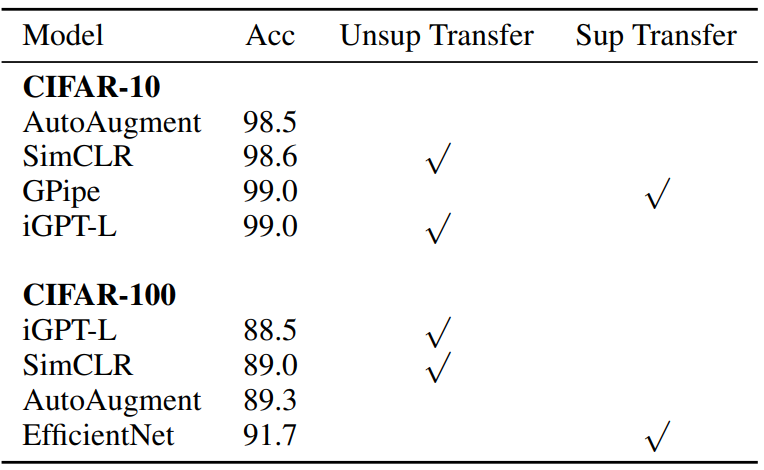

而在 CIFAR-10 上,有 13.6 億參數(shù)的 iGPT-L 取得了準(zhǔn)確度 99% 的好成績(jī),如下圖所示。

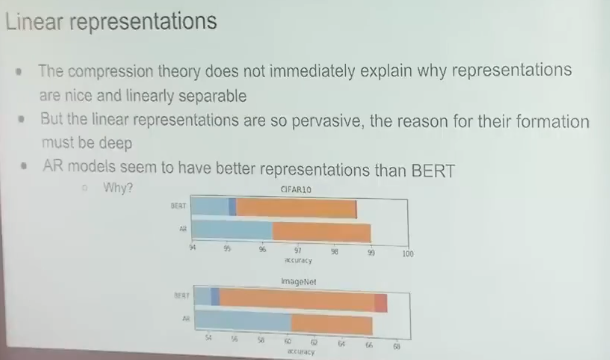

線性表征

演講最后,Sutskever 表示他想談?wù)劸€性表征。

他說(shuō):「我喜歡壓縮理論,因?yàn)樵诖酥斑€沒(méi)有以嚴(yán)格方式思考無(wú)監(jiān)督學(xué)習(xí)的方法。」而現(xiàn)在我們能在一定程度上做到這一點(diǎn)了。但壓縮理論不能直接解釋為什么表征是線性可分的,也無(wú)法解釋?xiě)?yīng)該有線性探針。線性表征是無(wú)處不在的,它們形成的原因必定很深刻。Sutskever 相信我們能在未來(lái)清晰地闡釋它。

他覺(jué)得另一個(gè)有趣的地方是自回歸模型在線性表征方面的表現(xiàn)優(yōu)于 BERT。但目前人們還不清楚其中的緣由。

不過(guò) Sutskever 倒是給出了自己的推測(cè):在根據(jù)之前所有的像素預(yù)測(cè)下一個(gè)像素時(shí),模型需要觀察數(shù)據(jù)的長(zhǎng)程結(jié)構(gòu)。BERT 在處理向量時(shí)會(huì)丟棄一些像素 token,通過(guò)兼顧地考慮一點(diǎn)過(guò)去和一點(diǎn)未來(lái),模型實(shí)際上能得到相當(dāng)好的預(yù)測(cè)結(jié)果。這樣一來(lái)就去除了所有困難任務(wù),任務(wù)的難度就下降了很多。預(yù)測(cè)下一個(gè)像素中最困難的預(yù)測(cè)任務(wù)比 BERT 預(yù)測(cè)情況中最困難的預(yù)測(cè)任務(wù)難多了。