發揮offline方法的潛力,武大&快手提出解耦合的視頻實例分割框架DVIS

視頻分割任務 (Video Segmentation) 由圖像分割任務擴展而來,旨在同時分割、檢測、追蹤視頻中的所有目標,是一項比圖像分割更具挑戰的基礎任務。

相比于逐幀處理視頻幀的圖像分割算法,視頻分割算法可以提供時序穩定、準確的分割結果,并追蹤每一個單獨的目標,實現視頻中實例級別的理解與編輯功能。視頻分割在視頻編輯、短視頻基礎工具、自動駕駛、監控安防等下游任務有著重要作用。

視頻編輯(目標擦除)[a]

視頻編輯(視頻換背景)[b]

自動駕駛(車輛與行人分割與追蹤)

近年來,Transformer [1] 在 CV 中各個領域被廣泛應用。DETR [2] 作為基于 Transformer 的經典工作之一,在圖像目標檢測、圖像實例分割領域展現出了強大的潛力。相比于基于 ROI 的實例表征方式,DETR 所采用的基于 Query 的實例表征方式展現出了更強勁的表征能力以及靈活性。受到圖像目標檢測領域進展的啟發,VisTR [9] 首次將 Transformer 應用于 VIS 領域,展現出了巨大的性能提升。隨后基于 Transformer 的方法在 VIS 領域成為了主流。

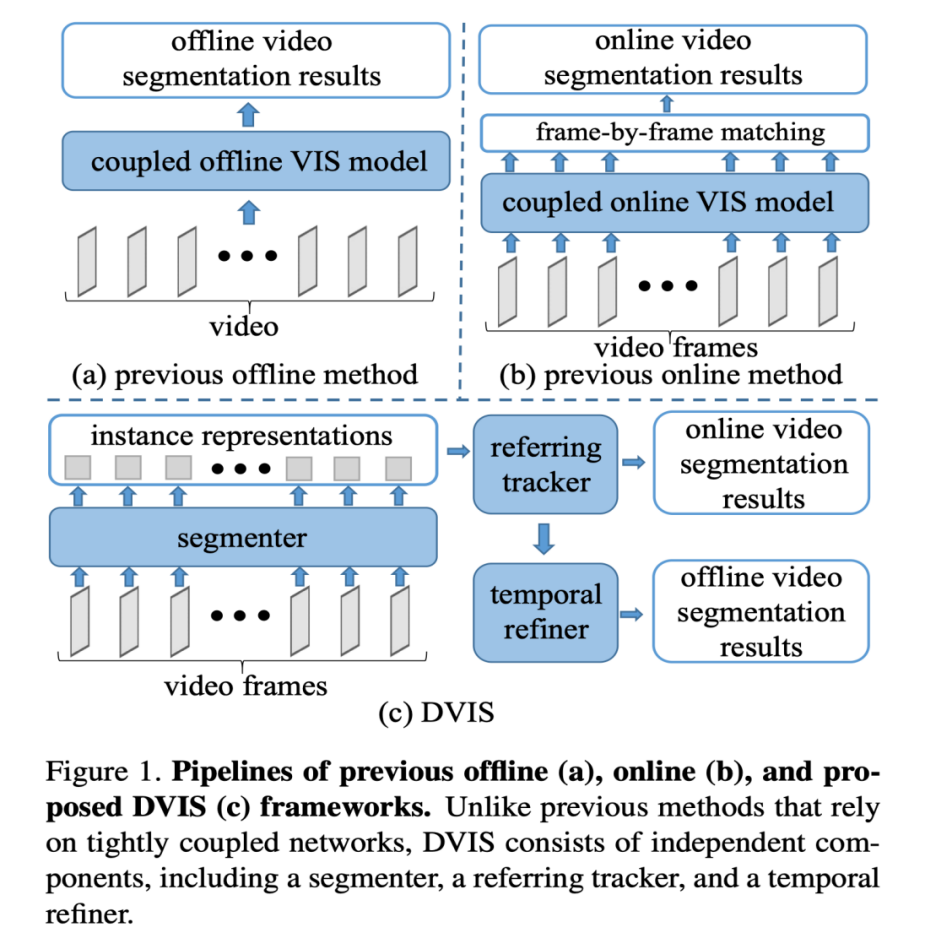

目前視頻分割領域的方法可以分為在線 (online) 與離線 (offline) 方法。在線方法在預測當前幀結果時以當前幀及歷史幀作為輸入,主要應用于需要實時處理的需求場景,如自動駕駛中的實時感知。離線方法在預測當前幀結果時可以利用視頻中任意幀作為輸入,主要應用于離線處理的需求場景,如視頻編輯等。

現有的 SOTA 的 online 方法 (MinVIS [3]、IDOL [4] 等) 遵循著先執行圖像分割后逐幀關聯實例的技術路線。這種技術路線并未根據其他幀的信息來優化當前幀的分割結果,因此缺乏對于視頻信息的有效利用。

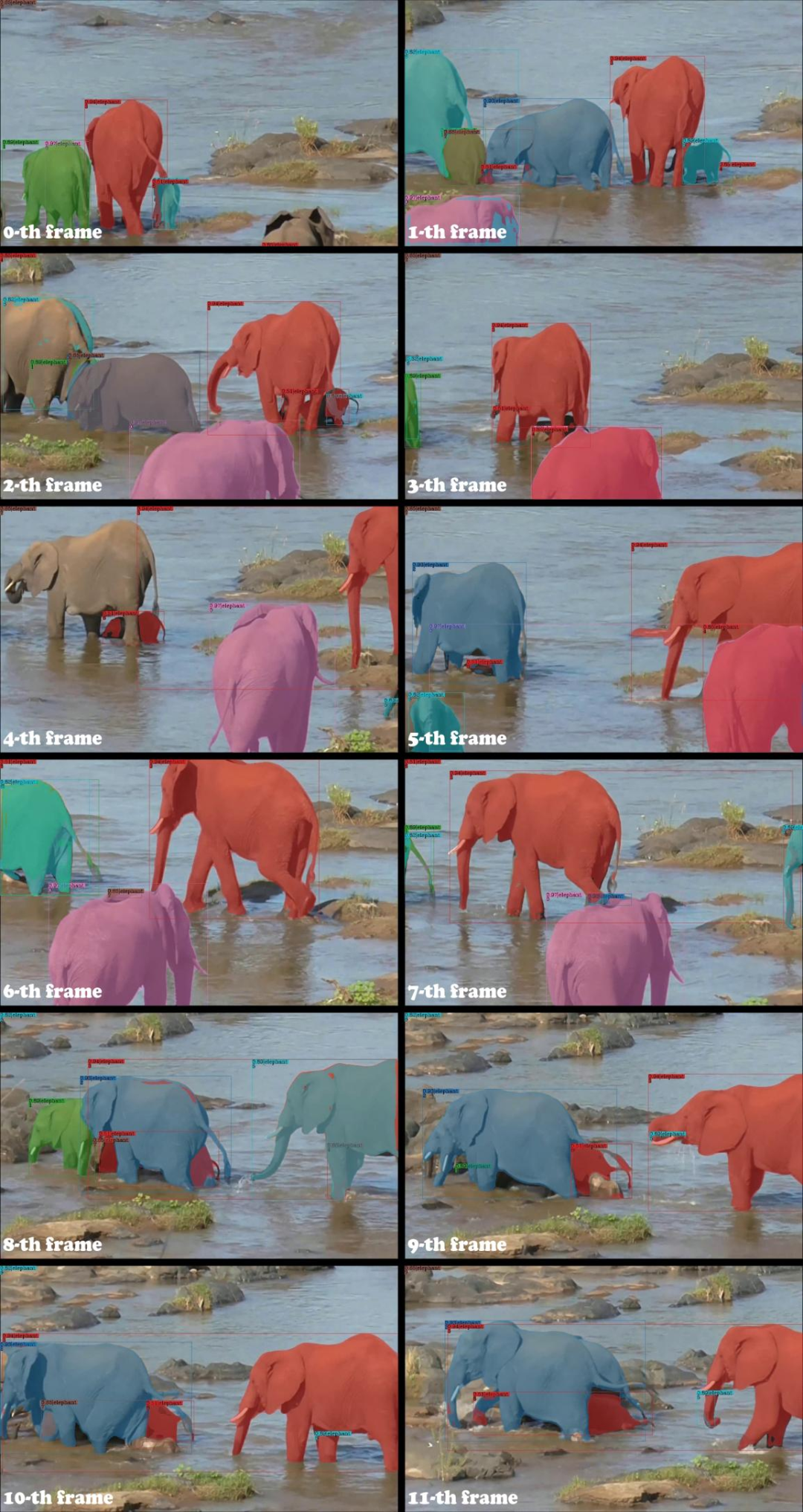

現有的 SOTA 的 offline 方法 (SeqFormer [5]、Mask2Former-VIS [6]、VITA [7]、IFC [8] 等) 采用一個緊耦合網絡來端到端地處理視頻分割任務。雖然這種技術路線理論上可以更加有效地利用視頻信息,但是在長視頻以及復雜場景中,性能卻不盡人意。如以下視頻抽幀所示,當視頻中出現很多個同類目標發生相互遮擋換位等情況時,Mask2Former-VIS 的目標跟蹤結果出現錯亂,分割精度也受到影響。

Mask2Former-VIS 在換位場景極易追蹤出錯(ID 請放大觀看)

offline 方法相比于 online 方法可以利用更多的信息,因此理論上應該有著更好的表現。然而事實并非如此,在復雜場景下現有的 offline 方法的性能顯著低于 online 方法。我們認為這是由于現有的 offline 方法對實例表征的設定所導致的。現有的 offline 方法采用單一的可學習的 query 來表征視頻中的一個實例,這種可學習的 query 可以被看作位置以及大小先驗。然而在實際場景中,某個實例的表觀和空間位置都可能發生大幅變化,因此僅靠位置與大小先驗很難從所有幀中都探測到該實例的正確特征。 正如上面視頻 demo 所示,3 號 query(紅色掩碼覆蓋)學習到的先驗位置信息處在視頻的右側,然而視頻前段所標記的大象在視頻結束時已運動至視頻左側。

那么如何充分利用視頻信息以使得 offline 方法發揮出理論上應有的潛力?來自武漢大學與快手 Y-tech 的研究者共同研發了一種新的視頻實例分割算法——DVIS,回答了該問題。研究論文已被 ICCV2023 接收。

- 論文地址:https://arxiv.org/pdf/2306.03413.pdf

- 項目地址:https://github.com/zhang-tao-whu/DVIS

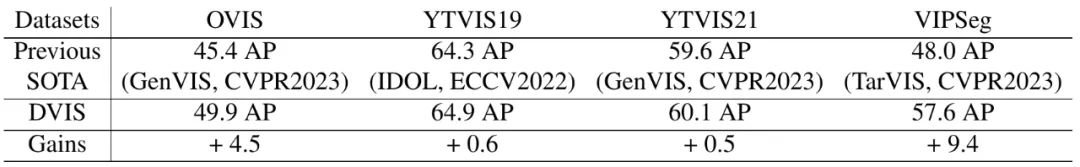

DVIS 在 OVIS、YouTube-VIS、VIPSeg 等數據集上均取得了 SOTA 表現,在 OVIS 數據集上從 2023 年 2 月霸榜至今,并在 CVPR 2023 的 PVUW 挑戰賽、ICCV2023 的 LSVOS 挑戰賽等多項賽事中取得冠軍。

具體來說,DVIS 具有以下特性:

- DVIS 可以實現視頻通用分割,可以處理視頻實例分割 (VIS)、視頻語義分割 (VSS) 以及視頻全景分割 (VPS) 三大任務。

- DVIS 可以在 online 以及 offline 模式下運行。

- 解耦的設計使得 DVIS 訓練所需要的計算資源較少,相比于 segmenter 僅帶來了不足 5% 的額外計算代價,DVIS-R50 可以在 2080Ti 上一天內完成訓練。

- DVIS 在多個 VIS 以及 VPS 的數據集上均取得 SOTA 性能。

效果展示

在本文之前,VIS 領域的 SOTA 方法 MinVIS 在復雜視頻上的表現較差,主要體現在目標跟蹤 ID 容易發生錯亂、分割掩碼破碎等現象。本文提出的 DVIS 則可以在復雜長視頻中追蹤并穩定分割目標。MinVIS 和 DVIS 的對比如下視頻所示。

除此之外,DVIS 在目標占畫面比例較小時依然表現良好:

方法簡介

既然直接建模實例在整個視頻上的表征是困難的,那么是否可以首先在單幀中建模實例,然后逐幀關聯實例來獲取同一實例在所有幀的表征,最后再對實例的時序信息加以利用。毫無疑問,逐幀關聯的難度要比直接關聯所有視頻幀上的同一實例小得多。在給出時間上良好對齊的實例特征的情況下,有效地對這些特征加以利用也是輕而易舉的。

我們將 VIS 任務分解為圖像分割、物體關聯、時序精化三個子步驟,相應的我們分別設計 segmenter、tracker 和 refiner 三個網絡模塊來處理這三個子步驟。其中圖像分割即為在單幀中分割出目標并獲取目標的表征。物體關聯即為關聯相鄰幀的目標表征,為 refiner 提供一個良好對齊的初值。時序精化即為基于對齊好的物體時序信息來優化物體的分割結果以及追蹤結果。

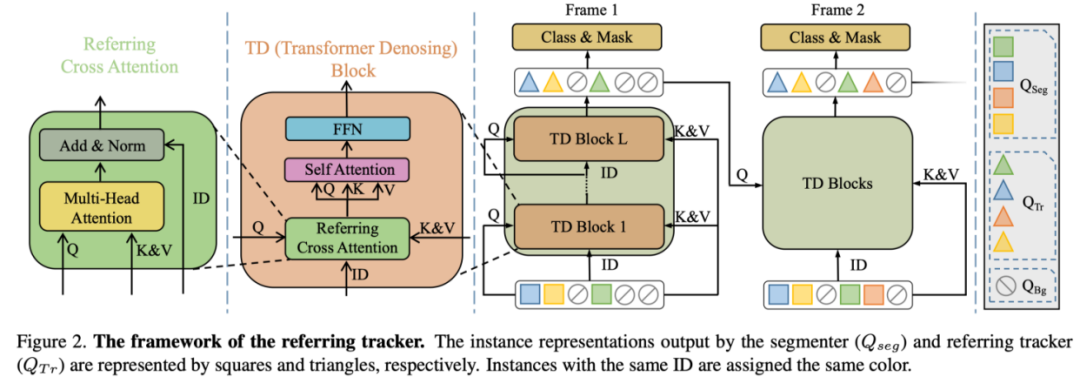

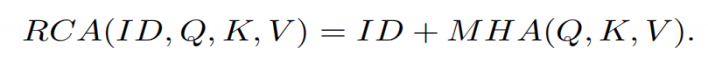

當 DVIS 的架構確定好后,我們需要針對圖像分割、物體關聯、時序精化三個子步驟分別設計合理的 segmenter、tracker 以及 refiner 網絡。圖像分割子步驟中,我們采用了 SOTA 的圖像通用分割網絡 Mask2Former 作為 segmenter 來提取物體的表征;物體關聯子步驟中,我們將追蹤建模為參考去噪 / 重建任務,并設計了 Referring Tracker 來進行穩健的目標關聯;在時序精化子步驟中,我們基于 1D 卷積以及 Self Attention 實現了 Temporal Refiner 來有效地利用物體的時序信息。

1. Referring Tracker

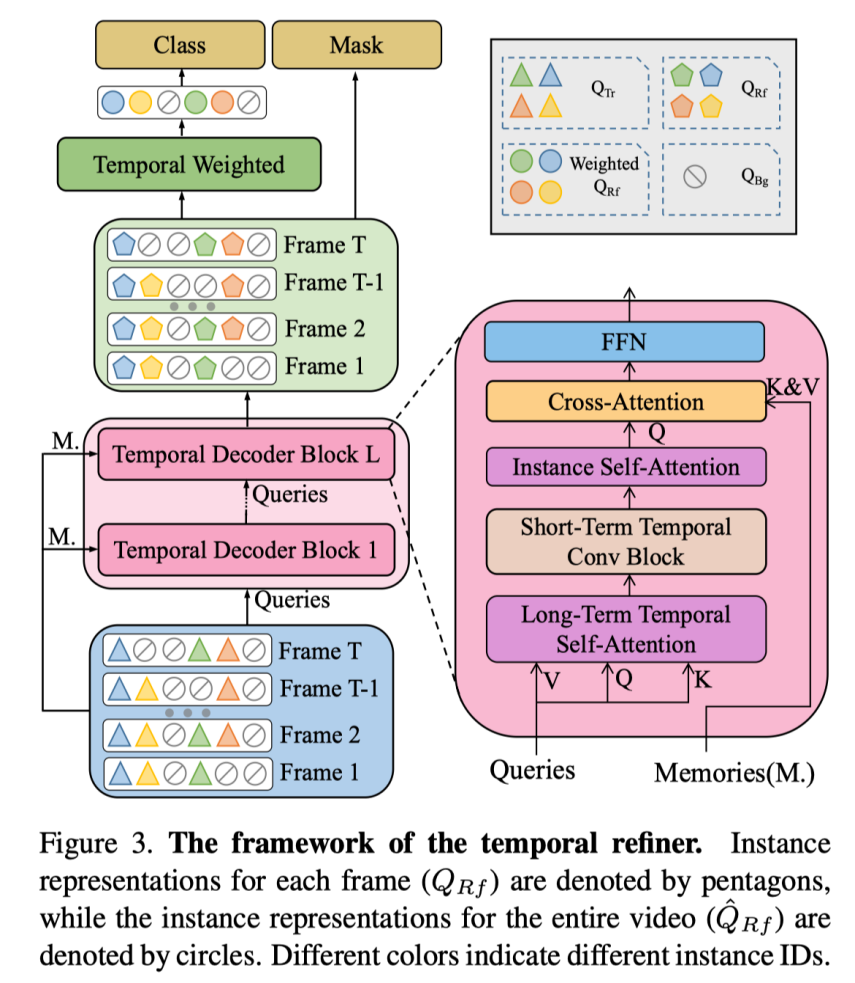

DVIS 將相鄰幀物體的關聯任務建模為根據上一幀物體 query 來重建當前幀對應的物體 query,即給定上一幀物體的 query 作為 reference query,然后從 segmenter 輸出的當前幀的 object query 中聚合信息,最后輸出 reference query 相應的實例在當前幀的掩碼和類別。Referring Tracker 通過 Referring Cross Attention 來學習以上過程。Referring Cross Attention 充分利用 refrence query 來指導信息的聚合并阻隔了 reference query 與當前信息的混雜,其由標準 Cross Attention 稍作改動而得到:

2. Temporal Refiner

在 Referring Tracker 輸出在時間維度上基本對齊的目標 query 后,就可以很容易的通過標準操作(如 1D 卷積以及 Self Attention)來對時序特征進行有效利用。我們設計的 Temporal Refiner 也非常簡單,由 1D 卷積以及 Self Attention 來聚合時序特征。Temporal Refiner 基于物體的時序特征來優化分割結果以及追蹤結果。

值得一提的是 DVIS 的設計很靈活,Referring Tracker 可以疊加于任何 query-based 的圖像分割器來實現在線的視頻分割,Temporal Refiner 同樣可以疊加于任何在線的視頻分割器來獲取更強大的分割性能。

實驗結果

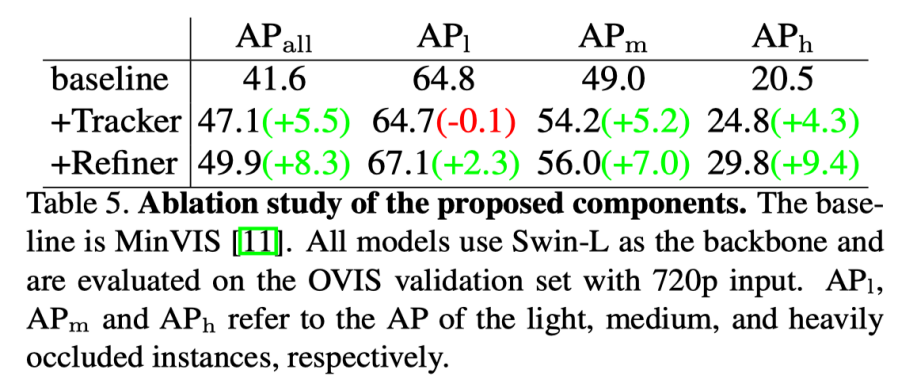

我們在 OVIS 數據集上對于 Referring Tracker 和 Temporal Refiner 的作用進行了消融實驗。Tracker 的主要作用是實現更魯棒的目標關聯,尤其是對于中度遮擋和重度遮擋的物體有較大改善(如下表所示,為中度遮擋以及重度遮擋的目標分別帶來了 5.2 AP 和 4.3 AP 的性能提升)。Refiner 的主要作用是充分利用時序信息,結果顯示由于時序信息的有效利用,Temporal Refiner 對于被輕度、中度、重度遮擋物體的性能都有顯著提升(如下表所示,為輕度、中度以及重度遮擋的目標分別帶來了 2.4 AP 和 1.8 AP 和 5.1 AP 的性能提升)。

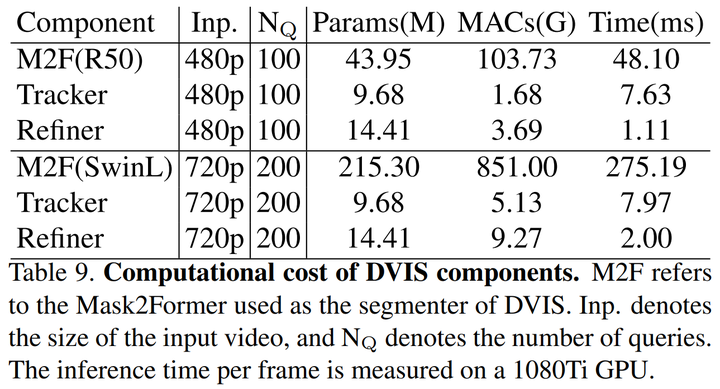

并且,由于 Referring Tracker 和 Temporal Refiner 僅處理 object query,因此計算代價很小,計算量總和少于 Segmenter 的 5%(見下表):

DVIS 在 OVIS、YouTube-VIS (2019,2021) 以及 VIPSeg 等數據集上均取得 SOTA:

結論

在本文中,我們提出了 DVIS,一種將 VIS 任務解耦的框架,將 VIS 任務分為三個子任務:分割,跟蹤和細化。我們的貢獻有三個方面:1)我們將解耦策略引入了 VIS 任務并提出了 DVIS 框架,2)我們提出了 Referring Tracker,通過將幀間關聯建模為引用去噪來增強跟蹤的魯棒性,3)我們提出了 Temporal Refiner,利用整個視頻的信息來精化分割結果,彌補了之前工作在這方面的缺失。結果表明,DVIS 在所有 VIS 數據集上實現了 SOTA 性能。

雖然 DVIS 的設計來源于對 VIS 領域內既有方法不足的反思,但是 DVIS 的設計并不局限于視頻實例分割領域,其可以無任何改動的在 VIS,VPS 和 VSS 上都取得 SOTA 性能,這證明了 DVIS 的通用性與強大潛力。我們希望,DVIS 將成為一個強大且基礎的基準,并且我們的解耦洞見將激發在線和離線 VIS 領域的未來研究。

從未來技術發展的角度上,我們將會繼續探索面向圖像、視頻以及更多模態的基礎視覺感知技術,從模型通用性、開放類別等角度進一步拓展基礎視覺感知技術的邊界。