國產大模型登頂多模態(tài)榜單!解決幻覺、跨語言兩大難題

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯(lián)系出處。

國產大模型,登頂多模態(tài)榜單!

昆侖萬維最近在大模型圈可謂“風生水起”。

幾天前剛被曝挖來了AI大牛顏水成,出任天工智能聯(lián)席CEO。

現(xiàn)在,其「天工」大模型Skywork-MM又登頂多模態(tài)榜單,在騰訊優(yōu)圖實驗室聯(lián)合廈門大學開展的多模態(tài)大語言模型(Multimodal Large Language Model,簡稱“MLLM”)測評中,綜合得分排名第一。

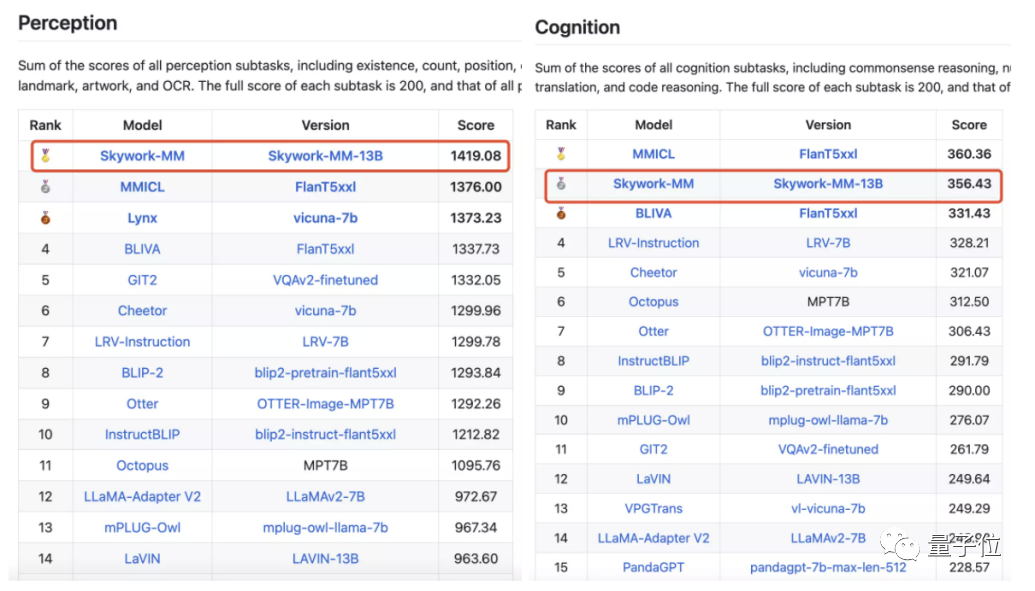

△MME感知榜第一,認知榜第二,總榜第一

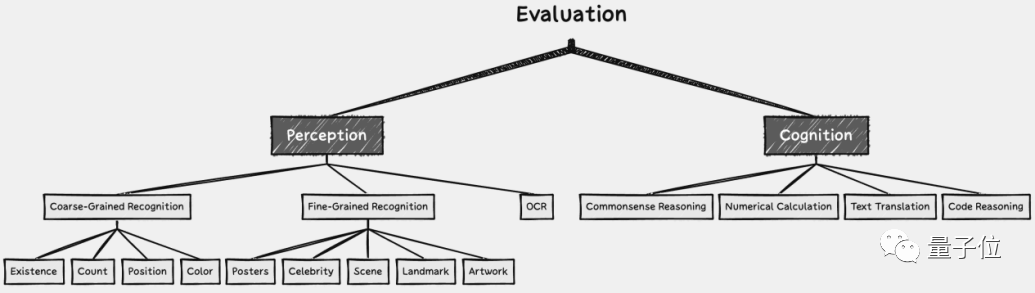

騰訊優(yōu)圖實驗室聯(lián)合廈門大學在新建的評測基準MME上首次對全球范圍內MLLM模型進行了全面定量評測并公布了16個排行榜,包含感知、認知兩個總榜單以及14個子榜單。

MME數(shù)據(jù)集是一個最近發(fā)布的多模態(tài)語言模型測評基準。

它通過大型多模態(tài)語言模型在涵蓋感知和認知任務的14個子任務上的表現(xiàn)來全面評估模型。

而Skywork-MM只用了不到50M的圖文數(shù)據(jù)——遠小于其他大模型(>100M),拿下了第一(榜單地址見文末)。

如何做到?

主要是解決了現(xiàn)有多模態(tài)大模型中頗為困擾的兩大問題:

幻覺和較弱的跨語言能力。

多模態(tài)兩大難

所謂幻覺,是指多模態(tài)大模型在回答問題時,傾向于肯定的答案,即使我們所給的問題中根本沒有相關特征。

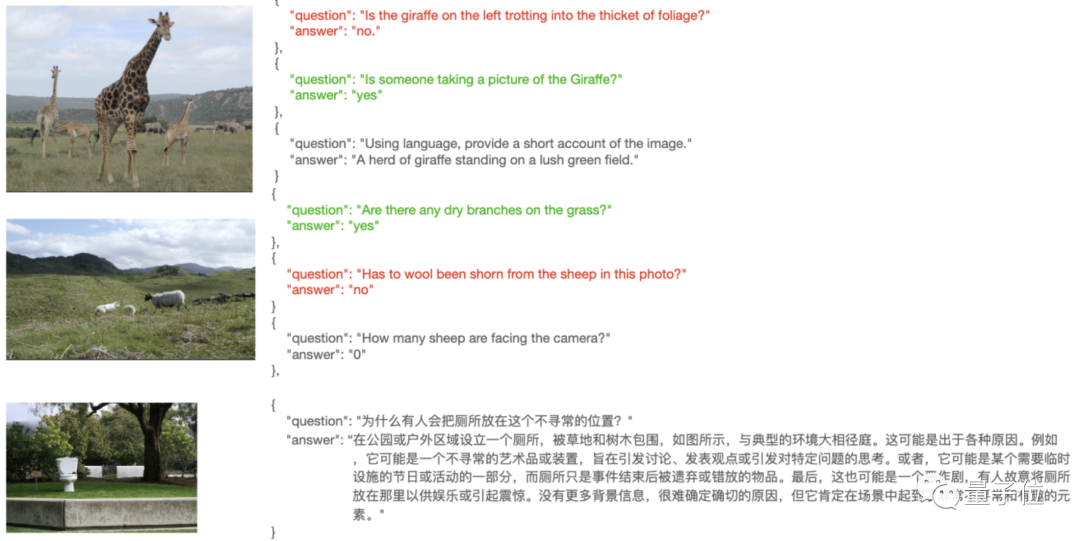

例如面對下面這張圖像。

如果問它“這個男人的頭發(fā)是什么顏色?”,即使優(yōu)秀如LLaVA、MiniGPT-4等多模態(tài)大模型,也會“睜著眼說瞎話”:黑色。

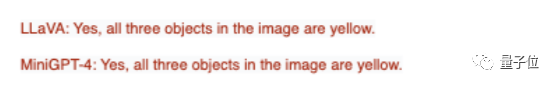

再如這張圖片:一個玻璃杯、一個茶杯、一個浴缸里面有條小金魚。

如果問它“圖片中的所有物品都是黃色的嗎?”,沒有誰能答對。

至于跨語言能力問題,主要表現(xiàn)在應對中文場景中的問題回答不盡如人意。

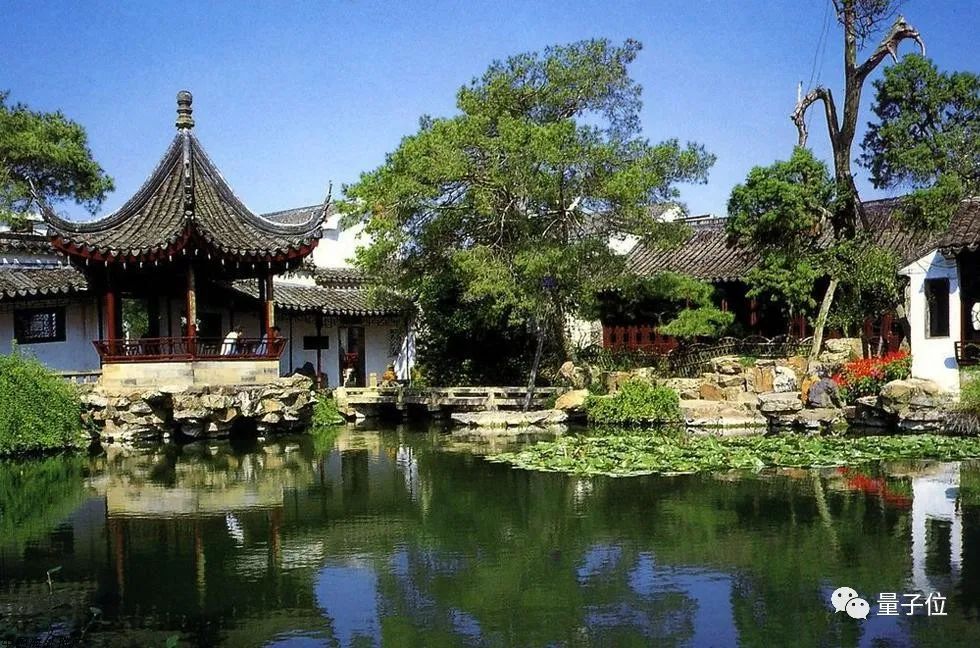

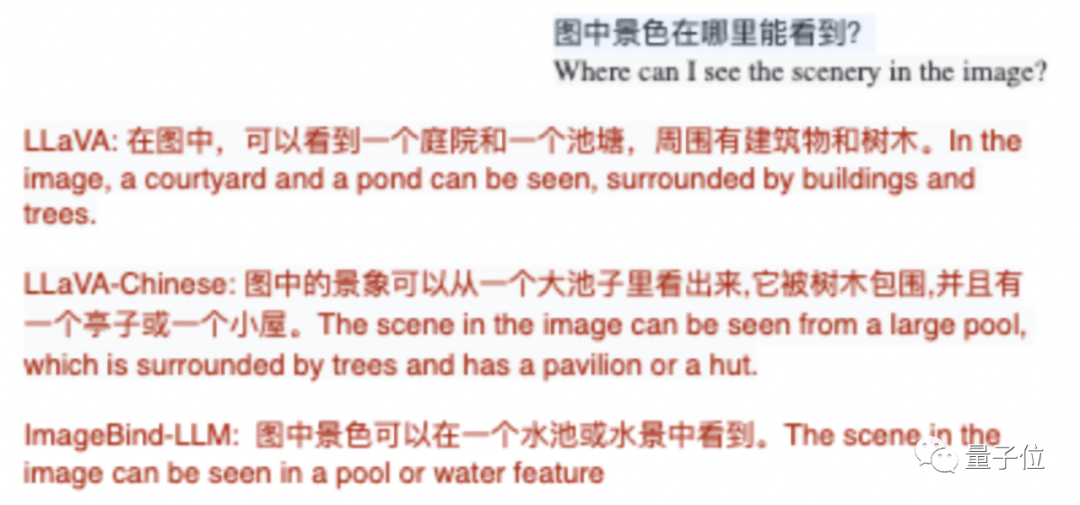

比如辨認下面這張圖片是“科羅拉多大峽谷還是蘇州園林”時,3個雙語多模態(tài)語言模型:LLaVA、 LLaVA-Chinese、ImageBind-LLm全部回答成前者。

問它們從哪里能觀賞到該景色,就更是一言難盡了。

甚至有時,模型還會直接回復純英文。

這兩大問題嚴重影響著現(xiàn)有多模態(tài)大模型的性能。

怎么解決?

三方面入手

昆侖萬維天工大模型Skywork-MM從分別從數(shù)據(jù)、模型和訓練流程三方面入手。

其中重點是數(shù)據(jù)和模型。

先看數(shù)據(jù)。

首先對于幻覺問題。

從本質出發(fā),該問題主要是整個模型訓練過程中使用的數(shù)據(jù)太偏重正樣本。

也就是說,模型描述的都是圖片中有什么,而沒有學習圖片中沒有什么。

如果訓練過程中再碰上弱相關的圖文數(shù)據(jù),模型就更加放飛聯(lián)想、形成較嚴重的幻覺。

為此,天工大模型多模態(tài)團隊提出以圖像為中心,喂給模型既包含正樣本也包含負樣本的多模態(tài)指令微調數(shù)據(jù):

這使得模型既能夠學習一張圖像中存在的視覺特征,也能學習到不存在的特征。

這樣,模型的指令跟隨能力便得到增強:問什么答什么,沒有的也不胡編。

其次,對于跨語言中的中文問題,一共有兩個解決思路:

(1)增強中文的指令追隨能力。

由于“微調指令的文化gap很小”,只需將上面解決幻覺問題中構造的英文指令微調數(shù)據(jù)翻譯成中文使用。

(2)增強中文相關場景的識別能力。

需要注意的是,在解決跨語言問題時,我們重點關注的點是文化偏差——

即通用的視覺特征和語言特征可以通過共有的語料進行關聯(lián),但是各個語言文化中專有的視覺特征和語言特征的關聯(lián)需要大量特殊學習。

因此我們需要加入大規(guī)模的中文圖像-文本對數(shù)據(jù)。

不過,這樣的中文語料并不好收集,一是囿于數(shù)據(jù)質量,而是困于數(shù)量。

怎么辦?

引出Skywork-MM在模型架構上的改進。

為了不讓低質量的圖文數(shù)據(jù)影響模型效果,天工大模型多模態(tài)團隊在設計上選擇將視覺模型和大語言模型完全凍結。

這樣做的目的是保持視覺模型在前置CLIP訓練中學習到的視覺特征不損失,以及大語言模型的語言能力不損失。

同時,為了更好的關聯(lián)不同文化環(huán)境中的視覺特征和語言特征,模型整體包含了一個可學習的視覺特征采樣器和語言模型的LoRA適配器。

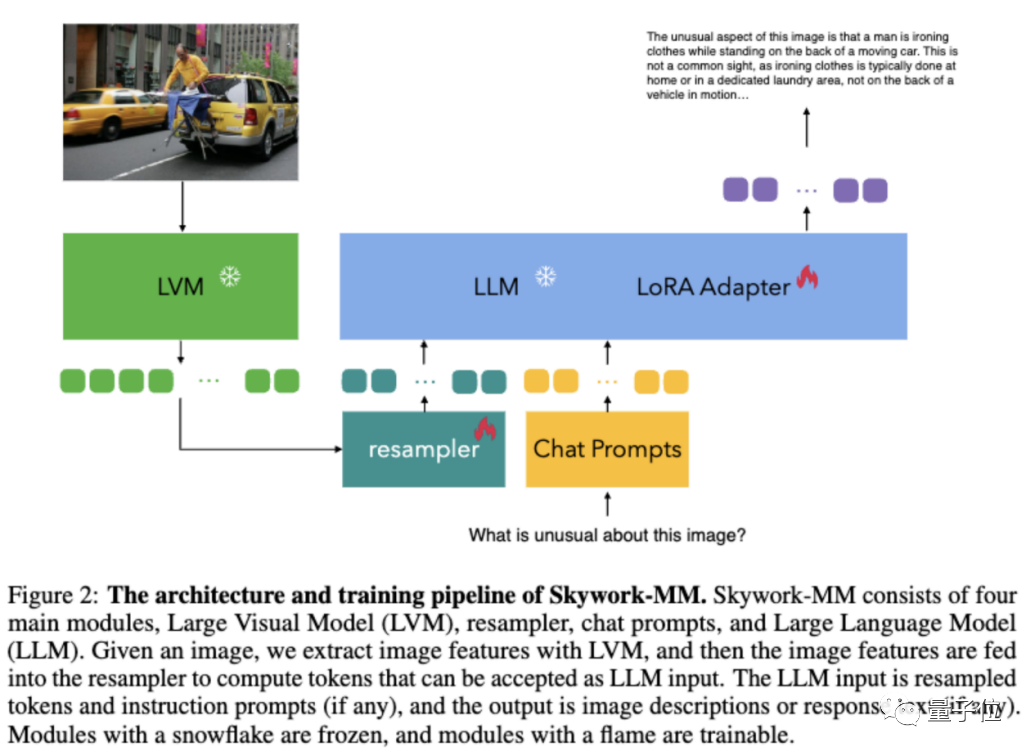

如下圖所示,Skywork-MM一共包含四大模塊:

給定一張圖像,LVM先提取圖像特征,然后將圖像特征輸入到重采樣器中,計算出可為LLM輸入的token。

LLM接收token和指令提示(如果有),然后輸出圖像描述或對問題的回答。

至于訓練流程,主要分為兩階段:

第一階段使用雙語的大規(guī)模圖文對數(shù)據(jù)進行圖像概念和語言概念的關聯(lián)學習。

第二階段使用多模態(tài)微調數(shù)據(jù)進行指令微調。

此時,各種類型的指令微調數(shù)據(jù)(包括正樣本和負樣本)就組成統(tǒng)一的Chat Prompt形式。

Ps. 上圖中的重采樣器和LoRA適配器標記了火焰,它們是可訓練的。

登頂MME綜合榜單

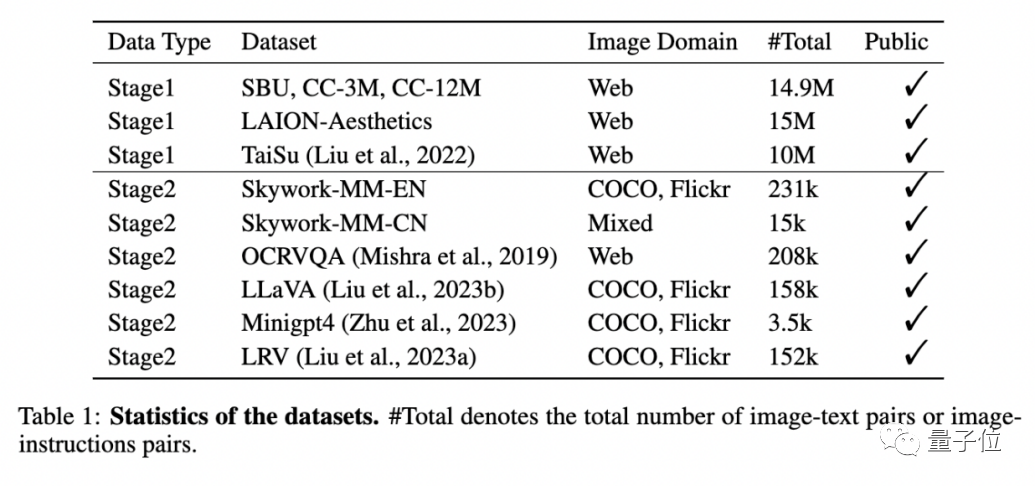

如下表所示,Skywork-MM一共用了大約50M圖文數(shù)據(jù),這比當前的同類大模型都要少得多。

但經(jīng)過以上數(shù)據(jù)、模型和訓練流程三方面的改進,Skywork-MM效果拔群。

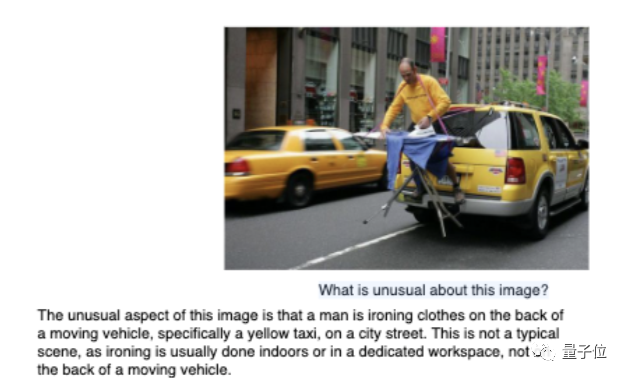

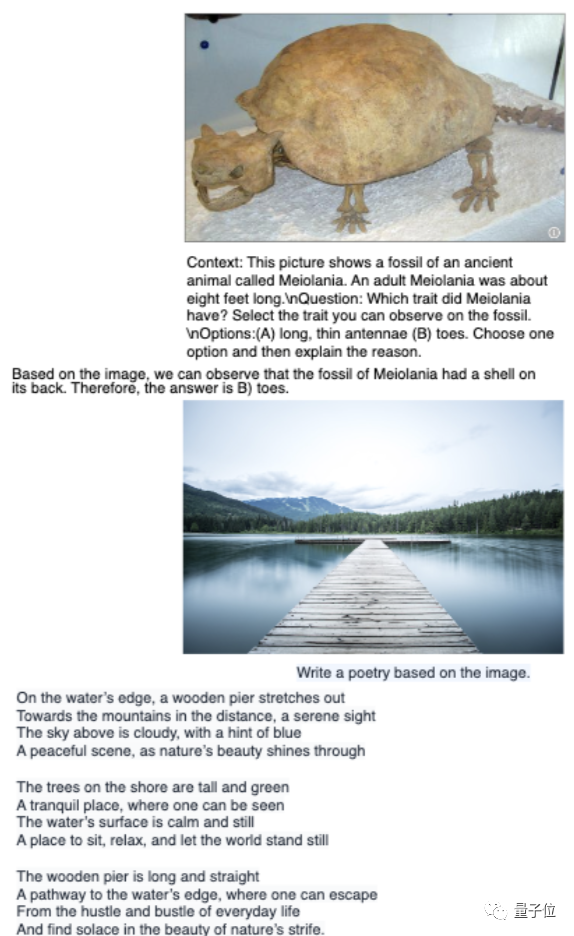

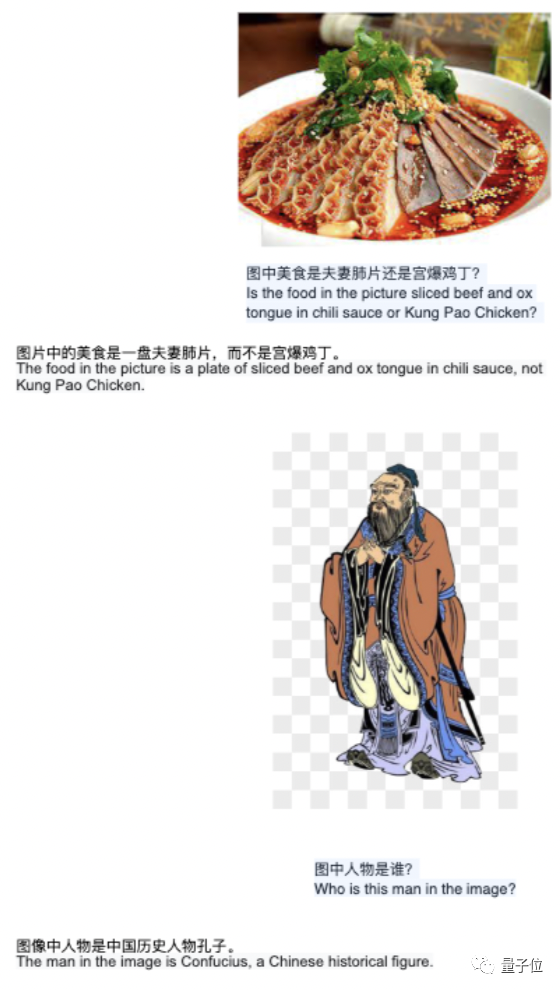

如下圖所示:

它能夠準確理解圖片中的反常行為;

也能聽明白一些特殊的指令(根據(jù)選項回答問題,根據(jù)風景寫詩,寫廣告詞,寫獲獎感言等等);

對于中文場景問題,表現(xiàn)得也不再像個“歪果仁”了。

可謂擁有了良好的指令跟隨和中文場景問答能力。

因此像第一段展示的那些幻覺和跨語言問題,它完全可以信手拈來:

孟非沒有頭發(fā)就沒有,不會說成黑色;蘇州園林、非誠勿擾節(jié)目一眼認出;三個物體沒有一個是黃色。

而如開頭所示,在與其他模型的橫向測試中,Skywork-MM直接榮登MME榜單綜合第一,包括感知榜單第一(且與第二名有著43分的差距)、認知榜單第二。

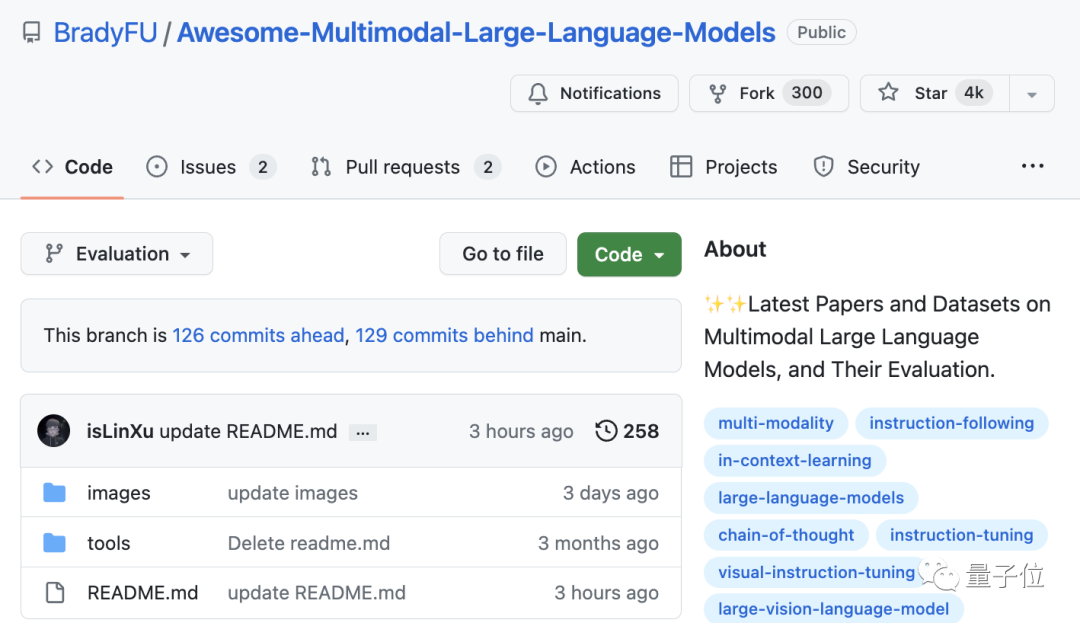

這個榜單大約今年6月上線、目前GitHub 4k標星,是當前多模態(tài)大模型最新的測評基準之一。

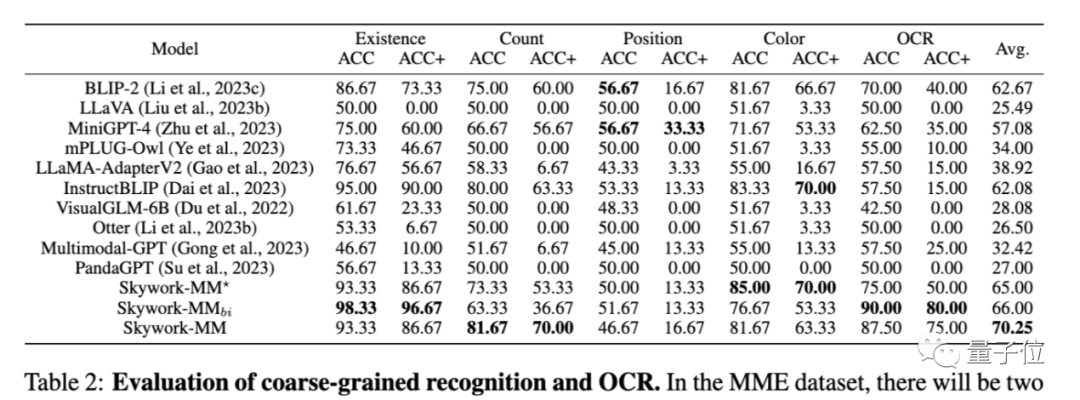

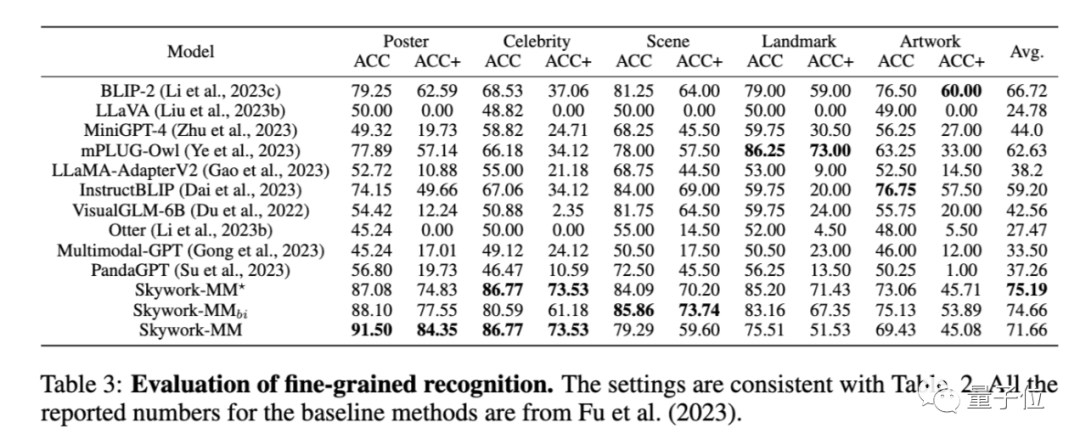

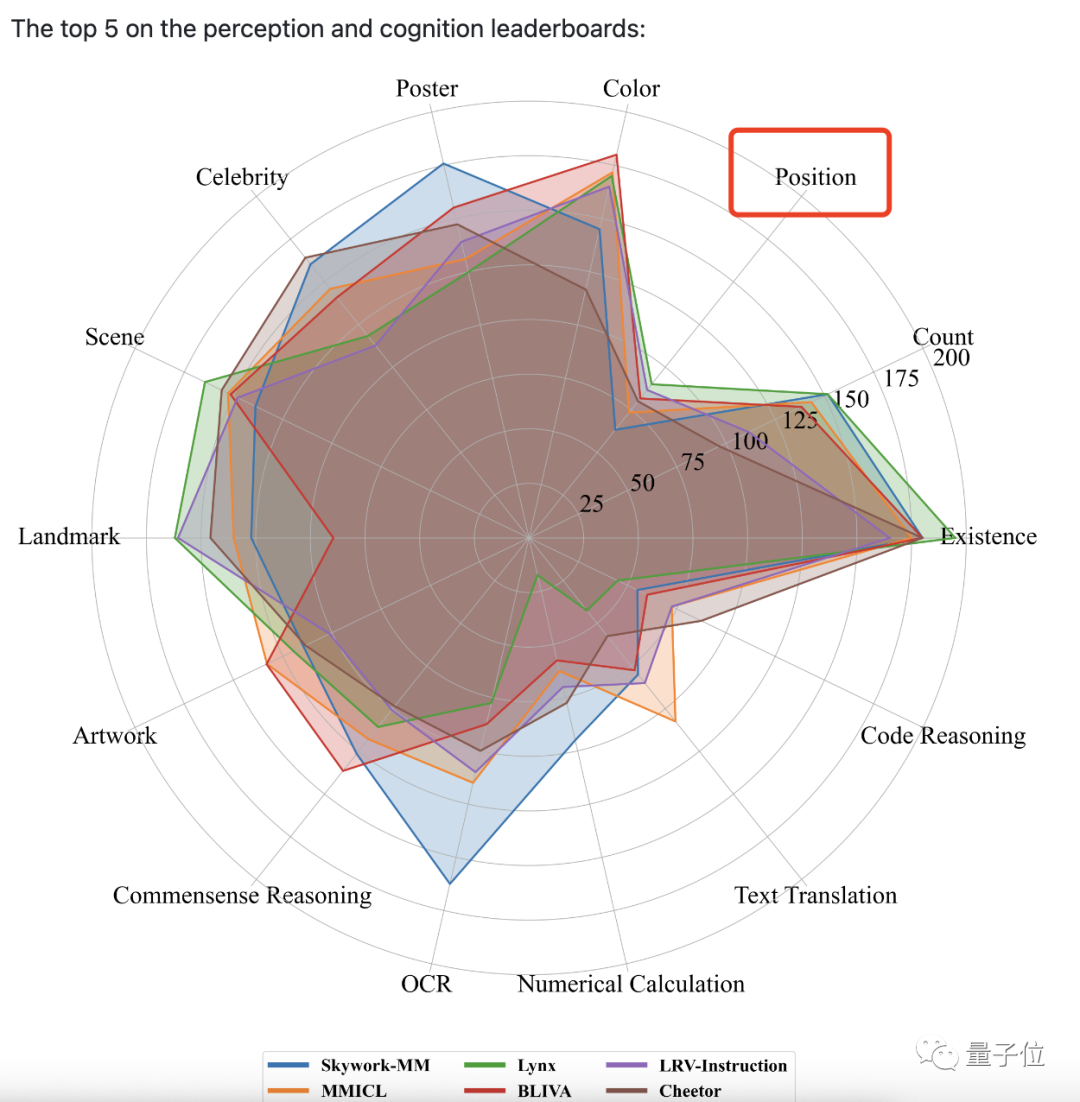

它一共包含14個子任務,其中感知任務除OCR,還包括粗粒度和細粒度對象識別,前者識別對象的存在與否、數(shù)量、位置和顏色;后者識別電影海報、名人、場景、地標和藝術品。

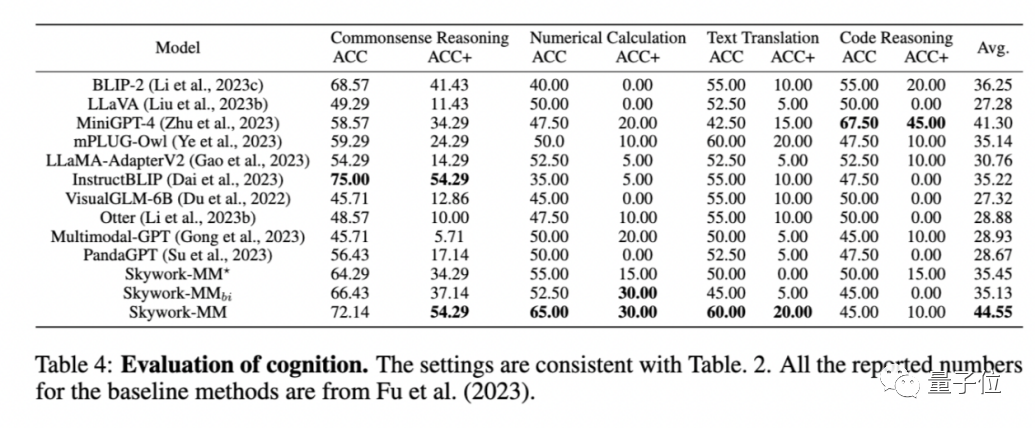

認知任務則包括常識推理、數(shù)值計算、文本翻譯和代碼推理。

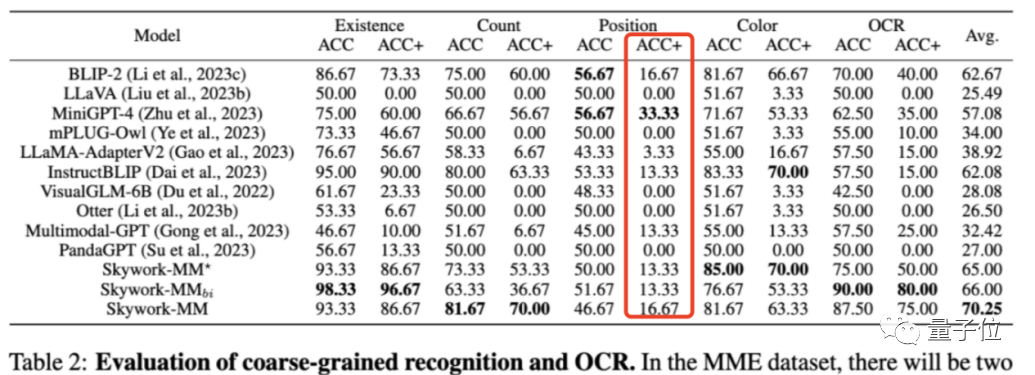

下表顯示Skywork-MM在該榜單感知任務中的OCR+粗粒度識別上的具體得分:

細粒度識別得分:

以及認知任務得分:

可以看到,能與Skywork-MM偶爾“平分秋色”的只有MiniGPT-4和BLIP系列。

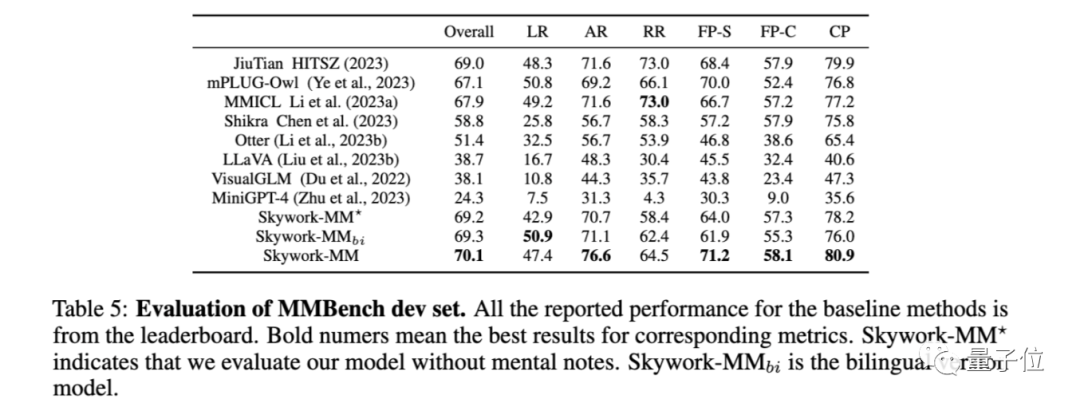

而除了MME榜單,Skywork-MM還在另一多模態(tài)基準MMBench的開發(fā)集上表現(xiàn)出色:

進步空間

需要注意的是,盡管昆侖萬維天工大模型這一最新成果,代表了當前多模態(tài)大模型的最高水平,但它還是存在很多進步空間。

例如:

文化和語言障礙仍然存在,還需要我們開發(fā)一種多語言的LVM,更有效地提取不同文化特有的視覺特征,或者再收集更多各語言的大規(guī)模、高質量圖像文本對,確保模型準確掌握視覺概念和文本概念的關聯(lián)。

除此之外,目前的成果只建立在較小規(guī)模的基礎之上(13B),如果研究更大的多模態(tài)模型,我們在使用數(shù)據(jù)、參數(shù)設置、訓練策略等方面可能都需要進一步探索。

評估基準也還可以更全面,目前MME和MMBench的測試范圍都有限。

以及從上面的粗粒度感知識別任務榜單來看,現(xiàn)有所有多模態(tài)大模型對于根據(jù)圖片準確識別物體位置的能力(對實現(xiàn)機器人感知意義重大)都比較欠缺:

最高的模型得分才33.33,離滿分100還有很大的差距。

這個缺陷從下圖也可以看出:

毫無疑問的是,人工智能的未來一定是多模態(tài)的。

以上這些問題說明,我們才剛剛開始探索它真正的潛力。

然而,我們相信,在一次又一次的榜單排名更迭之中,屬于多模態(tài)大模型的“ChatGPT時刻”終將會到來。

論文地址:https://github.com/will-singularity/Skywork-MM/blob/main/skywork_mm.pdf

榜單地址:https://github.com/BradyFU/Awesome-Multimodal-Large-Language-Models/tree/Evaluation