文生圖新SOTA!Pika北大斯坦福聯合推出RPG,多模態助力解決文生圖兩大難題

近日,北大、斯坦福、以及爆火的Pika Labs聯合發表了一項研究,將大模型文生圖的能力提升到了新的高度。

論文地址:https://arxiv.org/pdf/2401.11708.pdf

代碼地址:https://github.com/YangLing0818/RPG-DiffusionMaster

論文作者提出了一個全新的免訓練文本到圖像生成/編輯框架,利用多模態大語言模型(MLLM)強大的思維鏈推理能力,來增強文本到圖像擴散模型的組合性。

簡單來說,就是能讓文生圖模型在面對「多個屬性和關系的多個對象的復雜文本提示」時表現更出色。

話不多說,直接上圖:

A green twintail girl in orange dress is sitting on the sofa while a messy desk under a big window on the left, a lively aquarium is on the top right of the sofa, realistic style.

一個穿著橙子連衣裙的綠色雙馬尾女孩坐在沙發上,左邊的大窗戶下是一張凌亂的辦公桌,沙發右上方是一個活潑的水族館,現實主義風格。

面對關系復雜的多個對象,模型給出的整個畫面的結構、人與物品的關系都非常合理,使觀者眼前一亮。

而對于同樣的提示,我們來看一下當前最先進的SDXL和DALL·E 3的表現:

再看一下新框架面對多個對象綁定多個屬性時的表現:

From left to right, a blonde ponytail Europe girl in white shirt, a brown curly hair African girl in blue shirt printed with a bird, an Asian young man with black short hair in suit are walking in the campus happily.

從左到右,一個穿著白色襯衫、扎著金發馬尾辮的歐洲女孩,一個穿著印著小鳥的藍色襯衫、棕色卷發的非洲女孩,一個穿著西裝、黑色短發的亞洲年輕人正開心地在校園里散步。

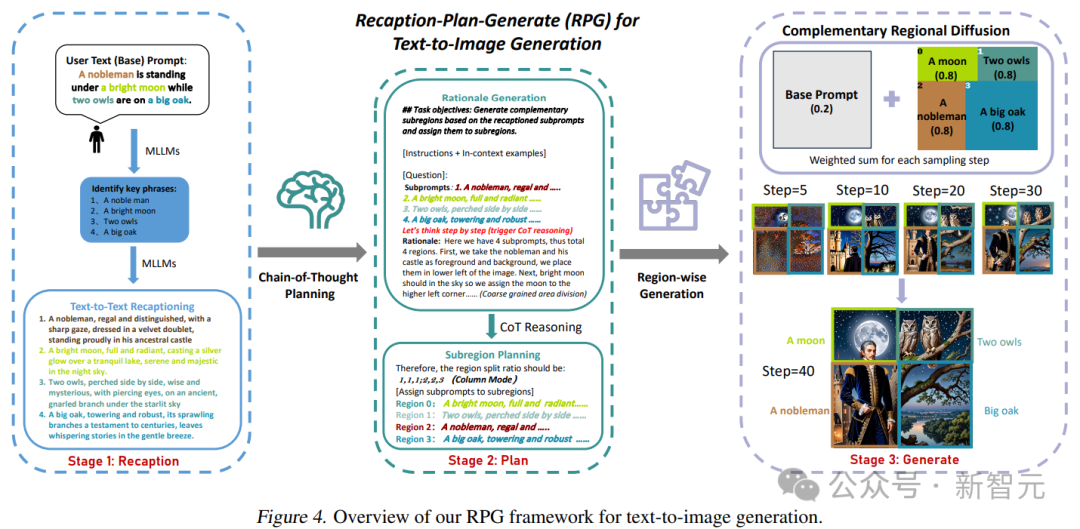

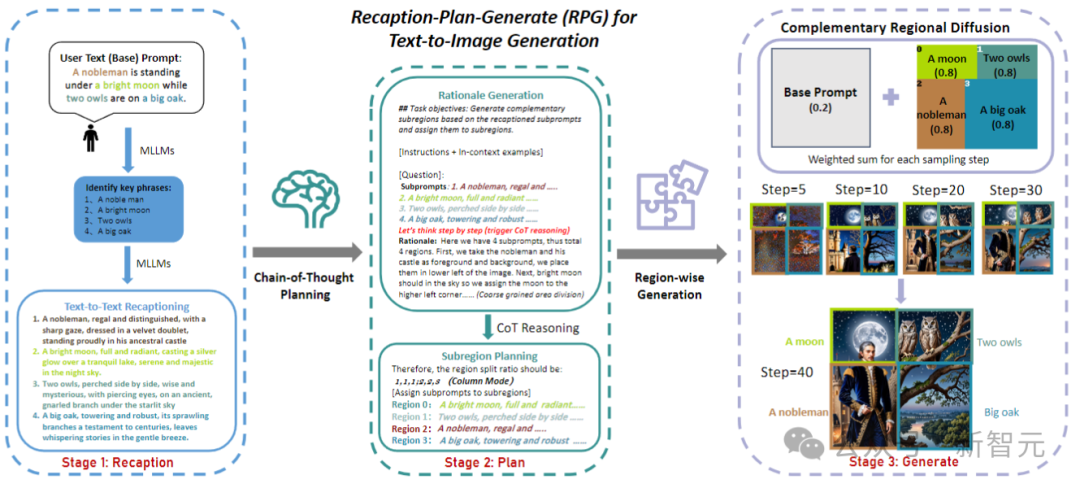

研究人員將這個框架命名為RPG(Recaption,Plan and Generate),采用MLLM作為全局規劃器,將復雜圖像的生成過程分解為子區域內多個更簡單的生成任務。

文中提出了互補的區域擴散,實現區域組合生成,還將文本引導的圖像生成和編輯以閉環方式集成到了RPG框架中,從而增強了泛化能力。

實驗表明,本文提出的RPG框架優于目前最先進的文本圖像擴散模型,包括DALL·E 3和SDXL,尤其是在多類別對象合成以及文本圖像語義對齊方面。

值得注意的是,RPG框架可以廣泛兼容各種MLLM架構(如MiniGPT-4)和擴散骨干網絡(如ControlNet)。

RPG

當前的文生圖模型主要存在兩個問題:1. 基于布局或基于注意力的方法只能提供粗略的空間引導,并且難以處理重疊的對象;2. 基于反饋的方法需要收集高質量的反饋數據,并產生額外的訓練成本。

為了解決這些問題,研究人員提出了RPG的三個核心策略,如下圖所示:

給定一個包含多個實體和關系的復雜文本提示,首先利用MLLM將其分解為基本提示和高度描述性的子提示;隨后,利用多模態模型的CoT規劃將圖像空間劃分為互補的子區域;最后,引入互補區域擴散來獨立生成每個子區域的圖像,并在每個采樣步驟中進行聚合。

多模態重新調整

將文本提示轉換為高度描述性的提示,提供信息增強的提示理解和擴散模型中的語義對齊。

使用MLLM來識別用戶提示y中的關鍵短語,獲得其中的子項:

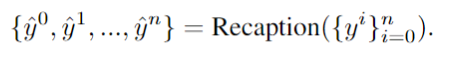

使用LLM將文本提示符分解為不同的子提示符,并進行更詳細的重新描述:

通過這種方式,可以為每個子提示生成更密集的細粒度細節,以有效地提高生成圖像的保真度,并減少提示和圖像之間的語義差異。

思想鏈規劃

將圖像空間劃分為互補的子區域,并為每個子區域分配不同的子提示,同時將生成任務分解為多個更簡單的子任務。

具體來說,將圖像空間H×W劃分為若干互補區域,并將每個增強子提示符分配給特定區域R:

利用MLLM強大的思維鏈推理能力,進行有效的區域劃分。通過分析重新獲得的中間結果,就能為后續的圖像合成生成詳細的原理和精確的說明。

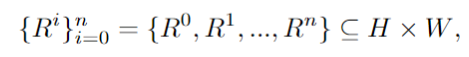

補充區域擴散

在每個矩形子區域內,獨立生成由子提示引導的內容,隨后調整大小和連接的方式,在空間上合并這些子區域。

這種方法有效地解決了大模型難以處理重疊對象的問題。此外,論文擴展了這個框架,以適應編輯任務,采用基于輪廓的區域擴散,從而對需要修改的不一致區域精確操作。

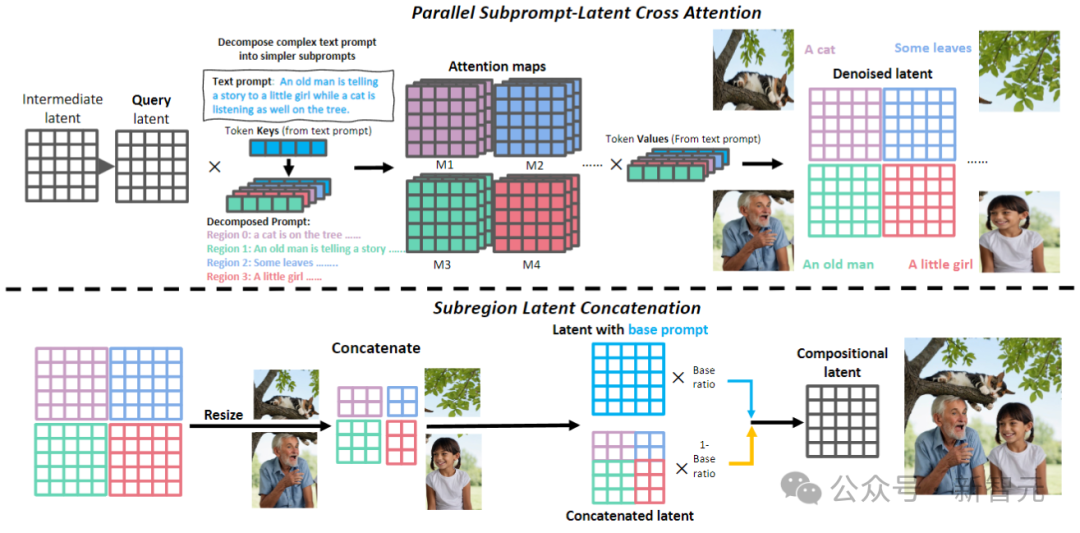

文本引導的圖像編輯

如上圖所示。在復述階段,RPG采用MLLM作為字幕來復述源圖像,并利用其強大的推理能力來識別圖像和目標提示之間的細粒度語義差異,直接分析輸入圖像如何與目標提示對齊。

使用MLLM(GPT-4、Gemini Pro等)來檢查輸入與目標之間關于數值準確性、屬性綁定和對象關系的差異。由此產生的多模態理解反饋將被交付給MLLM,用于推理編輯計劃。

我們來看一下生成效果在以上三個方面的表現,首先是屬性綁定,對比SDXL、DALL·E 3和LMD+:

我們可以看到在全部三項測試中,只有RPG最準確地反映了提示所描述的內容。

然后是數值準確性,展示順序同上(SDXL、DALL·E 3、LMD+、RPG):

——沒想到數數這件事情對于文生圖大模型還挺難的,RPG輕松戰勝對手。

最后一項是還原提示中的復雜關系:

此外,還可以將區域擴散擴展為分層格式,將特定子區域劃分為更小的子區域。

如下圖所示,當增加區域分割的層次結構時,RPG可以在文本到圖像的生成方面實現顯著的改進。這為處理復雜的生成任務提供了一個新的視角,使我們有可能生成任意組成的圖像。