實現輸入到輸出「模態自由」, NUS華人團隊開源NExT-GPT,最接近AGI的大一統多模態大模型來了

ChatGPT 的誕生,引爆了 2023 年的基于大語言模型的 AI 浪潮,此后各類開源大語言模型陸續問世,包括 Flan-T5、Vicuna、 LLaMA、Alpaca 等。隨后,社區繼續發力,為模擬這個多模態的世界,研究者們將純語言的大模型擴展到了處理語言之外的多模態大語言模型,諸如支持圖像類的 MiniGPT-4、BLIP-2、Flamingo、InstructBLIP 等,支持視頻類的 Video-LLaMA、PandaGPT 等,以及支持聲音類的 SpeechGPT 等等。

但目前的多模態大語言模型,距離真正人類級別的 AGI,總感覺少了點「內味」。沒錯,人類的認知和溝通必須無縫地在任何信息模態之間進行轉換。作為人類,我們不僅僅可以理解多模態內容,還能夠以多模態的方式靈活輸出信息。

對于現有的大語言模型,一方面,其大多局限于關注于某種單一模態信息的處理,而缺乏真正「任意模態」的理解;另一方面,其都關注于多模態內容在輸入端的理解,而不能以任意多種模態的靈活形式輸出內容。

正當大家都在期待 OpenAI 未來要發布的 GPT-5 是否能實現任意模態大一統功能時,幾天前,來自于新加坡國立大學的 NExT++ 實驗室的華人團隊率先開源了一款「大一統」通用多模態大模型「NExT-GPT」,支持任意模態輸入到任意模態輸出。目前 NExT-GPT 的代碼已經開源,并且上線了 Demo 系統。

- 項目地址:https://next-gpt.github.io

- 代碼地址:https://github.com/NExT-GPT/NExT-GPT

- 論文地址:https://arxiv.org/abs/2309.05519

該實驗室在多模態學習方向的研究有著多年的耕耘,具有深厚的積累,而 NExT-GPT 的取名也雙關了實驗室的名字以及 GPT of Next generation 的寓意。

NExT-GPT 一經發布便受到了 AI 社區的大量關注。有網友表示,NExT-GPT 標識著全能型 LLM 的到來:

也有網友贊嘆,這才是未來的 LLM 大趨勢(大一統任意模態輸入輸出的 LLM):

接下來,我們來看看 NExT-GPT 可以實現哪些功能:

- Text → Text + Image + Audio

- Text + Image → Text + Image + Video + Image

- Text + Video → Text + Image

- Text + Video → Text + Audio

- Text + Audio → Text + Image + Video

- Text → Text + Image + Audio + Video

- Text → Text + Image

- Text + Video → Text + Image + Audio

- Text → Text + Image + Audio + Video

- Text → Text + Image

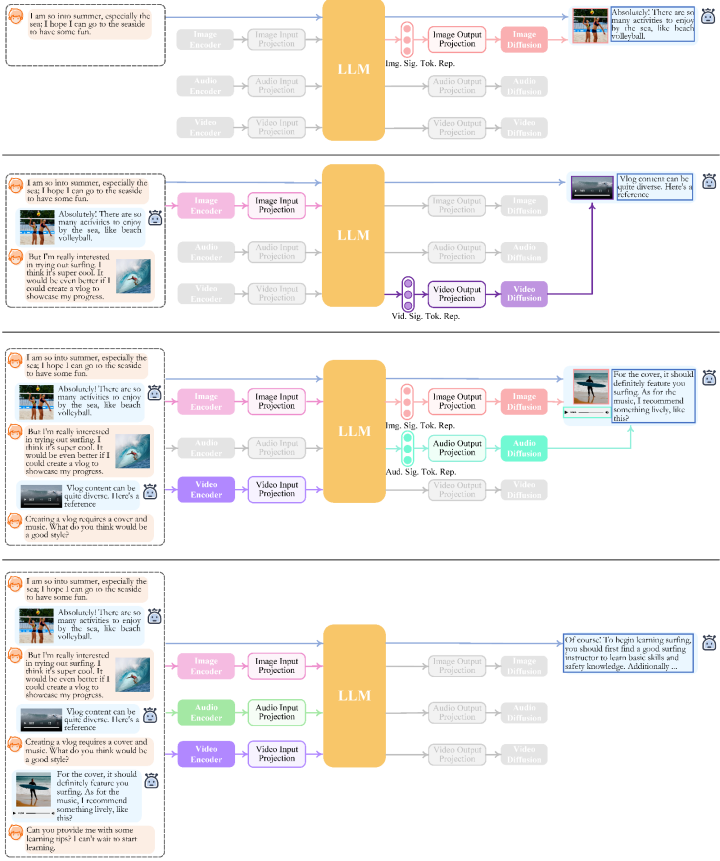

可看到,NExT-GPT 能夠準確理解用戶所輸入的各類組合模態下的內容,并準確靈活地返回用戶所要求的甚至隱含的多模態內容,常見的圖生文、圖生視頻、看圖像 / 聲音 / 視頻說話、圖像 / 聲音 / 視頻問答等問題統統不在話下,統一了跨模態領域的大部分常見任務,做到了真正意義上的任意到任意模態的通用理解能力。

作者在論文中還給出一些定量的實驗結果驗證,感興趣的讀者可以閱讀論文內容。

技術細節

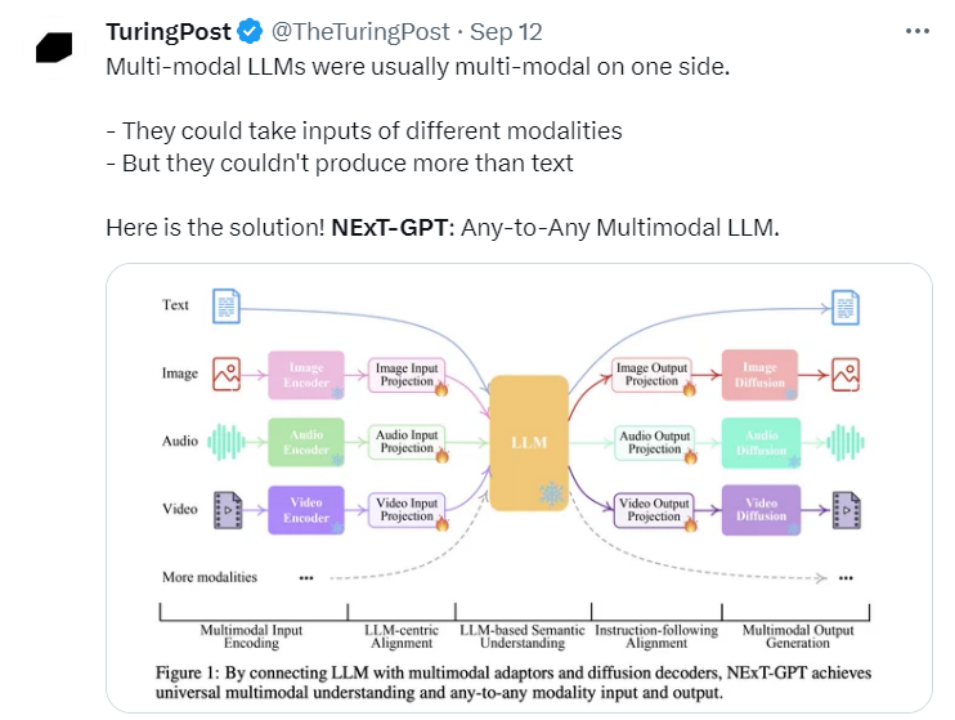

那 NExT-GPT 是如何實現任意模態輸入到任意模態輸出的?原理非常簡單,作者甚至表示在技術層面上「沒有顯著的創新點」:通過有機地連接現有的開源 1) LLM, 2) 多模態編碼器和 3) 各種模態擴散解碼器,便構成了 NExT-GPT 的整體框架,實現任意模態的輸入和輸出,可謂大道至簡。

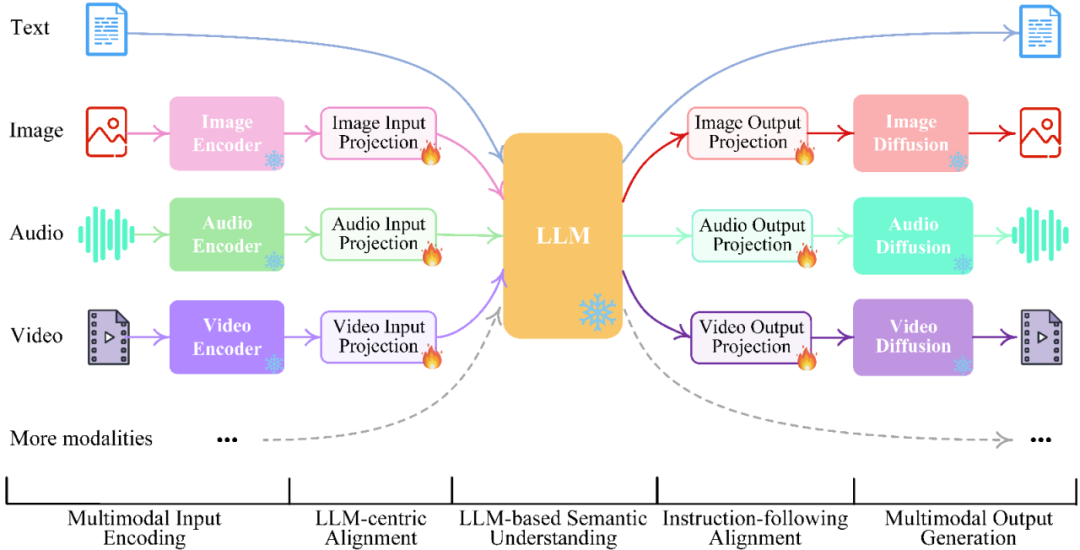

NExT-GPT 整體呈現為一個「編碼端 - 推理中樞 - 解碼器」三層架構:

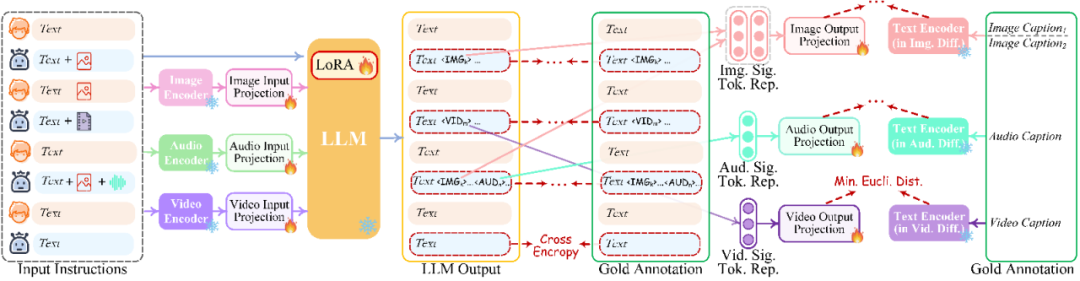

- 多模編碼階段:利用已開源的編碼器對各種輸入模態進行編碼,然后通過一個投影層將這些特征投影為 LLM 所能夠理解的「類似語言的」表征。作者采用了 MetaAI 的 ImageBind 統一多模態編碼器。

- 推理中樞階段:利用開源 LLM 作為核心大腦來處理輸入信息,進行語義理解和推理。LLM 可以直接輸出文本,同時其還將輸出一種「模態信號」token,作為傳遞給后層解碼端的指令,通知他們是否輸出相應的模態信息,以及輸出什么內容。作者目前采用了 Vicuna 作為其 LLM。

- 多模生成階段:利用各類開源的圖像擴散模型、聲音擴散模型以及視頻擴散模型,接收來自 LLM 的特定指令信號,并輸出所對應的模型內容(如果需要生成的指令)。

模型在推理時,給定任意組合模態的用戶輸入,通過模態編碼器編碼后,投影器將其轉換為特征傳遞給 LLM(文本部分的輸入將會直接出入到 LLM)。然后 LLM 將決定所生成內容,一方面直接輸出文本,另一方面輸出模態信號 token。如果 LLM 確定要生成某種模態內容(除語言外),則會輸出對應的模態信號 token,表示該模態被激活。技術示意圖如下:

文中作者指出,NExT-GPT 可能并不是實現任意模態輸入到任意模態輸出功能的首個工作。目前有兩類前驅工作:

- 一類是不久前所發布的 CoDi 模型,其整合了各種模態的 diffusion 模型,可以同時處理和生成各種組合的模態內容。然而作者指出,CoDi 由于缺乏 LLMs 作為其核心部件,其僅限于成對(Parallel)內容的輸入和生成,而無法實現復雜的內容推理和決策,根據用戶輸入的指令靈活響應。

- 另一類工作則試圖將 LLMs 與現有的外部工具結合,以實現近似的「任意多模態」理解和生成,代表性的系統如 Visual-ChatGPT 和 HuggingGPT。但作者指出,由于這類系統在不同模塊之間的信息傳遞完全依賴于 LLM 所生成的文本,其割裂、級聯的架構容易不可避免地引入了噪音,降低不同模塊之間的特征信息傳遞效用。并且其僅利用現有外部工作進行預測,缺乏一種整體的端到端訓練,這對于充分理解用戶的輸入內容和指令是不利的。

而 NExT-GPT 可以良好地解決如上所述的現有工作問題。那么 NExT-GPT 有哪些關鍵點呢?

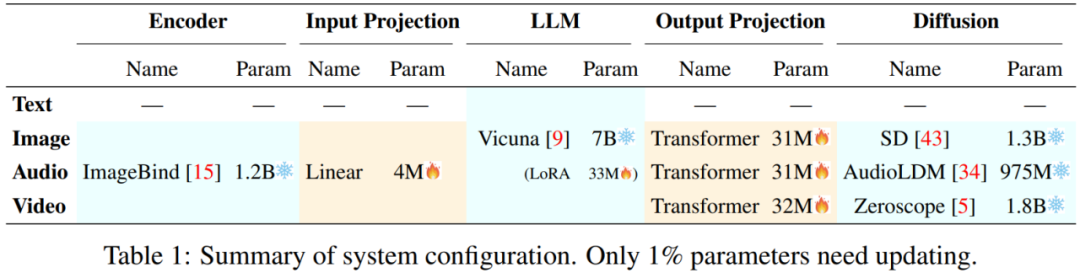

- 關鍵點-1:低成本實現復雜推理 + 多模態 in 和多模態 out

如前文所述,不僅要繼承 LLM 所具備的復雜內容理解和推理能力,還需要實現任意模態的輸入和輸出。若考慮從零開始構建整個系統,代價將會巨大(除非是大廠才能承擔成本),也不利于開源和傳播。考慮到現有的大模型已經基本實現了多模態的輸入,為實現全能的大一統多模態能力,因此最關鍵的一點在于高性能的多模態輸出。為此,NExT-GPT 完全基于現有開源的高性能模塊(比如目前性能最強的擴散模型),充分站在巨人的肩膀上,以最低的成本實現大一統多模態大模型的構建目標(實驗室可承擔級別的成本)。

- 關鍵點-2:高效率端到端訓練和模態對齊學習

妥當的、端到端的系統訓練是 NExT-GPT 區別于現有其他組合型統一大模型系統最重要的一點,也是保證 NExT-GPT 具有優秀性能的前提。另一方面,還需要充分對齊系統中的所有模態的特征表征。為了既保證具有較好的學習成效,又全面降低、控制學習成本,本工作包含了以下的亮點。

首先,NExT-GPT 考慮分別在編碼層 - LLM 之間以及 LLM - 解碼層之間插入投影層(Projection Layers)。在凍結大規模參數的基座「編碼層 - LLM - 解碼層」情況下,僅去訓練參數量極低的投影層部分(以及在指令微調時基于 LoRA 的 LLM 低代價更新),作者實現了僅僅 1% 參數量的訓練代價。

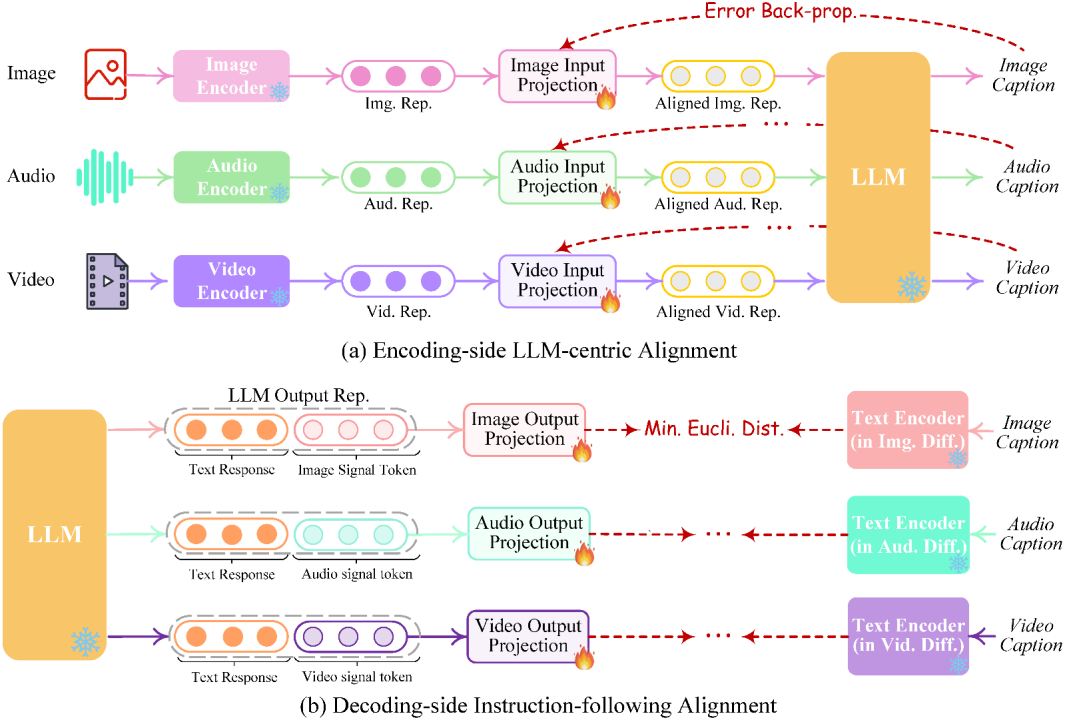

具體通過 1)以 LLM 為中心的編碼端多模態對齊學習,和 2)局部微調的解碼端指令跟隨增強學習實現。

另外,對于多模態大模型,為確保其能夠充分忠于用戶指令而響應,進一步的指令調整(IT)是非常有必要的。不同于現有的多模態大模型其輸出端僅涉及到文本,我們的 NExT-GPT 系統,其輸入和輸出端同時覆蓋了各類模態信息。

為此,作者提出了一種模態切換指令微調學習(Modality-switching Instruction Tuning,MosIT),技術內涵如下圖所示。同時,由于現存的多模態指令微調數據集都無法滿足任意多模態 LLM 場景(即 MosIT)的要求,我們因此構建了一套 MosIT 數據集。該數據涵蓋了各種多模態輸入和輸出,提供了必要的復雜性和變異性,幫助提升 NExT-GPT 獲得優越的多模態指令跟隨和相應能力。

結論和未來展望

總體上,NExT-GPT 系統展示了構建一個通用大一統多模態的 AI 模型的美好景愿和喜人的可能性,這將為 AI 社區中后續的更「人類水平」的人工智能研究提供寶貴的借鑒。

基于 NExT-GPT,后續的研究工作可以考慮以下幾個方面:

1. 模態與任務擴展:受限于現有資源,目前作者所開源的 NExT-GPT 系統僅支持四種模態:語言、圖像、視頻和音頻。作者表示,后續會逐步擴展到更多的模態(例如,網頁、3D 視覺、熱圖、表格和圖表)和任務(例如,對象檢測、分割、定位和跟蹤),以擴大系統的普遍適用性。

2. 考慮更多基座 LLM:目前作者實現了基于 7B 版本的 Vicuna LLM,其表示下一步將整合不同大小的 LLM,以及其他 LLM 類型。

3. 多模態生成策略:目前版本的 NExT-GPT 系統僅考慮了基于擴散模型的純輸出方式的多模態輸出。然而生成模式容易輸出錯誤幻想內容(Hallucination),并且輸出內容的質量往往容易受到擴散模型能力的限制。因此,進一步提升擴散模型的性能很關鍵,這能直接幫助提高多模態內容的輸出質量。另外,實際上可以整合基于檢索的方法來補充基于生成的過程的弊端,從而提升整體系統的輸出可靠性。

4. 降低多模態支持成本:可以考慮進一步降低對更多模態的支持的成本。NExT-GPT 考慮了 ImageBind 來統一多種模態的編碼,從而節省了在編碼端的代價。而對于多模態輸出端,作者簡單地集成了多個不同模態的擴散模型。如何防止隨著模態的增加而動態增加解碼器是后續的重要研究方面。比如可以考慮將一些支持不同模態生成(但具有模態共性)的擴散模型進行復用。

5. MosIT 數據集擴展:目前 NExT-GPT 所使用的 MosIT 數據集規模受限,這也會限制其與用戶的交互表現。后續研究可以進一步提升模態切換指令微調學習策略以及數據集。