大模型可解釋性你能理得清嗎?綜述已來,一文解你疑惑

大規模語言模型在自然語言處理方面展現出令人驚訝的推理能力,但其內在機理尚不清晰。隨著大規模語言模型的廣泛應用,闡明模型的運行機制對應用安全性、性能局限性和可控的社會影響至關重要。

近期,中美多家研究機構(新澤西理工學院、約翰斯?霍普金斯大學、維克森林大學、佐治亞大學、上海交大、百度等)聯合發布了大模型可解釋性技術的綜述,分別對傳統的 fine-tuning 模型和基于 prompting 的超大模型的可解釋性技術進行了全面的梳理,并探討了模型解釋的評估標準和未來的研究挑戰。

- 論文鏈接:https://arxiv.org/abs/2309.01029

- Github 鏈接:https://github.com/hy-zhao23/Explainability-for-Large-Language-Models

解釋大模型的難點在什么地方?

為何解釋大模型有點難?大語言模型在自然語言處理任務上的驚艷表現引起了社會廣泛的關注。與此同時,如何解釋大模型在跨任務中令人驚艷的表現是學術界面臨的迫切挑戰之一。不同于傳統的機器學習或者深度學習模型,超大的模型架構和海量的學習資料使得大模型具備了強大的推理泛化能力。大語言模型 (LLMs) 提供可解釋性的幾個主要難點包括:

- 模型復雜性高。區別于 LLM 時代之前的深度學習模型或者傳統的統計機器學習模型,LLMs 模型規模巨大,包含數十億個參數,其內部表示和推理過程非常復雜,很難針對其具體的輸出給出解釋。

- 數據依賴性強。LLMs 在訓練過程中依賴大規模文本語料,這些訓練數據中的偏見、錯誤等都可能影響模型,但很難完整判斷訓練數據的質量對模型的影響。

- 黑箱性質。我們通常把 LLMs 看做黑箱模型,即使是對于開源的模型來說,比如 Llama-2。我們很難顯式地判斷它的內部推理鏈和決策過程,只能根據輸入輸出進行分析,這給可解釋性帶來困難。

- 輸出不確定性。LLMs 的輸出常常存在不確定性,對同一輸入可能產生不同輸出,這也增加了可解釋性的難度。

- 評估指標不足。目前對話系統的自動評估指標還不足以完整反映模型的可解釋性,需要更多考慮人類理解的評估指標。

大模型的訓練范式

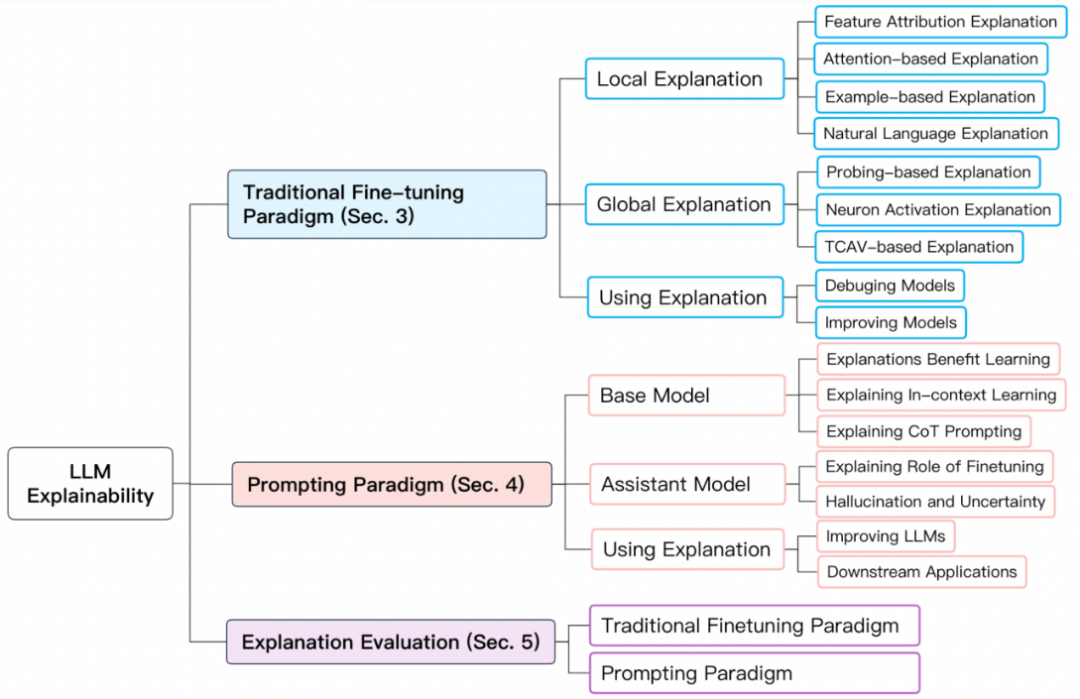

為了更好的歸納總結大模型的可解釋性,我們將 BERT 及以上級別的大模型的訓練范式分為兩種:1)傳統 fine-tuning 范式;2)基于 prompting 的范式。

1.傳統 fine-tuning 范式

對于傳統 fine-tuning 范式,首先在一個較大的未標記的文本庫上預訓練一個基礎語言模型,再通過來自特定領域的標記數據集進行 fine-tuning。常見的此類模型有 BERT, RoBERTa, ELECTRA, DeBERTa 等。

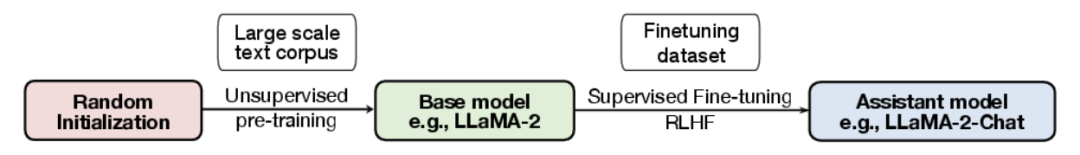

2.基于 prompting 的范式

基于 prompting 的范式通過使用 prompts 實現 zero-shot 或者 few-shot learning。與傳統 fine-tuning 范式相同,需要預訓練基礎模型。但是,基于 prompting 范式的微調通常由 instruction tuning 和 reinforcement learning from human feedback (RLHF) 實現。常見的此類模型包括 GPT-3.5, GPT 4, Claude, LLaMA-2-Chat, Alpaca, Vicuna 等。其訓練流程如下圖:

基于傳統 fine-tuning 范式的模型解釋

基于傳統 fine-tuning 范式的模型解釋包括對單個預測的解釋(局部解釋)和對模型結構級別組分如神經元,網絡層等的解釋(全局解釋)。

1.局部解釋

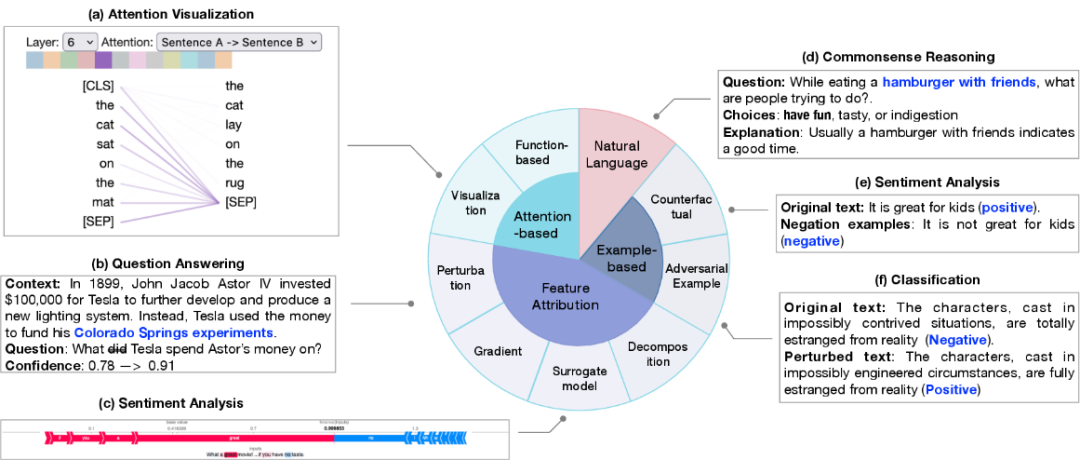

局部解釋對單個樣本預測進行解釋。其解釋方法包括特征歸因(feature attribution)、基于注意力機制的解釋(attention-based)、基于樣本的解釋(example-based)、基于自然語言的解釋(natural language explanation)。

(1) 特征歸因旨在衡量每個輸入特征(例如單詞、短語、文本范圍)與模型預測的相關性。特征歸因方法可以分類為:

- 基于擾動的解釋,通過修改其中特定的輸入特征觀察對輸出結果的影響;

- 基于梯度的解釋,將輸出對輸入的偏微分作為相應輸入的重要性指標;

- 替代模型,使用簡單的人類可理解的模型去擬合復雜模型的單個輸出,從而獲取各輸入的重要性;

- 基于分解的技術,旨在將特征相關性得分進行線性分解。

(2) 基于注意力的解釋:注意力通常被作為一種關注輸入中最相關部分的途徑,因此注意力可能學習到可以用于解釋預測的相關性信息。常見的注意力相關的解釋方法包括:

- 注意力可視化技術,直觀地觀察注意力分數在不同尺度上的變化;

- 基于函數的解釋,如輸出對注意力的偏微分。然而,學術界對于將注意力作為一個研究角度依然充滿爭議。

(3) 基于樣本的解釋從個例的角度對模型進行探測和解釋,主要分為:對抗樣本和反事實樣本。

- 對抗樣本是針對模型對微小變動非常敏感的特性而生成的數據,自然語言處理中通常通過修改文本得到,人類難以區別的文本變換通常會導致模型產生不同的預測。

- 反事實樣本則是通過將文本進行如否定的變形,通常也是對模型因果推斷能力的檢測。

(4) 自然語言解釋使用原始文本和人工標記的解釋進行模型訓練,使得模型可以生成自然語言解釋模型的決策過程。

2.全局解釋

全局解釋旨在從模型構成的層面包括如神經元,隱藏層和更大的組塊,為大模型的工作機制提供更高階的解釋。主要探究在不同網絡構成部分學習到的語義知識。

- 基于探針的解釋 探針解釋技術主要基于分類器進行探測,通過在預訓練模型或者微調模型上訓練一個淺層分類器,然后在一個 holdout 數據集上進行評估,使得分類器能夠識別語言特征或推理能力。

- 神經元激活 傳統神經元激活分析只考慮一部分重要的神經元,再學習神經元與語義特性之間的關系。近來,GPT-4 也被用于解釋神經元,不同于選取部分神經元進行解釋,GPT-4 可以用于解釋所有的神經元。

- 基于概念的解釋 將輸入先映射到一組概念中,再通過測量概念對預測的重要性來對模型進行解釋。

基于 prompting 范式的模型解釋

基于 prompting 范式的模型解釋,需要對基礎模型和助手模型分別解釋以區別兩種模型的能力,并探究模型學習的路徑。其探究的問題主要包括:為模型提供解釋對 few-shot learning 的益處;理解 few-shot learning 和思維鏈能力的來源。

1.基礎模型解釋

- 解釋對模型學習的好處 探究在 few-shot learning 的情況下解釋是否對模型學習有幫助。

- 情境學習 探究情境學習在大模型中的作用機制,以及區分情境學習在大模型中和中等模型中的區別。

- 思維鏈 prompting 探究思維鏈 prompting 提高模型的表現的原因。

2.助手模型解釋

- Fine-tuning 的角色 助手模型通常先經過預訓練獲得通用語義知識,在通過監督學習和強化學習獲取領域內知識。而助手模型的知識主要來源于哪個階段依然有待研究。

- 幻覺與不確定性 大模型預測的準確性和可信度依然是目前研究的重要課題。盡管大模型的推理能力強大,但其結果常常出現錯誤信息和幻覺。這種預測的不確定性為其廣泛應用帶來了巨大的挑戰。

模型解釋的評估

模型解釋的評估指標包含合理性 (plausibility),忠實度 (faithfulness),穩定性 (stability),魯棒性 (robustness) 等。論文主要講述了兩個被廣泛關注的圍度:1)對人類的合理性;2)對模型內在邏輯的忠實度。

對傳統 fine-tuning 模型解釋的評估主要集中在局部解釋上。合理性通常需要將模型解釋與人工標注的解釋按照設計的標準進行測量評估。而忠實性更注重量化指標的表現,由于不同的指標關注模型或數據的方面不同,對于忠實性的度量依然缺乏統一的標準。基于 prompting 模型解釋的評估則有待進一步的研究。

未來研究挑戰

1.缺乏有效的正確解釋

其挑戰來源于兩個方面:

- 缺乏設計有效解釋的標準;

- 有效解釋的缺乏導致對解釋的評估同樣缺乏支撐。

2.涌現現象的根源未知

對大模型涌現能力的探究可以分別從模型和數據的角度進行,從模型的角度,1)引起涌現現象的模型結構;2)具備跨語言任務超強表現的最小模型尺度和復雜度。從數據的角度,1)決定特定預測的數據子集;2)涌現能力與模型訓練和數據污染的關系;3)訓練數據的質量和數量對預訓練和微調各自的影響。

3.Fine-tuning 范式與 prompting 范式的區別

兩者在 in-distribution 和 out-of-distribution 的不同表現意味著不同的推理方式。1)在數據同分布(in-distribution)之下,其推理范式的不同之處;2)在數據不同分布的情況下,模型魯棒性的差異根源。

4.大模型的捷徑學習問題

兩種范式之下,模型的捷徑學習問題存在于不同的方面。盡管大模型由于數據來源豐富,捷徑學習的問題相對緩和。闡明捷徑學習形成的機理并提出解決辦法對模型的泛化依然重要。

5.注意力冗余

注意力模塊的冗余問題在兩種范式之中廣泛存在,對注意力冗余的研究可以為模型壓縮技術提供一種解決方式。

6.安全性和道德性

大模型的可解釋性對控制模型并限制模型的負面影響至關重要。如偏差、不公平、信息污染、社會操控等問題。建立可解釋的 AI 模型可以有效地避免上述問題,并形成符合道德規范的人工智能系統。