如何降低視覺Transformer計算成本?時間冗余方法讓人大吃一驚

Transformer 一開始是為自然語言處理任務設計的,但現在卻已經被廣泛用于視覺任務。視覺 Transformer 在一系列視覺識別任務上實現了出色的準確度,并在圖像分類、視頻分類和目標檢測等任務上取得了當前最優的表現。

視覺 Transformer 的一大缺點是計算成本高。典型的卷積網絡(CNN)處理每張圖像需要數十 GFlops,而視覺 Transformer 所需的往往會多上一個數量級,達到每張圖像數百 GFlops。在處理視頻時,由于數據量巨大,這個問題更為嚴重。高昂的計算成本讓視覺 Transformer 難以被部署到資源有限或有嚴格延遲需求的設備上,這就限制了這項技術的應用場景,否則我們已經有一些激動人心的應用了。

在近期一篇論文中,威斯康星大學麥迪遜分校的三位研究者 Matthew Dutson、Yin Li 和 Mohit Gupta 首先提出可以在后續輸入之間使用時間冗余來降低視覺 Transformer 在視頻應用中的成本。他們也發布了模型代碼,其中包含用于構建 Eventful Transformer 的 PyTorch 模塊。

- 論文地址:https://arxiv.org/pdf/2308.13494.pdf

- 項目地址:http://wisionlab.com/project/eventful-transformers

時間冗余:首先假設有一個視覺 Transformer,其可以逐幀或逐視頻片段地處理視頻序列。這個 Transformer 可能是簡單的逐幀處理的模型(如目標檢測器)或是某個時空模型的中間步驟(如 ViViT 的分解式模型的第一步)。不同于一個輸入就是一個完整序列的語言處理 Transformer,在這里,研究者的做法是隨時間為 Transformer 提供多個不同的輸入(幀或視頻片段)。

自然視頻包含顯著的時間冗余,即后續幀之間的差異很小。盡管如此,包括 Transformer 在內的深度網絡通常都會「從頭開始」計算每一幀。該方法會丟棄之前推理獲得的潛在相關信息,浪費極大。故而這三位研究者設想:是否可以復用之前計算步驟的中間計算結果來提升處理冗余序列的效率?

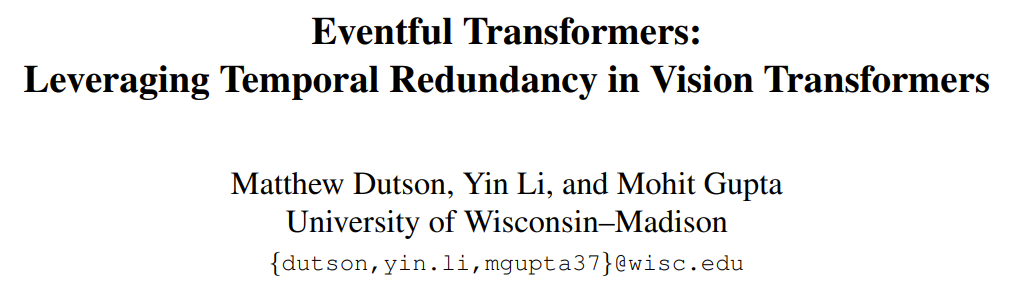

自適應推理:對于視覺 Transformer 以及一般意義上的深度網絡而言,推理成本通常由架構決定。然而在現實應用中,可用的資源可能會隨時間而變化,比如可能因為存在相競爭的進程或電源發生變化。如此一來,可能就存在運行時修改模型計算成本的需求。在這項新成果中,研究者設定的一大主要設計目標便是適應性 —— 其方法可實現對計算成本的實時控制。下圖 1(底部)給出了在視頻處理過程中修改計算預算的示例。

Eventful Transformer:本文提出了 Eventful Transformer,這類 Transformer 能利用輸入之間的時間冗余來實現高效且自適應的推理。Eventful 這一術語的靈感來自事件相機(event camera),這種傳感器能在場景變化時離散地記錄影像。Eventful Transformer 會跟蹤隨時間發生的 token 層面的變化情況,并在每個時間步驟有選擇性地更新 token 表征和自注意力映射圖。Eventful Transformer 的模塊中包含一種門控模塊,用于控制運行時間被更新 token 的數量。

該方法可用于現成的模型(通常無需再訓練)并且兼容許多視頻處理任務。研究者也進行了實驗論證,結果表明 Eventful Transformer 可用于現有的當前最佳模型,在極大降低它們的計算成本的同時還能維持其原有的準確度。

Eventful Transformer

這項研究的目標加速用于視頻識別的視覺 Transformer。在這個場景中,視覺 Transformer 需要反復處理視頻幀或視頻片段,具體的任務包括視頻目標檢測和視頻動作識別等。這里提出的關鍵思想是利用時間冗余,即復用之前時間步驟的計算結果。下面將詳細描述如何通過修改 Transformer 模塊來使其具備感知時間冗余的能力。

token 門控:檢測冗余

這一小節將介紹研究者提出的兩種新模塊:token 門和 token 緩沖器。這些模塊讓模型可以識別和更新自上次更新后有明顯變化的 token。

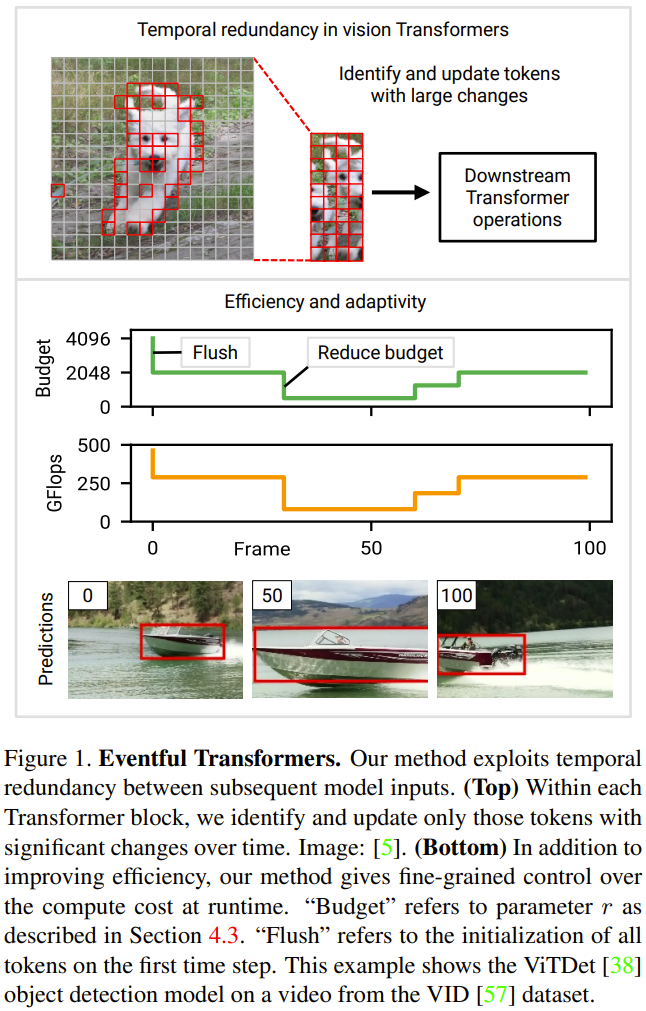

門模塊:該門會從輸入 token N 中選擇一部分 M 發送給下游層執行計算。其記憶中維護著一個參照 token 集,記為 u。這種參照向量包含每個 token 在其最近一次更新時的值。在每個時間步驟,比較各個 token 與其對應的參照值,其中與參照值相差較大的 token 獲得更新。

現在將該門的當前輸入記為 c。在每個時間步驟,按照以下流程更新門的狀態并決定其輸出(見下圖 2):

1. 計算總誤差 e = u ? c。

2. 對誤差 e 使用一個選取策略。選擇策略返回一個二元掩碼 m(相當于一個 token 索引列表),表示其中哪 M 個 token 應被更新。

3. 提取出上述策略選取的 token。圖 2 中將其描述為乘積 c×m;在實踐中則是通過沿 c 的第一個軸執行「gather」操作來實現。這里將收集到的 token 記為 ,這就是該門的輸出。

,這就是該門的輸出。

4. 將參照 token 更新成所選 token。圖 2 將這個過程描述為 ;在實踐中使用的操作則是「scatter」。在第一個時間步驟,門會更新所有 token(初始化 u ← c 并返回 c? = c)。

;在實踐中使用的操作則是「scatter」。在第一個時間步驟,門會更新所有 token(初始化 u ← c 并返回 c? = c)。

緩沖器模塊:緩沖模塊維護著一個狀態張量 ,其跟蹤的是每個輸入 token

,其跟蹤的是每個輸入 token

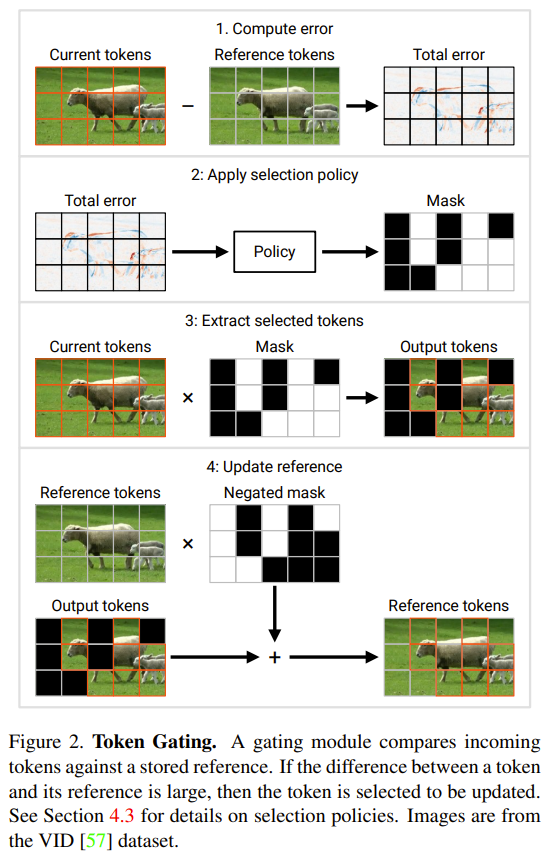

時,該緩沖器將來自 f (c?) 的 token 分散到其在 b 中對應位置。然后它返回更新后的 b 作為其輸出,參見下圖 3。

時,該緩沖器將來自 f (c?) 的 token 分散到其在 b 中對應位置。然后它返回更新后的 b 作為其輸出,參見下圖 3。

研究者將每個門與其后的緩沖器組成一對。這里給出一種簡單的使用模式:門的輸出

被傳遞給一系列針對各個 token 的運算 f (c?);然后將所得到的張量

被傳遞給一系列針對各個 token 的運算 f (c?);然后將所得到的張量 傳遞給一個緩沖器,其將恢復完整的形狀。

傳遞給一個緩沖器,其將恢復完整的形狀。

構建可感知冗余的 Transformer

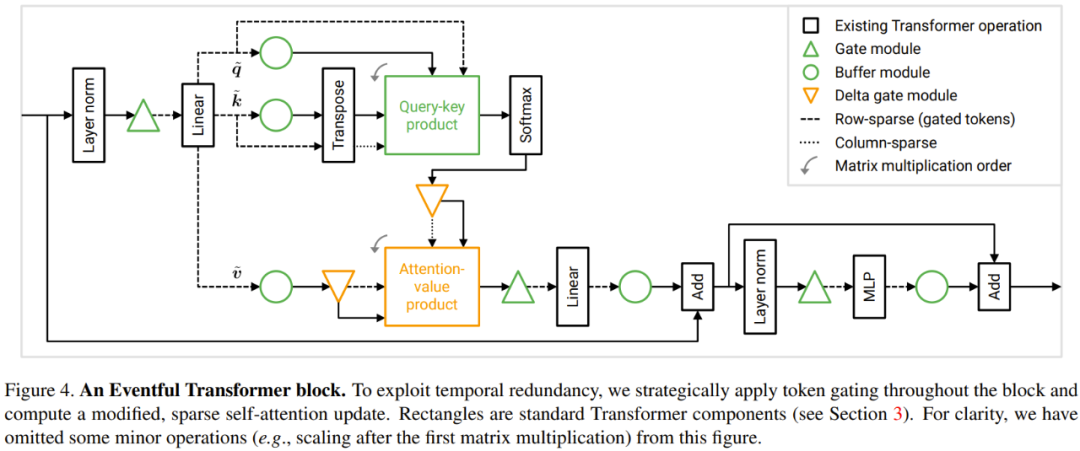

為了利用上述時間冗余,研究者提出了一種對 Transformer 模塊的修改方案。下圖 4 展示了 Eventful Transformer 模塊的設計。該方法可以加速針對各個 token 的運算(如 MLP)以及查詢 - 鍵值和注意力 - 值乘法。

在針對各個 token 的運算 Transformer 模塊中,很多運算都是針對各個 token 的,也就是說它們不涉及到 token 之間的信息交換,其中包括 MLP 和 MSA 中的線性變換。為了節省計算成本,研究者表示可以跳過未被門選取的 token 的面向 token 的運算。由于 token 之間的獨立性,這不會改變對所選 token 的運算結果。參見圖 3。

具體來說,針對各個 token 的運算(包括 W_qkv 變換、W_p 變換和 MLP)的連續序列,研究者使用了一對門 - 緩沖器。注意,他們還在 skip 連接之前添加了緩沖器以確保兩個加法操作數的 token 是正確對齊的。

針對各個 token 的運算的成本正比于 token 的數量。門可將這個數量從 N 降至 M,也就將下游的針對各個 token 的運算的計算成本降低了 N/M 倍。

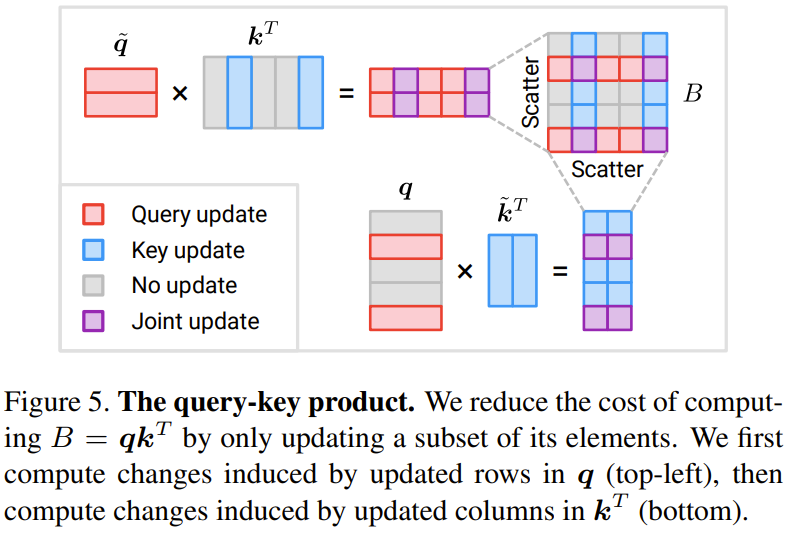

查詢 - 鍵值的積:現在來看看查詢 - 鍵值積 B = q k^T。

下圖 5 展示了稀疏地更新查詢 - 鍵值積 B 中一部分元素的方法。

這些更新的總體成本為 2NMD,相較而言,從頭開始計算 B 的成本為 N^2D。注意,新方法的成本正比于 M,即門選取的 token 的數量。當 M < N/2 時(此時更新的 token 不到總量一半),可節省計算量。

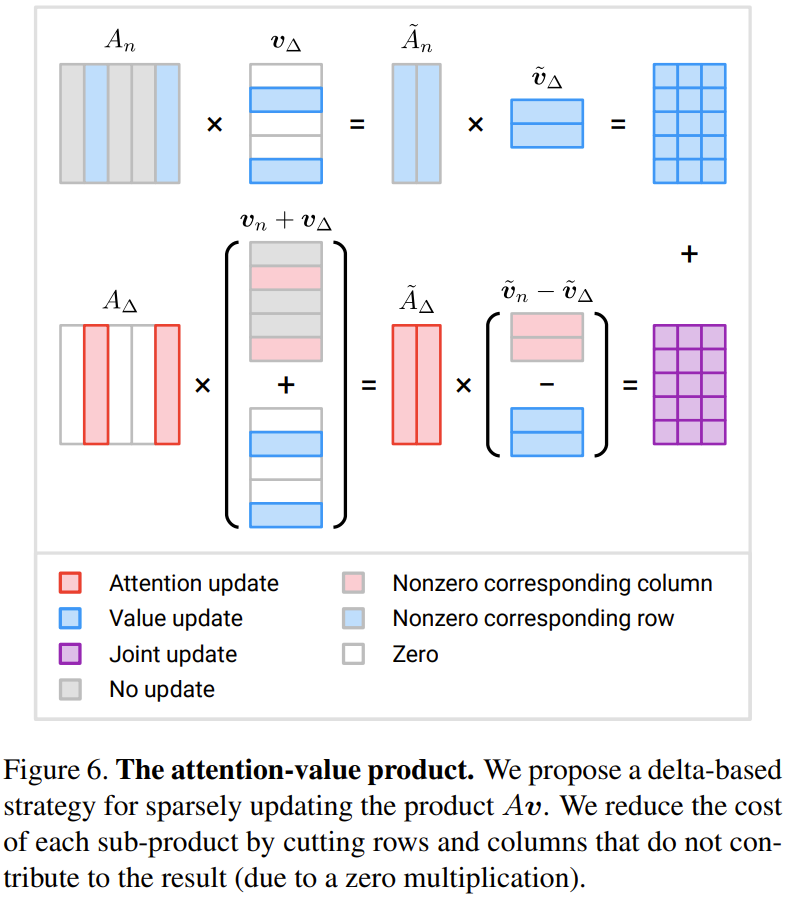

注意力 - 值的積:研究者為此提出了一種基于增量 ? 的更新策略。

下圖 6 展示了新提出的高效計算三個增量項的方法。

同樣當 M < N/2 時,可節省計算量。

token 選取策略

Eventful Transformer 的一大重要設計是其 token 選取策略。給定一個門誤差張量 e,這樣一個策略的目標是生成一個掩碼 m,其中指示了應當被更新的 token。具體的策略包括:

Top-r 策略:該策略選取 r 個誤差 e 有最大范數的 token(這里使用的是 L2 范數)。

閾值策略:該策略選取誤差 e 的范數超過一個閾值 h 的所有 token。

其它策略:更復雜精細的 token 選取策略可實現更好的準確度 - 成本權衡,比如可以使用一個輕量級策略網絡來學習一個策略。但是,訓練策略的決策機制的難度可能很大,因為二元掩碼 m 一般是不可微分的。另一個思路是使用重要度分數作為選取的參考信息。但這些想法都還有待未來研究。

實驗

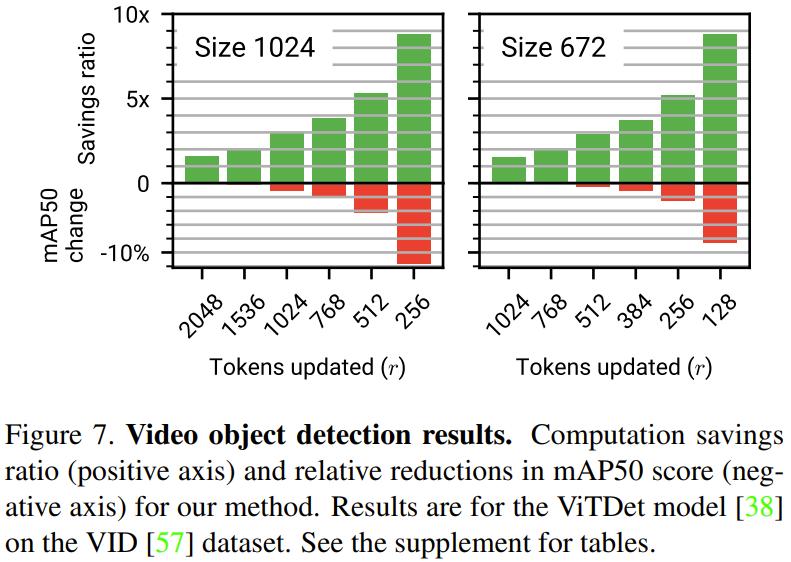

研究者用實驗評估了新提出的方法,具體使用的任務是視頻目標檢測和視頻動作識別。

下圖 7 展示了視頻目標檢測的實驗結果。其中正軸是計算節省率,負軸是新方法的 mAP50 分數的相對減少量。可以看到,新方法用少量的準確度犧牲換來了顯著的計算量節省。

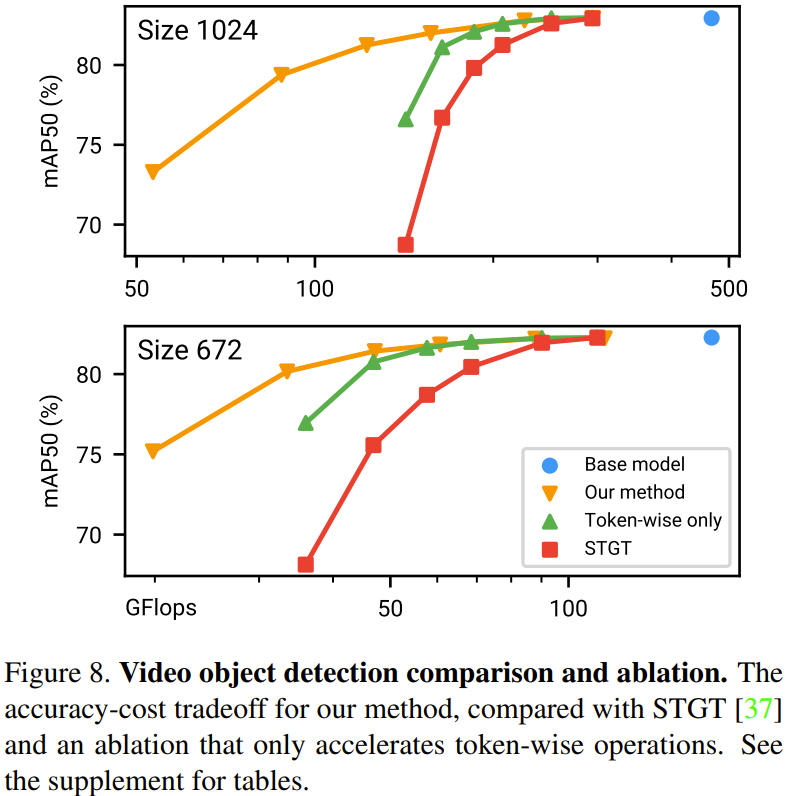

下圖 8 給出了在視頻目標檢測任務上的方法比較和消融實驗結果。

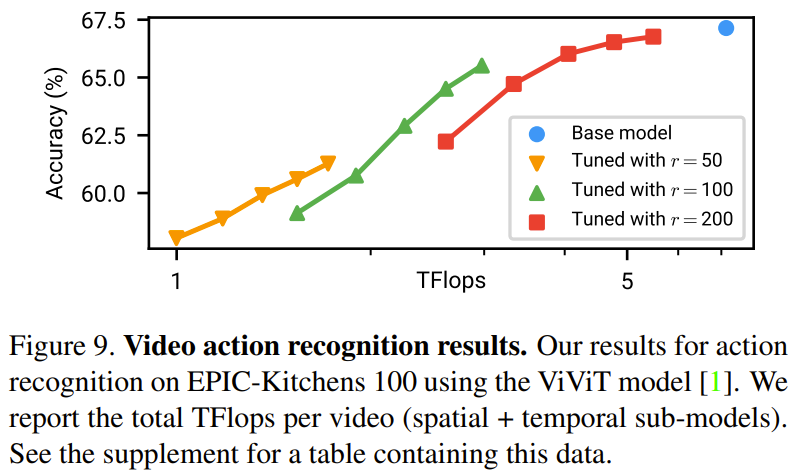

下圖 9 給出了視頻動作識別的實驗結果。

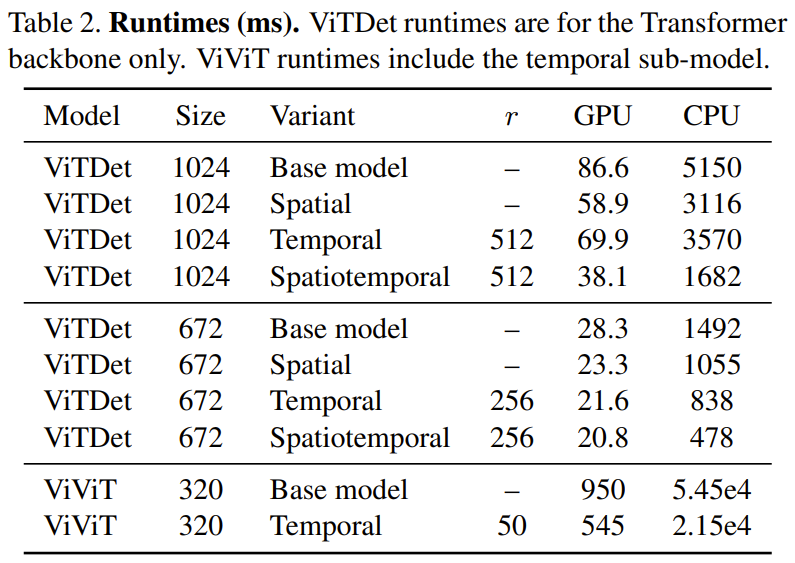

下表 2 給出了在一臺 CPU(Xeon Silver 4214, 2.2 GHz)和一臺 GPU(NVIDIA RTX3090)上運行時間(毫秒)結果,可以看到時間冗余在 GPU 上帶來的速度提升可達 1.74 倍,在 CPU 上帶來的提升可達 2.47 倍。

更多技術細節與實驗結果參見原論文。