4K畫質3D合成視頻不再卡成幻燈片,新方法將渲染速度提高了30多倍

當 4K 畫質、60 幀視頻在某些 APP 上還只能開會員觀看時,AI 研究者已經把 3D 動態合成視頻做到了 4K 級別,而且畫面相當流暢。

在現實生活中,我們接觸的大多數視頻都是 2D 的。在觀看這種視頻時,我們是沒有辦法選擇觀看視角的,比如走到演員中間,或者走到空間的某個角落。VR、AR 設備的出現彌補了這一缺陷,它們提供的 3D 視頻允許我們變換視角、甚至隨意走動,沉浸感大大提升。

但是,這種 3D 動態場景的合成一直是個難點,無論是在畫質上還是流暢度上。

最近,來自浙江大學、像衍科技和螞蟻集團的研究者對這個問題發起了挑戰。在一篇題為「4K4D: Real-Time 4D View Synthesis at 4K Resolution」的論文中,他們提出了一種名為4K4D的點云表示方法,大大提升了高分辨率3D動態場景合成的渲染速度。具體來說,使用 RTX 4090 GPU,他們的方法能以 4K 分辨率進行渲染,幀率可達80 FPS;以1080p分辨率進行渲染時,幀率可達400FPS。總體來看,它的速度是以前方法的30多倍,而且渲染質量達到了SOTA。

以下是論文簡介。

論文概覽

- 論文鏈接:https://arxiv.org/pdf/2310.11448.pdf

- 項目鏈接:https://zju3dv.github.io/4k4d/

動態視圖合成旨在從捕獲的視頻中重建動態 3D 場景,并創建沉浸式虛擬回放,這是計算機視覺和計算機圖形學中長期研究的問題。這種技術實用性的關鍵在于它能夠以高保真度實時渲染,使其能夠應用于 VR/AR、體育廣播和藝術表演捕捉。傳統方法將動態 3D 場景表示為紋理網格序列,并使用復雜的硬件進行重建。因此,它們通常僅限于受控環境。

最近,隱式神經表示在通過可微渲染從 RGB 視頻重建動態 3D 場景方面取得了巨大成功。例如《Neural 3d video synthesis from multi-view video》將目標場景建模為動態輻射場,利用體渲染合成圖像,并與輸入圖像進行對比優化。盡管動態視圖合成結果令人印象深刻,但由于網絡評估昂貴,現有方法通常需要幾秒鐘甚至幾分鐘才能以 1080p 分辨率渲染一張圖像。

受靜態視圖合成方法的啟發,一些動態視圖合成方法通過降低網絡評估的成本或次數來提高渲染速度。通過這些策略,MLP Maps 能夠以 41.7 fps 的速度渲染前景動態人物。然而,渲染速度的挑戰仍然存在,因為 MLP Maps 的實時性能只有在合成中等分辨率(384×512)的圖像時才能實現。當渲染 4K 分辨率的圖像時,它的速度降低到只有 1.3 FPS。

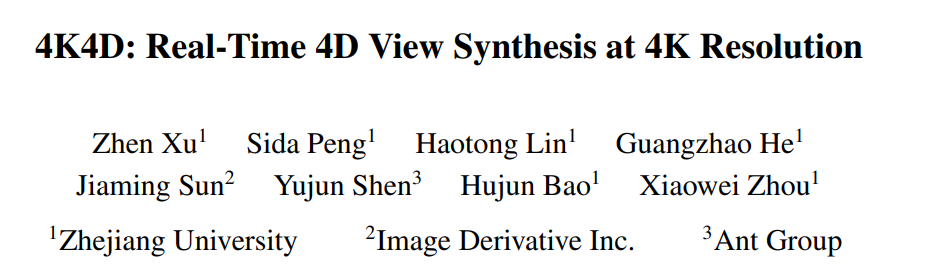

在這篇論文中,研究者提出了一種新的神經表示 ——4K4D,用于建模和渲染動態 3D 場景。如圖 1 所示,4K4D 在渲染速度上明顯優于以前的動態視圖合成方法,同時在渲染質量上具有競爭力。

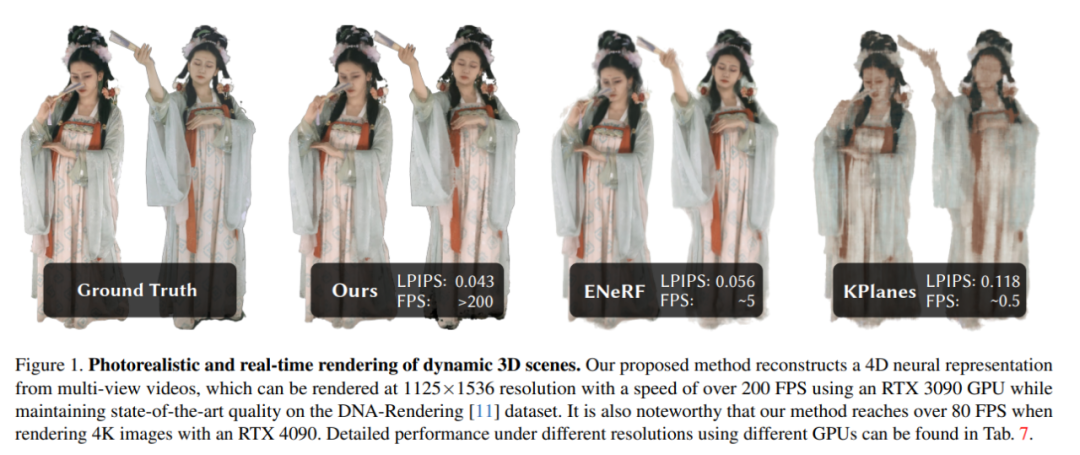

作者表示,他們的核心創新在于 4D 點云表示和混合外觀模型。具體而言,對于動態場景,他們使用空間雕刻算法獲得粗點云序列,并將每個點的位置建模為可學習向量。他們還引入 4D 特征網格,為每個點分配特征向量,并將其輸入 MLP 網絡,以預測點的半徑、密度和球諧函數(SH)系數。4D 特征網格自然地在點云上應用了空間正則化,使得優化更加穩健。基于 4K4D,研究者開發了一種可微深度剝離算法,利用硬件光柵化實現前所未有的渲染速度。

研究者發現,基于 MLP 的 SH 模型難以表示動態場景的外觀。為了緩解這個問題,他們還引入了一個圖像混合模型來與 SH 模型結合,以表示場景的外觀。一個重要的設計是,他們使圖像混合網絡獨立于觀看方向,因此可以在訓練后預先計算,以提高渲染速度。作為一把雙刃劍,該策略使圖像混合模型沿觀看方向離散。使用連續 SH 模型可以彌補這個問題。與僅使用 SH 模型的 3D Gaussian Splatting 相比,研究者提出的混合外觀模型充分利用了輸入圖像捕獲的信息,從而有效地提高了渲染質量。

為了驗證新方法的有效性,研究者在多個廣泛使用的多視圖動態新視圖合成數據集上評估了 4K4D,包括 NHR、ENeRF-Outdoo、DNA-Rendering 和 Neural3DV。廣泛的實驗表明,4K4D 不僅渲染速度快了幾個數量級,而且在渲染質量方面也明顯優于 SOTA 技術。使用 RTX 4090 GPU,新方法在 DNA-Rendering 數據集上達到 400 FPS,分辨率為 1080p;在 ENeRF-Outdoor 數據集上達到 80 FPS,分辨率為 4k。

方法介紹

給定捕獲動態 3D 場景的多視圖視頻,本文旨在重建目標場景并實時地進行視圖合成。模型架構圖如圖 2 所示:

接著文中介紹了用點云建模動態場景的相關知識,他們從 4D 嵌入、幾何模型以及外觀模型等角度展開。

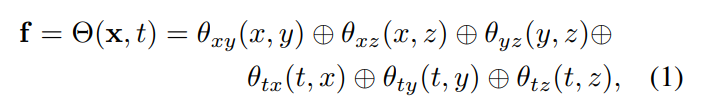

4D 嵌入:給定目標場景的粗點云,本文使用神經網絡和特征網格表示其動態幾何和外觀。具體來說,本文首先定義了六個特征平面 θ_xy、θ_xz、θ_yz、θ_tx、θ_ty 和 θ_tz,并采用 K-Planes 策略,利用這六個平面來建模一個 4D 特征場 Θ(x, t):

幾何模型:基于粗點云,動態場景幾何結構通過學習每個點上的三個屬性(entries)來表示,即位置 p ∈ R^3 、半徑 r ∈ R 和密度 σ ∈ R。然后借助這些點,計算空間點 x 的體積密度。點位置 p 被建模為一個可優化的向量。通過將 Eq.(1) 中的特征向量 f 饋送到 MLP 網絡中來預測半徑 r 和密度 σ。

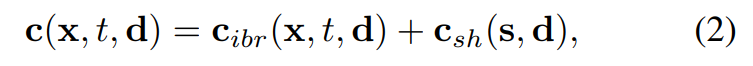

外觀模型:如圖 2c 所示,本文使用圖像混合技術和球諧函數(SH)模型來構建混合外觀模型,其中圖像混合技術表示離散視圖外觀 c_ibr,SH 模型表示連續的依賴于視圖的外觀 c_sh。對于第 t 幀處的點 x,其在視圖方向 d 上的顏色為:

可微深度剝離

本文提出的動態場景表示借助深度剝離算法可以渲染成圖像。

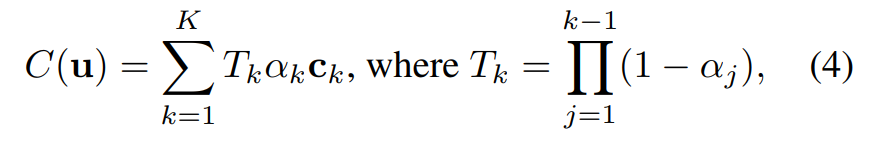

研究者開發了一個自定義著色器來實現由 K 個渲染通道組成的深度剝離算法。即對于一個特定的像素 u,研究者進行了多步處理,最后,經過 K 次渲染后,像素 u 得到一組排序點 {x_k|k = 1, ..., K}。

基于這些點 {x_k|k = 1, ..., K},得到體渲染中像素 u 的顏色表示為:

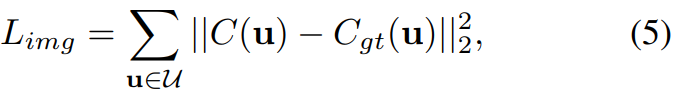

在訓練過程中,給定渲染的像素顏色 C (u),本文將其與真實像素顏色 C_gt (u) 進行比較,并使用以下損失函數以端到端的方式優化模型:

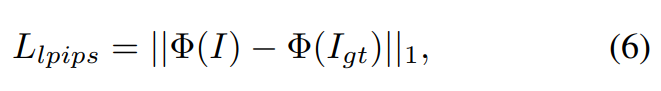

除此以外,本文還應用了感知損失:

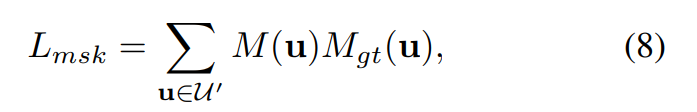

以及掩碼損失:

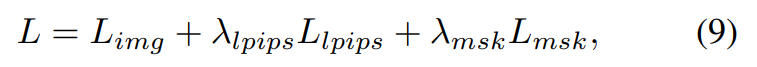

最終的損失函數定義為:

實驗及結果

本文在 DNA-Rendering、ENeRF-Outdoor、 NHR 以及 Neural3DV 數據集上評估了 4K4D 方法。

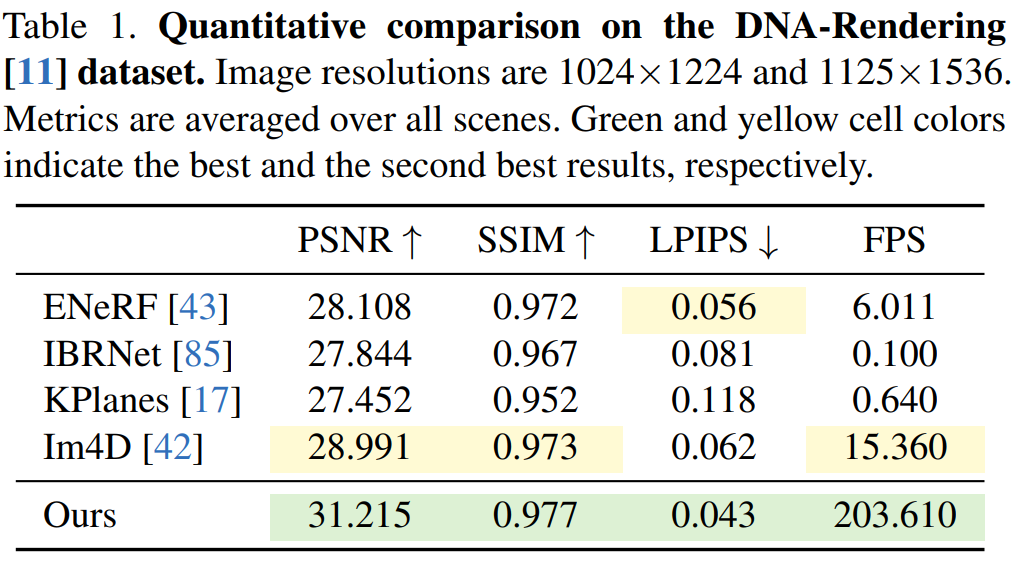

在 DNA-Rendering 數據集上的結果如表 1 所示,結果顯示,4K4D 渲染速度比具有 SOTA 性能的 ENeRF 快 30 多倍,并且渲染質量還更好。

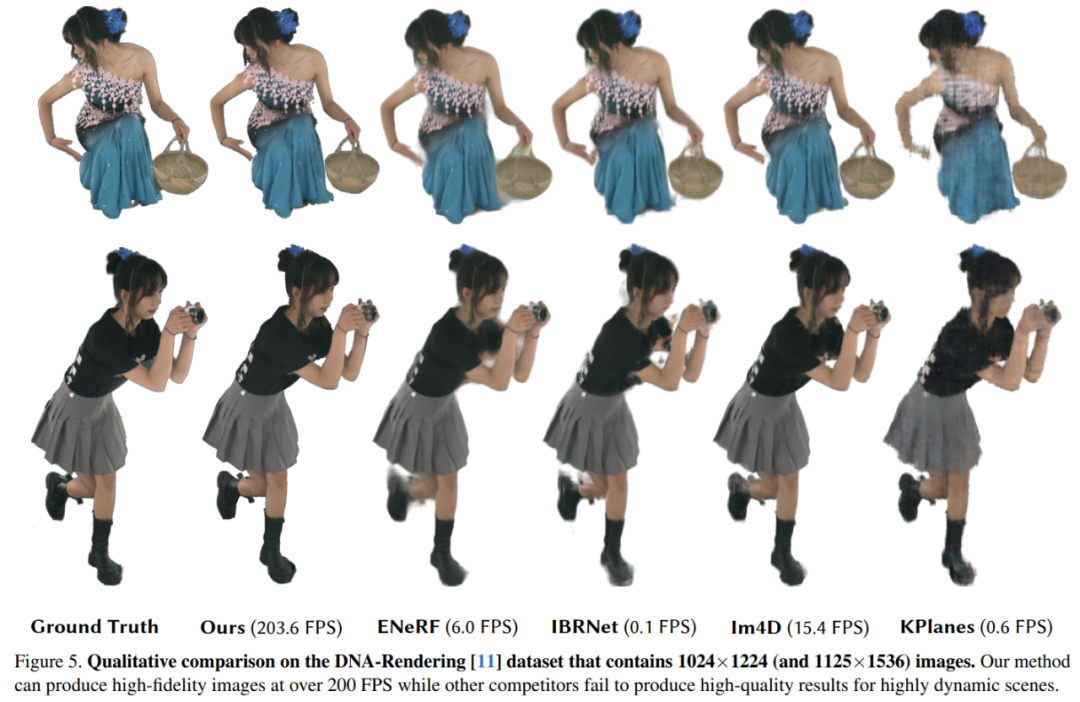

在 DNA-Rendering 數據集上的定性結果如圖 5 所示,KPlanes 無法對 4D 動態場景下的詳細外觀和幾何形狀進行恢復,而其他基于圖像的方法產生了高質量的外觀。然而,這些方法往往會在遮擋和邊緣周圍產生模糊的結果,導致視覺質量下降,相反,4K4D 可以在超過 200 FPS 的情況下產生更高保真度的渲染。

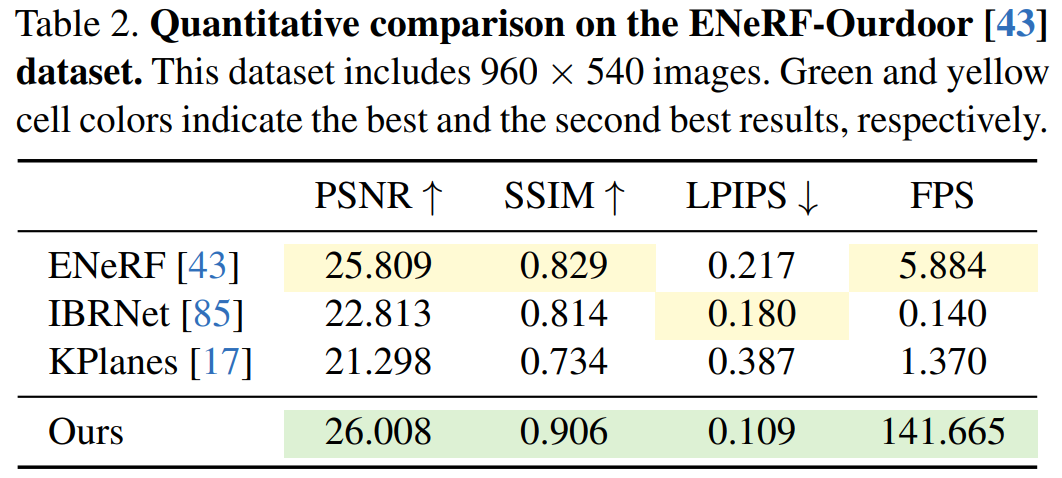

接下來,實驗展示了不同方法在 ENeRFOutdoor 數據集上的定性和定量結果。如表 2 所示,4K4D 在以超過 140 FPS 的速度進行渲染時仍然取得了明顯更好的結果。

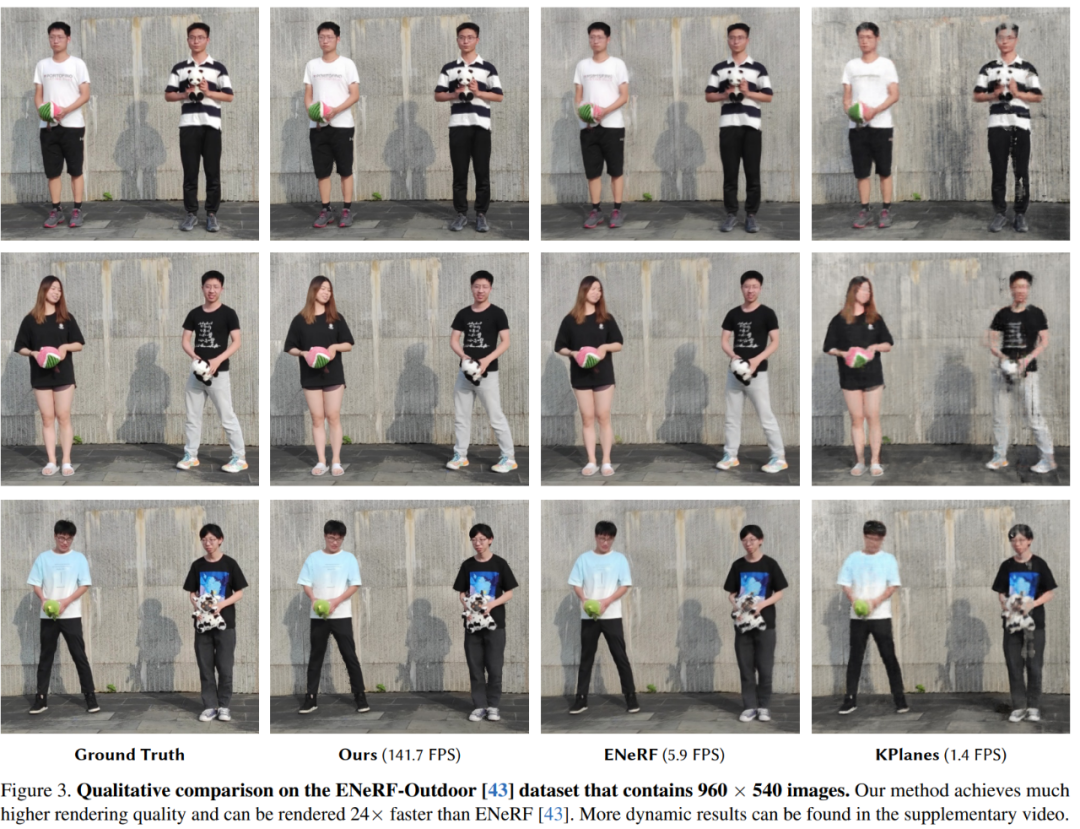

而其他方法,如 ENeRF 產生了模糊的結果;IBRNet 的渲染結果包含圖像邊緣周圍的黑色偽影,如圖 3 所示;K-Planse 無法重建動態人體以及不同的背景區域。

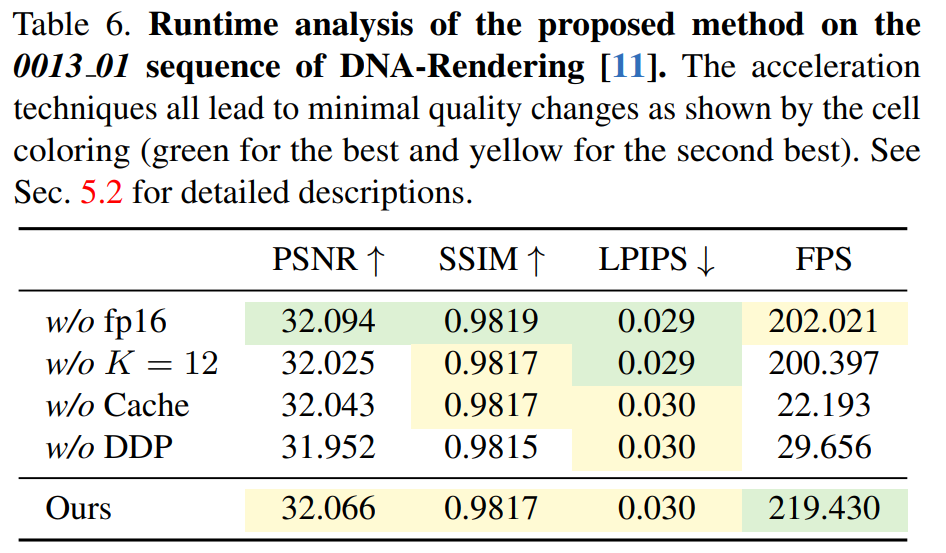

表 6 展示了可微深度剝離算法的有效性,4K4D 比基于 CUDA 的方法快 7 倍以上。

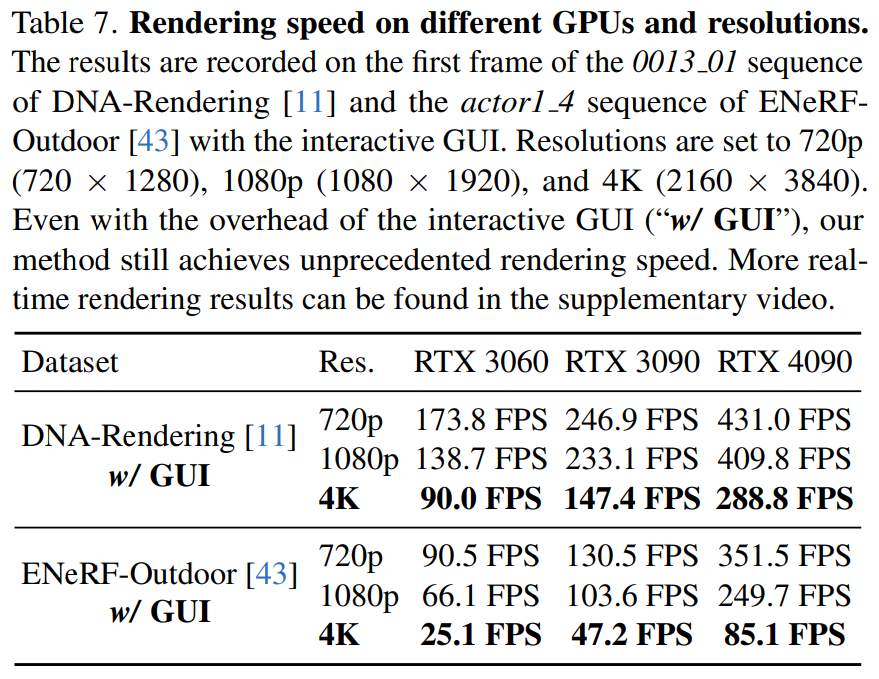

本文還在表 7 中報告了 4K4D 在不同分辨率的不同硬件(RTX 3060、3090 和 4090)上的渲染速度。

更多細節請參見原論文。