CVPR 2024 滿分論文 | Deformable 3D Gaussian:基于可變形3D高斯的高質量單目動態重建新方法

項目主頁:https://ingra14m.github.io/Deformable-Gaussians/

論文鏈接:https://arxiv.org/abs/2309.13101

代碼:https://github.com/ingra14m/Deformable-3D-Gaussians

單目動態場景(Monocular Dynamic Scene)是指使用單眼攝像頭觀察并分析的動態環境,其中場景中的物體可以自由移動。單目動態場景重建對于理解環境中的動態變化、預測物體運動軌跡以及動態數字資產生成等任務至關重要。

隨著以神經輻射場(Neural Radiance Field, NeRF)為代表的神經渲染的興起,越來越多的工作開始使用隱式表示(implicit representation)進行動態場景的三維重建。盡管基于NeRF的一些代表工作,如D-NeRF,Nerfies,K-planes等已經取得了令人滿意的渲染質量,他們仍然距離真正的照片級真實渲染(photo-realistic rendering)存在一定的距離。我們認為,其根本原因在于基于光線投射(ray casting)的NeRF管線通過逆向映射(backward-flow)將觀測空間(observation space)映射到規范空間(canonical space)無法實現準確且干凈的映射。逆向映射并不利于可學習結構的收斂,使得目前的方法在D-NeRF數據集上只能取得30+級別的PSNR渲染指標。

為了解決這一問題,我們提出了一種基于光柵化(rasterization)的單目動態場景建模管線,首次將變形場(Deformation Field)與3D高斯(3D Gaussian Splatting)結合實現了高質量的重建與新視角渲染。實驗結果表明,變形場可以準確地將規范空間下的3D高斯前向映射(forward-flow)到觀測空間,不僅在D-NeRF數據集上實現了10+的PSNR提高,而且在相機位姿不準確的真實場景也取得了渲染細節上的增加。

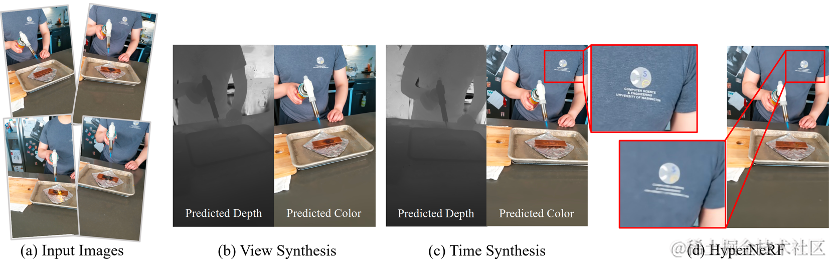

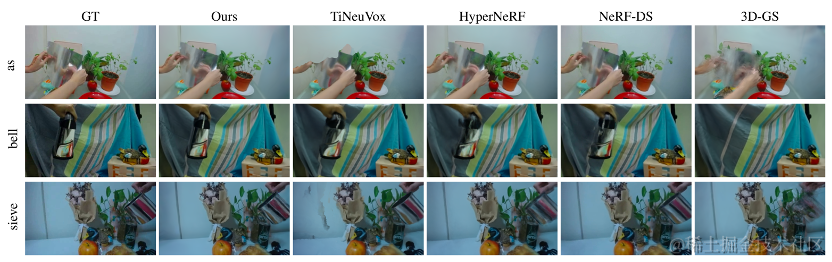

HyperNeRF真實場景的實驗結果

該研究的論文《Deformable 3D Gaussians for High-Fidelity Monocular Dynamic Scene Reconstruction》已被計算機視覺頂級國際學術會議 CVPR 2024接收。值得一提的是,該論文是首個使用變形場將3D高斯拓展到單目動態場景的工作,并且在公開數據集上取得了SOTA結果。

相關工作

動態場景重建一直以來是三維重建的熱點問題。隨著以NeRF為代表的神經渲染實現了高質量的渲染,動態重建領域涌現出了一系列以隱式表示作為基礎的工作。D-NeRF和Nerfies在NeRF光線投射管線的基礎上引入了變形場,實現了魯棒的動態場景重建。TiNeuVox,K-Planes和Hexplanes在此基礎上引入了網格結構,大大加速了模型的訓練過程,渲染速度有一定的提高。然而這些方法都基于逆向映射,無法真正實現高質量的規范空間和變形場的解耦。

3D高斯潑濺是一種基于光柵化的點云渲染管線。其CUDA定制的可微高斯光柵化管線和創新的致密化使得3D高斯不僅實現了SOTA的渲染質量,還實現了實時渲染。Dynamic 3D高斯首先將靜態的3D高斯拓展到了動態領域。然而,其只能處理多目場景非常嚴重地制約了其應用于更通用的情況,如手機拍攝等單目場景。

研究思想

Deformable-GS的核心在于將靜態的3D高斯拓展到單目動態場景。每一個3D高斯攜帶位置,旋轉,縮放,不透明度和SH系數用于圖像層級的渲染。根據3D高斯alpha-blend的公式我們不難發現,隨時間變化的位置,以及控制高斯形狀的旋轉和縮放是決定動態3D高斯的決定性參數。然而,不同于傳統的基于點云的渲染方法,3D高斯在初始化之后,位置,透明度等參數會隨著優化不斷更新。這給動態高斯的學習增加了難度。

在本次研究中,我們創新性地提出了變形場與3D高斯聯合優化的動態場景渲染框架。我們將COLMAP或隨機點云初始化的3D高斯視作規范空間,隨后通過變形場,以規范空間中3D高斯的坐標信息作為輸入,預測每一個3D高斯隨時間變化的位置和形狀參數。利用變形場,我們可以將規范空間的3D高斯變換到觀測空間用于光柵化渲染。這一策略并不會影響3D高斯的可微光柵化管線,經過其計算得到的梯度可以用于更新規范空間3D高斯的參數。此外,引入變形場有利于動作幅度較大部分的高斯致密化。這是因為動作幅度較大的區域變形場的梯度也會相對較高,從而指導相應區域在致密化的過程中得到更精細的調控。即使規范空間3D高斯的數量和位置參數在初期也在不斷更新,但實驗結果表明,這種聯合優化的策略可以最終得到魯棒的收斂結果。大約經過20000輪迭代,規范空間的3D高斯的位置參數幾乎不再變化。

在真實場景中,我們發現真實場景的相機位姿往往不夠準確,而動態場景更加劇了這一問題。這對于基于神經輻射場的結構來說并不會產生較大的影響,因為神經輻射場基于多層感知機(MLP),是一個非常平滑的結構。但是3D高斯是基于點云的顯式結構,略微不準確的相機位姿很難通過高斯潑濺得到較為魯棒地矯正。因此為了緩解這個問題,我們創新地引入了退火平滑訓練(Annealing Smooth Training,AST)。該訓練機制旨在初期平滑3D高斯的學習,在后期增加渲染的細節。這一機制的引入不僅提高了渲染的質量,而且大幅度提高了時間插值任務的穩定性與平滑性。

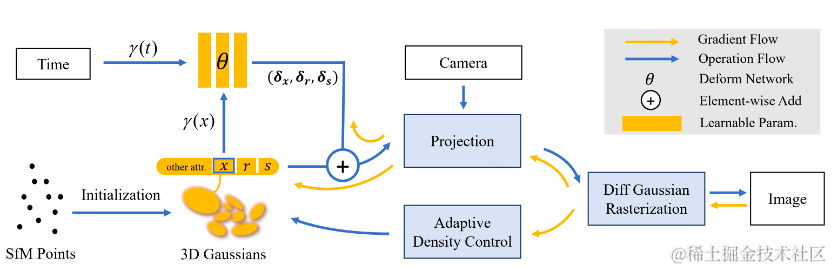

圖2展示了該研究的流程圖,詳情請參見論文原文。

流程圖

結果展示

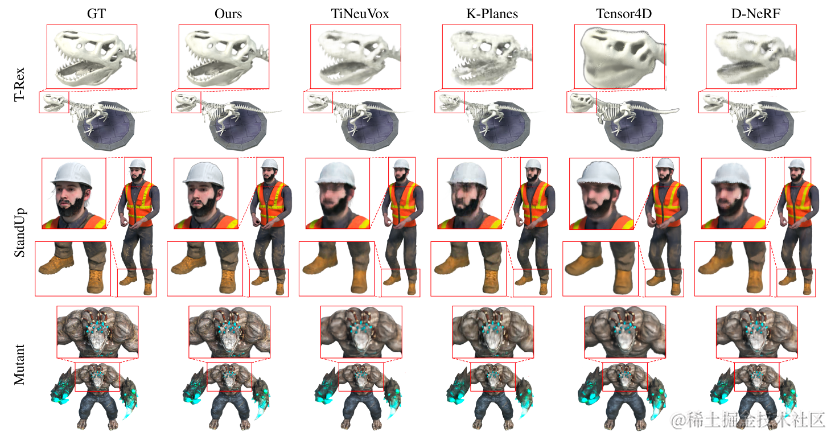

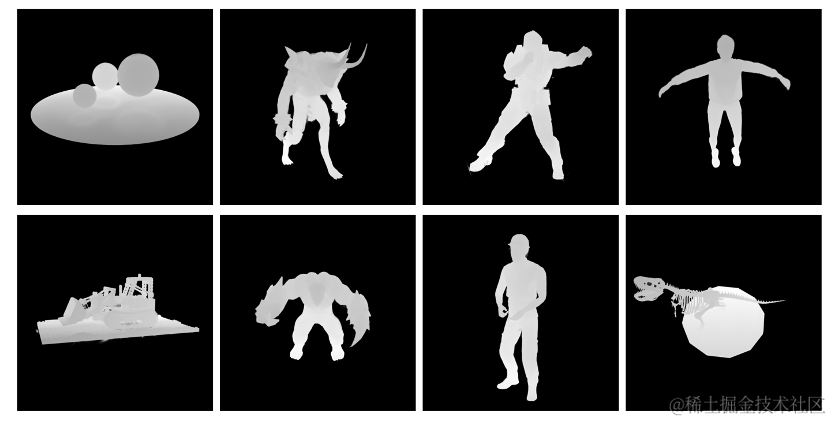

該研究首先在動態重建領域被廣泛使用的D-NeRF數據集上進行了合成數據集的實驗。從圖3的可視化結果中不難看出,Deformable-GS相比于之前的方法有著非常巨大的渲染質量提升。

該研究在D-NeRF數據集上的定性實驗對比結果

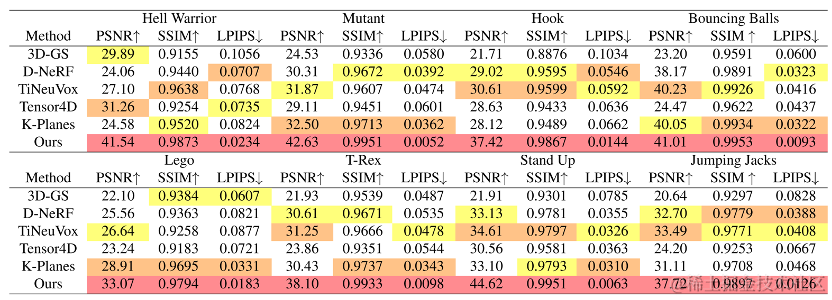

我們方法不僅在視覺效果上取得了大幅度的提高,定量的渲染指標上也有著對應的支持。值得注意的是,我們發現D-NeRF數據集的Lego場景存在錯誤,即訓練集和測試集的場景具有微小的差別。這體現在Lego模型鏟子的翻轉角度不一致。這也是為什么之前方法在Lego場景的指標無法提高的根本原因。為了實現有意義的比較,我們使用了Lego的驗證集作為我們指標測量的基準。

方法對比

我們在全分辨率(800x800)下對比了SOTA方法,其中包括了CVPR 2020的D-NeRF,Sig Asia 2022的TiNeuVox和CVPR2023的Tensor4D,K-planes。我們的方法在各個渲染指標(PSNR、SSIM、LPIPS),各個場景下都取得了大幅度的提高。

我們的方法不僅能夠適用于合成場景,在相機位姿不夠準確的真實場景也取得了SOTA結果。如圖5所示,我們在NeRF-DS數據集上與SOTA方法進行了對比。實驗結果表明,即使我們的方法沒有對高光反射表面進行特殊處理,我們依舊能夠超過專為高光反射場景設計的NeRF-DS,取得了最佳的渲染效果。

真實場景方法對比

雖然MLP的引入增加了渲染開銷,但是得益于3D高斯極其高效的CUDA實現與我們緊湊的MLP結構,我們依舊能夠做到實時渲染。在3090上D-NeRF數據集的平均FPS可以達到85(400x400),68(800x800)。

此外,該研究還首次應用了帶有前向與反向深度傳播的可微高斯光柵化管線。如圖6所示,該深度也證明了Deformable-GS也可以得到魯棒的幾何表示。深度的反向傳播可以推動日后很多需要使用深度監督的任務,例如逆向渲染(Inverse Rendering),SLAM與自動駕駛等。

深度可視化

火山引擎多媒體實驗室簡介

火山引擎多媒體實驗室是字節跳動旗下的研究團隊,致力于探索多媒體領域的前沿技術,參與國際標準化工作,其眾多創新算法及軟硬件解決方案已經廣泛應用在抖音、西瓜視頻等產品的多媒體業務,并向火山引擎的企業級客戶提供技術服務。實驗室成立以來,多篇論文入選國際頂會和旗艦期刊,并獲得數項國際級技術賽事冠軍、行業創新獎及最佳論文獎。

火山引擎是字節跳動旗下的云服務平臺,將字節跳動快速發展過程中積累的增長方法、技術能力和工具開放給外部企業,提供云基礎、視頻與內容分發、大數據、人工智能、開發與運維等服務,幫助企業在數字化升級中實現持續增長。