GPT-4完成正確率僅6%!北大等提出首個「多輪、多模態」PPT任務完成基準PPTC

最近對大型語言模型(例如ChatGPT和GPT-4)進行的評估工作主要側重于在基本自然語言任務上的能力,以及模型生成用于解決單句用戶指令的API的工具使用能力,卻忽略了在理解復雜多模態環境中使用API完成用戶指令的難題。

此外,現有評估方法主要集中在比較生成的API與標簽API序列,但在存在多個/無限正確解決方案的復雜情況下,這種方法也變得不再適用。

為了解決這個挑戰,來自北大和微軟亞洲研究院的研究人員們提出了測試大模型在多輪,多模態環境下完成PPT任務的評估數據集PPTC(PowerPoint Task Completion)。

論文地址:http://arxiv.org/abs/2311.01767

開源項目:https://github.com/gydpku/PPTC

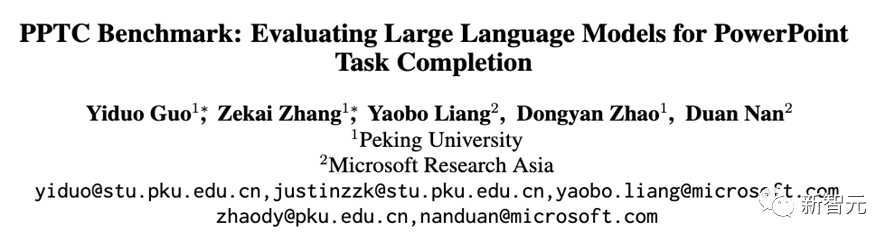

如圖1(a)所示,為了幫助用戶完成對PPT文檔的創建和編輯,研究人員采取多輪人機對話的形式來構建數據集。

=

=

圖1:(a)模擬了人類與語言模型之間的多輪對話場景,以評估語言模型在PPT任務完成性能方面的表現。(b)對話單元的輪次數量分布。

每輪開始于用戶的指令,大模型需要生成對應的API序列作為解決方法,執行并返回生成的PPT文檔給用戶。

數據集中一共有279個像這樣的多輪對話單元,如圖1(b)所示,大部分單元由3到10對話輪次組成。

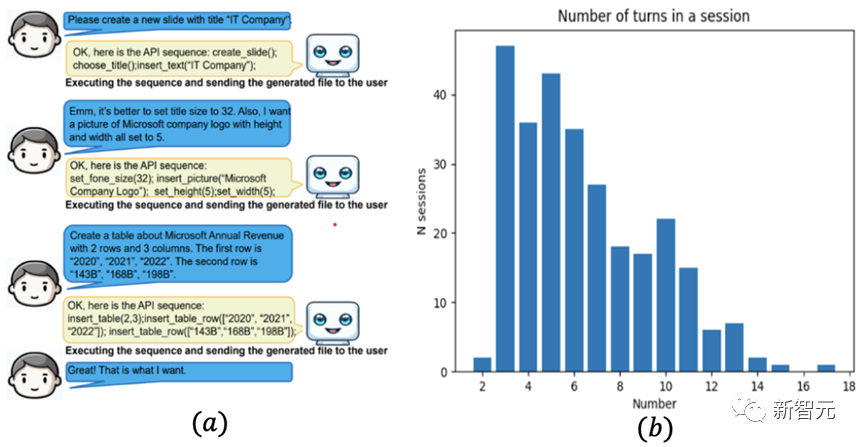

更進一步,如圖2(a)所示,數據集中包含各種難度的用戶指令(由所需API數量決定),如數百個涉及到統計圖表、表格、圖像、空間位置相關多模態操作的指令。

圖2:(a)指令所需最少API數量分布。(b)涉及到統計圖表,表格,圖片和位置操作的用戶指令數量。

生成和執行API序列

為了完成每輪用戶的指令,研究人員主要考慮:

- 當前輪次的用戶指令

- 之前輪次的用戶指令(對話歷史)

- PPT文檔(環境信息)

- 可使用的API列表作為大模型輸入,prompt大模型生成對應的API序列作為解決方案。

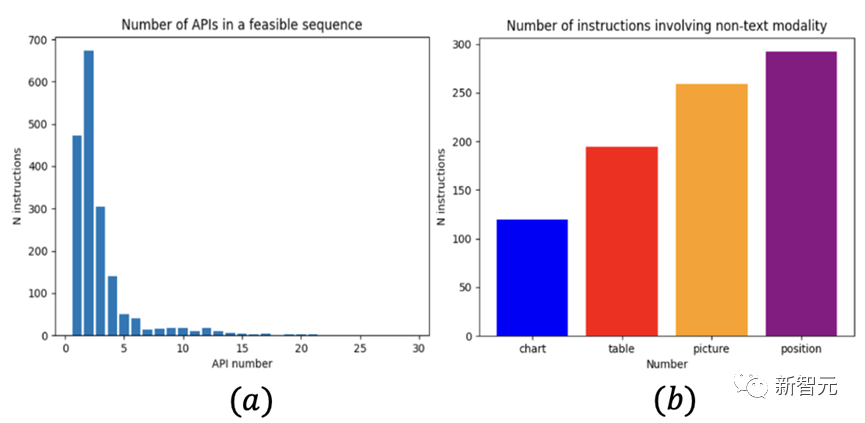

圖3:一個會話單元中語言模型如何完成一個輪次。(A)用當前的指令、之前的指令(對話歷史)、PPT文件內容以及API參考文件作為輸入prompt大模型。(B)然后,語言模型生成API序列并執行它,以獲取預測的PPT文件。(C)評估預測文件中的屬性和位置關系

為了方便大模型處理信息,研究人員提供一個PPT文檔讀取函數來將多模態文檔轉化為文字形式的文檔內容,以及一個API執行函數來自動執行大模型生成的API序列,從而生成對應的預測PPT文檔。

評估大模型生成的PPT文檔

本文提出PPTX-Match評估系統來評估大模型生成的文檔是否正確。

如圖3所示,它使用PPTX庫來抽取生成的文檔中所有的元素,并逐一驗證元素間的空間位置關系是否正確,并驗證元素的屬性內容是否和標簽文檔的對應內容匹配。

本文的評測系統只評測最終生成的PPT文檔,因此允許各種API序列來完成用戶指令。

基于這個系統,本文的評測指標分別包括只考慮當前輪次的輪次層面表現和考慮整個單元的單元層面表現。

實驗結果

本文在3個閉源大模型和6個開源大模型上測試PPTC數據集。進一步的,本文測試計劃算法(零樣本思維鏈(Zero-shot CoT)和思維樹(ToT)算法)以及PPT內容和API選擇算法是否能進一步提升GPT-4模型在PPTC上的表現。

從表1和表2展現出的結果中,可以得出以下結論:

(1)GPT-4是9個大模型中表現最強的模型,在創建新PPT文檔任務中它甚至能實現75%的輪次層面正確率。

(2)基于開源大模型(LLaMa-2)的進一步代碼預訓練(code-LLaMa)和對齊能夠進一步提升模型輪次層面表現

本文在3個閉源大模型和6個開源大模型上測試PPTC數據集。進一步的,本文測試計劃算法(零樣本思維鏈(Zero-shot CoT)和思維樹(ToT)算法)以及PPT內容和API選擇算法是否能進一步提升GPT-4模型在PPTC上的表現。

從表1和表2展現出的結果中,可以得出以下結論:

(1)GPT-4是9個大模型中表現最強的模型,在創建新PPT文檔任務中它甚至能實現75%的輪次層面正確率。

(2)基于開源大模型(LLaMa-2)的進一步代碼預訓練(code-LLaMa)和對齊能夠進一步提升模型輪次層面表現

表1:9個大語言模型的結果。「TD-003」是指Text-Davinci-003模型

(3)計劃算法和選擇算法能夠進一步提升GPT-4 2到5個百分點的輪次層面正確率。然而,本文發現,盡管思維樹相對零樣本思維鏈花了超過數倍的推斷成本,它的表現卻并沒有明顯進一步的提升。

表2:GPT-4和基于GPT-4模型的算法的結果。'CoT'和'ToT'分別是思維鏈和思維樹算法

三個PPTC上的主要挑戰

進一步的,本文分析得出大模型在PPTC上遇到的三個主要的挑戰:

1.錯誤累計導致大模型單元層面表現糟糕

盡管諸如GPT-4這樣的大模型在輪次層面表現較好,但當本文測試大模型在包含多個輪次的單元層次表現時,大模型表現普遍糟糕。

如表1所示,在創建新文檔任務中,GPT-4只正確完成了不到百分之23的多輪次單元。

2.大模型處理長PPT模版的能力欠佳

在PPT文檔編輯任務中,大模型需要基于給予的長PPT模板完成用戶指令。

圖4: 創建新的PPT文件任務(任務1)和編輯PPT模板任務(任務2)的分析結果。在子圖(a)中,本圖展示了涉及圖表、表格、圖片、位置和純文本的指令的平均基于輪次的準確度。在子圖(b)中,本圖展示了GPT-4的四種常見錯誤的比例。

然而,如表1所示,即使是GPT-4,也只實現了百分之38的輪次正確率,只完成了6%的多輪次單元。如圖4(b)所示,對文檔的誤解成為編輯任務的主要錯誤原因。

3.多模態指令提高了任務難度

如圖4(a)所示,大模型在處理圖表,表格,圖像,空間位置相關的指令上的表現遠不如處理只涉及純文本操作的指令表現,特別是涉及到移動空間位置的指令。

如圖4(b)所示,糟糕的空間位置感知成為創建新文檔任務的主要錯誤原因。

總結

- 本文提出了PowerPoint任務完成評估測試(PPTC),用于衡量在 PowerPoint 官方軟件中的語言模型的任務完成性能。這一基準測試包含了279個多輪會話單元,涵蓋了復雜的多模式環境中的數百個多模式指令。

- 本文提出了PPTX-Match評估系統,用于自動測量語言模型在PPTC中的性能。本文測試了3個閉源語言模型和6個開源語言模型,發現GPT-4是所有語言模型中性能最強的。

- 本文進一步發現了三個關鍵的錯誤因素:會話中的錯誤累積、長的PPT模板處理和多模態感知。這些發現為未來的語言模型和基于語言模型的agent系統提出了重要的挑戰。