多模態LLM視覺推理能力堪憂,浙大領銜用GPT-4合成數據構建多模態基準

無論是語言模型還是視覺模型,似乎都很難完成更抽象層次上的理解和推理任務。

語言模型已經可以寫詩寫小說了,但是依舊算不對9.11和9.9比大小的問題。

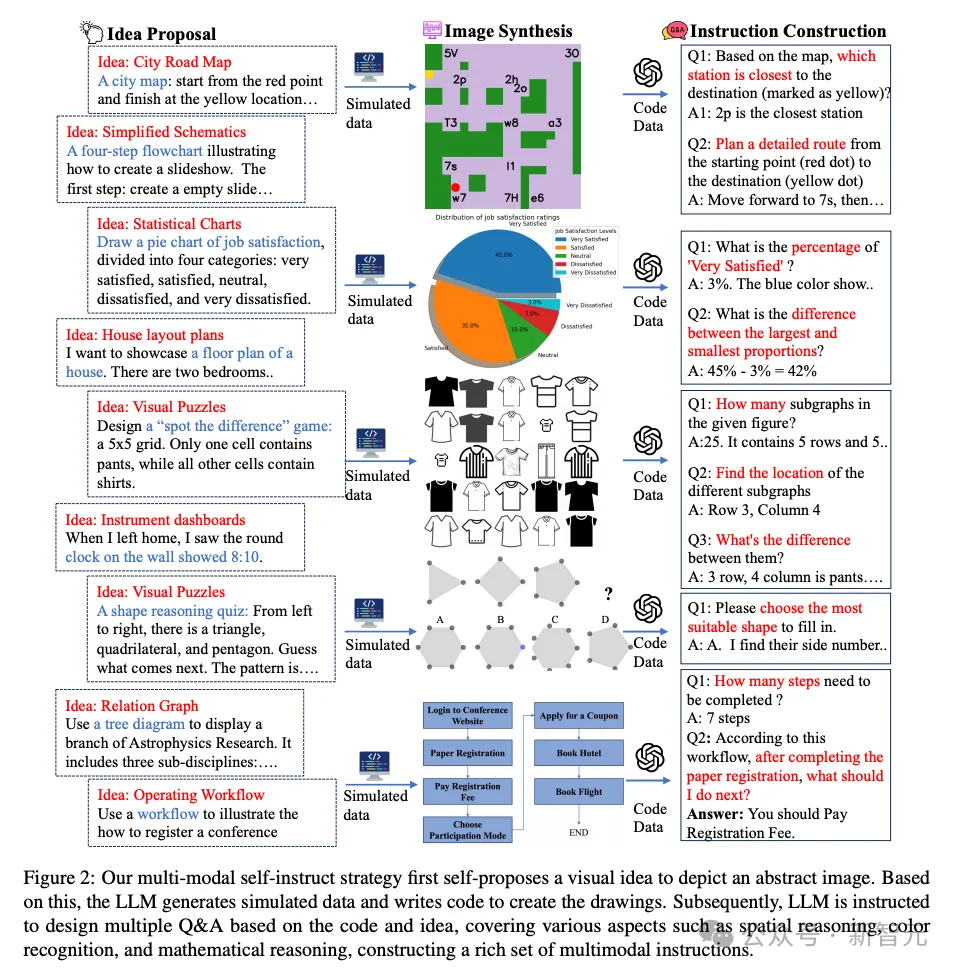

同樣的問題也出現在視覺模型中,它們能完美理解自然景色或人物照片,卻無法處理各種圖表任務,甚至看表讀時間都是難題。

如果要將AI系統用在更多專業領域,這些能力缺陷就顯得極為突出。

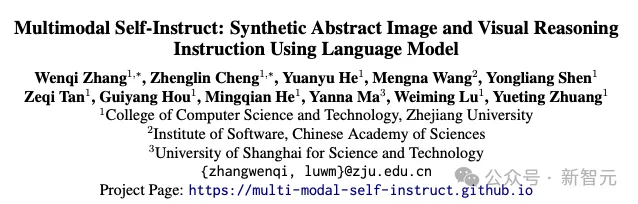

最近,浙江大學、中科院軟件研究所、上海科技大學等機構就聯合提出了一種新的多模態基準,專門衡量模型對抽象圖像的理解能力和視覺推理能力。

圖片

圖片

論文地址:https://arxiv.org/pdf/2407.07053

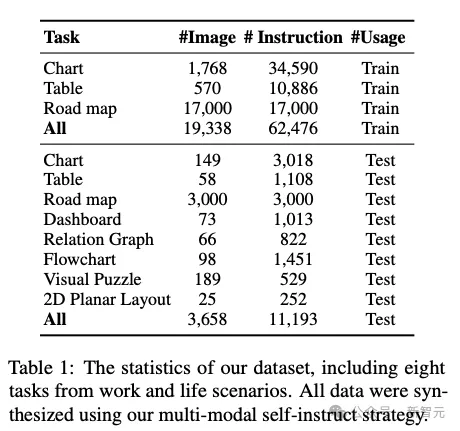

數據集共包含11,193個帶有相關問題的抽象圖像,涵蓋了儀表板、路線圖、圖表、表格、流程圖、關系圖、視覺謎題和2D平面圖等8大類別,此外還有額外的62,476條數據用于微調模型。

經過測試,人類在該基準上可以達到至少82.1%的準確率,但Claude 3.5 Sonnet和GPT-4o等頂流模型的成績卻遠遠落后于人類,分別只有64.7%和59.9%。

圖片

圖片

目前全部數據已經上傳至HuggingFace倉庫。

圖片

圖片

倉庫地址:https://huggingface.co/datasets/zwq2018/Multi-modal-Self-instruct

此外,作者也將數據構建數據所用的代碼上傳到了GitHub。

圖片

圖片

代碼地址:https://github.com/zwq2018/Multi-modal-Self-instruct

構建數據集

作為新提出的基準測試,重頭戲自然是數據集的構建過程。

作者在論文中指出,想要采集到合適的抽象圖像-文本對,既需要大量人力,也十分耗費時間。

那么使用合成數據呢?

同樣也不容易,因為我們需要的是多模態數據,但LLM無法直接生成圖像,DALL-E、Stable Diffusion等圖像生成模型又無法同步生成文本。

一個直覺的解決方案是將二者結合在一起,直接生成<圖像,問題,答案>形式的數據。

但文生圖模型實際上很難對圖像細節做到細微精準的控制,尤其是生成僅由幾何形狀組成的抽象圖像,更何況其中大部分還需要包含數字和文字。

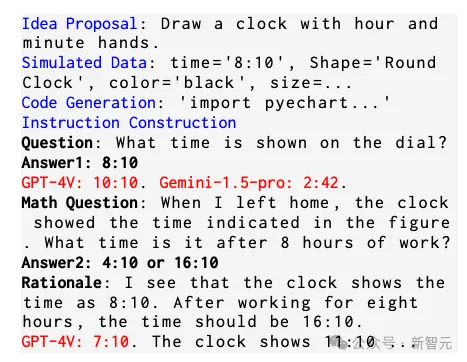

鑒于以上問題,作者提出了一種以代碼為中心的「自我指導」(self-instruct)策略進行圖像和相關文本的同步合成,整個過程只有語言模型——GPT-4-Turbo的參與,沒有用到圖像生成模型。(圖2)

圖片

圖片

首先指導LLM,針對某個日常情景,提出一種視覺創意。這個過程中,作者給LLM提供了一些in-context示例,使生成結果盡可能涵蓋全部8個類別。

然后模型根據自己提出的創意,生成所需的數據和代碼以繪制圖像。

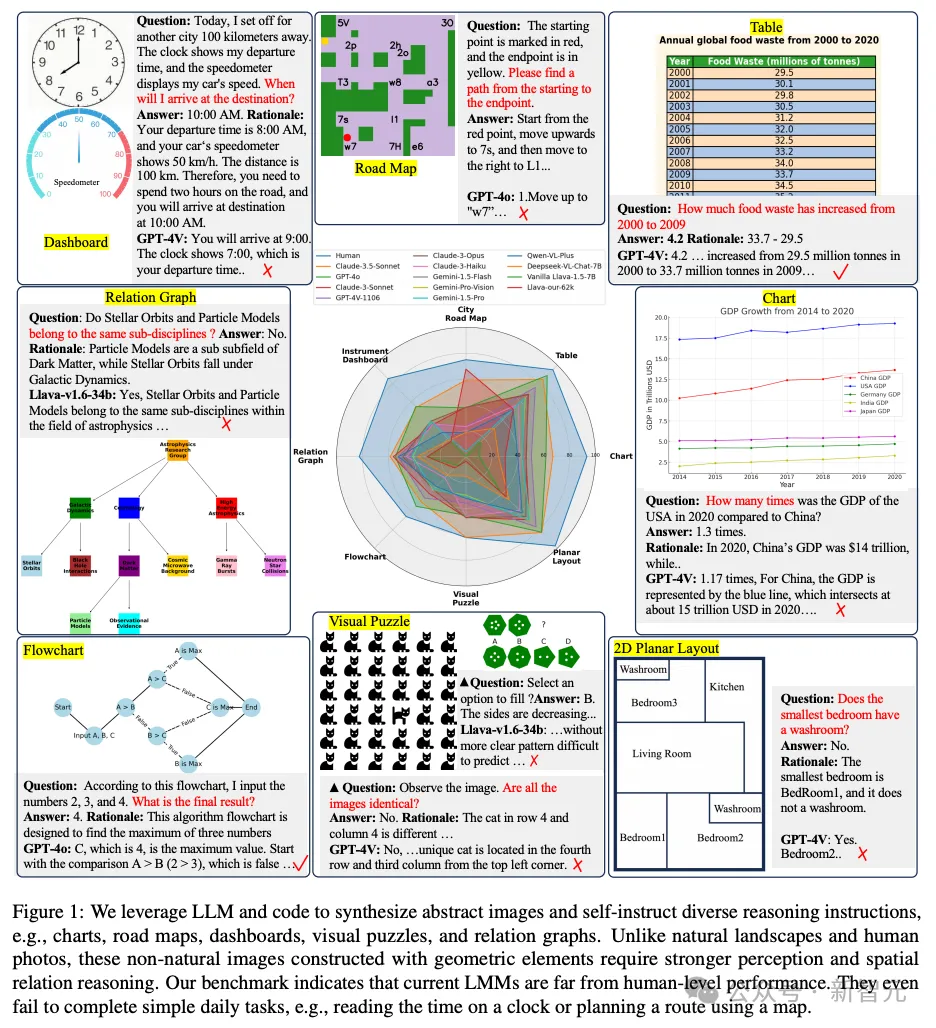

比如對于餅狀圖,LLM就需要先「捏造」數據,設計出每個類型對應的百分比數值。在代碼生成中,作者激勵模型使用Matplotlib或ECharts等代碼庫,顯著降低了代碼復雜度。

執行代碼并渲染好圖像后,LLM會繼續進行「自我指導」,根據視覺內容,加上之前所用的視覺創意、數據和代碼作為prompt,生成多個高質量的<問題,答案>文本對。

除了為每個問題生成答案,作者還提示LLM生成能解釋答案的「原理」(rationale),以便用于訓練模型,起到類似于CoT的作用。

整個構建過程的流水線如下圖所示:

圖片

圖片

這種「以代碼為中心」的方式不僅更容易保證圖像的細節、質量和多樣性,也讓LLM更容易生成相關文本。

數據合成過程所用的模型是GPT-4-Turbo,但合成后還經過Llava-1.5的初篩,以保證圖像的美觀程度、布局合理性以及文本可讀性等。

最終構建的測試集共包含3.658張圖像和11,193條指令,涵蓋了儀表板、路線圖、圖表、表格、流程圖、關系圖、視覺謎題和2D平面圖等8個類別。

圖片

圖片

數據集進行了10%的隨機抽樣,并讓人類驗證答案的正確性,發現數據集的質量有一定的保證。

為了能進一步評估合成數據的質量,作者還為圖表、表格和路線圖這三個任務構建了額外的訓練集,共包含62,476條指令(圖1)。

圖片

圖片

基準測試

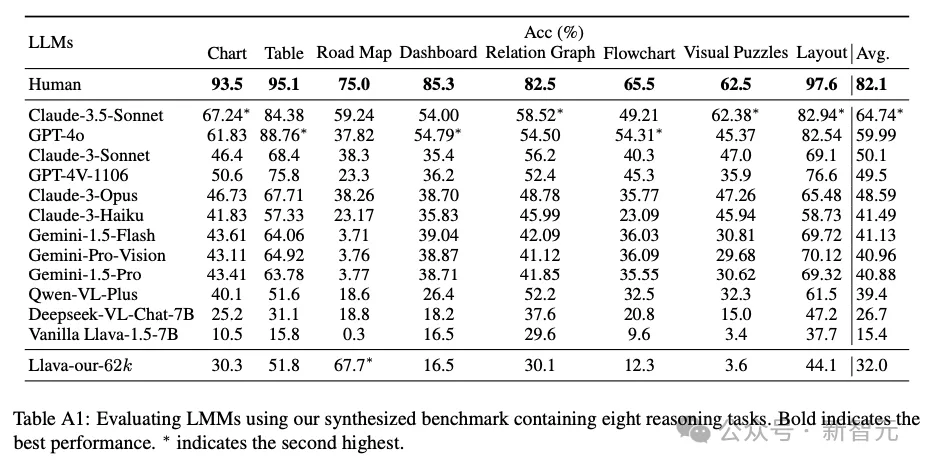

論文共對12個模型進行了測試,詳細結果如表A1所示,其中人類所得分數來自于兩個本科生分數的平均。

其中得分最高的是Claude 3.5 Sonnet,平均準確率為64.74%;GPT-4o緊隨其后,準確率為59.99%,都與人類平均水平82.1%相去甚遠。

作者發現,在圖表、關系圖、2D平面圖中,模型經常在抽象概念或空間關系上出錯。

8個類別的抽象圖像中,模型表現最差的當屬「路線圖」類。Claude 3.5 Sonnet平均準確率為59.24%,其余模型均為未超過40%。

在「路線圖」和「視覺謎題」兩類圖像任務中,開源和閉源模型的差距尤為明顯。

模型微調

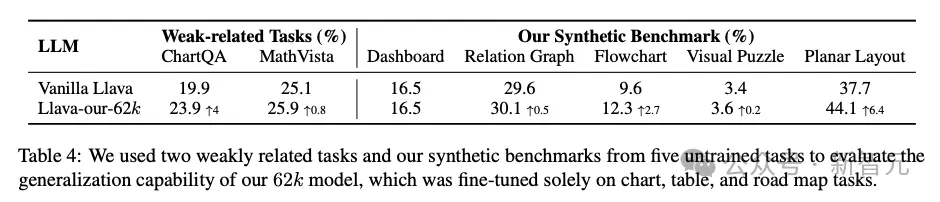

除了構建基準,論文發現,用這些合成數據訓練模型可以顯著提高其視覺推理能力。

相比之前的Vanilla Llava-1.5-7B,用62K條數據經過4小時LoRA微調后的模型,在3類圖像任務上都有非常顯著的提升。尤其是「路線圖」類別,準確率飆升67.4%,超過了GPT-4V和Claude-3-Sonnet(表2)。

雖然模型在微調后出現性能提升屬于正常現象,但這種微調效率可以側面證明合成數據的潛力,尤其是在質量、有效性和多樣性方面。

除了在原基準上有所進步,微調后的模型在ChatQA、MathVista這樣弱相關任務上也有不同程度的分數提升(表4)。

這意味著,在合成數據上的訓練可以提升模型的通用視覺推理能力,從而泛化到其他任務,而非僅僅是擬合訓練場景。

圖片

圖片

結論與限制

論文最重要的貢獻在于指出了當前多模態LLM在視覺推理方面的次優表現,并構建了合成數據組成的基準測試集,表明合成數據訓練是一個有前景的解決方案。

與此同時,作者指出了該研究存在的三方面限制:

- 數據合成過程嚴重依賴LLM的代碼合成和推理能力,因此論文只使用了GPT-4等閉源模型。隨著Llama 3等開源模型逐漸提升性能,未來可以利用開源模型合成數據以減少成本

- 本項工作主要用代碼合成8類的抽象圖像,例如表格和地圖,未來可以繼續擴展到用代碼控制機器人仿真器,生成特定的房屋布局和結構

- 我們認為視覺編碼器是當前LLM的瓶頸,尤其是對于抽象圖表而言,因此未來提升編碼器圖像分辨率可以增強LLM的細粒度認知能力