LoRAShear:微軟在LLM修剪和知識恢復方面的最新研究

LoRAShear是微軟為優化語言模型模型(llm)和保存知識而開發的一種新方法。它可以進行結構性修剪,減少計算需求并提高效率。

LHSPG技術( Lora Half-Space Projected Gradient)支持漸進式結構化剪枝和動態知識恢復。可以通過依賴圖分析和稀疏度優化應用于各種llm。

LoRAPrune將LoRA與迭代結構化修剪相結合,實現參數高效微調。在LLAMA v1上的實現即使進行了大量的修剪也能保持相當的性能。

在不斷發展的人工智能領域,語言模型模型(llm)已經成為處理大量文本數據、快速檢索相關信息和增強知識可訪問性的關鍵工具。它們的深遠影響跨越了各個領域,從增強搜索引擎和問答系統到啟用數據分析,研究人員、專業人員和知識尋求者都從中獲益。

而目前最大的問題是,信息的動態性要求LLM不斷更新知識。一般情況下微調一直被用來向這些模型灌輸最新的見解的方式,開發人員使用特定于領域的數據對預訓練模型進行微調使其保持最新狀態。因為組織和研究人員的定期更新對于保持llm與不斷變化的信息景觀保持同步至關重要。但微調的成本大且周期長。

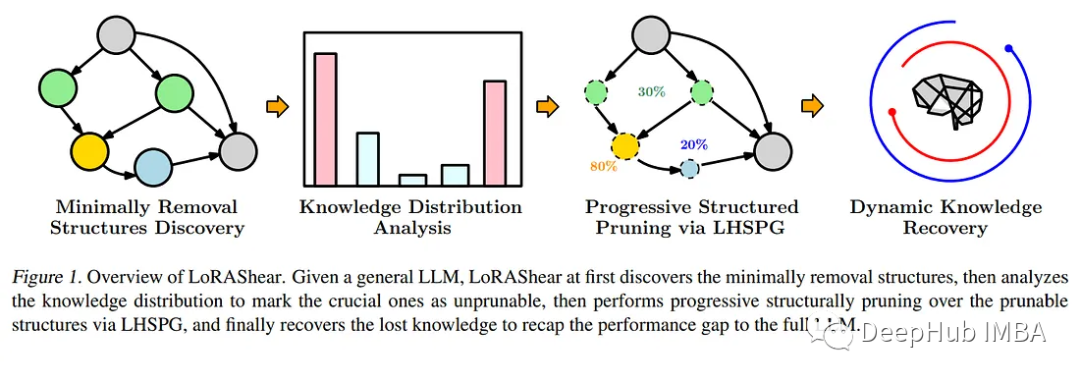

為了應對這一迫切需要,微軟的研究人員推出了一種開創性的方法——LoRAShear。這種創新的方法不僅簡化了llm,而且促進了結構知識的恢復。結構修剪的核心是去除或減少神經網絡架構中的特定組件,優化效率、緊湊性和計算需求。

微軟的LoRAShear引入了LHSPG技術,支持漸進式結構化修剪。這種方法在LoRA模塊之間無縫地傳遞知識,并集成了動態知識恢復階段。微調過程類似于預訓練和指示微調,確保llm保持更新和相關性。

LoRAShear通過依賴圖分析可以擴展到一般llm,特別是在LoRA模塊的支持范圍內。所采用的算法為原始LLM和LoRA模塊創建依賴關系圖。除此以外還引入了一種結構化稀疏性優化算法,該算法利用LoRA模塊信息來增強權重更新過程中的知識保存。

論文中還有一個稱為LoRAPrune的集成技術,將LoRA與迭代結構化修剪相結合,實現了參數高效的微調和直接硬件加速。這種節省內存的方法完全依賴于LoRA的權重和梯度來進行修剪標準。這個過程包括構造一個跟蹤圖,確定要壓縮的節點組,劃分可訓練的變量,并最終將它們返回給LLM。

論文通過在開源LLAMAv1上的實現,證明了LoRAShear的有效性。值得注意的是,修剪了20%的LLAMAv1只有1%的性能損失,而修剪了50%的模型在評估基準上保留了82%的性能。

LoRAShear代表了人工智能領域的重大進步。它不僅簡化了LLM的使用方式,使其更有效率,而且確保了關鍵知識的保存。它可以使人工智能驅動的應用程序能夠在優化計算資源的同時,與不斷發展的信息環境保持同步。隨著組織越來越依賴人工智能進行數據處理和知識檢索,像LoRAShear這樣的解決方案將在市場上發揮關鍵作用,提供效率和知識彈性。

論文地址:https://arxiv.org/abs/2310.18356