微軟華人團隊最新研究:從LLM到LAM,讓大模型真正具有「行動力」!

LLM只能針對問題進行回答與分析?這種「隔靴搔癢」的體驗也許就要被終結(jié)了!

最近,微軟推出了一項名為「大型行動模型」(Large Aciton Model,LAM)的創(chuàng)新技術(shù),標(biāo)志著大模型從語言理解向?qū)嶋H執(zhí)行任務(wù)的轉(zhuǎn)變。

與傳統(tǒng)的LLM不同,LAM不僅能理解用戶的自然語言指令,還能將這些指令轉(zhuǎn)化為具體的行動步驟,在軟件環(huán)境中自主執(zhí)行文檔編輯、表格處理等任務(wù)。

雖然這實際上并不是一個全新的概念,但LAM是首款能夠操作Microsoft Office來執(zhí)行任務(wù)的模型。

論文鏈接:https://arxiv.org/pdf/2412.10047

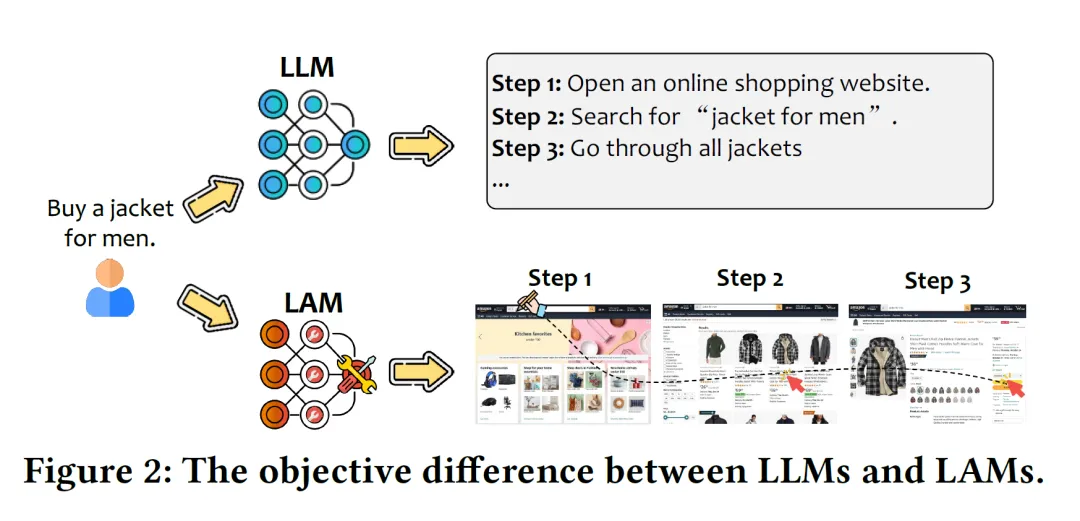

不同于GPT-4o等負(fù)責(zé)處理和生成文本的傳統(tǒng)語言模型,LAM可以將用戶請求轉(zhuǎn)化為實際操作。

例如同樣是給一個男人買夾克,LLM只能給出文本步驟,而LAM卻可以直接像女朋友一樣挑選款式并網(wǎng)購。

哪個更加有實際效用,這就自不必多說了。畢竟誰不想有個能直接替自己去解決一些生活瑣碎的「分身」呢?

LAM能夠理解用戶通過文本、語音或圖像等各種輸入方式表達的需求,并將這些需求轉(zhuǎn)化為詳細(xì)的逐步計劃。

執(zhí)行過程中,LAM能將復(fù)雜的任務(wù)分解為多個子任務(wù),根據(jù)實時情況調(diào)整其行動策略,以應(yīng)對執(zhí)行過程中的意外情況。

此外,LAM還能自主探索與學(xué)習(xí),獨立探索新的解決方案。

讓LLM行動起來

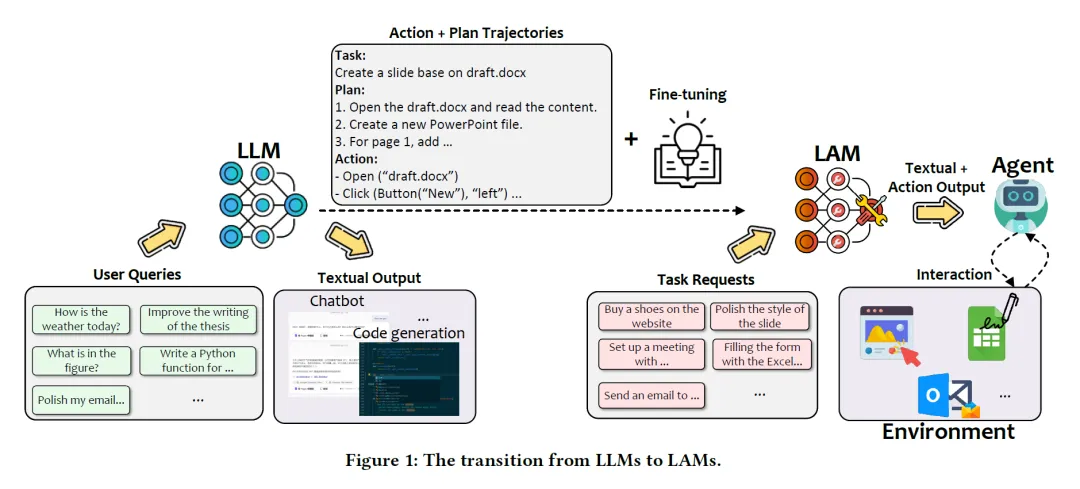

LAM通常建立在LLM的基礎(chǔ)上,但是從LLM到LAM的過渡卻并沒那么容易,如下圖所示。

從LLM到LAM的轉(zhuǎn)變

將LLM轉(zhuǎn)化為功能性LAM的過程涉及多個復(fù)雜的階段,每個階段都需要大量的努力與專業(yè)知識。

首先需要利用LLM來處理用戶數(shù)據(jù)集,并生成對應(yīng)的文本輸出,將任務(wù)分解為行動與相應(yīng)的計劃。

經(jīng)過微調(diào)之后,接受了任務(wù)要求的LAM就能輸出對應(yīng)的文本格式的行動輸出。

最后將其輸出反饋給智能體,讓其與環(huán)境不斷地實時交互。

如何開發(fā)LAM?

既然LAM能夠為我們執(zhí)行任務(wù),化為我們的「分身」來幫我們與世界互動,那么如何開發(fā)與部署LAM就是一個關(guān)鍵的問題。

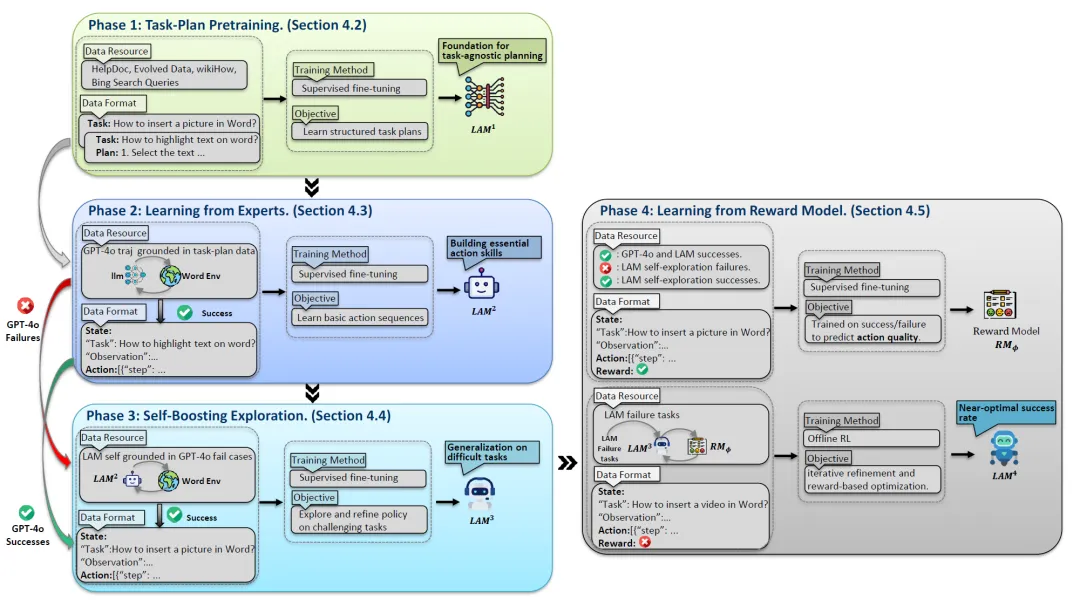

LAM的訓(xùn)練過程包括以下關(guān)鍵步驟:

1. 任務(wù)分解與規(guī)劃:模型首先學(xué)習(xí)將任務(wù)分解為邏輯步驟,并生成詳細(xì)的執(zhí)行計劃。

2. 行動生成與執(zhí)行:將用戶意圖轉(zhuǎn)化為具體的行動指令,包括圖形用戶界面操作、API調(diào)用等。

3. 動態(tài)調(diào)整與優(yōu)化:在執(zhí)行過程中,LAM能根據(jù)反饋調(diào)整其行動策略,以提高成功率和效率。

4. 從獎勵機制學(xué)習(xí):通過獎勵機制進行微調(diào)訓(xùn)練,進一步優(yōu)化模型的性能。

階段1:任務(wù)分解與規(guī)劃

在初始階段,模型將任務(wù)分解為邏輯步驟。

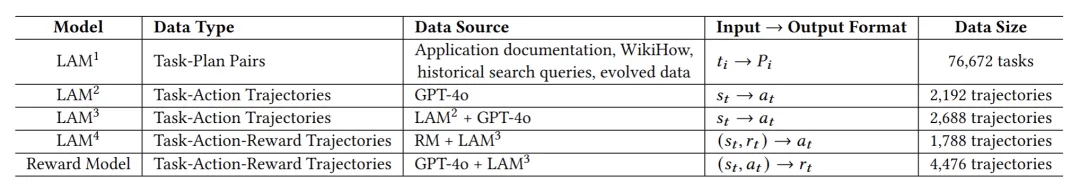

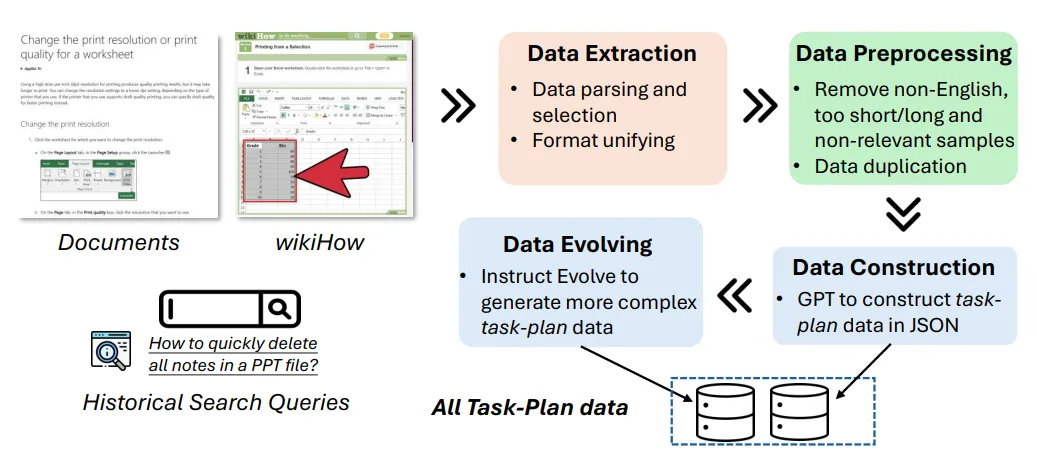

研究人員以Mistral-7B作為基礎(chǔ)模型,收集了來自多個來源的76,672個任務(wù)-計劃對(???? , ????),包括應(yīng)用幫助文檔、WikiHow和歷史搜索查詢。

在此階段不會生成具體的行動,但模型獲得了強大的規(guī)劃能力,為后續(xù)的動作執(zhí)行提供了重要基礎(chǔ)。

階段2:行動生成與執(zhí)行

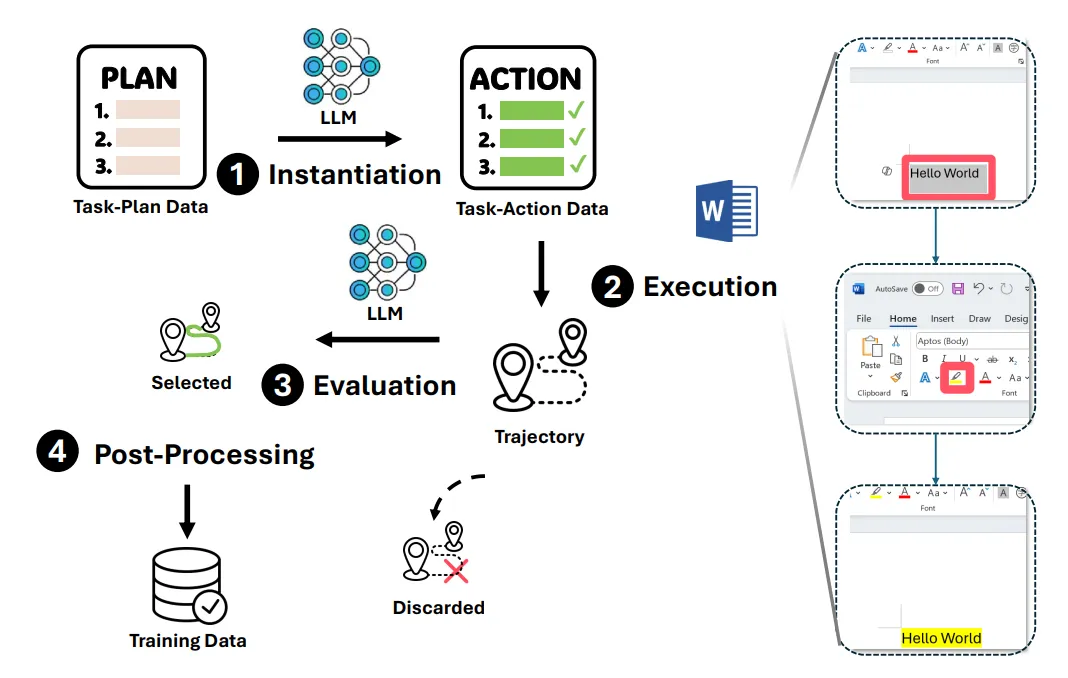

在此階段,作者引入了由GPT-4o標(biāo)注的任務(wù)-動作軌跡,讓LAM向先進的AI模型GPT-4o學(xué)習(xí)。

將學(xué)習(xí)到的任務(wù)規(guī)劃轉(zhuǎn)化為可執(zhí)行的動作,從GPT-4o的成功經(jīng)驗中汲取知識和策略,更好地理解和處理復(fù)雜任務(wù)。

本文中的示例應(yīng)用是Microsoft Word,在該環(huán)境下共收集了2,192個成功的專家軌跡。每個軌跡由一系列狀態(tài)-動作對(???? , ????)組成。通過對這些成功的行動序列進行學(xué)習(xí),我們獲得了LAM2。

階段3:動態(tài)調(diào)整與優(yōu)化

之后,我們讓模型嘗試解決GPT-4o失敗的任務(wù),通過ReAct機制與環(huán)境進行交互。

首先從GPT-4o失敗的任務(wù)中采樣2,284個任務(wù),并收集了LAM2生成的496個成功軌跡,將這些數(shù)據(jù)與2,192個GPT-4o成功軌跡相結(jié)合,形成了一個增強數(shù)據(jù)集。

在這一階段,LAM會自主探索新的解決方案,嘗試解決那些曾難倒其他AI系統(tǒng)的問題,拓展自身能力邊界,增強對不同任務(wù)和場景的適應(yīng)性。

階段4:從獎勵機制中學(xué)習(xí)

盡管模型在前述階段有所改進,但未能充分利用失敗所帶來的學(xué)習(xí)機會。

因此,論文引入了強化學(xué)習(xí)來解決這些問題。通過基于獎勵的訓(xùn)練對系統(tǒng)進行微調(diào),根據(jù)模型執(zhí)行任務(wù)的結(jié)果給予相應(yīng)的獎勵或懲罰,引導(dǎo)模型不斷優(yōu)化行為策略,以達到更好的效果。

可以看到,訓(xùn)練LAM的過程包括四個步驟:首先,模型學(xué)習(xí)如何將任務(wù)分解為邏輯步驟。其次,通過先進的AI系統(tǒng)(如GPT-4o)學(xué)習(xí)如何將計劃轉(zhuǎn)化為具體行動。然后,LAM會獨立探索新的解決方案。最后,通過獎勵機制進行微調(diào)訓(xùn)練。

表中總結(jié)了每個階段使用的訓(xùn)練數(shù)據(jù)。

LAM數(shù)據(jù)收集與構(gòu)建

眾所周知,數(shù)據(jù)是訓(xùn)練LLM的基石。類似地,LAM在監(jiān)督微調(diào)階段也需要經(jīng)過精心準(zhǔn)備的以行動為導(dǎo)向的高質(zhì)量數(shù)據(jù)。

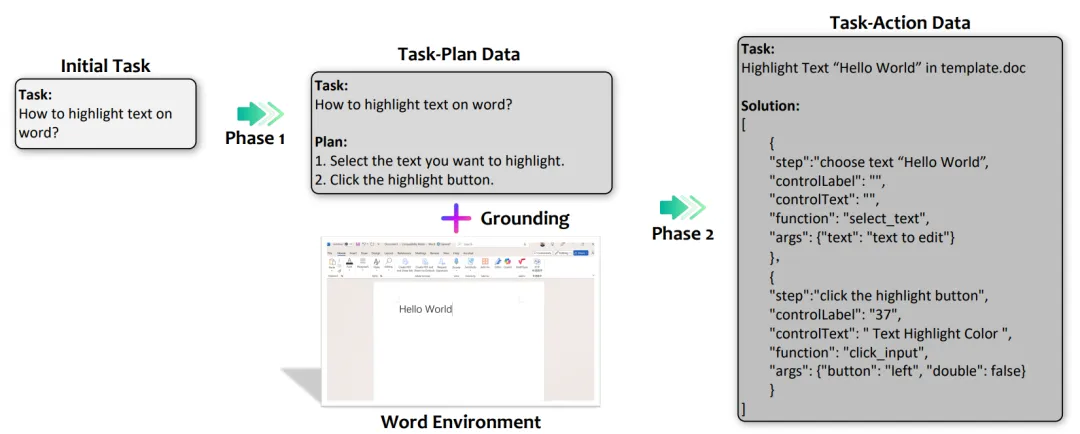

因此研究者采用了兩階段的數(shù)據(jù)收集:任務(wù)-計劃數(shù)據(jù)和任務(wù)-行動數(shù)據(jù),如下圖所示。

任務(wù)-計劃數(shù)據(jù):在這一階段,研究者收集包含任務(wù)和對應(yīng)計劃的數(shù)據(jù)。

任務(wù)是用自然語言表達的用戶請求,而計劃是為完成這些任務(wù)而設(shè)計的詳細(xì)步驟。例如,「如何在Word中更改字體大小?」會有一個對應(yīng)的計劃,概述完成該任務(wù)所需的步驟。

這些數(shù)據(jù)用于微調(diào)模型,以生成有效的計劃,并提升其高層次的推理和規(guī)劃能力。

構(gòu)建任務(wù)-計劃數(shù)據(jù)的流程

任務(wù)-行動數(shù)據(jù):在這一階段,任務(wù)-計劃數(shù)據(jù)被轉(zhuǎn)換為任務(wù)-行動數(shù)據(jù),包括任務(wù)、計劃和執(zhí)行這些計劃所需的相應(yīng)動作序列。任務(wù)和計劃被細(xì)化為更具體且能夠在特定環(huán)境中執(zhí)行的內(nèi)容。

構(gòu)建任務(wù)-行動數(shù)據(jù)的流程

經(jīng)過上述圖中的4個處理步驟后,最終生成的動作序列類似于:

select_text(text="hello")或者是

click(notallow=Button("20"), how="left", double=False)也就是能夠直接與環(huán)境交互的可執(zhí)行指令。

總的來說,任務(wù)-計劃數(shù)據(jù)旨在增強模型的高層次規(guī)劃能力,使其能夠根據(jù)用戶請求生成詳細(xì)的逐步計劃。

而任務(wù)-行動數(shù)據(jù)則側(cè)重于通過將每個計劃步驟轉(zhuǎn)化為具體、可執(zhí)行的步驟或序列,從而賦予模型執(zhí)行這些計劃的能力,并能接受環(huán)境的實時反饋。

數(shù)據(jù)收集和準(zhǔn)備流程確保模型能夠同時進行高層次規(guī)劃和低層次行動執(zhí)行,從而彌合了LLM生成計劃與能夠采取可執(zhí)行行動之間的差距。

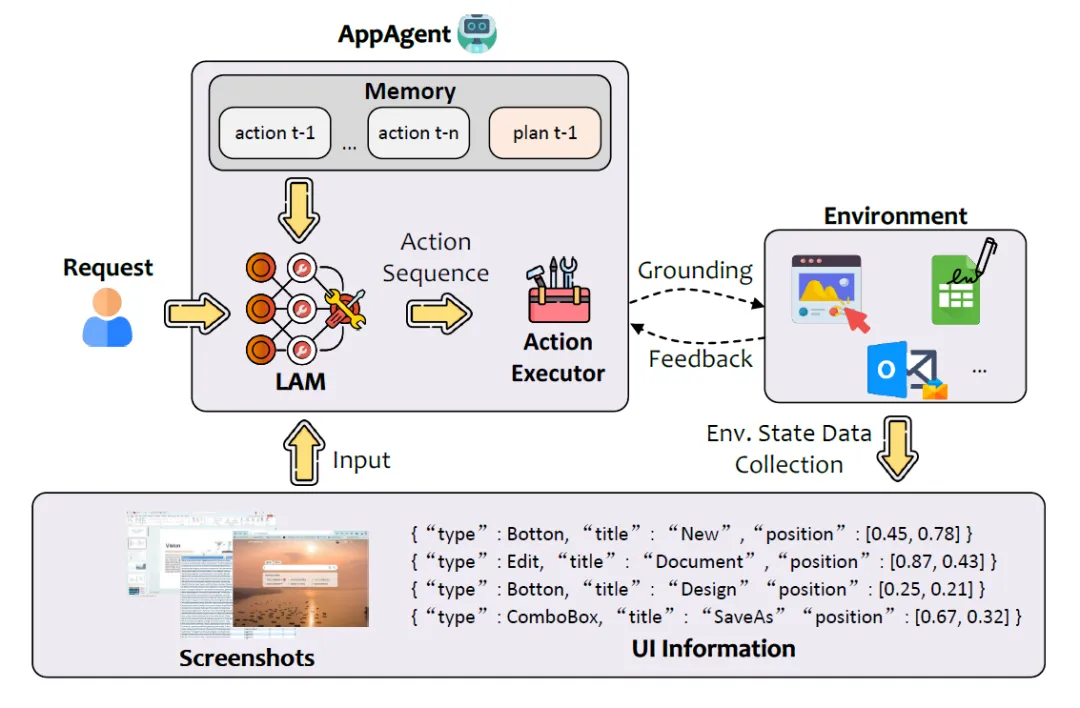

LAM的在線評估

我們將訓(xùn)練完成的LAM集成到GUI智能體UFO中,使模型預(yù)測的行動能夠在Windows操作系統(tǒng)中有效執(zhí)行,并與環(huán)境進行交互。

UFO智能體通過接受自然語言的用戶請求,并與Windows應(yīng)用程序的UI控件進行互動,完成具體任務(wù)。

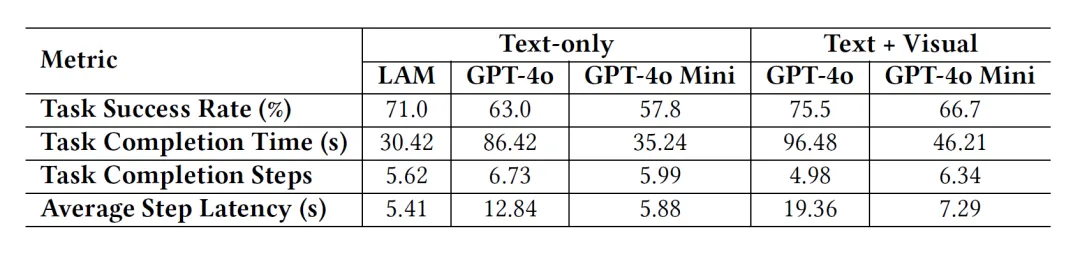

我們采用以下指標(biāo)對 LAM 的性能進行全面評估:

1. 任務(wù)成功率(Task Success Rate, TSR): 成功完成任務(wù)的數(shù)量占嘗試總?cè)蝿?wù)數(shù)量的百分比。

2. 任務(wù)完成時間: 從初始請求到最終動作完成的總時間。

3. 任務(wù)完成步驟: 智能體成功完成每個任務(wù)所執(zhí)行的總動作步驟數(shù)量。

4. 平均步驟延遲: 每個動作步驟的平均耗時。

LAM在Word測試環(huán)境中的成功率為71%,而GPT-4o在無視覺信息輸入的情況下,成功率為63%。

此外,LAM的執(zhí)行速度也更快,每個任務(wù)僅需30秒,而GPT-4o則需要86秒,是LAM的2.8倍。

實驗結(jié)果突顯了LAM作為僅使用文本的模型的優(yōu)勢,使LAM成為實際應(yīng)用中有效的解決方案。

未來展望

LAM的推出為辦公自動化、復(fù)雜任務(wù)處理等領(lǐng)域帶來了新的可能性。例如,在Microsoft Office中,LAM可以自動執(zhí)行文檔編輯、表格處理等任務(wù),極大地提高工作效率。此外,LAM還有潛力在更多領(lǐng)域發(fā)揮重要作用。

LAM展示了其發(fā)展?jié)摿Γ谏虡I(yè)化落地中仍然面臨一些挑戰(zhàn),例如,控制機器人系統(tǒng)的LAM可能會誤解指令并導(dǎo)致?lián)p害;金融或醫(yī)療應(yīng)用中如果執(zhí)行錯誤動作,可能帶來嚴(yán)重的后果。

然而,研究人員相信,LAM代表了AI發(fā)展的一次重要轉(zhuǎn)變,預(yù)示著AI助手將能更積極地協(xié)助人類完成實際任務(wù)。

行動勝于言辭

LAM的推出標(biāo)志著人工智能從語言理解向任務(wù)執(zhí)行的轉(zhuǎn)變,開啟了AI自主的新時代。從生成語言到執(zhí)行具體動作,大模型將能在現(xiàn)實世界中產(chǎn)生直接影響,這是邁向AGI的關(guān)鍵一步。

未來,隨著技術(shù)的不斷發(fā)展,LAM將在更多領(lǐng)域發(fā)揮重要作用,為我們的生活和工作帶來更多便利和驚喜。