CoBEVFlow:解決車路協同感知的時序異步問題

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面&個人理解

協同感知技術能夠有效解決單體感知中存在的障礙物遮擋、視角受限、以及遠距離感知能力弱等問題。然而實際場景中存在著網絡用塞、延遲等問題,協同感知受此影響,性能會嚴重下降,甚至低于單體感知效果。NeurIPS 2023的最新研究文章 《Asynchrony-Robust Collaborative Perception via Bird’s Eye View Flow》將協同信息時間戳不對齊的協同感知任務定義為時序異步的協同感知(Asynchrony Collaborative Perception),來自上海交通大學、南加州大學、和上海人工智能實驗室的研究者們在本文中提出了CoBEVFlow:基于鳥瞰圖流(BEV Flow)的時序異步魯棒的協同感知系統。實驗效果表明,CoBEVFlow能有效緩解時序異步帶來的影響。

- 論文鏈接:https://arxiv.org/abs/2309.16940

- 代碼鏈接:https://github.com/MediaBrain-SJTU/CoBEVFlow

- 項目主頁:https://sizhewei.github.io/projects/cobevflow/

CoBEVFlow的出發點

近年來,自動駕駛領域在學術界和工業界都受到了極大的關注。但真實世界中道路情況復雜多變,且存在著行人、非機動車、不遵守交通規則的道路參與者甚至少數情況下會出現動物等情況,這些特殊情況都會給自動駕駛技術的應用帶來極大挑戰。對于在單車部署傳感器(如相機、激光雷達、毫米波雷達等),基于單車傳感器的目標檢測的方法稱為單體感知。盡管單體感知在目前的多數情況下表現尚可,但這種感知方式存在固有的局限性。單體感知依賴自身的傳感器,其感知能力受限于傳感器的視角、有效距離和精度。例如,當傳感器遭受遮擋,視角受限時,感知能力就會大幅下降,為智能體后續的認知和決策帶來安全隱患。此外,對于遠處的物體,激光雷達產生的點云過于稀疏,無法提供有效的位置信息,導致感知系統很難對遠距離的環境進行感知。下圖就是一個真實場景中由于視線遮擋,對于人類駕駛員也非常頭痛的“鬼探頭”問題。

圖 1. 視線遮擋造成的“鬼探頭”問題令人類駕駛員也非常頭痛!

圖 1. 視線遮擋造成的“鬼探頭”問題令人類駕駛員也非常頭痛!

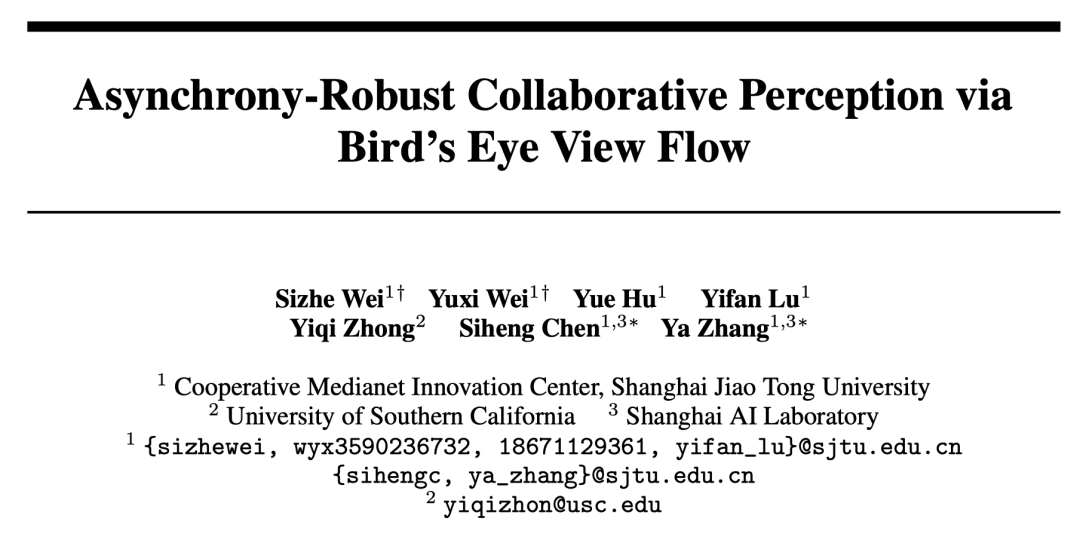

多智能體之間的協同感知為單體感知存在的這些問題提供了解決方案。隨著通信技術的發展,多個智能體之間可以利用通信共享彼此的信息,每個智能體可以結合自身傳感器信息與其他智能體的信息,對周圍環境進行感知。通過智能體之間的協作,每個智能體可以獲取自身視野盲區與可視距離以外的信息,有助于提升每個智能體的感知以及決策能力。此外,協同感知也能減少智能體對于高精度長距離傳感器的依賴,通過多個使用低精度、低成本傳感器的智能體相互協作,達到甚至超過單個裝配高精度傳感器的感知能力。在現實世界中,由于通信延遲、擁塞、中斷、時鐘錯位、以及采樣頻率不一致等等問題,智能體接收到的協作信息所帶有的時間戳不一致是不可避免的。如圖所示,藍色車輛代表元智能體(ego agent),而另外兩輛車在連續時間軸上的不同時刻傳遞協作信息。在這種情況下,元智能體收集到的信息發生在不對齊的時間戳上。

圖 2. 異步通信示意圖。來自不同智能體的協作信息帶有的時間戳是連續時間軸上的任意值。

圖 2. 異步通信示意圖。來自不同智能體的協作信息帶有的時間戳是連續時間軸上的任意值。

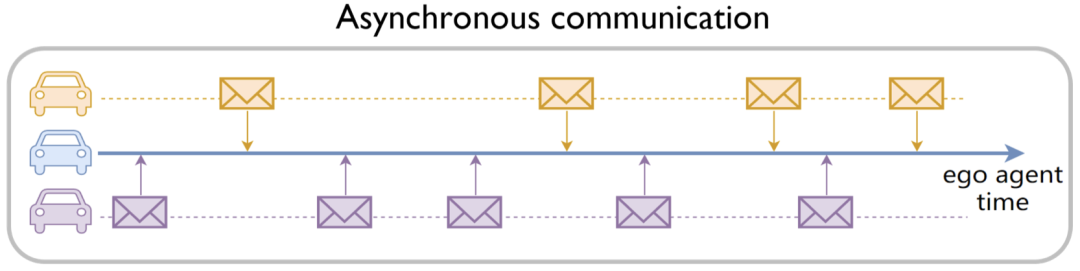

這個問題會導致多智能體融合過程中信息不匹配——來自不同智能體的協作信息中對同一個移動目標的位置信息是不同的,從而導致協同感知得到的感知結果甚至比單個智能體感知結果更差。如果忽視這個問題,仍然使用傳統的協作感知方法,得到的協作感知結果如圖所示。

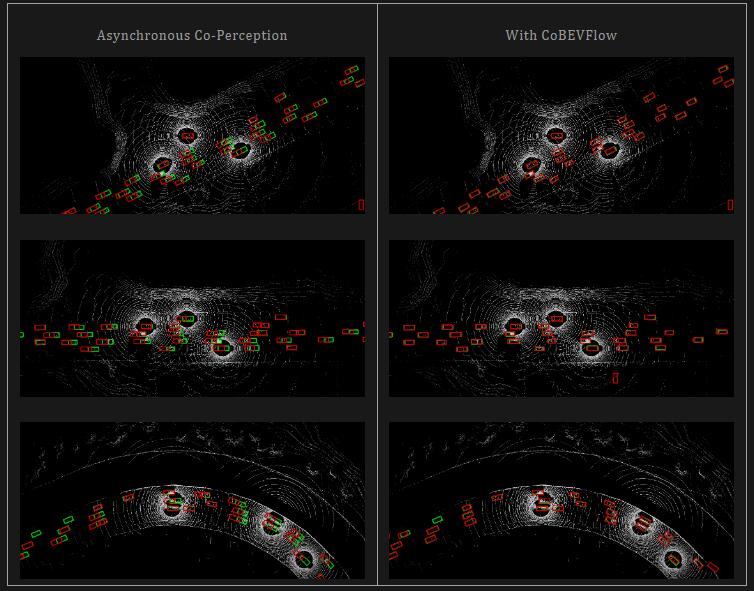

圖 3. 協作信息時間戳不一致對協作感知造成的影響。紅色表示感知結果,綠色表示真實值。左圖為協作不一致的情況下,不使用CoBEVFlow的結果,右圖為經過CoBEVFlow處理過的結果。

紅色框表示檢測結果,綠色框表示真實值,“錯誤的”協作信息會干擾元智能體的單體感知信息,導致結果甚至比單體感知結果。這也就意味著時間戳不對齊問題導致協作失去了意義。

為此,研究者們定義了異步協作感知(Asynchrony Co-Perception)任務。其中異步表示來自參與協作的智能體所傳遞的協作信息帶有的時間戳不一致,而且來自同一個智能體的連續兩幀信息之間的時間間隔是不固定的。基于這個問題,該文提出了基于鳥瞰流圖(BEV Flow)的時序異步魯棒的協同感知系統:CoBEVFlow。

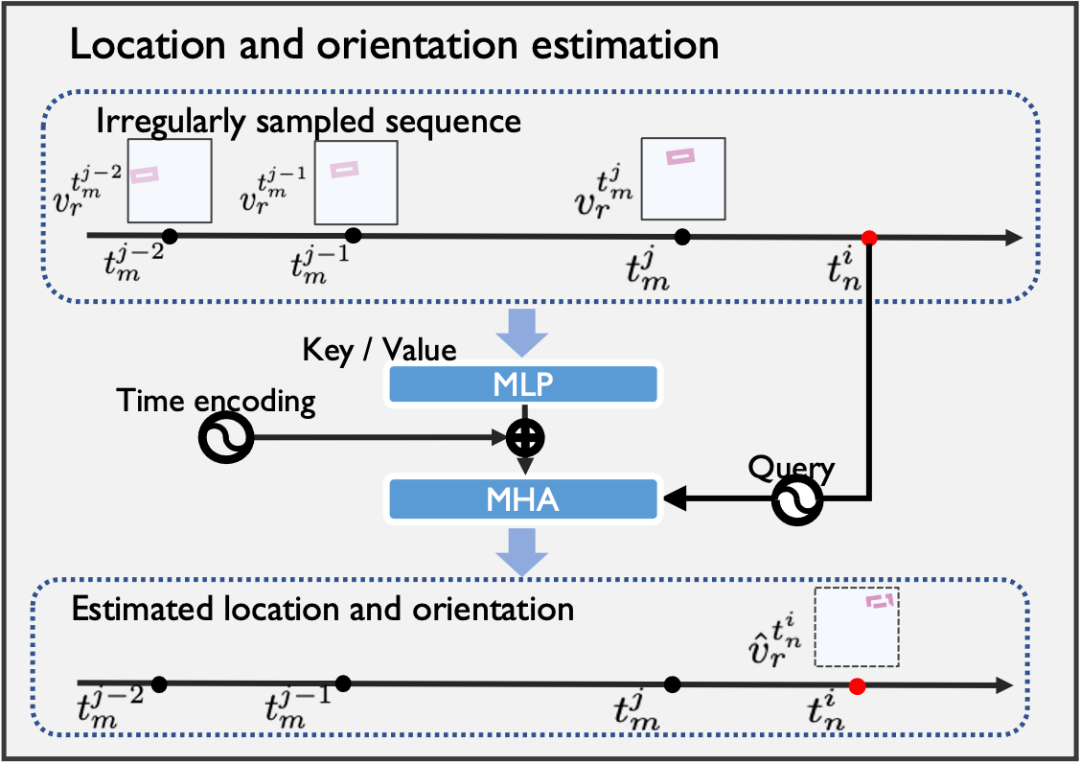

CoBEVFlow的問題定義

研究者們首先對異步協同感知任務給出了數學定義:

對于場景中的 個智能體,每個智能體可以向其他智能體發送/接收協作信息,并存儲來自任何智能體的最多 個歷史幀的消息。對于第 個智能體, 和 分別是在當前時間 的原始觀察和感知真實值(ground truth),其中 是智能體 的第 個時間戳, 是智能體 在時間 發送給智能體 的協作消息。異步設置的關鍵在于每個協作消息的時間戳 是一個連續值,來自其他智能體的這些消息不對齊,即 ,并且兩個連續時間戳 之間的時間間隔是不固定的。因此,每個智能體會在任意時間接收到其他智能體發送的協作消息。因此,異步協作感知的任務可以表示為:

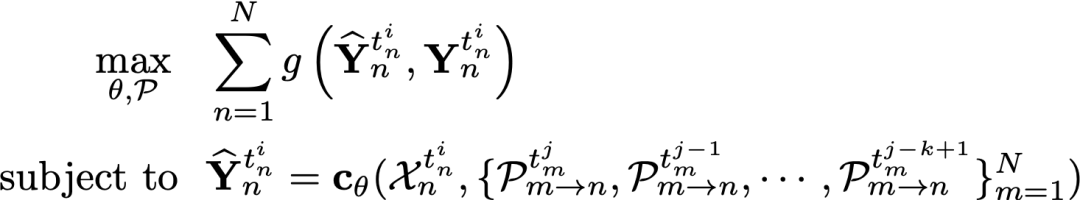

其中 是感知評估指標, 是智能體 在時間 的感知結果, 是具有可訓練參數 的協作感知網絡,并且 $t_m^{j-k+1}<t_m^{j-k+2}<\cdots<t_m^j\le t_n^i$。需要注意的是:當來自其他智能體的協作消息都對齊且兩個連續時間戳之間的時間間隔是規則的;即,對于所有智能體對="" $m,n$,有="" $t_m^i="t_n^i$,對于所有智能體" $n$,$t_n^i-t_n^{i-1}$="" 是一個常數,該任務退化為理想情況下時序同步的協作感知。<="" p="">

CoBEVFlow的方法介紹

異步協作感知的本質問題是,來自多個智能體的協作信息可能給同一個移動目標記錄不同時刻的位置信息。因此研究者們提出的CoBEVFlow用兩個核心思路來解決這個問題:

- 生成一個感興趣區域(ROI)集,后續只針對這些集合中的特征進行操作;

- 捕捉歷史幀中這些感興趣區域的運動趨勢,根據運動趨勢將對應位置的特征重新對齊到當前時刻的位置。

通過這兩個思想,避免了直接修改特征,并保持了背景特征,所以CoBEVFlow不會引入不必要的噪聲。

CoBEVFlow的總體框架

圖 4. CoBEVFlow框架圖。

圖 4. CoBEVFlow框架圖。

如CoBEVFlow框架圖所示,原始感知信息 通過編碼器得到特征 。在Message Packing 模塊中,特征通過 ROI 生成器得到 ROI集 ,同時作為掩碼得到稀疏特征 ,每個智能體將ROI集和稀疏特征作為協作信息打包發送。智能體收到來自其他的智能體發送的協作信息之后,在Message Fusion模塊中處理協作信息。基于來自同一智能體的過去 幀信息,通過Flow生成器生成鳥瞰流圖(BEV Flow Map) ,并利用該流圖,將稀疏特征圖上的特征挪動到當前時刻的位置上,也即得到挪動后特征 。將處理好的特征與自身的特征進行融合得到融合后特征 ,隨機進入解碼器得到最后的感知結果 。

信息打包模塊(Message Packing)

生成BEV特征圖上的ROI集合,然后發送這些集合以及對應的稀疏特征。其中ROI生成器采用的網絡架構和解碼器一致,但是網絡參數并不需要保持一致。這樣做的目的是,讓ROI生成器學習到更多關于單體感知的特征分布。

信息融合模塊(Message Fusion)

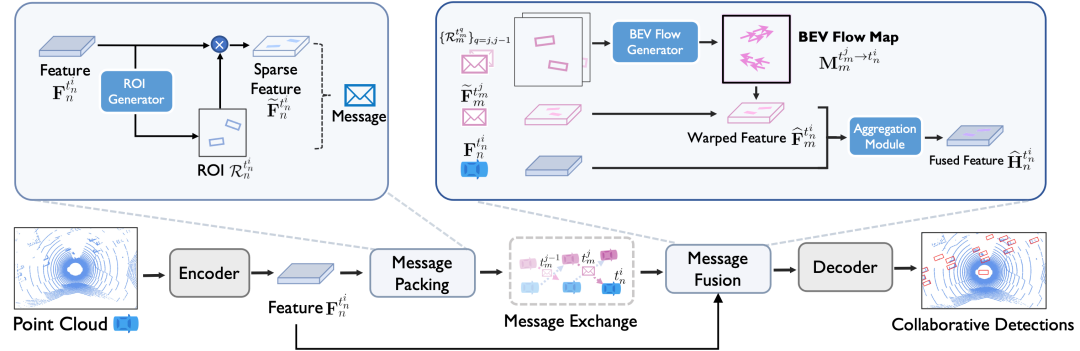

捕捉這些ROI的運動趨勢,叫做BEV Flow Map,利用BEV Flow來將異步的信息對齊到當前時刻,再進行融合。BEVFlow的生成包括兩個關鍵步驟:

- 相鄰時間戳的ROI匹配;

- BEVFlow估計。

圖 5. BEV Flow Map生成包括:ROI匹配和Flow生成過程。

圖 5. BEV Flow Map生成包括:ROI匹配和Flow生成過程。

相鄰幀的ROI匹配:目的是匹配同一智能體在連續兩個時間戳上發送的信息中的感興趣區域(ROI)。匹配上的ROI本質上就是在不同時間戳下的同一個目標。匹配包含三個過程:成本矩陣構建、貪婪匹配和后處理。首先構建成本矩陣,其中每個值表示兩個時間戳下兩個ROI之間的匹配成本,矩陣中的每個值是基于角度和距離計算的。接著使用貪婪匹配策略來搜索配對的ROI。最后,后處理中通過刪除匹配對中過大的值所代表的配對來避免無效匹配。

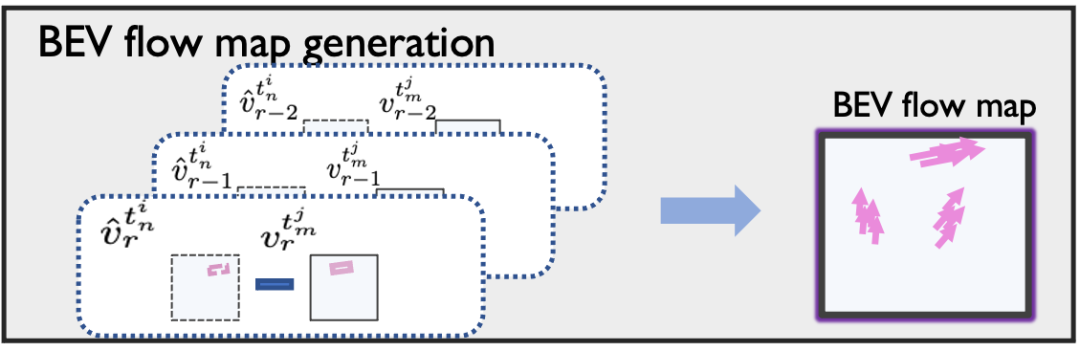

圖 6. BEV Flow 估計示意圖。

圖 6. BEV Flow 估計示意圖。

BEV Flow估計:檢索每個ROI在一系列不規則時間戳下的歷史位置。這個模塊是一個基于注意力機制的模塊,使用這些不規則的軌跡段來預測元智能體的當前時間戳下這些ROI的位置和方向,并生成相應的BEV Flow。與使用循環神經網絡處理常規通信延遲的方法SyncNet(ECCV'22) 相比,生成的BEV Flow具有兩個優點:i)它通過基于注意力機制的估計和適當的時間編碼來處理不規則的異步情況;ii)它基于運動趨勢的來移動特征,避免了重新生成整個特征圖。

實驗效果

為了驗證CoBEVFlow的效果,研究者們在兩個數據集上進行了實驗,分別是IRV2V和DAIR-V2X。其中IRV2V是本文提出的首個異步協作感知數據集,其包含不同程度的時間異步性,而DAIR-V2X是真實數據集。實驗的任務是基于點云的目標檢測。使用交并比(Intersection-over-Union,IoU)閾值為 0.50 和 0.70 對檢測性能進行評估,采用平均精度(Average Precision,AP)作為評價指標。

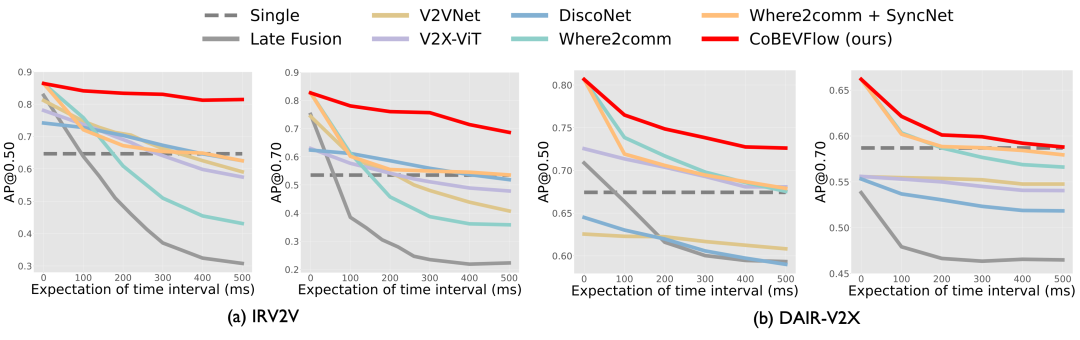

CoBEVFlow (紅實線) 在異步情況下顯著魯棒

圖 7. 在時間間隔期望值從 0 到 500 毫秒的情況下,CoBEVFlow 與其他基準方法的性能進行了比較。CoBEVFlow 在兩個數據集上表現優于所有基準方法,并展現了在任何異步水平下的出色魯棒性。

圖 7. 在時間間隔期望值從 0 到 500 毫秒的情況下,CoBEVFlow 與其他基準方法的性能進行了比較。CoBEVFlow 在兩個數據集上表現優于所有基準方法,并展現了在任何異步水平下的出色魯棒性。

研究者們對比了現有的協同感知SOTA方法與CoBEVFlow在不同的異步程度下的感知結果。如圖,紅色虛線表示沒有協作的單體檢測,紅色實線表示CoBEVFlow。所有方法均使用基于 PointPillars 的特征編碼器。為了模擬時間異步性,研究者們使用二項分布對接收到的消息的幀間隔進行采樣,以獲取隨機的不規則時間間隔。圖中展示了在 IRV2V 和 DAIR-V2X 上,所提出的 CoBEVFlow 和SOTA方法在不同程度時間異步性下的檢測性能(AP@IoU=0.50/0.70)比較,其中 x 軸是最新接收信息的延遲時間間隔和相鄰幀之間的間隔的期望值,y 軸是檢測結果。需要注意的是,當 x 軸為 0 時,表示為標準的協作感知沒有任何異步性。可以看出:i)在所有異步程度下, CoBEVFlow 在模擬數據集(IRV2V)和真實世界數據集(DAIR-V2X)中均實現了最佳性能。在 IRV2V 數據集上,在 300ms期望間隔下,CoBEVFlow 在 AP@0.50 和 AP@0.70 方面分別比最好的SOTA方法提高了 23.3% 和 35.3%。類似地,在 500ms 間隔期望下,分別實現了 30.3% 和 28.2% 的提升。在 DAIR-V2X 數據集上,CoBEVFlow 依舊效果領先。ii)CoBEVFlow 表現出了顯著的異步魯棒性。如圖中的紅線所示,在不同的異步情況下,CoBEVFlow 在 IRV2V 數據集上僅出現 4.94% 和 14.0% 的 AP@0.50 和 AP@0.70 下降。這些結果遠超過了單一目標檢測的性能,甚至在極端的異步情況下也是如此。

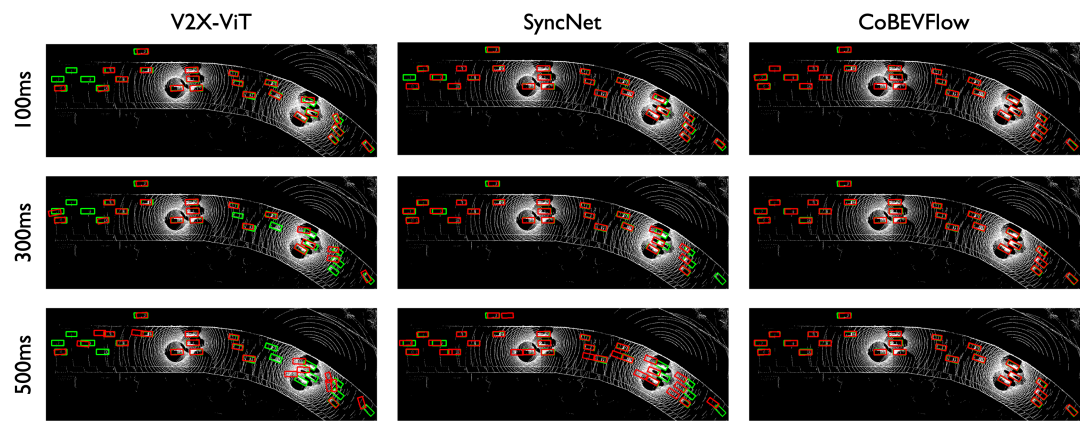

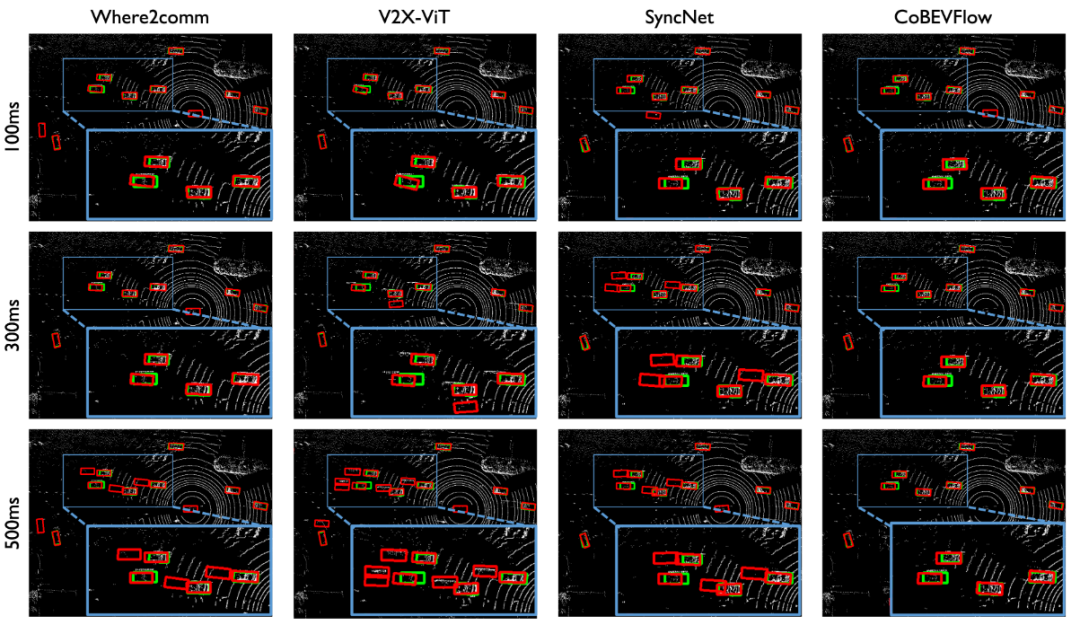

圖 8. CoBEVFlow與SOTA方法在IRV2V數據集上的可視化對比,紅色是預測結果,綠色是真實值。 圖 9. CoBEVFlow與SOTA方法在DAIR-V2X 數據集上的可視化對比。紅色是預測結果,綠色是真實值。

圖 9. CoBEVFlow與SOTA方法在DAIR-V2X 數據集上的可視化對比。紅色是預測結果,綠色是真實值。

圖 10. 時序異步情況下采用where2comm(左)直接進行協同感知的結果,與利用CoBEVFlow(右)進行協同感知的結果對比。紅色為預測結果,綠色為真實值。

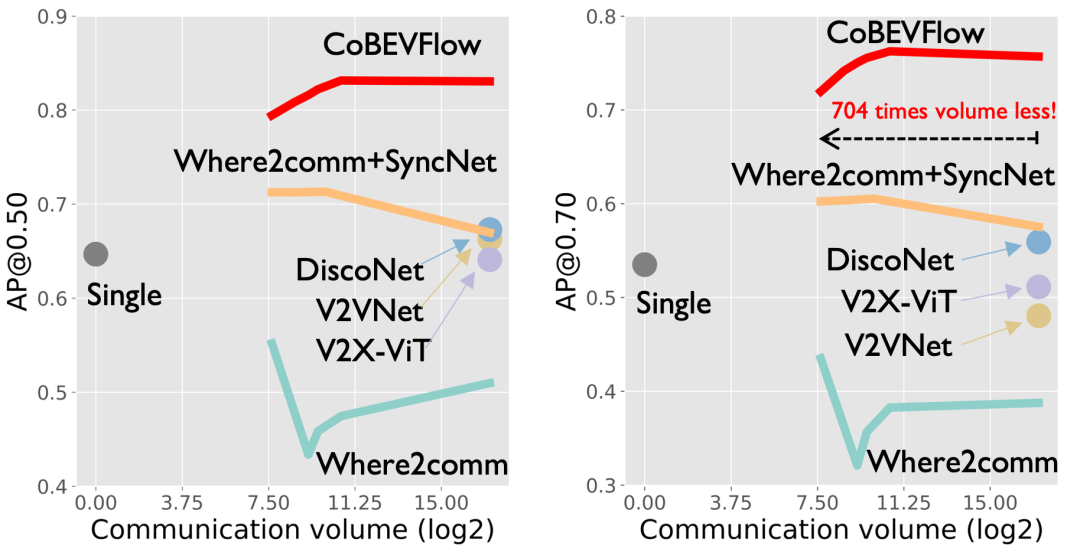

CoBEVFlow (紅實線) 顯著節省通信帶寬

圖 11. 感知性能與通信帶寬之間的關系(時序異步期望為300ms)。

圖 11. 感知性能與通信帶寬之間的關系(時序異步期望為300ms)。

研究者們對比了不同方法的性能與通信帶寬之間的關系。如圖,紅色實線表示CoBEVFlow。在時間異步的期望值為300毫秒的情況下,隨著通信量的增加,CoBEVFlow的性能持續穩定提高,而where2comm和SyncNet的性能由于異步信息而導致性能波動。CoBEVFlow能夠顯著節省通信帶寬的原因是,其協作信息只包含ROI區域中的稀疏特征以及ROI集,而不用整個特征圖進行協作。

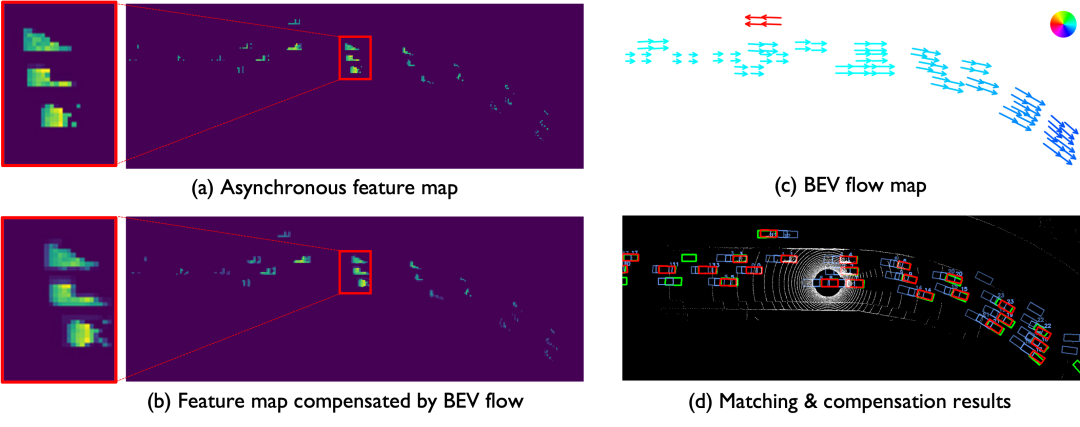

CoBEVFlow能夠避免引入額外噪聲

圖 12. BEV Flow Map的效果可視化。(a)(b)分別是經過矯正前后的中間特征可視化,(c) 為BEV flow map的可視化,(d) 為匹配結果的可視化。

圖 12. BEV Flow Map的效果可視化。(a)(b)分別是經過矯正前后的中間特征可視化,(c) 為BEV flow map的可視化,(d) 為匹配結果的可視化。

CoBEVFlow利用歷史協作信息生成鳥瞰流圖——BEV Flow Map,并根據流圖,將BEV特征圖上的“網格”特征找到新的對應的索引。這個過程的思想是“挪動”異步的特征到當前時刻對應的位置上,不涉及對于特征的數值變換,避免了引入額外的噪聲(事實上,在挪動特征的過程中,用到了PyTorch內置的函數進行warp操作,存在著微小的差值誤差)。研究人員們將原始的特征和挪動后的特征分別進行可視化,如圖中的子圖(a)、(b)。同時,將生成額BEV Flow Map以及ROI區域的配對結果進行了可視化,如圖中的子圖(c)、(d)。能從圖中看出,該文提出的鳥瞰流圖生成器對于不同幀中的ROI區域能夠有效配對,也因此可以捕捉到ROI區域的運動趨勢,并生成流圖,用來矯正特征圖。

圖 13. 鳥瞰流圖的連續多幀可視化結果。

圖 13. 鳥瞰流圖的連續多幀可視化結果。

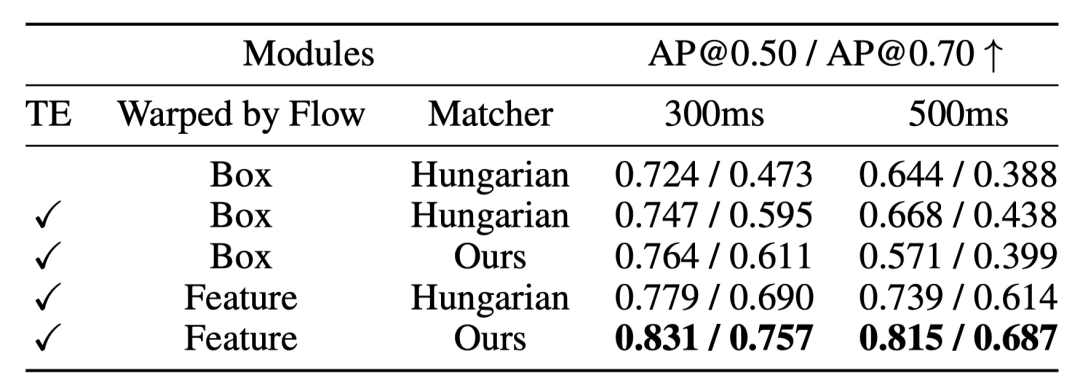

BEV Flow Map 作用在中融合優于后融合

表 1 IRV2V數據集上的消融實驗結果。

表 1 IRV2V數據集上的消融實驗結果。

既然生成的BEV Flow Map能夠準確捕捉ROI的運動趨勢,那為什么不直接對檢測框的位置進行矯正?研究人員們針對這個問題也在消融實驗的部分進行了實驗驗證。如表格中的第3行和第5行的對比,能夠看出,對于特征的矯正比對于檢測框位置的矯正效果要好。研究人員猜測,可能是感興趣區域對于單車檢測未必是一個完整的物體,但是經過多車融合后的特征圖,包含了來自多個協作者的信息,因此對于一些在單車視角下“不確定”的目標,中融合對于中間特征進行操作將更有優勢。此外,消融實驗中也進行了關于時間編碼和不同的匹配算法的效果驗證。

總結

CoBEVFlow關注解決協同感知中存在的時序異步問題。其提出的核心思路有兩個:一是每個智能體發送的協作信息中應包含感興趣區域與其對應的稀疏特征圖。二是在協作感知時,基于收集到的歷史信息生成BEV Flow,并用其“矯正”時序異步的特征。通過這兩兩個關鍵思路,CoBEVFlow能夠有效處理包含延遲、中斷、采樣頻率不一致等原因導致的時序異步問題,同時不會對特征圖引入額外的噪聲。

原文鏈接:https://mp.weixin.qq.com/s/BNFPPrQB4dVhm66p_ikqjA