最新Claude2.1、Llama 2隨便用!亞馬遜把生成式AI開發(fā)門檻打下去了

好消息,搞生成式AI應(yīng)用的門檻,被狠狠地打下去了!

就在剛剛,亞馬遜云科技在年度盛會(huì)re:Invent中正式宣布:

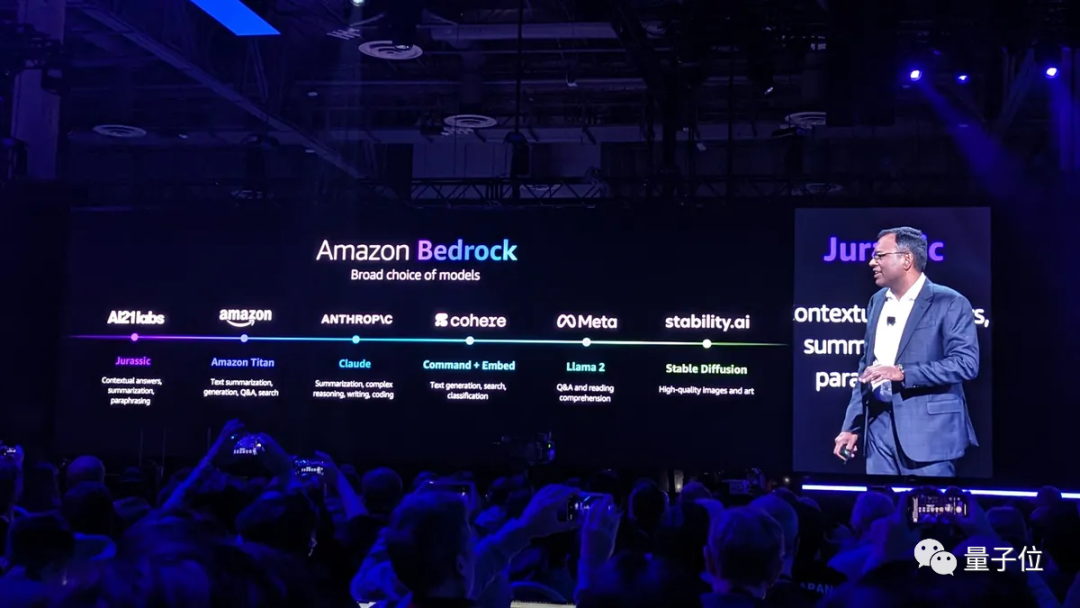

在我這搞生成式AI應(yīng)用,主流、最新大模型隨便用~

例如Meta家的Llama 2 70B、Antropic家的Claude 2.1等等:

能夠?qū)⑷绱吮姸啻竽P汀按虬逼饋?lái)的集大成者,便是亞馬遜云科技的AI大模型服務(wù)Amazon Bedrock。

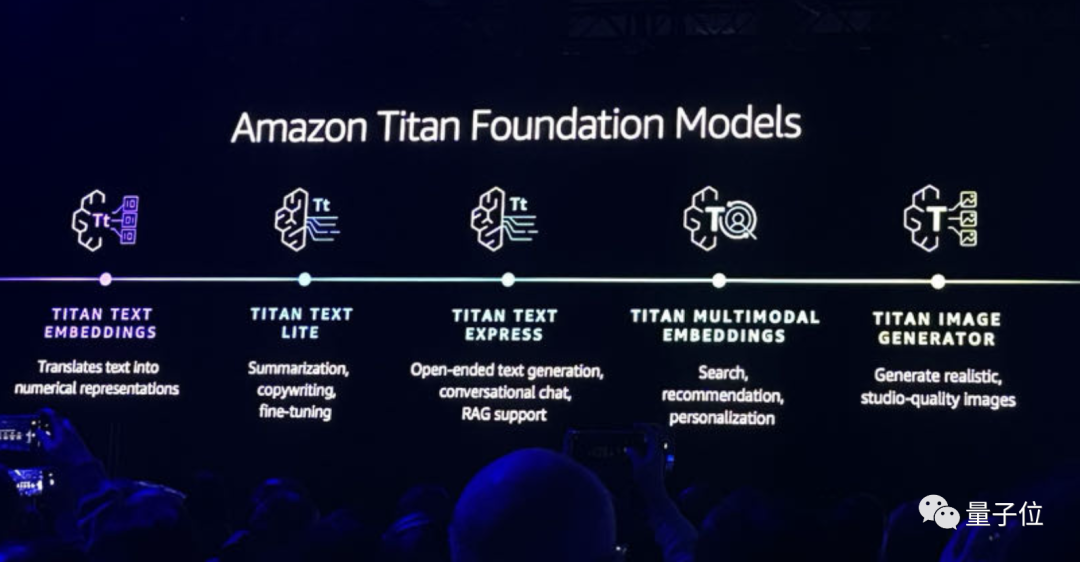

當(dāng)然,其中也包含了自家最新升級(jí)的大模型Titan:

- Titan Text Embeddings:將文本轉(zhuǎn)變?yōu)閿?shù)字表征;

- Titan Text Lite:可執(zhí)行對(duì)文本的總結(jié)、文案生成和微調(diào);

- Titan Text Express:開放式文本生成、會(huì)話聊天,并支持RAG;

- Titan Multimodel Embeddings:支持搜索、推薦和個(gè)性化定制;

- Titan Image Generator:可生成超現(xiàn)實(shí)、影棚級(jí)質(zhì)量的圖片。

亞馬遜云科技AI副總裁Swami Sivasubramanian,還在現(xiàn)場(chǎng)演示了Titan Iamge Generator的能力。

例如只需一句話就可以將一只綠色蜥蜴,毫無(wú)PS痕跡地變成橘色:

再如把圖片掉轉(zhuǎn)個(gè)方向,也是只是一句話的事兒了:

方便,著實(shí)是方便。

不過(guò)縱觀整場(chǎng)發(fā)布會(huì),這些個(gè)功能和升級(jí)也還僅是亞馬遜云科技把門檻打下去的動(dòng)作一隅。

還有更多新功能的發(fā)布,讓搞生成式AI應(yīng)用變得簡(jiǎn)單了不少。

SageMaker上新

SageMaker是亞馬遜云科技長(zhǎng)期押注的一個(gè)項(xiàng)目,它的主要作用便是構(gòu)建、訓(xùn)練和部署機(jī)器學(xué)習(xí)模型。

Swami在今天的大會(huì)中宣布了它的諸多新功能,讓客戶可以更輕松地去構(gòu)建、訓(xùn)練和部署生成式AI模型。

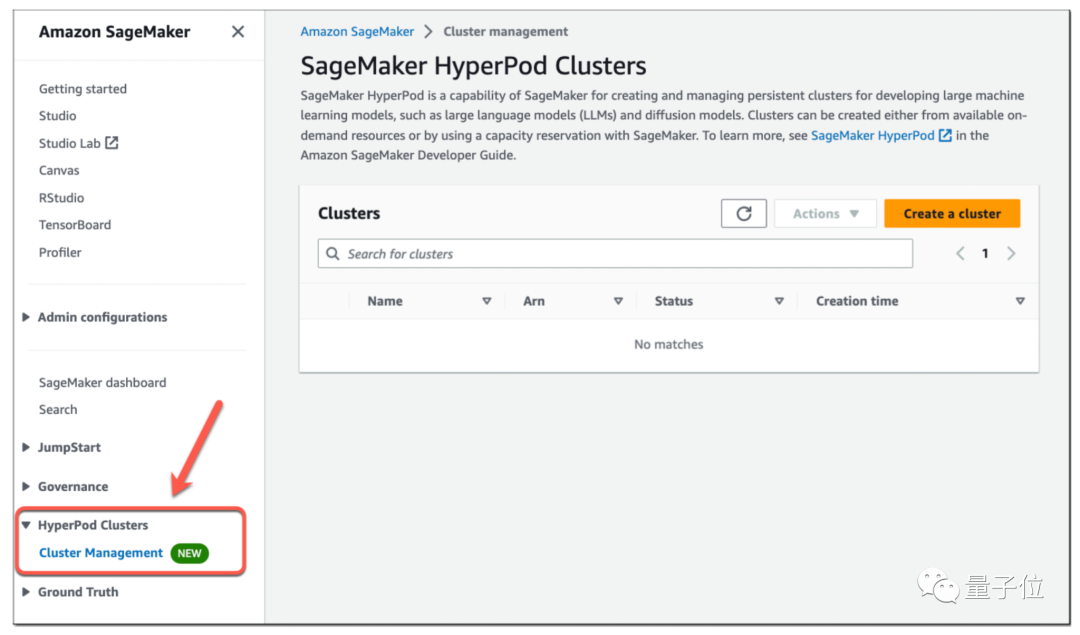

首先,便是SageMaker HyperPod功能。

我們都知道,以往基礎(chǔ)模型通常過(guò)于復(fù)雜,無(wú)法使用單個(gè) AI 芯片進(jìn)行訓(xùn)練;因此,它們必須拆分到多個(gè)處理器上,這是一項(xiàng)技術(shù)上復(fù)雜的工作。

而SageMaker HyperPod可以提供對(duì)按需AI訓(xùn)練集群的訪問(wèn),開發(fā)人員可以通過(guò)點(diǎn)擊式命令和相對(duì)簡(jiǎn)單的腳本組合來(lái)配置集群,這比手動(dòng)配置基礎(chǔ)架構(gòu)要快得多。

Swami在現(xiàn)場(chǎng)表示:

SageMaker HyperPod將訓(xùn)練基礎(chǔ)模型所需的時(shí)間減少了40%。

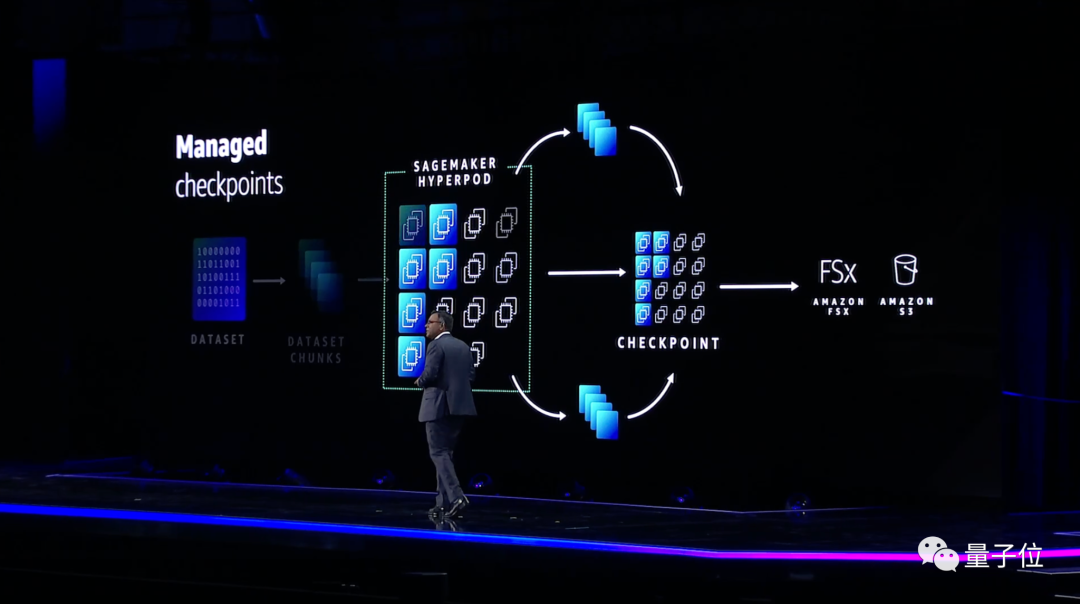

SageMaker HyperPod不僅可以自動(dòng)執(zhí)行設(shè)置AI訓(xùn)練集群的過(guò)程,它還可以自動(dòng)執(zhí)行其維護(hù)。

當(dāng)客戶集群中的某個(gè)實(shí)例脫機(jī)時(shí),內(nèi)置的自動(dòng)化軟件會(huì)自動(dòng)嘗試修復(fù)它;如果故障排除嘗試不成功,SageMaker HyperPod 會(huì)將出現(xiàn)故障的節(jié)點(diǎn)換成新節(jié)點(diǎn)。

在某些情況下,基礎(chǔ)模型需要數(shù)周或數(shù)月的時(shí)間來(lái)訓(xùn)練。如果中斷使底層 AI 基礎(chǔ)設(shè)施脫機(jī),開發(fā)人員必須從頭開始重新開始訓(xùn)練,這可能會(huì)導(dǎo)致嚴(yán)重的項(xiàng)目延遲。

為避免此類情況,SageMaker HyperPod 會(huì)在訓(xùn)練期間定期保存AI模型,并提供從最新快照恢復(fù)訓(xùn)練的功能。

不僅如此,每個(gè)SageMaker HyperPod集群都預(yù)配置了一組亞馬遜云科技開發(fā)的分布式訓(xùn)練庫(kù)。

這些庫(kù)會(huì)自動(dòng)將開發(fā)人員的模型分散到集群中的芯片上,而且還可以將訓(xùn)練該模型的數(shù)據(jù)拆分為更小,更易于管理的部分。

其次,在推理方面,亞馬遜云科技推出了SageMaker Inference功能。

它的出現(xiàn)將有助于降低模型的部署成本和延遲;新的推理功能可以讓客戶單個(gè)端點(diǎn)上部署一個(gè)或多個(gè)基礎(chǔ)模型,并控制分配給它們的內(nèi)存和加速器數(shù)量。

具體降本增效的成果,亞馬遜云科技在現(xiàn)場(chǎng)也有介紹:

這項(xiàng)新功能可以幫助將部署成本降低50%,并將延遲減少20%。

在構(gòu)建機(jī)器學(xué)習(xí)模型的無(wú)代碼界面上的SageMaker Canvas也有所更新。

我們現(xiàn)在可以直接用自然語(yǔ)言去處理了!

在聊天界面中,SageMaker Canvas提供了許多與您正在使用的數(shù)據(jù)庫(kù)相關(guān)的引導(dǎo)提示,或者你可以提出自己的提示。

例如,你可以通過(guò)說(shuō)“準(zhǔn)備數(shù)據(jù)質(zhì)量報(bào)告”、“根據(jù)特定條件刪除行”等等,讓它來(lái)執(zhí)行你的需求。

……

總而言之,SageMaker今天的眾多能力更新,著實(shí)是讓模型的構(gòu)建、訓(xùn)練和部署簡(jiǎn)單了不少。

對(duì)數(shù)據(jù)也“下手”了

擁有強(qiáng)大的數(shù)據(jù)基礎(chǔ),對(duì)于充分利用生成式AI可以說(shuō)是至關(guān)重要。

Swami在現(xiàn)場(chǎng)表示,強(qiáng)大的數(shù)據(jù)基礎(chǔ)需要滿足三點(diǎn):全面(comprehensive)、集成(integrated)和治理(governed)。

圍繞這些特性,亞馬遜云科技在今天的大會(huì)中也做了相應(yīng)新功能的發(fā)布。

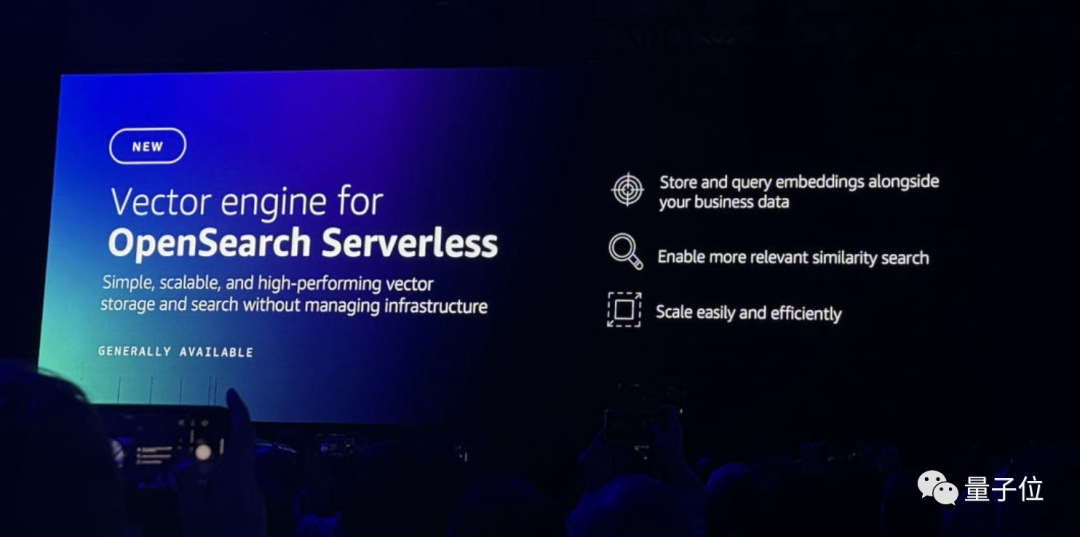

首先便是針對(duì)向量引擎的OpenSearch Serverless,它能夠帶來(lái)更高效的搜索和流程。。

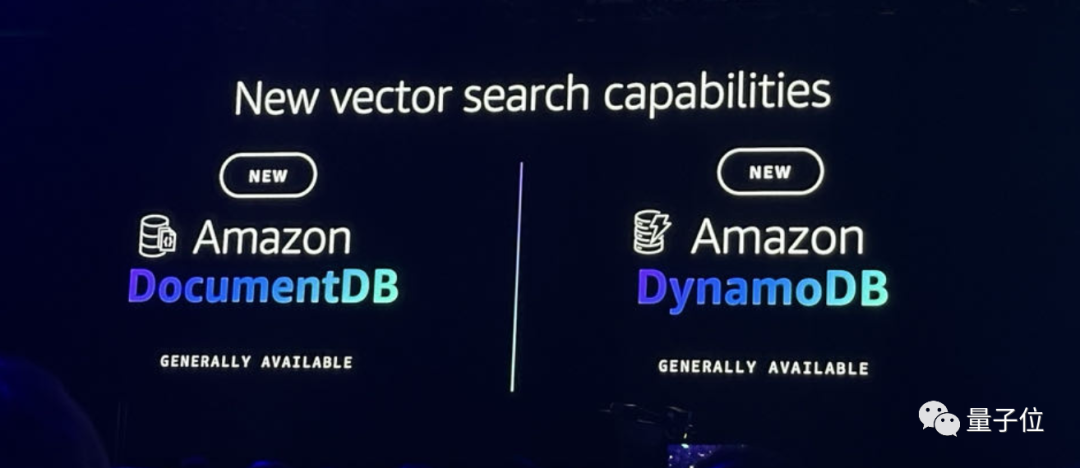

其次,DocumentDB和DynamoDB也加入到了向量功能,可以允許用戶將多種數(shù)據(jù)存儲(chǔ)在一起。

除此之外,MemoryDB for Redis也有了相應(yīng)更新,它也可以支持向量搜索,響應(yīng)時(shí)間變得更快,每秒可以處理數(shù)萬(wàn)個(gè)查詢。

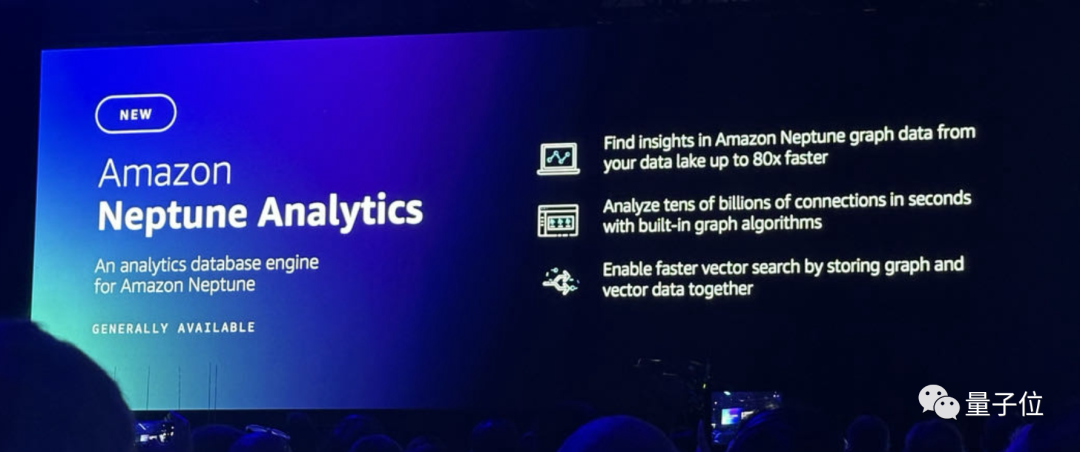

在分析數(shù)據(jù)庫(kù)方面,亞馬遜云科技則是推出了Amazon Neptune Analytics,可以讓開發(fā)人員在幾秒鐘內(nèi)檢查海量的圖形數(shù)據(jù),也支持更快的向量搜索。

在數(shù)據(jù)的“集成”特性方面,亞馬遜云科技依舊堅(jiān)持的是“zero-ETL”之道——Amazon S3加持下的OpenSearch Service zero-ETL integration,僅使用一個(gè)工具,便可以分析S3中的所有操作數(shù)據(jù)。

最后,在“治理”方面,亞馬遜云科技上新的功能便是Clean Rooms ML。

它可以允許用戶在不共享底層數(shù)據(jù)的情況下與客戶應(yīng)用機(jī)器學(xué)習(xí)模型。

One More Thing

在推動(dòng)大模型發(fā)展的這件事上,亞馬遜云科技可以說(shuō)是有著自己獨(dú)到的“玩法”——

不僅發(fā)展自家的大模型,更是給其它大模型提供AI基礎(chǔ)設(shè)施和AI工具,讓它們也能更好地發(fā)展。

那么二者之間是否會(huì)存在沖突和競(jìng)爭(zhēng)呢?

在量子位與亞馬遜云科技數(shù)據(jù)庫(kù)和遷移服務(wù)副總裁Jeff Carter的交流過(guò)程中,他發(fā)表了如下看法:

我希望我們生活在一個(gè)合作的世界里,每個(gè)LLM都擅長(zhǎng)于不同的方面,我認(rèn)為這種情況會(huì)持續(xù)下去,這種專業(yè)化水平也會(huì)持續(xù)一段時(shí)間。

我喜歡Bedrock的一個(gè)原因是它可以無(wú)縫地從一個(gè)LLM轉(zhuǎn)換到另一個(gè)LLM。很明顯,亞馬遜將持續(xù)在LLM方面推進(jìn)最先進(jìn)的技術(shù)。

但對(duì)于每個(gè)LLM,或許下個(gè)月所呈現(xiàn)出來(lái)的能力會(huì)截然不同,這也就是為什么我們認(rèn)為給客戶提供選擇的能力和同時(shí)使用多個(gè)功能的能力是如此重要的原因之一。