NUMA架構(gòu):CPU和內(nèi)存性能瓶頸的終結(jié)者!

NUMA的出現(xiàn)

我們都知道,CPU是計算機的核心組件,它被設(shè)計用來完成計算機的核心任務(wù):計算,這里的計算既包括數(shù)學(xué)上的運算,還包括條件的判斷、IO設(shè)備的讀寫等多個方面。

在計算機發(fā)展初期,為了提升CPU的計算能力,工程師們的方法是不斷增加晶體管的數(shù)量和提升CPU的主頻,因為這可以讓CPU在單位時間內(nèi)完成更多次數(shù)的計算。

然而,當(dāng)技術(shù)發(fā)展到一定程度之后,CPU的散熱和功耗的問題開始變得突出,單純提升主頻開始變得越來越困難,然后工程師們又有了新的想法:既然一個人干活效率有限,那就讓更多的人一起干活吧!于是,多核CPU應(yīng)運而生。

多核CPU可以同時處理多個任務(wù),極大地提高了計算機的運算速度。然而,隨著核心數(shù)量的增加,新的問題也隨之出現(xiàn)。在多核CPU系統(tǒng)中,所有的核心共享同一塊內(nèi)存,當(dāng)多個核心同時訪問內(nèi)存時,就會產(chǎn)生爭用,這種爭用會導(dǎo)致內(nèi)存訪問的延遲增加,從而影響系統(tǒng)的整體性能。

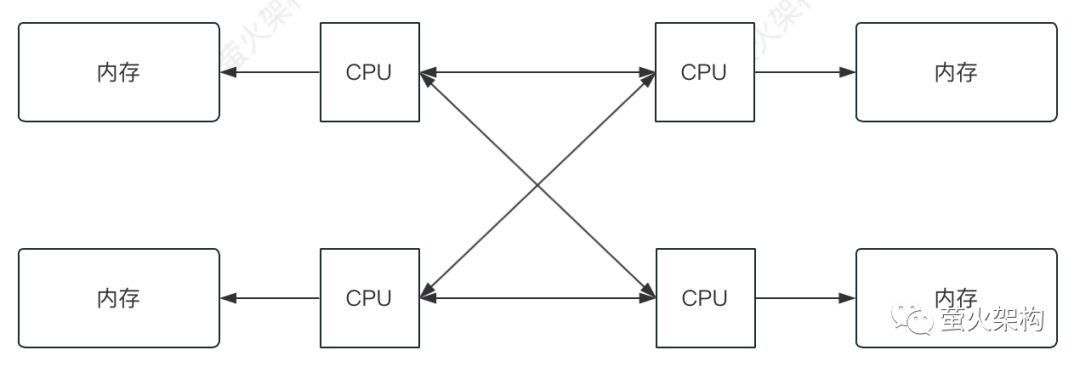

為了解決這個問題,工程師們又提出了非統(tǒng)一內(nèi)存訪問(NUMA)架構(gòu)。在NUMA架構(gòu)中,每個節(jié)點都有自己的內(nèi)存,節(jié)點之間通過CPU互連網(wǎng)絡(luò)進行通信。這樣,每個節(jié)點中的處理器訪問自己的內(nèi)存時,就不會與其他節(jié)點產(chǎn)生爭用,從而減少了內(nèi)存訪問的延遲,提高了系統(tǒng)的整體性能。

圖片

圖片

NUMA的問題

雖然非統(tǒng)一內(nèi)存訪問(NUMA)架構(gòu)可以提高多處理器系統(tǒng)的性能,但它也帶來了一些新的問題,主要包括以下幾點:

內(nèi)存訪問不均衡

在NUMA系統(tǒng)中,處理器訪問遠程內(nèi)存時需要經(jīng)過核心之間的通道進行,因此本地內(nèi)存的速度要比訪問遠程內(nèi)存快,大約比訪問其它節(jié)點快2倍以上。這就意味著,如果一個程序的數(shù)據(jù)大部分位于遠程節(jié)點,那么它的性能可能會受到影響。例如,假設(shè)有一個程序,它在處理器A上運行,但它需要訪問的數(shù)據(jù)大部分在處理器B的本地內(nèi)存中,那么它需要花費更多的時間來獲取這些數(shù)據(jù),這就降低了程序的運行效率。

還有,如果程序的數(shù)據(jù)不是均勻的分布在各個內(nèi)存節(jié)點,CPU訪問數(shù)據(jù)時就可能時快時慢,這會給程序的穩(wěn)定運行帶來一些挑戰(zhàn),對于一些性能敏感的應(yīng)用影響會比較大。

數(shù)據(jù)管理復(fù)雜

在NUMA系統(tǒng)中,每個處理器都有自己的內(nèi)存,這就需要操作系統(tǒng)和應(yīng)用程序更加智能地管理數(shù)據(jù)的分布和遷移,以確保內(nèi)存訪問的均衡性。例如,操作系統(tǒng)需要能夠監(jiān)控程序的內(nèi)存訪問模式,并根據(jù)需要將數(shù)據(jù)從一個節(jié)點遷移到另一個節(jié)點,這增加了操作系統(tǒng)的復(fù)雜性。

另外,現(xiàn)代CPU的物理核心都會自帶一個高速緩存,它會緩存程序頻繁使用和即將使用的數(shù)據(jù),如果程序頻繁的在各個物理核心之間切換執(zhí)行,就會導(dǎo)致緩存的失效,影響程序的性能。解決這個問題需要復(fù)雜的緩存同步機制。

硬件和軟件兼容性問題

NUMA架構(gòu)需要特定的硬件支持,并且需要操作系統(tǒng)和應(yīng)用程序具有相應(yīng)的調(diào)度和優(yōu)化策略,以充分利用NUMA的優(yōu)勢。例如,一些操作系統(tǒng)可能無法正確識別和優(yōu)化NUMA硬件,或者一些應(yīng)用程序可能沒有正確地使用NUMA API,這都可能影響到系統(tǒng)的性能。

解決方案

解決NUMA架構(gòu)中遇到的問題并不是那么容易,這涉及到硬件設(shè)計、操作系統(tǒng)優(yōu)化和應(yīng)用程序調(diào)度等多方面的技術(shù)和策略,下面是一些常見的解決方案:

內(nèi)存親和性

內(nèi)存親和性(memory affinity)是一種讓程序盡可能訪問本地內(nèi)存的技術(shù)。這主要有賴于操作系統(tǒng),它可以通過調(diào)度策略,讓線程或進程在訪問數(shù)據(jù)時,優(yōu)先訪問它們所在的CPU節(jié)點的內(nèi)存。這樣可以減少訪問遠程內(nèi)存的次數(shù),提高程序的運行效率。

這還有賴于操作系統(tǒng)的智能內(nèi)存管理機制。例如,Linux操作系統(tǒng)中的自動NUMA平衡功能,可以自動監(jiān)控程序的內(nèi)存訪問模式,并在需要時將數(shù)據(jù)遷移到更接近的節(jié)點,以減少訪問遠程內(nèi)存的開銷。

高速互連技術(shù)

有時候跨節(jié)點訪問內(nèi)存不可避免,為了盡量提高和穩(wěn)定訪問速度,CPU廠商們在小小的硅片上搞出了很多小花樣。

在多核CPU中,一些核心可能會共享一級或二級緩存。操作系統(tǒng)可以將需要頻繁通信的線程調(diào)度到共享緩存的核心上,可以提高數(shù)據(jù)訪問的效率。

在大型的NUMA系統(tǒng)中,可能會有很多個處理器和內(nèi)存節(jié)點。為了更好地管理這些資源,設(shè)計者們將相鄰的或者性能相似的節(jié)點組織在一起,形成一個子NUMA群組。每個群組內(nèi)部的節(jié)點可以高速互連,而群組之間的連接可能會相對較慢。在應(yīng)用程序設(shè)計和系統(tǒng)調(diào)度方面,我們可以將這些群組作為調(diào)度和內(nèi)存分配的單位,以便更好地控制內(nèi)存訪問的性能。

為了提高處理器內(nèi)部或處理器之間的訪問速度,CPU廠商們搞出了一些高速互聯(lián)技術(shù),比如AMD的Infinity Fabric和Intel的Ultra Path Interconnect(UPI),它們可以提供更高的帶寬和更低的延遲,提高了數(shù)據(jù)在節(jié)點之間的傳輸效率。

軟硬件兼容

為了充分利用NUMA的優(yōu)勢,硬件、操作系統(tǒng)和應(yīng)用程序需要進行相應(yīng)的優(yōu)化。硬件制造商需要提供支持NUMA的硬件,并提供相應(yīng)的驅(qū)動程序。

操作系統(tǒng)依賴這些驅(qū)動程序,然后能夠識別和管理NUMA硬件,并提供相應(yīng)的API供應(yīng)用程序使用。比如Linux提供了numactl工具和libnuma庫,可以用來設(shè)置內(nèi)存親和性。

應(yīng)用程序開發(fā)者則需要了解NUMA架構(gòu),并使用正確的API和算法,以確保程序在NUMA系統(tǒng)上的性能。

比如在多線程環(huán)境中,如果兩個或更多的線程在同一個緩存行中的不同位置讀寫數(shù)據(jù),一個線程寫數(shù)據(jù)就可能導(dǎo)致另一個線程需要讀取的數(shù)據(jù)在緩存中失效,從而導(dǎo)致很慢的內(nèi)存讀取。這就需要在編程時注意:盡量讓同一緩存行中的數(shù)據(jù)被同一個線程訪問,或者是通過內(nèi)存對齊和填充,使得同一緩存行中的數(shù)據(jù)不會被多個線程同時訪問。

一些高性能的程序都會考慮這方面的問題,比如Java中的Disruptor異步處理庫,Disruptor在每個事件處理器的序列號周圍填充了一些無用的數(shù)據(jù),使得每個事件處理器的序列號都獨占一個緩存行。這樣,即使多個事件處理器在并發(fā)地更新自己的序列號,也不會影響到其他事件處理器的緩存行。

總的來說,解決NUMA架構(gòu)中的問題需要硬件、操作系統(tǒng)和應(yīng)用程序的配合。通過正確的設(shè)計和優(yōu)化,可以充分利用NUMA的優(yōu)勢,提高多處理器系統(tǒng)的性能。

應(yīng)用案例

再舉兩個例子。

數(shù)據(jù)庫應(yīng)用

在數(shù)據(jù)庫應(yīng)用中,我們可以利用NUMA的特點進行優(yōu)化。例如,我們可以將數(shù)據(jù)庫的表分區(qū),并將不同的分區(qū)分配到不同的NUMA節(jié)點。這樣,當(dāng)多個查詢同時運行時,它們可以在不同的節(jié)點上并行執(zhí)行,互不干擾,從而提高了查詢的性能。

高性能計算

在高性能計算應(yīng)用中,我們可以將并行的任務(wù)分配到不同的NUMA節(jié)點上。這樣,每個任務(wù)可以在本地內(nèi)存中訪問數(shù)據(jù),避免了訪問遠程內(nèi)存的開銷,從而提高了計算的效率。

通過這些例子可以看到一個基本原則:在NUMA架構(gòu)中,我們應(yīng)該盡可能讓任務(wù)在本地內(nèi)存中訪問數(shù)據(jù),以避免訪問遠程內(nèi)存的開銷。通過合理的任務(wù)調(diào)度和數(shù)據(jù)分布策略,我們可以充分利用NUMA的優(yōu)勢,提高程序的性能。