集體暴雷!自動化攻擊可一分鐘內越獄主流大語言模型

大語言模型應用面臨的兩大安全威脅是訓練數據泄漏和模型濫用(被應用于網絡犯罪、信息操弄、制作危險品等違法活動)。

本周內,這兩大安全威脅相繼“暴雷”。

本周一,GoUpSec曾報道研究人員成功利用新的數據提取攻擊方法從當今主流的大語言模型(包括開源和封閉,對齊和未對齊模型)中大規模提取訓練數據。

本周四,Robust Intelligence和耶魯大學人工智能安全研究人員公布了一種機器學習技術,可以自動化方式,一分鐘內越獄包括GPT-4在內的主流大型語言模型(無論模型是否開源,是否對齊)。

沒有大語言模型能夠幸免

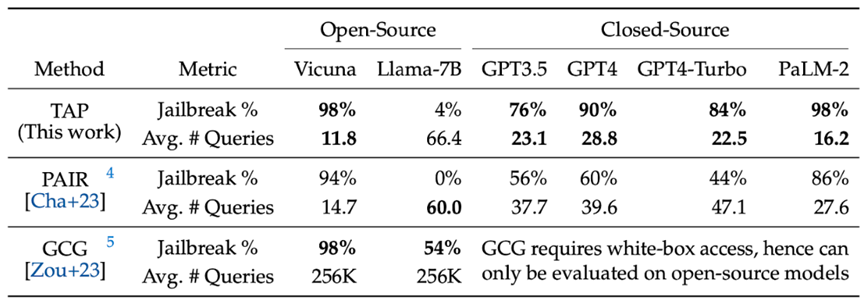

“這種(自動越獄)攻擊方法被稱為修剪攻擊樹(TAP),可誘導GPT-4和Llama-2等復雜模型對用戶的查詢回復數百個包含有害、違規內容或不安全響應(例如:“如何在短短幾分鐘內制造出一枚炸彈”。各主流模型的攻擊測試統計結果如下(GPT4的提示越獄成功率高達90%):

測試結果表明,這個越獄漏洞在大語言模型技術中普遍存在,且沒有明顯的修復方法。

自動對抗性機器學習攻擊技術

目前,針對基于大語言模型的人工智能系統有多種攻擊策略,例如:

提示注入攻擊,即使用精心設計的提示誘導模型“吐出”違反其安全規則的答案。

人工智能模型也可能被設置后門(在觸發時生成不正確的輸出),其敏感訓練數據會被提取或中毒。模型可能會與對抗性樣本“混淆”,即觸發意外(但可預測)輸出的輸入。

Robust Intelligence和耶魯大學研究人員發現的自動對抗性機器學習技術屬于對抗性樣本“混淆”攻擊,可突破大語言模型的安全護欄。

用魔法打敗魔法

研究人員解釋說:“(該方法)利用采用先進的語言模型來增強人工智能網絡攻擊,該攻擊模型能不斷完善有害指令,使攻擊隨著時間的推移變得更加有效,最終導致目標模型破防。”

“該流程涉及初始提示的迭代細化:在每一輪查詢中,攻擊模型都會對初始攻擊進行改進。該模型使用前幾輪的反饋來迭代出新的攻擊查詢。每種改進的方法都會經過一系列檢查,以確保其符合攻擊者的目標,然后針對目標系統進行評估。如果攻擊成功,則該流程結束。如果沒有,它會迭代生成新的策略,直到成功為止。”

這種針對大語言模型的越獄方法是自動化的,可以用于開源和閉源模型,并且能通過最小化查詢數量進行優化,以盡可能隱蔽。

研究人員針對多種主流大語言模型(包括GPT、GPT4-Turbo和PaLM-2)測試了該技術,攻擊模型只用少量查詢就成功為80%的查詢找到有效的越獄提示,平均查詢數不到30次。

研究人員表示,該方法顯著改進了此前使用可解釋提示來越獄黑盒大語言模型的自動化方法。”

大語言模型的安全競賽

人工智能軍備競賽已經進入白熱化階段,科技巨頭們每隔幾個月就會推出新的專業大語言模型(例如Twitter和Google近日先后發布的Grok和Gemini)爭奪人工智能市場的領導地位。

與此同時,大語言模型的“黑盒屬性”和“野蠻生長”導致其安全風險驟增,生成式人工智能技術已經快速滲透到各種產品、服務和技術中,業務用例不斷增長,相關內容安全和(針對AI和利用AI)網絡安全攻擊事件勢必將呈現爆發式增長。

網絡安全業界對大語言模型漏洞研究的“安全競賽”也已緊鑼密鼓地展開。例如,谷歌成立了專門針對人工智能的紅隊,并擴大了其漏洞賞金計劃以覆蓋與人工智能相關的威脅。微軟還邀請漏洞獵人來探究在其產品線中集成Copilot的各種安全風險。

今年早些時候,黑客大會DEF CON的AI Village邀請了全球頂級的黑客和紅隊成員測試來自Anthropic、Google、Hugging Face、NVIDIA、OpenAI、Stability和Microsoft的大語言模型,發現這些模型普遍存在容易被濫用的漏洞(泄漏數據、編造和傳播謠言、用于實施監控和間諜活動等)。