當GPT-4V充當機器人大腦,可能你都沒AI會規劃

GPT-4V 已經能幫我們設計網站代碼,控制瀏覽器,這些應用集中在虛擬數字世界中。假如我們把 GPT-4V 帶入現實世界,讓它作為控制機器人的大腦,會有什么有趣的結果呢?

最近,來自清華大學交叉信息研究院的研究者提出「ViLa」算法,實現了讓 GPT-4V 走進物理世界中,為機器人操作日常生活物品提供任務規劃。

ViLa 全稱是 Robotic Vision-Language Planning,它利用 GPT-4V 在視覺和語言兩個模態上做聯合推理的能力,把抽象的語言指令分解為一系列可執行的步驟。ViLa 最讓人驚喜的是它展現出對物理世界中常識的理解,而這是很多之前基于大語言模型(LLM)的機器人任務規劃算法所欠缺的。

比如在下面這個視頻中,研究人員讓機器人拿出擱板上的漫威模型(鋼鐵俠)。ViLa 能理解這個場景中物體的復雜空間位置關系,即紙杯和可樂罐擋住了鋼鐵俠,要拿出鋼鐵俠,則必須先拿走紙杯和可樂罐。

又比如在下面這個視頻中,研究人員讓機器人為上美術課的孩子們整理出一個桌面區域。ViLa 能根據這個場景中的剪紙,推斷出現在上課所需的工具是剪刀,把其它危險物品,比如螺絲刀和水果刀放入收納盒中。

可以看出,ViLa 具有像人類一樣的常識,能在非常復雜的環境中控制機器人,為機器人提供任務規劃。

- 論文地址:https://arxiv.org/pdf/2311.17842.pdf

- 論文主頁:https://robot-vila.github.io/

- 論文視頻:https://www.youtube.com/watch?v=t8pPZ46xtuc

接下來,該研究詳細介紹了 ViLa 這項研究成果。

方法介紹

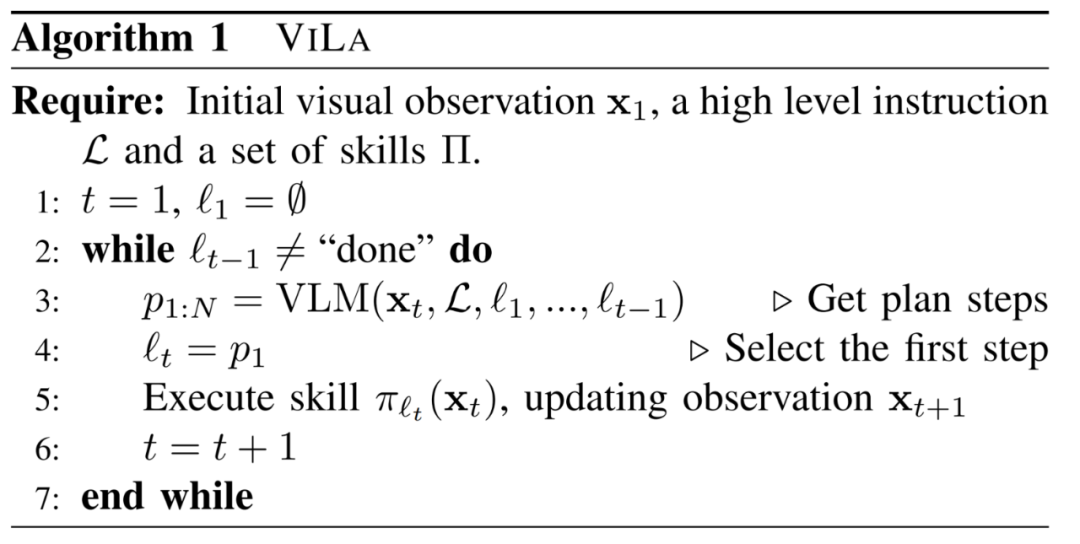

ViLa 使用了視覺語言大模型 (VLM) 來做機器人的任務規劃。如今的 VLM 在圖像和語言兩個模態上都展現出前所未有的理解和推理能力。將 VLM 應用到機器人任務中,它能基于當前環境的視覺觀測,結合自己豐富的世界知識進行推理。作者團隊提出了 ViLa 算法,主張直接使用視覺語言大模型(如 GPT-4V),將高級抽象指令分解為一系列低級可執行技能。

給定一條語言指令和當前的視覺觀測圖像,ViLa 利用 GPT-4V 通過鏈式思維推理來理解環境場景,隨后生成多步的計劃。接著,這個計劃的第一步由一個基本策略來執行。最后,已經執行的步驟被添加到已完成的計劃中,使得在動態環境中實現閉環規劃方法。

GPT-4V 由于經過大規模互聯網數據的訓練,展現出了卓越的多樣性和極強的泛化能力。這些特性使得它特別擅長處理論文中提出的開放世界場景。此外,作者團隊發現,即使是在零樣本(Zero-Shot)學習模式下運行,由 GPT-4V 驅動的 ViLa 也能夠解決多種具有挑戰性的規劃問題。這顯著減少了之前方法中所需的提示工程。

實驗

ViLa 在現實世界和模擬環境中都展示了以零樣本方式解決各種日常操作任務的能力,有效處理各種開放集指令和物體對象。作者團隊通過大量實驗證明了 ViLa 的優勢:1. ViLa 能深刻理解視覺世界中的常識,2. ViLa 支持靈活的多模態目標指定方法,3. ViLa 自然地支持視覺反饋和閉環控制。

A. ViLa 能深刻理解視覺世界中的常識

語言和圖像作為不同的信號類型,各具獨特性質:語言由人類生成,富含語義,但在表達全面信息方面有限;相比之下,圖像作為自然信號,包含細致的低層次特征,一張圖像便能夠捕捉場景的全部信息。在難以用語言簡單概括的復雜場景下,這種差異尤為突出。通過將視覺圖片直接結合到推理過程中,ViLa 可以理解視覺世界的常識知識,擅長處理需要全面了解空間布局或物體屬性的復雜任務。

空間布局

用簡單的語言描述復雜的空間布局,尤其是物體定位、位置關系和環境限制,是非常困難的。通過直接將視覺融入推理過程,ViLa 可以精確地識別物體在場景中的位置,以及它們之間的關系。

在 “拿可樂罐” 任務中,ViLa 發現可樂罐不在視線中,于是聰明地打開了冰箱并找到了它。而基線方法則會在可樂罐不在視線中的情況下給出” 拿起可樂罐 “的錯誤指令。

在 “拿空盤子” 任務中,ViLa 知道在拿起藍色盤子之前,需要先把它上面的蘋果和香蕉移走。而基線方法則忽視了盤子上的物體,直接給出” 拿起藍色盤子 “的錯誤指令。

物體屬性

物體的定義涵蓋多個屬性,包括形狀、顏色、材質、功能等。然而,自然語言的表達能力有限,因此在全面傳達這些屬性方面顯得笨拙。此外,物體的屬性與特定任務密切相關。以上原因使得過去的算法難以處理需要深入理解復雜物體屬性的場景。然而,得益于對視覺和語言的聯合推理,ViLa 對于物體在特定場景中的屬性有深入的理解。

在 “準備美術課” 任務中,ViLa 認為螺絲刀和水果刀是危險物品,于是移走了它們;考慮到桌上的剪紙,ViLa 認為剪刀對美術課是必要的物品,于是留下了它。而基線方法則忽視了桌上的剪紙和美術課這一特定場景,認為剪刀也是危險物品,選擇將其移走。

在 “挑選新鮮水果” 任務中,ViLa 可以精確地挑選出新鮮且完整的水果。而基線方法認為剝了一半的橘子和腐爛的香蕉都是完整且新鮮的水果。

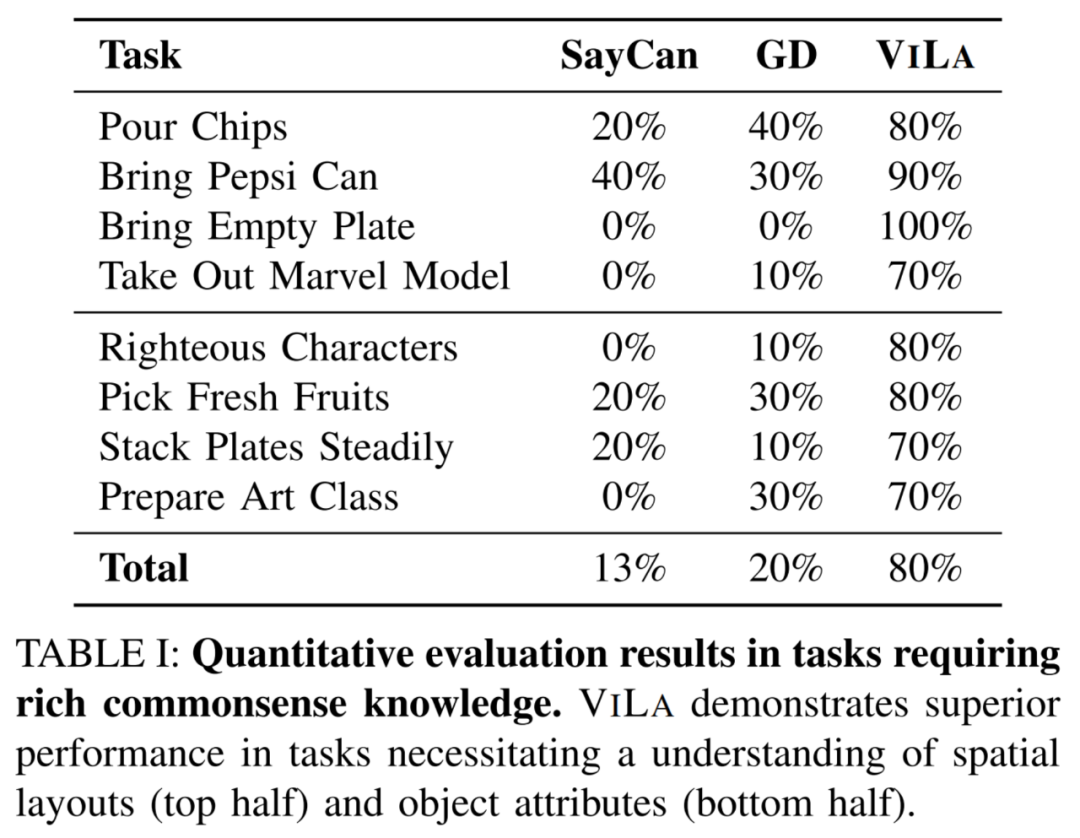

作者團隊在 8 個相關任務上進行了充分的定量實驗。如表一所示,ViLa 在理解空間布局和物體屬性任務上顯著超過了基線方法。

B. 多模態目標指定

ViLa 支持靈活的多模態目標指定方法。ViLa 不僅能夠利用語言指令,還能夠利用多種形式的圖像作為目標,甚至利用語言和圖像的混合形式來定義目標。

視頻中的四個任務分別表明:

- ViLa 可以將真實圖片作為目標。

- ViLa 可以將抽象圖片(如小孩的畫,草稿等)作為目標。

- ViLa 可以將語言和圖像的混合形式作為目標。

- ViLa 可以發現圖片中手指指著的位置,并將其作為實際任務中的目標位置。

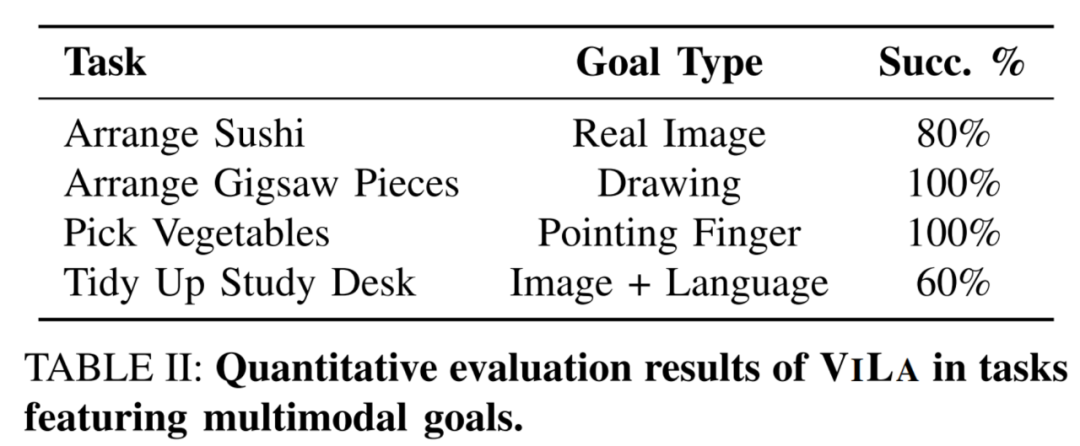

作者團隊在這四個任務上進行了定量實驗。如表二所示,ViLa 在所有任務中均表現出了強大的識別多模態目標的能力。

C. 視覺反饋

ViLa 以直觀、自然的方式有效利用視覺反饋,在動態環境中實現魯棒的閉環規劃。

- 在 “堆木塊” 任務中,ViLa 檢測出了執行基本技能時的失敗,于是重新執行了一遍基本技能。

- 在 “放薯片” 任務中,ViLa 意識到了執行過程中人的干擾。

- 在 “找貓糧” 任務中,ViLa 可以不斷地打開抽屜 / 柜子來尋找貓糧,直到找到。

- 此外,ViLa 可以完成需要人機交互的任務,等待人握住可樂罐之后才松開夾爪。

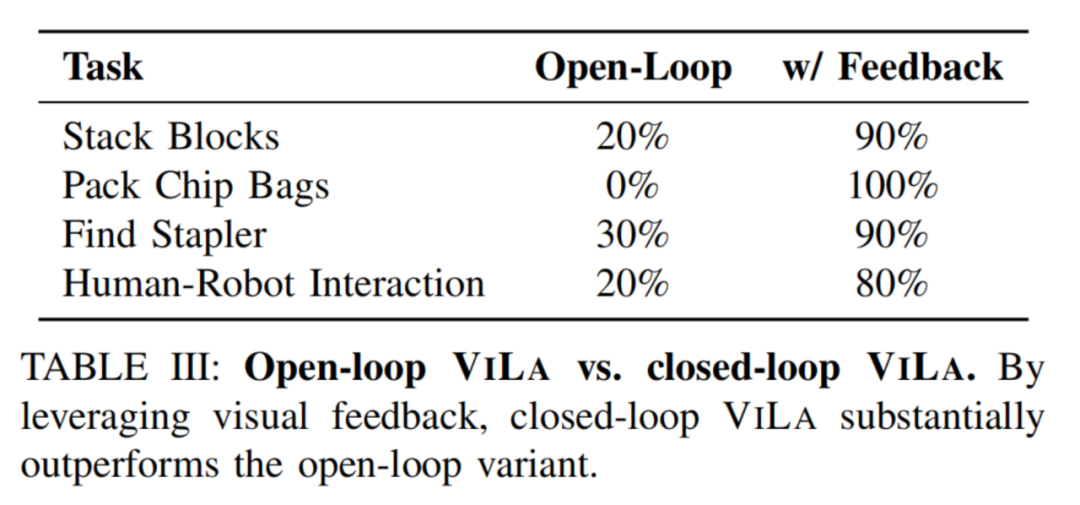

作者團隊在這四個任務上進行了定量實驗。如表三中所示,通過自然地結合視覺反饋,閉環控制的 ViLa 的表現顯著強于開環控制。

D. 模擬環境實驗

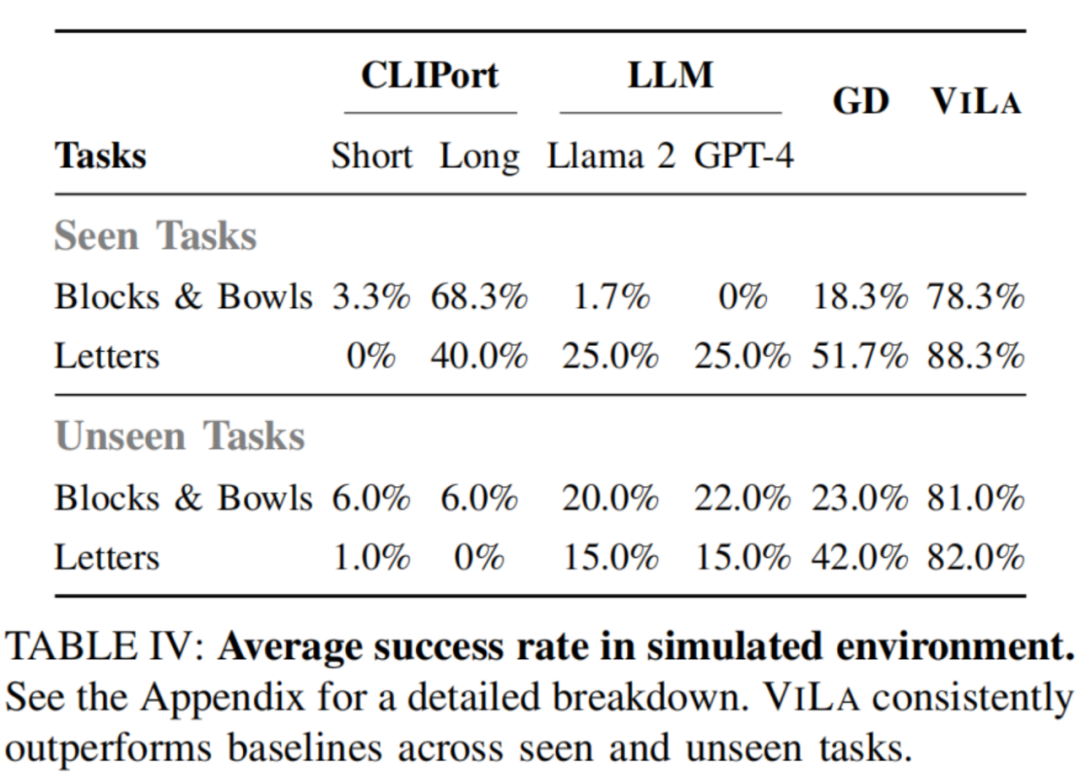

在模擬環境中,ViLa 可以按照高級語言指令的指示,將桌子上的物體重新組織成特定的排列。

如表四中所示,ViLa 在模擬環境中的表現也顯著超過了基線方法。

了解更多內容,請參考原論文。