隨意指定CLIP關注區域!上交復旦等發布Alpha-CLIP:同時保持全圖+局部檢測能力

CLIP是目前最流行的視覺基座模型,其應用場景包括但不限于:

- 與LLM大語言模型結合成為視覺多模態大模型;

- 作為圖像生成(Stable Diffusion)、點云生成(Point-E)的condition model,實現image-to-3D;

- 用于指導NeRF的優化方向從而實現text-to-3D;

- 本身用于開放類別的識別和檢測。

但CLIP必須以整張圖片作為輸入并進行特征提取,無法關注到指定的任意區域,不過自然的2D圖片中往往包含不同的物體,part和thing,如果能由用戶或檢測模型指定需要關注的區域,在圖像編碼的過程就確定需要關注的對象,將會提升CLIP模型的可控制性和區域檢測能力。為此,上海交通大學、復旦大學、香港中文大學、澳門大學等機構的學者們提出了Alpha-CLIP模型,在原始CLIP模型的RGB三個通道的基礎上額外引入了第四個alpha通道來決定需要關注的區域。

圖片

圖片

論文鏈接:https://arxiv.org/abs/2312.03818項目主頁:https://aleafy.github.io/alpha-clip代碼鏈接:https://github.com/SunzeY/AlphaCLIP

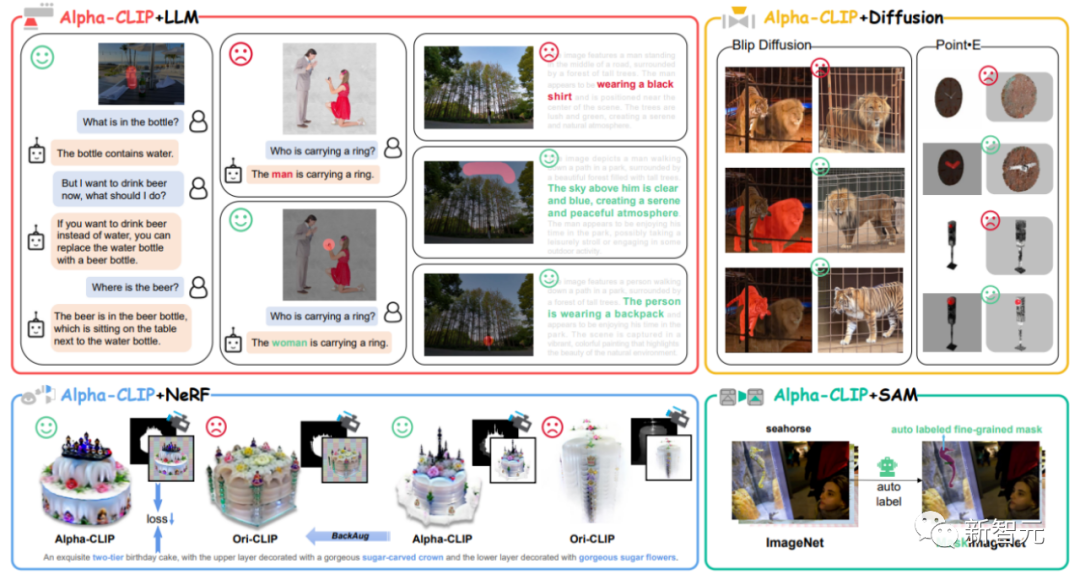

通過構造千萬量級的「RGBA四通道圖片-文本對」對Alpha-CLIP進行訓練,Alpha-CLIP不僅在ImageNet上保持了原始的全圖檢測能力,還能對用戶指定的任意區域進行highlight關注。下面分別介紹Alpha-CLIP的應用場景。

圖1 Alpha-CLIP使用場景總覽

圖1 Alpha-CLIP使用場景總覽

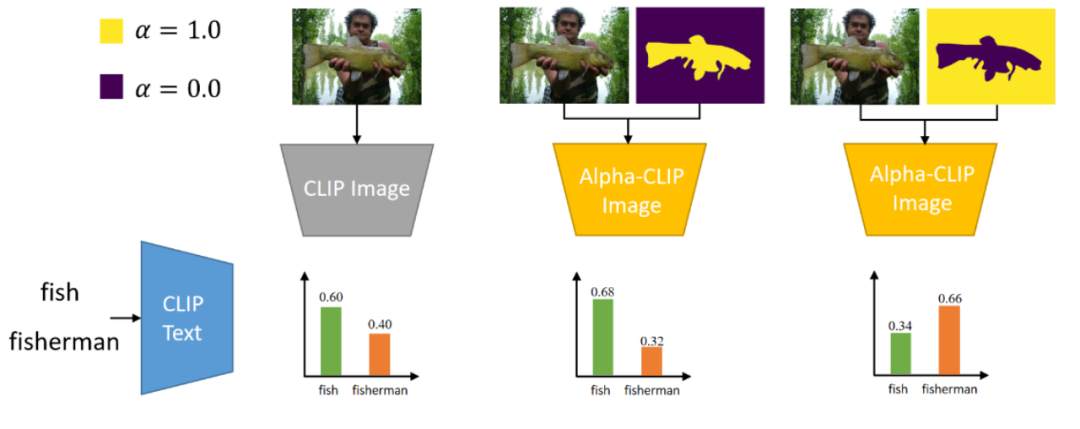

圖像分類

如圖所示,對于ImagNet的一張圖片,研究人員可以通過alpha-map控制CLIP去關注魚或漁夫。

圖片

圖片

圖片

圖片

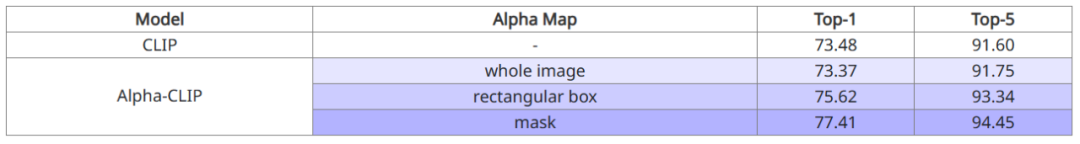

以ImageNet的Zero-Shot Classification作為評價指標,研究人員驗證了在對全圖進行識別時,Alpha-CLIP可以保持原本CLIP的分類準確率。

進一步地,在給出了需要關注區域的長方形box或者mask時,Alpha-CLIP可以進一步提升分類準確率。

與LLM大語言模型的結合

圖片

圖片

將主流的LLaVA-1.5中的CLIP基座模型替換為Alpha-CLIP,用戶可以通過簡單地用畫筆標記處需要關注的區域,從而進行指定區域的對話交互。

圖片

圖片

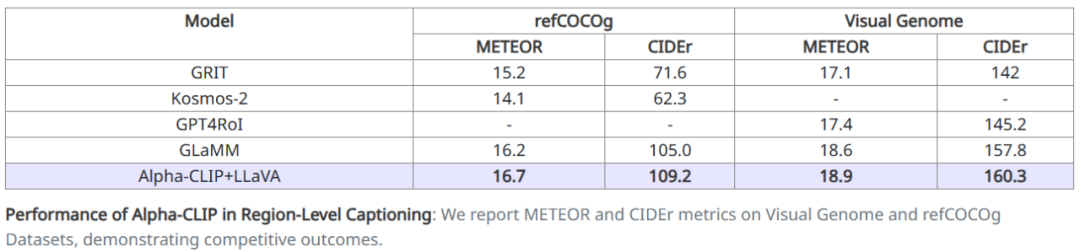

在定量實驗方面,研究人員通過LLaVA測試了MLLM的region caption能力。通過在RefCOCO和VG上分別進行finetune,取得了SOTA的region caption分數。

圖片

圖片

與Stable Diffusion的結合

圖片

圖片

Stable-Diffusion是目前主流的2D圖片生成模型,其Image Variation版本可以實現「圖生圖」,其中圖片的編碼器也是CLIP模型。通過將該模型替換為Alpha-CLIP,可以實現更復雜圖片中指定物體的生成(同時較好地保留背景)。

如上圖所示,使用原始的CLIP會生成同時具有獅子和老虎特征的「獅虎獸」,而Alpha-CLIP能夠很好地區分兩個物體,從而指導Stable Diffusion模型生成更專一的圖片。

圖片

圖片

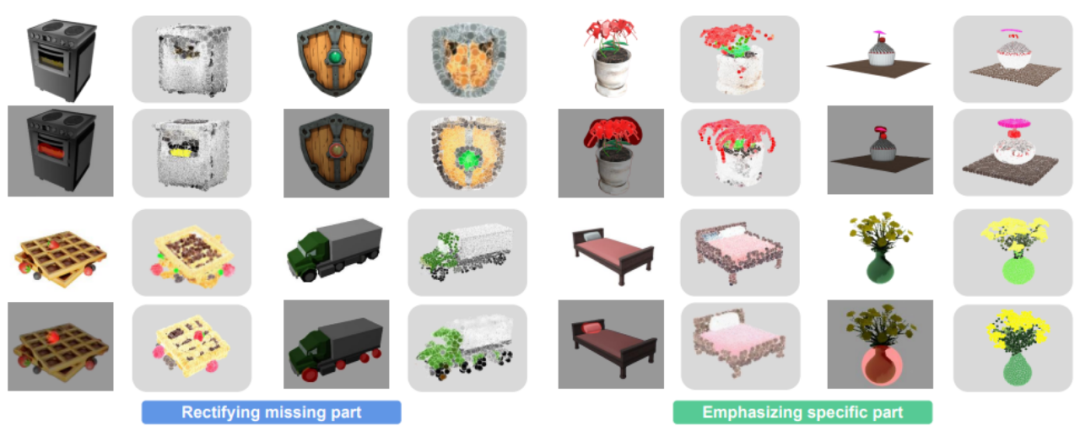

與Point-E的結合

圖片

圖片

Point-E是Open-AI開源的一個支持Image-to-3D和text-to-3D的點云diffusion模型,通過將它的Image編碼器從原始的CLIP替換為Alpha-CLIP。

可以支持用戶對任意區域進行關注,從而恢復丟失的「表針」和「盾牌的十字架」。

圖片

圖片

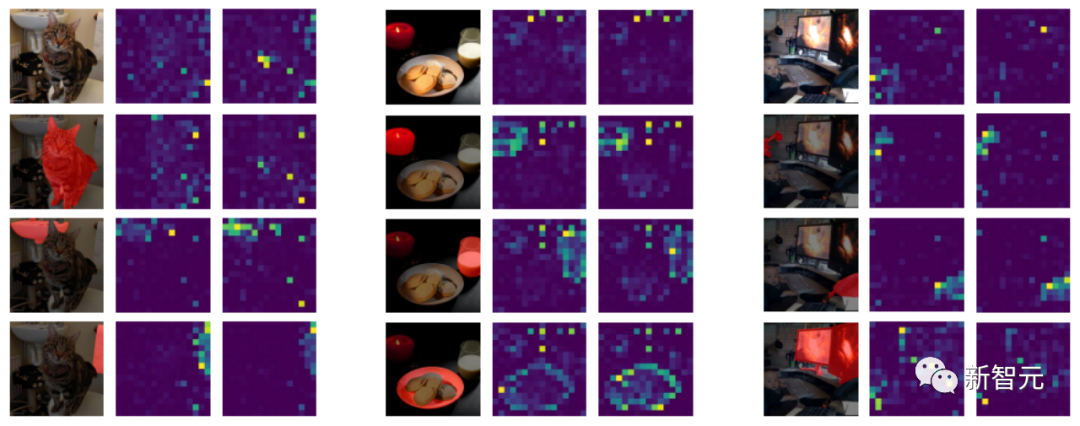

Attention Map可視化

本工作對Alpha-CLIP的注意力進行可視化,以檢查Alpha-CLIP是否更加關注用戶定義alpha-map。通過檢查視覺編碼器中最后一個Transformer塊中[CLS] token的注意力圖。可視化采用了具有16個注意頭的ViT-L/14模型。

圖片

圖片

為了進行公正比較,使用第5和第16個注意頭的注意力圖進行可視化,因為我們發現在這16個頭中,這兩個特征圖最為明顯。結果如下圖所示。這種可視化驗證了Alpha-CLIP更加關注要聚焦的區域,更重要的是,它在保留原始CLIP特征位置的二維位置信息時沒有造成損害。

結論

本文介紹的這項工作提出了Alpha-CLIP模型,該模型引入了一個額外的alpha通道,用于指定感興趣的區域。

通過對數百萬個RGBA區域-文本對進行訓練,Alpha-CLIP不僅表現出卓越的區域關注能力,而且確保其輸出空間與原始的CLIP模型保持一致。這種一致性使得Alpha-CLIP在CLIP的各種下游應用中能夠輕松替代,無縫銜接。研究人員證明了當提供特定關注的區域時,Alpha-CLIP展現出了更強大的Zero-Shot識別能力,并驗證了它在許多下游任務中的有用性。CLIP的應用遠遠超出了本文的范圍。研究人員希望在前景區域或mask較容易獲得時,Alpha-CLIP將能夠在更多場景中得到應用。

雖然Alpha-CLIP在需要關注區域的各種場景中表現出有效的性能,但目前的結構和訓練過程限制了其專注于多個對象或建模不同對象之間關系的能力。此外,當前的訓練方法限制了alpha通道在中間值之外的泛化(只能接受0,1兩個值),因此用戶無法指定注意力的幅度。另一個限制同時存在于Alpha-CLIP和原始CLIP中,即純Transformer結構的編碼器分辨率較低,這阻礙了Alpha-CLIP識別小物體并進行關注。研究人員計劃在未來的工作中解決這些限制并擴展CLIP的輸入分辨率,相信這些未來的方向是增強Alpha-CLIP能力并在各種下游任務中擴展其實用性的途徑。