使用LM Studio在本地運行LLM完整教程

GPT-4被普遍認為是最好的生成式AI聊天機器人,但開源模型一直在變得越來越好,并且通過微調在某些特定領域是可以超過GPT4的。在開源類別中,出于以下的原因,你可能會考慮過在本地計算機上本地運行LLM :

- 脫機:不需要互聯網連接。

- 模型訪問:在本地運行模型,可以嘗試開源模型(Llama 2、Vicuna、Mistral、OpenOrca等等)。

- 隱私:當在本地運行模型時,沒有信息被傳輸到云。盡管在使用GPT-4、Bard和claude 2等基于云的模型時,隱私問題可能被夸大了,但在本地運行模型可以避免任何問題。

- 實驗:如果你看到了生成人工智能的價值,可以通過測試了解模型的細節并知道還有什么可用。

- 成本:開源模型是免費的,其中一些可以不受限制地用于商業。

對許多人來說,運行本地LLM需要一點計算機知識,因為它通常需要在命令提示符中運行它們,或者使用更復雜的web工具,如Oobabooga。

LM Studio是一個免費的桌面軟件工具,它使得安裝和使用開源LLM模型非常容易。

但是請記住,LM Studio并不開源,只是免費使用

但是LM Studio是我目前見到最好用,也是最簡單的本地測試工具,所以如果是本機測試使用的話還是推薦試一試他。

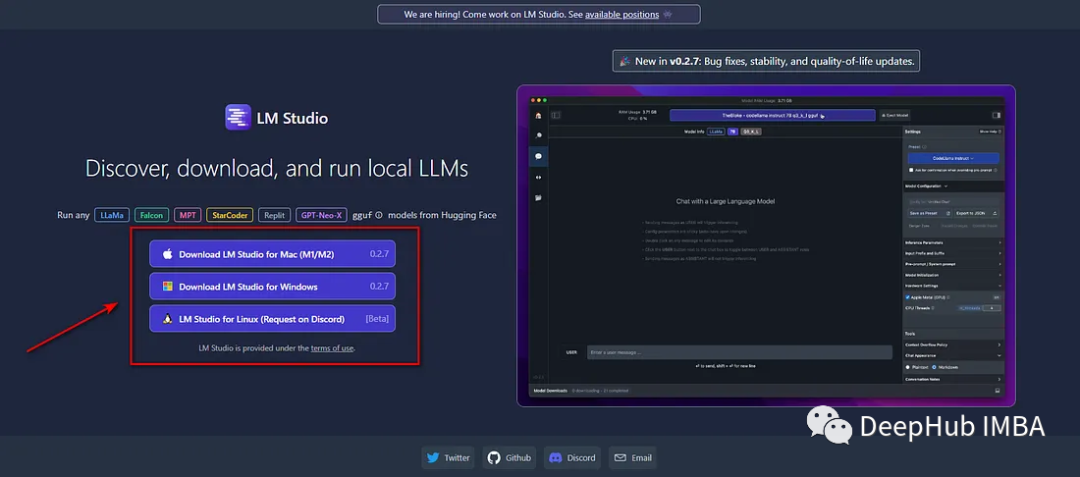

首先進入“lmstudio.ai”,下載并安裝適合操作系統的版本:

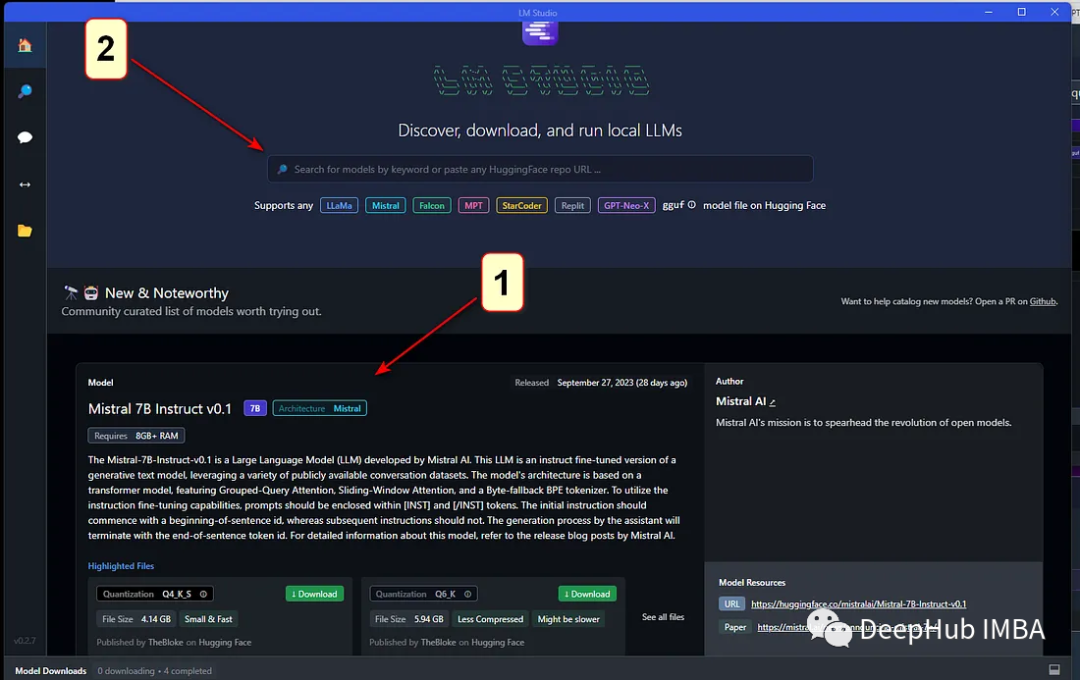

LM Studio,選擇要安裝的LLM。

可以通過選擇主窗口中列出的社區建議模型之一來實現進行,也可以使用HuggingFace上可用的任何模型的搜索欄查找關鍵字。

模型搜索列表中可以看到安裝/下載文件的大小。請確保下載的大小沒有問題。(國內需要魔法)

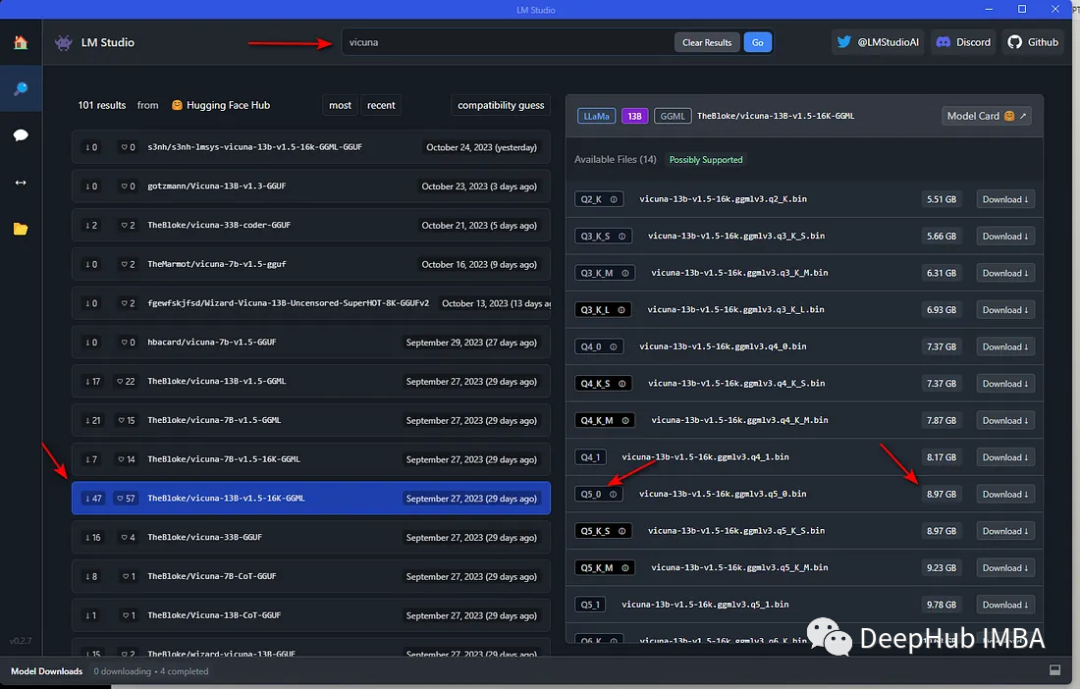

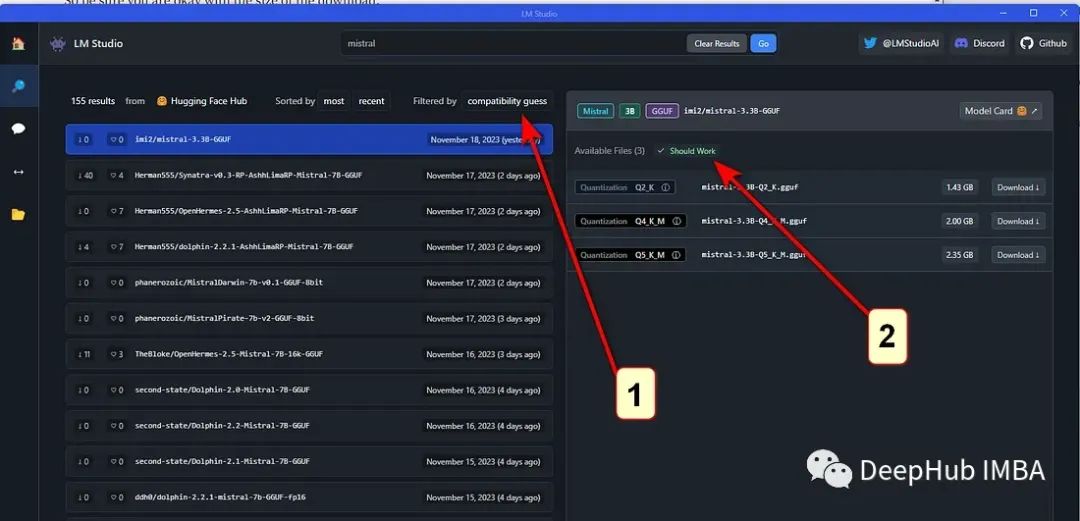

在屏幕左上角的發布日期欄,是“compatibility guess”。LM Studio已經檢查了本地系統,并展示它認為可以在計算機上運行的那些模型。要查看所有模型,點擊“compatibility guess”(#1)。點擊左邊的一個模型,右邊就會顯示可用的版本,并顯示那些根據你的電腦規格應該可以工作的模型(#2)。見下圖:

根據計算機的能力/速度,較大的模型將更準確,但速度較慢。并且這個鞋模型中的大多數都是量化的,包含了GGML和GGUF等格式。(具體這些格式可以參考我們以前的文章)

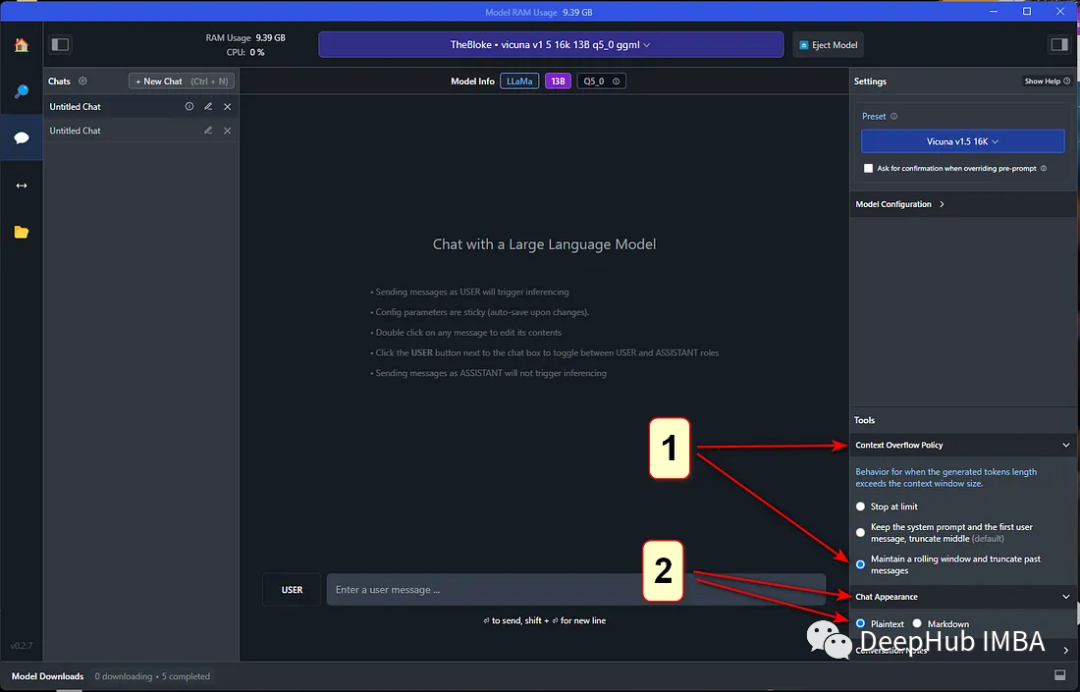

模型下載完成后,(1)在窗口頂部的下拉菜單中選擇模型;(2)選擇左側欄中的聊天氣泡;(3)打開右側的“Context Overflow Policy”和“Chat Appearance”。

確保在“Context Overflow Policy”下選擇“Maintain a rolling window and truncate past messages”,并在“Chat Appearance”下選擇“Plaintext”。

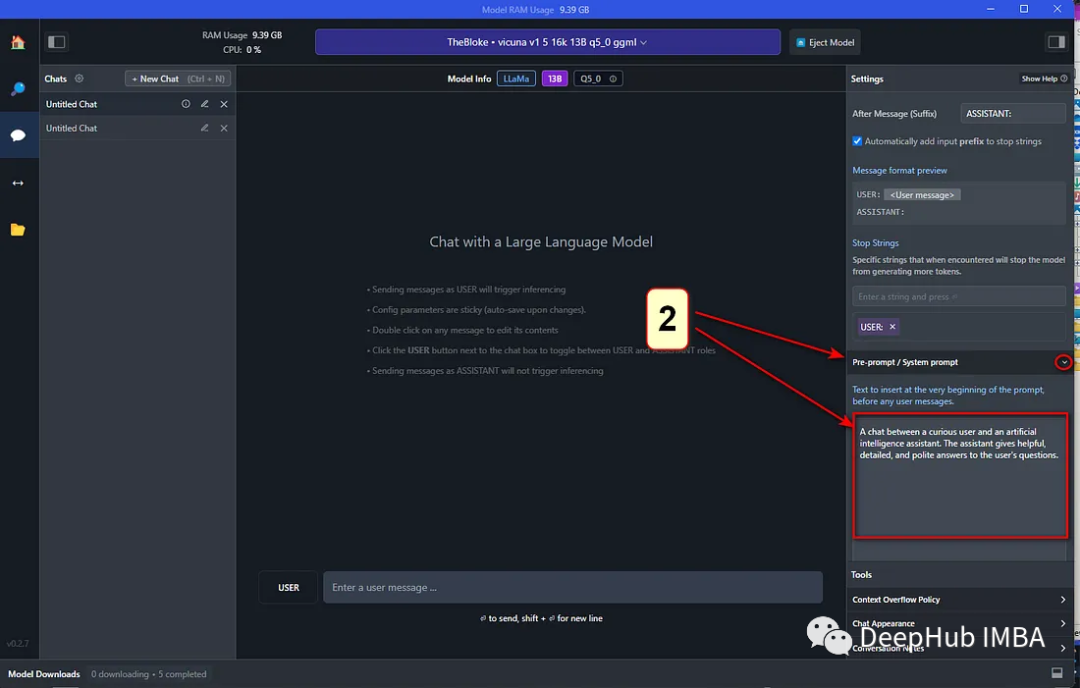

打開“Model Configuration”,然后打開“Prompt Format”,向下滾動到“Pre-prompt / System prompt”,選擇“>”符號打開。可以在這里輸入系統“role”。也就是說可以設定希望機器人如何行動,以及在它的回答中應該提供什么“技能”或其他特定的品質。這與ChatGPT Plus帳戶的“Custom instructions”相同。

繼續向下滾動,找到“Hardware Settings”。默認設置是計算機的CPU完成所有工作,但如果安裝了GPU,將在這里看到它。如果GPU顯存不夠,可以將GPU想要處理多少層(從10-20開始)這會將一部分層使用GPU處理,這與llama.cpp的參數是一樣的。還可以選擇增加LLM使用的CPU線程數。默認值是4。這個也是需要根據本地計算機進行設置。

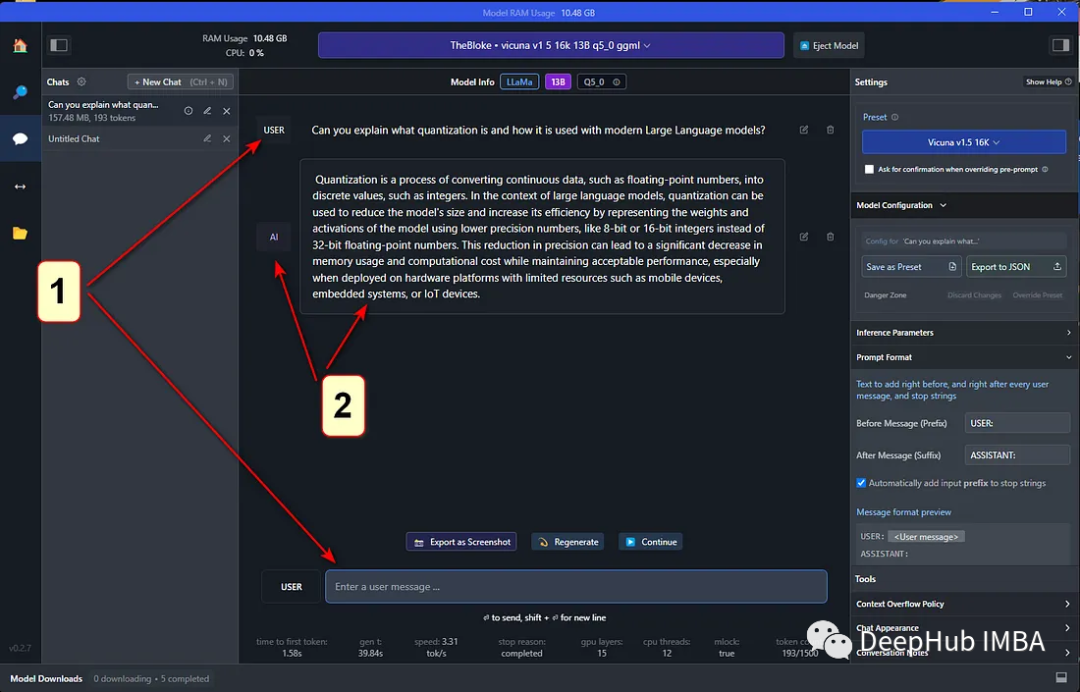

完成這些更改后,就可以使用本地LLM了。只需在“USER”字段中輸入查詢,LLM將響應為“AI”。

可以看到LM Studio提供了極好的體驗,為ChatGPT提供了一個很好的本地替代方案。LM Studio提供了一種使用OpenAI兼容接口來提供模型的方便方法,這簡化了與使用OpenAI作為后端的客戶端的集成。

如果你正在尋找一種快速簡便的方法來設置和使用具有不同開源模型的聊天或服務器供個人使用,LM Studio是一個很好的起點。