人工智能生成文本檢測在實踐中使用有效性探討

人工智能輔助撰寫文章的技術現在無處不在!ChatGPT已經解鎖了許多基于語言的人工智能應用程序,人工智能在任何類型的內容生成中的使用都已經達到了以前前所未有的高度。

在諸如創意寫作之類的工作中,人們被要求創造自己的內容。但是由于人工智能在這些任務中的普及和有效性,很人工智能很有可能會被濫用。所以能夠獲得可靠和值得信賴的工具來檢測人工智能生成的內容是一個非常重要的問題。所以本文將提供構建這樣一個工具的思路和技術規范。

文本檢測的思路

我們的目標是“像GPT這樣的大語言模型有多大可能生成全部或部分文本?”

所以我們就要從日常入手,比如:一個典型的日常場景,你母親對你說下面這句話的可能性有多大?

親愛的,請在晚上8點前上床睡覺;親愛的,請在晚上11點后上床睡覺。

我們會猜測前者比后者更有可能發生,因為你已經建立了對周圍世界的理解,并對哪些事件更有可能發生有了感覺。

這正是語言模型的工作原理。語言模型學習周圍世界的一些東西,他們學會預測給出一個不完整句子的下一個符號或單詞。

在上面的例子中,如果你被告知你的媽媽正在說某事,而到目前為止她說的是“親愛的,請上床睡覺”,那么這個句子最有可能的延續是“8:00 pm之前”,而不是“11:00 pm之后”。因為父母都會讓孩子早睡覺,對吧

語言模型的困惑度是什么?

困惑:困惑的狀態;混亂;不確定性。

在現實世界中如果你遇到意想不到的情況,例如:當你在路上開車時,看到一個紅綠燈,那么你就不太可能感到困惑,而如果你看到一只野生動物穿過城市的街道,那么你肯定就會產生很大的疑問。

對于一個試圖預測句子中下一個單詞的語言模型,如果它使用一個我們不期望的單詞來完成句子,我們說這個模型會讓我們感到困惑。

具有低困惑的句子看起來像下面這樣

1、It’s a sunny day outside.

2、I’m sorry I missed the flight and was unable to reach the national park in time.

具有高度困惑的句子看起來像下面這樣:

1、It’s a bread day outside.

2、I’m convenient missed light outside and could not reach national park.

如何計算語言模型所做預測的困惑度呢?

困惑度 perplexity

語言模型的復雜性與能夠毫不意外地預測句子的下一個符號(單詞)的概率有關。

假設我們用包含6600個記號的詞匯表訓練一個語言模型,讓模型預測句子中的下一個單詞。假設選擇這個單詞的可能性是5/6600(即不太可能)。它的困惑度是概率6600/5 = 1320的倒數,這表示困惑非常高。如果選擇這個單詞的可能性是6000/6600,那么困惑度將是6600/6000 = 1.1,這說明困不太困惑。

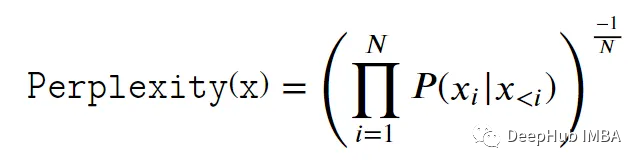

困惑度的計算公式如下:

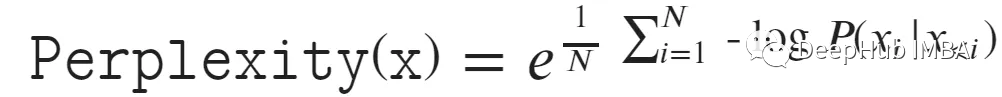

為了保證數值的穩定性,我們可以用對數函數來定義它。

模型的訓練和驗證困惑度可以直接從batch或epoch損失中計算出來。但是無法計算預測的困惑度,因為它要求每個預測都有一組基本的真值標簽。

讓我們假設變量probs是一個張量,它包含了語言模型在序列中那個位置預測基真值的概率。

可以使用此代碼計算每個困惑度。

token_perplexity = (probs.log() * -1.0).exp()

print(f"Token Perplexity: {token_perplexity}")使用此代碼可以計算樣本的困惑度。

sentence_perplexity = (probs.log() * -1.0).mean().exp().item()

print(f"Sentence Perplexity: {sentence_perplexity:.2f}")以下代碼可以計算給定一個句子的每個單詞的概率。

def get_pointwise_loss(self, inputs: List[str], tok):

self.model.eval()

all_probs = []

with torch.inference_mode():

for input in inputs:

ids_list: List[int] = tok.encode(input).ids

# ids has shape (1, len(ids_list))

ids: Torch.Tensor = torch.tensor(ids_list, device=self.device).unsqueeze(0)

# probs below is the probability that the token at that location

# completes the sentence (in ids) so far.

y = self.model(ids)

criterion = nn.CrossEntropyLoss(reductinotallow='none', ignore_index=0)

# Compute the loss starting from the 2nd token in the model's output.

loss = criterion(y[:,:,:-1], ids[:,1:])

# To compute the probability of each token, we need to compute the

# negative of the log loss and exponentiate it.

loss = loss * -1.0

# Set the probabilities that we are not interested in to -inf.

# This is done to make the softmax set these values to 0.0

loss[loss == 0.0] = float("-inf")

# probs holds the probability of each token's prediction

# starting from the 2nd token since we don't want to include

# the probability of the model predicting the beginning of

# a sentence given no existing sentence context.

#

# To compute perplexity, we should probably ignore the first

# handful of predictions of the model since there's insufficient

# context. We don’t do that here, though.

probs = loss.exp()

all_probs.append(probs)

#

#

return all_probs

#上面就是最基本的大語言模型的工作原理,以及我們如何計算每個單詞和每個句子的困惑度,下面我們就可以利用這些信息來構建一個可以檢測某些文本是否是人工智能生成的工具。

檢測ai生成的文本

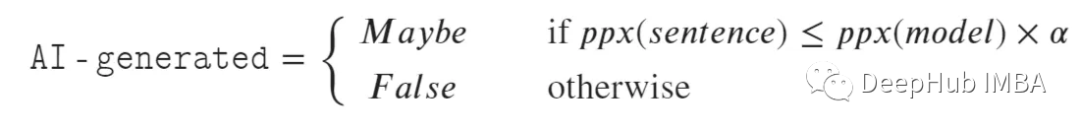

為了檢查文本是否是人工智能生成的,我們需要將句子的困惑度與模型的困惑度進行比較,該困惑度由一個模糊因子alpha縮放。如果句子的困惑程度超過模型縮放的困惑程度,那么它可能是人類編寫的文本(即不是人工智能生成的)。否則,它可能是人工智能生成的。如果句子的困惑度小于或等于模型的縮放訓練困惑度,那么它很可能是使用該語言模型生成的,但我們不能很確定。這是因為這段文字有可能是人類寫的,而它恰好是模型也可以生成的。因為模型是在大量人類書寫的文本上進行訓練的,所以在某種意義上,該模型就代表了“普通人的寫作”。

上式中的Ppx (x)表示輸入“x”的困惑度。

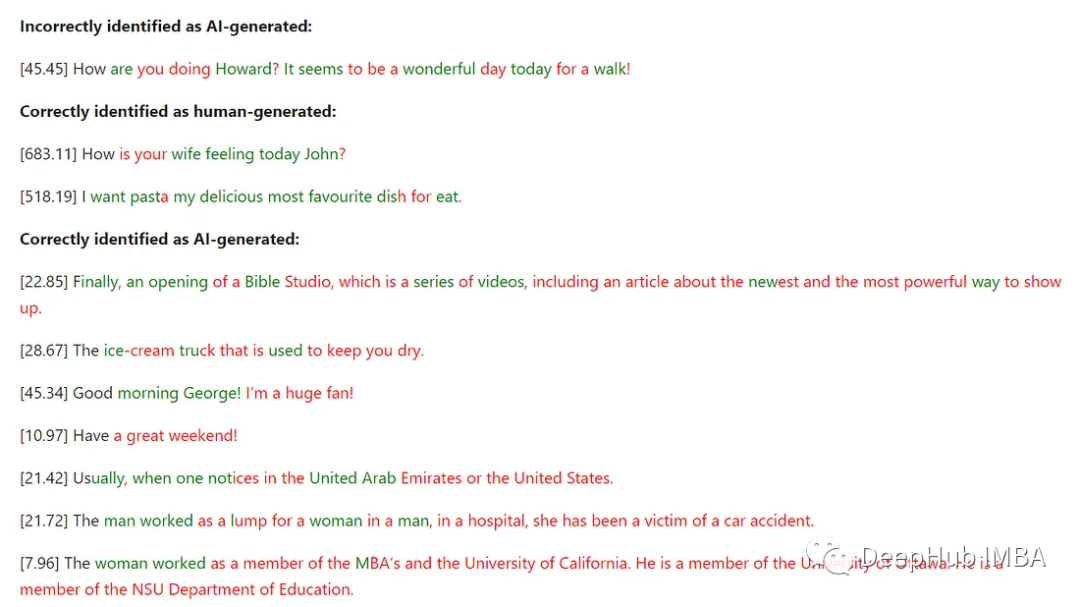

讓我們看看人類編寫的與 ai生成文本的示例。

我們的Python代碼可以根據句子中的每個標記相對于模型的困惑度為其上色。如果我們不考慮它的困惑,第一個符號總是認為是手寫的(因為模型也需要第一個輸入才可以進行后續的輸出)。困惑度小于或等于模型縮放困惑度的單詞用紅色表示,表明它們可能是ai生成的,而困惑度更高的令牌用綠色表示,表明它們肯定不是ai生成的。

句子前方括號中的數字表示使用語言模型計算出的句子的復雜程度。有些單詞是半紅半藍的。這是由于我們使用了子詞標記器。

下面是生成上述HTML的代碼。

def get_html_for_token_perplexity(tok, sentence, tok_ppx, model_ppx):

tokens = tok.encode(sentence).tokens

ids = tok.encode(sentence).ids

cleaned_tokens = []

for word in tokens:

m = list(map(ord, word))

m = list(map(lambda x: x if x != 288 else ord(' '), m))

m = list(map(chr, m))

m = ''.join(m)

cleaned_tokens.append(m)

#

html = [

f"<span>{cleaned_tokens[0]}</span>",

]

for ct, ppx in zip(cleaned_tokens[1:], tok_ppx):

color = "black"

if ppx.item() >= 0:

if ppx.item() <= model_ppx * 1.1:

color = "red"

else:

color = "green"

#

#

html.append(f"<span style='color:{color};'>{ct}</span>")

#

return "".join(html)

#正如我們從上面的例子中看到的,如果一個模型檢測到一些文本是人工手寫的,那么它肯定是人工手寫的,但如果它檢測到文本是人工智能生成的,那么它就有可能不是人工智能生成的。為什么會這樣呢?讓我們看看下面!

假陽性

語言模型是在人類寫的大量文本上訓練的。一般來說,很難發現某件東西是否是由特定的人寫的。該模型用于訓練的輸入包括許多不同的寫作風格,是由不同的人完成的。這使得模型學習許多不同的寫作風格和內容。很有可能你的寫作風格與模型訓練的某些文本的寫作風格非常接近。這就會產生誤報,也是為什么模型不能確定某些文本是人工智能生成的。但是該模型可以確定一些文本是人為生成的。

”OpenAI最近宣布將停止其用于檢測ai生成文本的工具,理由是準確率低“(https://tech.hindustantimes.com/tech/news/openai-kills-off-its-own-ai-text-detection-tool-shocking-reason-behind-it-71690364760759.html)。這條新聞就說明了上面的問題。

原始版本的人工智能分類器工具從一開始就存在一定的局限性和不準確性。用戶需要手動輸入至少1000個字符的文本,然后OpenAI對其進行分析,將其分類為人工智能或人類編寫的文本。該工具的表現并不理想,因為它只正確識別了26%的人工智能生成的內容,并且在大約9%的情況下錯誤地將人類編寫的文本標記為人工智能。

以下是OpenAI的博客文章。與本文中提到的方法相比,他們似乎使用了不同的方法。

我們的分類器是一個語言模型,對同一主題的人類編寫文本和人工智能編寫文本的數據集進行微調。從各種各樣的來源收集了這個數據集,我們認為這些數據是由人類編寫的,比如預訓練數據和人類對提交給InstructGPT的提示。將每篇文章分為提示和回復。根據這些提示,從我們和其他組織訓練的各種不同的語言模型中生成響應。對于我們的web應用程序,我們調整置信閾值以保持低誤報率;換句話說,如果分類器非常自信,我們只會將文本標記為可能是人工智能編寫的。

GPTZero是一個流行的人工智能生成文本檢測工具。似乎GPTZero使用perplexity 和Burstiness 來檢測人工智能生成的文本。“Burstiness ”指的是某些單詞或短語在文本中突發性出現的現象。如果一個詞在文本中出現過一次,它很可能會在很近的地方再次出現。”

GPTZero聲稱有非常高的成功率。根據GPTZero常見問題解答,“在0.88的閾值下,85%的人工智能文檔被歸類為人工智能,99%的人類文檔被歸類為人類。”

方法的通用性

本文中提到的方法不能很好地一般化。如果您有3個語言模型,例如GPT3、GPT3.5和GPT4,那么必須在所有3個模型中運行輸入文本,并檢查它們的困惑度,以查看文本是否由其中任何一個生成。這是因為每個模型生成的文本略有不同,并且它們都需要獨立地評估文本,以查看是否有任何模型生成了文本。

截至2023年8月,隨著世界上大型語言模型的激增,人們似乎不太可能檢查任何一段文本是否來自世界上任何一個語言模型。

下面的例子顯示了要求我們的模型預測ChatGPT生成的句子是否是人工智能生成的結果。正如您所看到的,結果喜憂參半。

這種情況發生的原因有很多。

1、我們的模型是在非常少的文本上訓練的,而ChatGPT是在tb的文本上訓練的。

2、與ChatGPT相比,我們的模型是在不同的數據分布上訓練的。

3、我們的模型只是一個GPT模型,而ChatGPT針對類似于聊天的響應進行了微調,使其以略微不同的語氣生成文本。如果你有一個生成法律文本或醫療建議的模型,那么我們的模型在這些模型生成的文本上也會表現不佳。

4、我們的模型非常小(與chatgpt類模型的> 200B個參數相比,我們的模型小于100M個參數)。

很明顯,如果希望提供一個相當高質量的結果來檢查任何文本是否是人工智能生成的,我們需要一個更好的方法。

接下來,讓我們來看看網上流傳的一些關于這個話題的錯誤信息。

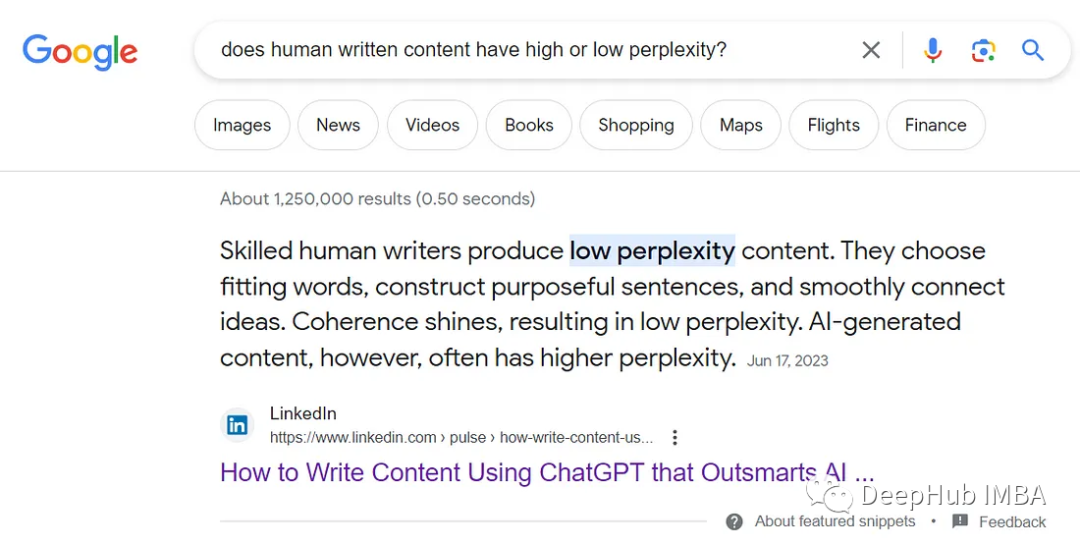

有些文章錯誤地解釋了困惑。例如,如果你在google.com上搜索“人類寫的內容是高困惑還是低困惑?”,將在第一個位置獲得以下結果。

這是不正確的,因為與人工智能生成的內容相比,人類編寫的內容通常具有更高的困惑度。

最近kaggle也發布了一個 LLM - Detect AI Generated Text 的比賽,目前的baseline只用的tfidf和lgb,有興趣的也可以關注一下。

以下是我總結的一些代碼:

import nltk

from collections import Counter

from sklearn.feature_extraction.text import CountVectorizer

from textblob import TextBlob

import numpy as np

text = "This is some sample text to detect. This is a text written by a human? or is it?!"

# 1. N-gram Analysis

def ngram_analysis(text, n=2):

n_grams = nltk.ngrams(text.split(), n)

freq_dist = nltk.FreqDist(n_grams)

print(freq_dist)

ngram_analysis(text)

# 2. Perplexity

# Perplexity calculation typically requires a language model

# This is just an example of how perplexity might be calculated given a probability distribution

def perplexity(text, model=None):

# This is a placeholder. In practice, we would use the model to get the probability of each word

prob_dist = nltk.FreqDist(text.split())

entropy = -1 * sum([p * np.log(p) for p in prob_dist.values()])

return np.exp(entropy)

print(perplexity(text))

# 3. Burstiness

def burstiness(text):

word_counts = Counter(text.split())

burstiness = len(word_counts) / np.std(list(word_counts.values()))

return burstiness

print(burstiness(text))

# 4. Stylometry

def stylometry(text):

blob = TextBlob(text)

avg_sentence_length = sum(len(sentence.words) for sentence in blob.sentences) / len(blob.sentences)

passive_voice = text.lower().count('was') + text.lower().count('were')

vocabulary_richness = len(set(text.split())) / len(text.split())

return avg_sentence_length, passive_voice, vocabulary_richness

print(stylometry(text))

# 5. Consistency and Coherence Analysis

# Again, this is a simple way to explain the idea of calculating the consistency of a text. In reality, more complex algorithms are used.

def consistency(text):

sentences = text.split(".")

topics = [sentence.split()[0] for sentence in sentences if sentence]

topic_changes = len(set(topics))

return topic_changes

print(consistency(text))總結

本文介紹了關于如何檢測ai生成文本的思路。可以使用的主要指標是生成文本的困惑度。還介紹了這種方法的一些缺點,包括誤報的可能性。希望這有助于理解檢測人工智能生成文本背后的細節。

但是當我們討論檢測人工智能生成文本的技術時,這里的假設都是整個文本要么是人類編寫的,要么是人工智能生成的。但是實際上文本往往部分由人類編寫,部分由ai生成,這使事情變得相當復雜。本文總結的代碼也是對所有文本內容的檢測,對于部分由人類編寫,部分由ai生成則會復雜的多。

對于人工智能生成文本的檢測是一個不斷發展的領域,還需要我們努力找出一種方法,以更高的準確率檢測人工智能生成的文本。