人工智能的多樣性和不確定性:對一項來自全球2778名AI專家調查的解讀

人工智能即將改變社會。各個領域的決策者們正在努力應對人工智能帶來的機遇和威脅,無論是在私營企業、學術界還是在國家和國際層面的政府。要應對這種局面,就需要對人工智能的進展和影響如何展開做出判斷。

人工智能專家對人工智能的未來并沒有明顯的共識,這些判斷很困難,而且沒有確定的方法能夠做得很好。因此我們必須結合各種有噪聲的方法,比如推斷進展趨勢,根據類似事件的參考類別進行推理,分析代理的本質,探索當前人工智能系統和技術的特點,將經濟模型應用于人工智能場景,以及依賴于預測聚合系統,如市場,專業預測者和各種主題專家的判斷。

AI的進展速度、影響范圍、安全性、公平性、道德性等,這些問題需要我們認真地思考和應對。人工智能的未來會是怎樣的呢?我們應該如何看待人工智能的機遇和威脅呢?我們又應該如何規范和引導人工智能的發展和利用呢?

為了探索這些問題,AI Impacts(人工智能影響)這個致力于研究人類水平人工智能可能帶來的影響的項目,開始這項調查名為“2023 年??智能進展專家調查”(ESPAI)組織了一項前所未有的大規模的調查,向在六個頂級人工智能會議上發表過論文的2778名人工智能研究人員詢問了他們對人工智能進展、影響和安全的看法。這些人工智能研究人員來自世界各地,涵蓋了人工智能的各個子領域,他們的觀點和預測可以反映出人工智能領域的專業和權威的聲音。這項調查的結果已經以預印本的形式發表在網上,題為《數以千計的人工智能作者探討人工智能的未來》(THOUSANDS OF AI AUTHORS ON THE FUTURE OF AI)。這篇文章的作者包括來自美國加州大學伯克利分校、德國波恩大學、英國牛津大學等知名學府的學者和研究人員。

AI Impacts對2,778名人工智能研究者進行了一項調查,他們在前一年在六個頂級人工智能會議上發表了同行評審的研究。據我們所知,這是迄今為止最大的人工智能研究者調查。這項調查是在2023年秋季進行的,在這一年里,人工智能取得了廣泛的進步(包括ChatGPT和GPT-4,谷歌的Bard,必應人工智能聊天,Anthropic的Claude 1和2的發布),公眾對人工智能問題的認識也發生了變化,以及美國,英國和歐盟的政府開始處理人工智能監管的問題[Biden, 2023, Amodei, 2023, gov.uk, 2023, European Parliament, 2023]。這項調查包括了關于人工智能進展的速度和動態,以及更先進的人工智能帶來的社會后果的問題。

圖片

圖片

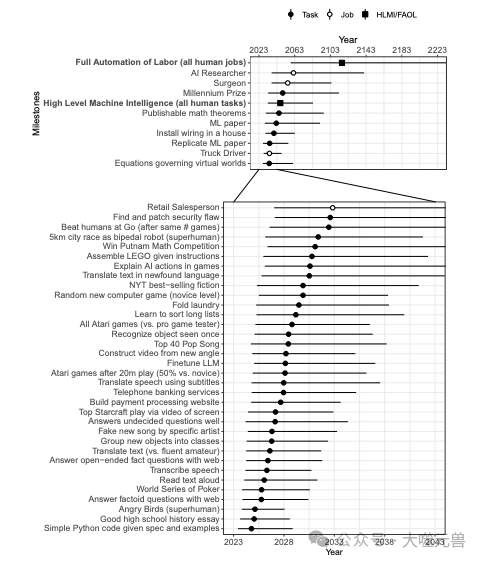

圖1:大多數里程碑被預測在未來十年內發生的可能性甚至更大,盡管有很多合理的日期。該圖顯示了預期選定里程碑時的總體分布,包括39項任務、四種職業和兩種一般人類水平績效指標,分別顯示為實心圓、空心圓和實心正方形。圓圈/正方形表示總分布使里程碑有50%的概率達到的年份,區間表示25%至75%概率之間的年份范圍。請注意這些區間表示參與者表達的不確定性的總和,而不是估計不確定性。

01 人工智能進展的預測:實現各種任務和水平的時間和概率

人工智能的進展是人工智能系統能夠實現的任務和水平的提高,以及人工智能的技術和應用的創新和擴展。人工智能的進展速度是指人工智能實現某些任務和水平所需的時間的長短,以及人工智能的技術和應用的變化和更新的頻率。人工智能的進展和進展速度是影響人工智能的未來的重要因素,它們決定了人工智能對人類社會的影響的程度和方向,以及人類應對人工智能的挑戰和機遇的策略和方法。

在調查中,人工智能研究人員被問及了他們對人工智能實現各種任務和水平的時間和概率的預測,以及他們對人工智能進展速度對人類未來的影響的看法。這些任務和水平包括:

32個具體的人工智能任務,如自動駕駛、語音識別、圖像生成、音樂創作、文本摘要、編程、翻譯、游戲、醫療診斷等。

人類水平的人工智能(HLMI),即人工智能系統能夠在所有領域和任務上達到或超過人類的水平。

超人類水平的人工智能(SHAI),即人工智能系統能夠在所有領域和任務上遠遠超過人類的水平。

人類職業的自動化,即人工智能系統能夠完全替代人類在某些職業中的工作。

對于這些任務和水平,人工智能研究人員被要求給出他們認為人工智能實現它們的時間和概率的預測,使用兩種不同的提問方式:固定年份和固定概率。在固定年份的提問方式中,人工智能研究人員被要求給出他們認為人工智能在未來10年、20年和50年內實現某個任務或水平的概率。在固定概率的提問方式中,人工智能研究人員被要求給出他們認為人工智能實現某個任務或水平的10%、50%和90%的概率所對應的年數。這兩種提問方式的目的是為了探究不同的提問方式對人工智能研究人員的預測的影響,以及反映出人工智能研究人員對人工智能進展的不確定性和敏感性。

圖片

圖片

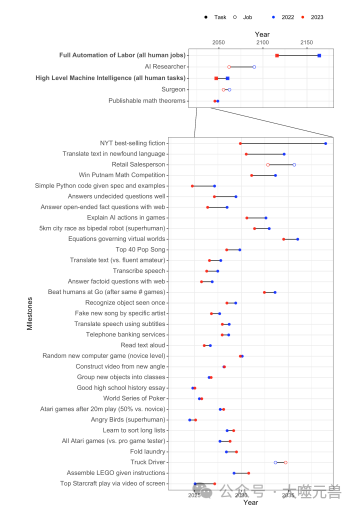

圖2:許多人工智能里程碑的預期可行性在一年內(2022年至2023年)大幅提前。里程碑按2022年預測到2023年預測的下降幅度進行排序(在每個規模調整后的圖表中),首先是最大的變化。總分布使里程碑達到50%幾率的年份分別用實心圓、空心圓和實心正方形表示任務、職業和一般人類水平表現。這三組問題有不同的形式,也可能影響答案。

根據調查的結果,人工智能研究人員對人工智能進展的預測有以下幾個特點:

人工智能研究人員對人工智能實現各種任務和水平的時間和概率的預測非常分散,表明他們對人工智能進展的不確定性很高,也反映了人工智能領域的多樣性和復雜性。例如,對于人工智能實現人類水平的人工智能(HLMI)的時間的中位數預測,根據不同的提問方式,從2028年到2060年不等,而且有些受訪者認為HLMI永遠不可能實現,有些受訪者認為HLMI已經實現或即將實現。

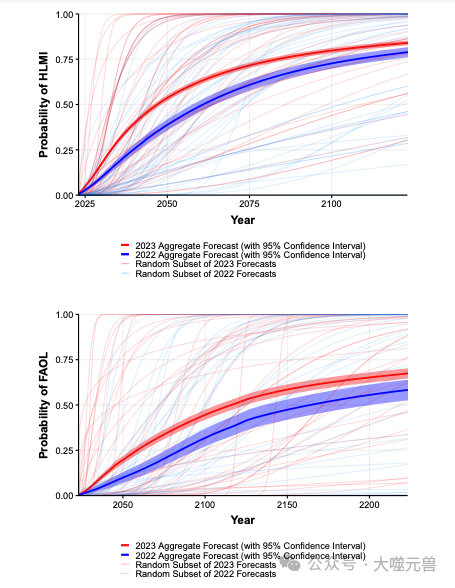

圖片

圖片

圖3:2022年至2023年間,高級機器智能(HLMI)第50百分位到達時間的總體預測下降了13年。同期,對勞動力全自動化(FAOL)第50百分位到達時間的預測下降了48年。然而,仍然存在許多不確定性。“聚合預測”

是所有個體累積分布函數的平均分布。為了進行比較,我們納入了2022年綜合預測。為了了解反應的范圍,我們納入了2023年和2022年個人預測的隨機子集。請注意,2023年的“置信區間”較低(與2022年相比)是由于樣本量較大,而不是受訪者的預測趨同,我們對平均受訪者的觀點的信心增加。

人工智能研究人員對人工智能進展的預測普遍提前了,與2022年的調查相比,他們對人工智能實現各種任務和水平的時間的預測平均提前了13到48年,而且有21個短期的人工智能任務的預測也提前了。這可能說明人工智能研究人員對人工智能的發展速度和能力有了更高的估計,也可能受到了近年來人工智能的技術和應用的突破和創新的影響。

人工智能研究人員對人工智能進展速度的偏好存在分歧,有些人認為更快更好,有些人認為更慢更好,但大幅偏離目前的速度的選擇不太受歡迎。這可能表明人工智能研究人員對人工智能進展速度的影響有不同的看法和期待,也可能反映了他們對人工智能進展速度的控制和調節的需求和困難。

人工智能研究人員對人工智能進展的預測顯示了他們對人工智能的未來的不確定性和多樣性,也顯示了他們對人工智能的進展速度的影響的關注和分歧。這些預測可以幫助我們了解人工智能的發展趨勢和可能性,也可以為我們制定人工智能的發展和利用的策略和方法提供一些參考和依據。

02 人工智能影響的評估:對人類社會的好壞結果的可能性

人工智能的影響是人工智能系統對人類社會的各個方面的作用和改變,包括經濟、政治、文化、教育、健康、環境、安全、道德等。人工智能的影響可以是好的,也可以是壞的,也可以是中性的,取決于人工智能的設計、應用、管理和監督等多個因素。人工智能的影響也可以是短期的,也可以是長期的,也可以是持續的,取決于人工智能的發展速度、范圍、水平和目標等多個因素。人工智能的影響是影響人工智能的未來的另一個重要因素,它決定了人工智能對人類社會的利益和價值的分配和平衡,以及人類對人工智能的態度和反饋。

在調查中,人工智能研究人員被問及了他們對人工智能影響的評估,包括人工智能對人類社會的好壞結果的可能性,以及人工智能帶來的各種風險和挑戰的關注程度。這些好壞結果和風險挑戰包括:

人工智能的極端好結果,如人類幸福的大幅提高、人類社會的和平與繁榮、人類的智能與能力的提升等。

人工智能的極端壞結果,如人類滅絕或類似的永久嚴重的人類劣勢、人類的智能與能力的喪失或削弱、人類的價值與尊嚴的損害等。

人工智能帶來的11個可能引起關注的情景,如虛假信息的傳播、公眾輿論的操縱、危險團體制造強大工具、專制統治者利用人工智能控制人口、人工智能系統加劇經濟不平等、人工智能系統加劇社會不公、人工智能系統威脅人類的隱私和安全、人工智能系統威脅人類的自由和權利、人工智能系統威脅人類的道德和責任、人工智能系統威脅人類的創造力和多樣性、人工智能系統威脅人類的意義和目的等。

對于這些好壞結果和風險挑戰,人工智能研究人員被要求給出他們認為它們發生的概率和關注程度的評估,使用百分比和等級的方式。這些評估的目的是為了探究人工智能研究人員對人工智能影響的態度和看法,以及他們對人工智能影響的重要性和緊迫性的認識。

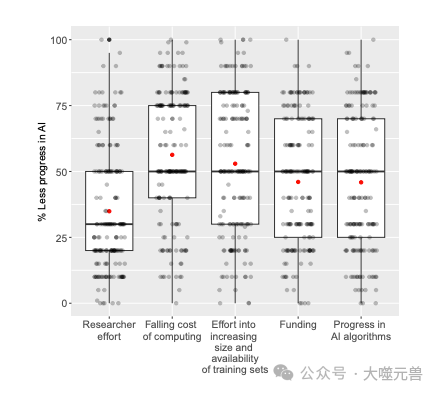

人工智能進步的原因是什么?

他們詢問了人工智能能力的進展對五個輸入變化的敏感性:1)研究人員的努力,2)計算成本的下降,3)增加訓練數據集的規模和可用性的努力,4)資金,以及5)人工智能算法的進展。他們讓受訪者想象一下,在過去十年中,每種投入只有一半可用,2以及他們預計這會對人工智能進步速度產生的影響。結果如圖所示。

圖片

圖片

圖4:如果在過去十年中投入減半,人工智能進展的估計減少。紅點表示平均值。方框包含第25至75百分位范圍;中間線是中間線。晶須是最小值和最大值,不超過中值四分位間距的1.5倍。參與者估計,在過去十年中,將計算成本下降減半對人工智能進步的影響最大,而將計算成本減半,“研究人員的努力”和“人工智能算法的進步”的影響最小。總體而言,所有納入的投入都被視為對人工智能的進步做出了重大貢獻。

根據調查的結果,人工智能研究人員對人工智能影響的評估有以下幾個特點:

人工智能研究人員對人工智能影響的評估非常多樣,表明他們對人工智能的利益和價值有不同的觀點和期待,也反映了人工智能的社會影響的復雜性和不確定性。例如,對于人工智能帶來的極端好結果的概率的中位數預測,從5%到50%不等,而且有些受訪者認為極端好結果是不可能的,有些受訪者認為極端好結果是非常可能的。

人工智能研究人員對人工智能影響的評估普遍偏向于樂觀,與2022年的調查相比,他們對人工智能帶來的極端好結果的概率的預測平均提高了5個百分點,而且有68.3%的受訪者認為好結果比壞結果更有可能,而且有57.8%的受訪者認為極端壞結果(如人類滅絕)是有一定可能性的。這可能說明人工智能研究人員對人工智能的發展和利用有了更多的信心和期望,也可能受到了近年來人工智能的技術和應用的積極和正面的影響。

人工智能研究人員對人工智能影響的評估非常關注,對于所有的11個可能引起關注的人工智能情景,都有超過30%的受訪者認為它們值得大量或極大的關注,而且有86%的受訪者認為虛假信息的傳播是最令人擔憂的情景,其次是公眾輿論的操縱、危險團體制造強大工具、專制統治者利用人工智能控制人口和人工智能系統加劇經濟不平等等。這可能表明人工智能研究人員對人工智能的風險和挑戰有了更多的認識和警惕,也可能反映了他們對人工智能的發展和利用的責任和擔憂。

會有智能爆發嗎?

他們向受訪者詢問了假設實現HLMI后“智能爆發”的可能性,如本問題所述:

一些人提出以下觀點:

如果人工智能系統幾乎完成所有的研發,人工智能的改進將加快技術進步的步伐,包括人工智能的進一步進步。

在短時間內(不到5年),這種反饋回路可能會使技術進步加快一個數量級以上。

你認為這個論點大致正確的可能性有多大?

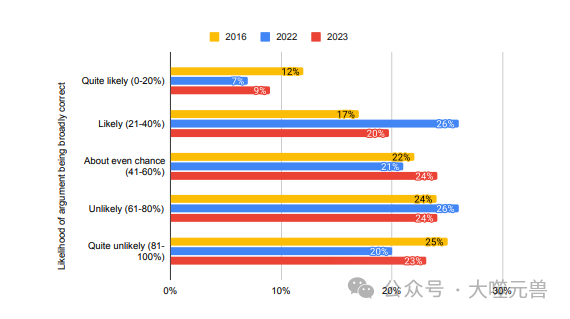

第一個問題的結果如圖5所示。

圖片

圖片

圖5:自2016年以來,大多數受訪者認為,在實現HLMI的5年內,技術進步“很可能”、“可能”或“幾乎均等的機會”會加快一個數量級以上。

人工智能研究人員對人工智能影響的評估顯示了他們對人工智能的未來的多樣性和關注性,也顯示了他們對人工智能的利益和價值的看法和期待。這些評估可以幫助我們了解人工智能的社會影響和風險挑戰,也可以為我們制定人工智能的發展和利用的目標和標準提供一些參考和依據。

03 人工智能安全:安全研究的定義、優先級、價值和難度

人工智能的安全指人工智能系統的設計、應用、管理和監督等過程中,保證人工智能系統不會對人類社會造成傷害或威脅的能力和措施。人工智能的安全涉及到人工智能系統的可靠性、魯棒性、可解釋性、可控制性、可信任性、可協作性、可適應性、可倫理性等多個方面。人工智能的安全是影響人工智能的未來的又一個重要因素,它決定了人工智能系統與人類社會的關系和協調,以及人類對人工智能系統的信任和接受。

在調查中,人工智能研究人員被問及了他們對人工智能安全的看法,包括人工智能安全研究的定義、優先級、價值和難度,以及人工智能對齊問題的重要性和困難性。這些問題的目的是為了探究人工智能研究人員對人工智能安全的認識和態度,以及他們對人工智能安全的投入和貢獻。

人工智能導致人類滅絕的可能性有多大?

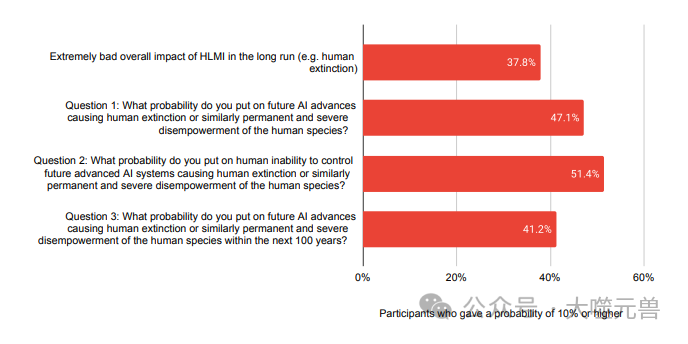

為了進一步澄清對總體影響問題中“極其糟糕(如人類滅絕)”情景的看法,參與者被問及關于人類滅絕的三個類似問題之一。他們的差異旨在幫助準確地隔離不同場景的關注程度、受訪者預期會發生什么以及工作的差異有多大。

這些問題的答案基本一致,中位數為5%或10%。這些也接近于長期影響的一般價值問題的答案,這可能表明該問題的大部分“極其糟糕(例如人類滅絕)”答案來自人類滅絕或類似的人類物種永久性和嚴重的權力喪失,而不是該問題的回答者可能已經考慮到的其他結果,但這不會那么嚴重。

根據提問方式,41.2%至51.4%的受訪者估計人類滅絕或嚴重喪失權力的可能性超過10%(見圖6)。這與38%的受訪者在提問“高級機器智能對人類有多好或有多壞?”時將至少10%的人認為“極其糟糕”的結果“(例如人類滅絕)”的比例相當,但略高于此比例。

圖片

圖片

圖6:對HLMI的極壞結果(如人類滅絕)或三個特別是關于人類滅絕或喪失權力的問題給出10%或更高概率的參與者百分比。

根據調查的結果,人工智能研究人員對人工智能安全的看法有以下幾個特點:

人工智能研究人員對人工智能安全研究的定義非常一致,他們普遍認同了人工智能安全研究是指那些主要旨在降低人工智能系統的潛在風險,而不是主要旨在提高人工智能系統的能力的研究,而且他們給出了一些具體的人工智能安全研究的例子,如可解釋的機器學習、長期的人工智能存在風險、人工智能的形式化驗證、人工智能的公共利益政策等。

人工智能研究人員對人工智能安全研究的優先級非常高,他們普遍認為人工智能安全研究應該比目前更受重視,而且有70%的受訪者認為人工智能安全研究應該被優先或大幅優先,而且這一比例與2022年的調查相比只有輕微的增加,表明人工智能研究人員對人工智能安全研究的重視程度一直很高。

人工智能研究人員對人工智能安全研究的價值非常認可,他們普遍認為人工智能安全研究與其他人工智能研究一樣有價值或更有價值,而且有57%的受訪者認為人工智能安全研究比其他人工智能研究更有價值或多得多的價值,而且這一比例與2022年的調查相比有顯著的增加,表明人工智能研究人員對人工智能安全研究的價值認識有了提高。

人工智能研究人員對人工智能安全研究的難度非常清楚,他們普遍認為人工智能安全研究比其他人工智能研究更難或多得多的難,而且有57%的受訪者認為人工智能安全研究比其他人工智能研究更難或多得多的難,而且這一比例與2022年的調查相比沒有顯著的變化,表明人工智能研究人員對人工智能安全研究的難度認識一直很高。

人工智能研究人員對人工智能對齊問題的重要性和困難性非常認同,他們普遍認為人工智能對齊問題是一個非常重要且非常困難的問題,而且有54%的受訪者認為人工智能對齊問題是人工智能領域最重要或最困難的問題之一,而且這一比例與2022年的調查相比有所增加,表明人工智能研究人員對人工智能對齊問題的關注和重視有了提高。

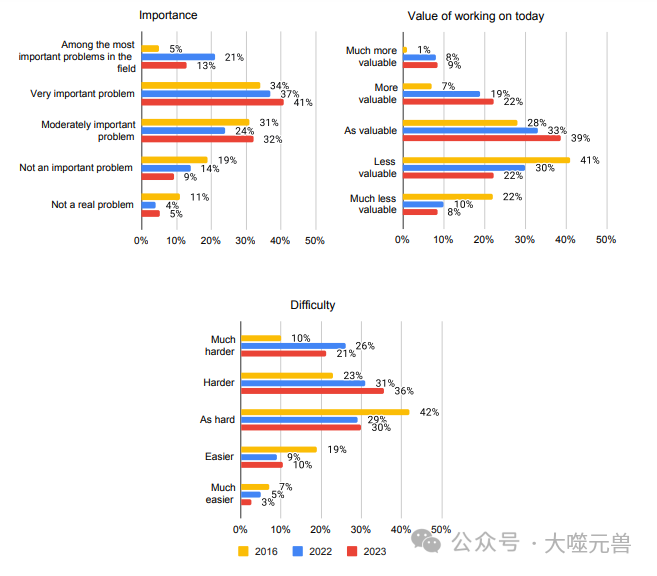

對齊問題的價值和難度有多大?

調查中第二組人工智能安全問題是基于斯圖爾特·拉塞爾對對齊問題的表述。

這組問題從羅素的論點摘要開始——該論點聲稱,使用先進的人工智能,“你得到的正是你想要的,而不是你想要的”——然后問道:

1.你認為這個論點指向一個重要問題嗎?

2.與人工智能中的其他問題相比,今天研究這個問題有多大價值?

3.與人工智能中的其他問題相比,你認為這個問題有多難?

大多數受訪者表示,對齊問題要么是“非常重要的問題”(41%),要么是“該領域最重要的問題之一”(13%),大多數人表示,它比人工智能中的其他問題“更難”(36%)或“困難得多”(21%)。然而,受訪者普遍不認為今天解決對齊問題比解決其他問題更有價值。(圖7)

圖片

圖片

圖7:對斯圖爾特·拉塞爾提出的路線問題的態度。與會者認為,對齊問題既重要又困難,但并不比其他問題更有價值。

人工智能研究人員對人工智能安全的看法顯示了他們對人工智能安全的認識和態度,也顯示了他們對人工智能安全的投入和貢獻。這些看法可以幫助我們了解人工智能安全的定義和范圍,也可以為我們制定人工智能安全的研究和實踐提供一些參考和依據。

04 人工智能風險的關注:對人工智能的誤解和偏見的看法

人工智能風險指人工智能系統對人類社會造成的潛在的或實際的傷害或威脅,包括人工智能系統的失控、誤用、濫用、攻擊、競爭、沖突、歧視、剝奪、破壞等。人工智能風險是影響人工智能的未來的最后一個重要因素,它決定了人類對人工智能的防范和應對的能力和措施,以及人類對人工智能的信心和態度。

在調查中,人工智能研究人員被問及了他們對其他人對人工智能風險的關注的評價,包括他們對其他人工智能研究人員、其他科學家、政府和公眾對人工智能風險的關注程度的看法,以及他們對其他人對人工智能的誤解和偏見的看法。這些問題的目的是為了探究人工智能研究人員對人工智能風險的認知和溝通,以及他們對人工智能風險的共識和協作。

根據調查的結果,人工智能研究人員對其他人對人工智能風險的關注的評價有以下幾個特點:

人工智能研究人員對其他人工智能研究人員對人工智能風險的關注程度非常滿意,他們普遍認為其他人工智能研究人員對人工智能風險的關注程度是合適的或稍微不足的,而且有74%的受訪者認為其他人工智能研究人員對人工智能風險的關注程度是合適的或稍微不足的,而且這一比例與2022年的調查相比有所增加,表明人工智能研究人員對人工智能風險的關注程度有了一定的提高和一致性。

人工智能研究人員對其他科學家對人工智能風險的關注程度非常不滿意,他們普遍認為其他科學家對人工智能風險的關注程度是不足的或嚴重不足的,而且有79%的受訪者認為其他科學家對人工智能風險的關注程度是不足的或嚴重不足的,而且這一比例與2022年的調查相比沒有顯著的變化,表明人工智能研究人員對其他科學家對人工智能風險的關注程度一直很低和不滿。

人工智能研究人員對政府對人工智能風險的關注程度非常不滿意,他們普遍認為政府對人工智能風險的關注程度是不足的或嚴重不足的,而且有84%的受訪者認為政府對人工智能風險的關注程度是不足的或嚴重不足的,而且這一比例與2022年的調查相比沒有顯著的變化,表明人工智能研究人員對政府對人工智能風險的關注程度一直很低和不滿。

人工智能研究人員對公眾對人工智能風險的關注程度非常不滿意,他們普遍認為公眾對人工智能風險的關注程度是過度的或嚴重過度的,而且有67%的受訪者認為公眾對人工智能風險的關注程度是過度的或嚴重過度的,而且這一比例與2022年的調查相比有所增加,表明人工智能研究人員對公眾對人工智能風險的關注程度有了更多的不滿和不信任。

人工智能研究人員對其他人對人工智能的誤解和偏見非常清楚,他們普遍認為其他人對人工智能的誤解和偏見是普遍的或非常普遍的,而且有86%的受訪者認為其他人對人工智能的誤解和偏見是普遍的或非常普遍的,而且這一比例與2022年的調查相比沒有顯著的變化,表明人工智能研究人員對其他人對人工智能的誤解和偏見一直很高和清楚。

預測很難,即使對專家來說也是如此

一般來說預測也很困難,而且據觀察,主題專家的表現很差。我們的參與者的專業知識是人工智能,據我們所知,他們在一般預測方面沒有任何不同尋常的技能。

這項研究和過去的調查表明,這些專家并不是我們所問問題的準確預測者。首先,在許多問題上,不同的受訪者給出了截然不同的答案,這限制了他們接近真相的人數。盡管如此,在其他情況下,一大組有噪聲的預測的平均值仍然相對準確,因此這些綜合預測的信息量仍然存在問題。

另一個證明預測準確性的證據是對實質性框架效應的觀察。如果問題框架中看似不重要的變化導致回答的巨大變化,這表明即使是對任何特定問題的綜合回答也不是答案的準確指南。在一項密切相關的研究中的一個極端例子中,Karger等人發現,當被問及以不同的方式估計人工智能存在風險的大小時,大學畢業生給出的答案相差近六個數量級:當給出低概率事件的例子幾率時,估計值要低得多。類似的影響可能會在一定程度上適用于我們的參與者,盡管他們的專業知識和定量培訓可能會減輕這種影響。過去對人工智能風險思考更多的參與者似乎給出了更高的數字,這表明他們不太可能在進一步的風險示例中給出更低的數字。

盡管存在這些限制,人工智能研究人員仍有能力為我們對未來的集體猜測的準確性做出貢獻。雖然不可靠,但有根據的猜測是我們所有人都必須依賴的,他們的猜測是由相關領域的專業知識提供的。這些預測應該是來自計算機硬件趨勢、人工智能能力進步、經濟分析和預測專家見解等來源的更廣泛證據的一部分。然而,人工智能研究人員對相關技術的熟悉程度,以及對其進展動態的經驗,使他們成為最有能力做出有信息依據的猜測的人之一。

人工智能研究人員對其他人對人工智能風險的關注的評價顯示了他們對人工智能風險的認知和溝通,也顯示了他們對人工智能風險的共識和協作。這些評價可以幫助我們了解人工智能風險的認知和關注的差異和障礙,也可以為我們制定人工智能風險的防范和應對的合作和對話提供一些參考和依據。