混合專家系統里根本沒專家?開源MoE模型論文引網友熱議

紅極一時的開源MoE模型Mixtral,論文終于新鮮出爐!

除了披露了更多技術細節,論文中還有一個結論引發了熱烈討論——

研究人員本想研究Mixtral是怎么根據話題分配專家的,結果發現專家的分配……和話題好像沒什么關系。

圖片

圖片

而在大多數人的印象中,Mixtral里的8個專家,是分別負責處理不同領域的話題的……

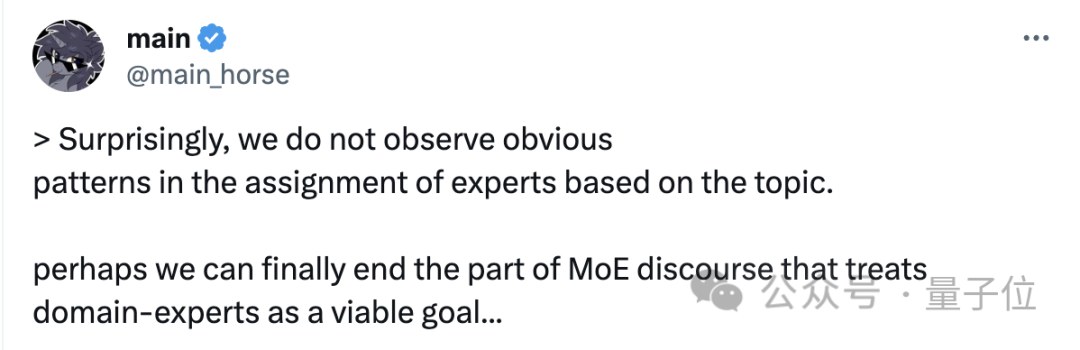

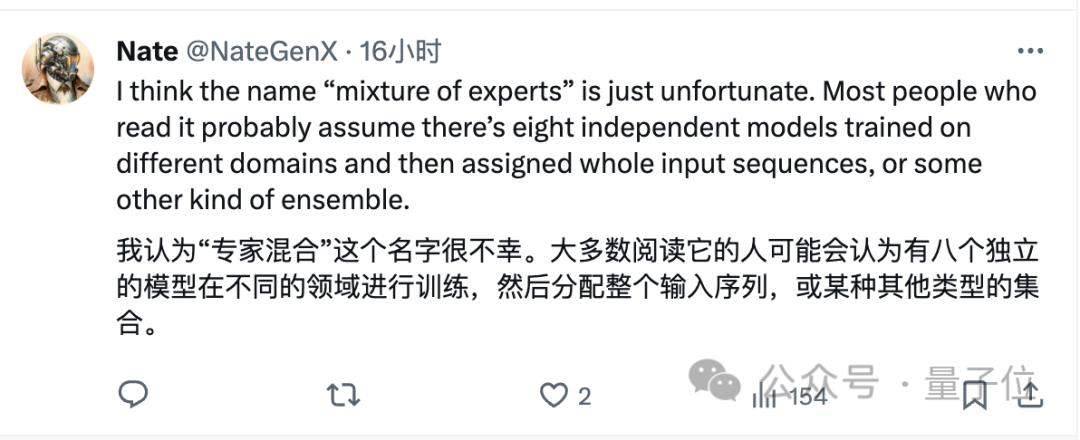

論文的結論曝光后,不少網友開始認為“專家混合”這個說法,可能不那么貼切了:

圖片

圖片

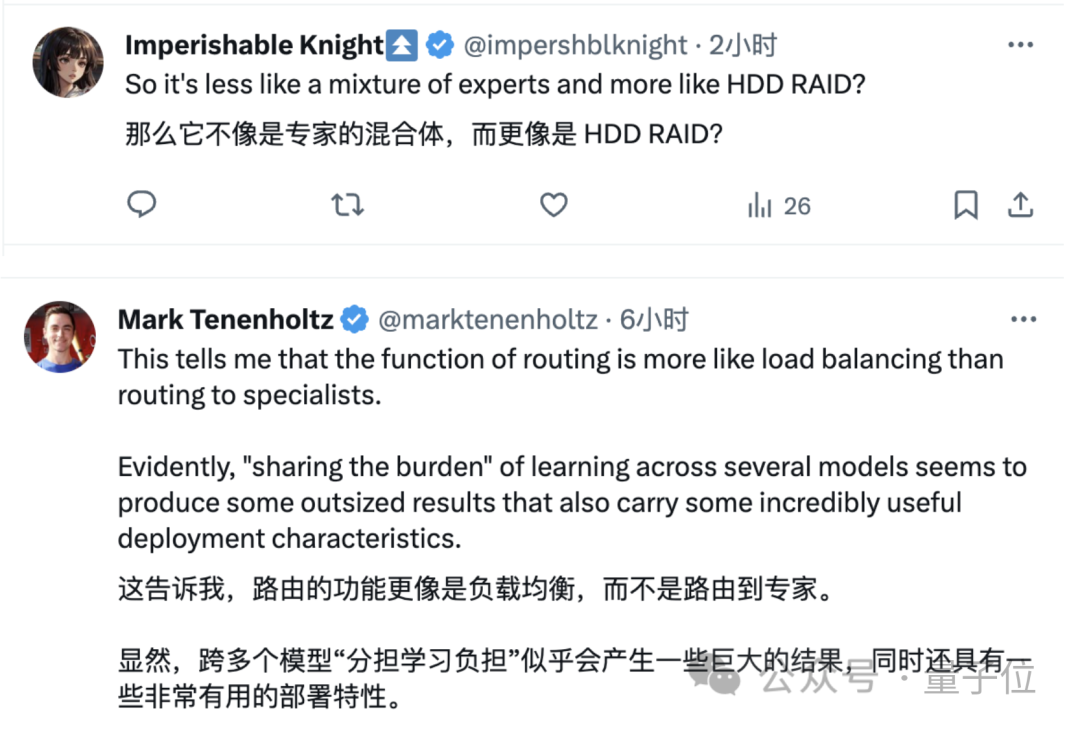

于是,針對Mixtral真實的工作機制,有網友給出了這樣的比喻:

所以,比起“專家的組合”,這樣的工作方式更像是一種硬盤陣列或者負載均衡?

圖片

圖片

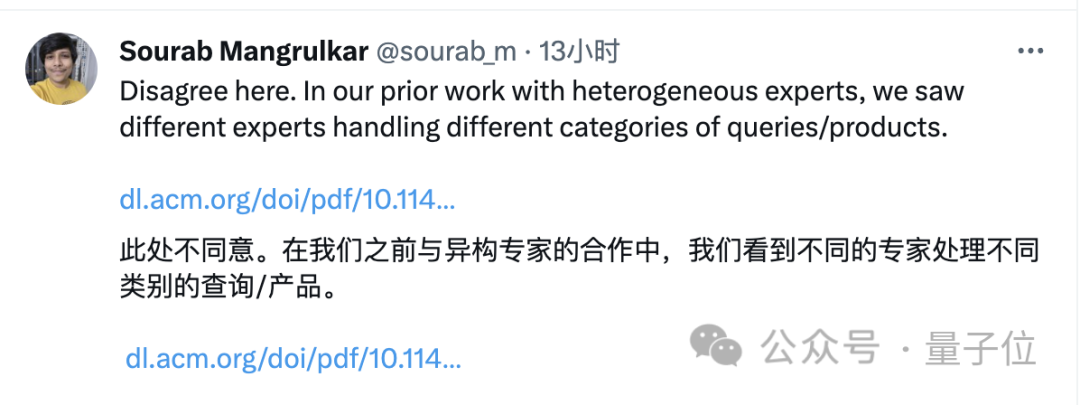

但也有網友表示了不同意見:

這個問題并不根屬于MoE,因為自己之前見過的MoE模型中,是發現了真·專家分工的現象的。

圖片

圖片

那么,這究竟是怎么一回事呢?

實驗未發現專家按領域分布

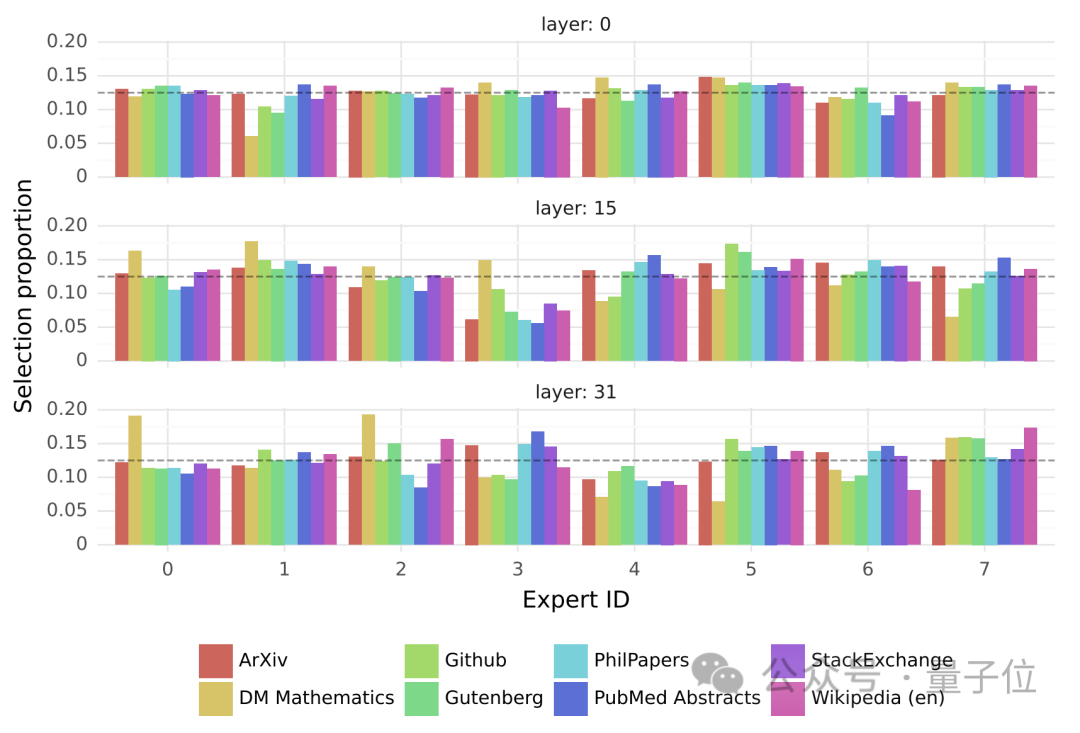

在訓練過程中,作者觀察了Mixtral中是否有一些專家會針對某些特定領域進行專門化。

具體來說,作者計算了第0、15、31層在The Pile驗證集的不同子集(包含不同領域的文檔)上被選中的專家分布。

這些子集包括LaTeX格式的arXiv論文、生物學論文(PubMed摘要)、哲學論文(PhilPapers)和GitHub代碼等。

結果發現,對這幾個層而言,除了數學領域(DM Mathematics)數據集的專家選擇略有不同外,其余數據集的專家分布都非常類似,并沒有體現出領域間有什么差別。

圖片

圖片

而在數學問題上出現不同表現的原因,可能是由于其具有相對特殊的語法結構,進一步的探究也證實了這一想法。

他們發現,專家選擇會被句子的語法結構所影響,一些語法關鍵詞,比如英語中的“Question”或者代碼中的“self”,被分配到相同的專家的概率非常大。

圖片

圖片

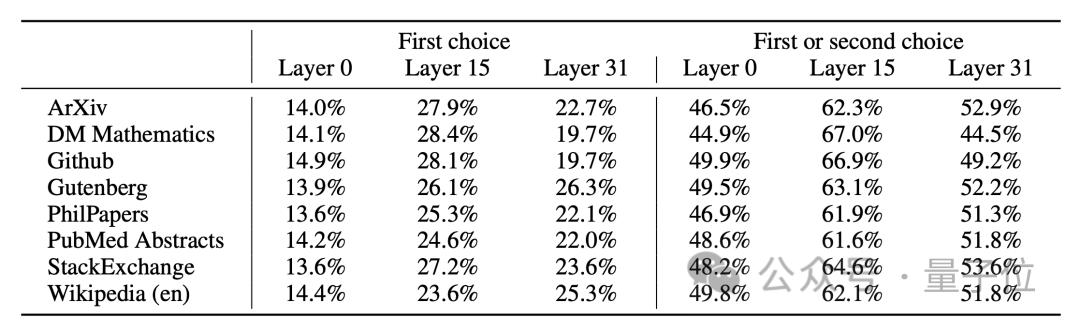

此外,定量的分析結果還發現了另一個專家分配規律——相鄰的token有很大概率被分配給同一專家。

作者比較了模型針對相鄰token選擇相同專家的概率,包括第一選擇一致率和第一二選擇一致率。

第一二選擇一致是指,模型針對兩個token分別做出的第一和第二選擇,只要存在交集即視為一致。

(比如第一個token的第一、二專家為分別為甲、乙,第二個token的第一、二專家分別為乙、丙,因為都包含了乙,就是一種第一二選擇一致的情況)

因Mixtral中有8個專家,因此在全隨機的選擇方式下,第一選擇一致率應為12.5%(1/8),第一二選擇一致率應為1 - (6/8) × (5/7),約為46%。

但實際測試發現,Mixtral第一和第一二選擇一致率高于隨機情況,特別是中間的第15層,說明了模型在專家選擇上是具有傾向性的。

圖片

圖片