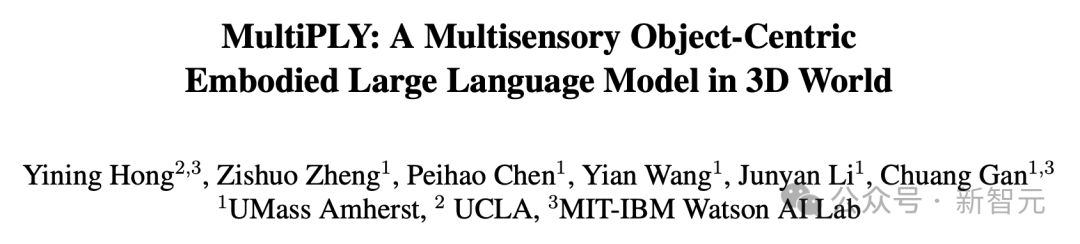

Agent觸摸漢堡辨冷熱,首次擁有類人感官!UCLA等發布3D多模態交互具身智能大模型

具身智能,是大模型未來應用的一個重要方向。

現在,大模型加持下的智能體,能夠參與3D環境,不僅有了聽覺視覺,還有了觸覺等多種感官能力。

臥室里有什么物體,一眼辨認。

聽到門鈴響了,LLM便會告訴你家里來客人了。

大模型加持的NPC,在觸摸桌子的香蕉后,發現沒熟并建議不要吃。

甚至,它還能感受到物體的溫度,餐桌上的漢堡已經涼了,會告訴你加熱后再吃。

除此之外,這些智能體借助LLM之力,還擅長使用工具、物體檢索、導航、任務分解等多種任務。

來自UMass Amherst、UCLA和MIT-IBM Watson AI Lab研究人員,推出了全新的具身智能大模型MultiPLY。

通過智能體與3D環境交互,MultiPLY呈現了大模型多感官能力,無縫地連接了語言、動作和感知!

論文地址:https://arxiv.org/abs/2401.08577

在推理過程中,MultiPLY能夠生成動作token,指示智能體在環境中采取行動,并獲得下一個多感官觀測值。

然后,通過狀態token將觀測結果反饋給LLM,以生成后續的文本或動作token。

在對象檢索、工具使用、多感官標注和任務分解的具體任務實驗中,MultiPLY的性能刷新SOTA。

多感官大模型

多模態大模型,如LLaVA、Flamingo、BLIP-2、PaLM-E,在視覺語言任務中表現出色。然而,它們主要關注2D場景理解,很難對3D環境進行推理和交互。

盡管目前也有關于3D場景理解的大模型研究,但這些LLM缺乏捕捉視覺和語言之外的多感官信息的能力。相比之下,人類通過觸摸甜甜圈,能夠感知其柔軟度和溫度,而這種能力遠遠超出了當前多模態LLM的范圍。

若想真正實現AI大佬口中的AGI,那么未來構建多感官的大模型也是必不可少。

但挑戰在于,當前缺少訓練LLM的多感官交互數據,另外還缺乏對3D場景和物體的多感官信息的正確表示。

通過將場景抽象為以「對象為中心」的表示,并在與對象進一步交互時關注對象細節,人類很輕易就能做到。

對于LLM來說,必須在以對象為中心的表示,以及詳細多感官信息之間靈活切換。

為此,研究人員提出了MultiPLY,一種多感官呈現的LLM,可以通過部署由LLM驅動的智能體與3D環境進行交互,從而對以對象為中心的多感官表示進行編碼,包括視覺、音頻、觸覺和溫度信息。

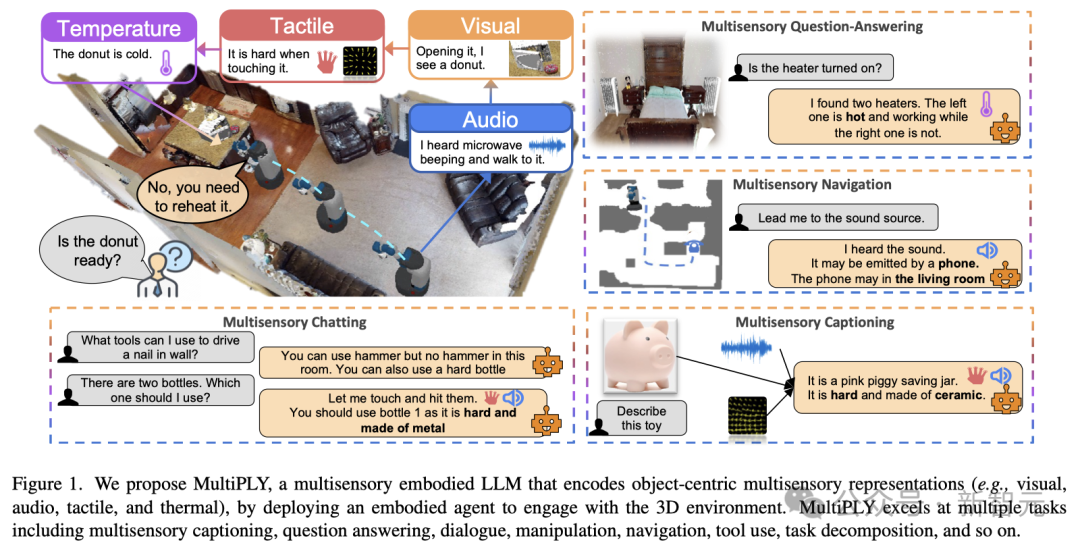

Multisensory-Universe數據集

為了訓練這種全新的模型,研究人員提出了一個大規模多感官數據集Multisensory-Universe,包含50萬條由AI智能體在3D虛擬環境中交互時收集的數據。

這些數據涵蓋了多種任務類型,包括多感官描述(multisensory captioning)、問答(question answering)、對話(dialogue)、操作(manipulation)、任務分解(task decomposition)等等。

向3D場景中添加互動對象

具體來說,團隊基于Habitat-Matterport 3D(HM3D)語義數據集對場景進行了構建。

HM3D數據集包含了216個三維空間及其內部的3,100個房間,但由于傳感器數據不足和種類單一的問題,這些對象無法在Habitatsim環境中進行互動。

為此,研究人員在場景中引入了新的對象,這樣智能體就可以利用Habitatsim與它們進行交互了。

主要來源有:

- ObjectFolder,包含了1000個對象模型,這些對象的撞擊聲效被儲存在隱式神經場中,并且還標注了對象的材質;

- Objaverse,是一個涵蓋了豐富類別的800,000個三維對象的集合。

具體來說,研究人員讓ChatGPT從ObjectFolder和Objaverse中選擇1到10個新對象,并為這些新加入的對象生成合適的邊界框。

期間,ChatGPT需要確定對象的材質類別(比如,陶瓷、塑料、鋼鐵)和特性(比如,可變形性、彈性、硬度),以及溫度標簽(比如,物體是熱的、冷的,還是和室溫一樣)。

除了HM3D中現有的對象及其邊界框外,研究人員給ChatGPT的提示還包括一些偏好,和少樣本示例:

- 挑選一些外觀相似的對象。比如,選兩個外形相似的瓶子,其中一個是塑料的,另一個是金屬的。這樣,就需要通過不同的傳感器收集信息來消除歧義。

- 挑選那些與環境匹配、并可以組合使用完成任務的對象。例如,在廚房環境中,可以選擇食材和烹飪工具。

多感官全景(Multisensory-Universe)生成管線

獲取新物體的傳感器數據

- 觸覺

對于觸覺數據的收集,研究人員采用了DiffTactile技術,它基于MLSMPM方法來模擬剛體、彈性和彈塑性的物體。

把物體的三維模型放入DiffTactile系統中,然后用一個裝有定位標記的抓手在事先設定好的位置觸碰這些物體。觸覺傳感器記錄下標記點的起始和結束位置,從而反映氣泡被壓縮的程度。

- 環境聲音

為了幫助導航或推理,每個物體都可以發出環境聲音,或者作為線索,讓AI智能體了解周圍環境中正在發生的事情。

引導ChatGPT根據AudioSet中的聲音樣本與新添加物體的語義標簽進行匹配。根據AudioSet提供的聲音描述,ChatGPT需要從候選物體列表中挑選出那些可能發出這種聲音的物體。

- 撞擊聲音

撞擊聲音是指敲擊或撞擊物體時所聽到的聲音,這對于識別物體的材料類型非常關鍵。

通過在ObjectFolder中查詢物體的隱式聲音場,再給定敲擊位置和施加的力,就可以獲撞擊聲音了。

- 溫度

針對每個物體的溫度標簽,需要讓ChatGPT給出它們各自合適的溫度。

智能體采集場景構建數據

研究人員通過大語言模型驅動的智能體,來收集場景構建中的所需數據。

首先,給ChatGPT設置任務,并讓它給出任務建議。接著,將一個能夠在3D環境中與物體進行互動的智能體放入其中,執行任務并收集交互數據。

- 生成任務建議

在給出需要執行的動作清單后,ChatGPT便會生成特定的任務,并產生一系列代表動作的詞語,以及基于物體實際反饋標簽推導出的語言推理結果。由于ChatGPT能夠訪問所有的材料和溫度標簽,因此它能在「觸摸」動作之后生成類似「感覺很冷」的句子。

- 互動數據的收集

智能體首先會隨機地探索環境,并收集初始的RGBD環境數據。在確定了動作之后,智能體就會去與環境中的物體進行互動,并獲取感官反饋。例如,當動作是「觸摸物體」時,智能體會反饋該物體的觸覺和溫度信息。

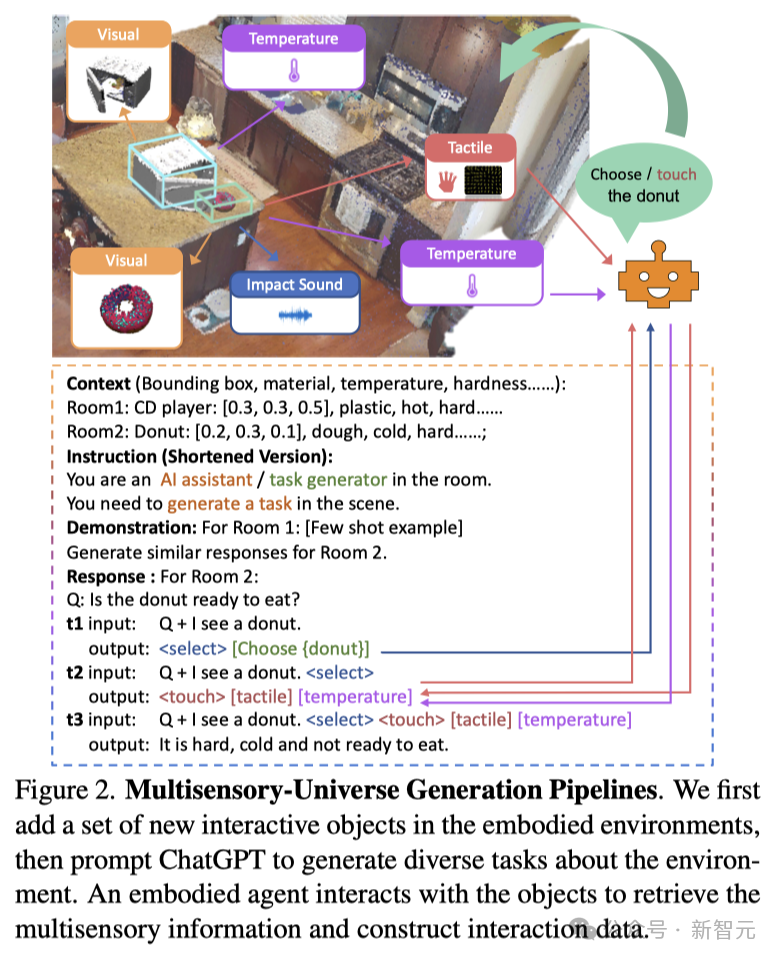

MultiPLY架構

接下來,便是進入MultiPLY大模型訓練階段了。

以對象為中心的場景表征

LLM首先將智能體探索的3D環境特征作為輸入,以便對場景有初步理解。

研究人員按照3D-LLM研究路線,利用2D特征來構建3D場景特征。這樣視覺特征就可以無縫地輸入到預訓練的視覺語言模型中,且無需適應。

然而,3D-LLM的點云編碼讓LLM很難一次處理數千個點。

當人類探索3D環境時,會將場景抽象表示,并粗略地形成對象及其位置的理解,無需記住所有細節。

同樣,研究團隊使用以對象為中心的抽象表示來表示3D場景。

通過概念圖和CLIP編碼器來編碼圖像中的物體,然后通過多視角關聯,將2D圖像編碼融合到3D空間中。

研究人員還將位置嵌入添加到物體的視覺特征中,最終得到 個特征作為抽象的以對象為中心的場景表示,其中

個特征作為抽象的以對象為中心的場景表示,其中 是對象的數量。

是對象的數量。

如果3D環境中的物體帶有環境聲音,研究人員會使用CLAP音頻編碼器對聲音進行編碼,并得到1024維的特征。

以對象為中心的場景表示和環境聲音表示作為LLM的初始輸入,由 <SCENE>、</SCENE> 和 <AMBIENT SOUND>、</AMBIENT SOUND> 等token括起來。

動作token

研究人員設計了一組動作token來表示智能體與環境的交互:

<SELECT> token選擇要與之交互的對象。通過語言特征(即<SELECT> token的LLM的最后隱藏狀態)和環境中對象的CLIP視覺特征之間的注意力來選擇對象。它會選擇有最大注意力分數的對象。

<NAVIGATE> token要求智能體導航到選定的對象。

<OBSERVE> token要求智能體仔細檢查所選對象并獲取對象詳細信息(以對象詳細點云的形式)。

<TOUCH> token允許智能體觸摸所選的物體,獲取觸覺和溫度信息。

<HIT> token允許智能體擊中所選物體,得到撞擊聲音。

<PICK-UP>和<PUT-DOWN> token讓智能體能夠拾取或放下選定的對象。

<LOOK-AROUND> token讓智能體轉頭并獲取附近的物體。

狀態token

研究人員還設計了另一種token,將交互結果反饋給LLM:

<OBJECT>:當AI智能體<OBSERVE>到一個物體時,它會記錄物體的點信息。得到從2D CLIP特征聚合而來的3D特征后,再加入位置信息來進行增強。隨后創建了一個由N個點組成的點云,每個點都有1024維的特征數據,其中N是點的總數。

<IMPACT SOUND>:當AI智能體<HIT>一個物體時,它會記錄產生的撞擊聲。利用CLAP音頻編碼器處理這些聲音,即可得到一個1024維的撞擊聲音數據。然后使用一個聲音映射器(即一個處理層)將聲音數據轉換成LLM可以處理的格式。

<TACTILE>:當一個物體被AI智能體<TOUCH>時,它會記錄下觸覺信息。先將觸覺感應轉化為熱圖,并使用CLIP來處理。通過對這些熱圖區塊進行平均值處理,就得到了一個1024維的溫度特征數據。然后使用一個觸覺映射器(即一個處理層)來將這些數據轉換成大語言模型的特征格式。

<TEMPERATURE> :在記錄溫度時,會先將溫度數據轉化為熱圖,并使用CLIP來處理。通過對熱圖區塊進行平均值處理,就獲得了一個1024維的溫度特征數據。然后再使用一個溫度映射器(即一個處理層)來將這些數據轉換成大語言模型的特征格式。

訓練與推理

模型架構

在此,研究人員使用了LLaVA作為多模態大模型骨干。

由于研究中的視覺特征已使用ConceptGraphs與LLaVA對齊到相同的嵌入空間,因此可以直接使用LLaVA的視覺到語言projector,而無需對視覺語言數據進行預訓練。

對于其他傳感器模式,研究人員利用輕量級適配器,它是單線層projector,將傳感器特征映射到LLaVA的文本token嵌入空間中。

模態對齊

如上所述,觸覺、聲音和溫度表示與語言特征不一致。

在第一階段,研究人員訓練傳感器到語言適配器以進行多感官特征對齊。對于音頻語言對齊,使用了AudioSet和AudioCaps。

對于撞擊聲、觸覺和熱數據,研究團隊使用ChatGPT生成一個句子標題,描述材料以及每種傳感器模態和語言之間的一致性。然后凍結圖像編碼器和LLM的權重,以加快收斂速度并保持語言推理能力。

使用Multisensory-Universe數據集進行指令微調

在第二階段,研究人員使用Multisensory-Universe數據集對LLaVA進行調優。

其中訓練損失由兩部分組成,第一個是LLM損失,與原始LLaVA模型相同。然后又添加了一項損失,迫使模型選擇正確的對象來關注。

具體來說,研究人員計算SELECT token的LLM最后一個隱藏狀態,與每個抽象對象特征之間的注意力。

該特征通過Sigmoid層,并通過二元交叉熵(BCE)損失進行優化。在這一階段的訓練中,解凍整個模型。

研究人員在128個V100 GPU上使用FSDP進行了高效訓練。

推理

在推理時,MultiPLY首先將任務提示和抽象場景表示作為輸入,并生成后續token。一旦生成了動作token,就會指示智能體采取Habitat-sim中的動作并與環境交互。

智能體的觀察結果通過狀態token作為輸入反饋給LLM。LLM進一步根據當前狀態輸入生成下一個token。

實驗結果

微調模型在多感官數據集上進行訓練之后,研究人員在模擬環境中對其進行了測試。

在這些測試中,AI智能體能夠根據MultiPLY生成的動作Token與模擬環境進行互動。

接著,LLM將等待智能體完成動作,并通過狀態Token接收智能體的觀察結果,以此來生成下一個Token。

具體來說,研究人員設計了4種實驗場景:對象檢索、工具使用、多感官標注和任務分解,并為每個場景提供了詳細的任務說明、基準測試和分析。

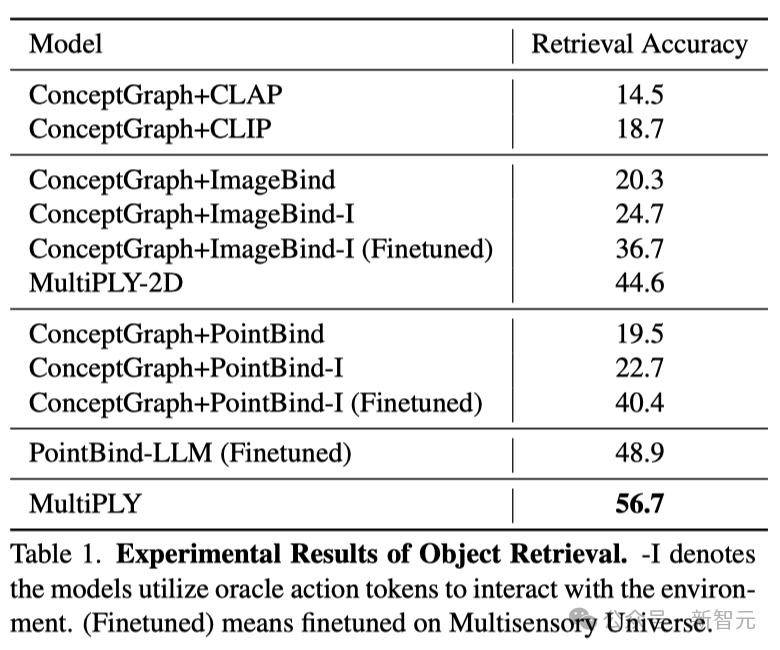

對象檢索

在對象檢索的實驗中,研究人員得出了幾個有趣的結論。

首先,能夠處理多種感官信息的模型,遠遠優于只能處理單一信息類型的模型。

CLIP和CLAP,以及那些依賴初始視覺特征的模型,在物品檢索任務中的表現很差。這更加凸顯了結合多種感官信息的模型,相較于僅依賴2D圖像模型的重要性。

這主要是因為,單一視角的圖片有時候無法提供充分的信息來識別物體,尤其是當視角不一致或者物體被遮擋時。

其次,LLM在性能上超越了基于相似度檢索的模型。這可能是因為后者將多感官的信息簡單地融合在一起,而沒有區分各種感官信息。

總體而言,MultiPLY在很多方面都顯著優于基準模型。

可能是因為其它模型將所有信息都與視覺信息綁定,而忽視了一個視覺特征可能與來自其他感官的多個特征相關聯的事實。

而MultiPLY通過單獨與不同感官數據進行交互和推理,可以將不同感官特征相互聯系。

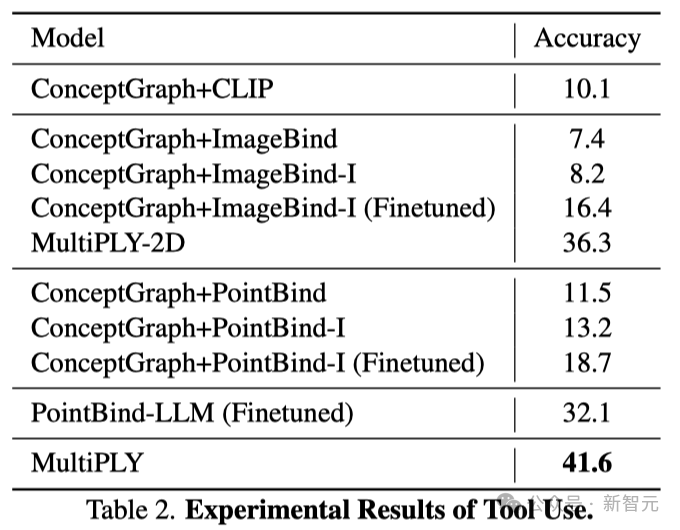

工具使用

在工具使用測試中,那些基于綁定(binding-based)的方法在工具使用這一任務上表現極差。

原因可能在于這些方法將物體的多種感官信息,作為不可分割的整體進行處理,導致它們無法從整體中區分出單獨的感官特征,比如物質材料。

因此,就 更別提去推斷這些特性是如何成為工具使用的依據,以及如何在多種感官信息融合后分析和理解物體的實際功能了。

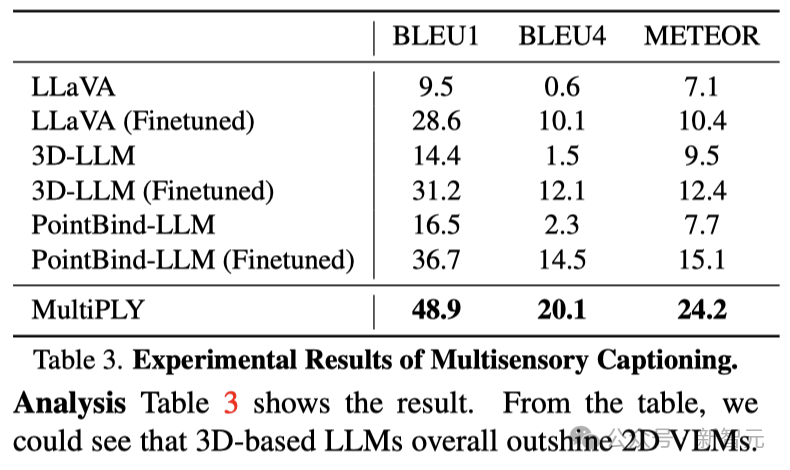

多感官標注

從下表可以明顯看出,整體而言,基于3D的大模型的性能,超越了基于2D VLM。

LLaVA和3D-LLM采用了全面的數據表示作為輸入,這導致它們無法與那些可以靈活切換不同數據表示、進行互動的模型相匹敵。

MultiPLY的表現比Pointbind-LLM更加出色,這很可能是因為PointBind把不同感官模態的數據表示綁定在一起,這樣做難以區分和解析各個感官信息。

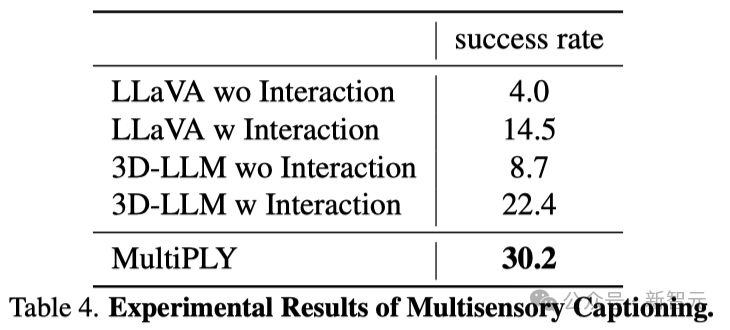

任務分解

在任務分解上,那些缺乏交互功能的模型表現極差,這很可能是由于VLM極易出現錯誤的幻覺。

例如,即使場景中并無面包,模型也可能錯誤地生成「找到一塊面包」的指令。

MultiPLY在性能上大幅領先于基線模型,是因為MultiPLY綜合考慮了多種感官信息,而其他模型僅僅依賴視覺信息。

另一個原因可能在于,基線模型僅以整個場景作為輸入,無法精確地關注到場景中的具體細節。

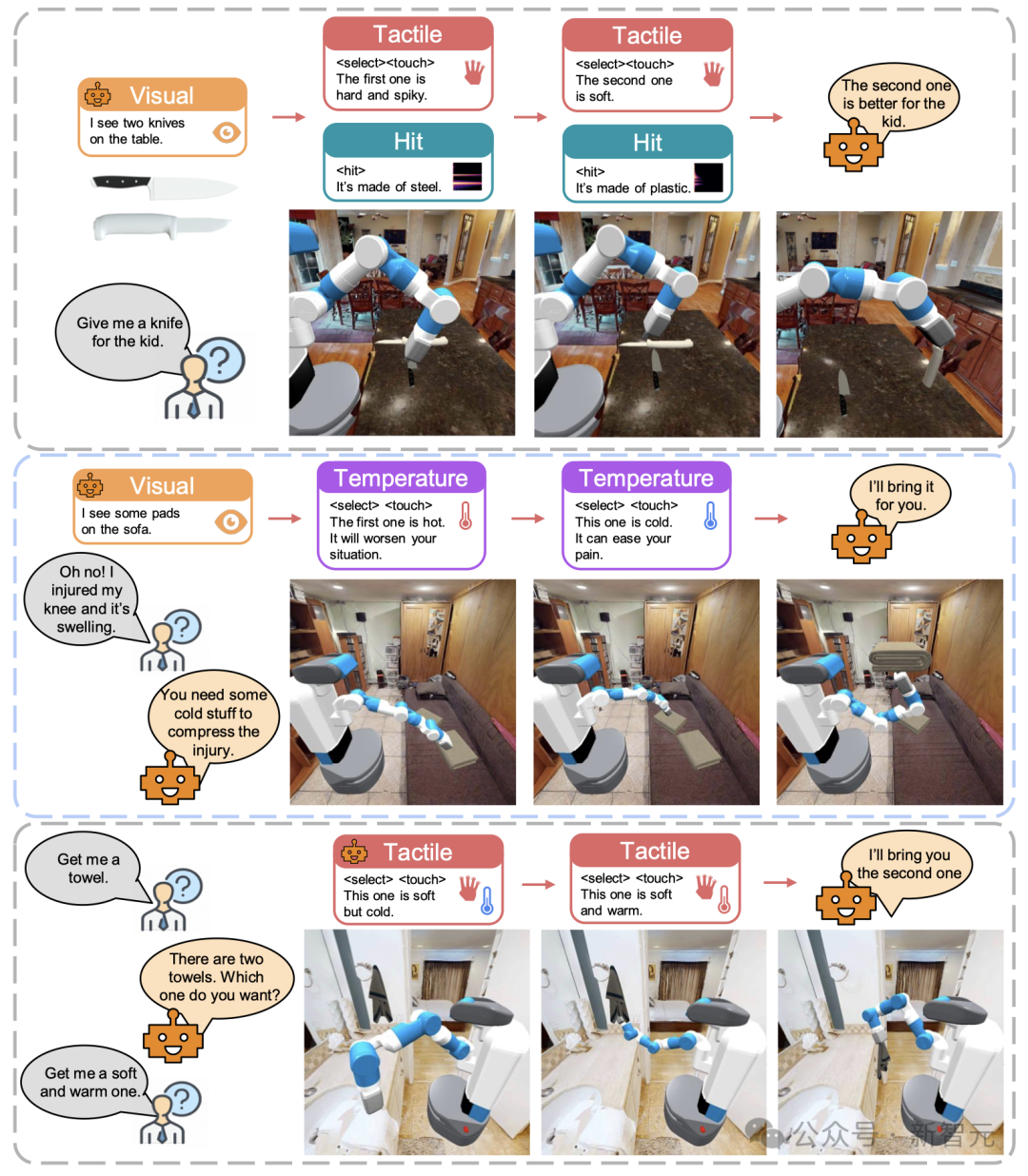

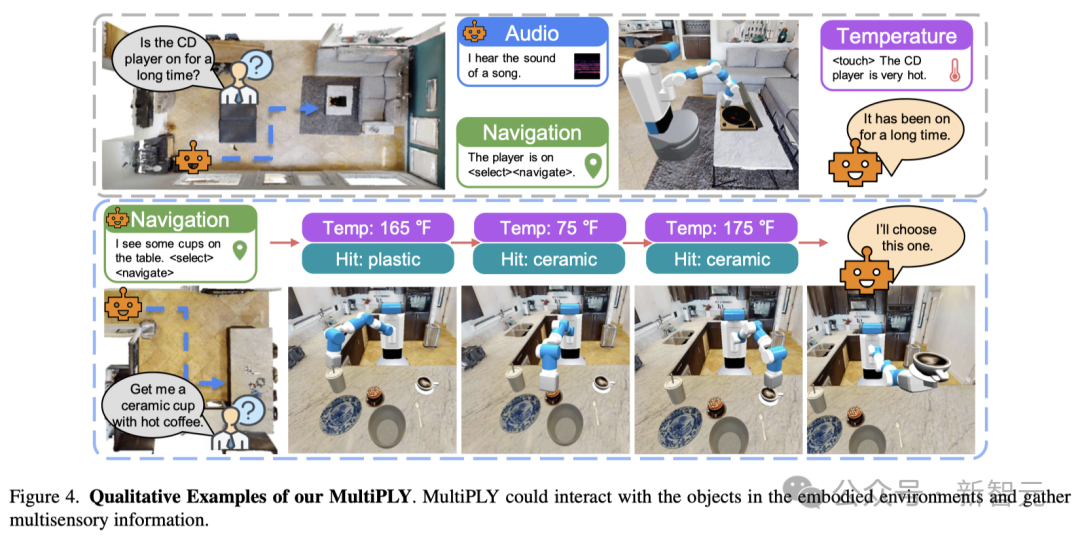

定性實驗

下圖直觀展現了MultiPLY在具體環境中與物體互動并獲取多種感官信息的強大能力。

作者介紹

Yining Hong是加州大學洛杉磯分校計算機科學專業的博士生,導師是MIT-IBM Watson AI Lab的淦創教授,以及UCLA的Song-Chun Zhu教授和Ying Nian Wu教授。

在此之前,她在上海交通大學獲得了學士學位。

她的研究致力于開發能夠主動探索并與三維物理世界進行互動,同時還能在這樣的環境中進行常識性推理的通用具身智能體。

其所需關鍵要素包括:

- 構建三維世界的模型;

- 發展大規模具身基礎模型;

- 實現視覺常識推理。