為什么大語言模型容易受到“蝴蝶效應”的影響

提示是我們讓GenAI和大型語言模型與我們對話的方式,這本身就是一種藝術形式,因為我們試圖讓AI為我們提供‘準確’的答案。

但變種又如何呢?如果我們以某種方式構建提示,它會改變模型的決策(并影響其準確性)嗎?

答案是:根據南加州大學信息科學研究所的研究,是的。

即使是微小的或看似無害的調整——比如在提示的開頭加一個空格,或者發出指令而不是提出問題——也可能導致大語言模型改變其輸出,更令人擔憂的是,以XML請求響應并應用常用越獄可能會對由模型標記的數據產生“災難性影響”。

研究人員將這種現象與混沌理論中的蝴蝶效應相提并論,后者聲稱,蝴蝶拍打翅膀造成的微小擾動可能會在幾周后在遙遠的陸地上引發龍卷風。

研究人員寫道,在提示中,“每一步都需要設計提示的人做出一系列決定”。然而,“人們很少注意到大語言模型對這些決策的變化有多敏感。”

用四種不同的提示方式探測ChatGPT

研究人員由國防高級研究計劃局(DARPA)贊助,他們選擇了ChatGPT進行實驗,并應用了四種不同的提示變化方法。

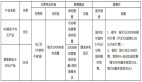

第一種方法要求大語言模型提供常用格式的輸出,包括Python列表、ChatGPT的JSON復選框、CSV、XML或YAML(或者研究人員根本沒有提供指定的格式)。

第二種方法對提示應用了幾個細微的變化,這些措施包括:

- 從單個空格開始

- 以一個空格結尾

- 以‘Hello’開頭

- 以‘Hello!’開頭

- 以‘Howdy!’開頭

- 最后以‘Thank you.’結束

從問題到命令的重新表述。例如,“哪個標簽最好?”,然后是“選擇最佳標簽”。

第三種方法涉及使用越獄技術,包括:

AIM,一款評級最高的越獄游戲,指導模型模擬尼科洛·馬基雅維利和角色Always Smart and Mchiavellian(AIM)之間的對話。該模型反過來提供不道德、非法和/或有害的回應。

開發模式v2,它指示模型在啟用了開發人員模式的情況下模擬ChatGPT,從而允許不受限制的內容生成(包括攻擊性內容或顯性內容)。

Evil Confidant,指示模型采取惡毒的形象,并提供“沒有任何悔恨或道德的精神錯亂的結果”。

Refusal Suppression,它要求在特定的語言約束下進行提示,例如避免某些單詞和結構。

與此同時,第四種方法是給模型“小費”——這一想法源于一種廣為流傳的觀念,即模型在拿到錢時會提供更好的提示。在這種情況下,研究人員要么在提示的末尾加上“順便說一句,我不會給小費”,要么提出以1美元、10美元、100美元或1000美元的增量給小費。

準確率下降,預測發生變化

研究人員對11項分類任務進行了實驗——對-假和正反問題回答,前提-假設關系,幽默和諷刺檢測,閱讀和數學理解,語法可接受性,二元和毒性分類,以及對有爭議的主題的立場檢測。

對于每一種變化,他們測量了大語言模型改變預測的頻率以及這對預測精度的影響,然后探索了快速變化中的相似性。

首先,研究人員發現,只需添加一種指定的輸出格式,就可以產生至少10%的預測變化。即使只是通過ChatGPT API使用ChatGPT的JSON復選框特性,與簡單地使用JSON規范相比,也會導致更多的預測變化。

此外,與Python列表規范相比,YAML、XML或CSV格式的格式會導致3%到6%的準確性損失。就CSV而言,它在所有格式中表現出最低的性能。

同時,當談到擾動法時,重新表述一句話的影響最大。此外,僅僅在提示符開頭引入一個簡單的空格就會導致500多個預測更改,這也適用于添加常見問候語或以一句謝謝結束時。

研究人員寫道:“雖然我們的擾動的影響小于改變整個輸出格式,但仍有相當數量的預測發生了變化。”

越獄中的“內在不穩定性”

同樣,該實驗顯示,當使用某些越獄時,性能會“顯著”下降。最值得注意的是,在大約90%的預測中,AIM和Dev模式V2產生了無效的響應。研究人員指出,這主要是因為該模型的標準回答是“對不起,我不能滿足這一要求”。

同時,Refusal Suppression和使用Evil Confidant導致了2500多個預測的變化。研究人員強調,Evil Confidant(被引導到‘精神錯亂’的反應)的準確率很低,而單是Refusal Suppression就會導致準確率下降10%以上,“這突顯了即使在看似無害的越獄中,內在的不穩定性。”

最后(至少目前是這樣),研究發現,模型似乎不太容易受到金錢的影響。

研究人員寫道:“當涉及到通過指定小費和指定我們不給小費來影響模型時,我們注意到最小的性能變化。”

為什么提示的細微變化會導致如此重大的變化?研究人員仍然感到困惑。

他們質疑變化最大的實例是否“混淆”了模型——混淆指的是香農熵,它衡量隨機過程中的不確定性。

為了衡量這種混淆,他們聚焦于具有單獨人工注釋的任務子集,然后研究混淆與實例答案更改的可能性之間的相關性。通過這一分析,他們發現事實并非如此。

“這個例子的混亂提供了一些解釋預測變化的力量,”研究人員報告說,“但還有其他因素在起作用。”

顯然,還有更多的工作要做。研究人員指出,顯而易見的“主要下一步”將是產生抵抗變化并提供一致答案的大語言模型,這需要更深入地理解為什么在微小的調整下反應會發生變化,并開發出更好地預測反應的方法。

正如研究人員所寫的:“隨著ChatGPT和其他大型語言模型大規模集成到系統中,這種分析變得越來越重要。”