Kubernetes 的「蝴蝶效應」:一個小改動如何引發連鎖災難?

引言

對于這種案例,你們的處理思路是怎么樣的呢,是否真正的處理過,如果遇到,你們應該怎么處理。

我想大多數人都沒有遇到過。

一、背景與問題概述

某企業在生產環境中執行 kubectl apply -f . 后,整個 prod 命名空間及其下所有資源(Deployments、Services、ConfigMaps 等)被意外刪除,導致業務中斷超過 30 分鐘。本文將深度剖析事故的技術原理、完整復現過程、恢復方案,并提供系統性預防策略。

1. 災難現象:從操作到崩潰的完整鏈條

1.1 操作流程

1. 操作意圖:開發人員試圖將本地測試通過的配置同步到生產環境。

2. 執行命令:kubectl apply -f . (應用當前目錄所有 YAML 文件)。

3. 預期結果:更新 prod 命名空間中的部分資源(如 Deployment 鏡像版本)。

1.2 實際后果

? 直接損失:prod 命名空間被刪除,導致其下所有資源級聯刪除。

? 業務影響:

服務不可用:所有 Pod 被終止,入口流量返回 5xx 錯誤。

數據風險:部分有狀態服務(如未配置持久卷的數據庫)數據丟失。

恢復耗時:手動重建資源耗時 30 分鐘以上。

1.3 事故證據

# 查看集群事件記錄(按時間排序)

kubectl get events --field-selector involvedObject.kind=Namespace --sort-by=.metadata.creationTimestamp

# 關鍵輸出

LAST SEEN TYPE REASON OBJECT MESSAGE

5s Normal Deleting Namespace/prod Namespace prod deleted二、根因分析:從代碼提交到集群行為的完整鏈條

2.1 直接原因

1. 本地配置污染:

# deployment.yaml(錯誤版本)

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

namespace: prod # 錯誤:本應屬于 test 命名空間? 開發者在本地測試時修改了某個 Deployment 的 metadata.namespace,從 test 改為 prod,但未在提交前還原。

2. Namespace 配置文件殘留:

# namespace.yaml(歷史版本,已被刪除)

apiVersion: v1

kind: Namespace

metadata:

name: prod? 代碼倉庫中存在 namespace.yaml 定義 prod 命名空間,但該文件在后續提交中被意外刪除或修改。

2.2 根本原因:Kubectl Apply 的三向合并機制

? 聲明式 API 的核心邏輯:kubectl apply 要求集群狀態與配置文件完全一致,差異部分將被自動修正。

? 三向合并(3-Way Strategic Merge Patch):

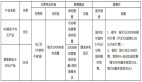

| 來源 | 內容 |

|---------------------|----------------------------------------------------------------------|

| 本地配置文件 (A) | 當前目錄中所有 YAML 定義的資源(包括缺失的 Namespace) |

| 集群當前狀態 (B) | 已存在的 prod 命名空間及其下資源 |

| 上次應用記錄 (C) | 通過注解 kubectl.kubernetes.io/last-applied-configuration 記錄的歷史配置 |- ? 合并結果:由于本地配置中缺少 Namespace/prod 的定義,kubectl apply 認為該資源應從集群中刪除。

2.3 級聯刪除的致命性

? Kubernetes 的級聯刪除策略:

刪除 Namespace 會觸發其下所有資源的刪除(類似于 kubectl delete namespace prod --cascade=background)。

無確認機制:默認無二次確認,操作立即生效。

三、技術復現:從代碼提交到集群崩潰的完整模擬

3.1 環境準備

# 創建初始命名空間和資源

kubectl create ns prod

kubectl apply -f deployment.yaml -n prod # 初始 Deployment 在 prod 中

# 初始 namespace.yaml 內容

cat <<EOF > namespace.yaml

apiVersion: v1

kind: Namespace

metadata:

name: prod

EOF3.2 錯誤操作復現

1. 開發者修改 Deployment 的 Namespace:

# deployment.yaml(被污染版本)

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

namespace: prod # 錯誤:此文件本應屬于 test 環境2. 刪除 Namespace 配置文件:

rm namespace.yaml # 或修改其 metadata.name3. 執行災難性命令:

kubectl apply -f . # 應用當前目錄(缺失 namespace.yaml)4. 結果驗證:

kubectl get ns prod # Error: namespaces "prod" not found四、恢復方案:從應急響應到徹底修復

4.1 緊急恢復

1. 重建命名空間:

kubectl create ns prod2. 從版本控制恢復配置:

git checkout HEAD~1 # 回滾到正確提交

kubectl apply -f . --server-side # 避免與殘留注解沖突3. 數據恢復:

無狀態服務:重新部署即可。

有狀態服務:若未配置持久化存儲,需從備份恢復(如 Velero)。

4.2 根因修復

1. 配置隔離:

Kustomize 多環境管理:

├── base

│ ├── deployment.yaml

│ └── namespace.yaml

└── overlays

├── prod

│ └── kustomization.yaml # 添加 namespace: prod

└── test

└── kustomization.yaml # 添加 namespace: test? Helm Values 注入:

# values-prod.yaml

namespace: prod2. 防刪除鎖:

# namespace.yaml

apiVersion: v1

kind: Namespace

metadata:

name: prod

annotations:

kubectl.kubernetes.io/lifecycle: prevent-deletion # 阻止直接刪除五、防御體系:構建安全的 GitOps 流水線

5.1 代碼層防護

? 自動化檢查:

# .pre-commit-config.yaml

- repo: local

hooks:

- id: check-namespace

name: Check namespace in YAML

entry: grep -r "namespace: prod" . --include=*.yaml && exit 1 || exit 0

language: system預提交鉤子(Pre-commit Hook):禁止修改生產環境 Namespace。

? Schema 校驗:

kubeval -d . --ignore-missing-schemas? 使用 kubeval 或 datree 校驗 YAML 合法性。

5.2 集群層防護

1. RBAC 最小權限:

# 禁止刪除生產 Namespace

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: prod-editor

rules:

- apiGroups: [""]

resources: ["namespaces"]

verbs: ["get", "list", "watch"]

resourceNames: ["prod"] # 僅允許讀操作2. 準入控制(Admission Controller):

? Kyverno 策略示例:

apiVersion: kyverno.io/v1

kind: ClusterPolicy

metadata:

name: protect-prod-namespace

spec:

validationFailureAction: enforce

background: false

rules:

- name: block-prod-namespace-deletion

match:

any:

- resources:

kinds:

- Namespace

names:

- prod

validate:

message: "Deleting prod namespace is prohibited!"

deny:

conditions:

- key: "{{request.operation}}"

operator: Equals

value: "DELETE"5.3 流程層防護

1. GitOps 自動化:

? Argo CD 同步策略:

# Application 配置

spec:

syncPolicy:

automated:

selfHeal: true # 自動修復差異

prune: false # 禁止自動刪除資源(關鍵!)2. 變更預檢:

? CI 集成 kubectl diff:

kubectl diff -f . --kubeconfig=/dev/null 2> /dev/null | grep -E "^-.*namespace: prod"六、深度思考:為什么這類事故頻繁發生?

6.1 認知誤區

? 誤解一:“kubectl apply 只是更新資源,不會刪除資源。”現實:若本地配置與集群狀態存在差異,apply 會強制執行刪除操作。

? 誤解二:“Namespace 是安全邊界,刪除需要顯式操作。”現實:Namespace 的刪除可能由配置文件缺失間接觸發。

6.2 文化缺失

? 責任模糊:開發者、審查者、運維人員均未對 Namespace 配置負責。

? 測試不足:缺乏預生產環境驗證 Namespace 變更。

七、終極防御清單

防御層級 | 具體措施 |

代碼層 | Kustomize/Helm 多環境隔離、預提交鉤子校驗 Namespace |

集群層 | RBAC 限制刪除權限、Kyverno 攔截刪除操作、Namespace 防刪除注解 |

流程層 | GitOps 自動化同步(Argo CD)、CI 集成 |

監控層 | 實時審計日志告警、Namespace 刪除事件觸發 Webhook 通知 |

災備層 | Velero 定期備份、多集群容災 |

八、 總結:云原生時代的生存法則

? 每一次 kubectl apply 都是對生產環境的直接操作,必須通過工具鏈將其轉化為受控的“手術流程”。

? 防御的核心不是信任,而是驗證:通過自動化檢查、權限控制和災備方案,將人為失誤的影響降至最低。

? 技術債務必須償還:忽略的 Namespace 管理、松散的 CI/CD 流程,終將以事故的形式要求連本帶利償還。