大模型推理成本排行榜來了:賈揚清公司效率領跑

「大模型的 API 是個虧本買賣嗎?」

隨著大語言模型技術的逐漸實用化,越來越多的科技公司提出了大模型 API 供開發者們使用。但前有 OpenAI「每天燒掉 70 萬美元」,我們也有理由懷疑以大模型為基礎的業務到底能不能持續。

本周四,AI 創業公司 Martian 為我們仔細盤算了一下。

排行榜鏈接:https://leaderboard.withmartian.com/

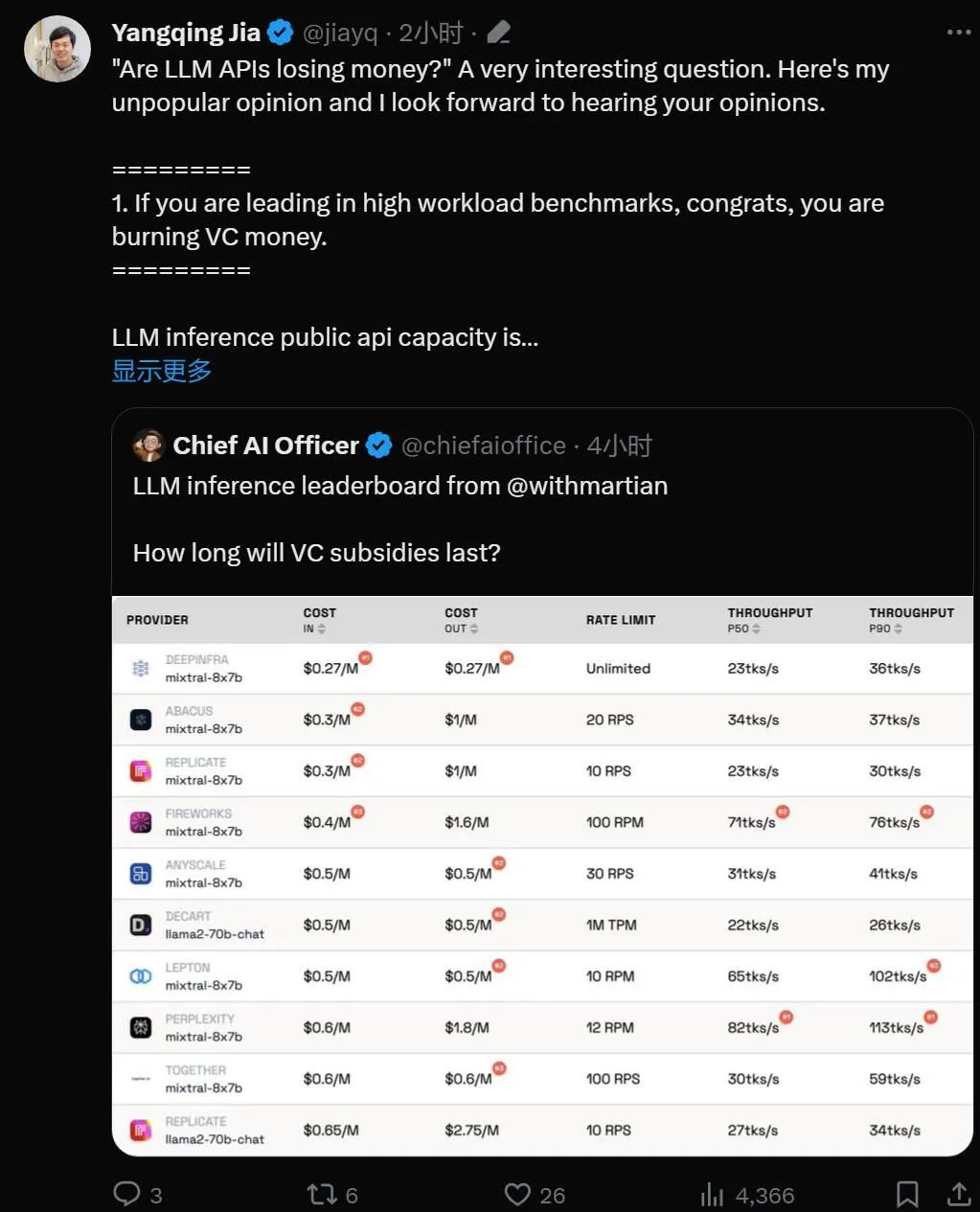

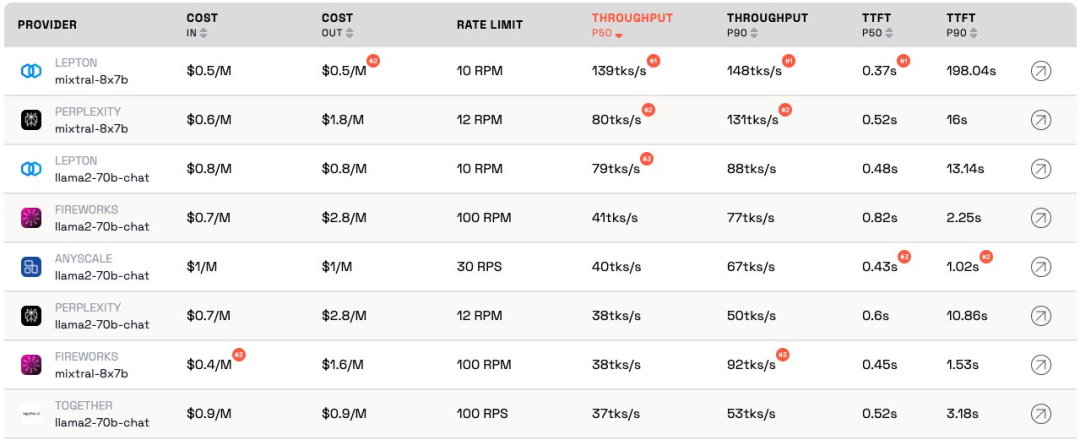

The LLM Inference Provider Leaderboard 是一個開源的大模型 API 推理產品排行榜。對于每個供應商的 Mixtral-8x7B 和 Llama-2-70B-Chat 公共端點,該榜單對成本、速率限制、吞吐量和 TTFT 的 P50 和 P90 進行了基準測試。

雖然互為競爭關系,但 Martian 發現各家公司提供的大模型服務之間存在大于 5 倍的成本差異,大于 6 倍的吞吐量,甚至還存在更大的速率限制差異。雖然在不同性能的大模型之間進行選擇只是業務開展的一部分,但選擇不同的 API 對于獲得最佳性能顯然至關重要。

在目前的榜單上可見,Anyscale 提供的服務對于 Llama-2-70B 的中等服務負載具有最佳的吞吐量。Together AI 對于 Llama-2-70B 和 Mixtral-8x7B 的大型服務負載具有最佳的 P50 和 P90 吞吐量。

此外,賈揚清的 LeptonAI 在短輸入 + 長輸出提示的小服務負載上能夠提供最佳的吞吐量。130 tks/s 的 P50 是所有廠商提供的所有模型產品中可以觀察到的最快吞吐量。

知名 AI 學者、Lepton AI 創始人賈揚清在排行榜放出后第一時間進行了點評,讓我們看看他是如何說的。

賈揚清首先闡述了人工智能領域行業現狀,然后肯定了基準測試的意義,最后指出 LeptonAI 將幫用戶找到最好的 AI 基礎策略。

1. 大模型 API 正在「燒錢」

如果模型在高工作負載基準測試中處于領先地位,那么恭喜,它正在「燒錢」。

LLM 推理公共 API 的容量就像是經營一家餐館:有廚師,需要估算客流量。聘請廚師是要花錢的。延遲和吞吐量可以理解為「你為顧客做飯的速度有多快」。對于一個合理的生意,你需要有「合理」數量的廚師。換句話說,你希望擁有能夠承載正常流量的容量,而不是在幾秒鐘內突然爆發的流量。流量激增意味著需要等待;反之,「廚師」則會無所事事。

在人工智能世界中,GPU 扮演著「廚師」的角色。基準負載是突發的。在低工作負載下,基準負載會混合到正常的流量中,并且測量結果可以準確表示服務在當前工作負載下的情況。

高服務負載場景則很有趣,因為會帶來中斷。基準測試每天 / 每周僅運行幾次,因此不是人們應該期望的常規流量。想象一下,讓 100 個人涌入當地的餐館來檢查廚師做菜的速度,結果會很不錯。借用量子物理學的術語,這被稱為「觀察者效應」。干擾越強(即突發負載越大),其精度就越低。換句話說:如果您給某個服務突然提供高負載,并發現該服務響應速度非常快,那么您就知道該服務有相當多的閑置容量。作為投資者,看到這種情況,你應該質問:這種燒錢的方式負責任嗎?

2. 模型最終會達到相似的表現

人工智能領域很喜歡競爭比賽,這的確很有趣。大家都會很快收斂到相同的解決方案,并且,由于 GPU 的原因,英偉達總是最終的贏家。這要歸功于偉大的開源項目,vLLM 就是一個很好的例子。這意味著,作為提供商,如果您的模型性能比其他模型差很多,您可以通過查看開源解決方案并應用良好的工程來輕松趕上。

3.「作為客戶,我不關心提供商的成本」

對于人工智能應用程序構建者來說,我們很幸運:總是有 API 提供商愿意「燒錢」。AI 行業正在燒錢來獲得流量,下一步才是擔心利潤。

基準測試是一項乏味且容易出錯的工作。無論好壞,通常都會發生成功者贊揚你而失敗者指責你的情況。上一輪卷積神經網絡基準測試就是如此。這不是一件容易的事,但基準測試將幫助我們在人工智能基礎設施方面獲得下一個 10 倍的收益。

基于人工智能框架和云基礎設施,LeptonAI 將幫用戶找到最好的 AI 基礎策略。