登Nature子刊,滑鐵盧大學團隊評論「量子計算機+大語言模型」當下與未來

模擬當今量子計算設備的一個關鍵挑戰,是學習和編碼量子比特之間發生的復雜關聯的能力。基于機器學習語言模型的新興技術已經顯示出學習量子態的獨特能力。

近日,加拿大滑鐵盧大學的研究人員在《Nature Computational Science》發表題為《Language models for quantum simulation》 的 Perspective 文章,強調了語言模型在構建量子計算機方面所做出的貢獻,并討論了它們在量子優勢競爭中的未來角色。

論文鏈接:https://www.nature.com/articles/s43588-023-00578-0

量子計算機已經開始成熟,最近許多設備都聲稱具有量子優勢。經典計算能力的持續發展,例如機器學習技術的快速崛起,引發了許多圍繞量子和經典策略之間相互作用的令人興奮的場景。隨著機器學習繼續與量子計算堆棧快速集成,提出了一個問題:它是否可以在未來以強大的方式改變量子技術?

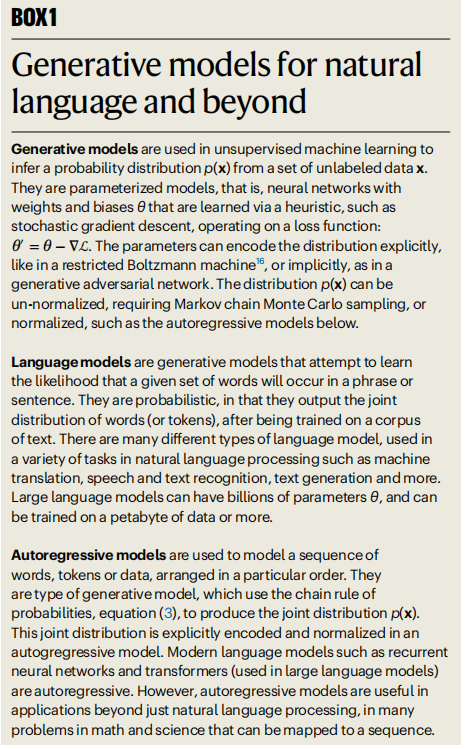

當今量子計算機提出的一個關鍵挑戰是量子態的學習。近年來迅速進入該領域的生成模型給出了學習量子態的兩種廣泛策略。

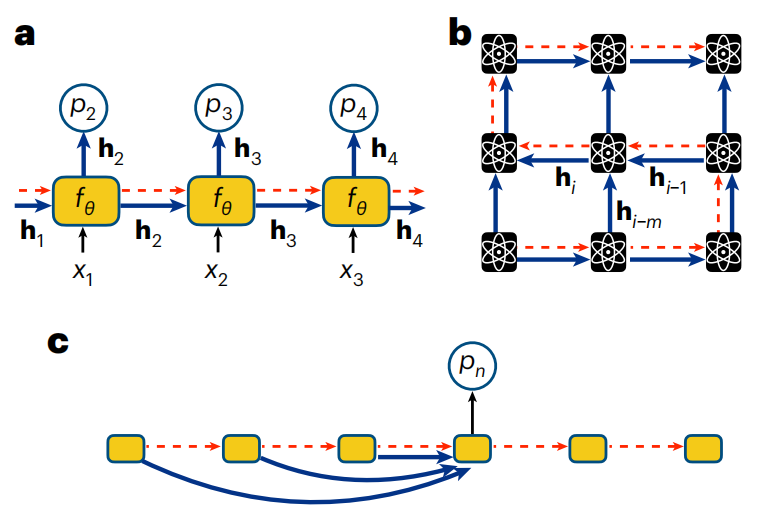

圖示:自然語言及其他領域的生成模型。(來源:論文)

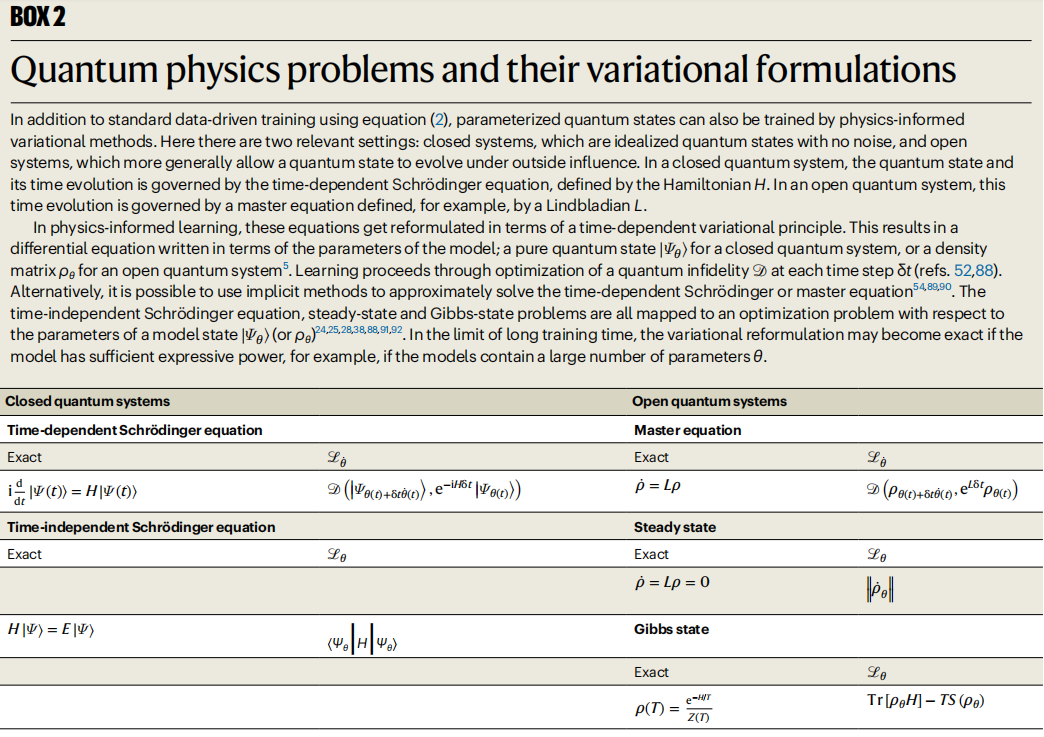

首先,通過代表量子計算機測量輸出的數據集,數據驅動的學習通過傳統的最大似然方法進行。其次,量子態可以通過所謂的物理學方法來解決,該方法利用量子比特之間相互作用的知識來定義替代損失函數。

無論哪種情況,量子態空間(希爾伯特空間)的大小都會隨著量子比特數量 N 呈指數增長,這是典型的維數災難。這對于擴展模型中表示量子態所需的參數數量以及尋找最佳參數值的計算效率提出了嚴峻的挑戰。基于人工神經網絡的生成模型非常適合應對這一挑戰。

語言模型是一種特別有前途的生成模型,它已成為解決高復雜性語言問題的強大架構。由于其可擴展性,也適用于量子計算中的問題。如今,隨著工業語言模型進入數萬億個參數的范圍,人們很自然地想知道類似的大型模型在物理學中可以實現什么,無論是在擴展量子計算等應用中,還是在量子物質、材料和設備的基礎理論理解中。

圖示:量子物理問題及其變分公式。(來源:論文)

量子計算的自回歸模型

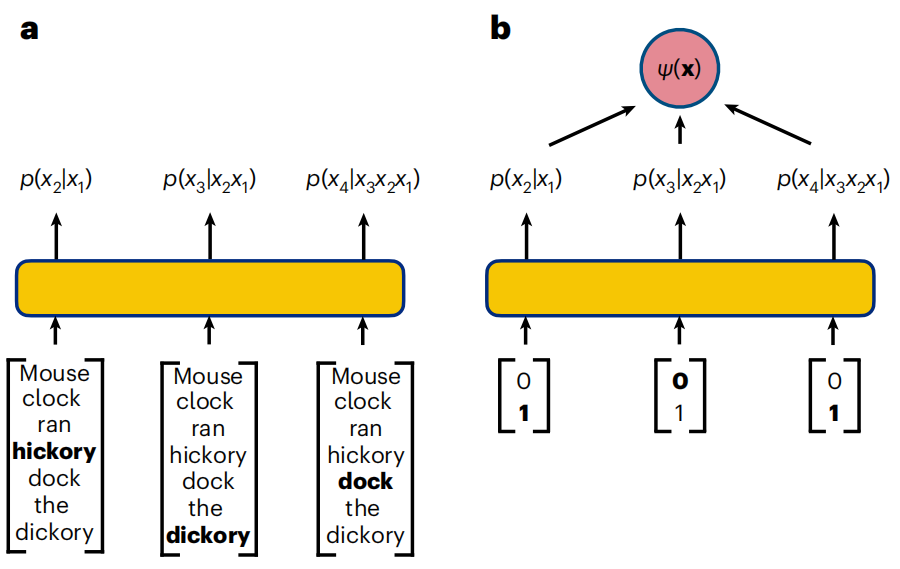

語言模型是旨在從自然語言數據推斷概率分布的生成模型。

生成模型的任務是學習語料庫中出現的單詞之間的概率關系,允許每次生成一個標記的新短語。主要困難在于對單詞之間所有復雜的依賴關系進行建模。

類似的挑戰也適用于量子計算機,其中糾纏等非局部相關性會導致量子比特之間高度不平凡的依賴性。因此,一個有趣的問題是,工業界開發的強大自回歸架構是否也可以應用于解決強相關量子系統中的問題。

圖示:文本和量子比特序列的自回歸策略。(來源:論文)

RNN 波函數

RNN 是任何包含循環連接的神經網絡,因此 RNN 單元的輸出取決于先前的輸出。自 2018 年以來,RNN 的使用迅速擴大,涵蓋了理解量子系統中各種最具挑戰性的任務。

RNN 適合這些任務的一個關鍵優勢是它們能夠學習和編碼量子比特之間高度重要的相關性,包括本質上非局域的量子糾纏。

圖示:用于量子比特序列的 RNN。(來源:論文)

物理學家已將 RNN 用于與量子計算相關的各種創新用途。RNN 已用于根據量子比特測量重建量子態的任務。RNN 還可以用于模擬量子系統的動態特性,這被認為是量子計算最有前途的應用之一,因此也是定義量子優勢的一項關鍵任務。RNN 已被用作構建神經糾錯解碼器的策略,這是容錯量子計算機開發的關鍵要素。此外,RNN 能夠利用數據驅動和物理啟發的優化,從而在量子模擬中實現越來越多的創新用途。

物理學家社區繼續積極開發 RNN,希望利用它們來完成量子優勢時代遇到的日益復雜的計算任務。RNN 在許多量子任務中與張量網絡的計算競爭力,加上它們利用量子比特測量數據的價值的天然能力,表明 RNN 將繼續在未來模擬量子計算機的復雜任務中發揮重要作用。

Transformer 量子態

多年來,雖然 RNN 在自然語言任務中取得了巨大成功,但最近它們在工業中因 Transformer 的自注意力機制而黯然失色,而 Transformer 是當今大型語言模型 (LLM) 編碼器-解碼器架構的關鍵組成部分。

縮放(scaling ) Transformer 的成功,以及它們在語言任務中所展示的非平凡涌現現象所引發的重要問題,一直吸引著物理學家,對他們來說,實現縮放是量子計算研究的主要目標。

從本質上講,Transformer 就是簡單的自回歸模型。然而,與 RNN 不同的是,RNN 是通過隱藏向量進行相關性的隱式編碼,Transformer 模型輸出的條件分布明確依賴于序列中有關自回歸特性的所有其他變量。這是通過因果屏蔽的自注意力機制來完成的。

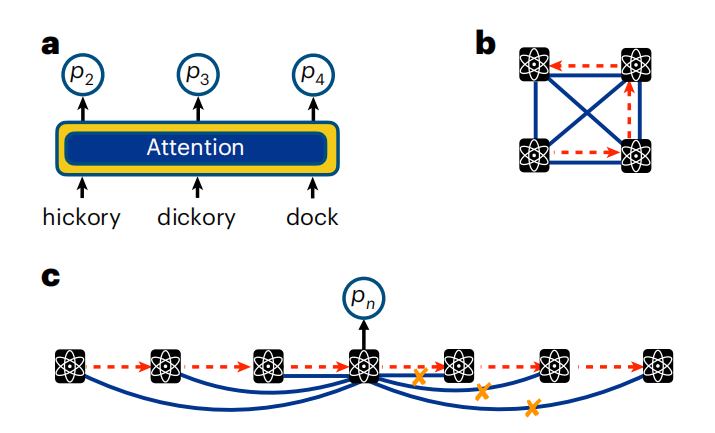

圖示:注意文本和量子比特序列。(來源:論文)

與語言數據一樣,在量子系統中,注意力是通過獲取量子比特測量值并通過一系列參數化函數進行轉換來計算的。通過訓練一堆這樣的參數化函數,Transformer 可以學習量子比特之間的依賴關系。有了注意力機制,就不需要將傳遞隱藏狀態的幾何結構(就像在 RNN 中一樣)與量子比特的物理排列相關聯。

通過利用這種架構,可以訓練具有數十億或數萬億參數的 Transformer。

對于當前一代量子計算機來說,結合數據驅動和物理啟發學習的混合兩步優化非常重要,已經證明了 Transformer 能夠減輕當今不完美的輸出數據中出現的錯誤,并可能形成強大的糾錯協議的基礎,以支持未來真正容錯硬件的開發。

隨著涉及量子物理 Transformer 的研究范圍不斷迅速擴大,一系列有趣的問題仍然存在。

量子計算語言模型的未來

盡管物理學家對它們的探索時間很短,但語言模型在應用于量子計算領域的廣泛挑戰時已經取得了顯著的成功。這些成果預示著未來許多有前途的研究方向。

量子物理學中語言模型的另一個關鍵用例來自于它們的優化能力,不是通過數據,而是通過哈密頓量或 Lindbladian 的基本量子比特相互作用的知識。

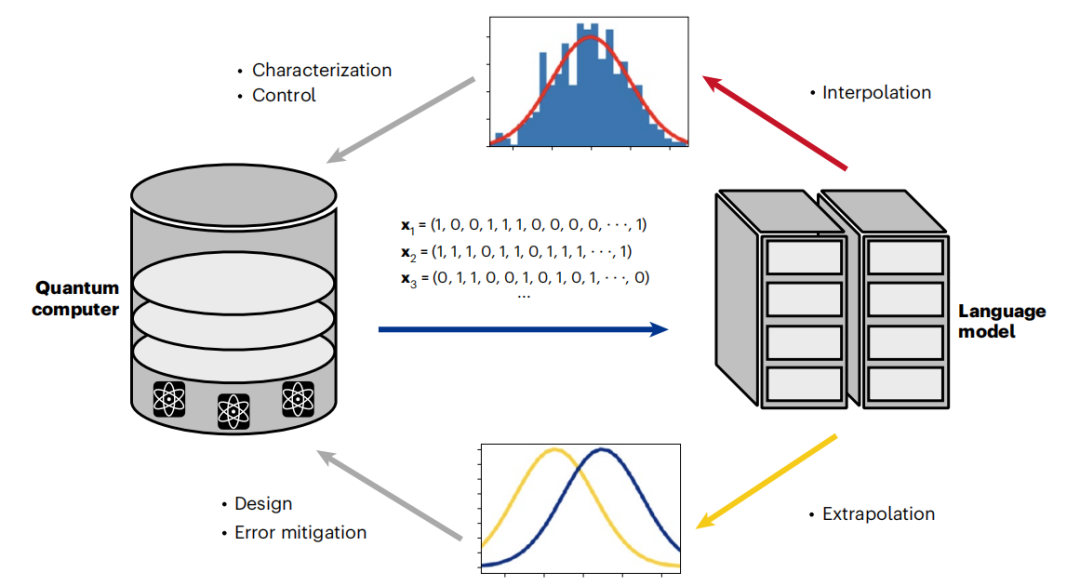

最后,語言模型通過數據驅動和變分驅動優化的結合,開辟了混合訓練的新領域。這些新興的策略為減少錯誤提供了新的途徑,并顯示出對變分模擬的強大改進。由于生成模型最近已被改編為量子糾錯解碼器,混合訓練可能為未來實現容錯量子計算機的圣杯邁出了重要一步。這表明,量子計算機和在其輸出中訓練的語言模型之間即將出現良性循環。

圖示:語言模型通過良性循環實現量子計算的擴展。(來源:論文)

展望未來,將語言模型領域與量子計算聯系起來的最令人興奮的機會在于它們展示規模和涌現的能力。

如今,隨著 LLM 涌現特性的展示,一個新的領域已經被突破,提出了許多引人注目的問題。如果有足夠的訓練數據,LLM 是否能夠學習量子計算機的數字副本?控制堆棧中包含語言模型,將如何影響量子計算機的表征和設計?如果尺度足夠大,LLM 能否顯示超導等宏觀量子現象的出現?

當理論學家思考這些問題時,實驗和計算物理學家已經開始認真地將語言模型應用于當今量子計算機的設計、表征和控制中。當我們跨越量子優勢的門檻時,我們也進入了擴展語言模型的新領域。雖然很難預測量子計算機和 LLM 的碰撞將如何展開,但顯而易見的是,這些技術相互作用所帶來的根本性轉變已經開始。