CMUÐ實現突破:機器狗點滿敏捷值天賦,超高速穿越障礙,速度與安全兼備!

在高速機器人運動領域,實現同時兼顧速度和安全一直是一大挑戰。但現在,卡內基梅隆大學(CMU)和蘇黎世聯邦理工學院(ETH)的研究團隊帶來了突破性進展。他們開發的新型四足機器人算法,不僅能在復雜環境中高速行進,還能巧妙避開障礙,真正做到了「敏捷而安全」。

論文地址: https://arxiv.org/pdf/2401.17583.pdf

在 ABS 的加持下,機器狗在各種場景下都展現出了驚艷的高速避障能力:

障礙重重的狹窄走廊:

凌亂的室內場景:

無論是草地還是戶外,靜態或動態障礙,機器狗都從容應對:

遇見嬰兒車,機器狗靈巧躲閃開:

警告牌、箱子、椅子也都不在話下:

對于突然出現的墊子和人腳,也能輕松繞過:

ABS 突破性技術:

RL+ Learning model-free Reach-Avoid value

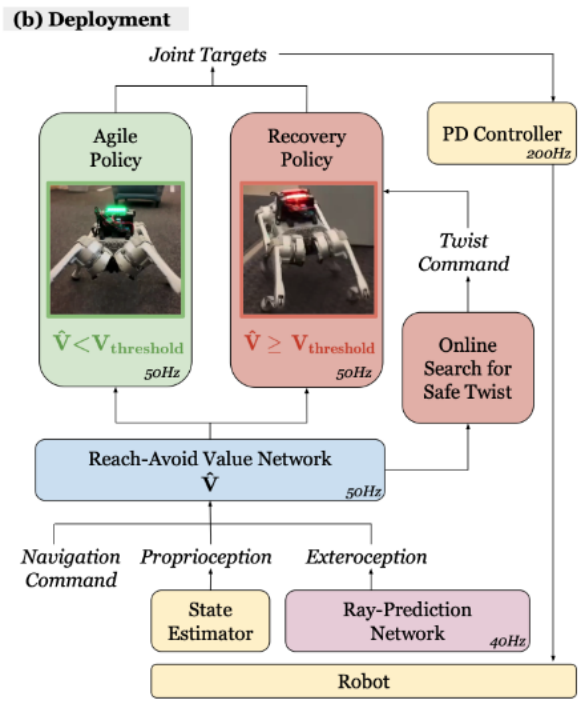

ABS 采用了一種雙策略(Dual Policy)設置,包括一個「敏捷策略」(Agile Policy)和一個「恢復策略」(Recovery Policy)。敏捷策略讓機器人在障礙環境中快速移動,而一旦 Reach-Avoid Value Estimation 檢測到潛在危險(比如突然出現的嬰兒車),恢復策略就會介入,確保機器人安全。

創新點 1:怎么訓練一個敏捷策略 Agile Policy?

敏捷策略的創新之處在于,與以往簡單地追蹤速度指令不同,它采用目標達成(position trakcing)的形式來最大化機器人的敏捷性。這一策略訓練機器人發展出感知運動技能,以在沒有碰撞的情況下達到指定目標。通過追求基座高速度的獎勵條件,機器人自然學會在避免碰撞的同時實現最大敏捷性。這種方法克服了傳統速度追蹤(velocity tracking)策略在復雜環境中可能的保守限制,有效提高了機器人在障礙環境中的速度和安全性。Agile Policy 在實機測試中極速達到了 3.1m/s

創新點 2:學習 Policy-conditioned reach-avoid value

「達防」(Reach-Avoid, RA)值學習的創新之處在于,它采用了無模型的方式學習,與傳統的基于模型的可達性分析方法不同,更適合無模型的強化學習策略。此方法不是學習全局 RA 值,而是使其依賴于特定策略,這樣可以更好地預測敏捷策略的失敗。通過簡化的觀測集,RA 值網絡可以有效地概括并預測安全風險。RA 值被用于指導恢復策略,幫助機器人優化運動以避免碰撞,從而實現在保證安全的同時提高敏捷性的目標。

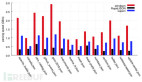

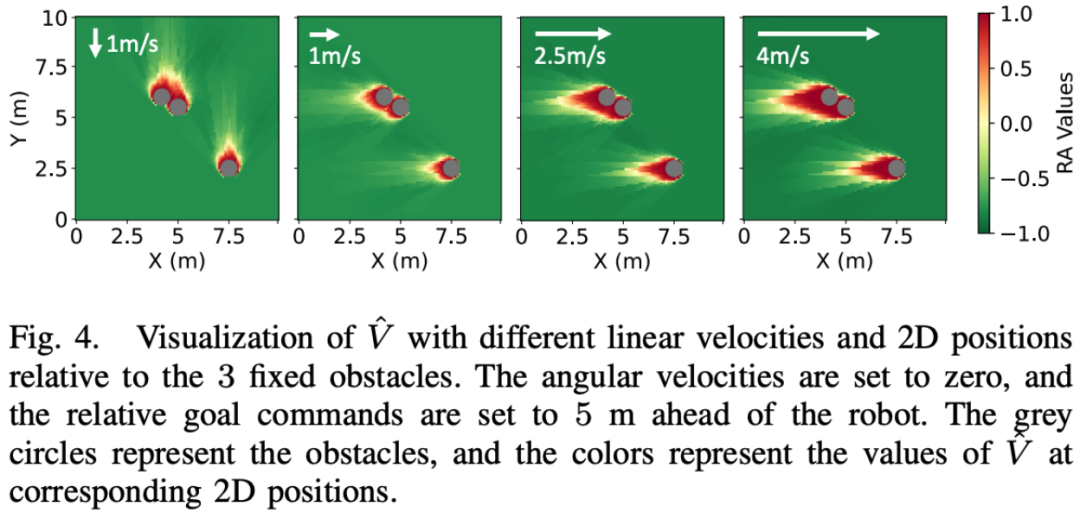

下圖展示了針對特定障礙物集合學習到的 RA(達防)值。隨著機器人速度的變化,RA 值的分布景觀也相應變化。RA 值的符號合理地指示了敏捷策略的安全性。換句話說,這張圖通過不同的 RA 值展示了機器人在不同速度下,面對特定障礙物時的安全風險程度。RA 值的高低變化反映了機器人在不同狀態下執行敏捷策略時可能遇到的安全風險。

創新點 3:用 Reach-Avoid Value 和恢復策略來拯救機器人

恢復策略的創新之處在于,它能使四足機器人快速追蹤線速度和角速度指令,作為一種備用保護策略。與敏捷策略不同,恢復策略的觀測空間專注于追蹤線速度和角速度命令,不需要外部感知信息。恢復策略的任務獎勵專注于線性速度追蹤、角速度追蹤、保持存活和保持姿勢,以便平滑切換回敏捷策略。這種策略的訓練同樣在仿真環境中進行,但有特定的域隨機化和課程設置,以更好地適應可能觸發恢復策略的狀態。這種方法為四足機器人提供了在高速運動中快速應對潛在失敗的能力。

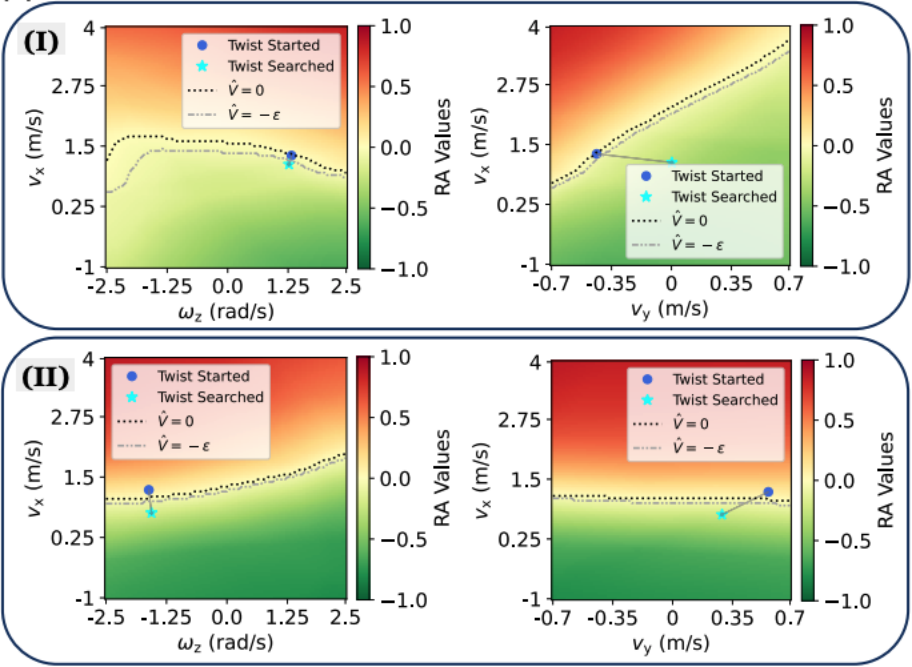

下圖展示了當恢復策略在兩個特定情況(I 和 II)下被觸發時,RA(達防)值景觀的可視化展示。這些可視化展示是在 vx(沿 x 軸的速度)與 ωz(繞 z 軸的角速度)平面以及 vx 與 vy(沿 y 軸的速度)平面上進行的。圖中顯示了搜索前的初始旋轉狀態(即機器人基座當前的旋轉狀態)和通過搜索得到的命令。簡單來說,這些圖表展示了在特定條件下,通過恢復策略搜索得到的最佳運動指令,以及這些指令如何影響 RA 值,從而反映機器人在不同運動狀態下的安全性。

魯棒性測試

作者在「12kg 負載 / 籃球撞擊 / 腳踢 / 雪地」的四個場景下測試了 ABS 框架的魯棒性,機器狗都從容應對:

研究團隊

這項研究是由 CMU 和 ETH 的研究團隊共同完成。團隊成員包括 Tairan He, Chong Zhang, Wenli Xiao, Guanqi He, Changliu Liu 和 Guanya Shi。他們的合作不僅在機器人技術領域取得了重大突破,更開啟了四足機器人新的應用可能。這項技術的成功展示了四足機器人在高速移動和安全避障領域的巨大潛力。未來,這種高速且安全的四足機器人有望在搜救、探險甚至是家庭服務等多個領域發揮重要作用。