無需GPU,手機芯片也能運行多模態模型!面壁智能發布MiniCPM,性能超過Mistral-7B!

原創2月1日,面壁智能發布了旗艦端側模型 MiniCPM,它以小博大的性能超越了 Mistral-7B,并在 MT-Bench 等榜單上表現出色。

MiniCPM 是一款能說會看、具備編程能力、擁有多模態能力的端側模型。它不僅在性能上優秀,而且具有極低的成本,支持 CPU 推理。MiniCPM 開源,并已在主流移動操作系統上進行了適配和測試。

1、端側成本極致降低:Mistral的1/100,GPT-4的1/360

在終端硬件廠商加速產品AI化的趨勢下,面壁智能認為,成本是大模型的隱形競爭力,“比起size,我們更在意成本”。

以搭載了驍龍855芯片的OPPO手機為例,MiniCPM每秒能處理7.5 Tokens,運行5年后報廢,成本為600元,由此可得170萬Tokens的推理成本僅1元——MiniCPM的推理成本僅Mistral的1/100,GPT-4的1/360。

據介紹,目前MiniCPM-2B在CPU(比GPU計算吞吐量低)上就能跑起來,相較于用GPU才能運行的大模型,能夠降低推理成本。與此同時,即便將大小壓縮75%,MiniCPM的性能也能做到基本無損耗。

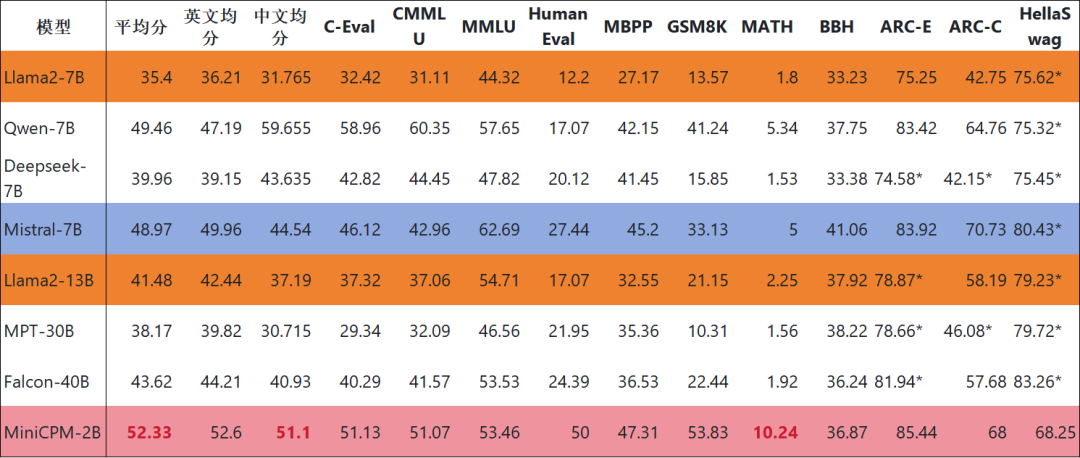

在性能上,MiniCPM-2B的中文知識能力、代碼能力、數學能力已經超過Mistral-7B,而英文知識能力、邏輯能力和常識問答能力還存在一定差距。而在測試模型接近人的程度的評測榜單MT-Bench上,MiniCPM-2B的表現超過了Llama 2-70B-Chat。

圖片

圖片

2、手機芯片也可運行

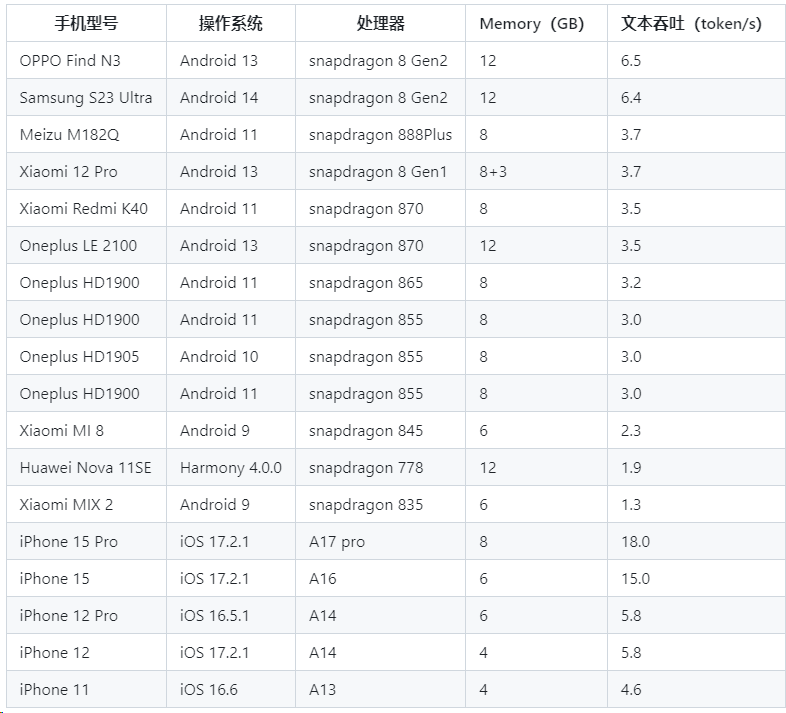

面壁智能團隊目前驗證了MiniCPM使用手機芯片進行推理的可行性。據悉,進行Int4量化后,MiniCPM只占2GB空間,具備在端側手機進行模型部署的條件。

其中,對于Android、Harmony系統,使用開源框架MLC-LLM進行模型適配,支持文本模型、多模態模型;對于iOS,使用開源框架LLMFarm進行模型適配,僅支持文本模型。

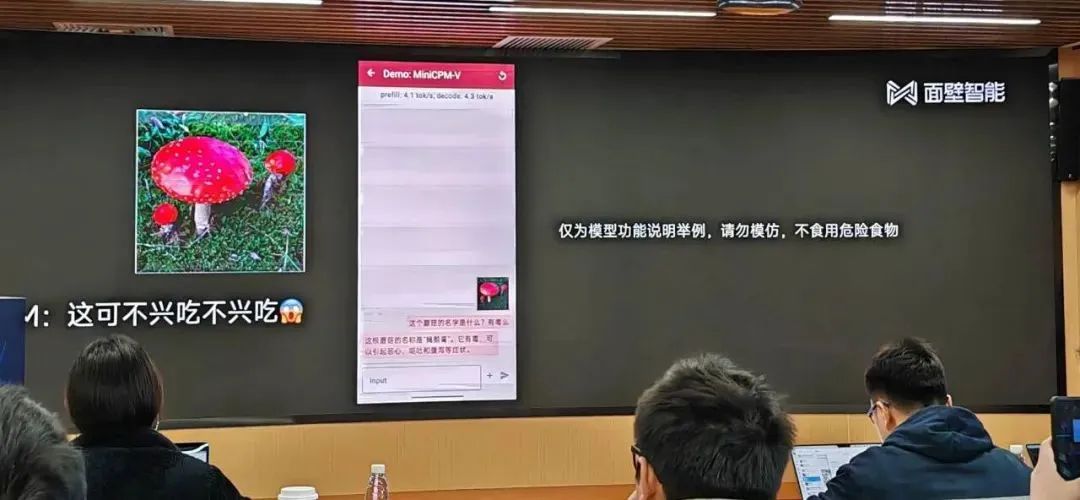

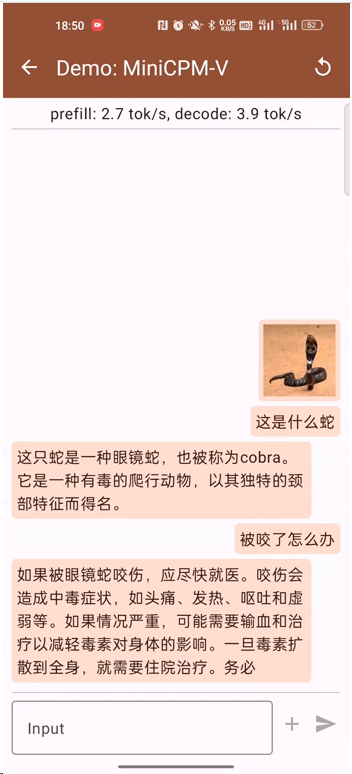

MiniCPM讓手機上具備了無需聯網、無需搜索也能識圖解答的能力。

圖片

圖片

圖片

圖片

“此前尚未有工作嘗試在手機上部署多模態大模型。我們此次在MLC-LLM上驗證了手機部署MiniCPM-V的可行性,能夠正常輸入輸出,但也存在圖片處理時間較長的問題,需要進一步優化。”

下圖是測試的手機型號、系統和處理器信息。

圖片

圖片

目前代碼已開源:https://github.com/OpenBMB/MiniCPM

3、多模態模型開源

此外,據介紹面壁還開源了一個多模態模型 OmniLMM,展現出了實時動作識別和精準理解等能力。

圖片

圖片

在發布會上,面壁智能演示了 Gemini 發布時同款的石頭剪刀布 demo。用英文向 AI 提問:我正在玩什么游戲?大模型會回答:石頭剪子布。

4、團隊平均年齡28歲80%清北

據了解,面壁智能源于清華 NLP 實驗室,是在國內較早開展大模型研究的團隊之一,其在 2018 年發布了全球首個基于知識指導的預訓練模型 ERNIE。2022 年 8 月開始公司化運作的面壁智能,去年經歷了兩輪融資,其推出的應用「面壁露卡」也拿到了網信辦第二批大模型備案。

目前,面壁智能已經組建起 100 余人的科研團隊,其中 80% 人員來自清北,平均年齡 28 歲。

面壁智能正在構建“大模型 + Agent”的雙引擎戰略,希望能構建出更小規模、更快速度、更低成本的解決方案。

此外,面壁智能聯合創始人還做了一個劇透:“我們會在春節之后不斷發布 MiniCPM 的新版本,性能還會進一步提升。我們要給大家春節的休息時間。”