權重、代碼、數據集全開源,性能超越Mistral-7B,蘋果小模型來了

小模型成趨勢?

本周,OpenAI 上線小模型 GPT-4o-mini,小模型賽道正式開卷。近期加入這一賽道的還有蘋果。

最近,蘋果公司作為 DataComp-LM(DCLM)項目的研究機構之一,在 Hugging Face 上發布了 DCLM-7B 開源模型。該模型性能已經超越了 Mistral-7B,并且正在逼近其他領先的開源模型,包括 Llama 3 和 Gemma。

- 論文鏈接:https://arxiv.org/pdf/2406.11794

- 項目鏈接:https://huggingface.co/apple/DCLM-7B

論文作者之一、蘋果機器學習團隊 Vaishaal Shankar 將 DCLM 模型描述為「真正開源的最佳模型」,因為 DCLM 不僅開源了模型權重,還開源了訓練代碼和預訓練數據集。

研究介紹

大型語言模型(LLM)目前面臨的一個評估挑戰是缺乏受控比較。LLM 研究通常會比較采用不同架構、計算或超參數的模型,因此難以理清影響語言模型質量的因素。

基于此,研究團隊提出了語言模型數據比較新基準 ——DCLM,這是語言模型訓練數據整編(curation)的第一個基準,旨在讓 LLM 通過設計高質量數據集來提高模型性能,特別是在多模態領域。

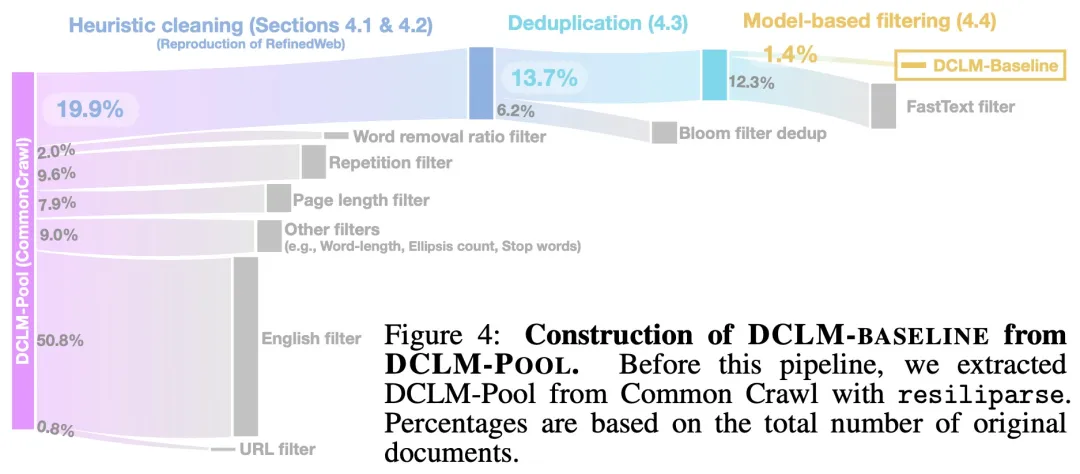

研究團隊發現基于模型的過濾,即由機器學習 (ML) 模型從較大的數據集中自動過濾和選擇高質量數據,可能是構建高質量訓練集的關鍵。

DCLM 整體思路很簡單:使用一個標準化的框架來進行實驗,包括固定的模型架構、訓練代碼、超參數和評估,最終找出哪種數據整理策略最適合訓練出高性能的模型。

使用 DCLM,研究團隊構建了一個高質量數據集 DCLM-BASELINE,并用該數據集從頭開始訓練了一個 7B 參數模型 —— DCLM-7B。

DCLM-7B 模型的細節。

DCLM-7B 使用基于 OpenLM 框架的預訓練方案,在 MMLU 基準上 5-shot 準確率達到 64%,可與 Mistral-7B-v0.3(63%)和 Llama 3 8B(66%)相媲美,并且在 53 個自然語言理解任務上的平均表現也可與 Mistral-7B-v0.3、Llama 3 8B 相媲美,而所需計算量僅為 Llama 3 8B 的 1/6。

以下是 DCLM-7B 在各種任務(部分)上的評估結果:

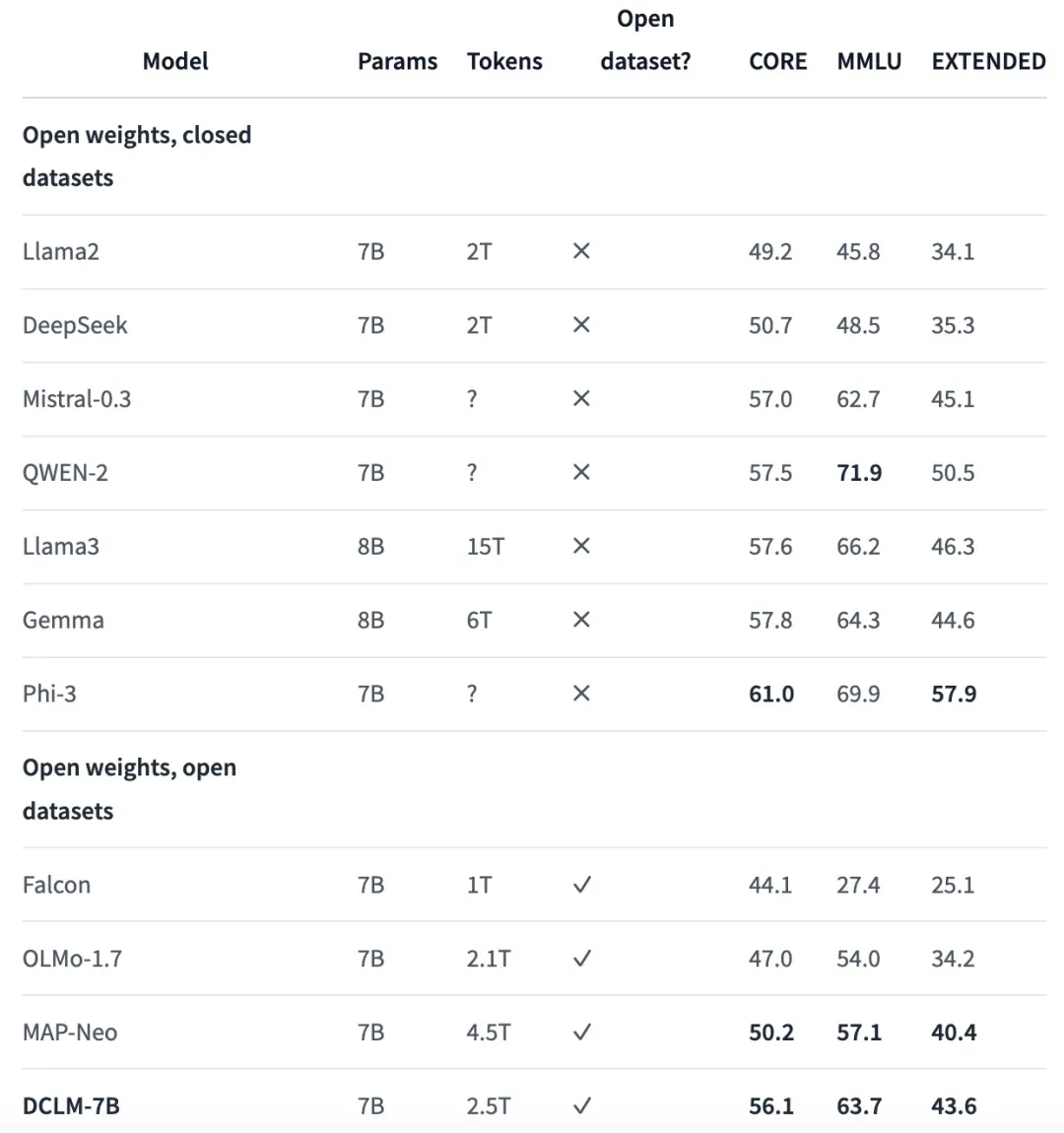

DCLM-7B 與其他同等大小模型比較結果如下表所示:

值得注意的是,大部分其他模型雖然開放權重但封閉數據。這就是 Vaishaal Shankar 將 DCLM 模型描述為「真正開源」的原因。

參考鏈接:https://venturebeat.com/ai/apple-shows-off-open-ai-prowess-new-models-outperform-mistral-and-hugging-face-offerings/。