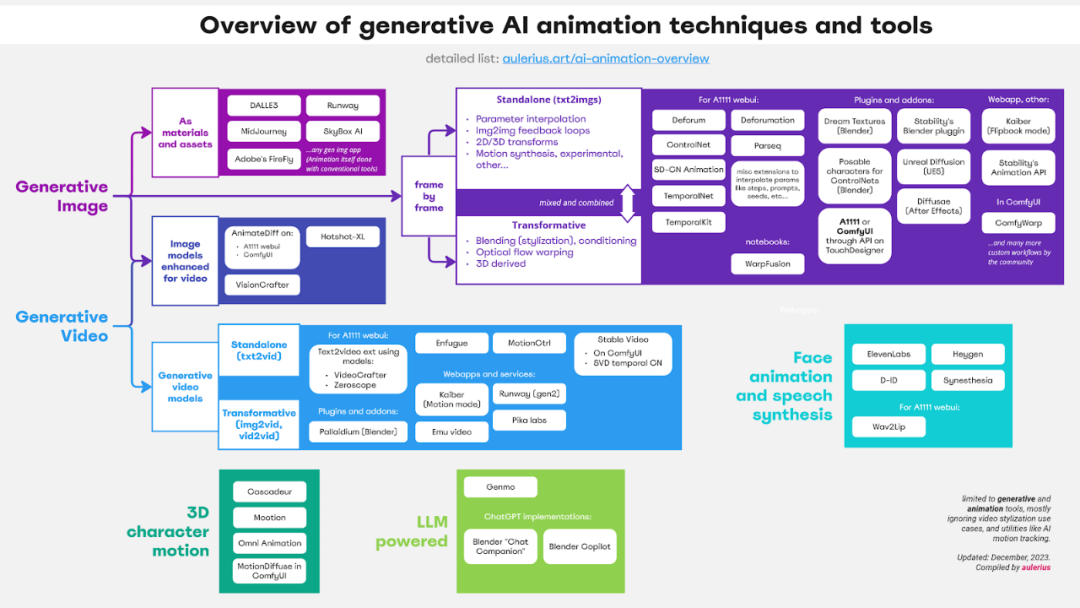

盤點如何用AI做動畫,還有各種工具等你取用

生成式 AI 已經成為互聯網的一個重要內容來源,現在你能看到 AI 生成的文本、代碼、音頻、圖像以及視頻和動畫。今天我們要介紹的文章來自立陶宛博主和動畫師 aulerius,其中按層級介紹和分類了動畫領域使用的生成式 AI 技術,包括簡要介紹、示例、優缺點以及相關工具。

他寫道:「作為一位動畫制作者,我希望一年前就有這樣一份資源,那時候我只能在混亂的互聯網上自行尋找可能性和不斷出現的進展。」

本文的目標讀者是任何對這一領域感興趣的人,尤其是不知如何應對 AI 領域新技術發展的動畫師和創意人士。另需說明,視頻風格化雖然也是相關技術,但本文基本不會涉及這方面。

本文的文章結構。

圖像生成

圖像生成技術是指使用 AI 模型生成圖像的技術,這些 AI 模型的訓練使用了靜態圖像。

將生成的圖像用作素材

將任意 AI 應用生成的靜態圖像用作 2D 剪貼畫、數字處理、拼貼等傳統工作流程中的素材,或者用作其它 AI 工具的資源,比如提供給圖像轉視頻(image2video)工具來生成視頻。除了作為圖像和素材來源,這類技術還需依賴剪切和圖像編輯等一些常用技能。

短片《Planets and Robots》中使用了數字剪貼畫來將生成的 AI 圖像動畫化,其中的配音也是使用 LLM 基于腳本生成的。

優點:

- 現有動畫師就很容易上手使用

- 可用于生成背景圖

缺點:

- 生成結果沒有多少「新意」

- 需要動畫師協調處理素材和動畫

免費工具(任何生成圖像模型或應用):

- Stable Diffusion(SD,運行在本地計算機上)或這些在線應用:Craiyon

- Invokeai (使用了 SD)

- Enfugue (使用了 SD)

- SkyBox AI—— 能生成適用于 VR 的 360 度場景圖

插件和附加組件:

- 在 Blender 中使用的 ComfyUI 節點

- Krita 上的 Stable Diffusion

- Krita 上的 ComfyUI—— 界面簡單易用,對藝術家友好

此外,Hugging face space 上還有一些免費的演示:https://huggingface.co/spaces

付費工具(任何生成圖像模型或應用):

- MidJourney

- Runway

- DALL?E 2

- Adobe 的 FireFly

注:動畫制作使用的工具包括 After Effects、Moho、Blender……

逐幀生成圖像

這類技術是以一種相當程度上立足動畫根源的精神來使用生成式擴散圖像模型,其是以逐幀方式生成動作序列,就像是傳統動畫制作的繪制再拍攝過程。其中的一大關鍵是這些模型在生成每張圖像時沒有時間或運動的概念,而是通過某種機制或各種應用或擴展來幫助得到某種程度上的動畫,從而實現所謂的「時間一致性(temporal consistency)」。

這些技術得到的動畫往往會出現閃爍現象。盡管許多使用這些工具的用戶會努力清理這些閃爍,但動畫師卻會把這視為一種藝術形式,稱為 boiling。

這方面最常用的是 Stable Diffusion 等開源模型以及基于它們構建的工具。用戶可以使用公開的參數來配置它們,還可以將它們運行在本地計算機上。相較之下,MidJourney 工具的模型沒有公開,而且主要是為圖像生成設計的,因此無法用來生成逐幀動畫。

動畫也可能使用 Stable WarpFusion 來制作,這其中涉及到圖像轉圖像的工作流程,通過一些扭變(置換)將底層的視頻輸入變成動畫。視頻作者:Sagans。

用逐幀圖像來制作動畫通常需要混合使用以下工具:

一步到位的工具(文本轉圖像)

有一些新技術支持直接通過文本 prompt 和參數調配來生成動畫:

- 參數插值(變形)

在每張生成的圖像幀上逐漸進行參數插值,以得到過渡動畫。這里的參數可能包括任何與模型相關的設定,比如文本 prompt 本身或底層的種子(隱空間游走)。

prompt 編輯法,即通過逐漸改變權重來創建動畫過渡。這里使用了 Depth ControlNet 來保持手部整體形狀的一致性。

- 圖像到圖像(I2I)反饋循環

通過圖像到圖像技術,將每張生成的圖像幀作為輸入來生成動畫的下一幀。這樣在其它參數和種子變化時也可以生成看起來相似的幀序列。這個過程通常由 Deforum 中的「去噪強度」或「強度調度」來控制。起始幀可以是已有的圖片。

這是大多數使用 Stable Diffusion 的動畫實現的一個核心組件,而 Stable Diffusion 是下列許多應用依賴的技術。這種技術很難平衡,并且很大程度上取決于使用的采樣器(噪聲調度器)。

使用一張起始圖像,然后使用一個稍有不同的 prompt,使其逐幀變化成其它形態。

- 2D 或 3D 變換(基于 I2I 循環)

逐漸變換每一幀生成圖像,之后再將其作為 I2I 循環的輸入。2D 變換對應于簡單的平移、旋轉和縮放。3D 技術則會想象一個在 3D 空間中移動的虛擬相機,這通常需要估計每幀生成圖像的 3D 深度,然后根據想象中的相機運動來進行變形處理。

想必你已經看過這種無限放大的動畫。它的視覺效果如此之棒,是因為其使用了 SD 來持續構建新細節。

- 實驗性、運動合成、混合等技術

運動合成的目標是「想象」后續生成幀之間的運動流,然后使用這個運動流來逐幀執行變形處理,從而基于 I2I 循環注入有機的運動。這通常需要依賴在視頻的運動估計(光流)上訓練的 AI 模型,只不過其關注的不是后續視頻幀,而是后續生成幀(通過 I2I 循環),或是使用某種混合方法。

其它技術還包括圖像修復和變形技術搭配使用、采用多個處理步驟或甚至捕獲模型訓練過程的快照等先進技術。舉個例子,Deforum 有很多可供用戶調控的地方。

使用 SD-CN Animation 制作,其使用了一種在生成幀之間產生幻覺運動的獨特方法。起始圖像只是作為起點,沒有其它用途。

變換型技術(圖像到圖像):

此外還可以使用某個來源的輸入來助力生成的幀和所得的動畫結果:

- 混合(風格化)—— 混合視頻源或 / 和按條件處理(ControlNets)

這類方法范圍很廣,做法是使用輸入視頻來混合和影響生成的序列。這些輸入視頻通常分為多個幀,作用通常是風格化現實視頻。在現如今的風格化跳舞視頻和表演熱潮中,這類技術常被用于實現動漫造型和性感體格。但你可以使用任何東西作為輸入,比如你自己動畫的粗略一幀或任何雜亂抽象的錄像。在模仿 pixilation 這種定格動畫技術和替換動畫技術方面,這類技術有廣泛的可能性。

在每一幀,輸入幀要么可以直接與生成圖像混合,然后再輸入回每個 I2I 循環,要么可以采用更高級的設定附加條件的做法,比如 ControlNet。

Deforum 搭配 ControlNet 條件化處理的混合模式,左圖是原視頻。遮掩和背景模糊是分開執行的,與這項技術無關。

- 光流變形(使用視頻輸入在 I2I 循環上執行)

「光流」是指視頻中估計的運動,可通過每一幀上的運動向量表示,其指示了屏幕空間中每個像素的運動情況。當估計出變形工作流程中的源視頻的光流后,就可以根據它對生成的幀執行變形,使得生成的紋理在對象或相機移動時也能「粘黏」在對象上。

Deforum 的混合模式支持這種技術搭配各種設置使用。為了得到閃動更少的結果,也會增加 cadence,使得變形的效果更好。遮掩和背景模糊是分開執行的,與這項技術無關。

- 3D 衍變

通過變形工作流程完成的條件處理也可能直接關聯 3D 數據,這可以跳過一個可能造成模糊的環節,直接在視頻幀上完成處理。

舉個例子,可以直接通過虛擬 3D 場景提供 openpose 或深度數據,而不是通過視頻(或經過 CG 渲染的視頻)估計這些數據。這允許采用最模塊化和最可控的 3D 原生方法;尤其是組合了有助于時間一致性的方法時,效果更佳。

這可能是現有技術與用于 VFX 的 AI 技術之間最有潛力的交叉領域,如下視頻所示:https://youtu.be/lFE8yI4i0Yw?si=-a-GvsaIVPrdaQKm

有一個廣泛應用的工具也使用了該技術,其可簡化并自動化用 Blender 生成直接適用于 ControlNet 的角色圖像的過程。在這個示例中,ControlNet 使用手部骨架來生成 openpose、深度和法線貼圖圖像,最終得到最右側的 SD 結果。(openpose 最終被舍棄了,因為事實證明它不適用于只有手部的情況。)

將所有這些技術結合起來,似乎有無盡的參數可以調整動畫的生成結果(就像模塊化的音頻制作)。它要么可以通過關鍵幀進行「調度」并使用 Parseq 這樣的工具繪制圖形,要么可以與音頻和音樂關聯,得到許多隨音頻變化的動畫。只需如此,你就能使用 Stable Diffusion 幫你跳舞了。

優點:

- 全新且不斷演變的美學風格,這是這種媒體形式特有的。

- 在概念上與傳統的動畫技術有共同點。

- 最容易定制化、最實用且易于指導。

- 模塊化、分層的方法。

缺點:

- 往往會有閃動問題,有時候會顯得很混亂。

- 技術方面要考慮的東西很多,難以平衡考慮,要想成為高手必須經歷陡峭的學習曲線。

- 如果沒有性能卓越的本地硬件(英偉達 GPU),就會很不方便。

免費工具:

可在 A1111 webui 中使用的工具:

- 用于參數插值動畫(travel)的小腳本:步驟(https://github.com/vladmandic/sd-extension-steps-animation) 、prompt(https://github.com/Kahsolt/stable-diffusion-webui-prompt-travel )、種子(https://github.com/yownas/seed_travel)。

- Deforum—— 能夠滿足各種動畫 SD 需求的最佳工房,整合了上面大多數技術。

- Parseq—— 用于 Deforum 的常用視覺參數排序工具。

- Deforum timeline helper—— 另一款參數可視化和調度工具。

- Deforumation—— 用于實時控制 Deforum 參數的 GUI,支持反應性調整和控制。

- TemporalKit—— 采用了 EBsynth 的一些原則,可與 SD 搭配使用實現一致的視頻風格化。

- SD-CN Animation—— 這多少還是個實驗性工具,支持一些混合風格化工作流程,也支持有趣的光流運動合成(這會導致運動抖動)。

- TemporalNet——ControlNet 模型可以用在 Deforum 等其它工作流程中,目標是提升時間一致性。Python 筆記本(需要在 Google Colab 或 Jupyter 上運行)。

- Stable WarpFusion —— 實驗性的代碼工具包,目標是執行高級的視頻風格化和動畫。與 Deforum 有很多一樣的功能。

插件和附加組件:

- 用于 Blender 的 Dream Textures

- Stabiliy AI 的 Blender 插件

- 看起來像用于 Blender 的 Openpose 的角色骨架 —— 可在 Blender 之外使用 ControlNet

- 用于虛幻引擎 5 的 Unreal Diffusion

- 用于 After Effects 的 After-Diffusion(目前還在開發中)

- 用于 TouchDesigner 的 A1111 或 ComfyUI API—— 如果你知道如何操作,那么這可用于執行動畫等各種任務

付費工具:

(通常也依賴于 SD,但運行在「云」上,用起來也更簡單):

- Stability AI 的動畫 API

- Kaiber 的 Flipbook 模式 —— 按照描述,基于 Deforum 代碼

插件和附加組件:

- 用于 After Effects 的 Diffusae

市面上還有許多應用和工具,但如果是付費工具,多半是基于開源的 Deforum 代碼。

注:最好的情況是你有足夠的優良硬件(即 GPU)在本地運行這些工具。如果沒有,你也可以嘗試運行在遠程計算機上的、功能有限的免費服務,比如 Google Colab。不過,Google Colab 上的筆記本也可以運行在本地硬件上。

視頻生成技術

這類技術使用在運動視頻上訓練的視頻生成 AI 模型,另外可以在神經網絡層面上使用時間壓縮來增強。

目前,這些模型有一個共同特征是它們僅能處理時間很短的視頻片段(幾秒),并受到 GPU 上可用視頻內存的限制。但是,這方面的發展速度很快,并且可以用一些方法將多個生成結果拼接成更長的視頻。

視頻生成模型

這是指使用從頭構建和訓練的模型來處理視頻。

現今的這類模型得到的結果往往晃動很大、有明顯的 AI 痕跡、顯得古怪。就像是很久之前生成圖像的 AI 模型一樣。這個領域的發展落后一些,但進展很快,我個人認為在靜態圖像生成上取得的進展并不會同等比例地在視頻生成方面重現,因為視頻生成的難度要大得多。

Paul Trillo 使用 Runway 的 Gen-2,僅通過圖像和文本 prompt 讓 AI 生成的視頻。

我認為在這方面,動畫和傳統電影之間的界限很模糊。只要其結果還與現實有差異,那么我們就可以在一定程度上把它們看作是動畫和視頻藝術的一種怪異新流派。就目前而言,我認為大家還是別想著用這類技術做真實風格的電影了,只把它視為一種新形式的實驗媒體即可。玩得開心哦!

一步到位的工具(文本轉視頻):使用文本 prompt 生成全新的視頻片段

理論上講,這類技術有無限可能性 —— 只要你能將其描述出來(就像靜態圖像生成那樣),就可能將其用于直播表演或生成任何超現實和風格化的內容。但從實踐角度看,為了訓練視頻模型,收集多樣化和足夠大的數據集要難得多,因此僅靠文本來設定生成條件,很難用這些模型實現利基(niche)的美學風格。

使用這種方法,只能很寬松地控制創意工作。當與圖像或視頻條件化處理(即變形工作流程)組合使用時,這種技術就會強大得多。

Kyle Wiggers 做的動畫生成測試,使用了 Runway 的 Gen-2

變形:使用文本 prompt,再根據已有的圖像或視頻進行進一步的條件化處理

- 圖像到視頻生成

很多視頻生成工具都能讓你以圖像為條件生成視頻。其做法可以是完全從你指定的圖像開始生成,也可以將指定圖像用作語義信息、構圖和顏色的粗略參考。

人們經常會使用傳統的靜態圖像模型生成起始圖像,然后再將其輸入視頻模型。

這里生成的每一段視頻都是使用一張唱片封面作為起始圖像,作者:Stable Reel

- 視頻到視頻生成

類似于圖像生成模型中的圖像到圖像過程,也有可能將輸入視頻的信息嵌入到視頻模型中,再加上文本 prompt,讓其生成(去噪)輸出。

我并不理解這其中的具體過程,但似乎這個過程不僅能在逐幀層面上匹配輸入視頻片段(如同使用 Stable Diffusion 進行風格化處理),而且能在整體和運動層面上匹配。和圖像到圖像生成過程一樣,這個過程受去噪強度控制。

如果運氣好并且有合適的 prompt,你也可以輸入視頻來「啟發」模型重新想象源視頻中的運動,并以完全不同的形式將其呈現出來。使用 webui txt2vid 中的 Zeroscope 完成,使用了 vid2vid 模式。

優點:

- 這類技術具有最大的可能性,并且會隨時間不斷改進。

- 在專業動畫知識方面沒有進入門檻。

- 相比于逐幀的技術,這類技術的結果往往更加平滑,通常也更為一致。

- 對于「變形」工作流程而言,這可能是比逐幀方法更簡單直接的方法。

缺點:

- 得到的結果通常顯得離奇怪異,一看就是 AI 生成的,而且這種情況比靜態圖像嚴重多了。在涉及人的仿真實影像方面尤其明顯。

- 計算成本高。相比于圖像 AI,更難以在本地硬件上運行。

- 存在視頻時長短和上下文短等限制(目前而言)。

免費工具:

- Stable Video (SVD)—— 來自 StabilityAI 的開源視頻擴散模型。目前很多托管式應用和工具都在快速部署實現該模型。

- SVD ComfyUI 實現

- SVD 時間 ControlNet

- MotionCtrl—— 經過增強,允許在各種視頻模型中控制目標運動和攝像機軌跡。

- Emu Video——Meta 的視頻生成模型的預覽演示。

- A1111 webui 的文本轉視頻插件,可搭配以下模型使用(如果你的硬件足夠):

- VideoCrafter

- Zeroscope

插件和附加組件:

- 用于 Blender 的 Pallaidium—— 一個多功能工具包,包含跨圖像、視頻甚至音頻領域的生成功能。

- 此外,你還能在 Hugging face space 上找到一些免費演示。

付費工具(有試用版):

- Runway 的 Gen2

- Kaiber 的 Motion 模式

- Pika labs(受限 beta 版)

注:最好的情況是你有足夠的優良硬件(即 GPU)在本地運行這些工具。如果沒有,你也可以嘗試運行在遠程計算機上的、功能有限的免費服務,比如 Google Colab,不過大多數免費或試用服務的功能都有限。

使用運動壓縮增強的圖像模型

隨著 AnimateDiff 的日益流行,出現了一個使用視頻或「運動」壓縮來增強已有圖像擴散模型的新興領域。相比于使用逐幀技術生成的結果,其生成的結果更相近于原生視頻模型(如上面介紹的)。這種技術的優勢是你還可以使用為 Stable Diffusion 等圖像模型構建的工具,如社區創建的任何檢查點模型、LoRA、ControlNet 以及其它條件化處理工具。

你甚至有可能通過 ControlNet 提供視頻條件化處理,就像是使用逐幀技術一樣。社區仍在積極實驗這一技術。可用的技術有的來自靜態圖像模型(比如 prompt 遍歷),也有的來自視頻原生模型。

如下視頻為使用 ComfyUI 中 AnimateDiff 完成的動畫,過程使用了多個不同的 prompt 主題。

視頻鏈接:https://www.instagram.com/p/Cx-iecPusza/?utm_source=ig_embed&utm_campaign=embed_video_watch_again

這種技術中的運動本身通常非常原始,只是在視頻片段中松散地插入對象和流,這往往會將事物變形成其它模樣。不過,這種技術有更好的時間一致性,而且仍處于起步階段。當場景很抽象,沒有具體物體時,這種方法能得到最好的結果。

優點:

- 可以受益于現有圖像擴散模型的進展。

- 可以通過去噪或使用 ControlNet 用視頻來進行條件化處理。

- 處理抽象、流運動效果很好。

缺點:

- 難以為人物或不常見的物體產生復雜、連貫一致的運動,反而常出現變形問題。

- 和視頻原生模型一樣,計算成本高。相比于圖像 AI,更難以在本地硬件上運行。

- 受限于較短的上下文窗口(目前而言),但也有一些人正在實驗解決方案。

免費工具:

目前,AnimateDiff (SD v1.5) 的實現一馬當先:

- 用于 AnimateDiff 的 A1111 webui 插件

- ComfyUI 中 AnimateDiff 實現

- VisionCrafter—— 一個用于 AnimateDiff 實現等項目的 GUI 工具

- 用于 SD XL:Hotshot-XL

- 多功能實現:Enfugue

付費工具:

- 目前好像沒有

整合語音合成的人臉動畫

大家都知道,這是一個流行迷因背后的技術。你可能看過一個相對靜止的人物(相機可能在移動)只有臉動著說話,這多半是用到了 AI 人臉動畫化和語音合成工具的組合方法。

這其中組合了多個技術步驟和組件。其源圖像多半是使用圖像生成 AI 制作的,但也可以使用任何帶有人臉的圖像。語音是根據文本生成的,并根據所選任務的音色進行了條件化處理。然后再使用另一個工具(或工具包中的某個模型)合成與音頻唇形同步的人臉動畫 —— 通常只生成圖像中臉部和頭部區域的運動。使用預訓練的數字化身也能讓身體動起來。

優點:

- 可用于輕松制作迷因動圖。

- …… 呃,有喜劇效果?

缺點:

- 通常看起來不自然。我還想不出這能有什么實際用途。

- 過于依賴付費應用提供的閉源人臉動畫工具。

- 即使你使用自己的錄像來訓練數字化身,得到的結果也過于呆板,動態效果很差。

免費工具:

- ElevenLabs—— 有使用次數限制,但次數似乎每個月都會刷新。

- A1111 WebUI 的 Wav2Lip 插件 —— 用于生成唇形同步動畫的工具。看起來僅限于嘴部區域。

你也可以在網上直接搜索文本轉語音服務,不可勝計,但效果多半趕不上 ElevenLabs。

至于全臉動畫化,就我所知,目前僅有一些付費應用提供了試用版,而且使用很受限。

付費工具(有試用版):

人臉動畫制作(通常會搭配語音合成):

- D-ID

- Heygen

- Synesthesia

搜索「D-ID 替代品」就能找到很多。

生成三維的人物運動

這是指為 3D 人物合成運動的技術。這類技術可以應用于 3D 動畫電影、視頻游戲或其它 3D 交互應用。正如圖像和視頻領域一樣,新興的 AI 工具讓人可通過文本來描述人物的運動。此外,一些工具還能根據很少的關鍵姿勢來構建運動或者在交互環境中實時動態地生成動畫。

Nikita 的充滿天才巧思的元人工智能電影預告片,其中將 AI 的運動學習過程展現成了一部滑稽幽默的有趣短片。

由于本文的關注重點是生成工具,因此沒有包含自動化某些非創意任務的 AI 應用,比如 AI 驅動的運動跟蹤、合成、打碼等,例子包括 Move.ai 和 Wonder Dynamics。

優點:

- 能整合進現有的 3D 動畫制作流程中,可減少重復性任務,有望成為動畫老手的好幫手。

- 能很好地處理物理效果和重量。

- 在未來的視頻游戲中實現動態的人物動畫?

缺點:

- 似乎受限于人類形態的雙足式人物。

- 還需要其它工具輔助。只是 3D 動畫制作流程的一個組件。你需要知道接下來該做什么。

- 訓練過程通常基于人類運動數據,這意味著到目前為止這些工具只能實現基于真實物理效果的運動,無法實現風格化或卡通中的運動機制。

免費工具(或可免費使用部分功能的服務):

- Mootion

- Omni Animation

- Cascadeur—— 動畫制作助理,可以根據最小化的輸入創建平滑的、基于物理機制的動畫和姿勢。可控性高,可能會成為未來一個主力工具。

- ComfyUI 中的 MDM、MotionDiffuse 和 ReMoDiffuse 實現。

付費工具:

- 免費工具的付費套餐會提供更多功能,使用限制也更少。

LLM 驅動的工具

從理論上講,由于大型語言模型(LLM)在編程任務上表現出色,尤其是經過微調之后,那么我們就可以在制作動畫的軟件中讓其編程和編寫腳本。這就意味著按照常規工作流程制作動畫時,能讓 AI 從頭到尾一直輔助。極端情況下,AI 能幫你完成一切工作,同時還能為后端流程分配適當的任務。

在實踐中,你也能嘗試這么做了!舉個例子,Blender 配備了非常廣泛的 Python API,允許通過代碼操作該工具,因此現在已經有幾個類似 ChatGPT 的輔助工具可用了。這個趨勢不可避免。只要有代碼,LLM 多半就會有用武之地。

優點:

- 潛力 —— 最終突破創意工作者面臨的任何技術障礙。

- 可用作創意軟件的助理,消除繁瑣重復的任務,幫你深度挖掘文檔內容。

缺點:

- 如果 AI 能幫你創造一切,那么成為創意工作者還有什么意義?

- 目前,LLM 只能運行在強大的遠程計算機上,通常是按 token 數收費或采用訂閱制。

免費工具:

- Blender Chat Companion——(類似于 Blender Copilot)Blender 中的一個 ChatGPT 實現,專用于處理適當的任務。使用了 ChatGPT API,這需要付費。

付費工具:

- Genmo—— 承諾會實現「創意通用智能」,采用了多步過程并且全都可以通過聊天界面控制。

- Blender Copilot——(類似于 Blender Chat Companion)Blender 中的一個 ChatGPT 實現,專用于處理適當的任務。使用了 ChatGPT API,這需要付費。

注:還有一個即將推出的 ChatUSD—— 這是一個可以操作和管理 USD 的聊天機器人,這是由皮克斯最初創建的標準,用以統一和簡化動畫電影制作中的 3D 數據交換和并行化。目前沒有更多相關消息了,但英偉達似乎很歡迎這項標準并在推動其成為各種 3D 內容的標準,而不只是電影。

終于完結了!內容很多,但我多半還是遺漏了一些東西。