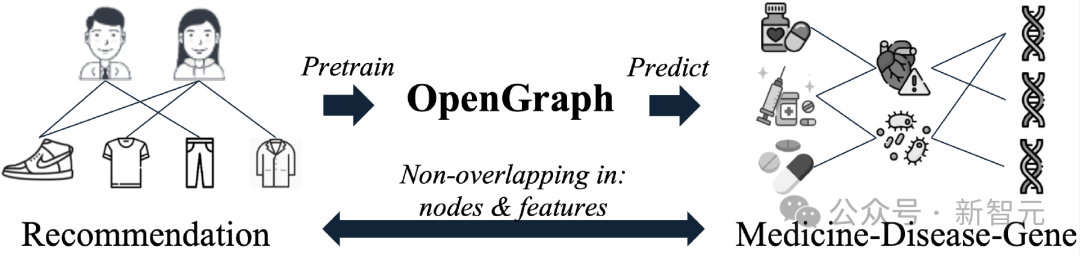

首次攻克「圖基礎模型」三大難題!港大開源OpenGraph:零樣本學習適配多種下游任務

圖學習(Graph Learning)技術能夠對復雜的關系數據進行挖掘和學習,在推薦系統、社交網絡分析、引用網絡和交通網絡等多個領域都顯示出了巨大的應用價值。

圖神經網絡(Graph Neural Networks, GNNs)基于迭代的消息傳遞機制,能夠捕捉圖結構數據中的復雜高階關系,在各類圖學習應用場景中取得了巨大的成功。

通常,這種端到端的圖神經網絡需要大量、高質量的標注數據才能獲得較好的訓練效果。

近年來,一些工作提出圖模型的預訓練-微調(Pre-training and Fine-tuning)模式,使用各種自監督學習任務在無標注的圖數據上首先進行預訓練,再在少量標注數據上進行微調,以對抗監督信號不足的問題。這里的自監督學習任務包括對比學習、掩碼重建、局部全局互信息最大化等方法。

盡管這種預訓練方法取得了一定的成功,但他們的泛化能力較為有限,特別是當預訓練和下游任務出現分布偏移(Distribution Shift)時。

例如在推薦系統中,預訓練模型使用較早時間采集的數據,而預測時用戶喜好、商品熱度常常出現變化。

為了解決這一問題,一些近期工作提出了針對圖模型的提示微調方法,能夠更加高效地將預訓練模型適應到下游任務和數據上。

盡管上述工作推進了圖神經模型的泛化能力,但這些模型全都假設:訓練數據和測試數據有相同的節點集合和特征空間。

這極大地限制了預訓練圖模型的應用范圍。因此,本文探索進一步提升圖模型泛化能力的方法。

具體來說,我們希望OpenGraph能夠捕捉通用的拓撲結構模式,對測試數據進行零樣本預測。即僅通過前向傳播過程,就可以對測試圖數據進行高效的特征提取和準確預測。

模型的訓練過程在完全不同的圖數據上進行,在訓練階段不接觸測試圖的任何元素,包括節點、邊、特征向量。

為了達成這一目的,本文需要解決以下三個挑戰:

C1. 跨數據集的Token集合變化

零樣本圖預測任務的一個顯著困難是,不同的圖數據通常有完全不同的圖token集合。具體來說,不同圖的節點集合通常沒有交集,并且不同圖數據集也經常使用完全不同的節點特征。這使得模型不能通過學習和特定數據集的圖token綁定的參數,來進行跨數據集的預測任務。

C2. 高效的節點間關系建模

在圖學習領域,節點之間常常存在錯綜復雜的依賴關系,模型需要對節點的局部和全局鄰域關系進行綜合考量。在搭建通用圖模型時,一個重要的任務是能夠高效地建模節點間關系,這能夠增強模型在處理大量圖數據時的模型效果和可擴展性。

C3. 訓練數據稀缺

由于隱私保護、數據采集成本等原因,在圖學習的很多下游領域中都廣泛存在數據稀缺問題,這使得通用圖模型的訓練容易缺乏對某些下游領域的了解而產生次優的訓練效果。

為了應對上述挑戰,香港大學的研究人員提出了 OpenGraph,這是一個擅長零樣本學習的模型,能夠識別不同下游領域之間可遷移的拓撲結構模式。

論文鏈接:https://arxiv.org/pdf/2403.01121.pdf

源碼鏈接:https://github.com/HKUDS/OpenGraph

通過創建一個具有拓撲感知投影方案的圖tokenizer來解決挑戰 C1,從而生成統一的圖tokens。

為了應對挑戰 C2,設計了一個可擴展的圖Transformer,它配備了基于錨點采樣的高效自注意力機制,并包括了token序列采樣以實現更高效的訓練。

為了解決挑戰 C3,我們利用大型語言模型進行數據增強,以豐富我們的預訓練,使用提示樹算法和吉布斯采樣來模擬現實世界的圖結構關系數據。我們在多個圖數據集上進行的廣泛測試顯示了 OpenGraph 在各種設置中的卓越泛化能力。

模型介紹

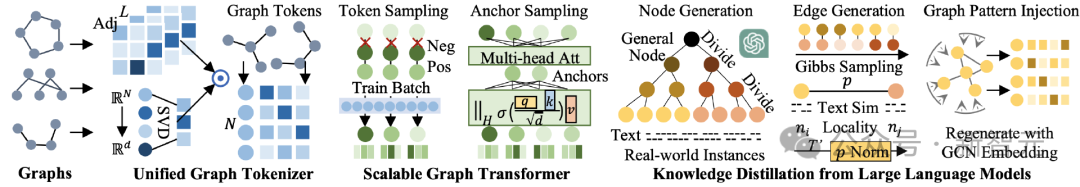

模型整體架構如下圖所示,可以分為三個部分,分別為1)統一圖Tokenizer,2)可擴展的圖Transformer,3)大語言模型知識蒸餾。

統一圖Tokenizer

為了應對不同數據集在節點、邊、特征上存在的巨大差異,我們的首要任務是建立一個統一的圖tokenizer,能夠有效地將不同圖數據影射為統一的token序列。在我們的tokenizer中,每個token都有一個語義向量,用于描述對應節點的信息。

通過采用統一的節點表征空間,以及靈活的序列數據結構,我們希望為不同的圖數據進行標準化、高效的tokenization。

為了達成這一目的,我們的tokenizer采用了經過平滑的拓撲信息,以及一個從節點空間到隱表征空間的映射函數。

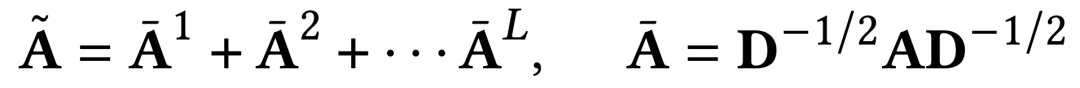

高階平滑鄰接矩陣

在圖tokenization過程中,使用鄰接矩陣的高次冪作為輸入之一,這種方式既能夠獲取圖結構的高階連接關系,也能夠解決原始鄰接矩陣中連接稀疏性的問題。

計算過程中進行了Laplacian歸一化,并將不同階的鄰接矩陣冪全部考慮進來,具體計算方法如下。

對任意圖的拓撲感知映射

不同數據集的鄰接矩陣在維度上存在巨大的差異,這使得我們不能直接將鄰接矩陣作為輸入,再使用一個固定輸入維度的神經網絡進行處理。

我們的解決方案是首先將鄰接矩陣投射為節點表征序列的形式,后續即可使用可變長的序列模型進行處理。而為了減少映射過程的信息損失,我們提出了一種拓撲感知的映射方法。

首先,我們拓撲感知映射的值域是一個維度較高的隱表征空間。之前的一些工作指出,在采用較大的隱空間維度時,即使是隨機的映射也常常可以產生令人滿意的表征效果。

為了進一步保留圖結構信息,并減少隨機性影響,我們使用快速特征值分解(SVD)來構造我們的映射函數。在實際實驗中,兩輪的快速特征值分解可以有效地保留拓撲信息,且產生的的計算開銷相對其他模塊可以忽略不計。

可擴展的圖Transformer

經過無參數的圖tokenization過程,對具有不同特征的圖數據,OpenGraph分配了統一的拓撲感知圖token表征。接下來的任務是采用可訓練的神經網絡,對節點間的復雜依賴關系進行建模。

OpenGraph采用了transformer架構,以利用其在復雜關系建模方面的強大能力。為了保證模型效率和性能,我們引入了以下兩種采樣技巧。

Token序列采樣

由于我們的圖token序列數據一般有較大的token數量和隱表征維度,OpenGraph采用的圖transformer對輸入的token序列進行采樣,只學習當前訓練批次內的token間兩兩關系,使得需要建模的關系對數量從節點數量平方,降低到訓練批次大小的平方,從而大大減小圖transformer在訓練階段的時間和空間開銷。并且,這種采樣方法能夠讓模型在訓練時更加關注當前的訓練批次。

盡管對輸入數據進行了采樣,由于我們的初始圖token表征包含了節點間的拓撲關系,采樣的token序列仍然能夠一定程度地反映全圖所有節點的信息。

自注意力中的錨點采樣方法

雖然token序列采樣將復雜度從節點數量平方降低到了批次大小平方,但平方級別的復雜度對批次大小有著較大的限制,使得模型訓練無法采用較大的批次,從而影響整體的訓練時間和訓練穩定性。

為了緩解這一問題,OpenGraph的transformer部分放棄了對所有token之間兩兩關系的建模,而是采樣部分錨點,將所有節點間的關系學習拆分成兩次所有節點與錨點之間的關系學習。

大語言模型知識蒸餾

由于數據隱私等原因,獲取各個領域的數據來訓練通用圖模型是很有挑戰性的。感受到大型語言模型(LLM)所展示的驚人知識和理解能力,我們利用其力量來生成各種圖結構數據,用于通用圖模型的訓練。

我們設計的數據增強機制,使LLM增強的圖數據能夠更好地近似真實世界圖的特征,從而提高了增強數據的相關性和有用性。

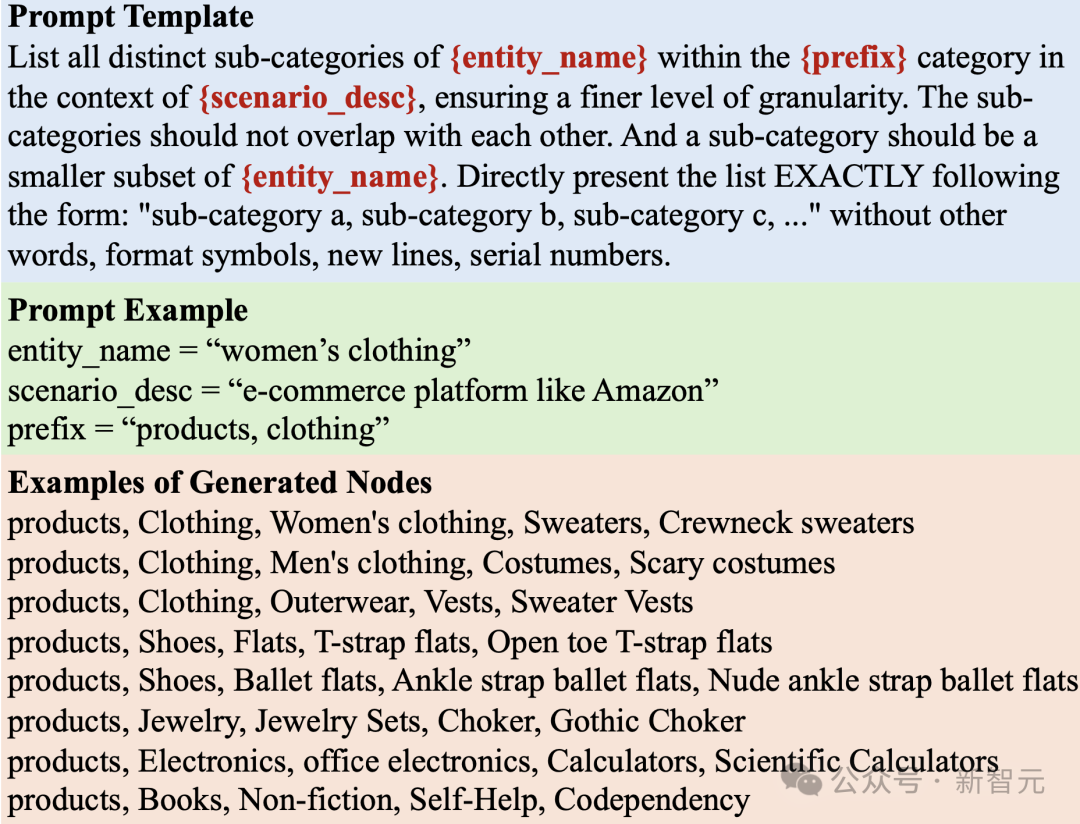

基于LLM的節點生成

在生成圖時,我們的初始步驟是創建一個適合特定應用場景的節點集。每個節點都具有一個基于文本的特征描述,該描述有助于后續的邊生成過程。

然而,當處理真實世界場景時,這項任務可能特別具有挑戰性,因為節點集的規模很大。例如,在電子商務平臺上,圖數據可能包含數十億種產品。因此,有效地使LLM生成大量節點成為一個重大挑戰。

為了解決上述挑戰,我們采用了一種策略,不斷將一般節點分成更細粒度的子類別。

例如,當生成電商場景下的產品節點時,首先使用類似于「列出淘寶等電子商務平臺上的所有產品的子類別」的查詢提示LLM。LLM回答了一個子類別列表,如“衣服”、“家居廚具”和“電子產品”等。

然后,我們要求LLM進一步細化每個子類別來繼續這一迭代分裂過程。這個過程一直重復,直到我們獲得了類似于真實世界實例的節點,例如一個帶有「衣服」、「女士衣物」、「毛線衫」、「帶兜毛線衫」和「白色帶兜毛線衫」標簽的產品。

提示樹算法

將節點分割成子類別并生成細粒度實體的過程遵循一種樹狀結構。最初的一般節點(例如“產品”、“深度學習論文”)作為根,細粒度實體作為葉節點。我們采用樹形提示策略來遍歷和生成這些節點。

基于LLM和吉布斯采樣的邊生成

為了生成邊,我們使用吉布斯采樣算法與上文生成的節點集。算法從一個隨機樣本開始進行迭代,每次在當前樣本的基礎上,采樣對其中某一個數據維度進行改變后得到的樣本。

這一算法的關鍵在于估計在當前樣本的條件下,某個數據維度改變的條件概率。我們提出根據節點生成時得到的文本特征,由LLM進行概率估計。

由于邊的集合空間較大,為了避免讓LLM對其進行探索而產生巨大的開銷,我們首先使用LLM對節點集合進行表征,再基于表征向量,使用簡單的相似度算子對節點間關系進行計算。在以上的邊生成框架內,我們還采用了以下三種重要的技巧進行調整。

動態概率歸一化

由于LLM表征的相似度可能與[0, 1]范圍差距巨大,為了獲得更適合采樣的概率數值,我們使用一種動態概率歸一化的方法。

該方法動態維護采樣過程中最近的T'個相似度估計數值,計算他們的均值和標準差,最后將當前的相似度估計映射到該均值上下兩個標準差的分布范圍中,從而得到近似[0, 1]的概率估計。

引入節點局部性

基于LLM的邊生成方法,能夠有效地根據節點的語義相似性,確定他們的潛在連接關系。

然而,它傾向于在所有語義相關的節點之間創建過多的連接,忽視了真實世界圖中重要的局部性概念。

在現實世界中,節點更有可能連接到相關節點的子集,因為它們通常只能夠與一部分節點有限地互動。為了模擬這一重要特性,引入了一種在邊生成過程中將局部性納入考慮的方法。

每個節點都隨機分配一個局部性索引,兩個節點之間的交互概率受到局部性索引絕對差值的衰減影響,節點的局部性索引差別越大,則衰減越嚴重。

注入圖拓撲模式

為了使生成的圖數據更加符合拓撲結構的模式,我們在第一次圖生成過程中再次生成修正的節點表征。

這一節點表征使用簡單的圖卷積網絡在初始生成圖上得到,他能更好地符合圖結構數據的分布特點,避免圖和文本空間之間的分布偏移。最終,我們在修正的節點表征基礎上,再次進行圖采樣,得到最終的圖結構數據。

實驗驗證

實驗中,我們僅使用基于LLM的生成數據集進行OpenGraph模型訓練,而測試數據集都是各個應用場景下的真實數據集,并包括了節點分類和鏈路預測兩類任務。實驗的具體設置如下:

0-shot設置

為了驗證OpenGraph的零樣本預測能力,OpenGraph在生成的訓練數據集上測試,再使用完全不同的真實測試數據集進行效果測試。訓練數據集和測試數據集在節點、邊、特征、標注上均沒有任何重合。

Few-shot設置

由于大多數現有方法無法進行有效的零樣本預測,我們采用少樣本預測的方式對他們進行測試。基線方法可以在預訓練數據上進行預訓練,之后使用k-shot樣本進行訓練、微調或提示微調。

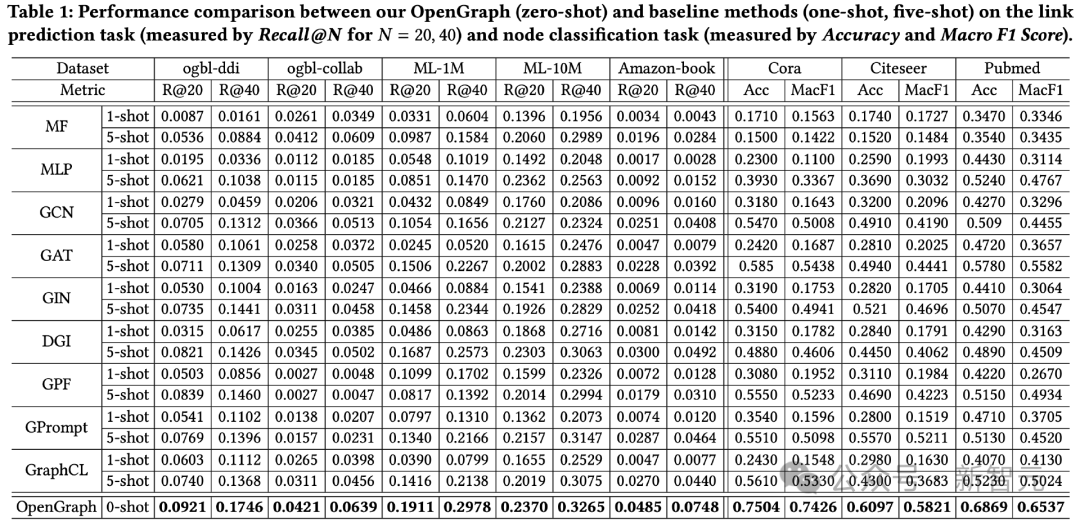

整體效果對比

在2個任務一共8個測試數據集上的測試效果如下所示。

從中可以觀察到:

1)在跨數據集的情況下,OpenGraph的零樣本預測效果相對現有方法具有較大的優勢。

2)在跨數據集遷移的情況下,現有的預訓練方法有時甚至還不如其基礎模型僅在少樣本上從零開始訓練,這體現了圖模型獲得跨數據集泛化能力的困難。

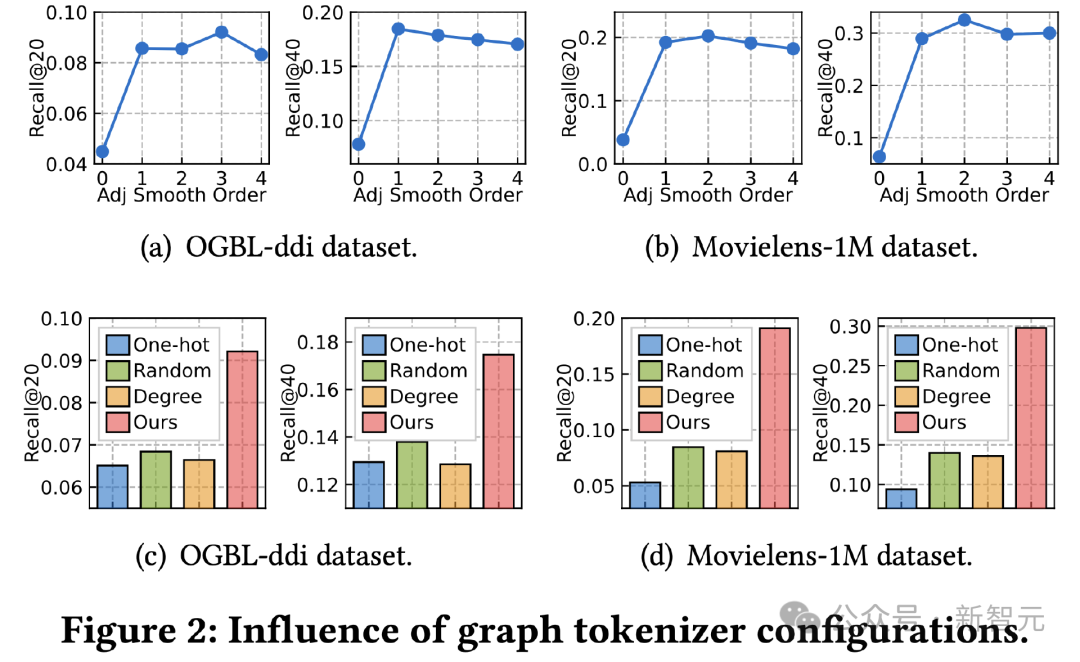

圖Tokenizer研究

接下來我們探究圖tokenizer設計對效果的影響。首先我們調整了鄰接矩陣平滑結束,測試其對效果的影響。0階時效果出現嚴重衰減,指示了采用高階平滑的重要性。

其次,我們將拓撲感知映射函數替換成其他簡單方法,包括跨數據集的可學習獨熱id表征、隨機映射、基于節點度的可學習表征。

結果顯示三種替代方案均效果較差,其中跨數據集學習id表征效果最差,現有工作中常用的度表征效果也衰減較大,不可學習的隨機映射在所有替代方法中表現最好,但仍與我們的拓撲感知映射有很大的差距。

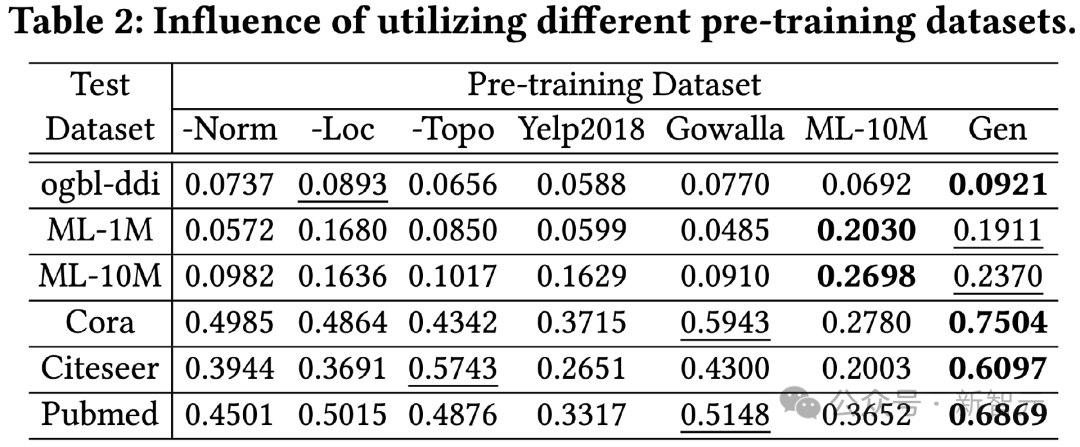

預訓練數據集研究

為了驗證基于LLM的知識蒸餾方法的有效性,我們使用不同的預訓練數據集對OpenGraph進行訓練,并測試其在不同測試集上的效果。

本實驗比較的預訓練數據集包括單獨去除我們生成方法中某個技巧的版本、與測試數據集不相關的兩個真實數據集Yelp2018和Gowalla、以及與測試數據集相關的ML-10M數據集,從結果中可以看出:

1)總體來說,我們的生成數據集能夠在所有測試數據上產生較好的效果。

2)所測試的三種生成技巧均起到了較為顯著的提升效果。

3)使用真實數據集(Yelp、Gowalla)進行訓練可能反而會帶來負面效果,這可能源于不同真實數據集之間的分布差異。

4)ML-10M在ML-1M和ML-10M上均取得了最佳效果,這說明使用相似的訓練數據集能夠產生較好的效果。

Transformer中的采樣技巧研究

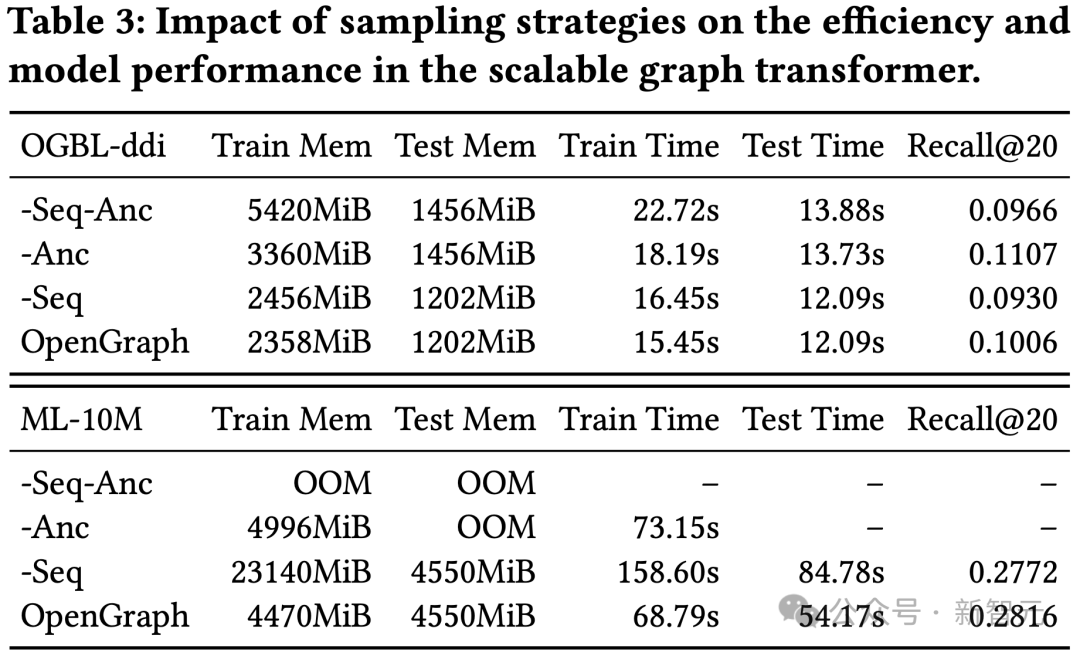

這項實驗對我們圖transformer模塊中的token序列采樣(Seq)和錨點采樣(Anc)進行了消融測試。

結果顯示,兩種采樣方法能夠在訓練和測試過程優化模型的空間和時間開銷。在效果方面,token序列采樣對模型效果有正向作用,而ddi數據集上的結果顯示,錨點菜樣對模型效果有負面效果。

結論

本研究的主要焦點是開發一個高度適應性的框架,能夠精確地捕捉和理解各種圖結構中復雜的拓撲模式。

通過發揮所提出模型的潛力,我們的目的是顯著提高模型的泛化能力,使其在包括各種下游應用在內的零樣本圖學習任務中表現出色。

為了進一步提高OpenGraph的效率和健壯性,我們在可擴展的圖transformer架構和基于LLM的數據增強機制的基礎上構建了我們的模型。

通過在多個基準數據集上進行的大量實驗,我們驗證了模型的杰出泛化能力。本研究在圖基座模型方向作出了初步探索的嘗試。

在未來的工作中,我們計劃賦予我們的框架自動發現噪聲連接和具有反事實學習影響力的結構的能力,同時學習各種圖的通用和可轉移的結構模式。